Introdução geral

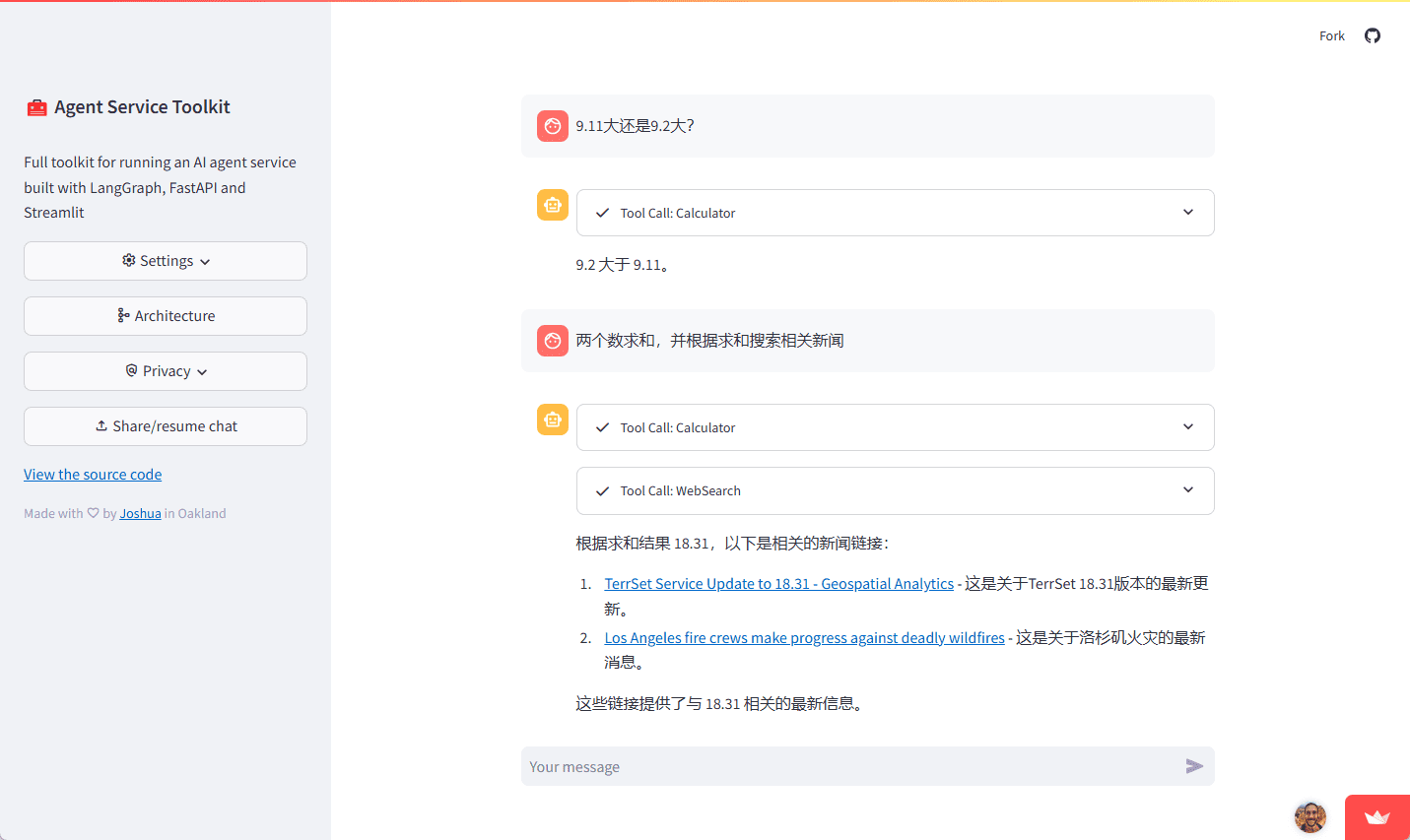

O AI Agent Service Toolkit é um conjunto de ferramentas completo baseado em LangGraph, FastAPI e Streamlit, projetado para ajudar os desenvolvedores a criar e executar rapidamente serviços de agentes de IA. O kit de ferramentas oferece uma estrutura flexível que suporta recursos e interações de agentes definidos pelo usuário para uma variedade de cenários de aplicativos. Seja desenvolvendo chatbots, ferramentas de análise de dados ou outros serviços baseados em IA, os usuários podem implementá-los rapidamente usando o kit de ferramentas. O kit de ferramentas foi projetado com a facilidade de uso e a extensibilidade em mente, permitindo que os usuários integrem facilmente a funcionalidade necessária por meio de configuração simples e modificações de código.

Experiência: https://agent-service-toolkit.streamlit.app/

Arquitetura do kit de ferramentas de serviço de agente

Lista de funções

- Agente LangGraph Agentes personalizáveis criados usando a estrutura LangGraph.

- Serviços FastAPI Serviços de streaming: fornece serviços para endpoints de streaming e não streaming.

- Processamento avançado de streaming Suporte a streaming baseado em tokens e mensagens.

- Auditoria de conteúdo Implementação do LlamaGuard para auditoria de conteúdo (obrigatório) Groq (chave de API).

- Interface Streamlit Interface de bate-papo: fornece uma interface de bate-papo fácil de usar para interagir com os agentes.

- Suporte a vários agentes Execute vários proxies no serviço e invoque-os por meio de caminhos de URL.

- design assíncrono Tratamento eficiente de solicitações simultâneas com async/await.

- Mecanismos de feedback Inclui um sistema de feedback baseado em estrelas integrado ao LangSmith.

- Metadados dinâmicos O ponto de extremidade : /info fornece metadados de configuração dinâmica sobre serviços e agentes e modelos disponíveis.

- Suporte ao Docker Inclui arquivos Dockerfiles e arquivos docker compose para facilitar o desenvolvimento e a implantação.

- teste (maquinário etc.) Inclui testes completos de unidade e integração.

Usando a Ajuda

Processo de instalação

- Execute-o diretamente no Python ::

- Certifique-se de que você tenha pelo menos uma chave de API do LLM:

echo 'OPENAI_API_KEY=sua_openai_api_key' >> .env- Instale as dependências e sincronize:

pip install uv uv sincronização -congelado- Ative o ambiente virtual e execute o serviço:

fonte .venv/bin/activate python src/run_service.py- Ative o ambiente virtual em outro terminal e execute o aplicativo Streamlit:

fonte .venv/bin/activate execução do streamlit src/streamlit_app.py - Execução com o Docker ::

- Certifique-se de que você tenha pelo menos uma chave de API do LLM:

bash echo 'OPENAI_API_KEY=sua_openai_api_key' >> .env - Execute-o com o Docker Compose:

bash docker compose up

- Certifique-se de que você tenha pelo menos uma chave de API do LLM:

Função Fluxo de operação

- Agente LangGraph ::

- Defina o proxy: na seção

src/agentes/Catálogo para definir agentes com diferentes recursos. - Configuração do proxy: use a opção

langgraph.jsondefine o comportamento e as configurações do agente.

- Defina o proxy: na seção

- Serviços FastAPI ::

- Iniciar o serviço: run

src/service/service.pyInicie o serviço FastAPI. - Acesso aos endpoints: via

/streamresponder cantando/não fluxoServiço de proxy de acesso ao terminal.

- Iniciar o serviço: run

- Interface Streamlit ::

- Tela inicial: Executar

src/streamlit_app.pyInicie o aplicativo Streamlit. - Uso interativo: interaja com o agente por meio de uma interface de bate-papo fácil de usar.

- Tela inicial: Executar

- Auditoria de conteúdo ::

- Configuração do LlamaGuard: Na seção

.envpara adicionar a chave da API do Groq para ativar a auditoria de conteúdo.

- Configuração do LlamaGuard: Na seção

- Suporte a vários agentes ::

- Configurar vários proxies: na seção

src/agentes/Diretório para definir vários proxies e invocá-los por meio de diferentes caminhos de URL.

- Configurar vários proxies: na seção

- Mecanismos de feedback ::

- Sistema de feedback integrado: um sistema de feedback baseado em estrelas é integrado ao serviço de agente para coletar feedback do usuário e aprimorar o serviço.

- Metadados dinâmicos ::

- Acesso aos metadados: via

/infoOs pontos de extremidade obtêm metadados de configuração dinâmica sobre serviços e agentes e modelos disponíveis.

- Acesso aos metadados: via

- teste (maquinário etc.) ::

- Execute o teste: na seção

testes/Catálogo para executar testes unitários e de integração para garantir a estabilidade e a confiabilidade do serviço.

- Execute o teste: na seção