Na Inflection, nossa missão é criar uma IA pessoal para todos e, em maio passado, lançamos [...].PiEm novembro, anunciamos o lançamento de um novo modelo básico primário [...Inflexão-2], na época o segundo melhor modelo de linguagem em larga escala do mundo.

Agora, estamos adicionando o QI (Quociente de Inteligência) ao excepcional QE (Quociente Emocional) de Pi.

Lançamos o Inflection-2.5, nosso modelo interno atualizado que é tão bom quanto os principais modelos de idiomas em larga escala do mundo, como o GPT-4 e o Gemini. Ele combina a potência bruta com nossa personalidade simpática e nosso ajuste fino exclusivos. A partir de hoje, o Inflection-2.5 estará disponível em [...pi.ai]( ), [iOS], [Android (sistema operacional)] ou nosso novo [desktopAplicativo para todos os usuários do Pi.

Alcançamos esse marco com uma eficiência incrível: o Inflection-2.5 tem quase o mesmo desempenho que o GPT-4, mas usa apenas a mesma quantidade de computação para treinamento que o GPT-4.40%.

Fizemos avanços específicos em áreas de QI, como codificação e matemática. Isso se reflete em melhorias específicas nos principais benchmarks do setor, garantindo que o Pi permaneça na vanguarda da tecnologia.Recursos de pesquisa na Web em tempo real de classe mundial: garanta que os usuários tenham acesso a atualizações de alta qualidade e informações atualizadas.

Lançamos o Inflection-2.5 para nossos usuários e eles estão adorando o Pi! Observamos um grande aumento no sentimento, no envolvimento e na retenção dos usuários, acelerando o crescimento orgânico.

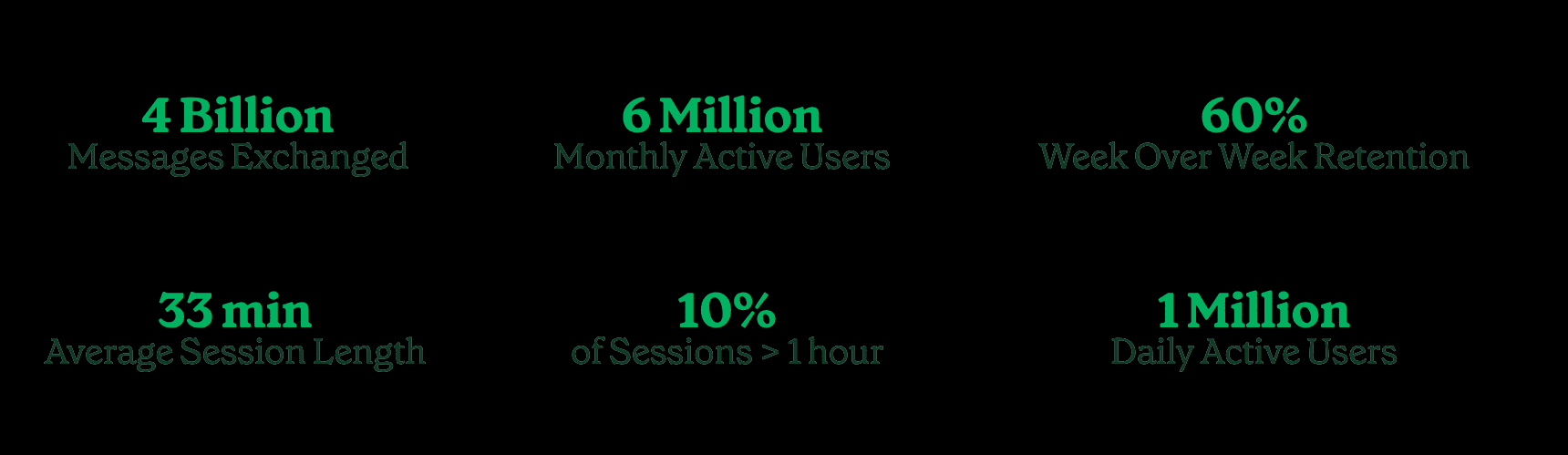

Temos um milhão de usuários ativos por dia e seis milhões de usuários ativos por mês que trocaram mais de quatro bilhões de mensagens com o Pi.

A duração média do diálogo com Pi é33 minutos.Uma em cada 10 conversas dura mais de uma hora por dia. Das pessoas que conversam com Pi em uma determinada semana, aproximadamente60%Voltaremos a conversar na próxima semana, e estamos observando uma aderência mensal maior do que a de nossos principais concorrentes.

Com o poder do Inflection-2.5, os usuários podem discutir uma variedade maior de tópicos com o Pi do que nunca: discutir eventos atuais, obter recomendações de restaurantes locais, estudar para um exame de biologia, elaborar um plano de negócios, programar, preparar-se para uma conversa importante ou apenas se divertir discutindo um hobby. Mal podemos esperar para mostrar a você o que o Pi pode fazer.

Resultados técnicos

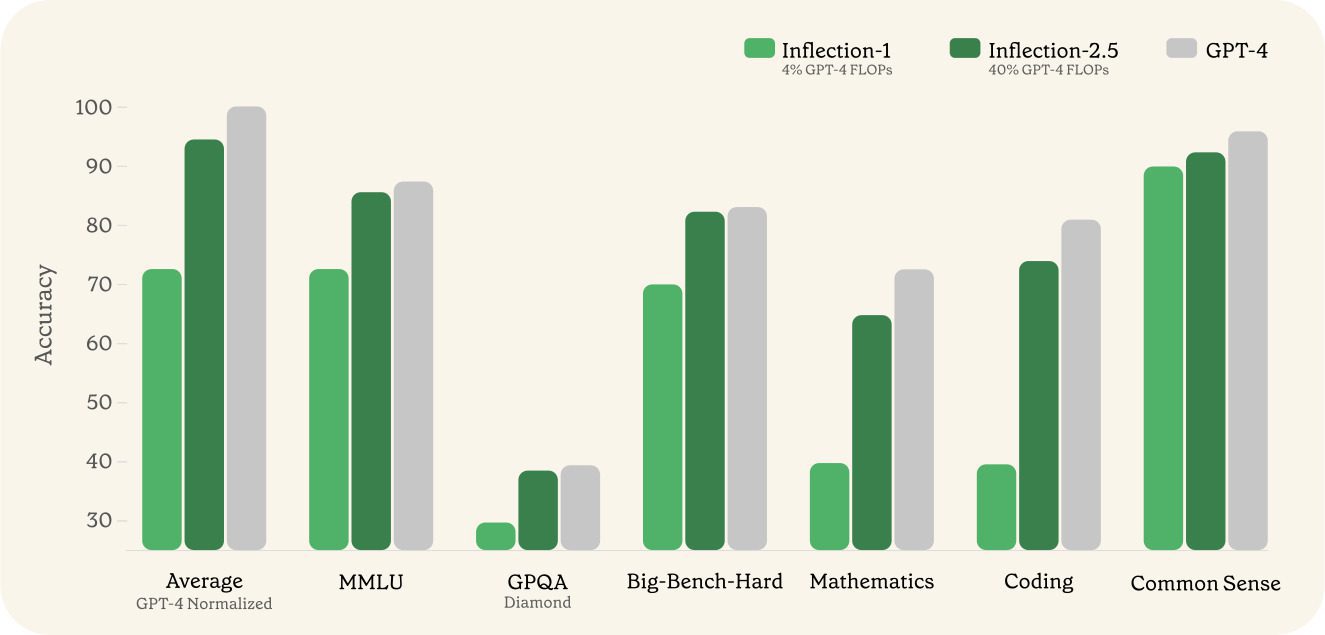

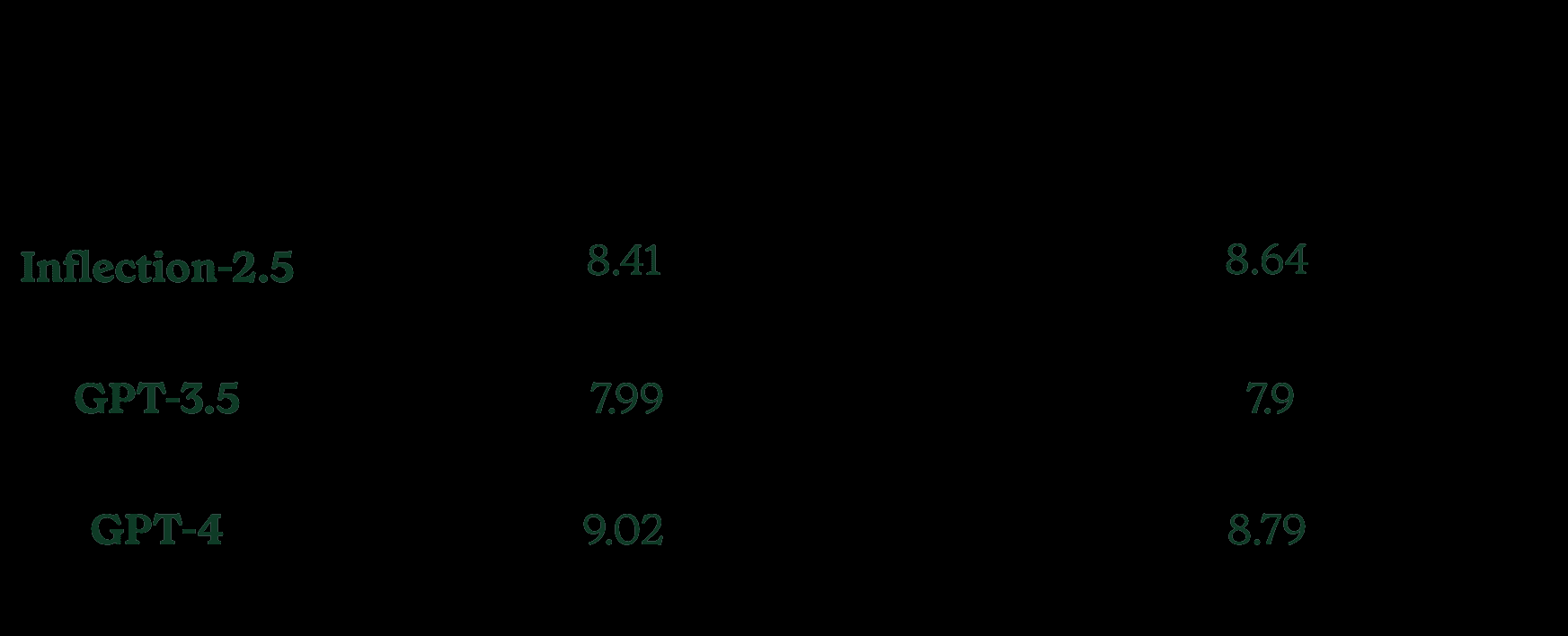

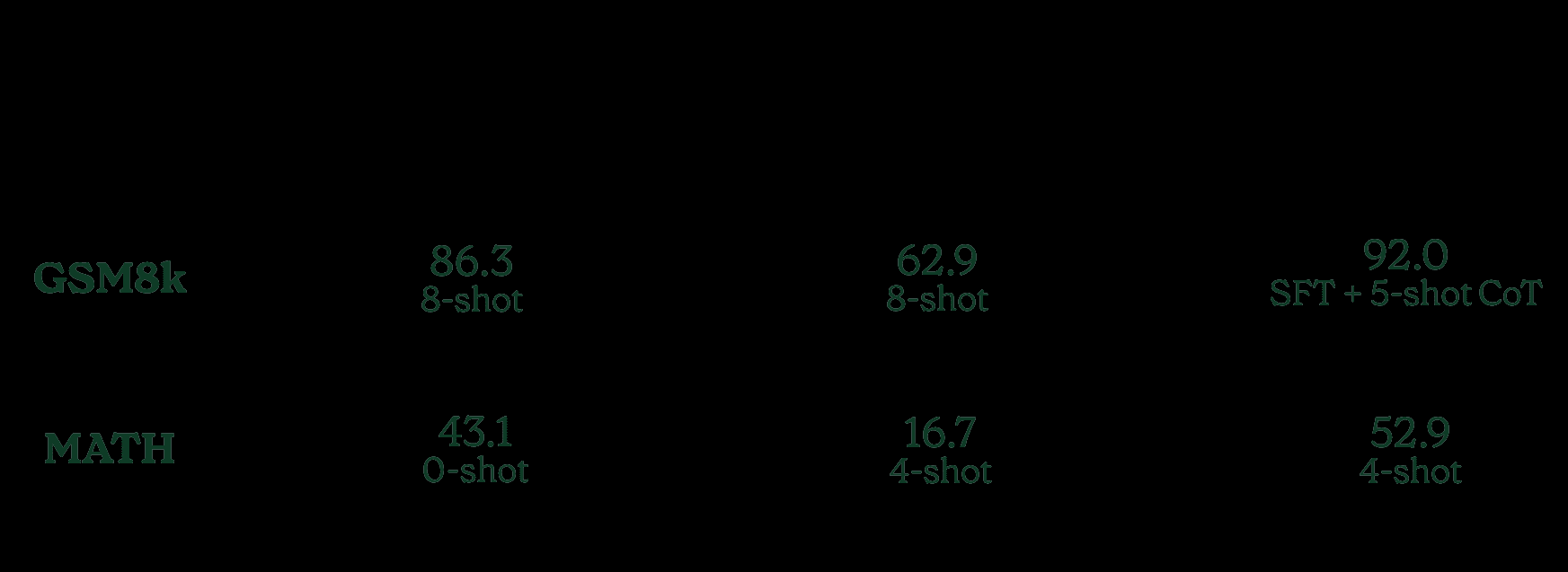

Abaixo, mostramos os resultados de uma série de testes de benchmark importantes do setor. Para simplificar, comparamos o Inflection-2.5 com o GPT-4. Esses resultados mostram que o Pi agora tem recursos de QI comparáveis aos líderes reconhecidos do setor. Devido aos diferentes formatos de relatório, estamos prestando atenção ao formato usado para a avaliação.

O Inflection-1 utilizou cerca de 41 TP3T de operações de ponto flutuante (FLOPs) de treinamento para o GPT-4 e obteve uma média de cerca de 721 TP3T de desempenho do GPT-4 em uma série de tarefas voltadas para o QI. O Inflection-2.5, que agora aciona o Pi, atinge um desempenho médio de mais de 941 TP3T para o GPT-4, apesar de usar apenas 401 TP3T de FLOPs de treinamento. Observamos ganhos significativos de desempenho em uma ampla gama de domínios, com as maiores melhorias ocorrendo no domínio STEM.

Em comparação com o Inflection-1, o Inflection-2.5 fez avanços significativos no benchmark MMLU, um benchmark diversificado que mede o desempenho em uma ampla gama de tarefas, desde o ensino médio até o nível de dificuldade profissional. Também avaliamos o extremamente difícil benchmark GPQA Diamond, um benchmark em nível de especialista.

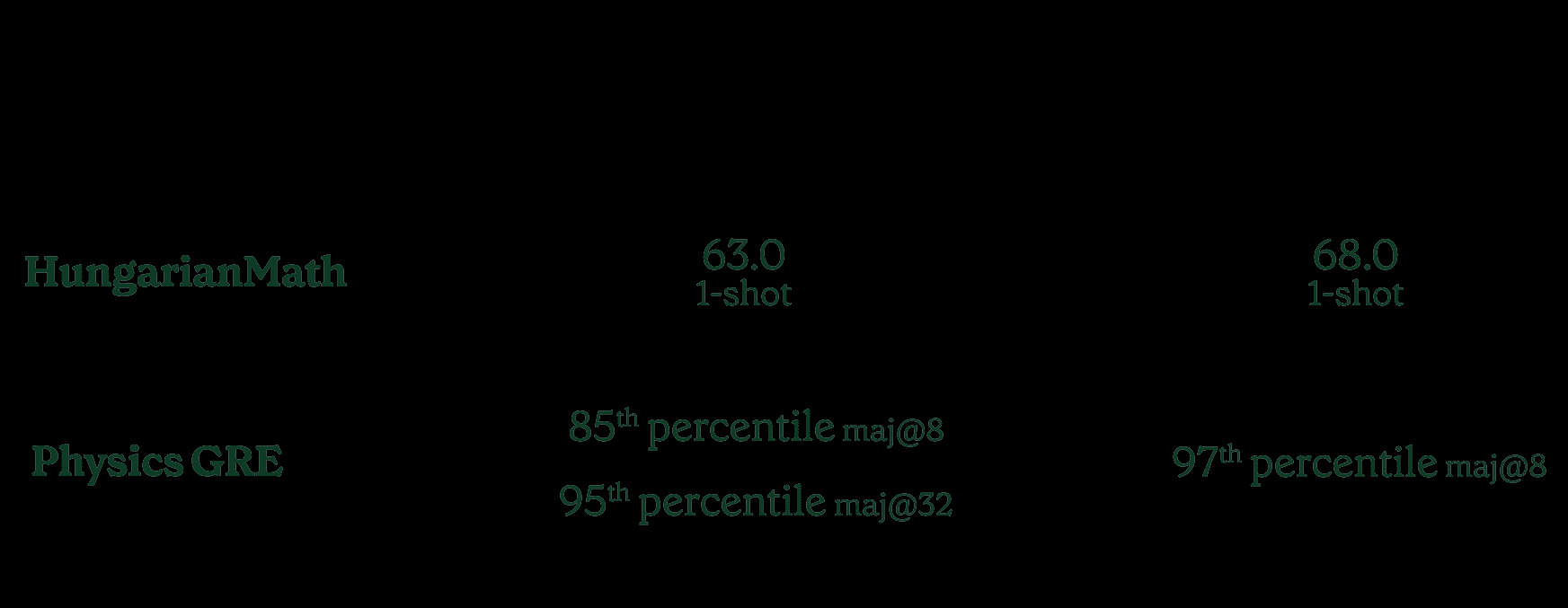

Também incluímos os resultados de dois exames STEM diferentes: o exame húngaro de matemática e o desempenho do GRE de física - o exame de admissão para graduados em física.

Para a matemática húngara, usamos [Aqui estãoUm pequeno número de exemplos de dicas e formatos é fornecido para facilitar a repetição. O Inflection-2.5 usa apenas o primeiro exemplo das dicas.

Também estamos...Postado.] publicaram versões processadas dos exames GRE físicos (GR8677, GR9277, GR9677, GR0177) e compararam o desempenho do Inflection 2.5 no primeiro exame com o GPT-4. Descobrimos que o Inflection-2.5 atinge o 85º percentil de pessoas que fazem o teste em humanos no MAJ@8 e quase alcança a pontuação mais alta no MAJ@32. Algumas perguntas com imagens foram excluídas dos resultados abaixo para facilitar comparações amplas. De qualquer forma, publicamos todas as perguntas.

No BIG-Bench-Hard, um subconjunto de problemas do BIG-Bench que são difíceis para modelos de linguagem grandes, o Inflection-2.5 apresenta mais de 101 TP3T de melhoria em relação ao Inflection-1 e é tão bom quanto os modelos mais avançados.

Ainda estamos aqui.MT-BenchAvaliamos nosso modelo no MT-Bench, uma tabela de classificação da comunidade amplamente conhecida para comparação de modelos. No entanto, depois de avaliar o MT-Bench, percebemos que quase um quarto dos exemplos nas categorias Raciocínio, Matemática e Codificação tinham soluções de referência incorretas ou premissas de problemas com falhas. Portanto, corrigimos esses exemplos e os publicamos em [...Aqui estão] lançou uma versão corrigida do conjunto de dados.

Ao avaliar esses dois subconjuntos, descobrimos que, na versão corretamente corrigida, nosso modelo tem um desempenho mais consistente com as expectativas baseadas em outros testes de referência.

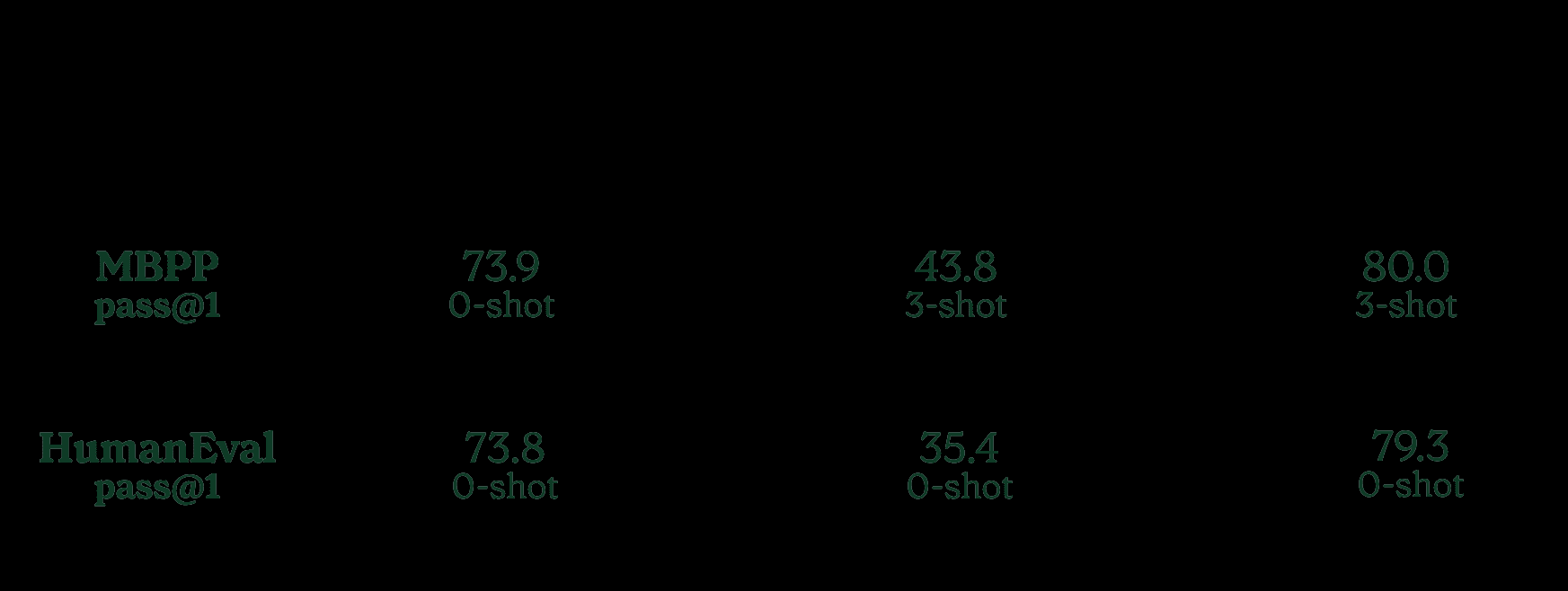

O Inflection-2.5 oferece melhorias específicas em relação ao Inflection-1 em termos de desempenho matemático e de codificação, conforme mostrado na tabela abaixo.

Nos benchmarks de codificação MBPP+ e HumanEval+, observamos uma melhoria significativa em relação ao Inflection-1.

Para o MBPP, relatamos os resultados de [Codificador do DeepSeek] para os valores de GPT-4. Para a HumanEval, usamos o [EvalPlus...] resultados na tabela de classificação (GPT-4 em maio de 2023).

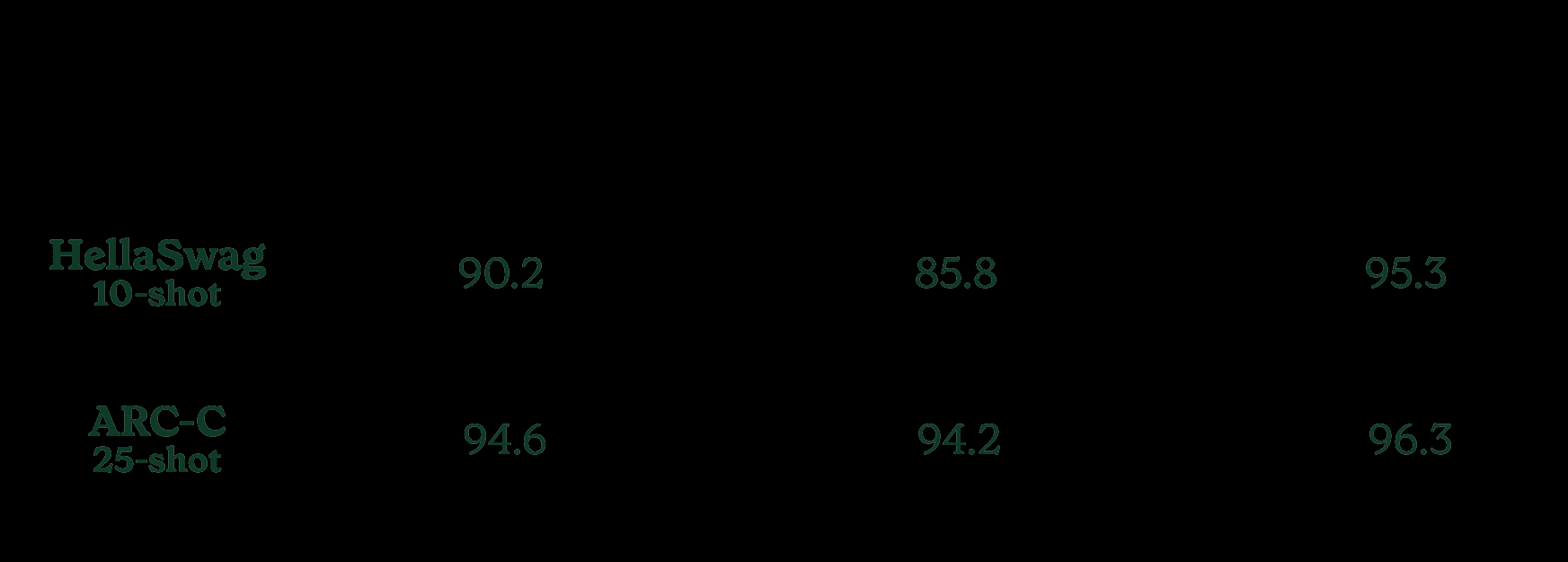

Também avaliamos o desempenho do Inflection-2.5 no HellaSwag e no ARC-C, dois benchmarks científicos e de senso comum que muitos modelos apresentam. Em ambos os casos, observamos um excelente desempenho nesses benchmarks quase saturados.

Todas as avaliações acima são para o modelo que agora impulsiona o Pi, mas observamos que a experiência do usuário pode variar um pouco devido aos efeitos da recuperação na Web (nenhum dos benchmarks acima usou a recuperação na Web), à estrutura do pequeno número de prompts de exemplo e a outras diferenças na produção.

Resumindo, o Inflection-2.5 mantém a personalidade única e acessível do Pi e seus excepcionais padrões de segurança, ao mesmo tempo em que se torna um modelo mais íntimo em todos os sentidos.

Somos gratos aos nossos parceiros do Azure e do CoreWeave pelo apoio que nos deram para levar o modelo de linguagem de última geração por trás do Pi a milhões de usuários em todo o mundo.