Hugging Face lança classificações corporais de inteligência de agentes: quem é o líder em chamadas de ferramentas?

O CEO da NVIDIA, Jen-Hsun Huang, saudou as inteligências de IA como a "força de trabalho digital", e ele não é o único líder de tecnologia a ter essa opinião. O CEO da Microsoft, Satya Nadella, também acredita que a tecnologia de corpos inteligentes mudará fundamentalmente a forma como as empresas operam.

A capacidade dessas inteligências de interagir com ferramentas externas e APIs expandiu muito seus cenários de aplicação. No entanto, as inteligências de IA estão longe de ser perfeitas, e avaliar seu desempenho em aplicativos do mundo real tem sido um desafio devido à complexidade das possíveis interações.

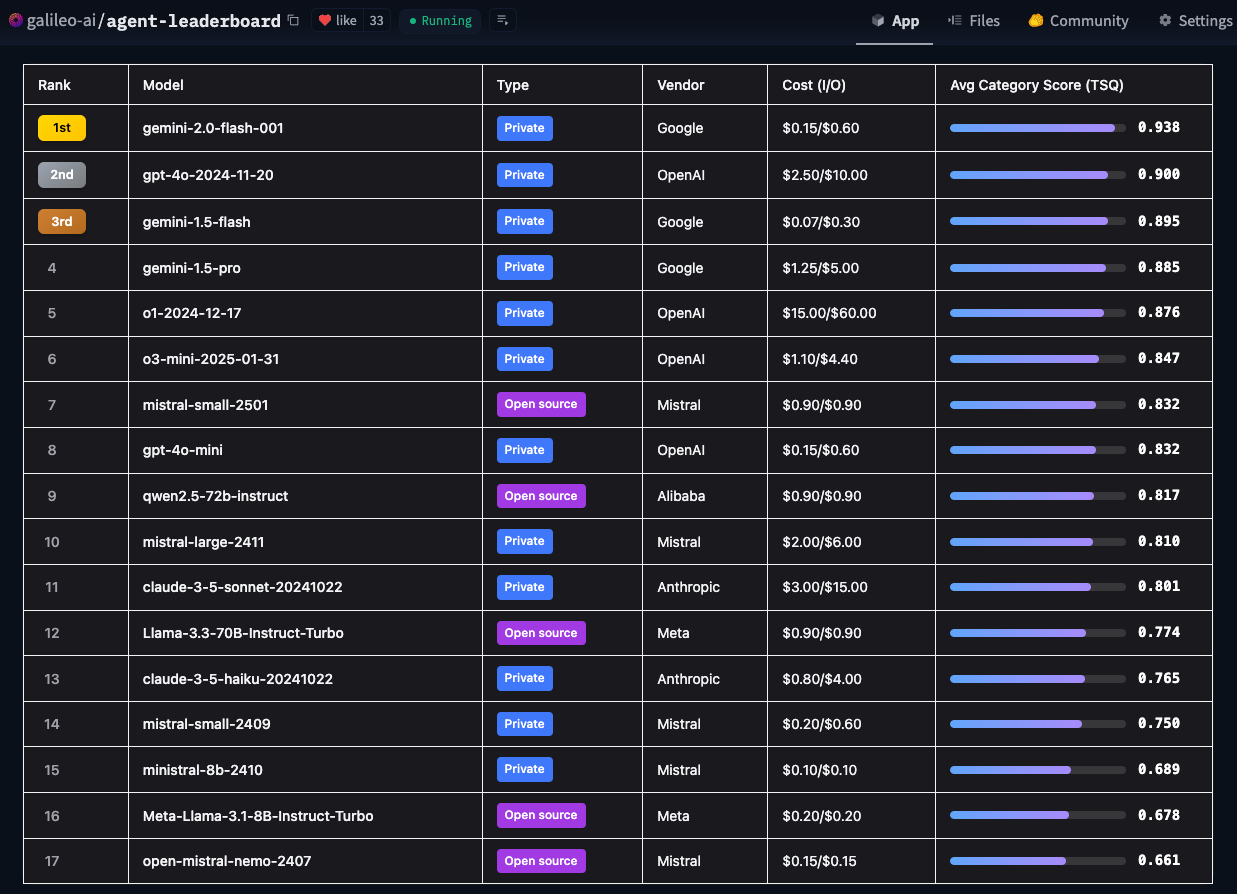

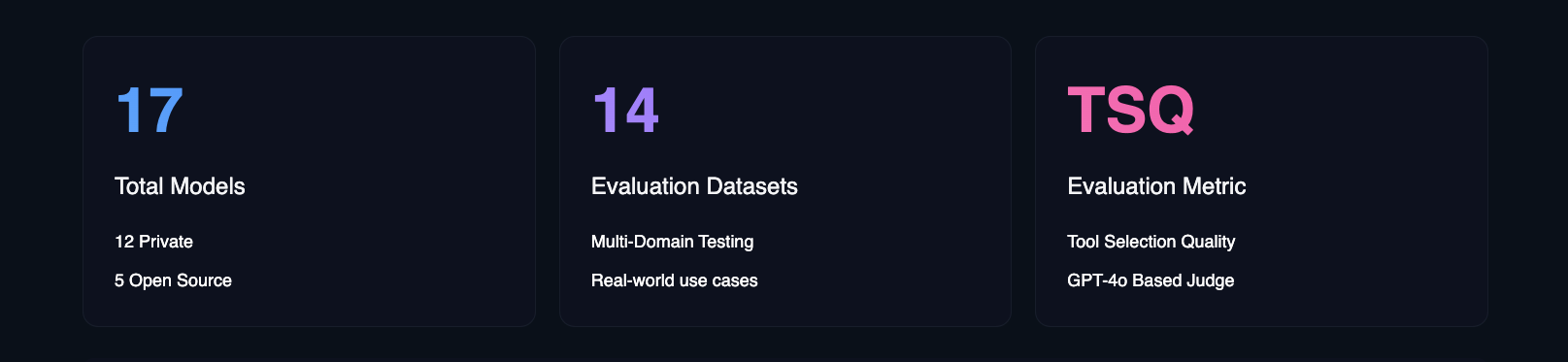

Para enfrentar esse desafio, a Hugging Face introduziu o Agent Intelligence Body Ranking. Usando a métrica de Qualidade de Seleção de Ferramenta (TSQ) do Galileo, o Leaderboard avalia o desempenho de diferentes Modelos de Linguagem Grande (LLMs) no tratamento de interações baseadas em ferramentas, fornecendo uma referência clara para os desenvolvedores.

- Classificação inteligente do corpo do agente de rosto de abraço

A Hugging Face criou essa classificação para responder à pergunta central: "Qual é o desempenho real das inteligências de IA em ambientes de negócios reais?" Os benchmarks acadêmicos são importantes, mas eles se concentram nas capacidades técnicas, enquanto a Hugging Face está mais preocupada com quais modelos são realmente aplicáveis a uma variedade de casos de uso no mundo real.

Recursos exclusivos do Quadro de Líderes de Avaliação Corporal Inteligente do Hugging Face Agent

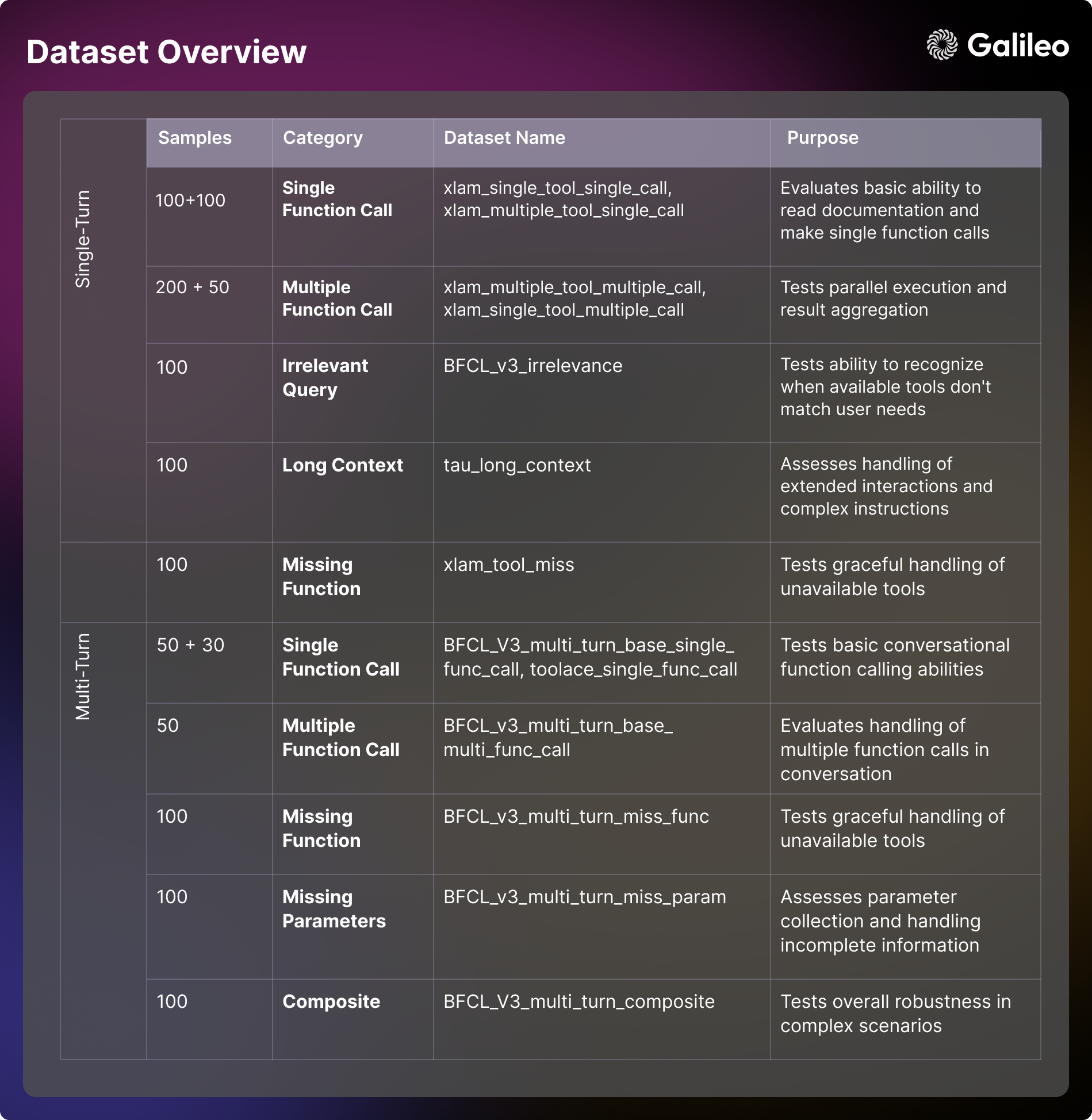

As estruturas de avaliação convencionais atuais geralmente se concentram em domínios específicos. Por exemplo, o BFCL se destaca em domínios acadêmicos, como matemática, entretenimento e educação; o τ-bench se concentra em cenários específicos do setor, como varejo e companhias aéreas; o xLAM abrange 21 domínios de geração de dados; e o ToolACE se concentra em interações de API em 390 domínios. A tabela de classificação da Hugging Face é única, pois combina esses conjuntos de dados em uma estrutura de avaliação abrangente projetada para cobrir uma gama maior de domínios e casos de uso do mundo real.

Ao integrar os benchmarks e cenários de teste da विविध, as tabelas de classificação da Hugging Face não apenas fornecem uma avaliação dos recursos técnicos de um modelo, mas também se concentram em fornecer insights práticos sobre como o modelo lida com casos extremos e considerações de segurança. A Hugging Face também fornece insights sobre vários fatores, como custo-benefício, diretrizes de implementação e impacto nos negócios - todos eles essenciais para as organizações que desejam implementar inteligências de IA. Com essa classificação, a Hugging Face espera ajudar as equipes empresariais a identificar com mais precisão os modelos de inteligências de IA que melhor atendem às suas necessidades específicas, levando em conta as restrições dos aplicativos do mundo real.

Dada a frequência dos lançamentos de novos modelos de linguagem grande (LLM), a Hugging Face planeja atualizar os benchmarks da tabela de classificação mensalmente para garantir que eles acompanhem as tecnologias de modelagem em rápida evolução.

Principais conclusões

A análise aprofundada da Hugging Face de 17 dos principais modelos de linguagem grande (LLMs) revela padrões interessantes na forma como as inteligências de IA abordam as tarefas do mundo real. A Hugging Face realizou testes de estresse abrangentes em modelos privados e de código aberto em 14 benchmarks diferentes, avaliando dimensões que variam de simples chamadas de API a interações complexas com várias ferramentas.

Classificações de modelagem de linguagem ampla (LLM)

Os resultados da avaliação da Hugging Face desafiam as percepções tradicionais do desempenho do modelo e fornecem uma referência prática valiosa para as equipes que estão criando inteligências de IA.

Principais conclusões das classificações de corpos inteligentes do agente

Complexidade das chamadas de ferramentas

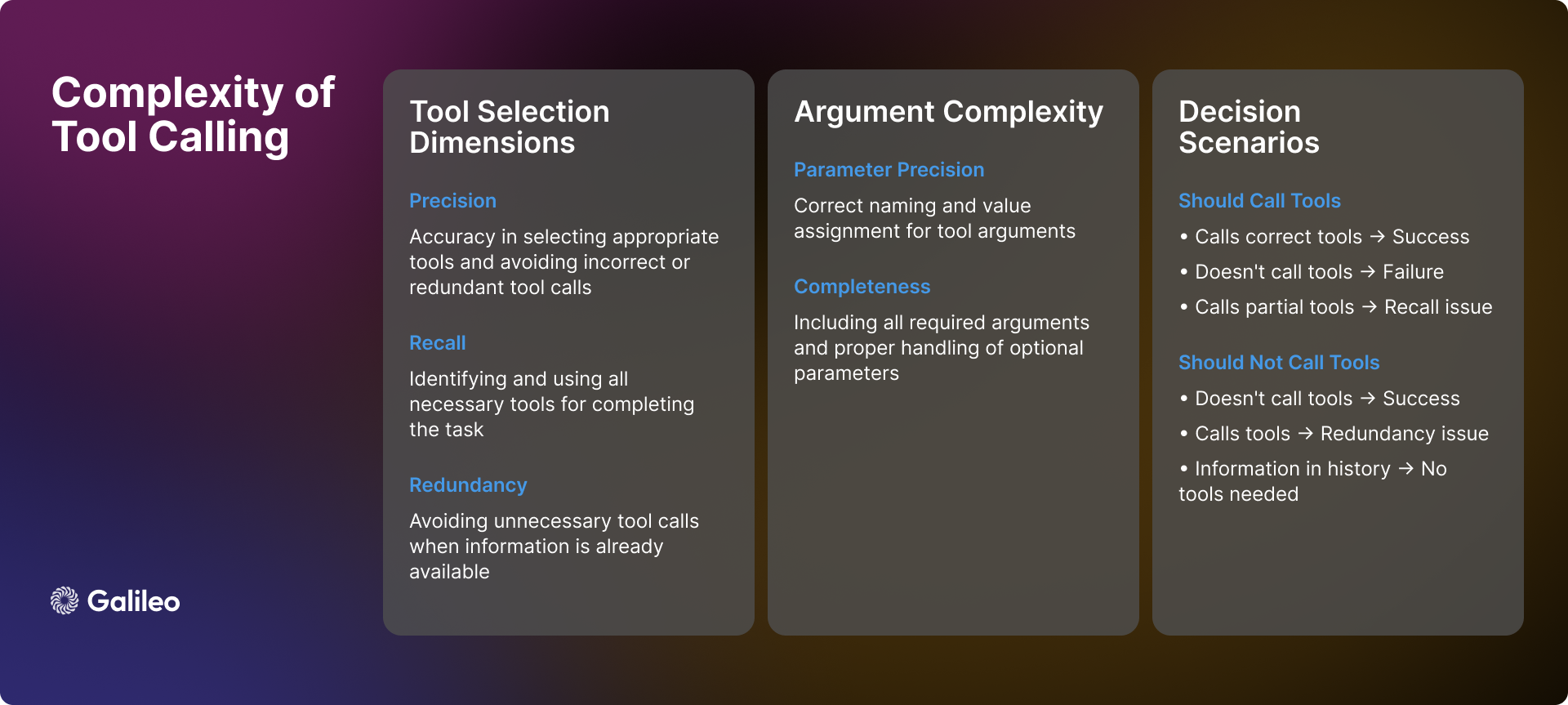

A complexidade da invocação de ferramentas vai muito além de simples chamadas de API. Na prática, as inteligências de IA enfrentam muitos cenários e desafios complexos no uso de ferramentas e precisam tomar decisões precisas:

reconhecimento de cenas

Quando um órgão inteligente recebe uma consulta do usuário, sua primeira tarefa é determinar se a invocação da ferramenta é necessária. Às vezes, as informações necessárias podem já existir no histórico do diálogo, tornando a invocação da ferramenta redundante. Além disso, as ferramentas disponíveis podem não ser suficientes para resolver o problema do usuário ou podem ser irrelevantes para a tarefa em si. Nesses casos, as inteligências precisam ser capazes de reconhecer suas limitações e ser honestas com o usuário, em vez de forçar o uso de ferramentas inadequadas.

Dinâmica de seleção de ferramentas

A seleção de ferramentas não é um simples problema binário de "sim" ou "não"; ela envolve precisão e recuperação. Idealmente, um corpo inteligente deveria ser capaz de identificar com precisão todas as ferramentas necessárias e, ao mesmo tempo, evitar a seleção de ferramentas irrelevantes. Entretanto, a realidade costuma ser mais complexa. Um organismo inteligente pode identificar corretamente uma ferramenta necessária, mas omitir outras (recall insuficiente), ou selecionar incorretamente algumas ferramentas desnecessárias e escolher as apropriadas (precisão insuficiente). Embora nenhum desses cenários seja ideal, eles representam graus variados de viés de seleção.

parametrização

Mesmo que um órgão inteligente selecione com sucesso a ferramenta certa, o processamento de parâmetros ainda pode apresentar novos desafios. Os corpos inteligentes devem:

- Forneça todos os parâmetros necessários e certifique-se de que eles estejam nomeados corretamente.

- Manuseio adequado de parâmetros opcionais.

- Garantir a precisão dos valores dos parâmetros.

- Formate os parâmetros de acordo com a especificação específica da ferramenta.

tomada de decisão sequencial

Para tarefas de várias etapas, as inteligências precisam demonstrar capacidades de tomada de decisão mais avançadas:

- Determinar a ordem ideal de chamadas de ferramentas.

- Lida com interdependências entre chamadas de ferramentas.

- Manter a coerência contextual entre várias operações.

- Flexibilidade para responder a sucessos ou fracassos localizados.

A complexidade descrita acima demonstra amplamente que a qualidade da seleção de ferramentas não deve ser vista como uma métrica simples. Em vez disso, ela deve ser vista como uma avaliação abrangente da capacidade das inteligências de tomar decisões complexas em cenários da vida real.

metodologia

O processo de avaliação da Hugging Face segue uma metodologia sistemática que busca fornecer uma avaliação abrangente e imparcial das inteligências de IA:

- Seleção de modelos: A Hugging Face selecionou cuidadosamente um conjunto diversificado de modelos de linguagem líderes, tanto de implementações proprietárias quanto de código aberto. Essa estratégia de seleção visa a fornecer uma visão abrangente do cenário tecnológico atual.

- Configuração de carroceria inteligente: O Hugging Face configura cada modelo como uma inteligência com dicas de sistema padronizadas e concede a eles acesso a um conjunto consistente de ferramentas. Essa configuração padronizada garante que a variação de desempenho seja um verdadeiro reflexo das capacidades inerentes ao modelo, em vez de ser influenciada por fatores externos, como a engenharia de dicas.

- Definição do indicador: O Hugging Face estabelece a Qualidade da Seleção de Ferramentas (TSQ) como a métrica de avaliação principal, concentrando-se na correção da seleção de ferramentas e na eficácia do uso de parâmetros. As métricas do TSQ foram projetadas tendo em mente os requisitos de desempenho do mundo real.

- Curadoria de conjuntos de dados: O Hugging Face cria um conjunto de dados equilibrado e de vários domínios por meio de amostragem estratégica de conjuntos de dados de referência maduros existentes. O conjunto de dados testa de forma abrangente os recursos das inteligências, desde chamadas de funções básicas até interações complexas em várias rodadas, para garantir a abrangência da avaliação.

- Sistema de pontuação: A pontuação final de desempenho é obtida calculando-se a média de pesos iguais em todos os conjuntos de dados. Essa abordagem garante uma avaliação equilibrada e evita que um único recurso domine os resultados gerais da avaliação, refletindo assim o desempenho abrangente das inteligências de forma mais objetiva.

Por meio dessa metodologia de avaliação estruturada, a Hugging Face tem como objetivo fornecer percepções que possam orientar diretamente as decisões de implementação no mundo real.

Como o Hugging Face mede o desempenho das inteligências do agente?

Como funciona a estrutura de avaliação

Conforme mencionado acima, a avaliação da invocação de ferramentas requer medições confiáveis em uma variedade de cenários diferentes. A Hugging Face desenvolveu a métrica de Qualidade de Seleção de Ferramentas para avaliar o desempenho da invocação de ferramentas das inteligências, observando a precisão da seleção de ferramentas e a eficácia do uso de parâmetros. A estrutura de avaliação foi projetada para determinar se as inteligências estão usando ferramentas adequadamente para concluir tarefas e para identificar situações em que o uso de ferramentas é desnecessário.

Durante o processo de avaliação, a Hugging Face usou os modelos GPT-4o e ChainPoll para avaliar as decisões de seleção de ferramentas. Para cada interação, a Hugging Face coleta vários julgamentos independentes, com a pontuação final representando a proporção de avaliações positivas. Cada julgamento inclui uma explicação detalhada para garantir a transparência no processo de avaliação.

O exemplo de código a seguir mostra como usar a métrica TSQ para avaliar o desempenho da chamada de ferramenta de um modelo de linguagem grande (LLM) em um conjunto de dados:

import promptquality as pq

import pandas as pd

file_path = "path/to/your/dataset.parquet" # 替换为你的数据集文件路径

project_name = "agent-leaderboard-evaluation" # 替换为你的项目名称

run_name = "tool-selection-quality-run" # 替换为你的运行名称

model = "gpt-4o" # 你想要评估的模型名称

tools = [...] # 你的工具列表

llm_handler = pq.LLMHandler() # 初始化 LLMHandler

df = pd.read_parquet(file_path, engine="fastparquet")

chainpoll_tool_selection_scorer = pq.CustomizedChainPollScorer(

scorer_name=pq.CustomizedScorerName.tool_selection_quality,

model_alias=pq.Models.gpt_4o,

)

evaluate_handler = pq.GalileoPromptCallback(

project_name=project_name,

run_name=run_name,

scorers=[chainpoll_tool_selection_scorer],

)

llm = llm_handler.get_llm(model, temperature=0.0, max_tokens=4000)

system_msg ={

"role":"system",

"content":'Your job is to use the given tools to answer the query of human. If there is no relevant tool then reply with "I cannot answer the question with given tools". If tool is available but sufficient information is not available, then ask human to get the same. You can call as many tools as you want. Use multiple tools if needed. If the tools need to be called in a sequence then just call the first tool.',

}

outputs = []

for row in df.itertuples():

chain = llm.bind_tools(tools)

outputs.append(

chain.invoke(

[system_msg,*row.conversation],

config=dict(callbacks=[evaluate_handler])

)

)

evaluate_handler.finish()

Por que a Hugging Face optou por usar o Large Language Model (LLM) para a avaliação de chamadas de ferramentas?

O método de avaliação baseado no Large Language Model (LLM) permite uma avaliação abrangente de vários cenários complexos. Essa abordagem pode verificar com eficácia se a inteligência lidou adequadamente com situações com informações contextuais insuficientes para determinar se são necessárias mais informações do usuário antes que a ferramenta possa ser usada. Em cenários de aplicação de várias ferramentas, o método é capaz de verificar se o corpo inteligente identifica todas as ferramentas necessárias e as invoca na ordem correta. Em diálogos com contextos longos, o método garante que o corpo inteligente considere totalmente as informações relevantes do início do histórico do diálogo. Mesmo nos casos em que as ferramentas estão ausentes ou são inaplicáveis, o método de avaliação determina se o organismo inteligente evita corretamente a invocação de ferramentas e, portanto, evita ações inadequadas.

Para se destacar nas métricas de TSQ, as inteligências de IA precisam demonstrar recursos sofisticados, incluindo: selecionar a ferramenta certa quando necessário, fornecer parâmetros precisos, coordenar várias ferramentas com eficiência e identificar cenários em que o uso da ferramenta é desnecessário. Por exemplo, quando todas as informações necessárias já existem no histórico do diálogo ou quando nenhuma ferramenta adequada está disponível, é preferível evitar a ferramenta.

Avaliação da composição do conteúdo do conjunto de dados

A estrutura de avaliação do Hugging Face emprega um conjunto de conjuntos de dados de referência cuidadosamente selecionados, derivados do BFCL (Berkeley Chamada de função Leaderboard (Berkeley Function Call Leaderboard), τ-bench (Tau benchmark), Xlam e ToolACE. Cada conjunto de dados foi projetado para testar os recursos das inteligências em um aspecto específico. A compreensão dessas dimensões de avaliação é fundamental para a avaliação do modelo e o desenvolvimento de aplicativos práticos.

capacidade para uma única rodada

- Uso de ferramentas básicas Cenário: concentra-se na avaliação da capacidade das inteligências de entender a documentação da ferramenta, os parâmetros do processo e realizar chamadas de funções básicas. Essa dimensão se concentra em examinar a formatação da resposta e os recursos de tratamento de erros das inteligências em interações diretas. Essa capacidade é essencial para tarefas automatizadas simples em aplicativos do mundo real, como definir lembretes ou obter informações básicas [xlam_single_tool_single_call].

- Seleção de ferramentas Cenário: avalia a capacidade do modelo de selecionar a ferramenta correta entre várias opções de ferramentas. Essa dimensão examina até que ponto o modelo é capaz de entender a documentação da ferramenta e tomar uma decisão fundamentada sobre a adequação da ferramenta. Para cenários de aplicativos do mundo real em que são criadas inteligências multifuncionais, essa capacidade é fundamental [xlam_multiple_tool_single_call].

- execução paralela Cenário: examine a capacidade de um modelo de programar várias ferramentas para trabalharem juntas ao mesmo tempo. Essa dimensão é fundamental para melhorar a eficiência em aplicativos do mundo real [xlam_multiple_tool_multiple_call].

- Reutilização de ferramentas Cenário: Avalie a capacidade das inteligências de lidar eficientemente com operações em lote e variações de parâmetros. Esse aspecto é particularmente importante para cenários de processamento em lote em aplicativos reais [xlam_single_tool_multiple_call].

Tratamento de erros e casos extremos

- teste de irrelevância Cenário: a capacidade de um modelo de teste de identificar as limitações da ferramenta e de se comunicar de forma razoável quando as ferramentas disponíveis não atendem às necessidades do usuário. Essa capacidade é a pedra angular da proteção da experiência do usuário e da confiabilidade do sistema [BFCL_v3_irrelevance].

- Manuseio de ferramentas ausentes Cenário: examine a elegância com que o modelo lida com a situação em que a ferramenta necessária não está disponível, incluindo a capacidade de informar o usuário sobre suas limitações e fornecer alternativas [xlam_tool_miss, BFCL_v3_multi_turn_miss_func].

gerenciamento de contexto (computação)

- contexto longo Cenário: Avalie a capacidade de um modelo de manter a coerência contextual e entender instruções complexas em diálogos de longo alcance. Essa capacidade é essencial para lidar com fluxos de trabalho complexos e interações longas [tau_long_context, BFCL_v3_multi_turn_long_context].

interação em várias camadas

- Diálogo básico Cenário: testar a capacidade das inteligências de fazer chamadas de função de conversação e manter o contexto em um diálogo de várias rodadas. Essa capacidade básica é fundamental para o desenvolvimento de aplicativos interativos [BFCL_v3_multi_turn_base_single_func_call, toolace_single_func_call].

- interação complexa Cenário: Combine vários desafios para testar de forma abrangente a robustez geral e a capacidade de resolução de problemas das inteligências em cenários complexos [BFCL_v3_multi_turn_base_multi_func_call, BFCL_v3_multi_turn_composite].

Gerenciamento de parâmetros

- parâmetro ausente Cenário: Examine como o modelo lida com situações em que as informações são incompletas e com que eficácia ele interage com o usuário para coletar os parâmetros necessários [BFCL_v3_multi_turn_miss_param].

A Hugging Face abriu o conjunto de dados para facilitar a pesquisa da comunidade e o desenvolvimento de aplicativos - Hugging Face Tabela de classificação de agentes Conjunto de dados

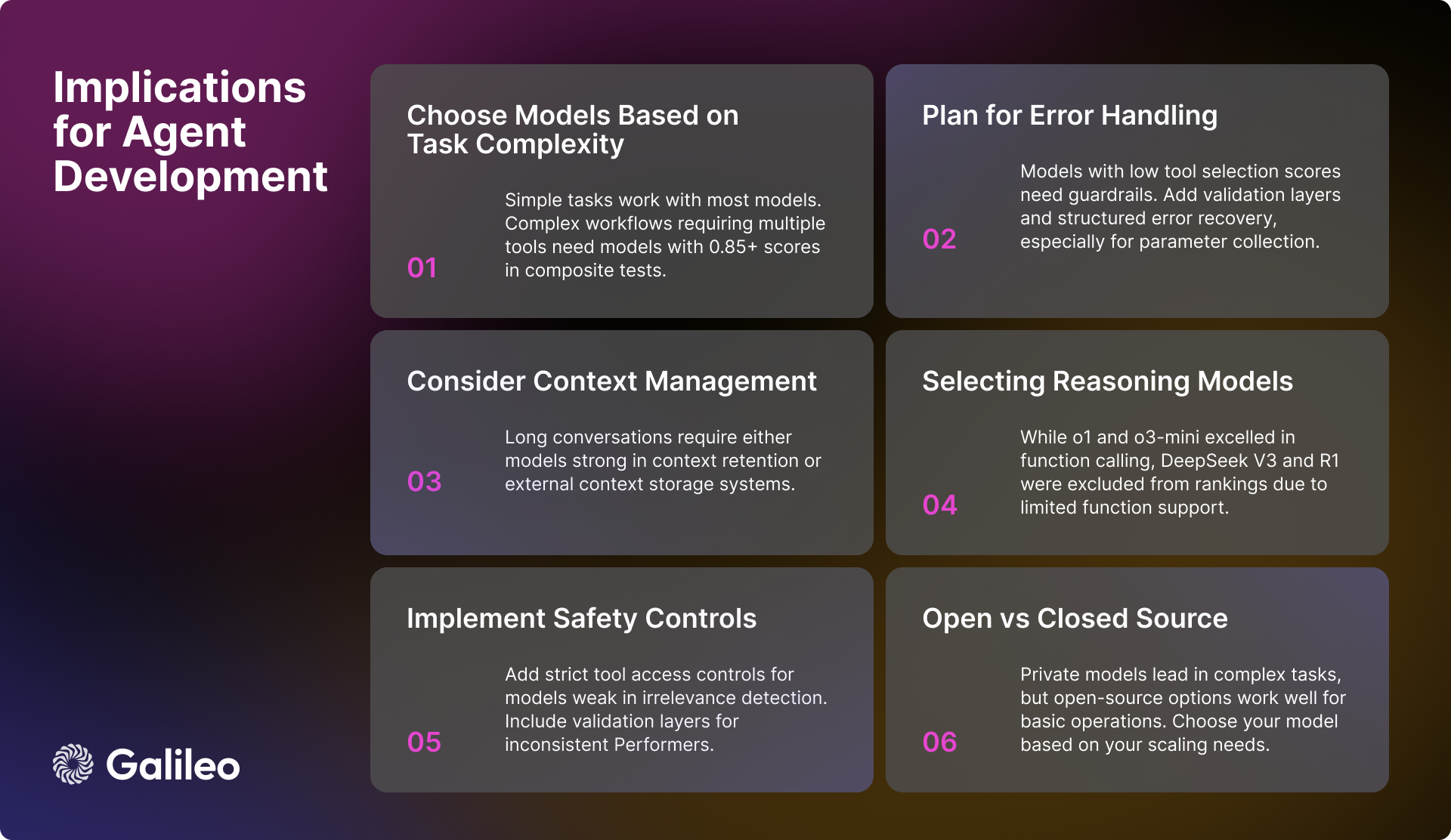

Implicações práticas para os engenheiros de IA

Os resultados da avaliação do Hugging Face fornecem muitos insights valiosos para os engenheiros de IA no desenvolvimento de inteligências de IA. Os seguintes fatores-chave precisam ser considerados ao criar um sistema corporal inteligente robusto e eficiente:

Seleção de modelos e desempenho

Para aplicativos que precisam lidar com fluxos de trabalho complexos, é fundamental selecionar modelos de alto desempenho com pontuação acima de 0,85 na tarefa composta. Embora a maioria dos modelos seja capaz de realizar tarefas básicas de invocação de ferramentas, ao lidar com operações paralelas, é mais importante concentrar-se na pontuação de execução do modelo em uma tarefa específica em vez de confiar apenas nas métricas gerais de desempenho.

Gerenciamento de contexto e erros

Para modelos com desempenho ruim em cenários de contexto longo, é fundamental implementar uma estratégia eficaz de resumo do contexto. Quando forem selecionados modelos com deficiências na detecção de irrelevância ou no processamento de parâmetros, deverão ser criados mecanismos robustos de tratamento de erros. Para modelos que exigem suporte adicional na coleta de parâmetros, pode-se considerar um fluxo de trabalho estruturado que oriente o usuário a fornecer as informações necessárias sobre os parâmetros.

Segurança e confiabilidade

Para garantir que o sistema seja seguro e confiável, é importante implementar um controle de acesso rigoroso para as ferramentas, especialmente para modelos que não apresentam bom desempenho na detecção de operações irrelevantes. Para modelos com estabilidade de desempenho insuficiente, considere adicionar camadas de verificação adicionais para melhorar a confiabilidade geral do sistema. Também é fundamental ter um sistema de recuperação de erros bem construído, especialmente para modelos que têm dificuldade para lidar com parâmetros ausentes.

Otimização do desempenho do sistema

Ao projetar a arquitetura do fluxo de trabalho do sistema, deve-se levar em consideração as diferenças na capacidade dos diferentes modelos de lidar com a execução paralela e com cenários de contexto longo. Ao implementar uma estratégia de processamento em lote, é importante avaliar a capacidade de reutilização de ferramentas do modelo, pois isso afetará diretamente a eficiência geral do sistema.

Status atual do desenvolvimento de modelos de IA

Embora os modelos proprietários ainda liderem em termos de capacidade geral, o desempenho dos modelos de código aberto está melhorando rapidamente. Em tarefas simples de interação de ferramentas, todos os tipos de modelos estão se tornando mais sofisticados. Entretanto, em interações complexas de várias rodadas e cenários de contexto longo, os modelos ainda enfrentam muitos desafios.

A variabilidade do desempenho do modelo em diferentes dimensões destaca a importância de selecionar modelos com base em requisitos de casos de uso específicos. Em vez de se concentrar apenas nas métricas genéricas de desempenho do modelo, os desenvolvedores devem avaliar profundamente o desempenho real do modelo nos cenários de aplicativos de destino.

A Hugging Face espera que essa lista de Agent Intelligentsia seja uma referência valiosa para os desenvolvedores.

Visão geral do desempenho do modelo

modelo de inferência

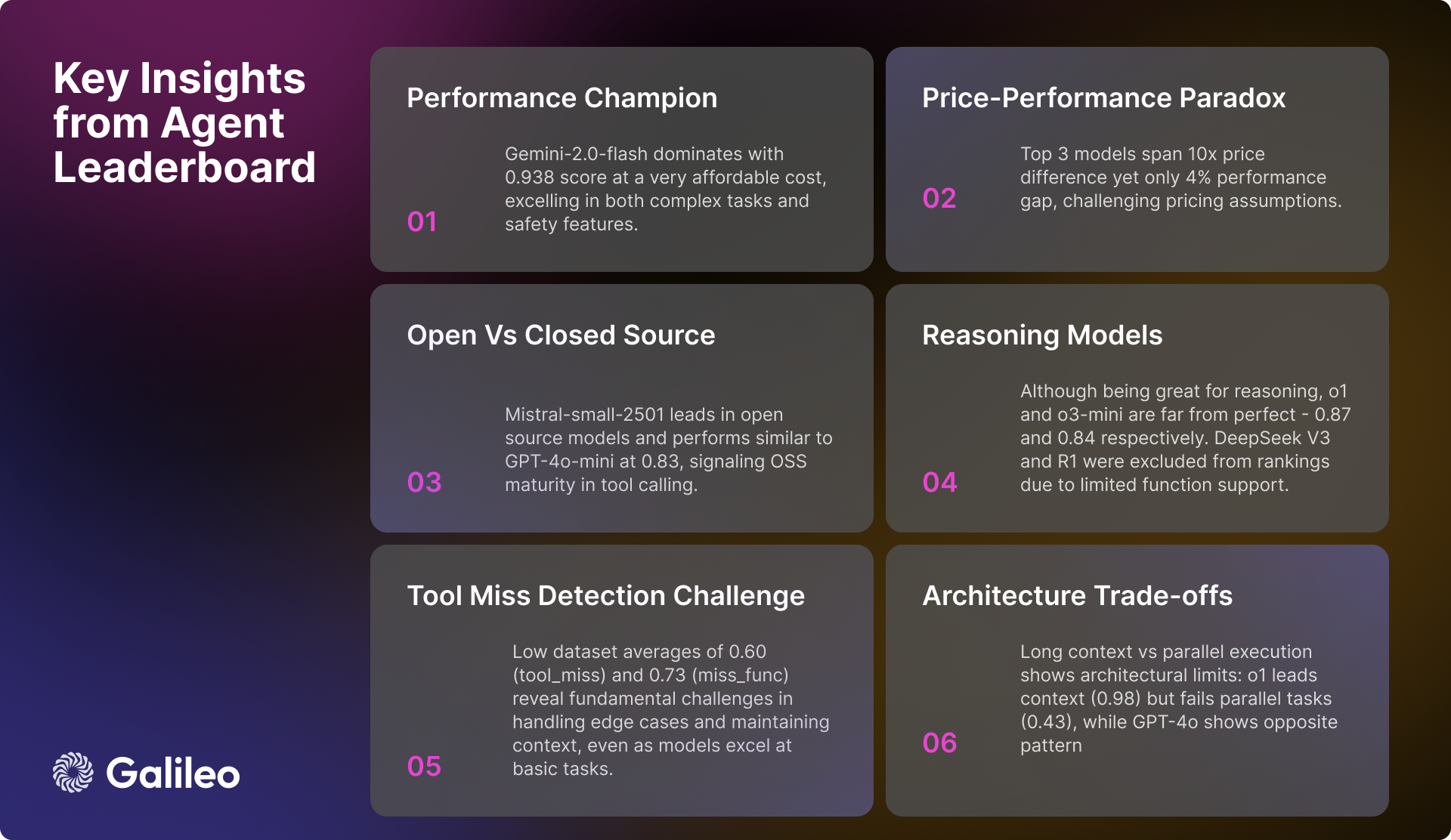

Um fenômeno de interesse na análise do Hugging Face é o desempenho do modelo de inferência. Embora o1 responder cantando o3-mini Embora tenha tido um bom desempenho na integração da capacidade de chamada de função, alcançando pontuações altas de 0,876 e 0,847, respectivamente, o Hugging Face encontrou alguns desafios com outros modelos de inferência. Especificamente.DeepSeek V3 responder cantando Deepseek R1 Os modelos, embora tenham tido um desempenho admirável em termos de recursos de uso geral, foram excluídos da tabela de classificação do Hugging Face devido ao seu suporte limitado a chamadas de função na versão atual.

É preciso enfatizar que DeepSeek V3 responder cantando Deepseek R1 A exclusão das classificações não é uma negação do desempenho superior desses modelos, mas sim uma decisão prudente tomada com pleno entendimento das limitações publicadas dos modelos. Na seção Deepseek V3 e Deepseek R1 Na discussão oficial da Hugging Face, os desenvolvedores deixaram claro que as versões atuais desses modelos ainda não oferecem suporte a chamadas de função. A Hugging Face optou por aguardar uma versão futura com suporte nativo a chamadas de função em vez de tentar criar soluções alternativas ou apresentar métricas de desempenho potencialmente enganosas.

Este caso подчеркивает As chamadas de função são um recurso especializado que nem todos os modelos de linguagem de alto desempenho têm por padrão. Mesmo os modelos que se destacam em raciocínio podem não suportar nativamente chamadas de função estruturadas se não forem especificamente projetados e treinados para isso. Portanto, uma avaliação completa do modelo para seu caso de uso específico garantirá que você faça a melhor escolha.

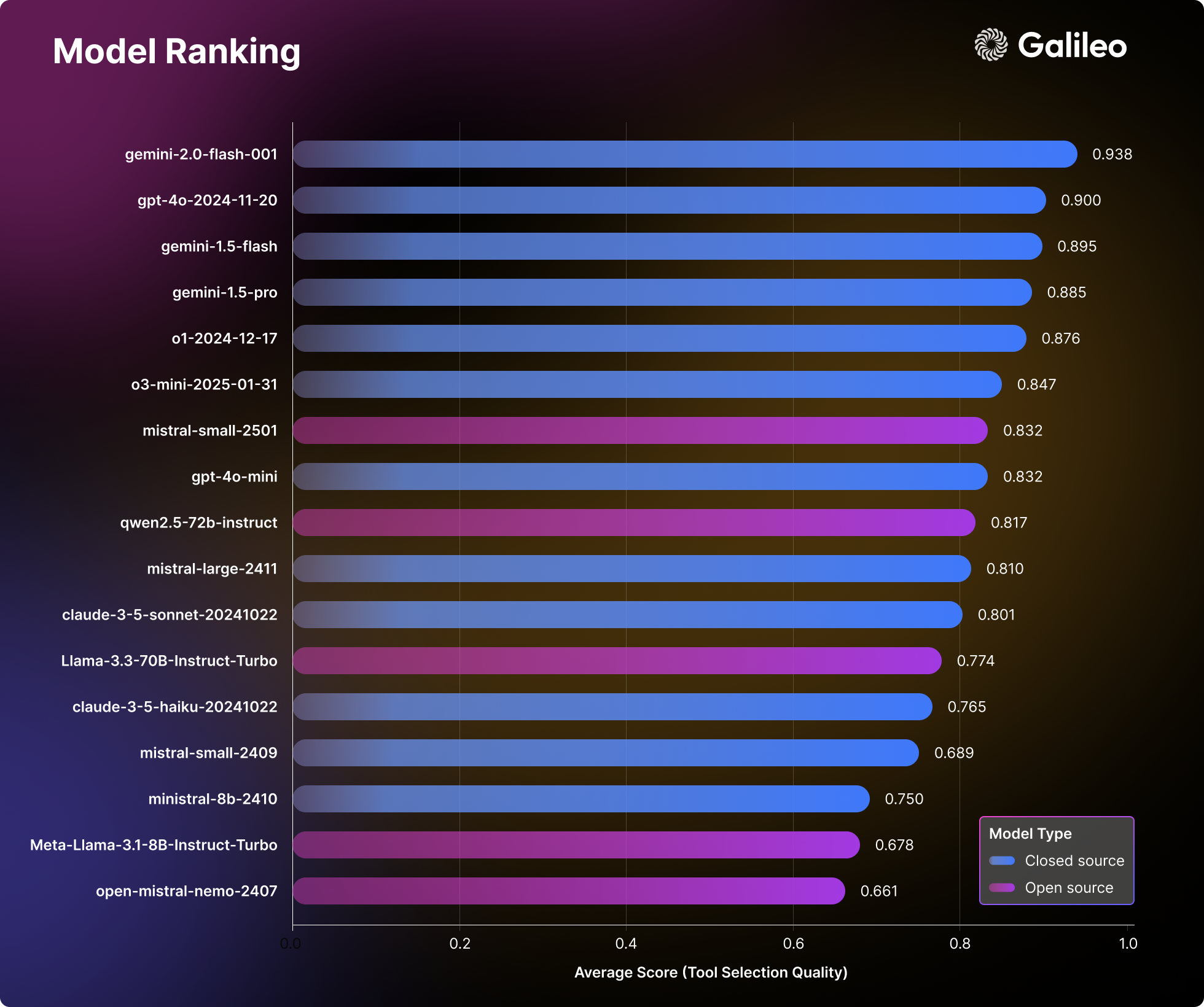

Desempenho de nível de elite (>= 0,9)

Gemini-2.0-flash O modelo continua a liderar as classificações com uma excelente pontuação média de 0,938. O modelo demonstra excelente estabilidade e consistência em todas as categorias de avaliação, com pontos fortes específicos em cenários compostos (0,95) e detecção de irrelevância (0,98). Considerando seu custo por milhão token Preços de US$ 0,15/US$ 0,6.Gemini-2.0-flash Um equilíbrio convincente entre desempenho e custo-benefício.

Seguido de perto por GPT-4oO modelo obteve uma pontuação alta de 0,900 e teve um bom desempenho em tarefas complexas, como processamento de várias ferramentas (0,99) e execução paralela (0,98). Embora GPT-4o O preço é significativamente mais alto, de US$ 2,5/US$ 10 por milhão de tokens, mas seu desempenho superior ainda é um fator determinante para seu custo mais alto.

Banda de alto desempenho (0,85 a 0,9)

O segmento de alto desempenho concentra-se em uma série de modelos fortes. Gemini-1.5-flash A excelente marca de 0,895 é mantida, especialmente na detecção de não correlação (0,98) e no desempenho de função única (0,99). Gemini-1.5-pro Apesar do preço mais alto de US$ 1,25/US$ 5 por milhão de tokens, ele ainda obteve uma pontuação alta de 0,885, demonstrando pontos fortes significativos em tarefas combinadas (0,93) e execução de ferramenta única (0,99).

o1 O modelo, apesar de seu preço mais alto de US$ 15/US$ 60 por milhão de tokens, ainda comprova sua posição no mercado com uma pontuação de 0,876 e o poder de processamento de contexto longo líder do setor (0,98). Modelos emergentes o3-mini Ele é competitivo com 0,847, é excelente em chamadas de função única (0,975) e detecção de irrelevância (0,97) e oferece uma opção bem equilibrada com preços de US$ 1,1/US$ 4,4 por milhão de tokens.

Capacidade de nível médio (0,8 a 0,85)

GPT-4o-mini mantém um desempenho eficiente de 0,832, com desempenho particularmente bom no uso de ferramentas paralelas (0,99) e na seleção de ferramentas. No entanto, o modelo tem um desempenho relativamente ruim em cenários de contexto longo (0,51).

No campo da modelagem de código aberto, omistral-pequeno-2501 Liderando o caminho com uma pontuação de 0,832, o modelo mostra melhorias significativas no processamento de contexto longo (0,92) e nos recursos de seleção de ferramentas (0,99) em comparação com a versão anterior. Qwen-72b Com uma pontuação de 0,817, ele vem logo atrás, sendo capaz de igualar o modelo privado na detecção de irrelevância (0,99) e demonstrando um forte processamento de contexto longo (0,92). Mistral-grande Tem bom desempenho na seleção de ferramentas (0,97), mas ainda enfrenta desafios na integração de tarefas (0,76).

Claude-sonnet obteve uma pontuação de 0,801 e se destacou na detecção de deleção instrumental (0,92) e no processamento de função única (0,955).

Modelo de camada básica (<0,8)

Os modelos de nível básico consistiam principalmente em modelos com bom desempenho em domínios específicos, mas relativamente baixos em termos de pontuações gerais. Claude-haiku Oferecendo um desempenho mais equilibrado com uma pontuação de 0,765 e com preço de US$ 0,8/US$ 4 por milhão de tokens, ele demonstra uma excelente relação custo-benefício.

modelo de código aberto Llama-70B mostra um potencial de 0,774, especialmente no cenário de várias ferramentas (0,99). Enquanto Mistral-pequeno (0.750), Mistral-8b (0,689) e Mistral-nemo (0,661) e outras variantes de menor escala do modelo, por outro lado, oferecem aos usuários opções eficientes em cenários de tarefas básicas.

Esses conjuntos de dados são essenciais para a construção de uma estrutura para avaliar de forma abrangente os recursos de invocação das ferramentas de modelagem de linguagem.

Comentários: A classificação do corpo inteligente do agente lançada pela Hugging Face capta com precisão o principal ponto problemático do atual aplicativo de modelo de linguagem grande: como usar as ferramentas de forma eficiente. Há muito tempo, a atenção do setor tem se concentrado na capacidade do modelo em si; no entanto, a capacidade de invocação de ferramentas é a chave para que o modelo seja realmente implementado e resolva os problemas reais. O surgimento dessa classificação, sem dúvida, oferece aos desenvolvedores uma referência valiosa para ajudá-los a escolher o modelo mais adequado para um cenário de aplicação específico. Da metodologia de avaliação à construção do conjunto de dados e à análise de desempenho final, o relatório da Hugging Face demonstra seu profissionalismo rigoroso e meticuloso e também reflete seus esforços ativos na promoção da implementação de aplicativos de IA. É especialmente louvável que a classificação não se concentre apenas no desempenho absoluto dos modelos, mas também analise o desempenho dos modelos em diferentes cenários, como processamento de contexto longo e invocações de várias ferramentas, que são considerações cruciais em aplicativos do mundo real. Além disso, a Hugging Face generosamente abriu o código-fonte do conjunto de dados de avaliação, o que, sem dúvida, promoverá ainda mais a pesquisa e o desenvolvimento da comunidade na área de recursos de invocação de ferramentas. Em suma, trata-se de um esforço muito oportuno e valioso.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...