HiOllama: uma interface de bate-papo limpa para interagir com modelos nativos do Ollama

Introdução geral

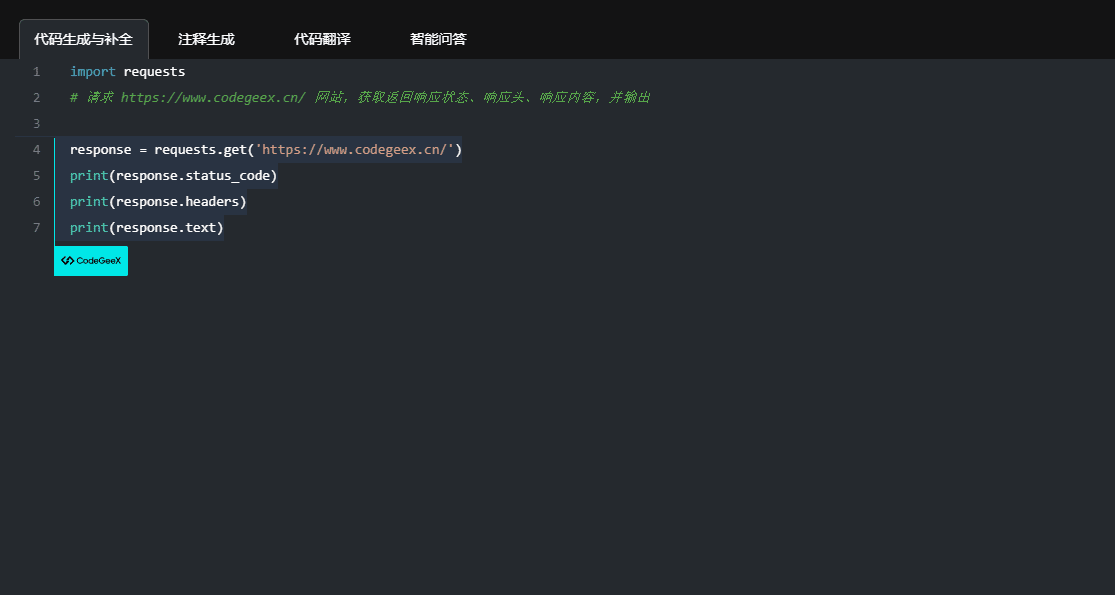

O HiOllama é uma interface amigável criada em Python e Gradio, projetada para interagir com os modelos Ollama. Ela oferece uma interface da Web simples e intuitiva que suporta geração de texto em tempo real e recursos de gerenciamento de modelos. Os usuários podem ajustar parâmetros como temperatura e número máximo de tokens, além de oferecer suporte ao gerenciamento de vários modelos do Ollama e à configuração personalizada do URL do servidor.

RECOMENDAÇÃO: Ollama vs. Abrir a WebUI A integração é mais amigável, mas os custos de implementação são um pouco mais altos.

Lista de funções

- Interface da Web simples e intuitiva

- Geração de texto em tempo real

- Parâmetros ajustáveis (temperatura, número máximo de tokens)

- Funções de gerenciamento de modelos

- Suporte a vários modelos Ollama

- Configuração personalizada do URL do servidor

Usando a Ajuda

Etapas de instalação

- Armazém de Clonagem:

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - Criar e ativar um ambiente virtual:

- Windows.

python -m venv env .\env\Scripts\activate - Linux/Mac.

python3 -m venv env source env/bin/activate

- Windows.

- Instale os pacotes necessários:

pip install -r requirements.txt - Instale o Ollama (se ainda não estiver instalado):

- Linux/Mac.

curl -fsSL https://ollama.ai/install.sh | sh - Windows.

Instale o WSL2 primeiro e, em seguida, execute o comando acima.

- Linux/Mac.

Etapas de uso

- Inicie o serviço Ollama:

ollama serve - Execute o HiOllama:

python main.py - Abra seu navegador e navegue até:

http://localhost:7860

Guia de início rápido

- Selecione um modelo no menu suspenso.

- Digite o prompt na área de texto.

- Ajuste a temperatura e o número máximo de tokens conforme necessário.

- Clique em "Generate" (Gerar) para obter a resposta.

- Use a opção Model Management para obter novos modelos.

configurar

As configurações padrão podem ser definidas nomain.pyModificado em:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

problemas comuns

- erro de conexãoVerifique se o Ollama está em execução (

ollama serve), verifique se o URL do servidor está correto e se a porta 11434 está acessível. - Modelo não encontradoPuxe o modelo primeiro:

ollama pull model_nameVerifique os modelos disponíveis:ollama list. - conflito portuário: em

main.pyAltere a porta na seçãoapp.launch(server_port=7860) # 更改为其他端口

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...