Relatório técnico do KAG, a primeira estrutura de serviço de aprimoramento de conhecimento de domínio profissional na China, que ajuda grandes modelos a se estabelecerem em domínios verticais.

Recentemente, Liang Lei, chefe do mecanismo de conhecimento do Ant Group, compartilhou o progresso do trabalho da equipe nos últimos seis meses na pesquisa de fusão de gráfico de conhecimento e modelo de linguagem em larga escala na Bund Conference, e lançou o KAG, a primeira estrutura de serviço de aprimoramento de conhecimento para domínios profissionais na China, que ajuda a criar inteligências profissionais com funções de aprimoramento de conhecimento. Este artigo é uma compilação textual do conteúdo do relatório.

Relatórios técnicos relacionados Endereço do arXiv:https://arxiv.org/pdf/2409.13731

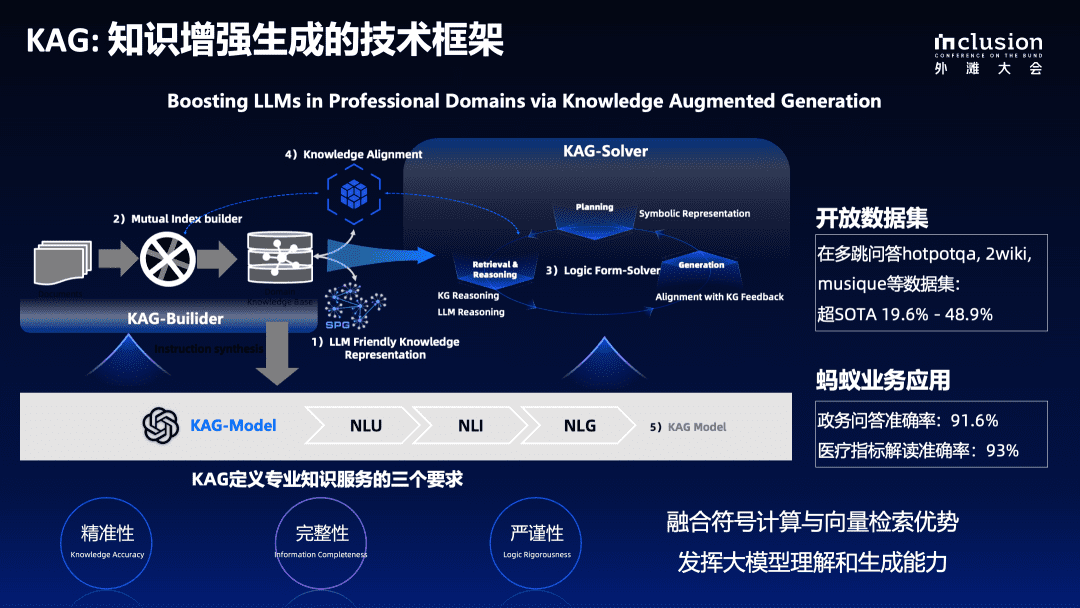

Desta vez, anunciamos KAG do relatório técnico geral. Esperamos realmente mesclar as vantagens da computação simbólica e da recuperação vetorial de gráficos de conhecimento, pois elas são complementares em muitos aspectos. Ao mesmo tempo, criaremos um sistema de geração de modelos de linguagem grandes e aprimorados pelo conhecimento, aproveitando os recursos de compreensão e geração de modelos de linguagem grandes.

Estamos prestes a entrar em OpenSPG A estrutura do KAG está publicada no projeto de código aberto, endereço do GitHub:

https://github.com/OpenSPG/KAG

Principais problemas na aplicação de grandes verticais de modelagem

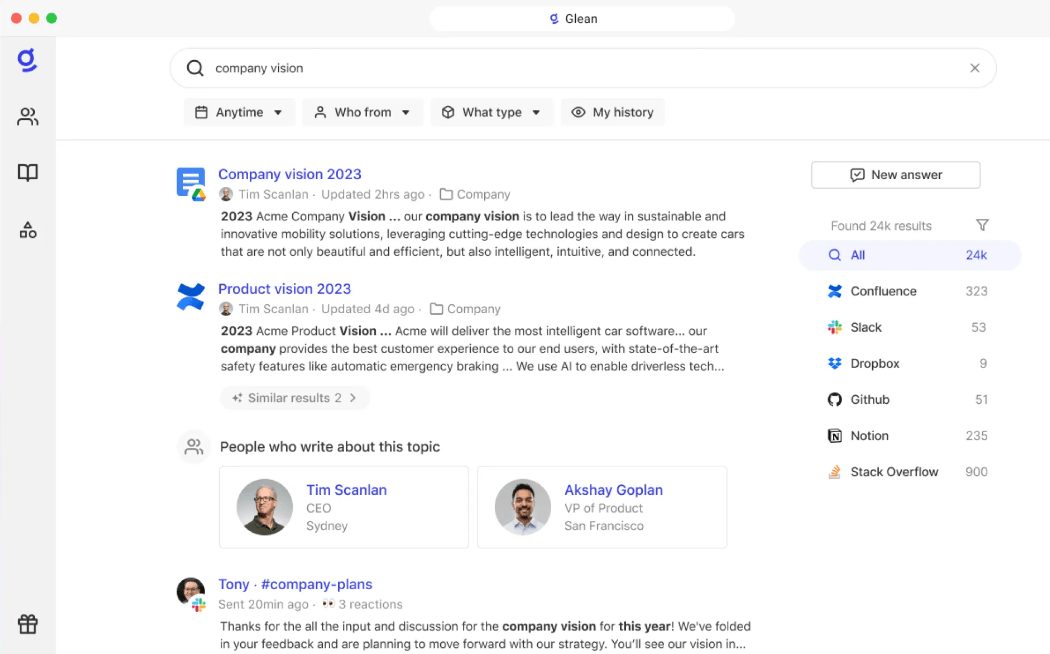

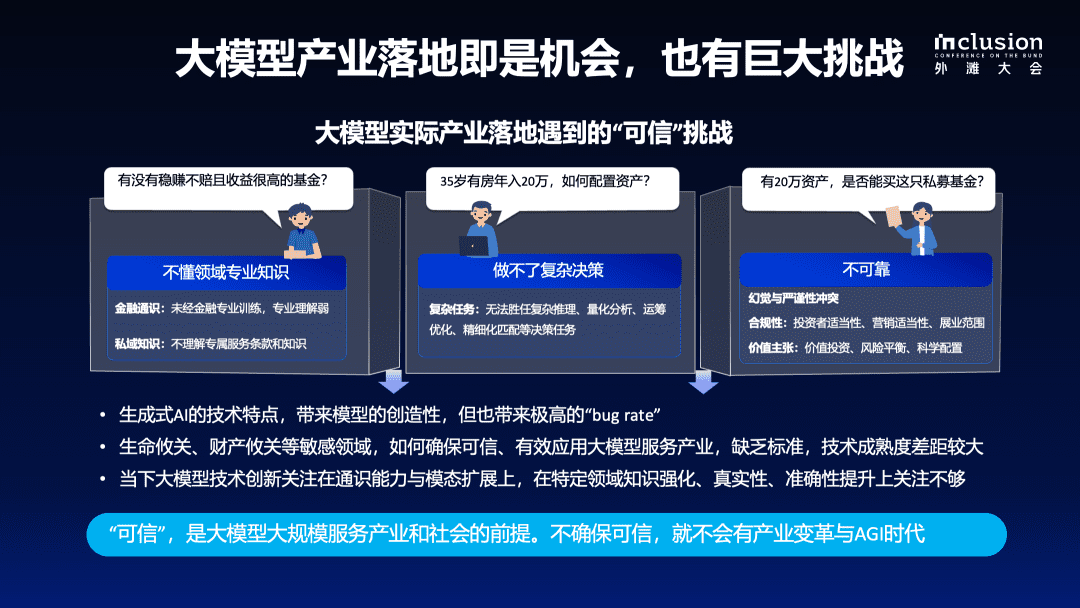

Após quase dois anos de pesquisa e prática, o setor reconheceu, de modo geral, os pontos fortes e as limitações dos modelos de Big Language, bem como seus desafios em aplicativos específicos do setor. Embora os modelos de Big Language tenham demonstrado recursos sólidos de compreensão e geração, ainda existem problemas como a falta de conhecimento do domínio, a dificuldade de tomar decisões complexas e a falta de confiabilidade em domínios profissionais. Acreditamos que a "confiabilidade" é um pré-requisito fundamental para a implementação de grandes modelos de linguagem em cenários do mundo real.

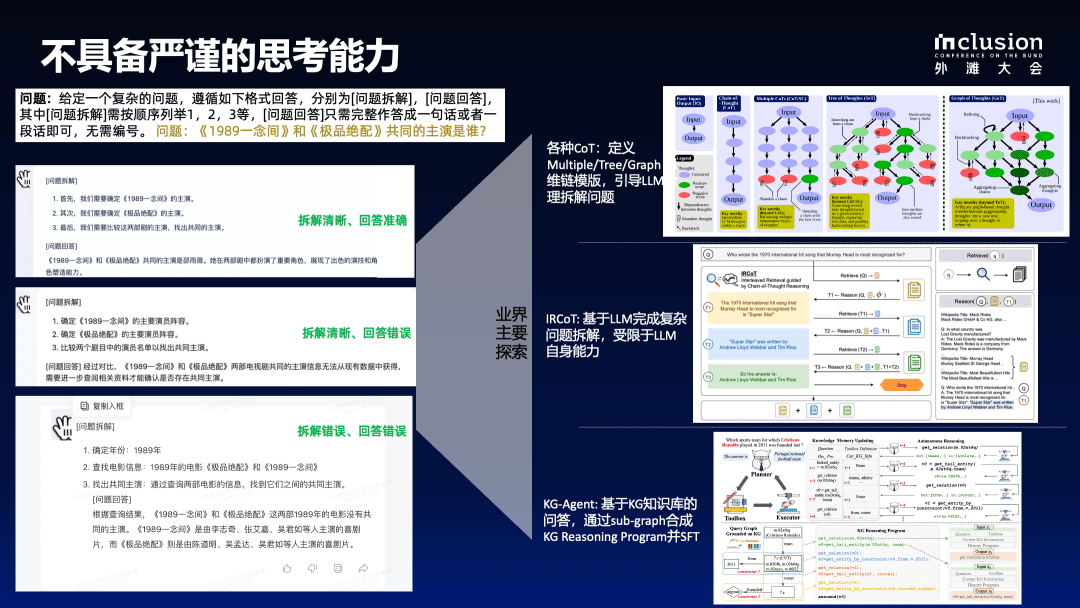

1.1 O LLM não tem a capacidade de pensar criticamente

Em primeiro lugar, os modelos de linguagem grandes não oferecem recursos rigorosos de raciocínio. Por exemplo, usamos a pergunta "Quem é a estrela comum de 1989 A Thought e The Best Match?" Nessa pergunta, testamos vários modelos de linguagem grandes na China separadamente, e os resultados mostram que a precisão e a consistência das respostas são baixas. Mesmo que alguns modelos possam dar uma resposta, há erros de lógica ou desmontagem inadequada do problema. À medida que as condições se tornam mais complexas, como a alteração das condições para "ator principal masculino" e "ator principal feminino" ou a adição de restrições de tempo, a precisão e a estabilidade continuarão a diminuir.

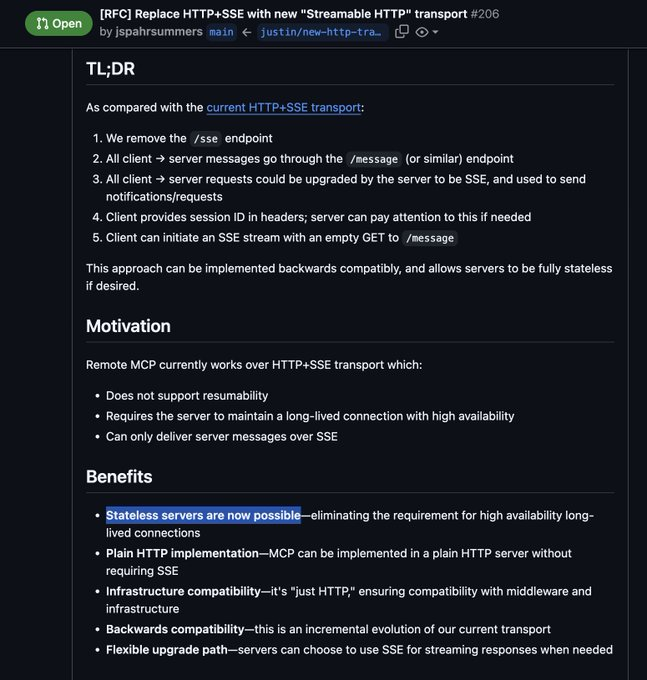

Para resolver esses problemas, muitas explorações foram realizadas no setor. Por exemplo, ao construir o modelo de cadeia de pensamento (COT) e definir o modelo de cadeia de pensamento múltiplo/árvore/gráfico, o LLM é orientado para desmontar o problema de forma razoável. Este ano, mais e mais pesquisas têm se concentrado em trazer o RAG no modelo de linguagem grande para compensar a falta de informações factuais. Outros desenvolvimentos envolvem o GraphRAG, que emprega estruturas gráficas para otimizar os mecanismos de recuperação.

A introdução de bases de conhecimento externas é amplamente usada atualmente, mas mesmo quando técnicas como a RAG são introduzidas para disponibilizar bases de conhecimento específicas do domínio ou arquivos de fatos para regeneração em modelos de linguagem grandes, a precisão das respostas geradas ainda não é totalmente garantida.

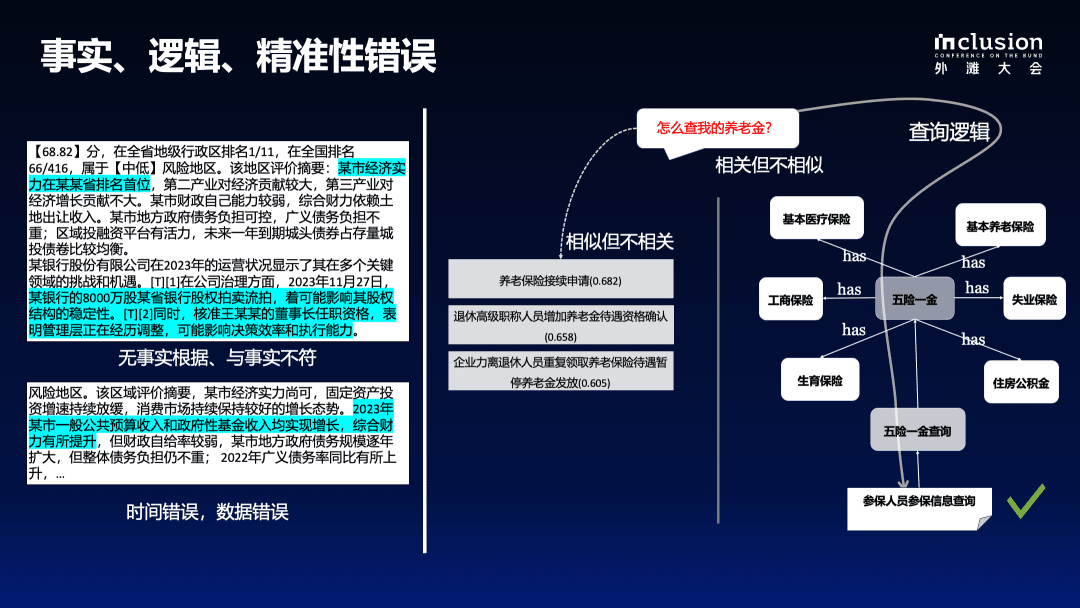

1.2 Erros de fato, lógica e precisão

O lado esquerdo da figura abaixo mostra um exemplo do uso de um big model para interpretar um indicador em um relatório do governo. Embora as pessoas de negócios tenham marcado o indicador com antecedência, o big model ainda adicionará seu próprio entendimento, resultando em informações distorcidas ou erros sem suporte. Por exemplo, é mencionado que uma determinada cidade está em primeiro lugar em uma determinada província, mas isso é incorreto do ponto de vista comercial. Da mesma forma, a informação sobre uma participação de US$ 80 milhões em um banco que foi a leilão não está presente no documento original. Pior ainda, o modelo também produz erros numéricos e lógicos, em que as métricas de negócios fornecidas no documento original pertencem a 2022, mas o conteúdo gerado é rotulado como 2023.

As imprecisões no processo de recuperação continuam sendo um problema, mesmo quando uma base de conhecimento externa é fornecida. O exemplo à direita ilustra as deficiências da abordagem RAG baseada no cálculo de vetores. Por exemplo, ao consultar como encontrar uma pensão, o uso direto de vetores para calcular documentos recuperados não se correlaciona com o conhecimento definido pelos especialistas em negócios.

Em domínios verticais, muitos conhecimentos estão, na verdade, intimamente relacionados uns aos outros, mesmo que não pareçam semelhantes na superfície. Por exemplo, "pensão" pertence à categoria de "cinco seguros e uma pensão", que está intimamente relacionada à política nacional, e o modelo de grande porte não pode gerar essas informações arbitrariamente. Portanto, é necessária uma estrutura de conhecimento de domínio predefinida para restringir o comportamento do modelo e fornecer uma entrada de conhecimento eficaz.

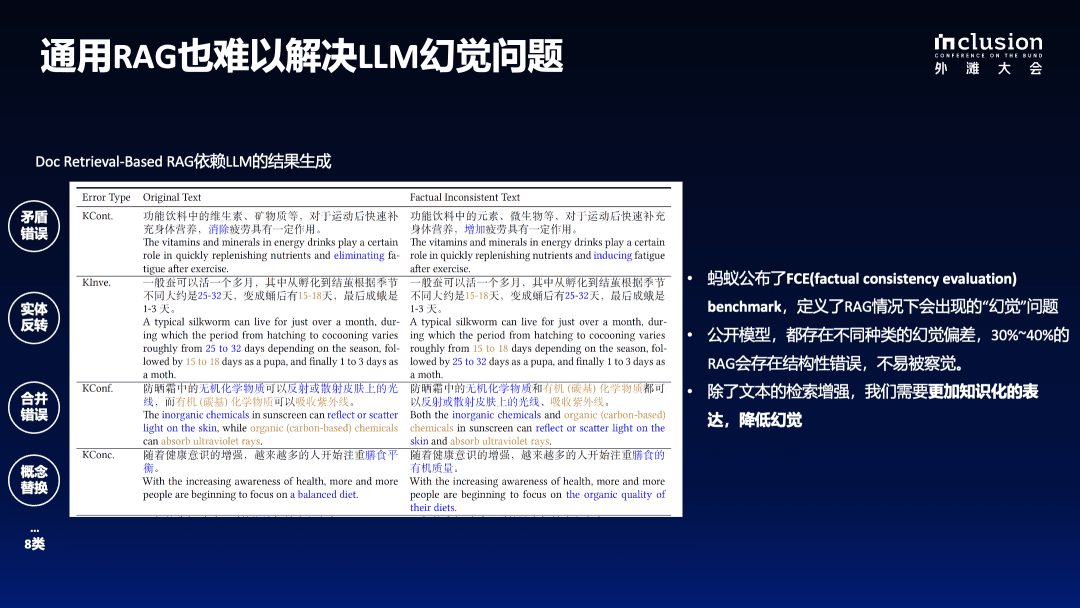

1.3 O RAG genérico também tem dificuldades para resolver as ilusões do LLM

Conforme mostrado na figura abaixo, o texto original menciona que as vitaminas e os minerais das bebidas funcionais são benéficos para reabastecer o corpo e eliminar a fadiga após o exercício, mas depois que o modelo é reescrito, ele pode ser incorretamente descrito como "tendo um certo efeito no aumento da fadiga", o que é uma mensagem enganosa que causará angústia aos usuários.

Além disso, há problemas com inversões de entidades, como reescrever a frase original de "15-18 dias depois de se tornar uma pupa" para "25-32 dias depois de se tornar uma pupa". Esses tipos de erros de detalhes tornam-se mais difíceis de detectar quando o modelo gera centenas ou até milhares de palavras de conteúdo.

De acordo com os resultados da avaliação, mesmo com a incorporação da técnica RAG, o modelo de linguagem de grande porte ainda sofre com uma taxa fantasma de 30%-40%, que é uma porcentagem bastante alta. Portanto, ao aplicar modelos de linguagem de grande escala em domínios verticais, eles devem atender a requisitos de profissionalismo extremamente altos.

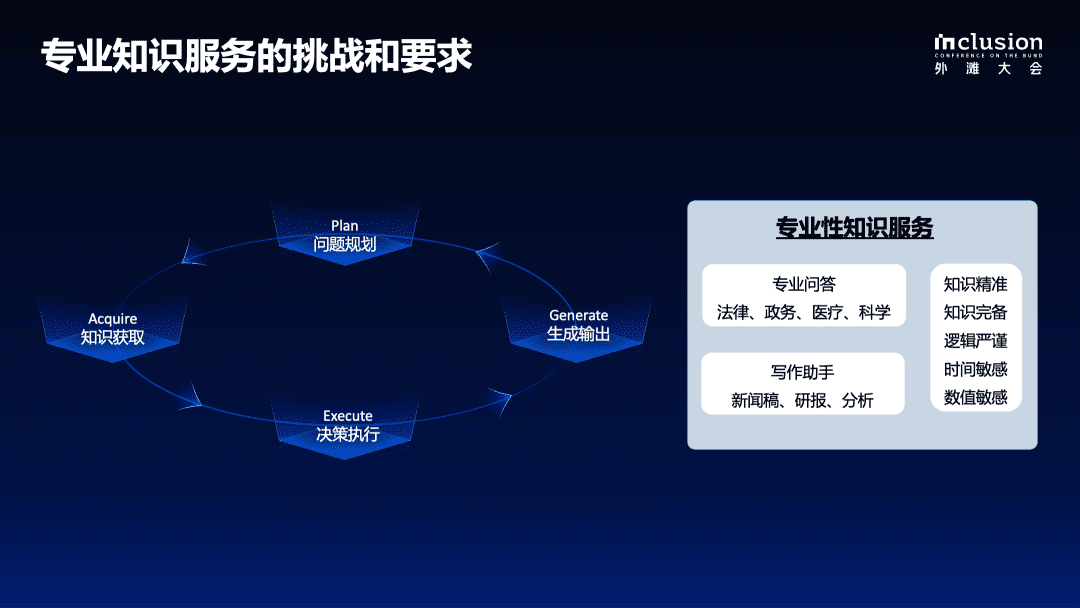

1.4 Desafios e requisitos para serviços de conhecimento profissional

Em cenários reais de tomada de decisões de negócios, seja na geração de um relatório de pesquisa ou no tratamento de um sinistro de seguro de automóvel, a solução de problemas complexos exige um processo rigoroso passo a passo que inclui o planejamento do problema, a coleta de dados, a execução da decisão e a geração e o fornecimento de feedback. Também deve haver um processo de tomada de decisão rigoroso e controlado ao aplicar modelos de Big Language a domínios profissionais.

Ao fornecer serviços especializados com base em um modelo amplo, várias condições devem ser atendidas para melhor servir a comunidade e os domínios específicos:

- Em primeiro lugar, é importante garantir a precisão do conhecimento, incluindo a integridade de seus limites e a clareza de sua estrutura e semântica;

- Em segundo lugar, é necessário rigor lógico, sensibilidade temporal e sensibilidade numérica;

- Por fim, são necessárias informações contextuais completas para facilitar o acesso a informações de apoio completas ao tomar decisões baseadas em conhecimento;

O acima exposto também é um recurso que atualmente não existe na maioria dos modelos grandes. Em vista disso, no primeiro semestre deste ano, fizemos muitas pesquisas e começamos formalmente a criar uma estrutura de geração controlada com base no aprimoramento do conhecimento para domínios verticais.

KAG: Estrutura de serviço de aumento de conhecimento para áreas de especialização

A figura abaixo ilustra o princípio de nossa estrutura geral de Geração de Conhecimento Aprimorado (KAG), que se baseia na OpenSPG Atualizações baseadas em projetos de código aberto. Fizemos aprimoramentos para abordar cinco aspectos da combinação atual de modelos de linguagem grandes e gráficos de conhecimento:

Em primeiro lugar, conseguimos aprimorar a representação do conhecimento. O gráfico de conhecimento original é limitado por um esquema forte, o que leva a um alto limite de aplicação e a dados esparsos, tornando-o muitas vezes insolúvel ao responder a perguntas em domínios verticais. Por esse motivo, otimizamos e atualizamos a representação do conhecimento para modelos de linguagem grandes, de modo que o gráfico de conhecimento possa dar melhor suporte à aplicação de modelos de linguagem grandes.

Em segundo lugar, os gráficos servem como uma excelente ferramenta de integração para conectar melhor todos os tipos de conhecimento, seja o conhecimento acadêmico rigoroso ou as informações de um texto. Portanto.Criamos uma estrutura de índice mútuo, atualizando de um índice invertido baseado em termos para um índice invertido baseado em gráficos.Isso não apenas indexa documentos com eficiência, mas também mantém associações semânticas entre documentos e a coerência entre entidades.

Terceiro, durante o processo de raciocínio, empregamos a desmontagem simbólica para garantir o rigor lógico. É difícil garantir a consistência lógica na linguagem gerada pelo modelo de linguagem, por isso introduzimos o LogicForm-driven Solver and Reasoning para desambiguação baseada em símbolos.

Em quarto lugar, para preencher a lacuna entre o custo da construção do gráfico de conhecimento e a eficiência da aplicação prática, tomamos emprestado o método de extração de informações abertas para construir o gráfico de conhecimento, o que reduz muito o custo de construção, mas também introduz mais ruído. Portanto, introduzimos o mecanismo de alinhamento do conhecimento, que usa o conhecimento conceitual para concluir o alinhamento entre as informações abertas e o conhecimento do domínio, com o objetivo de equilibrar as necessidades da extração de informações abertas e do alinhamento semântico.

Por fim, desenvolvemos o modelo KAG com o objetivo de integrar melhor os recursos de modelos de linguagem em grande escala e gráficos de conhecimento para obter uma sinergia mais eficaz. A interação orgânica entre os dois é facilitada por meio da síntese de instruções, com o objetivo final de integrar totalmente as vantagens da computação simbólica e da recuperação de vetores, além de dar total ênfase aos recursos de compreensão e geração do modelo de linguagem, promovendo assim sua aplicação e seus recursos em domínios verticais.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...