GPT4All: um cliente de modelo de idioma grande executado em CPUs com foco em localização e segurança de dados

Introdução geral ao GPT4All

O GPT-4All é um projeto de código aberto desenvolvido pela Nomic para permitir que os usuários executem modelos de linguagem grandes (LLMs) em dispositivos locais. Com ênfase na proteção da privacidade, o projeto pode ser usado sem conexão com a Internet e é adequado para usuários pessoais e comerciais. O GPT-4All é compatível com uma ampla variedade de hardware, incluindo chips Mac série M, GPUs AMD e NVIDIA, e pode ser facilmente executado por usuários em computadores desktop e laptop. O projeto também oferece um modelo rico de código aberto e suporte da comunidade, permitindo que os usuários personalizem a experiência do chatbot de acordo com suas necessidades.

O GPT4All é um ecossistema para a execução de modelos de linguagem avançados e personalizados em larga escala que são executados nativamente em CPUs de consumo e em qualquer GPU. Observe que sua CPU precisa suportar instruções AVX ou AVX2.

O modelo GPT4All é um arquivo de 3 GB a 8 GB que pode ser baixado e inserido no software de ecossistema de código aberto GPT4All. A Nomic AI oferece suporte e mantém esse ecossistema de software para garantir a qualidade e a segurança e está liderando o esforço para facilitar o treinamento e a implantação de seus próprios modelos de linguagem de grande escala Edge por qualquer indivíduo ou organização.

Ele não requer uma GPU nem uma conexão com a Internet e é capaz de realizar latência de inferência em tempo real no M1 Mac.

caracterização

Seu bate-papo é privado e nunca sai do seu dispositivo!

O GPT4All tem a privacidade e a segurança como sua primeira prioridade. Use o LLM para lidar com seus dados locais confidenciais que nunca saem de seu dispositivo.

Execução de modelos de linguagem no hardware do consumidor

O GPT4All permite que você execute o LLM em CPUs e GPUs, com suporte total para chips Mac série M e GPUs AMD e NVIDIA.

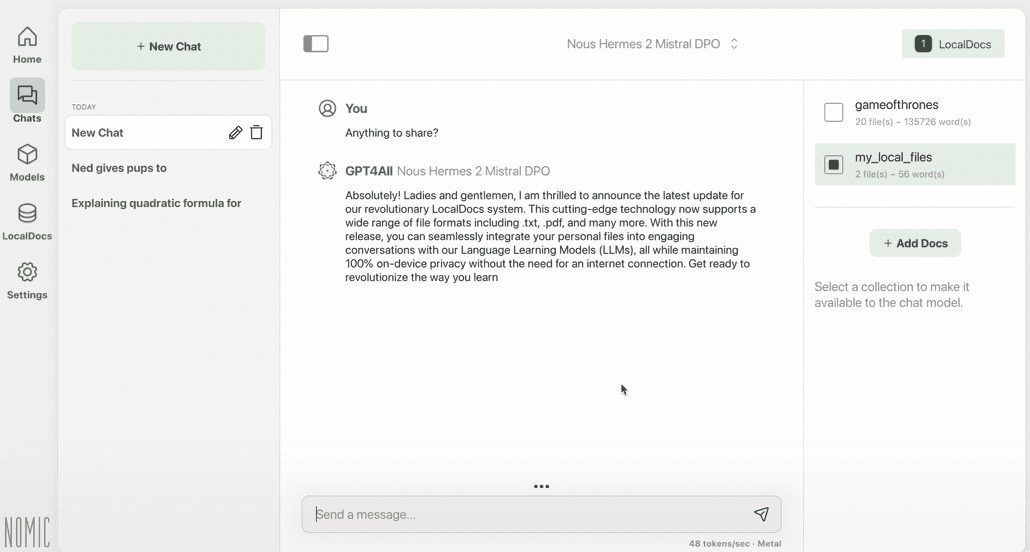

Bate-papo com arquivos locais

Use o LocalDocs para conceder ao LLM local acesso às suas informações privadas e confidenciais. Ele funciona sem a Internet e nenhum dado sai de seu dispositivo.

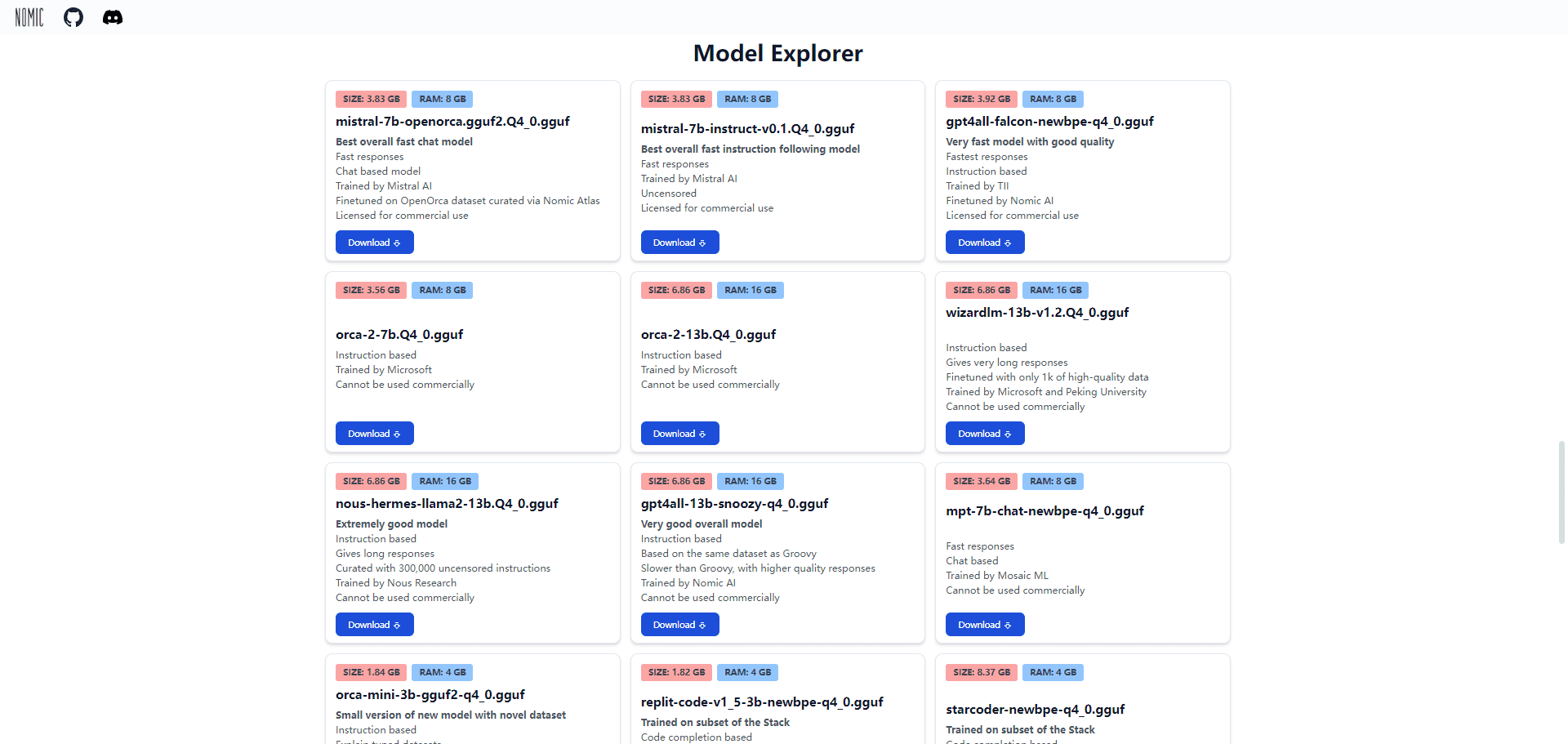

Explore mais de 1.000 modelos de linguagem de código aberto

O GPT4All é compatível com LLaMa, Mistral, Nous-Hermes e centenas de outros modelos populares.

Lista de funções

- operação localExecute LLMs em um dispositivo local sem conexão com a Internet.

- PrivacidadeTodos os dados são armazenados localmente para garantir a privacidade do usuário.

- Suporte a vários hardwaresCompatível com chips Mac série M, GPUs AMD e NVIDIA.

- comunidade de código abertoModelos avançados de código aberto e suporte da comunidade.

- PersonalizaçãoOs usuários podem personalizar os avisos do sistema do chatbot, a temperatura, a duração do contexto e outros parâmetros.

- Edição EnterpriseOferece suporte e funcionalidade de nível empresarial para implementações em grande escala.

Usando a Ajuda

Processo de instalação

- Faça o download do aplicativo::

- entrevistas Site oficial da Nomic Faça o download do pacote de instalação para Windows, macOS ou Ubuntu.

- Os usuários de Windows e Linux devem garantir que o dispositivo esteja equipado com um processador Intel Core i3 de 2ª geração / AMD Bulldozer ou superior.

- Os usuários do macOS precisam estar executando o Monterey 12.6 ou posterior, que funciona melhor nos processadores Apple Silicon série M.

- Instalação de aplicativos::

- Usuários do Windows: Execute o pacote de instalação baixado e siga as instruções para concluir a instalação.

- Usuários do macOS: arraste o aplicativo baixado para a pasta Aplicativos.

- Usuários do Ubuntu: instale o arquivo de pacote baixado usando a linha de comando.

- Inicie o aplicativo::

- Após a conclusão da instalação, abra o aplicativo GPT-4All e siga as instruções para a configuração inicial.

Diretrizes para uso

- Execução do modelo local::

- Depois de abrir o aplicativo, selecione o modelo de idioma desejado para fazer download e carregar.

- Há suporte para uma ampla variedade de modelos, incluindo LLaMa, Mistral, Nous-Hermes e outros.

- Chatbots personalizados::

- Ajuste parâmetros como alertas do sistema, temperatura e duração do contexto nas configurações para otimizar a experiência de bate-papo.

- Use o recurso LocalDocs para permitir que os LLMs locais acessem seus dados privados sem uma conexão com a Internet.

- Recursos do Enterprise Edition::

- Os usuários corporativos podem entrar em contato com a Nomic para obter uma licença Enterprise Edition e desfrutar de suporte e recursos adicionais.

- A Enterprise Edition é adequada para implementações em grande escala e oferece segurança e suporte aprimorados.

- Suporte à comunidade::

- Junte-se à comunidade GPT-4All para participar de discussões e contribuir com código.

- entrevistas Repositório do GitHub Obtenha as atualizações e a documentação mais recentes.

problemas comuns

- Como você garante a privacidade dos dados? GPT-4All Todos os dados são armazenados localmente no dispositivo, garantindo que a privacidade do usuário não seja violada.

- É necessária uma conexão com a Internet? Não. O GPT-4All pode ser executado completamente off-line em um dispositivo local.

- Qual é o hardware suportado? Compatível com chips Mac série M, GPUs AMD e NVIDIA e computadores desktop e laptop comuns.

Avaliação comparativa do modelo GPT4All

| Modelo | BoolQ | PIQA | HellaSwag | WinoGrande | ARC-e | ARC-c | OBQA | Média |

|---|---|---|---|---|---|---|---|---|

| GPT4All-J 6B v1.0 | 73.4 | 74.8 | 63.4 | 64.7 | 54.9 | 36 | 40.2 | 58.2 |

| GPT4All-J v1.1-breezy | 74 | 75.1 | 63.2 | 63.6 | 55.4 | 34.9 | 38.4 | 57.8 |

| GPT4All-J v1.2-jazzy | 74.8 | 74.9 | 63.6 | 63.8 | 56.6 | 35.3 | 41 | 58.6 |

| GPT4All-J v1.3-groovy | 73.6 | 74.3 | 63.8 | 63.5 | 57.7 | 35 | 38.8 | 58.1 |

| GPT4All-J Lora 6B | 68.6 | 75.8 | 66.2 | 63.5 | 56.4 | 35.7 | 40.2 | 58.1 |

| GPT4All LLaMa Lora 7B | 73.1 | 77.6 | 72.1 | 67.8 | 51.1 | 40.4 | 40.2 | 60.3 |

| GPT4All 13B snoozy | 83.3 | 79.2 | 75 | 71.3 | 60.9 | 44.2 | 43.4 | 65.3 |

| GPT4All Falcon | 77.6 | 79.8 | 74.9 | 70.1 | 67.9 | 43.4 | 42.6 | 65.2 |

| Nous-Hermes | 79.5 | 78.9 | 80 | 71.9 | 74.2 | 50.9 | 46.4 | 68.8 |

| Nous-Hermes2 | 83.9 | 80.7 | 80.1 | 71.3 | 75.7 | 52.1 | 46.2 | 70.0 |

| Nous-Puffin | 81.5 | 80.7 | 80.4 | 72.5 | 77.6 | 50.7 | 45.6 | 69.9 |

| Dolly 6B | 68.8 | 77.3 | 67.6 | 63.9 | 62.9 | 38.7 | 41.2 | 60.1 |

| Dolly 12B | 56.7 | 75.4 | 71 | 62.2 | 64.6 | 38.5 | 40.4 | 58.4 |

| Alpaca 7B | 73.9 | 77.2 | 73.9 | 66.1 | 59.8 | 43.3 | 43.4 | 62.5 |

| Alpaca Lora 7B | 74.3 | 79.3 | 74 | 68.8 | 56.6 | 43.9 | 42.6 | 62.8 |

| GPT-J 6.7B | 65.4 | 76.2 | 66.2 | 64.1 | 62.2 | 36.6 | 38.2 | 58.4 |

| LLama 7B | 73.1 | 77.4 | 73 | 66.9 | 52.5 | 41.4 | 42.4 | 61.0 |

| LLama 13B | 68.5 | 79.1 | 76.2 | 70.1 | 60 | 44.6 | 42.2 | 63.0 |

| Pythia 6.7B | 63.5 | 76.3 | 64 | 61.1 | 61.3 | 35.2 | 37.2 | 56.9 |

| Pythia 12B | 67.7 | 76.6 | 67.3 | 63.8 | 63.9 | 34.8 | 38 | 58.9 |

| Fastchat T5 | 81.5 | 64.6 | 46.3 | 61.8 | 49.3 | 33.3 | 39.4 | 53.7 |

| Fastchat Vicuña 7B | 76.6 | 77.2 | 70.7 | 67.3 | 53.5 | 41.2 | 40.8 | 61.0 |

| Fastchat Vicuña 13B | 81.5 | 76.8 | 73.3 | 66.7 | 57.4 | 42.7 | 43.6 | 63.1 |

| EstávelVicuña RLHF | 82.3 | 78.6 | 74.1 | 70.9 | 61 | 43.5 | 44.4 | 65.0 |

| StableLM Tuned | 62.5 | 71.2 | 53.6 | 54.8 | 52.4 | 31.1 | 33.4 | 51.3 |

| Base StableLM | 60.1 | 67.4 | 41.2 | 50.1 | 44.9 | 27 | 32 | 46.1 |

| Koala 13B | 76.5 | 77.9 | 72.6 | 68.8 | 54.3 | 41 | 42.8 | 62.0 |

| Assistente Aberto Pythia 12B | 67.9 | 78 | 68.1 | 65 | 64.2 | 40.4 | 43.2 | 61.0 |

| Mosaico MPT7B | 74.8 | 79.3 | 76.3 | 68.6 | 70 | 42.2 | 42.6 | 64.8 |

| Mosaico mpt-instruct | 74.3 | 80.4 | 77.2 | 67.8 | 72.2 | 44.6 | 43 | 65.6 |

| Mosaico mpt-chat | 77.1 | 78.2 | 74.5 | 67.5 | 69.4 | 43.3 | 44.2 | 64.9 |

| Assistente 7B | 78.4 | 77.2 | 69.9 | 66.5 | 56.8 | 40.5 | 42.6 | 61.7 |

| Wizard 7B sem censura | 77.7 | 74.2 | 68 | 65.2 | 53.5 | 38.7 | 41.6 | 59.8 |

| Mago 13B sem censura | 78.4 | 75.5 | 72.1 | 69.5 | 57.5 | 40.4 | 44 | 62.5 |

| GPT4-x-Vicuna-13b | 81.3 | 75 | 75.2 | 65 | 58.7 | 43.9 | 43.6 | 63.2 |

| Falcon 7b | 73.6 | 80.7 | 76.3 | 67.3 | 71 | 43.3 | 44.4 | 65.2 |

| Instrução do Falcon 7b | 70.9 | 78.6 | 69.8 | 66.7 | 67.9 | 42.7 | 41.2 | 62.5 |

| text-davinci-003 | 88.1 | 83.8 | 83.4 | 75.8 | 83.9 | 63.9 | 51 | 75.7 |

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...