Introdução geral

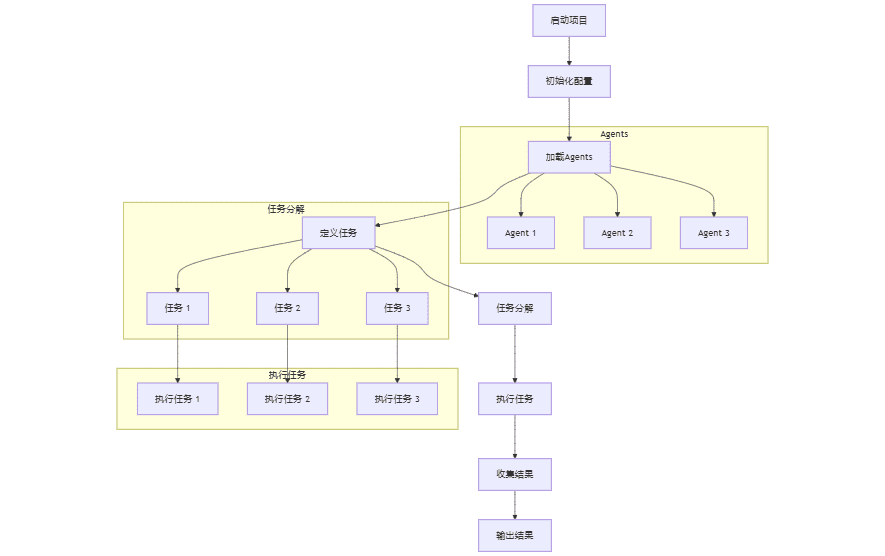

O miniLLMFlow é uma estrutura de desenvolvimento minimalista do Large Language Model (LLM) que contém apenas 100 linhas de código principal, demonstrando a filosofia de design "The Way is Simple". A estrutura foi projetada especificamente para permitir que os assistentes de IA (por exemplo, ChatGPT, Claude etc.) possam programar de forma autônoma, oferecendo suporte a recursos avançados, como inteligência múltipla, decomposição de tarefas e aprimoramento da recuperação de RAG. O projeto usa o protocolo de código aberto do MIT e é continuamente atualizado e mantido na plataforma GitHub. Seus melhores recursos sãoModelagem de fluxos de trabalho de LLM como estruturas de gráficos direcionados aninhadosA IA é uma tecnologia de processamento de tarefas simples por meio de nós, conectando agentes por meio de ações (marcando bordas), alcançando a decomposição de tarefas por meio de nós de orquestração de processos e oferecendo suporte ao aninhamento de processos e ao processamento em lote, tornando o desenvolvimento de aplicativos complexos de IA simples e intuitivo.

Lista de funções

- Suporte para sistemas de desenvolvimento colaborativo de inteligência múltipla

- Fornecer funções de decomposição de tarefas e programação de processos

- Implementação do desenvolvimento do aplicativo RAG (Retrieval Augmented Generation)

- Suporta a função de lote de nós para tarefas com uso intensivo de dados

- Fornecer gerenciamento de fluxo de trabalho com estrutura de gráfico direcionado aninhado

- Integração dos principais assistentes de LLM (por exemplo, ChatGPT, Claude)

- Suporte para ferramentas personalizadas e pacotes de API

- Suporte completo com documentação e tutoriais

Usando a Ajuda

1. configuração da instalação

Caminho 1: Instalação via pip

pip install minillmflow

Abordagem 2: uso direto do código-fonte

Integre-se rapidamente ao seu projeto copiando o arquivo de código-fonte (apenas 100 linhas) diretamente do projeto.

2. descrição da infraestrutura

O miniLLMFlow usa uma estrutura de gráfico dirigido aninhado e contém os seguintes conceitos principais:

- NósUnidade básica para processamento de tarefas LLM individuais

- Ações: bordas rotuladas de nós conectados para interações entre inteligências

- FluxosGráfico de direção formado por nós coreografados para decomposição de tarefas

- AninhamentoOs processos podem ser reutilizados como nós para dar suporte à criação de aplicativos complexos

- LoteSuporte para processamento paralelo de tarefas com uso intensivo de dados

3. guia para o processo de desenvolvimento

- fase de projeto

- Identificar processos de alto nível e estruturas de nós

- Projetando estruturas de memória compartilhada

- Definir campos de dados e métodos de atualização

- Fase de realização

- Comece com uma implementação simples

- Adição passo a passo de funcionalidades complexas

- Desenvolvido com o auxílio do Assistente do LLM

- Desenvolvido com o LLM Assistant

- Desenvolvimento de projetos com Claude::

- Criar um novo projeto e fazer upload de documentos

- Configuração das instruções de personalização do projeto

- Deixe o Claude ajudar com o design e a realização

- Desenvolvendo com o ChatGPT::

- Use um assistente de GPT especializado

- Opção de usar modelos mais novos para desenvolvimento de código

- Desenvolvimento de projetos com Claude::

4. exemplo de introdução

O projeto fornece um tutorial introdutório completo que mostra como implementar o sistema de resumo de artigos e proxy de controle de qualidade de Paul Graham, que pode ser experimentado rapidamente ao começar a usar o Google Colab.

5. melhores práticas

- Comece com uma funcionalidade simples e expanda-a gradualmente

- Fazer uso total do assistente do LLM para desenvolvimento

- Consulte o código de amostra na documentação

- Use as ferramentas internas de depuração e teste

- Acompanhe as atualizações do projeto e as discussões da comunidade