Introdução geral

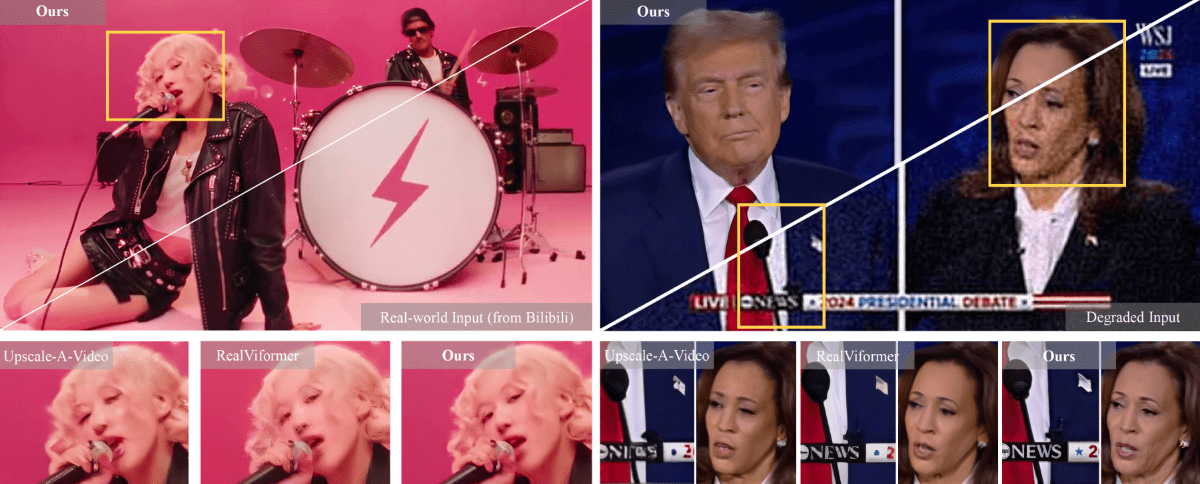

O STAR (Spatial-Temporal Augmentation with Text-to-Video Models) é uma estrutura inovadora de super-resolução de vídeo desenvolvida em conjunto pela Nanjing University, ByteDance e Southwest University. O projeto se dedica a solucionar os principais problemas no processamento de super-resolução de vídeo do mundo real e alcança um aprimoramento de alta qualidade dos quadros de vídeo combinando o conhecimento a priori dos modelos de difusão de texto para vídeo (T2V). A característica distintiva do modelo STAR está em sua capacidade de manter simultaneamente a fidelidade dos detalhes espaciais e a consistência temporal, o que geralmente é difícil de conciliar com as abordagens tradicionais baseadas em GAN. O projeto oferece duas versões de implementação: um modelo de processamento de redução de qualidade leve e pesada com base no I2VGen-XL e um modelo de processamento de redução de qualidade pesada com base no CogVideoX-5B, que é capaz de se adaptar às necessidades de aprimoramento de vídeo em diferentes cenários.

Lista de funções

- Oferece suporte à reconstrução de super-resolução para muitos tipos de processamento de degradação de vídeo (leve e pesado)

- Geração automatizada de palavras-chave, suporte para geração de descrição de vídeo usando ferramentas como Pllava

- Fornecimento de uma plataforma de demonstração on-line (HuggingFace Spaces)

- Suporta processamento de entrada de vídeo com resolução de 720x480

- Fornecer código de inferência completo e modelos pré-treinados

- Integração do LIEM (Local Information Enhancement Module) para melhorar a qualidade da reconstrução detalhada da tela

- Suporte ao processamento de vídeo em lote

- Oferece opções flexíveis de ponderação de modelos

Usando a Ajuda

1. configuração ambiental

Primeiro, você precisa configurar o ambiente de tempo de execução da seguinte forma:

- Clonar o repositório de código:

git clone https://github.com/NJU-PCALab/STAR.git

cd STAR

- Crie e ative o ambiente conda:

conda create -n star python=3.10

conda activate star

pip install -r requirements.txt

sudo apt-get update && apt-get install ffmpeg libsm6 libxext6 -y

2. seleção e download de modelos

A STAR oferece duas versões do modelo:

- Modelo baseado no I2VGen-XL:

- light_deg.pt: para processamento de vídeo de degradação de luz

- heavy_deg.pt: para processamento de vídeo com alta degradação

- Modelo baseado no CogVideoX-5B:

- Especificamente projetado para lidar com vídeos altamente degradados

- Suporta somente entrada com resolução de 720x480

Baixe os pesos de modelo apropriados do HuggingFace e coloque-os no arquivopretrained_weight/Catálogo.

3. fluxo de processamento de vídeo

- Preparar dados de teste:

- Coloque o vídeo a ser processado na seção

entrada/vídeo/diretório (no disco rígido do computador) - Preparação da palavra-chave (três opções):

- palavra não solicitada

- Gerado automaticamente usando o Pllava

- Escrever manualmente as descrições dos vídeos

- Coloque o vídeo a ser processado na seção

- Configurar parâmetros de processamento:

- modificações

video_super_resolution/scripts/inference_sr.shA configuração do caminho no- video_folder_path: caminho do vídeo de entrada

- txt_file_path: caminho do arquivo de prompt

- model_path: caminho do peso do modelo

- save_dir: caminho para salvar a saída

- modificações

- Iniciar o raciocínio:

bash video_super_resolution/scripts/inference_sr.sh

Observação: Se você encontrar um problema de estouro de memória (OOM), poderá adicionar um novo arquivo na pastainference_sr.shmidrange minor (em música)frame_lengthParâmetros.

4. configuração especial do modelo CogVideoX-5B

Se estiver usando o modelo CogVideoX-5B, são necessárias etapas adicionais:

- Crie um ambiente dedicado:

conda create -n star_cog python=3.10

conda activate star_cog

cd cogvideox-based/sat

pip install -r requirements.txt

- Faça o download de dependências adicionais:

- Necessidade de fazer download do VAE e do codificador T5

- atualização

cogvideox-based/sat/configs/cogvideox_5b/cogvideox_5b_infer_sr.yamlA configuração do caminho no - Substituindo o arquivo transformer.py