Introdução geral

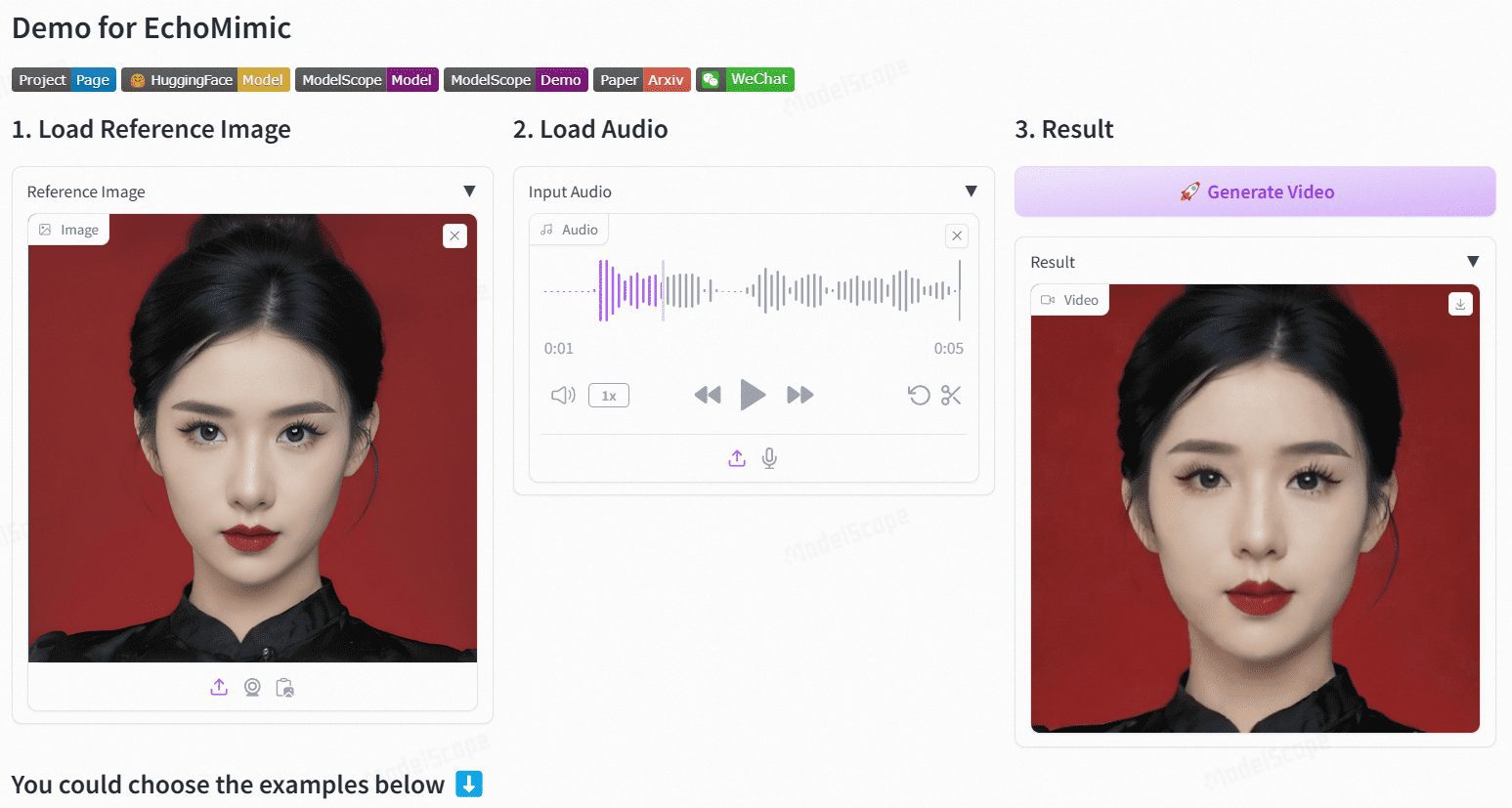

O EchoMimic é um projeto de código aberto que tem como objetivo gerar animações realistas de retratos, impulsionadas pelo áudio. Desenvolvido pela divisão Terminal Technologies do Ant Group, o projeto utiliza condições de pontos de marcação editáveis para gerar vídeos de retratos dinâmicos combinando áudio e pontos de marcação facial. O EchoMimic foi amplamente comparado em vários conjuntos de dados públicos e proprietários, demonstrando seu desempenho superior em avaliações quantitativas e qualitativas.

A versão EchoMimicV2 otimiza a velocidade de inferência e adiciona ações por gestos, recomendado.

Endereço de demonstração: https://www.modelscope.cn/studios/BadToBest/BadToBest V2: https://huggingface.co/spaces/fffiloni/echomimic-v2

Lista de funções

- Animação do driver de áudioGeração de animações realistas de retratos com entrada de áudio.

- Animação orientada por pontos de marcaçãoGeração de animações estáveis de retratos usando pontos de marcadores faciais.

- Driver de áudio + marcadorCombinação de áudio e marcadores faciais selecionados para gerar animações de retratos mais naturais.

- Suporte a vários idiomasSuporte a entrada de áudio em chinês, inglês e outros idiomas.

- Raciocínio eficienteModelos e pipelines otimizados melhoram significativamente a velocidade de inferência.

Usando a Ajuda

Processo de instalação

- Código de download::

git clone https://github.com/BadToBest/EchoMimic cd EchoMimic - Configuração do ambiente Python::

- Recomenda-se usar o conda para criar um ambiente virtual:

conda create -n echomimic python=3.8 conda activate echomimic - Instale os pacotes de dependência:

pip install -r requirements.txt

- Recomenda-se usar o conda para criar um ambiente virtual:

- Faça download e descompacte o ffmpeg-static::

- Baixe o ffmpeg-static, descompacte-o e defina a variável de ambiente:

export FFMPEG_PATH=/path/to/ffmpeg-4.4-amd64-static

- Baixe o ffmpeg-static, descompacte-o e defina a variável de ambiente:

- Faça o download dos pesos pré-treinamento::

- Faça o download dos pesos de modelo pré-treinados apropriados de acordo com a descrição do projeto.

Processo de uso

- Execução da interface da Web::

- Inicie a interface da Web:

python webgui.py - Visite o servidor local para visualizar a interface e fazer upload de arquivos de áudio para geração de animação.

- Inicie a interface da Web:

- raciocínio de linha de comando::

- Use os seguintes comandos para a geração de animação de retrato acionada por áudio:

python infer_audio2vid.py --audio_path /path/to/audio --output_path /path/to/output - Raciocínio em conjunto com sinais:

python infer_audio2vid_pose.py --audio_path /path/to/audio --landmark_path /path/to/landmark --output_path /path/to/output

- Use os seguintes comandos para a geração de animação de retrato acionada por áudio:

- Otimização de modelos::

- O uso do modelo e do pipeline otimizados pode melhorar significativamente a velocidade de inferência, por exemplo, de 7 min/240 fps para 50 seg/240 fps em GPUs V100.

advertência

- Certifique-se de que a versão do Python e a versão do CUDA usadas sejam compatíveis com os requisitos do projeto.

- Se você encontrar problemas durante o uso, poderá consultar o arquivo README do projeto ou enviar um problema no GitHub para obter ajuda.