Implantação de uma ferramenta de bate-papo personalizada de modelo "pequeno" para computadores de baixo custo

Por que implantar uma ferramenta de bate-papo de modelo "mini" privado?

Muitas pessoas já usaram o ChatGPT, o Wisdom Spectrum, o Beanbag, o Claude e outros excelentes modelos de idiomas grandes e, se precisarem usar modelos mais aprofundados, também comprarão serviços pagos de terceiros, afinal, eles têm um desempenho excelente. Por exemplo, meu principal cenário de trabalho é escrever artigos, então escolherei o Claude.

Embora eu adore usar o Claude, será que eu realmente o uso diariamente com alta frequência? A resposta é, obviamente, não!

Limites como limites de uso, fatores de preço, problemas de rede, etc., reduzem naturalmente a frequência de uso em situações desnecessárias. --Se uma ferramenta não pode ser "pega e usada" em qualquer ambiente, então há algo errado com ela.

Nesse caso, usar um modelo "pequeno" pode ser uma escolha melhor.

"Características do modelo "Small

GEMMA2, LLAMA3.1:8b, QWEN2:7b são pequenos o suficiente para o uso diário, entrada e saída contextual de 32k de comprimento, a maioria dos comandos é seguida, a capacidade de se expressar em chinês, responder a perguntas e, de modo geral, é boa, e não há nenhum produto do tipo "Wenxin Yiyin" que só possa inserir 2.000 palavras ou algo semelhante! As limitações... É suficiente para o uso diário, e consideraremos a possibilidade de nos especializarmos em tarefas especiais. As vantagens das miniaturas são as seguintes:

- Suporte para tamanhos de contexto não menores (ou até maiores) do que o modelo maior

- Tarefas diárias de redação com resultados que não sejam de baixa qualidade

- uso ilimitado

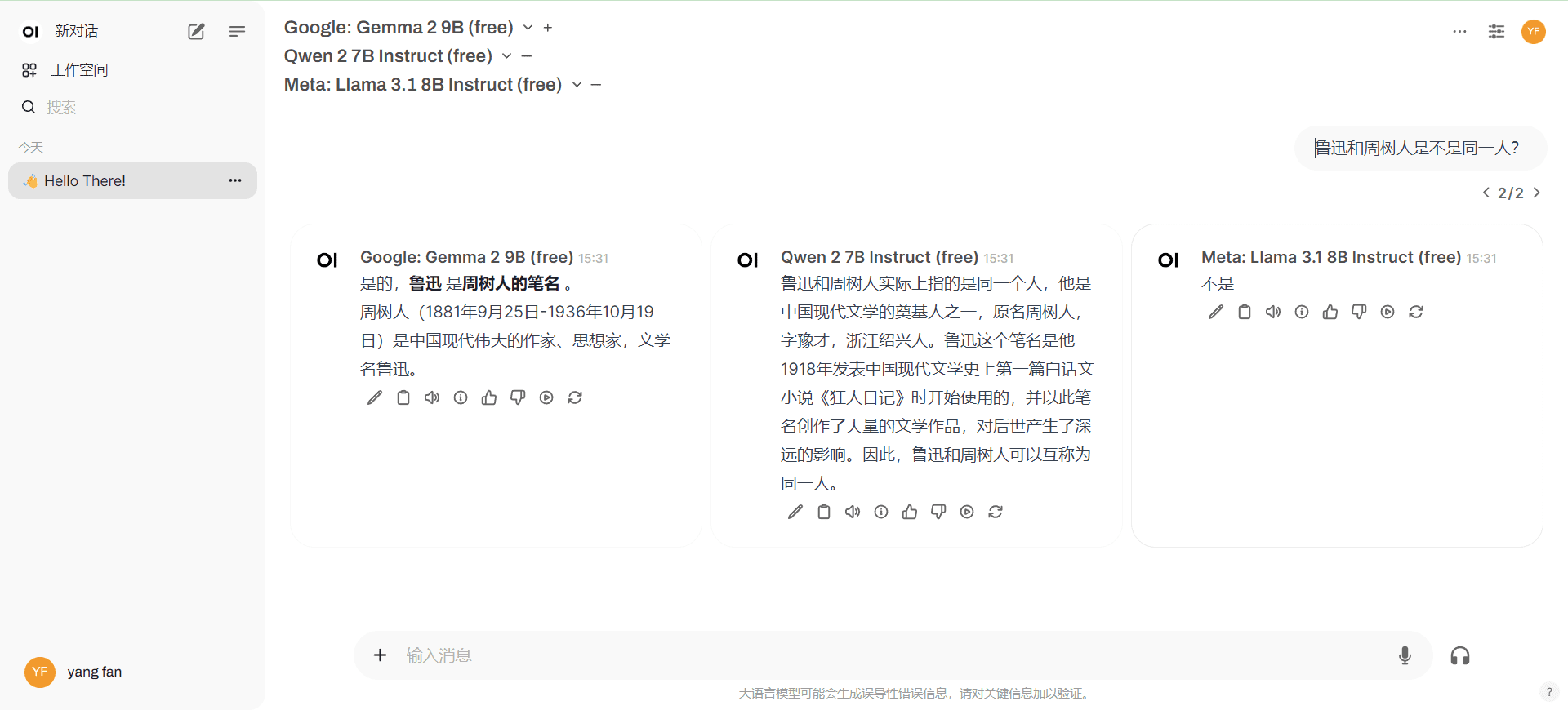

- Várias miniaturas podem gerar respostas ao mesmo tempo para facilitar a comparação.

- Execução mais rápida

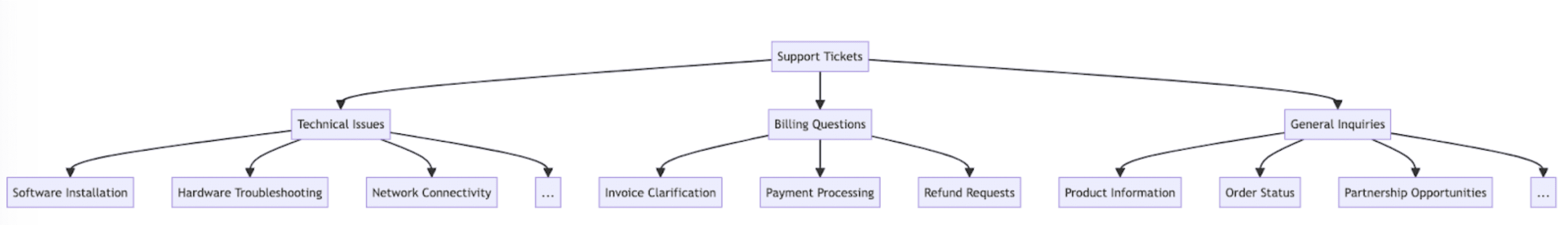

O que é implantação privada?

Uma interface WEB de bate-papo privado para fácil personalização e acesso gratuito a modelos "pequenos".

A solução mais clássica é implantar o Ollama+Open WebUI localmente, sendo que o primeiro é responsável por executar as miniaturas no computador local e o segundo hospeda a interface de bate-papo. Considere extranets para usar o Ollama+Open WebUI a qualquer hora e em qualquer lugar.cloudflaretalvezcpolarMapeie o endereço para uma rede externa (pesquise você mesmo o tutorial).

vantagem

- Os dados de bate-papo são locais e privados

- Flexibilidade para personalizar modelos locais

desvantagens

- Difícil de executar de forma persistente (você sempre tem que desligar o computador, certo?) Difícil de publicar em uma extranet

- Altos requisitos de hardware de computador

questão a ser abordada

São as deficiências que estamos tentando resolver:

1. a interface de bate-papo com IA implantada precisa ser publicada em uma extranet com URLs de acesso estáveis para ser usada em qualquer lugar e a qualquer momento

2) O limite de hardware do computador é principalmente o uso do Ollama para executar o modelo localmente, alterado para fabricantes conhecidos de serviços de API, e a proteção da privacidade é relativamente boa e gratuita. (O computador geral local pode executar modelos pequenos, a rede tem uma API gratuita)

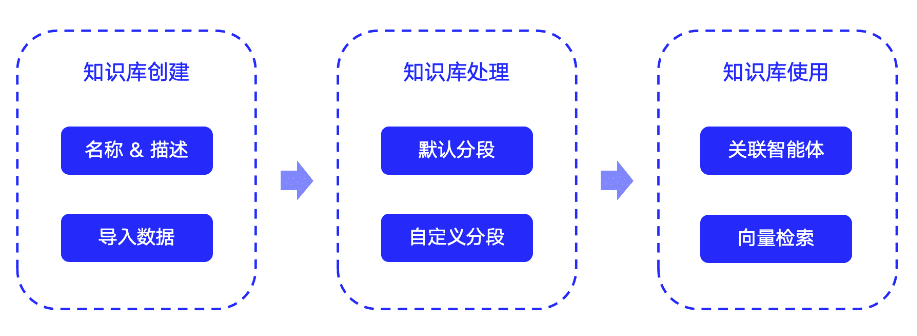

Programa ideal

1. implementação de doceker local/nuvem gratuita WebUI aberta + acesso a APIs de modelo "pequeno"

Somente para uso local, o hardware do computador só precisa ser capaz de executar o doceker

2. implantação própria/uso do NextChat tripartido + acesso a APIs de modelo "pequeno"

A auto-implantação do NextChat requer seu próprio nome de domínio, e há o risco de comprometer suas chaves ao usar um NextChat de três partes.

Esse plano de implantação é apenas para pessoas experientes operarem; não se recomenda o uso de produtos maduros por pessoas inexperientes, ou o atraso em problemas anormais não vale a pena.

Opção de implantação ideal 1

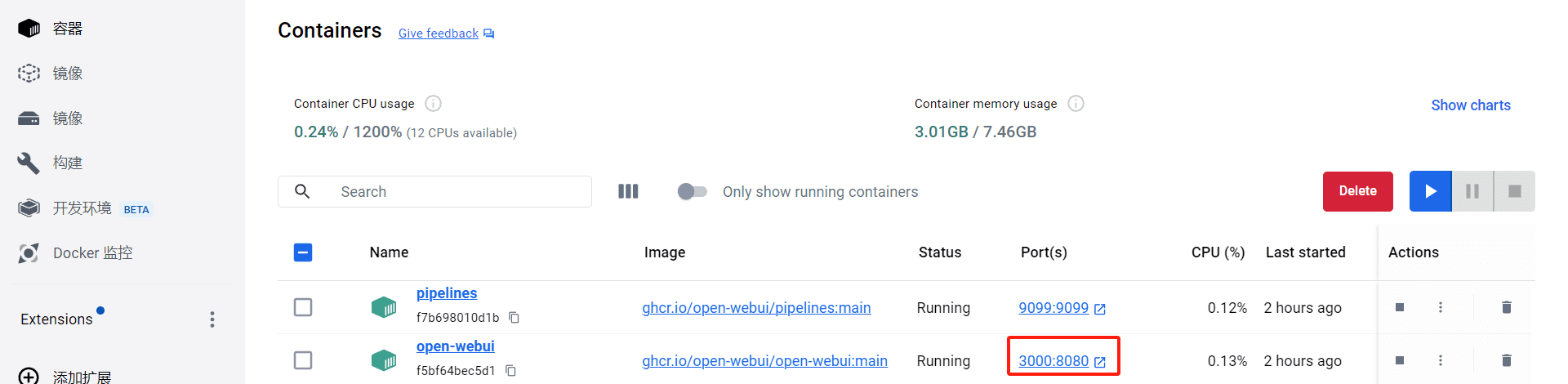

1. implantação do doceker

Local: implementação local de tutoriais do doceker, pesquise você mesmo

Nuvem: recursos gratuitos do doceker na nuvem, pesquise por conta própria, aqui eu uso Koyeb. (A Intranet não pode ser acessada diretamente, requer ciência e tecnologia)

2. implementação do Open WebUI no doceker

Local: detalhesLeia o documentoOs seguintes comandos de instalação são recomendados (mantenha-os atualizados)

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

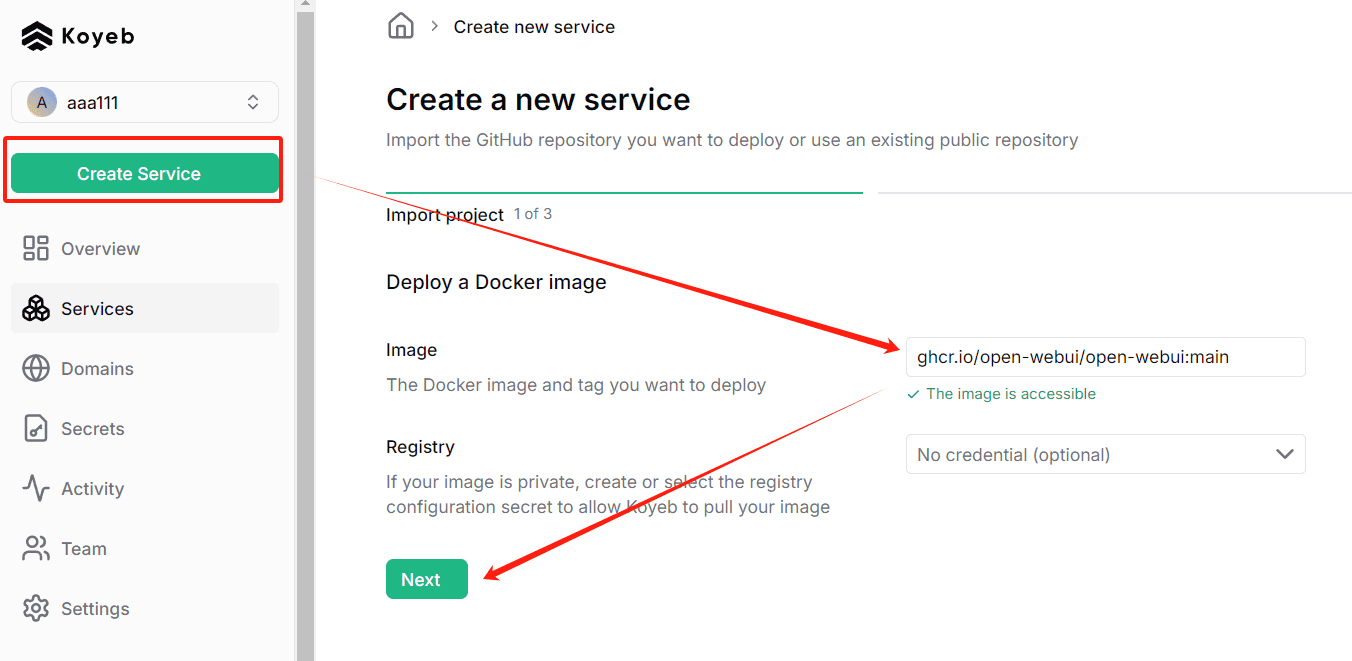

Nuvem: RegistroKoyebDepois disso, clique em Create Service e digite o seguinte comando

ghcr.io/open-webui/open-webui:main

3. iniciar Abrir WebUI

Inicialização local, endereço de acesso padrão: http://localhost:3000/

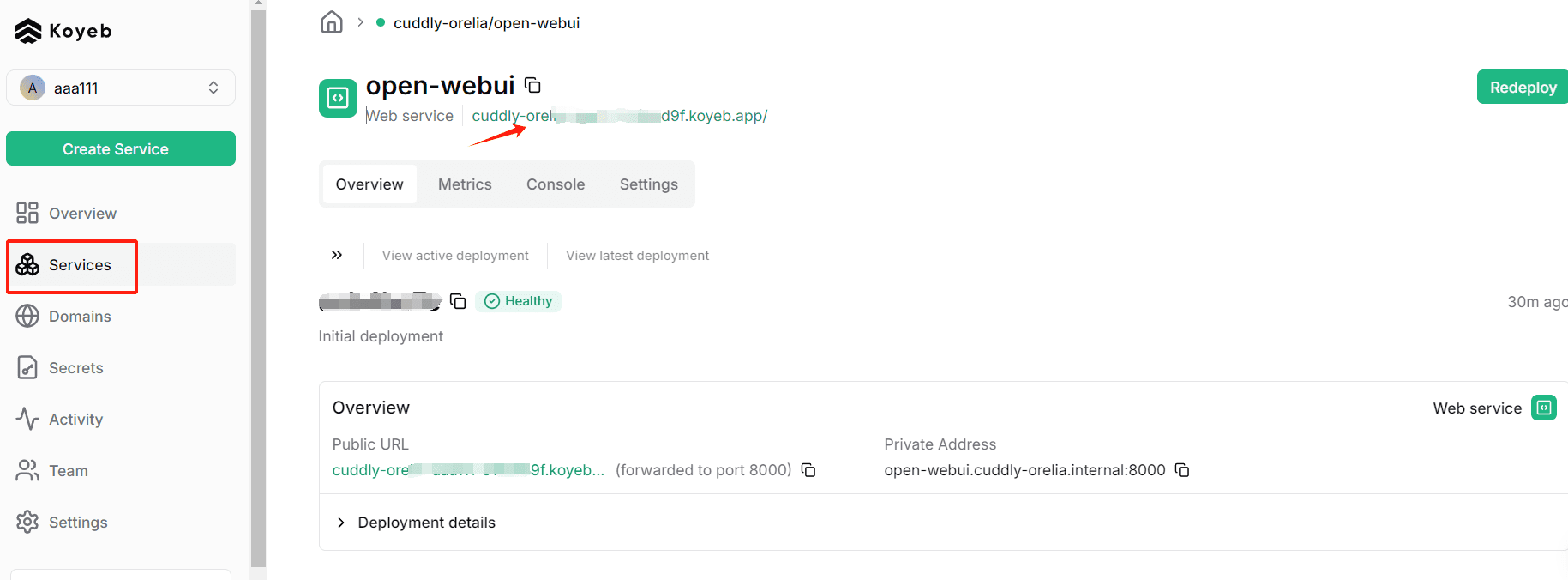

O lançamento na nuvem, após a conclusão da implementação do Koyeb, pode ser clicado aqui (a desvantagem é que esse nome de domínio não pode ser acessado diretamente pela intranet, e a vinculação do nome de domínio exige a abertura de uma conta paga)

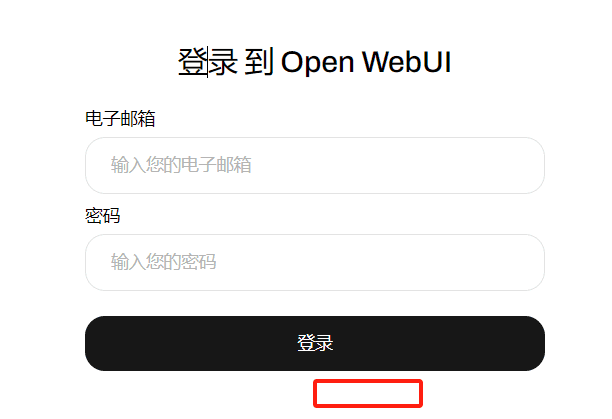

Após a inicialização, registre uma conta. Por padrão, a primeira conta registrada é a conta de administrador. Se já estiver registrado, somente a tela de login, na primeira visita, poderá ver o portal "registration" (registro)

4. solicite uma API de modelo "pequeno" gratuita

O OpenRouter é recomendado e vem escrevendo romances há um ano usando seus modelos gratuitos. Aqui está uma explicação de como obter as APIs de modelo do OpenRouter

PS: Fornecedores domésticos gratuitos de APIs de modelo pequeno: Silicon Flow

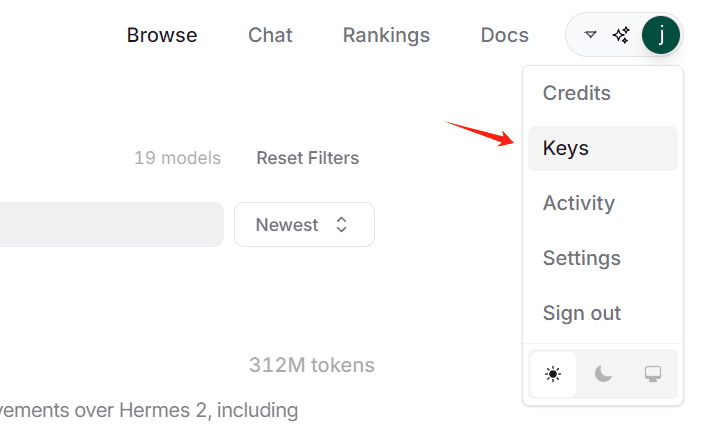

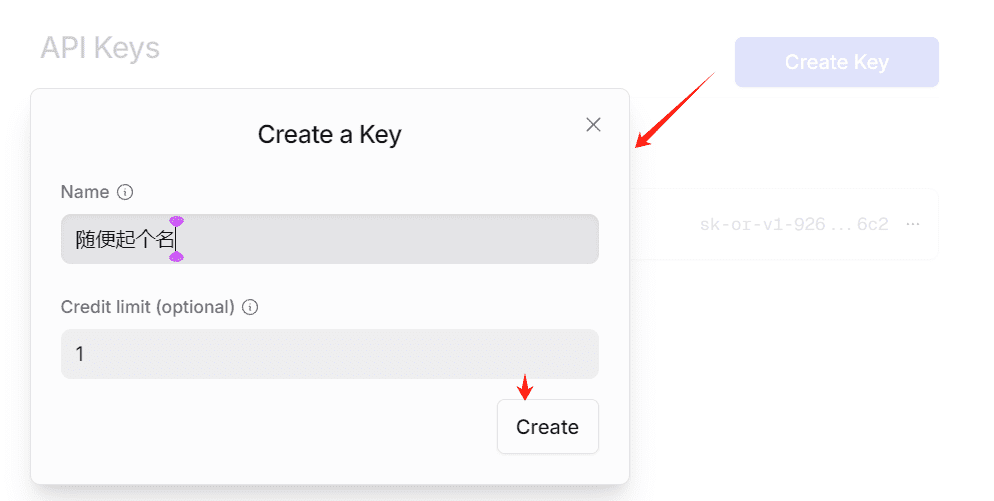

4.1 Criação de uma CHAVE

Você obterá uma sequência de caracteres que começa com sk-, essa é a CHAVE, copie-a e salve-a localmente; não será possível copiá-la novamente depois que a página for fechada.

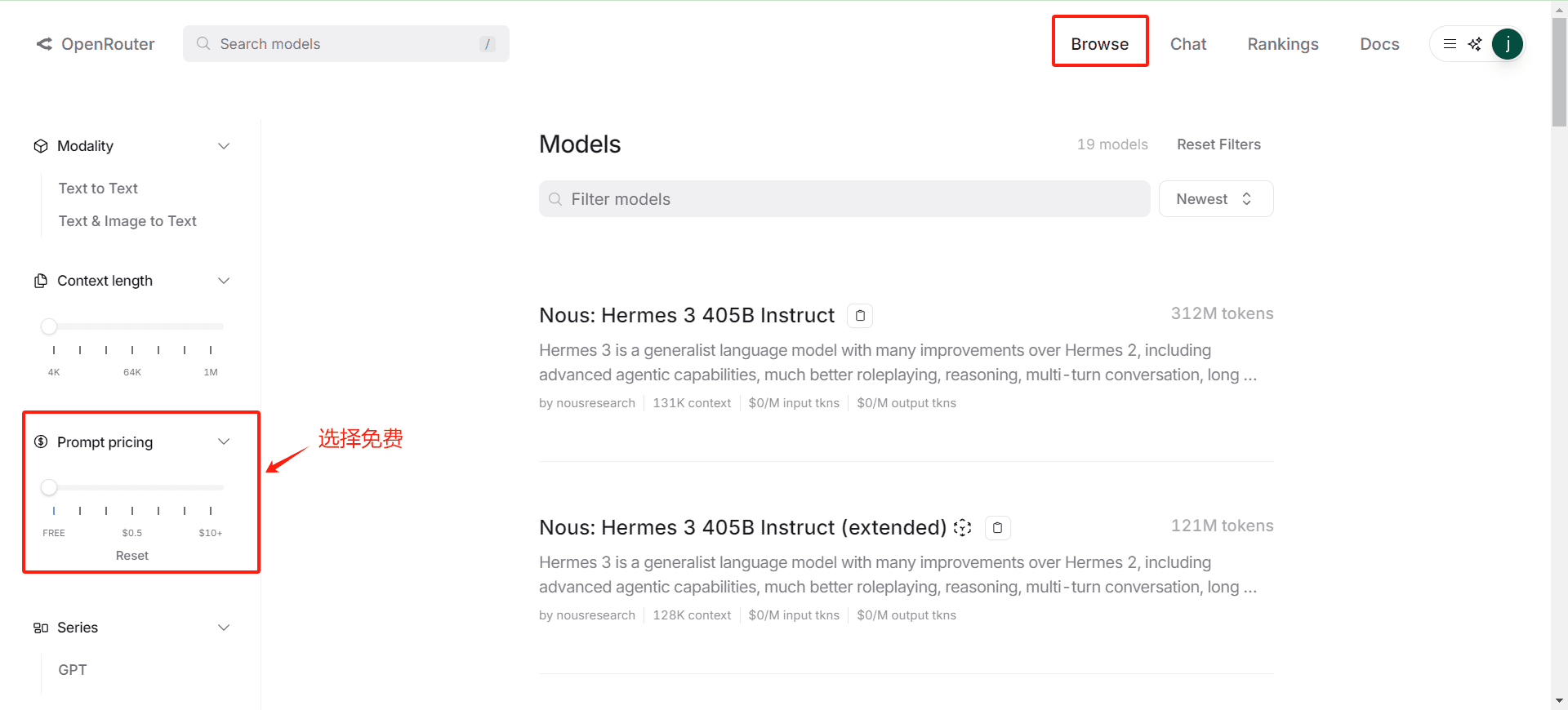

4.2 Confirmação da lista de modelos livres

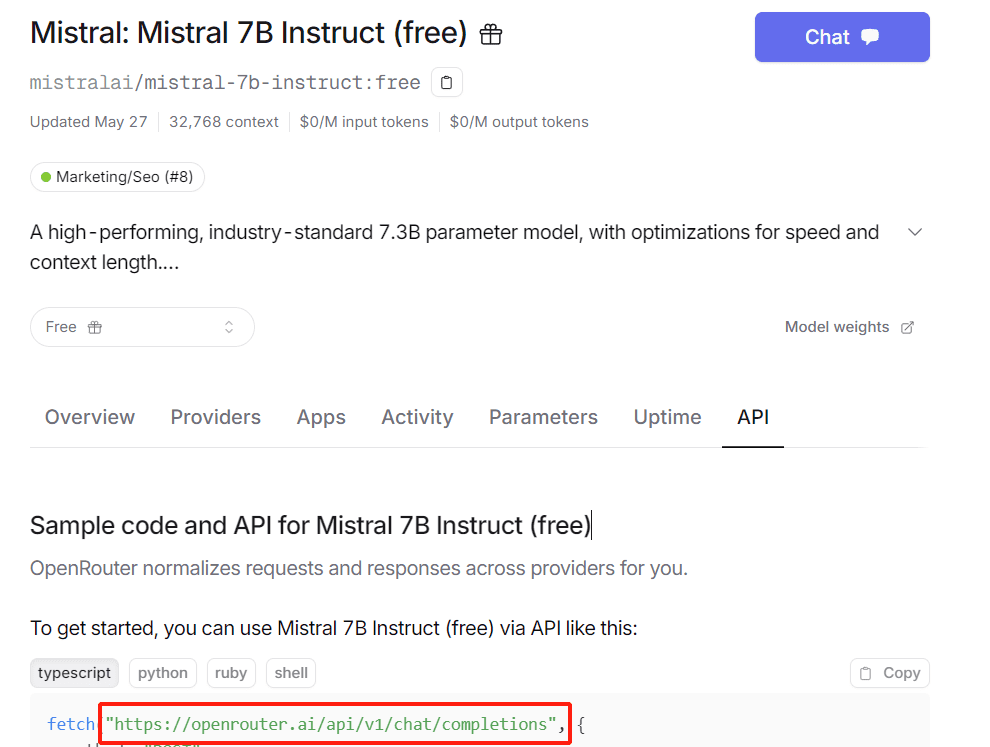

4.3 Obtenção do URL de solicitação da API(matemática) gênero

Acesse a página de qualquer modelo para vê-la, geralmente: https://openrouter.ai/api/v1/chat/completions

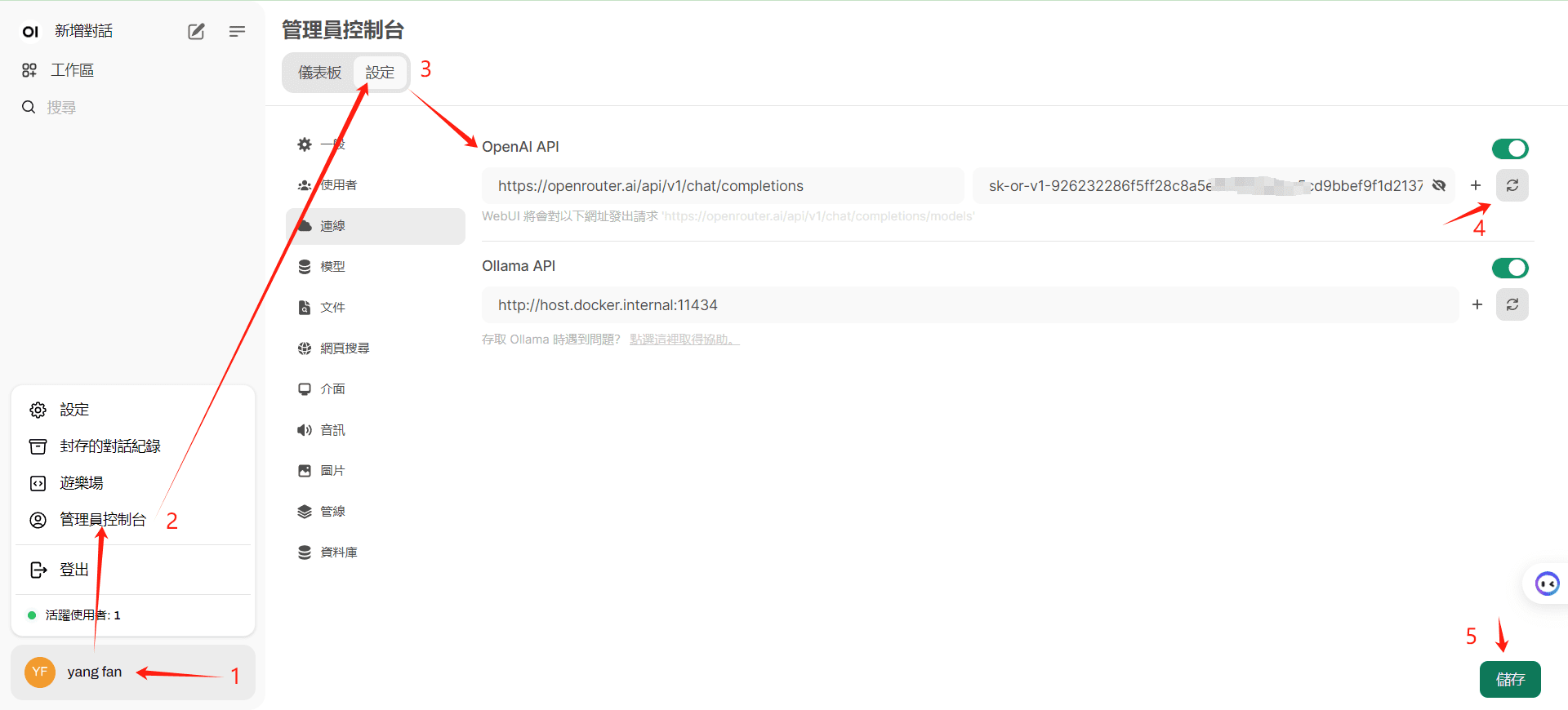

5. entrar no modelo de configuração da Open WebUI

Observe que clicar em "4" confirma que a interface foi acessada com êxito antes de clicar em Salvar.

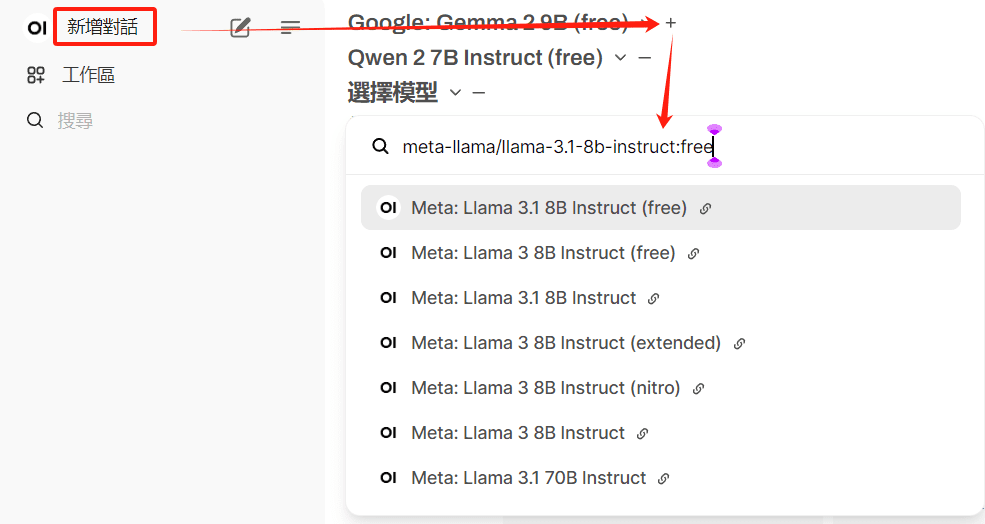

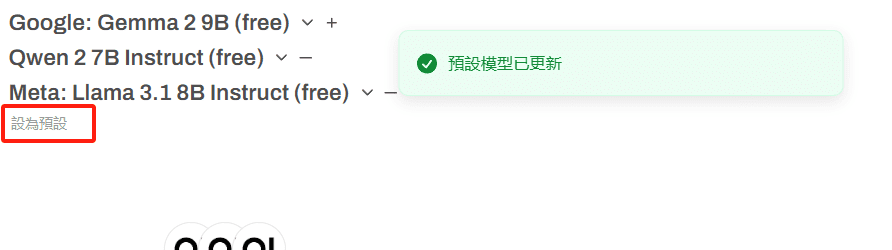

6. configurar o modelo padrão

Vários modelos gratuitos podem ser selecionados

O uso de modelos pagos resultará na desativação da conta

Clique em Presets para salvar modelos usados com frequência

7. tentativa de um primeiro diálogo

Opção 2 de implantação ideal

1. implantação do NextChat na nuvem

Implementação gratuita na nuvem com um clique, confira a ajuda por si mesmo: https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web

2) A primeira implantação do Deploy (vercel) é usada aqui.

Basta seguir o processo, e aqui estão três coisas que você deve ter em mente:

- Leia atentamente a documentação de ajuda e siga o tutorial para configurar seu projeto para ser atualizado automaticamente.

- Configure a variável KEY e a senha de acesso durante o processo de instalação do vercel; é recomendável configurá-las com antecedência.

- A vinculação de seu próprio nome de domínio permite o acesso direto a redes domésticas.

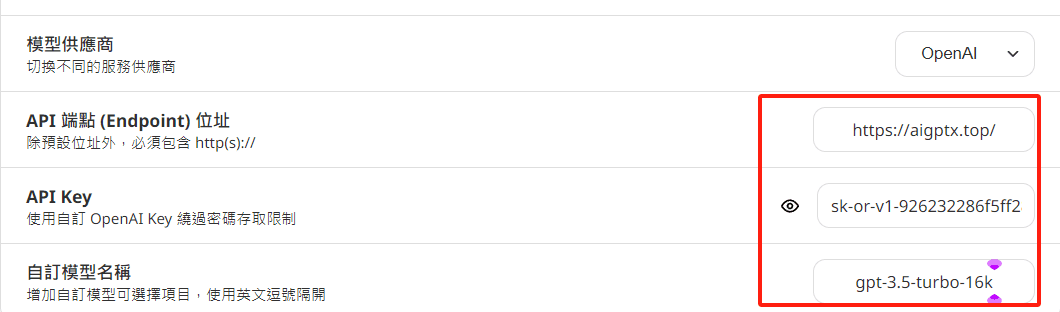

3. variáveis de configuração

Não é como a Opção 1, que pode ler a lista de modelos automaticamente; você precisa definir sua própria lista de modelos gratuitos, observe a alteração do endereço da interface

BASE_URL ou ponto de extremidade da OpenAI: defina isso como https://openrouter.ai/api

OPENAI_API_KEY ou Chave da API OpenAI: digite sua OpenRouter Chave de API aqui.

CUSTOM_MODELS ou Modelos personalizados: especifique o nome do modelo como ele está listado no OpenRouter.

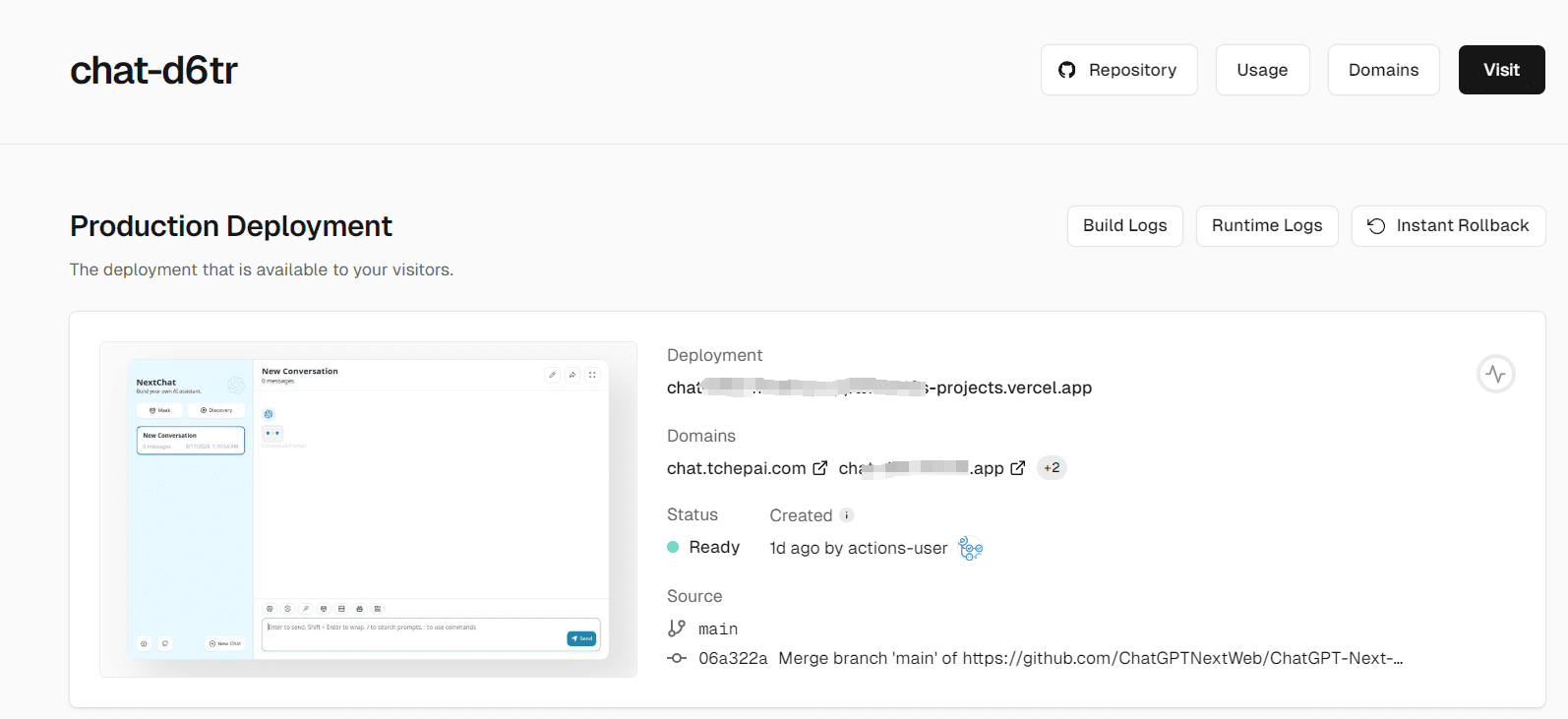

4. tela de conclusão da implantação

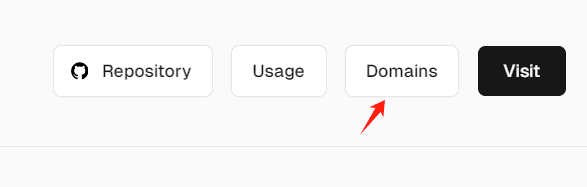

5.Nome de domínio vinculativo

Resolução de problemas de acesso no país

4. você pode configurar a API KEY de um modelo separadamente nas configurações

Você pode configurar umOhMyGPTUma pequena quantidade de créditos GPT4 gratuitos por dia, outro endereço para acesso estável à API KEY (para evitar ocultação abusiva):

Outro projeto de API KEY gratuito: https://github.com/chatanywhere/GPT_API_free

Endereço do NextChat implantado (tenha cuidado para não inserir informações confidenciais, insira sua própria API KEY): https://chat.tchepai.com/

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...