DeepClaude: uma interface de bate-papo que funde o raciocínio de cadeia R1 do DeepSeek com a criatividade do Claude

Introdução geral

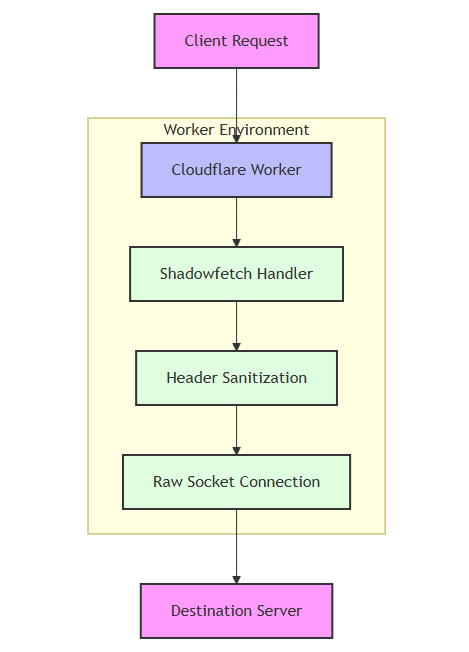

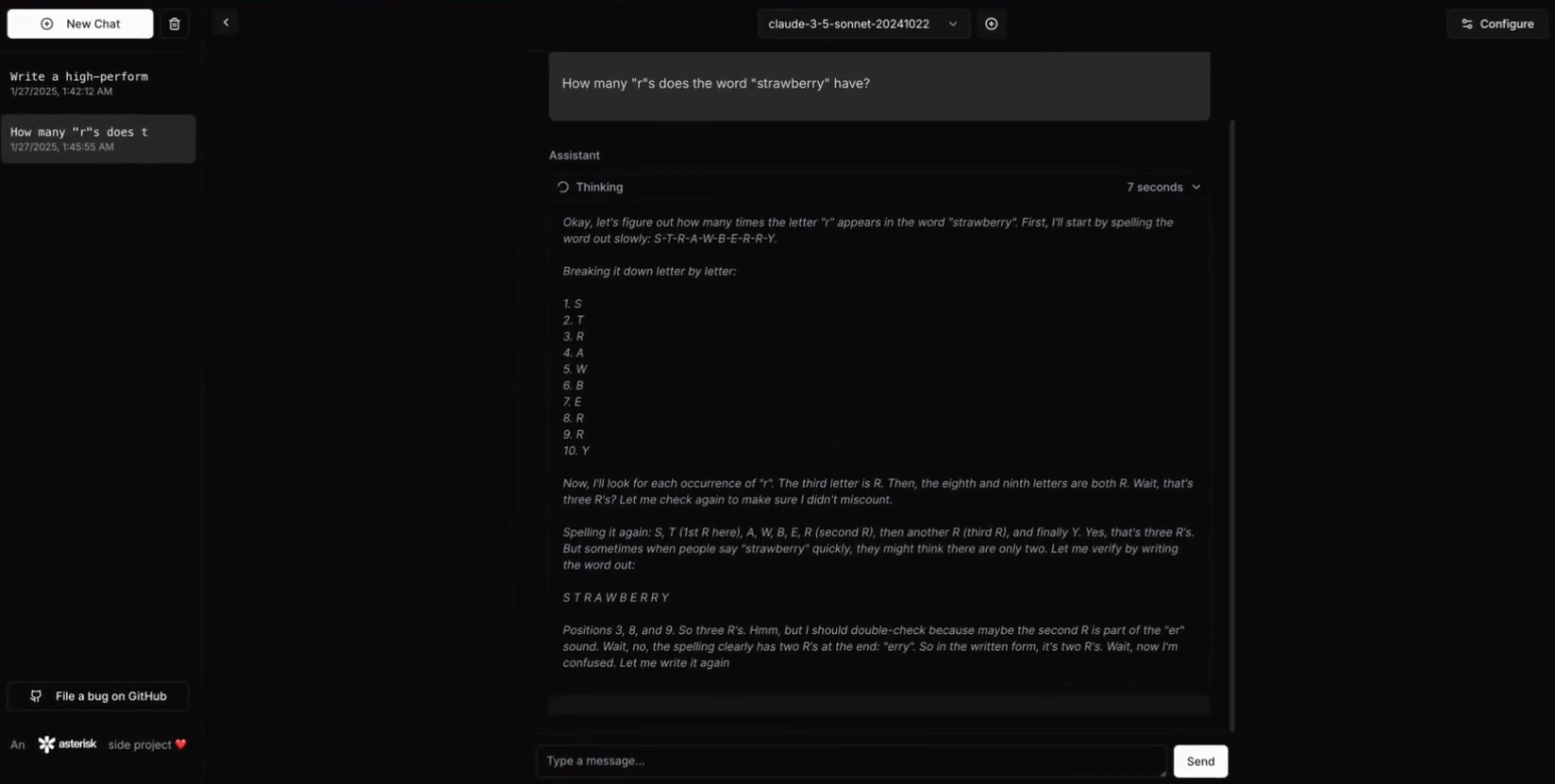

O DeepClaude é uma API de inferência de modelo de linguagem grande (LLM) de alto desempenho e uma interface de bate-papo que integra os recursos de raciocínio encadeado (CoT) do DeepSeek R1 com o AntrópicaClaude criatividade de modelos e recursos de geração de código. Esse projeto supera significativamente o desempenho do OpenAI o1, DeepSeek R1 e Claude Sonnet 3.5, oferece uma interface unificada que aproveita os pontos fortes de ambos os modelos, mantendo o controle total sobre as chaves e os dados da API. Os recursos do DeepClaude incluem resposta com latência zero, segurança de ponta a ponta, alta configurabilidade e uma base de código-fonte aberto. Os usuários podem gerenciar suas chaves de API com suas próprias chaves, garantindo a privacidade e a segurança dos dados. O melhor de tudo é que o DeepClaude é totalmente gratuito e de código aberto.

O DeepClaude usa o R1 para inferência e, em seguida, permite que o Claude produza os resultados

O DeepClaude também oferece uma API de inferência LLM de alto desempenho

Lista de funções

- Resposta de latência zeroResposta instantânea por meio de uma API Rust de alto desempenho.

- privado e seguroGerenciamento de chaves de API local para garantir a privacidade dos dados.

- Altamente configurávelOs usuários podem personalizar aspectos da API e da interface para atender às suas necessidades.

- código abertoBase de código livre e de código aberto, os usuários são livres para contribuir, modificar e implementar.

- Recursos duplos de IACombinando a criatividade e o poder de geração de código do Claude Sonnet 3.5 com o poder de raciocínio do DeepSeek R1.

- API BYOK hospedadaGerenciado usando a própria chave de API do usuário para garantir o controle total.

Usando a Ajuda

Processo de instalação

- pré-condições::

- Rust 1.75 ou superior

- Chave da API do DeepSeek

- Chave da API Anthropic

- armazém de clones::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- Criar o projeto::

cargo build --release

- arquivo de configuraçãoCriar no diretório raiz do projeto

config.tomlDocumentação:

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- Serviços operacionais::

cargo run --release

Diretrizes para uso

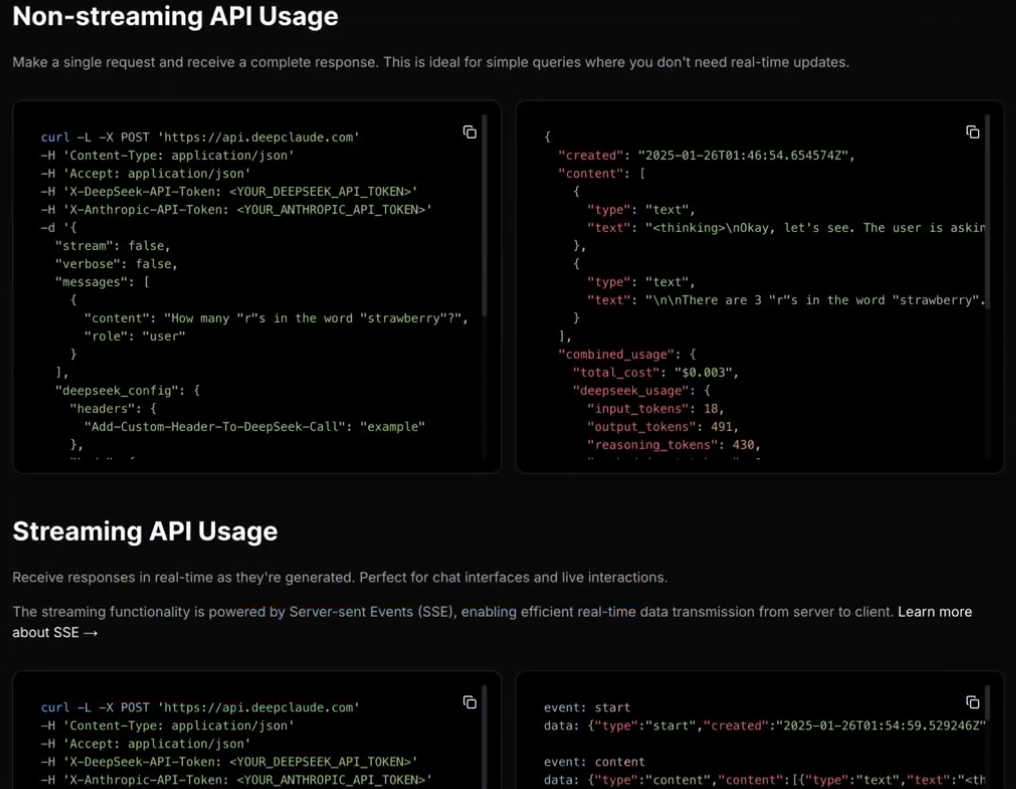

- Uso da API::

- exemplo básico::

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- Exemplo de resposta de fluxo contínuo::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - auto-hospedado::

- Opções de configuraçãoOs usuários podem modificar o

config.tomlopções de configuração na documentação para personalizar aspectos da API e da interface.

- Opções de configuraçãoOs usuários podem modificar o

- segurança::

- Gerenciamento de chaves de API localPrivacidade: garanta a privacidade das chaves e dos dados da API.

- criptografia de ponta a pontaProteção de dados: Protege a segurança da transmissão de dados.

- dedicar::

- Diretrizes de contribuiçãoOs usuários podem contribuir com código e melhorar o projeto enviando Pull Requests ou relatando problemas.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...