Introdução geral

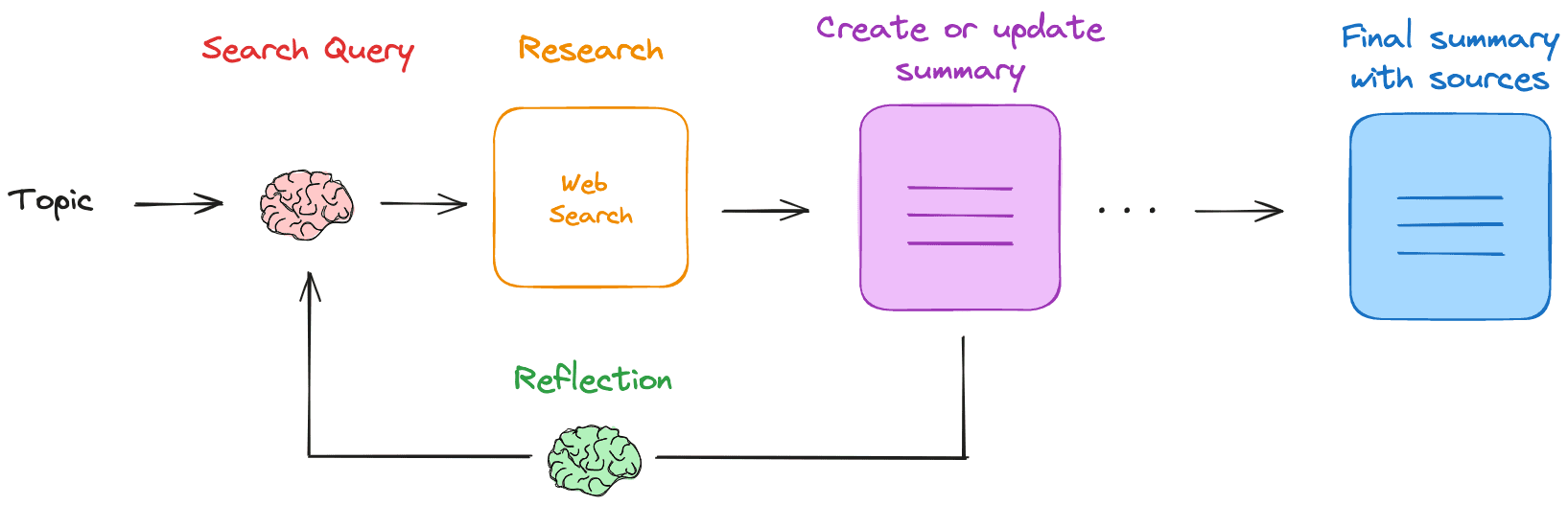

O Research Rabbit é um assistente nativo de pesquisa e resumo na Web baseado em LLM (Large Language Model). Depois que o usuário fornece um tópico de pesquisa, o Research Rabbit gera uma consulta de pesquisa, obtém resultados relevantes na Web e resume esses resultados. Ele repete esse processo, preenchendo as lacunas de conhecimento e, por fim, gera um resumo Markdown que inclui todas as fontes. A ferramenta é executada totalmente localmente, garantindo a privacidade e a segurança dos dados.

Lista de funções

- Gerar consultas de pesquisaGeração de consultas de pesquisa com base em tópicos fornecidos pelo usuário.

- Pesquisa na WebUse um mecanismo de pesquisa configurado (por exemplo, Tavily) para encontrar recursos relevantes.

- Resumo dos resultadosResumir os resultados da pesquisa na Web usando o LLM local.

- resumo reflexivoIdentificar lacunas de conhecimento e gerar novas consultas de pesquisa.

- uma atualização iterativaPesquisa: Realize repetidamente pesquisas e resumos para refinar gradualmente a pesquisa.

- operação localTodas as operações são realizadas localmente para garantir a privacidade dos dados.

- Resumo de markdownGerar um resumo final em Markdown com todas as fontes.

Usando a Ajuda

Processo de instalação

- Puxar o LLM localObter os LLMs locais necessários do Ollama, por exemplo

ollama pull llama3.2. - Obter a chave da API da TavilyRegistre o Tavily e obtenha a chave da API, defina as variáveis de ambiente

exportar TAVILY_API_KEY=. - armazém de clones: Executar

git clone https://github.com/langchain-ai/research-rabbit.gitArmazém de Clonagem. - Instalação de dependênciasVá para o diretório do projeto e execute

uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langógrafo devInstale a dependência. - Assistente de inicializaçãoIniciar o servidor LangGraph e acessar o arquivo

http://127.0.0.1:2024Veja a documentação da API e a interface do usuário da Web.

Processo de uso

- Configuração do LLMNome do LLM local: define o nome do LLM local a ser usado na interface do usuário da Web do LangGraph Studio (padrão)

llama3.2). - Definir a profundidade da pesquisaConfigure a profundidade das iterações do estudo (padrão 3).

- Insira um tópico de pesquisaInicie o Assistente de pesquisa inserindo o tópico da pesquisa na guia Configuração.

- Exibir processoO assistente gera uma consulta de pesquisa, realiza uma pesquisa na Web, resume os resultados usando o LLM e repete o processo.

- Obtendo o resumoO assistente gera um resumo Markdown com todas as fontes, que o usuário pode visualizar e editar.

Funções principais

- Gerar consultas de pesquisaApós inserir um tópico de pesquisa, o assistente gerará automaticamente uma consulta de pesquisa.

- Pesquisa na WebO assistente usa o mecanismo de pesquisa configurado para encontrar recursos relevantes.

- Resumo dos resultadosO assistente usa o LLM local para resumir os resultados da pesquisa e gerar um relatório preliminar.

- resumo reflexivoO assistente identifica lacunas de conhecimento no resumo e gera novas consultas de pesquisa para continuar a pesquisa.

- uma atualização iterativaO assistente realizará buscas e resumos de forma iterativa para refinar gradualmente a pesquisa.

- Geração de resumos MarkdownO assistente gera um resumo final em Markdown com todas as fontes, que o usuário pode visualizar e editar.