A Mistral AI lança os modelos Codestral 25.01: modelos específicos de programação maiores, mais rápidos e mais fortes

Código na velocidade da tecla Tab. Hoje, no Continuar.dev e, em breve, estará disponível em outros assistentes de código de IA líderes de mercado.

De todas as inovações em IA no ano passado, a geração de código foi, sem dúvida, a mais importante. Da mesma forma que as linhas de montagem simplificaram a fabricação e as calculadoras transformaram a matemática, os modelos de codificação representam uma mudança significativa no desenvolvimento de software.

IA Mistral A Codestral está na vanguarda dessa mudança com o lançamento do Codestral, um modelo de codificação de última geração (SOTA) lançado no início deste ano. Leve, rápido e proficiente em mais de 80 linguagens de programação, o Codestral é otimizado para casos de uso de baixa latência e alta frequência e suporta tarefas como Fill-in-the-Middle (FIM), correção de código e geração de testes. codestral O Codestral tem sido usado por milhares de desenvolvedores como um poderoso assistente de codificação, muitas vezes aumentando a produtividade várias vezes. Hoje, o Codestral está passando por uma grande atualização.

Codestral 25.01 Com uma arquitetura mais eficiente e um Tokeniser aprimorado do que a versão original, o código é gerado e concluído aproximadamente duas vezes mais rápido. O modelo é agora o líder absoluto na escrita de código em sua classe de peso e é SOTA em todos os casos de uso do FIM.

avaliação comparativa

Avaliamos o novo Codestral usando o modelo de codificação líder com parâmetros inferiores a 100B, que é amplamente considerado o melhor para a tarefa FIM.

delineado

| Python | SQL | Médias multilíngues | |||

|---|---|---|---|---|---|

| modelagem | Comprimento do contexto | HumanEval | MBPP | CruxEval | LiveCodeBench |

| Codestral-2501 | 256k | 86.6% | 80.2% | 55.5% | 37.9% |

| Codestral-2405 22B | 32k | 81.1% | 78.2% | 51.3% | 31.5% |

| Instrução Codellama 70B | 4k | 67.1% | 70.8% | 47.3% | 20.0% |

| DeepSeek Instruções do Codificador 33B | 16k | 77.4% | 80.2% | 49.5% | 27.0% |

| DeepSeek Coder V2 lite | 128k | 83.5% | 83.2% | 49.7% | 28.1% |

Por idioma

| modelagem | HumanEval Python | HumanEval C++ | HumanEval Java | Javascript HumanEval | Batida do HumanEval | Tipos de script HumanEval | HumanEval C# | HumanEval (média) |

|---|---|---|---|---|---|---|---|---|

| Codestral-2501 | 86.6% | 78.9% | 72.8% | 82.6% | 43.0% | 82.4% | 53.2% | 71.4% |

| Codestral-2405 22B | 81.1% | 68.9% | 78.5% | 71.4% | 40.5% | 74.8% | 43.7% | 65.6% |

| Instrução Codellama 70B | 67.1% | 56.5% | 60.8% | 62.7% | 32.3% | 61.0% | 46.8% | 55.3% |

| Instruções do DeepSeek Coder 33B | 77.4% | 65.8% | 73.4% | 73.3% | 39.2% | 77.4% | 49.4% | 65.1% |

| DeepSeek Coder V2 lite | 83.5% | 68.3% | 65.2% | 80.8% | 34.2% | 82.4% | 46.8% | 65.9% |

FIM (correspondência exata de uma linha)

| modelagem | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (média) |

|---|---|---|---|---|

| Codestral-2501 | 80.2% | 89.6% | 87.96% | 85.89% |

| Codestral-2405 22B | 77.0% | 83.2% | 86.08% | 82.07% |

| API* do OpenAI FIM | 80.0% | 84.8% | 86.5% | 83.7% |

| API de bate-papo do DeepSeek | 78.8% | 89.2% | 85.78% | 84.63% |

| DeepSeek Coder V2 lite | 78.7% | 87.8% | 85.90% | 84.13% |

| Instruções do DeepSeek Coder 33B | 80.1% | 89.0% | 86.80% | 85.3% |

Passe FIM@1.

| modelagem | HumanEvalFIM Python | HumanEvalFIM Java | HumanEvalFIM JS | HumanEvalFIM (média) |

|---|---|---|---|---|

| Codestral-2501 | 92.5% | 97.1% | 96.1% | 95.3% |

| Codestral-2405 22B | 90.2% | 90.1% | 95.0% | 91.8% |

| API* do OpenAI FIM | 91.1% | 91.8% | 95.2% | 92.7% |

| API de bate-papo do DeepSeek | 91.7% | 96.1% | 95.3% | 94.4% |

- O GPT 3.5 Turbo é a API FIM mais recente da OpenAI.

Disponível a partir de hoje

O Codestral 25.01 está sendo distribuído para desenvolvedores em todo o mundo por meio de nossos parceiros IDE / IDE plugin. Você pode sentir a diferença na qualidade de resposta e na velocidade de conclusão do código selecionando Codestral 25.01 em seu respectivo seletor de modelos.

Para casos de uso corporativo, especialmente aqueles que exigem a residência de dados e modelos, o Codestral 25.01 pode ser implantado localmente em suas instalações ou em uma VPC.

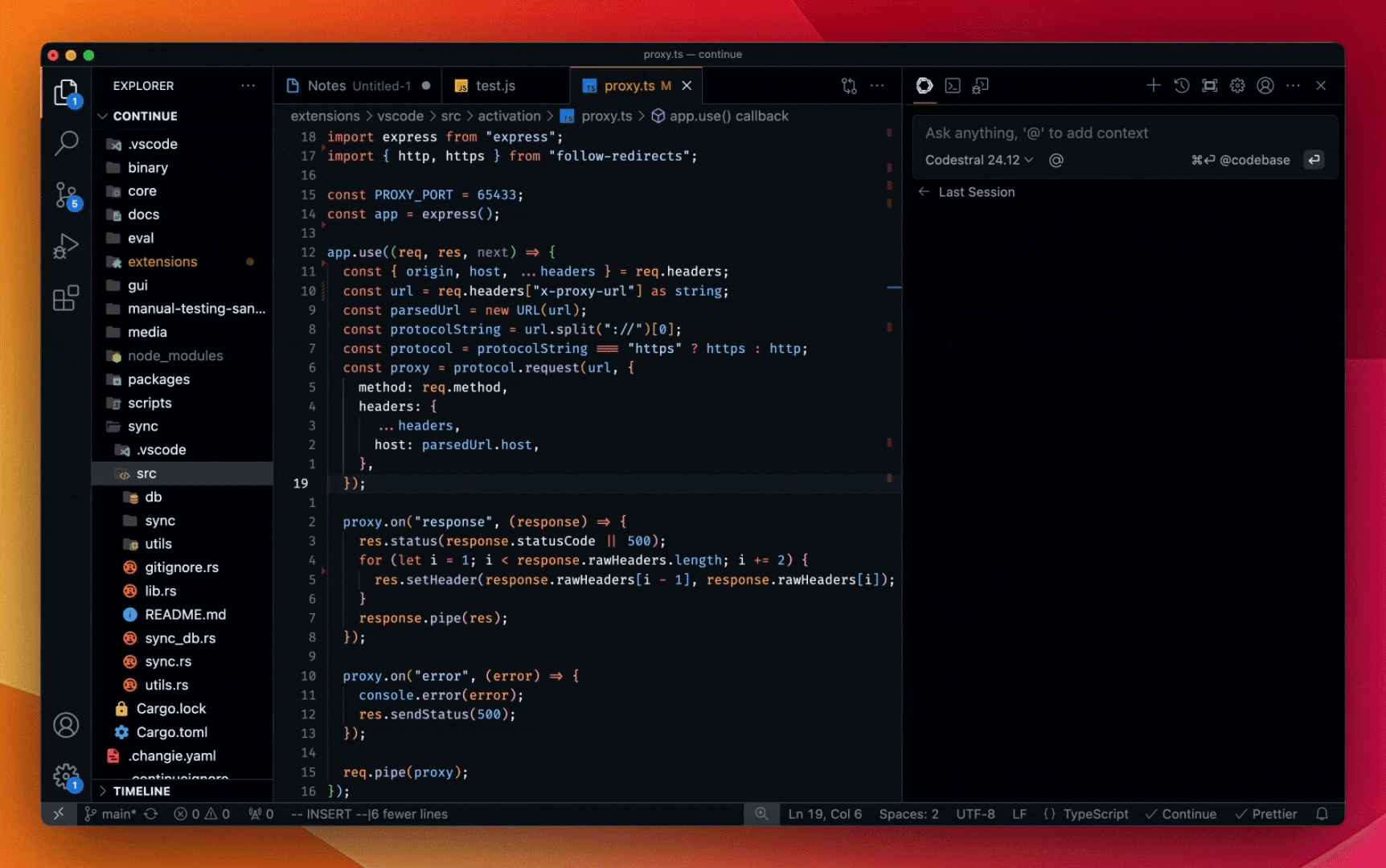

Confira a demonstração abaixo e adicione o Continuar para avaliação gratuita no VS Code ou na JetBrains.

* :: Codestral 25.01 chat demo

Ty Dunn, cofundador da Continue, disse: "Para os assistentes de código de IA, o preenchimento de código constitui a maior parte do trabalho, o que exige modelos que se destacam em Fill-in-the-Middle (FIM). -- O novo modelo da Mistral AI fornece recomendações mais precisas e mais rápidas - um componente essencial do desenvolvimento preciso e eficiente de software. É por isso que o Codestral é o modelo de autocompletar que recomendamos aos desenvolvedores."

Para criar sua própria integração usando a API Codestral, acesse A plataforma e usando codestral-latestA API também está disponível no Vertex AI do Google Cloud. A API também está disponível no Vertex AI para o Google Cloud, em pré-visualização privada no Azure AI Foundry e, em breve, no Amazon Bedrock. Documentação codificada.

Codestral 25.01 pol. LMsyscopiloto Ele estreou em primeiro lugar nas paradas de arena. Mal podemos esperar para ouvir sobre sua experiência!

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...