Experiência completa do Claude 3.7 Sonnet: canais gratuitos, detalhes da API, ativação do raciocínio

Recentemente, a Anthropic Inc. lançou Claude Uma atualização do modelo 3.5 Sonnet - Claude 3.7 Sonnet. Apesar de acrescentar apenas 0,2 ao número da versão, essa atualização traz várias mudanças no desempenho e na funcionalidade. Já se passaram mais de quatro meses desde a última atualização do modelo do Claude, o que é muito tempo no campo em rápida evolução da inteligência artificial.

É geralmente aceito no setor que os modelos não costumam ser atualizados diretamente para a versão 4.0 sem um avanço arquitetônico.

Acesso gratuito

| Nome do site | Endereços (alguns exigem acesso científico à Internet) | versão do modelo | modo de inferência | Janela de contexto (tokens) | Saída máxima (tokens) | função de rede | Limites/custos diários | especificidades |

|---|---|---|---|---|---|---|---|---|

| Site oficial do Claude | https://claude.ai/ | 3.7 Soneto | inferência | Aprox. 32K | Aprox. 8K | sem suporte | Os usuários gratuitos são limitados, os usuários pagos são limitados por Token (Normal/Extended). | A plataforma oficial, com um pequeno valor para usuários gratuitos e um limite para usuários pagos. |

| lmarena | https://lmarena.ai/ | 3.7 Soneto/32k Pensamento | Sem raciocínio/com raciocínio | 8K / 32K | 2K (máx. 4K) | sem suporte | Parece ser ilimitado | Fornece modos de não inferência e inferência de 32k com tokens de saída máximos ajustáveis. |

| Genspark | https://www.genspark.ai/ | 3.7 Soneto | inferência | inconclusivo | inconclusivo | apoiar algo | 5 sessões gratuitas por dia | Oferece suporte a pesquisas em rede para cenários em que você precisa obter as informações mais atualizadas. |

| Poe | https://poe.com/ | 3.7 Soneto/Pensamento | Sem raciocínio/com raciocínio | 16K / 32K (máx. 64K) | ajustável | sem suporte | Pontos de bônus diários, 3,7 Soneto 333 pontos por sessão, Pensamento 2367 pontos por sessão | Ajuste flexível da janela de contexto e do comprimento da saída por meio do uso do controle integral do sistema. |

| Cursor (em caráter experimental) | https://www.cursor.com/cn | 3.7 Soneto | inconclusivo | inconclusivo | inconclusivo | sem suporte | inconclusivo | Integrado ao editor de código para conveniência do desenvolvedor. |

| OpenRouter | https://openrouter.ai/ | 3.7 Soneto/Pensamento/On-line | Sem raciocínio / Raciocínio / Online | 200K | Ajustável (até 128K) | Suporte/Taxas | manter a mão sobre token Faturamento, mesmo preço para diferentes provedores de serviços, cobrança extra para modelos on-line | Há suporte para vários modelos e modos de raciocínio, com uma saída máxima parametrizada de 128 K. Os modelos de raciocínio suportam "raciocínio completo". Os modelos on-line oferecem suporte à rede por um custo adicional. |

| OAIPro | (É necessária uma chave de API) | 3.7 Soneto/Pensamento | Sem raciocínio/com raciocínio | 64K / 200K | 4K (ajustável) | sem suporte | Faturamento por token | O modelo Thinking ativa automaticamente a inferência, e o token de inferência é forçado a ser 80% de max_tokens. |

| Estúdio Cherry | (É necessária uma chave de API) | 3.7 Soneto | Sem raciocínio/com raciocínio | 200K | Ajustável (até 128K) | Suporte (requer Tavily Key) | Faturamento por token + Tavily Número de consultas (1.000 consultas gratuitas por mês) | Combinado com a API da Tavily, ele permite pesquisas em rede. |

| PróximoChat | (É necessária uma chave de API) | 3.7 Soneto | inconclusivo | inconclusivo | inconclusivo | Suporte (plug-in do WebPilot) | freeware | combinando WebPilot O plug-in permite a pesquisa em rede. |

Para experimentar o Claude 3.7 Sonnet gratuitamente, há várias maneiras de fazê-lo:

- Site oficial do Claude::

- endereço de acesso: (é necessário acesso científico) https://claude.ai/

- funcionalidadeMembros gratuitos podem usar a versão sem inferência do modelo e não são compatíveis com o recurso de rede.

- lmarena::

- endereço de acesso:: https://lmarena.ai/

- funcionalidadeNa opção "direct chat" (bate-papo direto), você pode selecionar a versão sem inferência ou a versão com inferência de 32k do modelo, sendo que ambas não oferecem suporte à rede. O limite de entrada é de 8k tokens, a saída padrão é de 2k tokens e a saída máxima pode ser de 4k tokens ajustando os parâmetros.

- Introdução à lmarenaPlataforma de modelagem de grandes linguagens (LLM): uma plataforma que oferece várias arenas de modelagem de grandes linguagens (LLM) e funcionalidade de bate-papo direto em que os usuários podem comparar e testar diferentes modelos.

- Versão sem inferência

- Edição 32k Reasoning

- Parâmetro máximo de tokens de saída (até 4k)

- Máximo de tokens de saída ExplicaçãoNúmero máximo de tokens: Esse parâmetro é usado para definir o número máximo de tokens que podem ser gerados pelo modelo em uma única passagem.

- Genspark::

- endereço de acesso: (é necessário acesso científico) https://www.genspark.ai/

- funcionalidadeO modelo é fornecido em uma versão de raciocínio, há suporte para rede (marque "Search Web") e há 5 conversas gratuitas por dia.

- Introdução ao GensparkPlataforma que fornece serviços de IA em que os usuários podem trabalhar com uma variedade de modelos de linguagem em grande escala e oferecer suporte a recursos de pesquisa conectados.

- Versão de raciocínio, com acesso à Internet, 5 vezes ao dia

- Poe::

- endereço de acesso: (é necessário acesso científico) https://poe.com/

- funcionalidade: 3000 pontos de bônus por dia.

- Introdução a PoePlataforma lançada pelo Quora que permite aos usuários interagir com vários modelos de linguagem em grande escala e criar bots personalizados.

- Modelo Claude 3.7Consumo de 333 pontos, ajustável por meio do controle deslizante, suporta até 16 mil contextos, sem rede.

- Cláusula 3.7 Modelos de pensamentoConsumo de pontos: 2367 pontos consumidos, ajustáveis por meio do controle deslizante, contexto padrão de 32k, máximo de 64k.

- Padrão 32k::

- Máximo de 64k::

Vale a pena observar que o livro de Poe

Global per-message budgetConfiguração.

Essa configuração indica a quantidade máxima de créditos a ser consumida por conversa, cujo padrão é 700; o Poe o alertará se uma mensagem exceder esse custo. Essa configuração se aplica a todos os bate-papos, e você também pode editar o orçamento para bate-papos específicos nas configurações de bate-papo. Se o orçamento for definido como muito baixo, as conversas com a IA poderão falhar, pois alguns modelos exigem maior consumo de pontos para funcionar corretamente.

- Cursor (período de experiência)::

- endereço de acesso:: https://www.cursor.com/cn

- funcionalidadeRede: Não há suporte para rede.

- Introdução ao CursorEditor de código: um editor de código com inteligência artificial integrada projetado para ajudar os desenvolvedores a escrever e depurar códigos com mais eficiência.

Uso da API

Para os desenvolvedores, o uso do Claude 3.7 Sonnet por meio da API oferece maior flexibilidade e controle.

- preçosPreço da API Sonnet Claude 3.7: o preço da API Sonnet Claude 3.7 é o mesmo da versão 3.5, com US$ 3/milhão de tokens para entrada e US$ 15/milhão de tokens para saída, além de US$ 0,3/milhão de tokens para leituras de cache e US$ 3,75/milhão de tokens para gravações de cache. O processo de inferência também conta os tokens de saída, portanto, a contagem real de tokens e o preço total são maiores do que seriam sem inferência. A contagem de tokens e o preço total são maiores do que sem o raciocínio.

- janela de contextoComo no Claude 3.5 Sonnet, a janela de contexto total para a API do Claude 3.7 Sonnet é de 200 mil tokens.

- Explicação da janela de contextorefere-se ao comprimento do texto que o modelo pode levar em conta ao processar a entrada.

- Explicação do tokenUnidade básica de texto: a unidade básica de texto, que pode ser uma palavra, um caractere ou uma subpalavra.

- saída máximaA API do Claude 3.5 Sonnet tem uma saída máxima de 8 mil tokens, enquanto o Claude 3.7 Sonnet tem uma saída máxima de 128 mil tokens ao definir um parâmetro.

A versão API do Big Model normalmente tem uma janela de contexto e uma saída máxima maiores do que a versão Chat, porque os usuários da API pagam pelo uso real e, quanto mais entradas e saídas, maior a receita do provedor de serviços. A versão do Chat geralmente tem um preço mensal fixo, portanto, quanto mais resultados você tiver, maior será o custo para o provedor de serviços.

modelo de raciocínio híbrido

Agora só há 3.7 sermodelo de raciocínio híbridoSam disse GPT4.5 é a última geração de modelos não inferenciais queGPT5.0 junto com o Em seguida, a série foi mesclada, provavelmente também com um modelo de inferência híbrido.

Híbrido é inferência e não inferência, usando o mesmo modelo, com a API usando parâmetros e a versão do Chat controlando o consumo/esforço do token de inferência com controles deslizantes ou menus suspensos etc.

Correspondência, o desempenho do raciocínio é diretamente proporcional ao desempenho do modelo subjacente X tempo de raciocínio, o desempenho do modelo subjacente é diferente, primeiro não comparado ao tempo de raciocínio, pode ser avaliado para medir o GPT para reduzir a sabedoria de poemas japoneses comumente usados e outros tópicos como exemplo de um teste pessoal.

O que se segue é uma estimativa pessoal, levando em conta apenas o pensamento sobre o relacionamento de alinhamento de tempo, não a inteligência. Apenas para referência

Há menos tokens a serem considerados para o R1 porque o R1 é gratuito e o desempenho deve ser levado em conta, mantendo os custos sob controle.

presente . DeepSeek manter R1-baixo colaboração com o3mini-med Esperar por uma luta, de fato, deve ser um desempenho mais forte se um Token de inferência maior for aberto

Outro motivo para o cartão DeepSeek, que claramente não é suficiente, é o fato de que o cartão anterior "Sistema ocupado". Depois de um mês, é improvável que consigamos aumentar o desempenho em um futuro próximo, como o3mini e Claude, estendendo significativamente o tempo e aumentando o número de tokens, de modo que a força seja grande o suficiente para voar e aumentar violentamente o poder aritmético.

Tongli, uma cidade na província de Jiangsu, China Gêmeos Como o R1, também é uma estratégia gratuita e o controle de custos vem em primeiro lugar, portanto, o Gemini 2.0 Flash Thinking Token também é o o3mini-low Esse equipamento.

Como definir a saída máxima de 128K

Método de configuração do Cherry Studio + OpenRouter (não referencial)

Esse método é para usar a API Sonnet do Claude 3.7 por meio do OpenRouter.

- Introdução ao OpenRouterPlataforma que fornece vários serviços de agregação de API de modelo de linguagem em grande escala.

- Sobre o Cherry StudioFerramenta do lado do cliente que oferece suporte a uma ampla gama de APIs para grandes modelos de linguagem.

- Abra o Cherry Studio e adicione ou edite um assistente.

- Em "Model Settings" (Configurações do modelo), adicione

betase selecione JSON para o tipo de dados do parâmetro:

["output-128k-2025-02-19"]

- aumentar

max_tokensselecione Numérico para o tipo de parâmetro e defina o valor como 128000:

betasconta paraParâmetros usados para ativar recursos experimentais específicos.max_tokensconta paraNúmero máximo de tokens: Usado para definir o número máximo de tokens que o modelo pode gerar em uma única passagem.

Testes empíricos mostraram que é possível obter saídas superiores a 64K com o OpenRouter, mas com alguma probabilidade de truncamento. Isso pode ser devido à instabilidade da rede ou às limitações do próprio modelo.

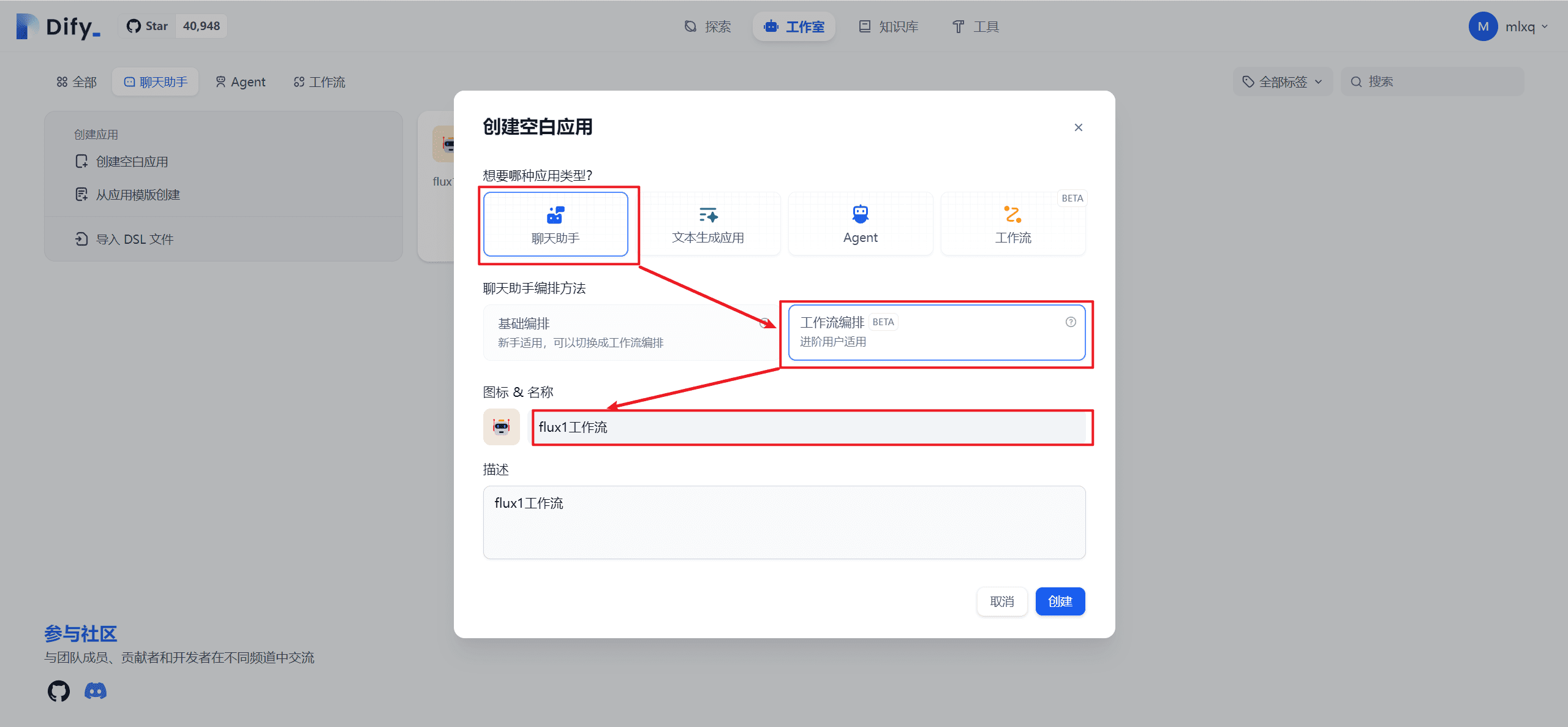

Método de configuração do OpenRouter (120K de raciocínio completo)

Esse método só se aplica ao modelo Claude-3.7-Sonnet:Thinking do OpenRouter.

- Abra o Cherry Studio e adicione ou edite um assistente.

- Em "Model Settings" (Configurações do modelo), adicione

betase selecione JSON para o tipo de dados do parâmetro:["output-128k-2025-02-19"] - aumentar

thinkingselecione JSON para o tipo de parâmetro e defina o valor como:{"type": "enabled", "budget_tokens": 1200000}thinkingconta paraParâmetros usados para ativar o modo de inferência e definir o orçamento de inferência.

- Defina a temperatura do modelo como 1. Outros valores de temperatura podem resultar em uma inferência inválida.

- aumentar

max_tokenscom o valor definido como 128000 (o valor mínimo é 1024, que precisa ser alguns K maior que o orçamento de inferência deixado para a saída final):

WebUI aberta + API oficial ou método de configuração oaipro (mais de 120 mil raciocínios completos)

- Introdução à Open WebUIInterface da Web de código aberto e auto-hospedada para modelagem de linguagem em larga escala.

- Introdução à oaiproPlataforma que fornece serviços de proxy da API do Claude.

aprovar (um projeto de lei ou inspeção etc.) Abrir a WebUI (usado em uma expressão nominal) pipe Modificações funcionais headerA saída do Claude 3.7 128K pode ser obtida em qualquer local da API.

pipeconta paraRecurso da Open WebUI que permite que os usuários modifiquem os cabeçalhos das solicitações.headerconta paraCabeçalho de solicitação HTTP: cabeçalho de solicitação HTTP que contém metadados sobre a solicitação.

A inferência pode ser definida para um máximo de 127999, isso porque:

Contexto total 200K (fixo) - Saída máxima 128K (configurável) = Entrada máxima restante 72K

Saída máxima 128K (configurável) - Cadeia de pensamento 120K (configurável) = Saída final restante 8K

Como verificar se o modo de raciocínio está ativado

É possível tentar fazer perguntas mais complexas. Se o modo de raciocínio estiver ativado, o Cherry Studio pensará por dezenas de segundos a minutos sem nenhum resultado. Atualmente, o Cherry Studio não foi adaptado para exibir o processo de raciocínio.

Por exemplo, tente as seguintes perguntas (que geralmente não levam à resposta correta sem raciocínio, levam alguns minutos com raciocínio e acertam na maioria dos casos):

resposta correta:

Vantagens e desvantagens de grandes produções

vantagem::

- É possível substituir parte do trabalho das inteligências. Por exemplo, enquanto a tradução de um livro poderia ter exigido anteriormente que um corpo inteligente dividisse os capítulos, agora ele pode lidar diretamente com o livro inteiro.

- Possível economia de custos. Se você não dividir os capítulos e inserir o texto inteiro diretamente, poderá produzir 8K de cada vez e repetir 16 vezes para obter uma saída de 128K. Embora o custo de saída seja o mesmo, o texto original só precisa ser inserido uma vez, economizando o custo de 15 entradas.

- Com uma estratégia de entrada sensata, você pode reduzir drasticamente os custos, melhorar a eficiência e até aumentar a velocidade de processamento.

- Com cerca de 100.000 palavras ou mais, pode ser uma tradução de um livro inteiro, escrever um livro para escrever um artigo da Web, antes e depois da consistência ser boa, não escreverá para trás para esquecer a frente, teoricamente pode ser uma saída única de 3,5 a 16 vezes a quantidade de código, o que melhora muito o poder de processamento e a eficiência.

desvantagens::

- O desempenho de todos os modelos grandes decai com o aumento do contexto, com a magnitude exata do decaimento a ser avaliada.

- Saídas únicas de 128K são caras, portanto, certifique-se de testar a palavra-chave cuidadosamente antes de passar para uma saída grande, a fim de evitar erros que possam levar ao desperdício.

Rede API

A própria API oficial do Claude não oferece suporte à rede:

- CherryStudio + chave de API da Tavily: 1000 conexões gratuitas por mês.

- Sobre a TavilyAPI de pesquisa: uma plataforma que fornece serviços de API de pesquisa.

Método: Atualize para a versão 1.0 mais recente do CherryStudio, registre-se e solicite uma chave de API gratuita em tavily.com:

Preencha a chave de API nas configurações do Cheery e clique no botão Rede na caixa Pergunta:

- NextChat + Plug-in do WebPilot: Rede gratuita.

- Sobre o NextChatPlataforma de bate-papo compatível com vários modelos e plug-ins de idiomas grandes.

- Introdução ao WebPilotPlug-in de extração de conteúdo da Web e funcionalidade de resumo: um plug-in que fornece extração de conteúdo da Web e funcionalidade de resumo.

- Sala de bate-papo do OpenRouter: Ele vem com um botão de rede. Como fazer isso: Faça login no Chatroom | OpenRouter, selecione o modelo 3.7 Sonnet e destaque o botão de rede na caixa de perguntas:

- O OpenRouter vem com recursos de redeMétodo: preencher manualmente o nome do modelo ao adicionar um modelo

anthropic/claude-3.7-sonnet:onlineO custo do programa é de US$ 4 por 1.000 consultas.

Outras informações relacionadas à API

- API oficial::

- entradas:: https://www.anthropic.com/api

- Recarga mínima de US$ 5.

- Não há suporte para a configuração por meio dos parâmetros Cherry

betasAtiva a saída de 128K. - O Tier 1 tem um limite de entrada de 20 mil tpm e um limite de saída de 8 mil tpm.

- entradas:: https://www.anthropic.com/api

- API do OpenRouter::

- entradas:: https://openrouter.ai/anthropic/claude-3.7-sonnet

- Fornece os modelos Claude-3.7-Sonnet, Claude-3.7-Sonnet Thinking e Claude-3.7-Sonnet Beta.

- O suporte para o Claude-3.7-Sonnet Online ou o Claude-3.7-Sonnet Thinking Online, com rede, está disponível por um custo adicional de US$ 4 por mil consultas.

- Há três provedores: Anthropic, Amazon e Google com o mesmo preço.

- A saída máxima para os provedores do Google é de apenas 64K, enquanto o Anthropic e o Amazon podem ser parametrizados para 128K.

- entradas:: https://openrouter.ai/anthropic/claude-3.7-sonnet

- API do OAIPro::

- Introdução à oaiproPlataforma que fornece serviços de proxy da API do Claude.

- Entrada padrão 64K, cadeia de pensamento + saída final 4K.

- Não há suporte para a configuração por meio dos parâmetros Cherry

betasHabilita a saída de 128K. Se você não adicionarmax_tokensa saída padrão é 4K. - Claude-3-7-Sonnet-20250219-Thinking model: a inferência é ativada diretamente, não são necessários parâmetros adicionais e o token de inferência é forçado a ser

max_tokens80%, parece que não é possível especificar othinkingParâmetros. - Claude-3-7-Sonnet-20250219 Modelo: pode ser especificado manualmente

thinkingParâmetros.

- centro de trânsito de baixo custo::

- aicnnProdução normal é de cerca de US$ 72/milhão de tokens.

- Introdução aicnnPlataforma para fornecer serviços de IA, incluindo API relay.

- Observação: algumas estações de trânsito de baixo custo podem suportar somente saída de 64K, não de 128K.

- aicnnProdução normal é de cerca de US$ 72/milhão de tokens.

Versão de bate-papo

Associação gratuita

É possível usar o Claude 3.7 Sonnet, mas há algumas limitações para seu uso. De acordo com o Antrópica No passado, o número de usuários gratuitos talvez não fosse muito grande.

Além disso, o modelo Claude 3.5 Haiku agora não está disponível para membros gratuitos.

- janela de contextoMedido em cerca de 32K.

- saída máximaMedido em cerca de 8K.

- sem inferência

membro pagante

A janela de contexto e a saída máxima da versão paga do Chat ainda não estão certas se são as mesmas da versão gratuita.

A versão paga oferece os modos de raciocínio Normal e Estendido. No entanto, deve-se observar que existe o risco de que as contas pagas sejam banidas. É recomendável recarregar sua assinatura antes de garantir que você tenha um endereço IP imaculado. Em termos comparativos, é mais seguro usar a API.

O limite de uso dos membros do Claude não se baseia no número de vezes, como o GPT ou o Grok, mas no número total de tokens. Como resultado, o uso do Modo de raciocínio, especialmente o Modo estendido, reduz significativamente o número de perguntas que podem ser feitas por dia. Alguns usuários revelaram que o Anthropic pode introduzir uma redefinição paga do limite de uso, permitindo que os usuários ignorem o período de reflexão por uma taxa única.

funcionalidade

- Carregamento de arquivosSuporte a até 20 arquivos com um máximo de 30 MB por arquivo.

- multimodalReconhecimento de imagem: Suporta reconhecimento de imagem, não de voz ou vídeo.

- GitHubNovo recurso que se conecta ao repositório do GitHub de um usuário como uma forma de fazer upload de arquivos.

- Código ClaudeFerramenta de linha de comando oficial para desenvolvedores, atualmente lançada como uma prévia limitada de pesquisa. A ferramenta oferece suporte à pesquisa de código, leitura, edição, execução de testes, commits do GitHub e operações de linha de comando, e foi projetada para reduzir o tempo de desenvolvimento e aumentar a eficiência do desenvolvimento orientado por testes e da depuração de problemas complexos.

- Redes, pesquisa profunda, pesquisa profunda, modelagem de fala, gráficos de VincennesClaude versão 3.5: Igual ao Claude versão 3.5, sem suporte.

Revisão do modelo

habilidades de codificação

A competência de código sempre foi um ponto forte do modelo Claude e uma grande preocupação para seu principal grupo de usuários, os programadores. Se a competência de código diminuir, o Claude poderá enfrentar um sério desafio.

- Lmarena: webdev Rating Leader. Referência: https://lmarena.ai/?leaderboard

- LivebenchA versão sem raciocínio do Claude 3.7 tem melhorias menores em comparação com a versão 3.5, e a versão com raciocínio tem melhorias maiores, mas com um aumento correspondente no custo (mesmo preço unitário, Token de saída maior). Referência: https://livebench.ai/

- Introdução ao Livebench:: uma plataforma para avaliação contínua do desempenho de grandes modelos de linguagem.

- AjudanteO modelo de inferência do Claude 3.7 custa cerca de 2,5 vezes mais do que a versão 3.5.

- Introdução ao AiderAssistente de programação com IA que ajuda os desenvolvedores na geração e depuração de códigos.

Referência: https://aider.chat/docs/leaderboards/

- IA do CodeParrotClaude 3.7 tem um bom desempenho no benchmark de codificação HumanEval com uma pontuação de 92,1, uma melhoria em relação ao Claude 3.5 (89,4).

- Introdução à IA do CodeParrotPlataforma que fornece uma série de ferramentas de codificação para otimizar o processo de desenvolvimento.

Uso inteligente de ferramentas corporais

A Anthropic afirma oficialmente que o Claude 3.7 se destaca no uso de ferramentas corporais inteligentes.

habilidade matemática

Claude 3.7 Normal é mediano em matemática, Raciocínio tem um desempenho melhor.

capacidade de raciocínio

desempenho do mercado

Calor da pesquisa do Google::

Google Play: Claude App está em 107º lugar nas paradas de sucesso dos EUA.

Loja de aplicativosNão conseguiu entrar no top 200.

Resumo e perspectivas

O lançamento do Claude 3.7 Sonnet marca outra iteração do Anthropic no espaço de modelos grandes. Apesar da pequena alteração no número da versão, ele oferece melhorias na geração de código, nos recursos de inferência e na grande saída contextual. No entanto, o Claude ainda enfrenta desafios em termos de acesso limitado para usuários gratuitos, falta de recursos de rede e desempenho do mercado.

Com base na taxa de atualização anterior da Anthropic, pode levar algum tempo até que o Claude 4.0 seja lançado. A taxa de crescimento geral do Claude, especialmente no C-suite (lado do consumidor), está claramente atrás de seus concorrentes. Sua avaliação foi superada pela xAI.

De acordo com a tendência atual, o Claude pode ser excluído do primeiro nível dos grandes modelos globais pela GPT, DeepSeek e Gemini. No futuro, o Claude poderá competir com modelos como Grok e Beanbag pela posição de segundo nível ou optar por abandonar completamente o mercado de C-end e se concentrar em verticais como programação, inteligência e redação.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...