Introdução geral

O Deep Live Cam é uma ferramenta de IA de código aberto projetada para permitir a substituição de rostos em tempo real e a geração de vídeos falsos profundos a partir de uma única foto. Usando algoritmos avançados de aprendizagem profunda, a ferramenta é capaz de substituir rostos em tempo real durante transmissões ao vivo ou chamadas de vídeo, protegendo a privacidade do usuário e acrescentando interesse. O Deep Live Cam é compatível com várias plataformas, incluindo CPU, NVIDIA CUDA, Apple Silicon, etc., e é adequado para uma ampla gama de campos, como entretenimento, educação, criação de arte e publicidade.

Lista de funções

- Substituição de rosto em tempo real: substituição de rosto em tempo real em vídeo por meio de uma única foto.

- Suporte multiplataforma: compatível com os principais sistemas operacionais e plataformas de hardware.

- Aceleração de GPU: suporta a aceleração NVIDIA CUDA para aumentar a velocidade de processamento.

- Mecanismo de auditoria de conteúdo: mecanismo antiabuso incorporado para evitar que a tecnologia seja usada em cenários inadequados.

- Código-fonte aberto: o código do projeto está hospedado no GitHub e pode ser baixado e modificado livremente pelos usuários.

Usando a Ajuda

Processo de instalação

- Preparação ambiental::

- Certifique-se de que o Python 3.10 ou posterior esteja instalado.

- Instale pip, git, ffmpeg e outras ferramentas de desenvolvimento.

- Para usuários do Windows, também será necessário instalar o tempo de execução do Visual Studio 2022.

- Clonagem e configuração::

- Clone o repositório GitHub do Deep-Live-Cam em seu ambiente local:

git clone https://github.com/hacksider/Deep-Live-Cam.git - Faça o download dos arquivos de modelo necessários e coloque-os no diretório especificado, seguindo as diretrizes da documentação:

- GFPGANv1.4

- inswapper_128_fp16.onnx

- Clone o repositório GitHub do Deep-Live-Cam em seu ambiente local:

- Instalação dependente::

- Use o pip para instalar as bibliotecas de dependência exigidas pelo projeto. Recomenda-se usar um ambiente virtual para evitar possíveis conflitos de dependência:

pip install -r requirements.txt

- Use o pip para instalar as bibliotecas de dependência exigidas pelo projeto. Recomenda-se usar um ambiente virtual para evitar possíveis conflitos de dependência:

- programa de corrida::

- Inicie o Deep-Live-Cam na linha de comando:

python run.py - Selecione a imagem de origem e o vídeo de destino para observar o efeito de troca de rosto em tempo real.

- Inicie o Deep-Live-Cam na linha de comando:

- Aceleração de GPU::

- Para aqueles com GPUs NVIDIA, você pode acelerar o processo de troca de faces instalando o CUDA Toolkit e configurando as variáveis de ambiente apropriadas:

pip uninstall onnxruntime onnxruntime-gpu pip install onnxruntime-gpu==1.16.3 python run.py --execution-provider cuda

- Para aqueles com GPUs NVIDIA, você pode acelerar o processo de troca de faces instalando o CUDA Toolkit e configurando as variáveis de ambiente apropriadas:

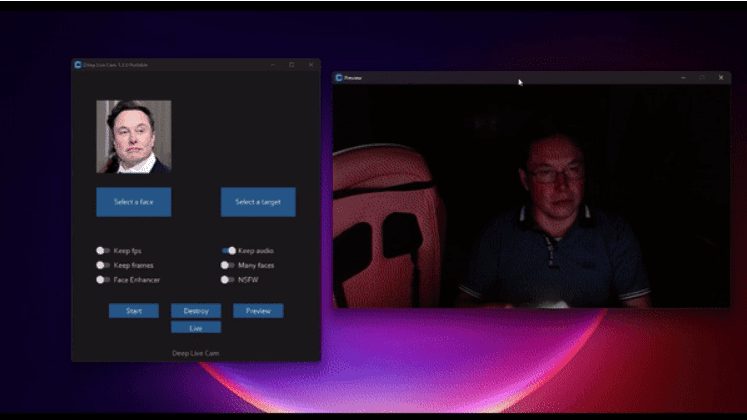

Processo de uso

- Selecione a imagem de origem e o vídeo de destino::

- Após o início do programa, selecione uma imagem que contenha o rosto desejado e uma imagem ou vídeo de destino.

- início do processamento::

- Clique no botão "Start" (Iniciar) e o programa iniciará o processamento e exibirá o efeito de mudança de rosto em tempo real.

- Exibir saída::

- Quando o processamento estiver concluído, abra o File Explorer e navegue até o diretório de saída selecionado para visualizar o vídeo de troca de faces gerado.

- modo de câmera::

- Selecione um rosto, clique no botão "live" (ao vivo) e aguarde alguns segundos para que a visualização seja exibida.

- Transmissão usando uma ferramenta de gravação de tela, como o OBS.

advertência

- Ao executar o programa pela primeira vez, talvez seja necessário fazer o download de um arquivo de modelo de aproximadamente 300 MB, dependendo da velocidade da sua conexão com a Internet.

- Se você quiser mudar os rostos, basta selecionar outra imagem e o modo de visualização será reiniciado.