Introdução ao MathCLUE "Competição Nacional de Matemática do Ensino Médio": uma avaliação aprofundada da capacidade de raciocínio matemático em nível de competição em modelos grandes. O sistema de avaliação abrange várias dimensões representativas da matemática do ensino médio, incluindo geometria, álgebra e estatística de probabilidade.

Modelo de medição: DeepSeek-R1 (acessado em chat.deepseek.com)

Avaliação e análise do DeepSeek-R1

🔍 DeepSeek-R1 está no topo da lista do concurso nacional de matemática para o ensino médio da MathCLUE

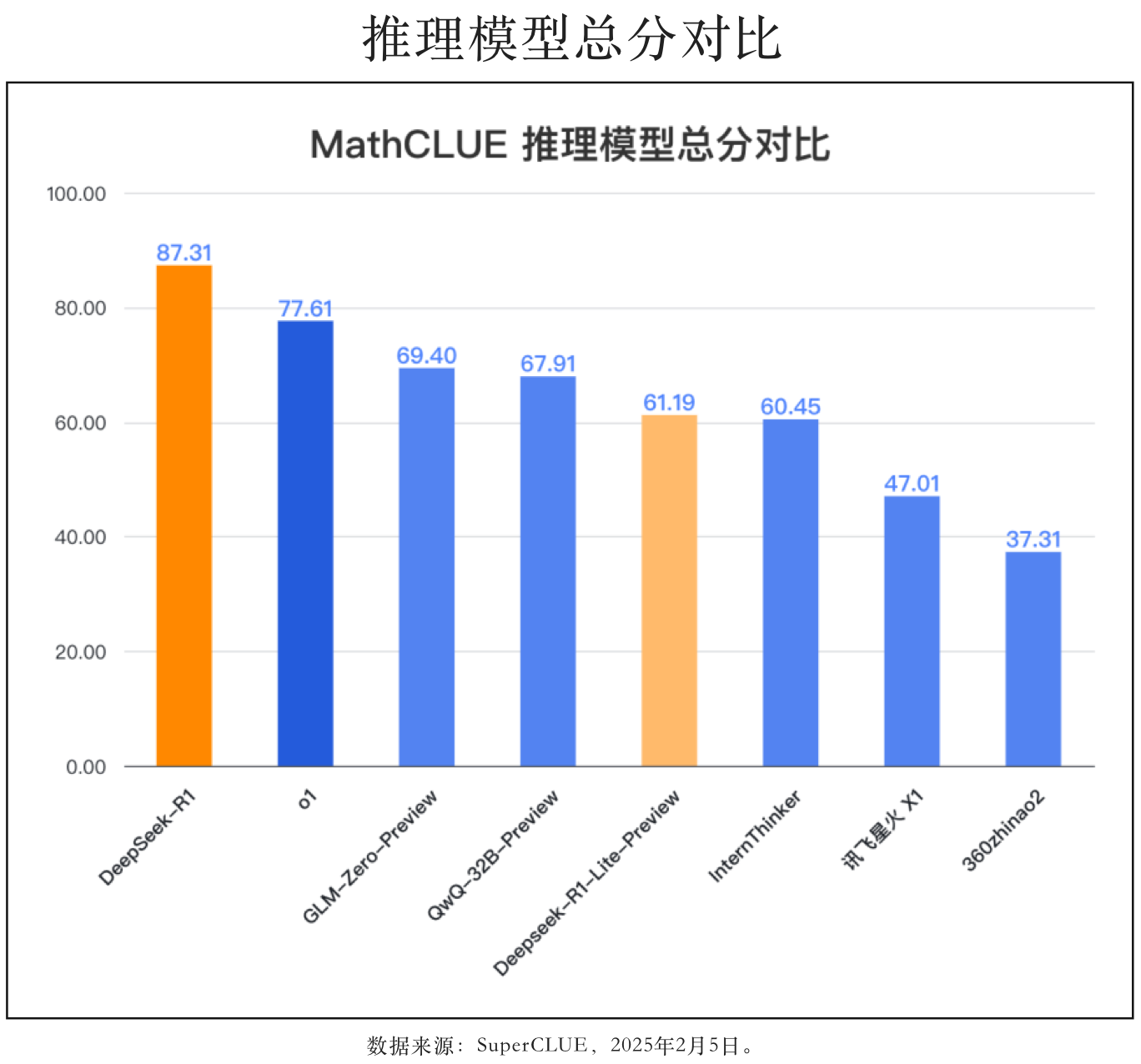

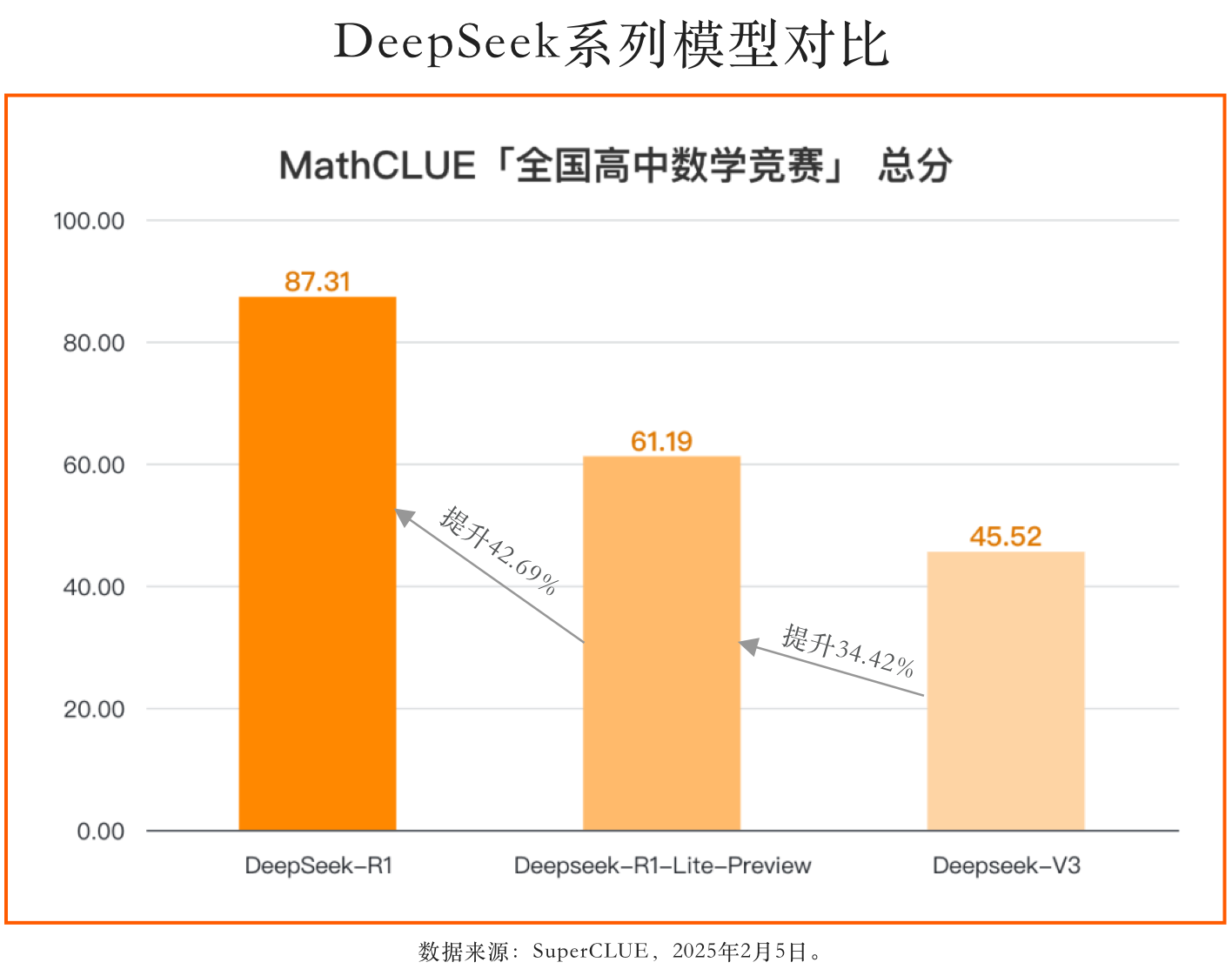

O DeepSeek-R1 está no topo da lista de avaliação da competição nacional de matemática do ensino médio, com uma excelente pontuação de 87,31 pontos, significativamente à frente do modelo o1, o melhor do mundo, por quase 10 pontos, em comparação com o DeepSeek-R1-Lite-Preview, que melhorou 26,12 pontos, sua pontuação geral melhorou substancialmente e sua capacidade de raciocínio matemático e de resolução de problemas atingiu um novo nível.

Enquanto isso, os resultados do Qwen2.5-Max "Competição Nacional de Matemática do Ensino Médio" foram divulgados! Não atendeu às expectativas, com os motivos

Modelo de avaliação: Qwen2.5-Max

Chame o nome da versão oficial da API: qwen-max-2025-01-25

Avaliação e análise do Qwen2.5-Max

O Qwen2.5-Max ainda tem espaço para melhorias na lista do MathCLUE

O Qwen2.5-Max obteve 33,58 pontos e ficou em 9º lugar na Competição Nacional de Matemática do Ensino Médio, à frente de modelos famosos do exterior. Claude 3.5 Sonnet (20241022) 15,67 pontos, mas ainda tem espaço para melhorar (com uma diferença de mais de 30 pontos) em comparação com os principais modelos nacionais e internacionais.

Analisamos o desempenho do modelo em profundidade com relação a suas perguntas erradas. Verificamos que o modelo omite o processo de solução e dá respostas erradas diretamente em alguns quebra-cabeças, e essa avaliação é pontuada somente com base nas respostas finais, o que pode ser o principal motivo de sua baixa pontuação.

Comentários

Conjunto de revisão da Competição Nacional de Matemática do Ensino Médio MathCLUE. Abrange questões da Competição Nacional de Matemática do Ensino Médio de 2024 e desenvolve uma avaliação rigorosa do Grande Modelo.

Metodologia

O método de determinar se a resposta final na resposta corresponde à resposta de referência para a resposta do macromodelo na tarefa de avaliação para confirmar a taxa de acerto do macromodelo (correto ou incorreto) em uma pergunta atinge a objetividade total na avaliação.