Introdução geral

O GLM-Edge é uma série de grandes modelos de linguagem e modelos de compreensão multimodal projetados para dispositivos finais da Universidade de Tsinghua (Smart Spectrum Light Language). Esses modelos incluem o GLM-Edge-1.5B-Chat, o GLM-Edge-4B-Chat, o GLM-Edge-V-2B e o GLM-Edge-V-5B para plataformas de telefone celular, carro e PC, respectivamente. A série de modelos GLM-Edge se concentra na facilidade de implantação prática e na velocidade de inferência, mantendo o alto desempenho, e se destaca nas plataformas Qualcomm Snapdragon e Intel, em particular. Os modelos da série GLM-Edge se concentram na facilidade de implantação e na velocidade de inferência, mantendo um desempenho eficiente, especialmente nas plataformas Qualcomm Snapdragon e Intel. Os usuários podem baixar e usar esses modelos via Huggingface, ModelScope, etc., e realizar a inferência do modelo por meio de vários backends de inferência (por exemplo, transformadores, OpenVINO, vLLM).

GLM Modelo de texto do lado final do Edge

GLM Modelo visual do lado da extremidade do Edge

Lista de funções

- Várias opções de modelosModelo de compreensão multimodal: fornece modelos de diálogo e modelos de compreensão multimodal em diferentes escalas de parâmetros para uma ampla variedade de dispositivos finais.

- Raciocínio eficienteObtenha velocidades de inferência eficientes nas plataformas Qualcomm Snapdragon e Intel com suporte para esquemas de quantificação híbridos.

- Suporte a várias plataformasModelos: Os modelos estão disponíveis para download no Huggingface, ModelScope e outras plataformas, e suportam uma ampla gama de backends de inferência.

- Fácil de implementarGuia de instalação e uso detalhado para que os usuários possam começar a usar rapidamente.

- Suporte para ajuste finoFornecimento de tutoriais de ajuste fino e arquivos de configuração para dar suporte aos usuários no ajuste fino de seus modelos de acordo com suas necessidades específicas.

Usando a Ajuda

Instalação de dependências

Certifique-se de que você tenha a versão 3.10 ou superior do Python. E instale as dependências da seguinte forma:

pip install -r requirements.txt

raciocínio modelado

Fornecemos vLLM, OpenVINO e transformadores para inferência de back-end, e você pode executar os modelos executando os seguintes comandos:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend vllm ---model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend ov --model_path THUDM/glm-edge-1.5b-chat-ov --precision int4

Observação: o modelo de versão do OpenVINO precisa ser convertido. Acesse a página relevante para executar o código de conversão:

python convert_chat.py --model_path THUDM/glm-edge-1.5b-chat --precision int4

python convert.py --model_path THUDM/glm-edge-v-2b --precision int4

Ajuste fino do modelo

Fornecemos código para o ajuste fino do modelo; consulte o tutorial de ajuste fino. A seguir estão as etapas básicas para o ajuste fino:

- Prepare o conjunto de dados e configure os parâmetros de treinamento.

- Execute o script de ajuste fino:

OMP_NUM_THREADS=1 torchrun --standalone --nnodes=1 --nproc_per_node=8 finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora. yaml

- Se você precisar continuar o ajuste fino a partir do ponto de salvamento, poderá adicionar um quarto parâmetro:

python finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml yes

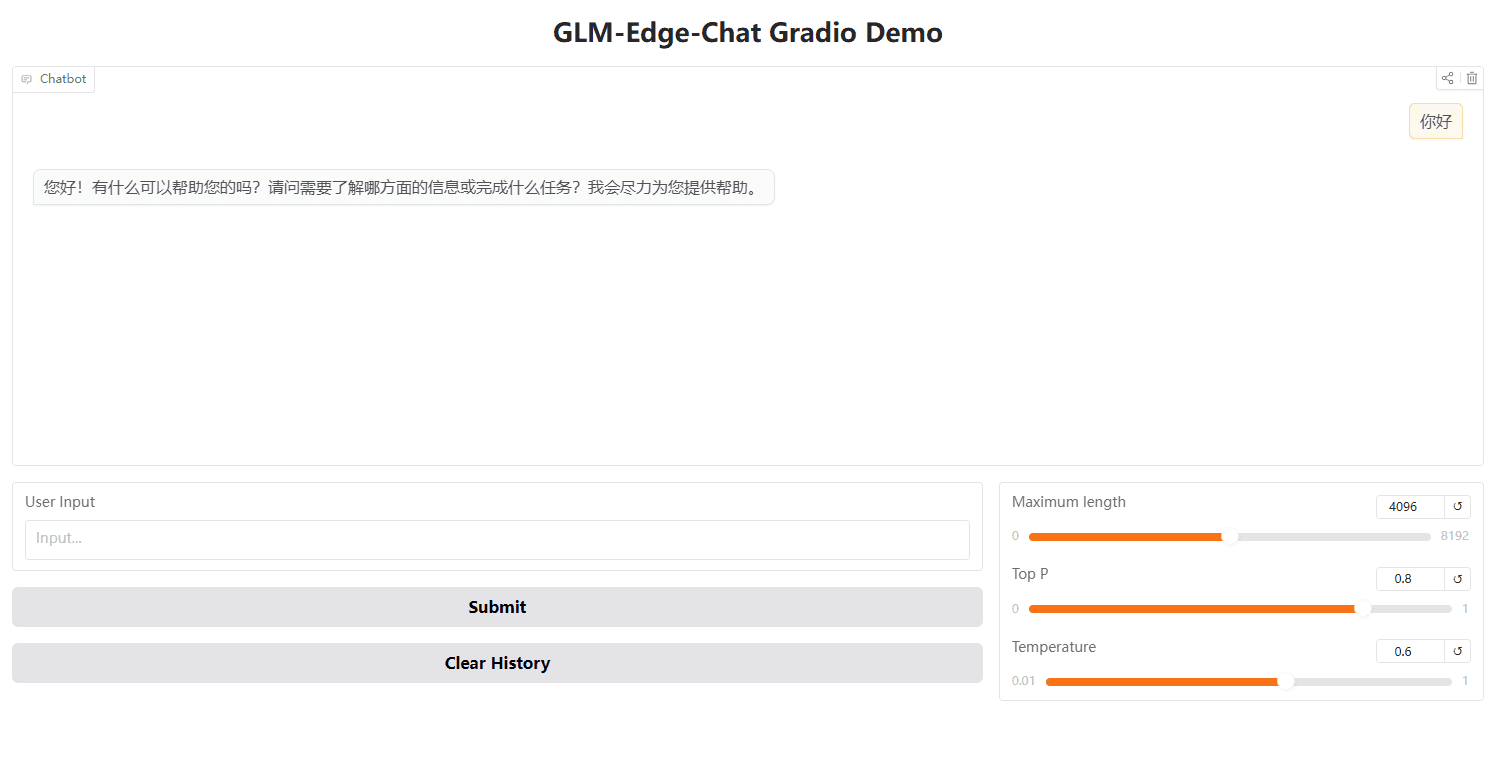

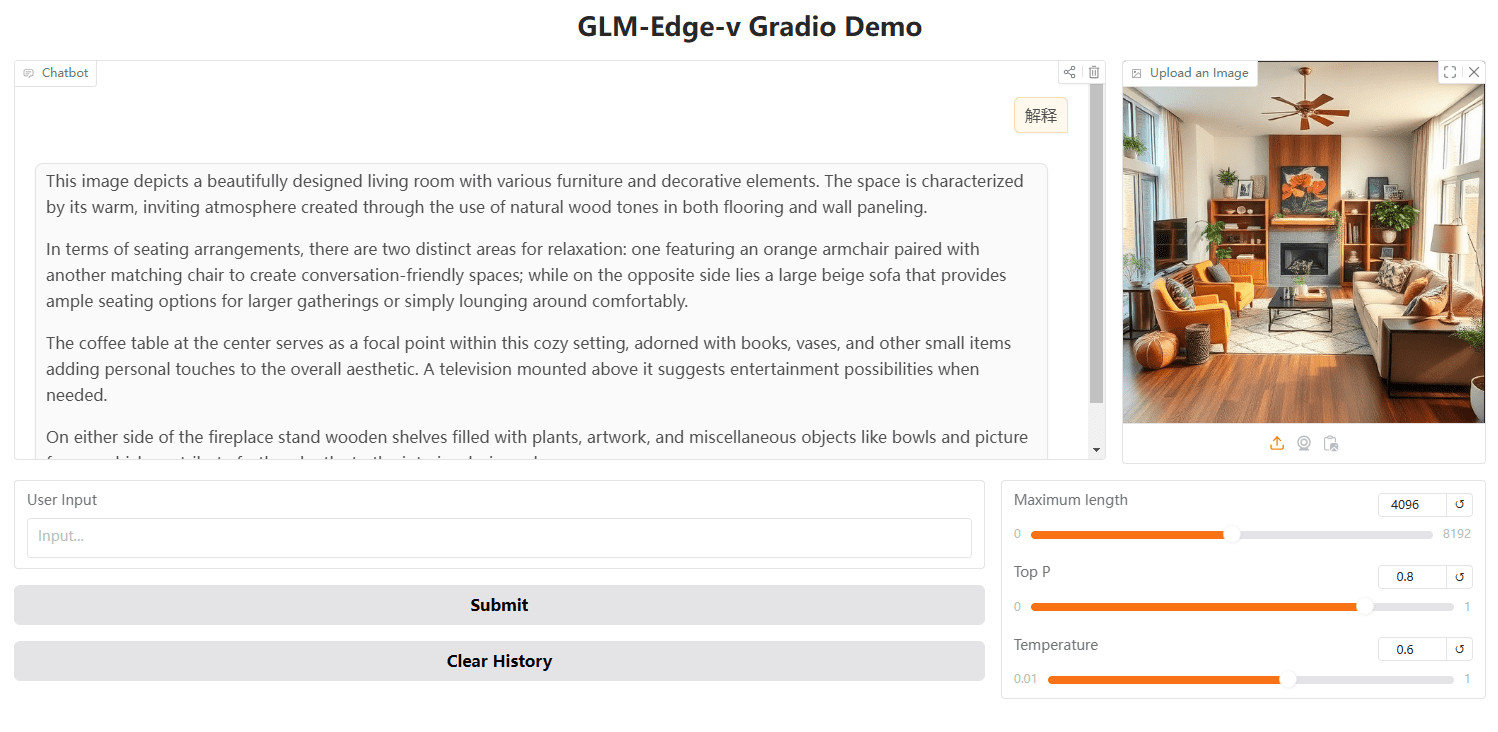

Iniciando a WebUI com o Gradio

Você também pode usar o Gradio para iniciar a WebUI:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

Raciocínio com a API OpenAI

importar openai

client = openai.Client(api_key="your_api_key", base_url="http://:/v1")

output = client.chat.completions.create(

model="glm-edge-v",

messages=[

{"role": "image_url", "image_url": {"url": "img.png"}}

],

max_tokens=512,

temperature=0.7

)

print(output)