Introdução geral

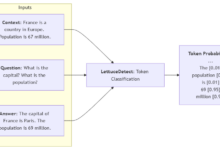

O Vision Parse é uma ferramenta revolucionária de processamento de documentos que combina de forma inteligente a tecnologia de modelagem de linguagem visual (Vision Language Models) de última geração para converter de forma inteligente documentos PDF em conteúdo de alta qualidade no formato Markdown. A ferramenta é compatível com vários dos principais modelos de linguagem visual, incluindo OpenAI, LLama e Google Gemini, etc., e pode extrair com precisão o texto e as tabelas do documento, além de manter a estrutura hierárquica do documento original, o estilo e o recuo. O Vision Parse não só é compatível com o processamento de PDFs de várias páginas, como também oferece opções de implantação de modelos locais, para que os usuários possam estar ao mesmo tempo e garantir a segurança do documento. processamento off-line. Seu design simples de API permite que os desenvolvedores realizem tarefas complexas de conversão de documentos com apenas algumas linhas de código, aumentando consideravelmente a eficiência e a precisão do processamento de documentos.

Lista de funções

- Extração inteligente de conteúdo: use modelos avançados de linguagem visual para reconhecer e extrair com precisão o conteúdo de textos e tabelas

- Integridade de formatação: mantém a formatação completa da estrutura hierárquica, do estilo e do recuo do documento

- Suporte a vários modelos: compatível com OpenAI, LLama, Gemini e outros provedores de modelos de linguagem visual

- Processamento de PDF com várias páginas: o suporte a documentos PDF com várias páginas será convertido em imagens codificadas em base64 para processamento

- Implementação de modelo local: a Ollama suporta a implementação de modelo local para segurança de documentos e uso off-line.

- Configuração personalizada: suporta parâmetros personalizados de processamento de PDF, como DPI, espaço de cores, etc.

- API flexível: fornece uma interface de API Python simples e intuitiva

Usando a Ajuda

1. preparação para a instalação

Requisitos básicos:

- Python 3.9 ou superior

- Para usar o modelo local, você precisa instalar o Ollama.

- A chave de API apropriada é necessária para usar o OpenAI ou o Google Gemini

Etapas de instalação:

- Use o pip para instalar o pacote básico:

pip install vision-parse

- Instale dependências adicionais conforme necessário:

- Suporte à OpenAI:

pip install 'vision-parse[openai]' - Suporte a Gêmeos:

pip install 'vision-parse[gêmeos]'

2. uso básico

Código de amostra:

from vision_parse import VisionParser

# Inicializar o analisador

parser = VisionParser(

nome_do_modelo="llama3.2-vision:11b", # usar modelo local

temperatura=0,4,

top_p=0,3,

extraction_complexity=False # Defina como True para obter resultados de extração mais detalhados

)

# Converter arquivo PDF

pdf_path = "seu_documento.pdf"

markdown_pages = parser.convert_pdf(pdf_path)

# Processar os resultados da conversão

for i, page_content in enumerate(markdown_pages):

print(f"\n--- Page {i+1} ---\n{page_content}")

3. configuração avançada

Configuração da página do PDF:

from vision_parse import VisionParser, PDFPageConfig

# configurar as definições de processamento de PDF

page_config = PDFPageConfig(

page_config = PDFPageConfig(

colour_space="RGB", include_annotations=True

include_annotations=True, preserve_transparency=Free

preserve_transparency=False

)

# Inicialize o analisador usando uma configuração personalizada

parser = VisionParser(

nome_do_modelo="llama3.2-vision:11b",

temperature=0.7,

top_p=0,4,

page_config=page_config

)

4. modelos de suporte

O Vision Parse oferece suporte a uma ampla variedade de modelos de linguagem visual convencionais:

- Modelos OpenAI: gpt-4o, gpt-4o-mini

- Modelos do Google Gemini: gemini-1.5-flash, gemini-2.0-flash-exp, gemini-1.5-pro

- Meta Llama e Llava (por meio de Ollama): llava:13b, llava:34b, llama3.2-vision:11b, llama3.2-vision:70b

5. técnicas de uso

- Escolha do modelo certo: escolha um modelo local ou um serviço baseado em nuvem de acordo com suas necessidades

- Ajuste de parâmetros: a criatividade e a precisão da saída são ajustadas pelos parâmetros temperatura e top_p.

- Complexidade da extração: para documentos complexos, é recomendável definir extraction_complexity=True

- Implementação local: a documentação sensível sugere o uso do Ollama para a implementação do modelo local

- Configuração de PDF: de acordo com as características do documento para ajustar o DPI, o espaço de cores e outros parâmetros