Introdução geral

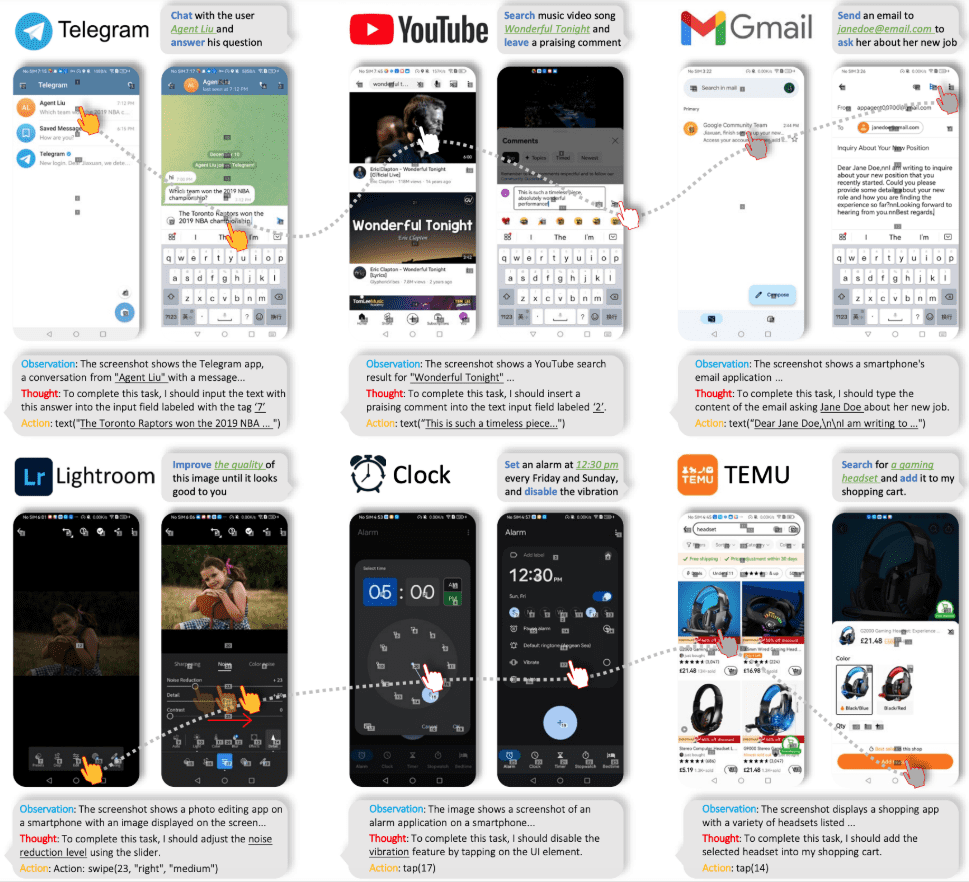

O AppAgent é uma estrutura de agente multimodal baseada no Modelo de Linguagem Ampla (LLM) projetado para operar aplicativos de smartphones. A estrutura amplia sua aplicabilidade em diferentes aplicativos por meio de um espaço de manipulação simplificado que imita as interações humanas, como toques e deslizes, eliminando assim a necessidade de acesso ao back-end do sistema. O AppAgent aprende a usar novos aplicativos explorando ou observando demonstrações humanas de forma autônoma e gera uma base de conhecimento para executar tarefas complexas.

A Tencent lançou o AppAgent, um corpo inteligente multimodal que pode operar a interface do telefone celular diretamente, reconhecendo a interface atual do telefone celular e os comandos do usuário, e pode operar o telefone celular como um usuário real! Por exemplo, ele pode operar um software de edição de fotos para editar imagens, abrir aplicativos de mapas para navegar, fazer compras e assim por diante.

Página inicial do projeto: https://appagent-official.github.io

Link para o artigo: https://arxiv.org/abs/2312.13771

resumo da dissertação

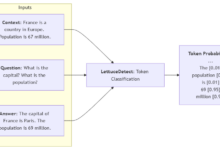

Com os recentes avanços nos modelos de linguagem grande (LLMs), foram criados corpos inteligentes que podem executar tarefas complexas. Neste artigo, apresentamos uma nova estrutura multimodal para corpos inteligentes baseada em modelos de linguagem grandes, projetada para manipular aplicativos de smartphones. Nossa estrutura permite que os corpos inteligentes manipulem aplicativos de smartphones por meio de um espaço de manipulação simplificado, de modo que seja como se um ser humano estivesse realizando operações de clicar e deslizar. Essa abordagem inovadora ignora a necessidade de acesso direto ao back-end do sistema, tornando-o adequado para uma ampla gama de aplicativos diferentes. No centro da funcionalidade de nossas inteligências está sua abordagem inovadora de aprendizado. O Intelligent Body aprende a navegar e a usar novos aplicativos por meio da autoexploração ou da observação de demonstrações humanas. No processo, ele constrói uma base de conhecimento na qual se baseia para executar tarefas complexas em diferentes aplicativos. Para demonstrar a utilidade da nossa inteligência, nós a testamos exaustivamente em 50 tarefas em 10 aplicativos diferentes, incluindo mídia social, e-mail, mapas, compras e ferramentas complexas de edição de imagens. Os resultados dos testes demonstram a capacidade eficiente da nossa inteligência de lidar com uma ampla gama de tarefas avançadas.

Lista de funções

- exploração autodirigidaAgentes: os agentes podem explorar aplicativos de forma autônoma, registrar elementos interativos e gerar documentação.

- Aprendizagem de demonstração humanaO agente aprende a tarefa observando uma demonstração humana e gera a documentação apropriada.

- implementação do mandatoDurante a fase de implantação, o agente executa tarefas complexas com base nos documentos gerados.

- Entradas multimodaisSuporte a entradas textuais e visuais, usando os modelos GPT-4V ou Qwen-VL-Max.

- Processamento de CAPTCHAPode ser autenticado por CAPTCHA.

- Reconhecimento de elementos da interface do usuárioUse sobreposições de grade para posicionar elementos de IU não marcados.

Usando a Ajuda

Instalação e configuração

- Download e instalaçãoFaça o download dos arquivos do projeto na página do GitHub e instale as dependências necessárias.

- arquivo de configuraçãoModificar o diretório raiz do

config.yamlpara configurar a chave de API para o modelo GPT-4V ou Qwen-VL-Max. - dispositivo conectadoConecte seu dispositivo Android usando USB e ative a depuração USB em Opções do desenvolvedor.

Modelo de exploração autônoma

- lançar uma exploração: Executar

aprender.pyselecione Autonomous Exploration Mode (Modo de exploração autônoma) e digite o nome do aplicativo e a descrição da tarefa. - Registre as interaçõesO agente explorará automaticamente o aplicativo, registrará os elementos de interação e gerará a documentação.

Modo de demonstração humana

- Demonstração de inicialização: Executar

aprender.pyselecione Human Demo Mode e digite o nome do aplicativo e a descrição da tarefa. - Demonstração executivaSiga as instruções e o agente registrará todas as interações e gerará a documentação.

implementação do mandato

- Iniciar tarefas: Executar

run.pydigite o nome do aplicativo e a descrição da tarefa e selecione a biblioteca de documentos apropriada. - operarAgente: O agente executará tarefas para concluir operações complexas com base na documentação.

Procedimento de operação detalhado

- Download do projetoVisite a página do GitHub, baixe os arquivos do projeto e extraia-os.

- Instalação de dependênciasExecutar em um terminal

pip install -r requirements.txtInstale todas as dependências. - modelo de configuraçãoModificar conforme necessário

config.yamlpara configurar a chave de API para o modelo GPT-4V ou Qwen-VL-Max. - dispositivo conectadoConecte seu dispositivo Android usando USB e ative o modo de depuração USB no dispositivo.

- Iniciar uma exploração ou demonstração: Executar

aprender.pyselecione o modo Autonomous Exploration (Exploração Autônoma) ou Human Demonstration (Demonstração Humana) e digite o nome do aplicativo e a descrição da tarefa. - Gerar documentaçãoO agente registrará todas as interações e gerará documentação para a execução subsequente da tarefa.

- operar: Executar

run.pyinsira o nome do aplicativo e a descrição da tarefa, selecione a biblioteca de documentos apropriada e o agente executará a tarefa com base no documento.