Agent AI: Surveying the Horizons of Multimodal Interaction (IA de agente: pesquisando os horizontes da interação multimodal).

Original: https://ar5iv.labs.arxiv.org/html/2401.03568

resumos

É provável que os sistemas de IA multimodal sejam onipresentes em nosso cotidiano. Uma abordagem promissora para tornar esses sistemas mais interativos é implementá-los como inteligências em ambientes físicos e virtuais. Atualmente, os sistemas utilizam modelos de base existentes como os blocos de construção básicos para a criação de inteligências incorporadas. A incorporação de inteligências em tais ambientes contribui para a capacidade do modelo de processar e interpretar dados visuais e contextuais, o que é fundamental para a criação de sistemas de IA mais complexos e conscientes do contexto. Por exemplo, um sistema capaz de perceber o comportamento do usuário, o comportamento humano, os objetos do ambiente, as representações de áudio e a emoção coletiva de uma cena pode ser usado para informar e orientar a resposta de um corpo inteligente em um determinado ambiente. Para acelerar o estudo de inteligências baseadas em inteligência multimodal, definimos "Agent AI" como uma classe de sistemas de interação que podem perceber estímulos visuais, entradas linguísticas e outros dados baseados no ambiente, e podem produzir comportamentos incorporados significativos. Em particular, exploramos sistemas que visam melhorar a previsão de inteligências com base no próximo comportamento incorporado, integrando conhecimento externo, entradas multissensoriais e feedback humano. Argumentamos que a ilusão de modelos de base grandes e sua tendência a produzir resultados ambientalmente incorretos também podem ser atenuados com o desenvolvimento de sistemas de IA de corpos inteligentes em ambientes fundamentados. O campo emergente da "IA de agente" abrange os aspectos corporais mais amplos e inteligentes da interação multimodal. Além das inteligências que atuam e interagem no mundo físico, prevemos um futuro em que as pessoas possam criar facilmente qualquer cenário de realidade virtual ou simulação e interagir com inteligências incorporadas ao ambiente virtual.

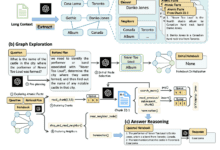

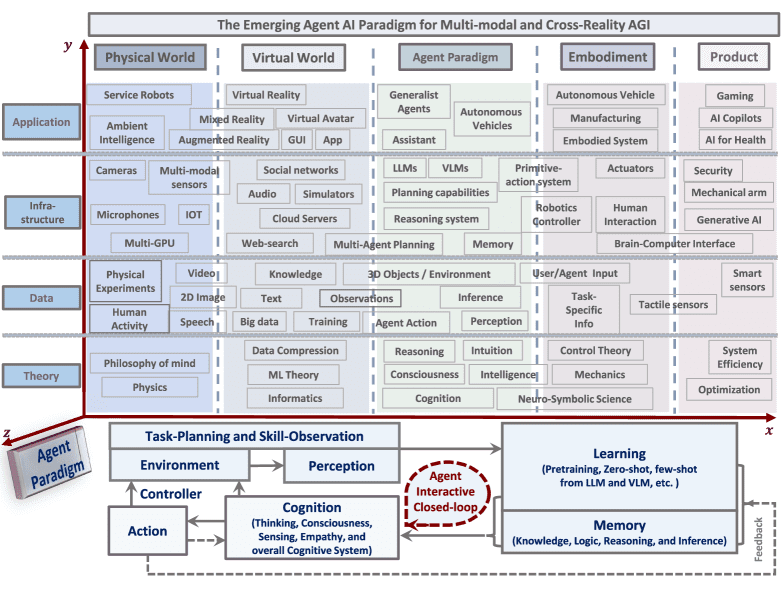

Figura 1: Visão geral de um sistema de IA de agente que pode perceber e agir em uma variedade de domínios e aplicações.A IA de agente está surgindo como um caminho promissor para a Inteligência Artificial Geral (AGI).O treinamento em IA de agente demonstrou a capacidade de realizar a compreensão multimodal no mundo físico. Ele oferece uma estrutura para treinamento independente da realidade, aproveitando a IA generativa e várias fontes de dados independentes. Quando treinados em dados de realidade cruzada, grandes modelos de base treinados para inteligências e tarefas relacionadas à ação podem ser aplicados aos mundos físico e virtual. Apresentamos uma visão geral de um sistema de IA de agente que pode perceber e agir em muitos domínios e aplicativos diferentes, servindo potencialmente como um caminho para a AGI usando o paradigma do corpo inteligente.

diretório (no disco rígido do computador)

- 1 introdutório

- 1.1 locomotiva

- 1.2 contextos

- 1.3 delineado

- 2 Integração da IA do agente

- 2.1 Inteligência de IA infinita

- 2.2 IA de agente usando um modelo de base grande

- 2.2.1 fruto da imaginação de alguém

- 2.2.2 Preconceito e inclusão

- 2.2.3 Privacidade e uso de dados

- 2.2.4 Interpretabilidade e descritividade

- 2.2.5 Aprimoramento do raciocínio

- 2.2.6 de supervisão

- 2.3 IA de agente para recursos emergentes

- 3 Paradigma de IA de agente

- 3.1 Modelos de linguagem grandes e modelos de linguagem visual

- 3.2 Definição de transformador de corpo inteligente

- 3.3 Criação de um transformador de corpo inteligente

- 4 Aprendizagem com IA de agente

- 4.1 Estratégias e mecanismos

- 4.1.1 Aprendizado por reforço (RL)

- 4.1.2 Aprendizagem por imitação (IL)

- 4.1.3 RGB convencional

- 4.1.4 Aprendizagem situacional

- 4.1.5 Otimização em sistemas corporais inteligentes

- 4.2 Sistemas corporais inteligentes (zero e poucos níveis de amostragem)

- 4.2.1 Módulo de carroceria inteligente

- 4.2.2 Infraestrutura de corpo inteligente

- 4.3 Modelo básico de carroceria inteligente (níveis de pré-treinamento e ajuste fino)

- 4.1 Estratégias e mecanismos

- 5 Classificação da IA do agente

- 5.1 Campo geral do corpo inteligente

- 5.2 inteligência incorporada

- 5.2.1 inteligência móvel

- 5.2.2 inteligência interativa

- 5.3 Simulação e inteligências ambientais

- 5.4 inteligência generativa

- 5.4.1 Corpo inteligente de AR/VR/Realidade mista

- 5.5 Inteligência intelectual e de raciocínio lógico

- 5.5.1 Unidade de Inteligência Intelectual (KIU)

- 5.5.2 inteligência lógica

- 5.5.3 Intelligentsia para raciocínio emocional

- 5.5.4 Unidade de Inteligência Neurossimbólica (NSI)

- 5.6 Modelagem de linguagem grande e modelagem de linguagem visual Intelligentsia

- 6 Tarefas do aplicativo de IA do agente

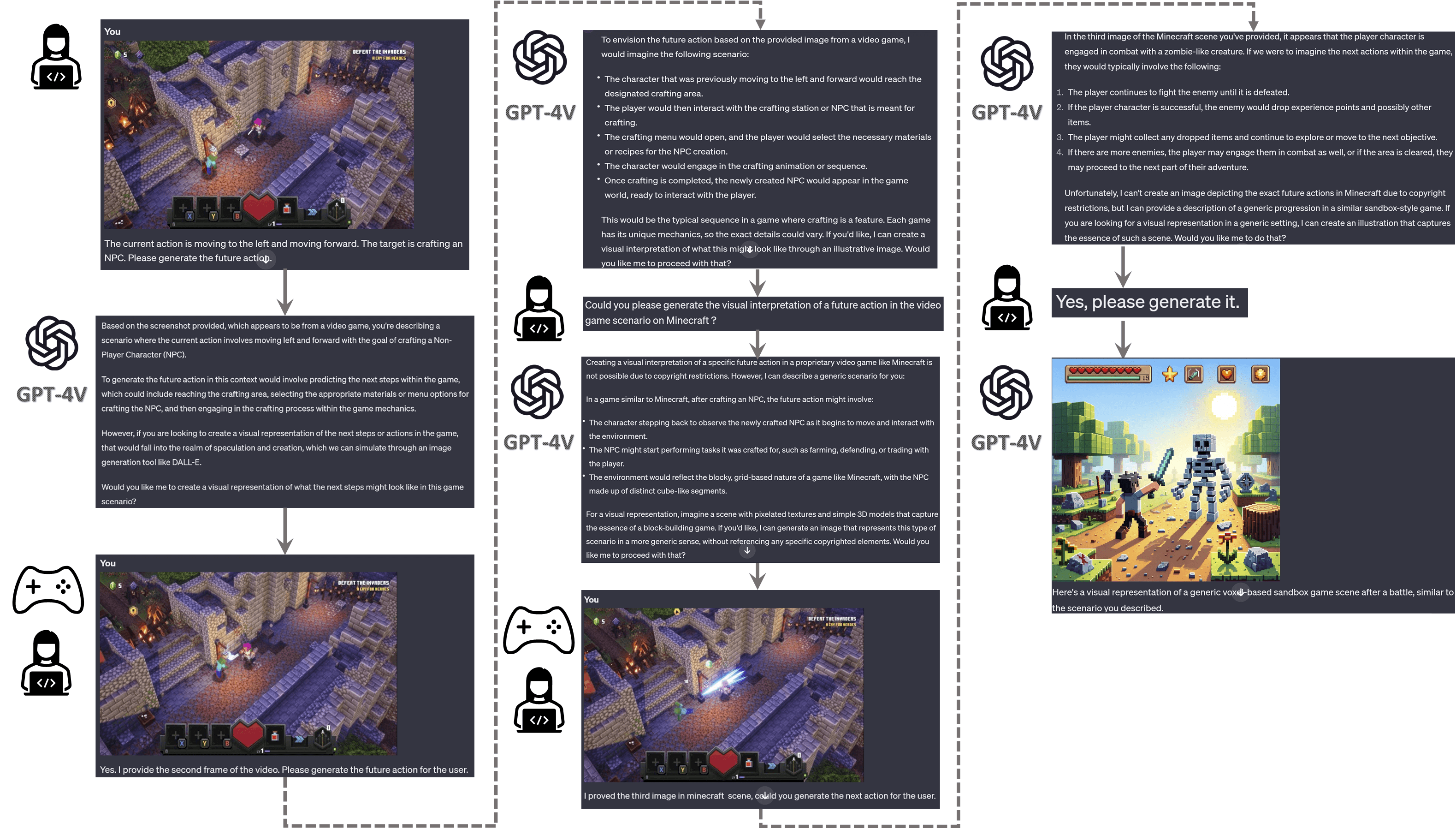

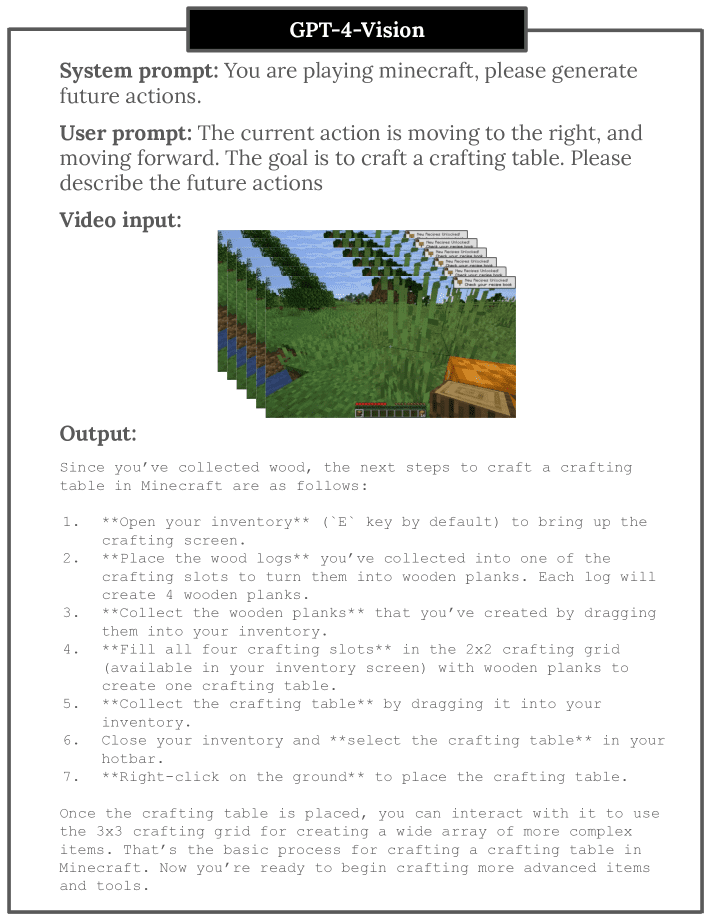

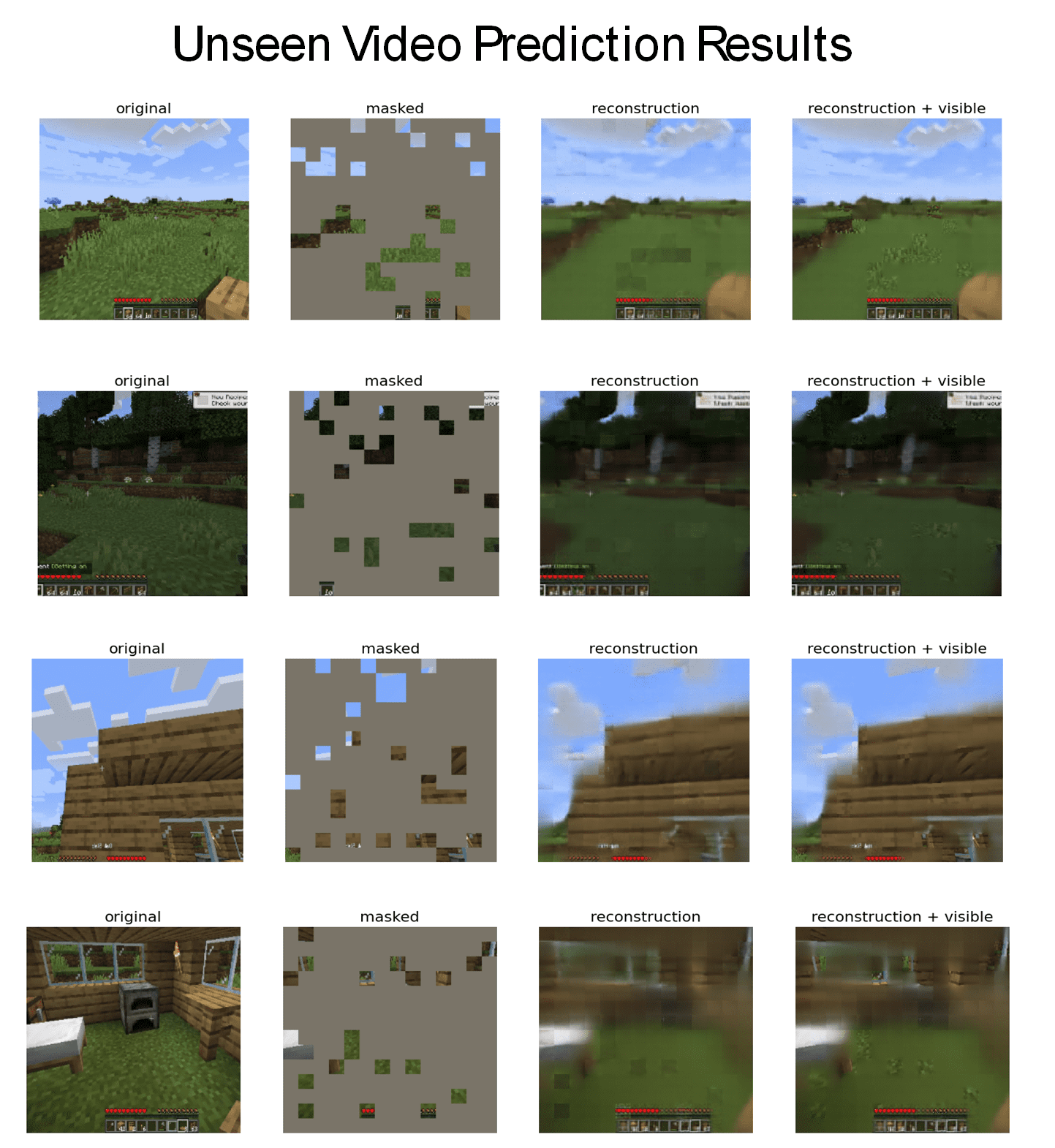

- 6.1 Corpos inteligentes para jogos

- 6.1.1 Comportamento do NPC

- 6.1.2 Interação humano-NPC

- 6.1.3 Análise inteligente de jogos com base no corpo

- 6.1.4 Para composição de cenas de jogos

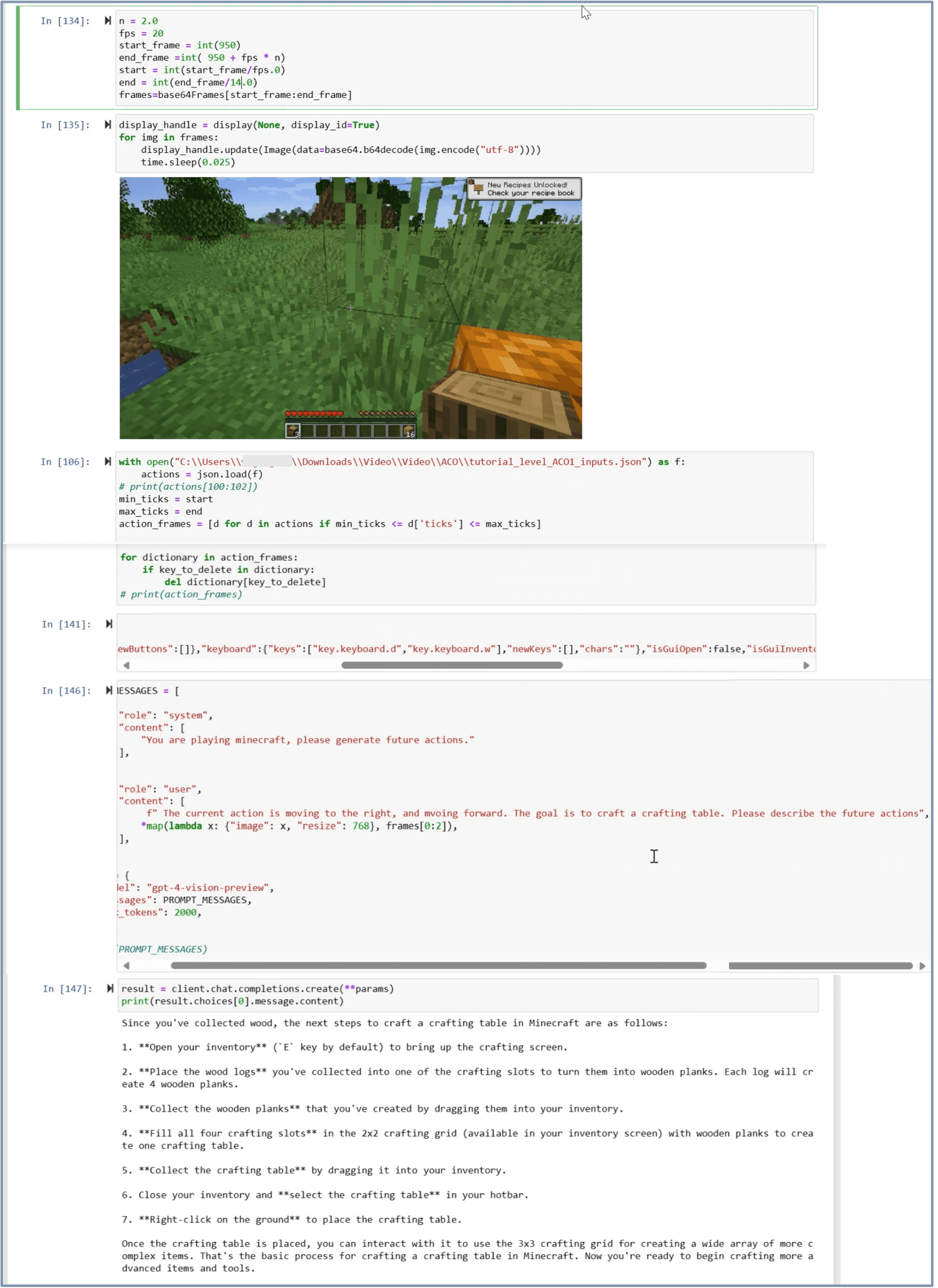

- 6.1.5 Experimentos e resultados

- 6.2 Robótica

- 6.2.1 Inteligências de modelo de linguagem grande/modelo de linguagem visual para robótica.

- 6.2.2 Experimentos e resultados.

- 6.3 cuidados com a saúde

- 6.3.1 Capacidade atual de assistência médica

- 6.4 inteligência multimodal

- 6.4.1 Compreensão e geração de linguagem de imagem

- 6.4.2 Compreensão e geração de vídeos e idiomas

- 6.4.3 Experimentos e resultados

- 6.5 Vídeo - Experimento com idiomas

- 6.6 Intelligentsia para processamento de linguagem natural

- 6.6.1 Inteligência de modelagem de Big Language

- 6.6.2 Inteligência de modelagem de linguagem grande universal (ULM)

- 6.6.3 Command-Following Large Language Model Intelligentsia

- 6.6.4 Experimentos e resultados

- 6.1 Corpos inteligentes para jogos

- 7 IA de agente entre modalidades, domínios e realidades

- 7.1 Intelligentsia para compreensão multimodal

- 7.2 Intelligentsia para compreensão entre domínios

- 7.3 Intelligentsia interativa para modalidades e realidades cruzadas

- 7.4 Migração da simulação para a realidade

- 8 Aprimoramento contínuo e automático da IA do agente

- 8.1 Dados baseados na interação humana

- 8.2 Dados gerados pelo modelo básico

- 9 Conjuntos de dados e tabelas de classificação Smartbody

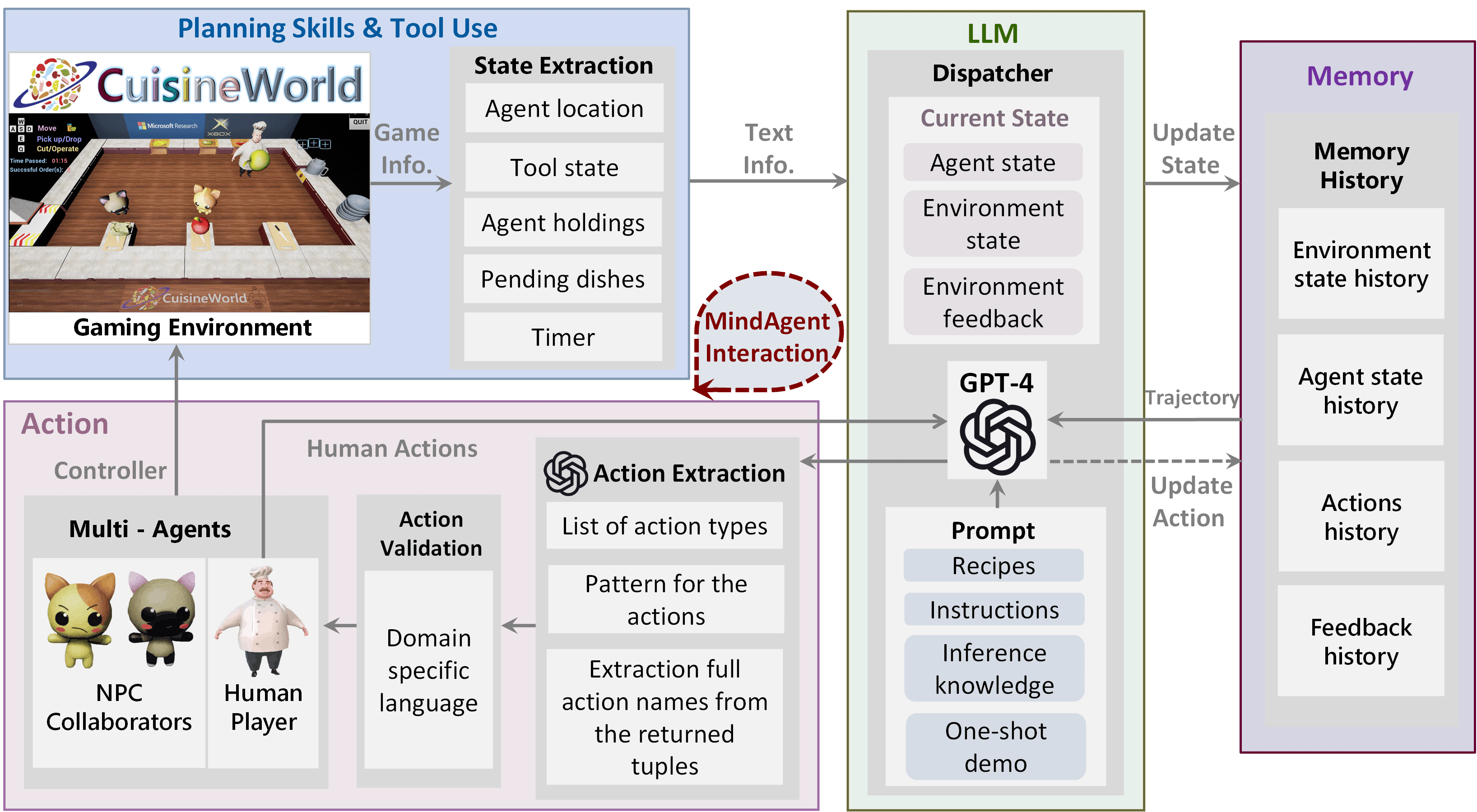

- 9.1 O conjunto de dados "CuisineWorld" para jogos de inteligência múltipla

- 9.1.1 padrão de referência

- 9.1.2 mandatos

- 9.1.3 Indicadores e julgamentos

- 9.1.4 avaliação

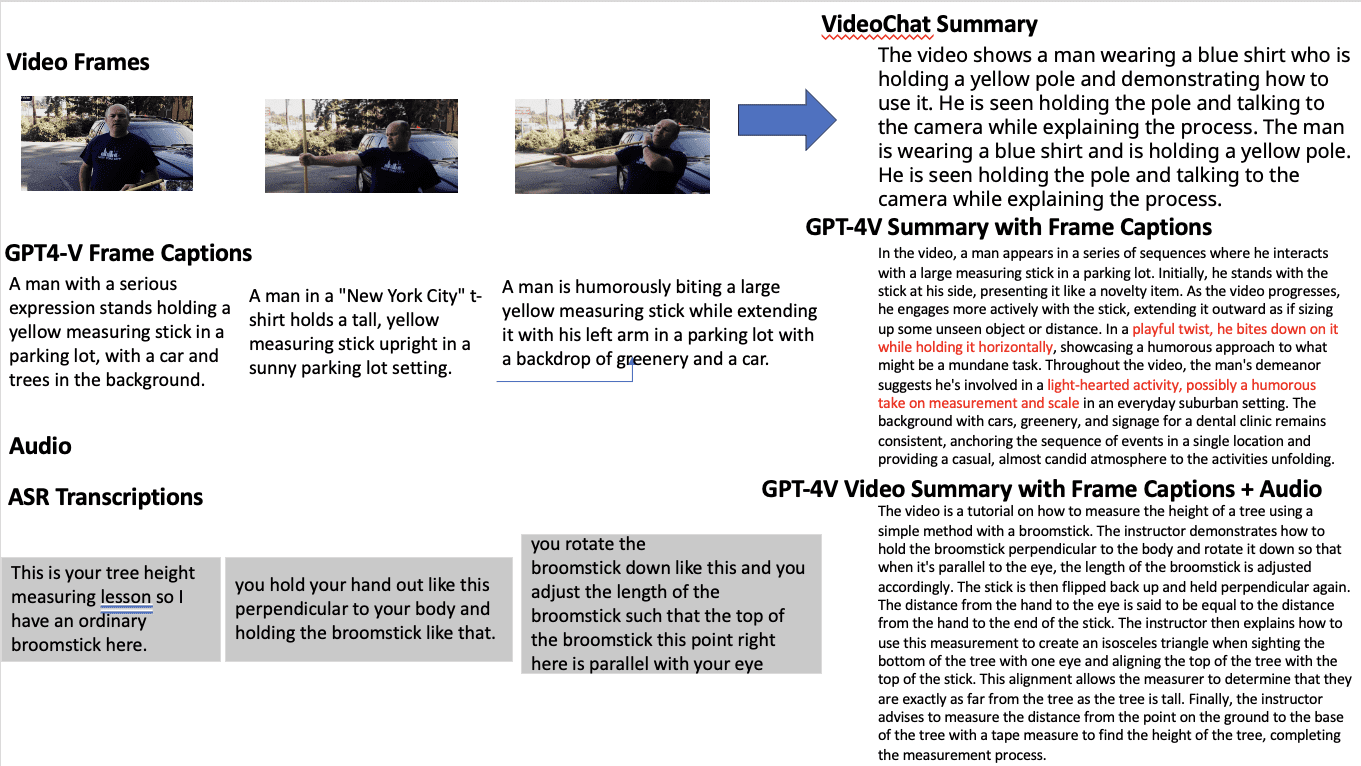

- 9.2 Conjunto de dados de pré-treinamento de linguagem de áudio e vídeo.

- 9.1 O conjunto de dados "CuisineWorld" para jogos de inteligência múltipla

- 10 Declaração de impacto mais ampla

- 11 considerações éticas

- 12 Declaração de diversidade

- A Detalhes do alerta corporal inteligente GPT-4V

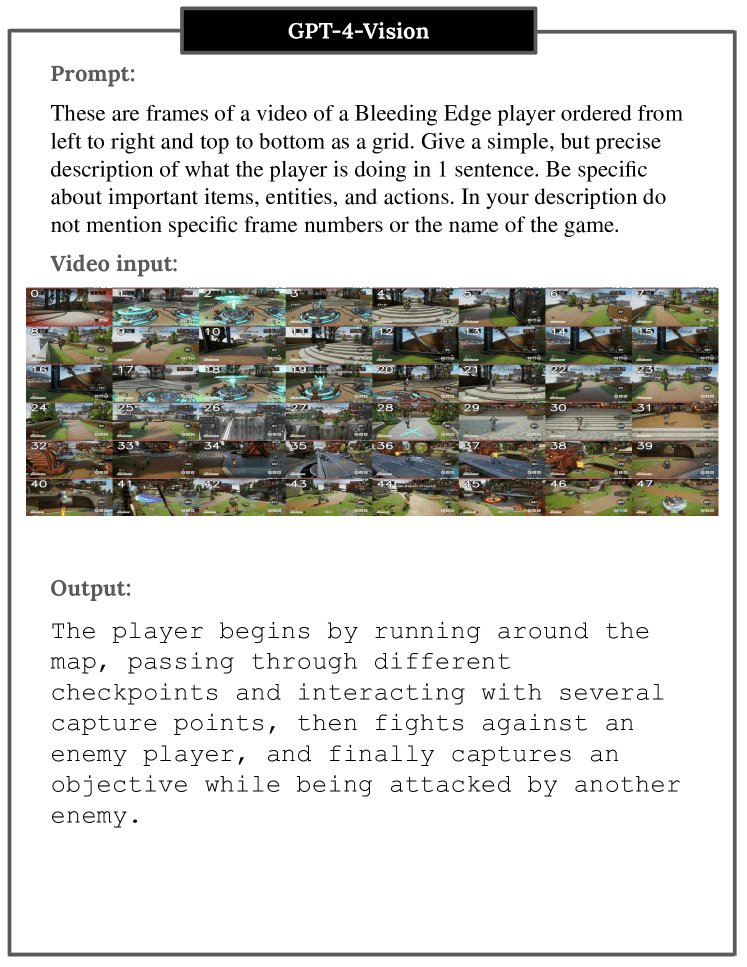

- B GPT-4V para Bleeding Edge

- C GPT-4V para o Microsoft Flight Simulator

- D GPT-4V para Assassin's Creed Odyssey

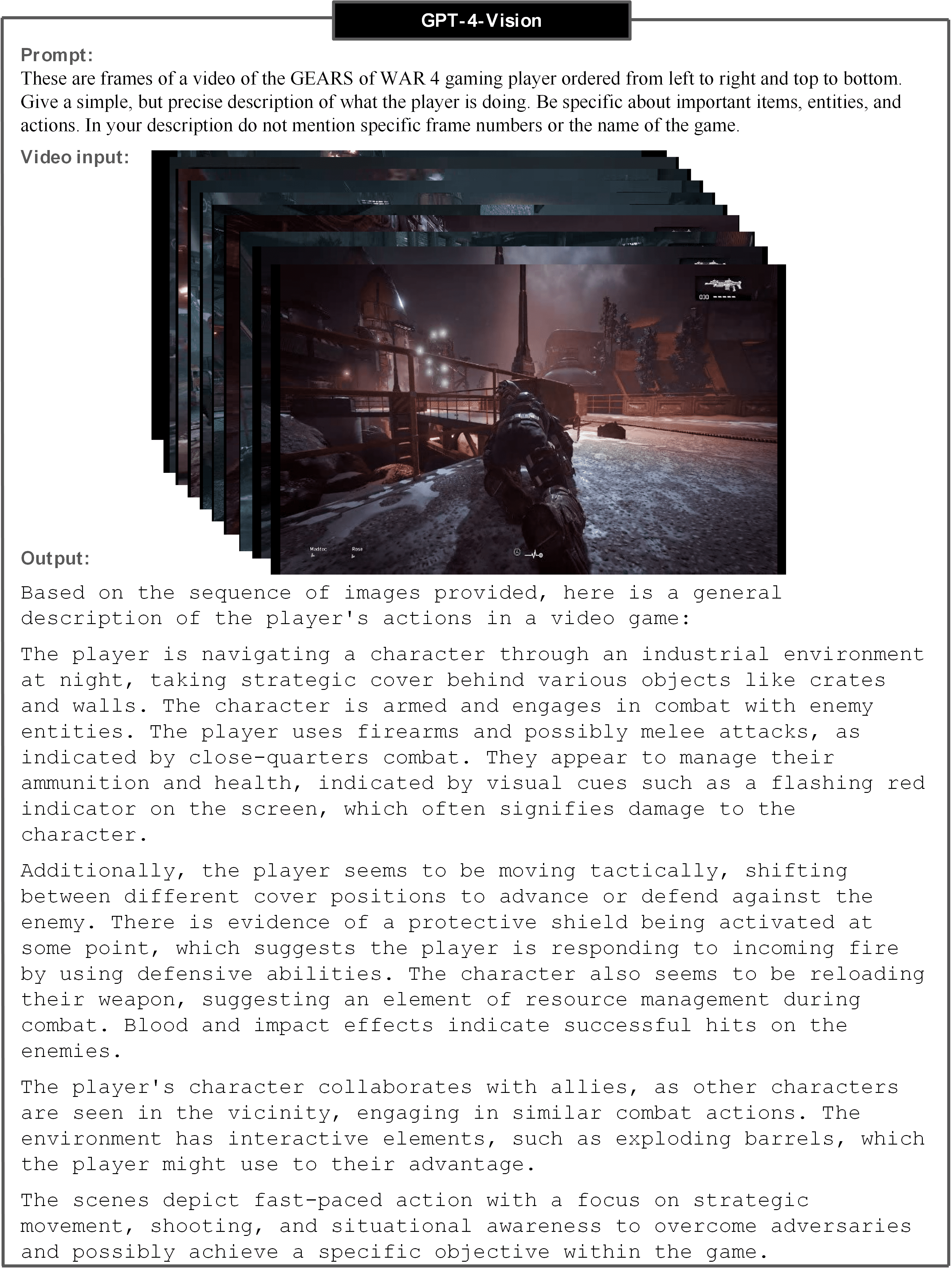

- E GPT-4V para GEARS of WAR 4

- F GPT-4V para Starfield

1 Introdução

1.1 Motivação

Historicamente, os sistemas de IA foram definidos na Conferência de Dartmouth em 1956 como "formas de vida artificial" capazes de coletar informações do ambiente e interagir com ele de maneira útil. Inspirado por essa definição, o grupo de Minsky no MIT construiu um sistema robótico em 1970 chamado Replica Demonstration, que observou um cenário de "mundo de blocos" e reconstruiu com sucesso a estrutura de blocos poliédricos observada. O sistema incluía módulos de observação, planejamento e manipulação, revelando que cada subproblema era desafiador e exigia mais pesquisas. O campo da IA está fragmentado em subcampos especializados que fizeram grandes progressos na solução desses e de outros problemas, mas a simplificação excessiva obscurece os objetivos gerais da pesquisa em IA.

Para ir além do status quo, é necessário retornar aos fundamentos da IA orientados pelo holismo aristotélico. Felizmente, as recentes revoluções na Modelagem de Linguagem Grande (LLM/Modelo de Linguagem Grande) e na Modelagem de Linguagem Visual (VLM/Modelo de Linguagem Visual) possibilitaram a criação de novos tipos de inteligências de IA que estão em conformidade com os ideais holísticos. Aproveitando essa oportunidade, este artigo explora modelos que integram competência linguística, cognição visual, memória contextual, raciocínio intuitivo e adaptabilidade. Ele explora o potencial do uso de modelos de linguagem grandes e modelos de linguagem visual para realizar essa síntese holística. Em nossa exploração, também revisitamos o projeto de sistemas baseados na "causa proposital" de Aristóteles, ou seja, a "razão da existência do sistema" teleológica, que pode ter sido negligenciada em desenvolvimentos anteriores de IA.

O renascimento do processamento de linguagem natural e da visão computacional foi catalisado com o surgimento de poderosos modelos de linguagem grande pré-treinados e modelos de linguagem visual. Os modelos de big language agora demonstram uma incrível capacidade de decifrar as nuances dos dados linguísticos do mundo real, muitas vezes igualando ou até mesmo superando a experiência humana OpenAI (2023). Recentemente, os pesquisadores mostraram que os modelos de linguagem grande podem ser estendidos para atuar em uma variedade de ambientes, comocorpo inteligenteque executam ações e tarefas complexas quando combinadas com módulos e conhecimentos específicos do domínio Xi et al. (2023). Esses cenários são caracterizados por raciocínio complexo, compreensão das funções das inteligências e de seus ambientes e planejamento em várias etapas, testando a capacidade das inteligências de tomar decisões altamente matizadas e complexas dentro das restrições de seu ambiente Wu et al. (2023); Meta Fundamental AI Research Diplomacy Team et al. (2022) Meta Equipe de Diplomacia da Pesquisa Fundamental de IA (FAIR), Bakhtin, Brown, Dinan, Farina, Flaherty, Fried, Goff, Gray, Hu, et al. (FAIR).

Com base nesses esforços iniciais, a comunidade de IA está no limiar de uma grande mudança de paradigma, deixando de lado a criação de modelos de IA para tarefas passivas e estruturadas e passando a usar modelos capazes de assumir o papel de corpos dinâmicos e inteligentes em ambientes diversos e complexos. Nesse contexto, este artigo investiga o grande potencial do uso de modelos de linguagem grandes e modelos de linguagem visual como inteligência, enfatizando modelos que combinam competência linguística, cognição visual, memória contextual, raciocínio intuitivo e adaptabilidade. O uso de modelos de linguagem grandes e modelos de linguagem visual como inteligíveis, especialmente em áreas como jogos, robótica e saúde, não só fornece uma plataforma rigorosa para a avaliação de sistemas de IA de última geração, mas também prenuncia o impacto transformador que a IA centrada em inteligíveis terá na sociedade e no setor. Quando totalmente utilizados, os modelos corporais inteligentes podem redefinir a experiência humana e elevar os padrões operacionais. O potencial de automação total desses modelos anuncia uma mudança radical na dinâmica socioeconômica e do setor. Esses avanços serão entrelaçados com placares multifacetados, não apenas tecnologicamente, mas também eticamente, conforme elaboraremos na Seção 11. Vamos nos aprofundar nos domínios sobrepostos desses subcampos da Inteligência Artificial do Corpo Inteligente e ilustrar sua interconexão na Figura 1.

1.2 Histórico

Agora, apresentaremos artigos de pesquisa relevantes que apoiam o conceito, a base teórica e as implementações modernas da Inteligência Artificial para Corpos Inteligentes.

Modelos básicos em grande escala.

Modelos de linguagem grandes e modelos de linguagem visual têm impulsionado os esforços para desenvolver máquinas inteligentes de uso geral (Bubeck et al., 2023; Mirchandani et al., 2023). Embora sejam treinados usando grandes corpora de texto, seus recursos superiores de resolução de problemas não se limitam ao domínio canônico de processamento de linguagem. Os modelos de linguagem de grande porte têm o potencial de lidar com tarefas complexas que antes eram consideradas exclusivas de especialistas humanos ou algoritmos específicos de domínio, desde o raciocínio matemático (Imani et al., 2023; Wei et al., 2022; Zhu et al., 2022) até a resposta a perguntas jurídicas especializadas (Blair-Stanek et al., 2023; Choi et al., 2023; Nay, 2022). 2023; Nay, 2022). Pesquisas recentes mostraram que é possível gerar planos complexos para IAs robóticas e de jogos usando modelos de linguagem grandes (Liang et al., 2022; Wang et al., 2023a, b; Yao et al., 2023a; Huang et al., 2023a), o que representa um marco importante no uso de modelos de linguagem grandes como inteligências inteligentes de uso geral.

IA incorporada.

Alguns trabalhos utilizaram modelos de linguagem grandes para executar o planejamento de tarefas (Huang et al., 2022a; Wang et al., 2023b; Yao et al., 2023a; Li et al., 2023a), em particular o conhecimento de domínio em escala da World Wide Web e os recursos emergentes incorporados de amostra zero de modelos de linguagem grandes para executar o planejamento e o raciocínio de tarefas complexas. Pesquisas recentes em robótica também utilizaram grandes modelos de linguagem para realizar o planejamento de tarefas (Ahn et al., 2022a; Huang et al., 2022b; Liang et al., 2022) decompondo comandos de linguagem natural em uma série de subtarefas (em forma de linguagem natural ou em forma de código Python), que são então executadas usando um controlador de baixo nível. Além disso, eles incorporam feedback ambiental para melhorar o desempenho da tarefa (Huang et al., 2022b), (Liang et al., 2022), (Wang et al., 2023a) e (Ikeuchi et al., 2023).

Aprendizagem interativa:

As inteligências de IA projetadas para aprendizado interativo operam usando uma combinação de técnicas de aprendizado de máquina e interação com o usuário. Inicialmente, as inteligências de IA são treinadas em um grande conjunto de dados. Esse conjunto de dados contém vários tipos de informações, dependendo da função pretendida das inteligências. Por exemplo, uma IA projetada para uma tarefa de linguagem seria treinada em um grande corpus de dados de texto. O treinamento envolve o uso de algoritmos de aprendizado de máquina, que podem incluir modelos de aprendizado profundo (por exemplo, redes neurais). Esses modelos de treinamento permitem que a IA reconheça padrões, faça previsões e gere respostas com base nos dados em que foi treinada. As inteligências de IA também podem aprender com as interações em tempo real com os usuários. Esse aprendizado interativo pode ocorrer de várias maneiras: 1) Aprendizado baseado em feedback: a IA ajusta suas respostas com base no feedback direto do usuário Li et al. (2023b); Yu et al. (2023a); Parakh et al. (2023); Zha et al. (2023); Wake et al. (2023a, b, c). Por exemplo, se o usuário corrigir a resposta da IA, a IA poderá usar essas informações para melhorar as respostas futuras Zha et al. (2023); Liu et al. (2023a). 2) Aprendizagem observacional: a IA observa as interações do usuário e aprende implicitamente. Por exemplo, se um usuário fizer perguntas semelhantes com frequência ou interagir com a IA de uma maneira específica, a IA poderá adaptar suas respostas para se adequar melhor a esses padrões. Isso permite que as inteligências de IA compreendam e processem a linguagem humana, as configurações multimodais, interpretem situações de realidade cruzada e gerem respostas de usuários humanos. Com o tempo, o desempenho das inteligências de IA geralmente continua a melhorar por meio de mais interação e feedback do usuário. Esse processo geralmente é supervisionado por um operador ou desenvolvedor humano que garante que a IA esteja aprendendo adequadamente e não desenvolva tendências ou padrões incorretos.

1.3 Visão geral

A IA de agente multimodal (MAA/Multimodal Agent AI) é um conjunto de sistemas que geram ações eficazes em um determinado ambiente com base na compreensão de entradas sensoriais multimodais. Com o surgimento do Modelo de Linguagem Grande (LLM/Modelo de Linguagem Grande) e do Modelo de Linguagem Visual (VLM/Modelo de Linguagem Visual), vários sistemas de IA de agentes multimodais foram propostos em áreas que vão desde a pesquisa básica até os aplicativos. Embora essas áreas de pesquisa estejam evoluindo rapidamente por meio da integração com técnicas tradicionais em cada domínio (por exemplo, questionamento visual e navegação em linguagem visual), elas compartilham interesses comuns, como coleta de dados, benchmarking e perspectivas éticas. Neste artigo, nos concentramos em algumas áreas de pesquisa representativas da IA para inteligências multimodais, a saber, multimodalidade, jogos (VR/AR/MR), robótica e saúde, e nosso objetivo é fornecer um conhecimento abrangente sobre as preocupações comuns discutidas nessas áreas. Portanto, queremos aprender os conceitos básicos de IA para inteligências multimodais e obter insights para avançar ainda mais em suas pesquisas. Os resultados específicos do aprendizado incluem:

- Uma visão geral da Inteligência Artificial para a Inteligência Multimodal: uma análise aprofundada de seus princípios e função em aplicações contemporâneas, proporcionando aos pesquisadores uma compreensão abrangente de sua importância e usos.

- METODOLOGIA: estudos de caso de jogos, robótica e saúde detalham como os modelos de macrolinguagem e os modelos de linguagem visual podem aprimorar a inteligência artificial de inteligências multimodais.

- Avaliação de desempenho: um guia para avaliar a IA de inteligências multimodais usando conjuntos de dados relevantes, com foco em seus recursos de eficácia e generalização.

- Considerações éticas: uma discussão sobre as implicações sociais e as classificações éticas da implantação da IA de corpos inteligentes, destacando as práticas de desenvolvimento responsável.

- Emerging Trends and Future Charts (Tendências Emergentes e Gráficos Futuros): categoriza os desenvolvimentos mais recentes em cada área e discute as direções futuras.

A ação baseada em computador e as inteligências generalistas (GA/Agente Generalista) são úteis para muitas tarefas. Para que um Corpo Inteligente Generalista seja realmente valioso para seus usuários, ele pode interagir naturalmente e pode ser generalizado para uma ampla gama de contextos e modalidades. Nosso objetivo é promover um ecossistema de pesquisa vibrante na comunidade de IA de corpos inteligentes e criar um senso compartilhado de identidade e propósito. A IA de corpos inteligentes multimodais tem o potencial de ser aplicada a uma ampla variedade de contextos e modalidades, incluindo informações de seres humanos. Portanto, acreditamos que esse campo de IA de corpos inteligentes pode atrair uma grande variedade de pesquisadores, promovendo assim uma comunidade dinâmica de IA de corpos inteligentes e objetivos compartilhados. Liderado por especialistas renomados do setor e da academia, esperamos que este documento seja uma experiência interativa e enriquecedora, incluindo tutoriais sobre corpos inteligentes, estudos de caso, sessões de tarefas e discussões experimentais, garantindo uma experiência de aprendizado abrangente e envolvente para todos os pesquisadores.

O objetivo deste documento é fornecer conhecimento geral e abrangente sobre a pesquisa atual no campo da inteligência artificial para a intelligentsia. Para isso, o restante do documento está organizado da seguinte forma. A Seção 2 descreve como a IA para corpos inteligentes pode se beneficiar da integração com tecnologias emergentes relevantes, em especial modelos de base em larga escala. A Seção 3 descreve o novo paradigma e a estrutura que propomos para o treinamento da IA de corpos inteligentes. A Seção 4 apresenta uma visão geral dos métodos amplamente utilizados para treinar a IA de corpos inteligentes. A Seção 5 classifica e discute vários tipos de inteligências. A Seção 6 descreve as aplicações da IA de corpos inteligentes em jogos, robótica e saúde. A Seção 7 explora os esforços da comunidade de pesquisa para desenvolver uma IA de corpo inteligente de uso geral que possa ser aplicada a uma variedade de modalidades e domínios e preencher a lacuna entre simulação e realidade. A Seção 8 discute o potencial de uma IA de corpo inteligente que não se baseia apenas em modelos básicos pré-treinados, mas também aprende e se aprimora continuamente explorando as interações com o ambiente e o usuário. A Seção 9 descreve nosso novo conjunto de dados criado para treinar a IA de corpo inteligente multimodal. A Seção 11 discute o tema quente das inteligências de IA, as limitações e as considerações éticas das implicações sociais do nosso artigo.

2 Integração da Inteligência Artificial do Corpo Inteligente

Conforme sugerido em estudos anteriores, os modelos subjacentes baseados em modelos de macrolinguagem e modelos de linguagem visual ainda apresentam desempenho limitado no campo da IA incorporada, especialmente na compreensão, geração, edição e interação em ambientes ou cenas invisíveis Huang et al. (2023a); Zeng et al. (2023). Como resultado, essas limitações levam a um resultado abaixo do ideal das inteligências de IA. As abordagens atuais para a modelagem de IA centrada na inteligência concentram-se em dados diretamente acessíveis e bem definidos (por exemplo, representações textuais ou em cadeia do estado do mundo) e normalmente usam padrões independentes de domínio e ambiente aprendidos em seu pré-treinamento em larga escala para prever resultados de ações para cada ambiente Xi et al. (2023); Wang et al. (2023c); Gong et al. (2023a); Wu et al. (2023). Em (Huang et al., 2023a), investigamos a tarefa de colaboração guiada por conhecimento e geração de cenas interativas combinando modelos de base grandes e mostramos resultados promissores que sugerem que as inteligências baseadas em conhecimento de modelos de linguagem grandes podem melhorar o desempenho da compreensão, geração e edição de cenas 2D e 3D, bem como outras interações homem-computador Huang et al. (2023a). ). Ao integrar a estrutura de IA do Intelligent Body, o modelo de base grande é capaz de compreender mais profundamente as entradas do usuário, resultando em sistemas de interação homem-computador complexos e adaptáveis. Os recursos emergentes de modelos de linguagem grandes e modelos de linguagem visual desempenham uma função inédita na interação humano-computador para IA generativa, IA incorporada, aumento de conhecimento para aprendizado multimodal, geração de realidade mista, edição de texto para visão e simulação 2D/3D em jogos ou tarefas de robótica. Os recentes avanços na modelagem fundamental da IA de corpos inteligentes proporcionam um catalisador iminente para desbloquear a inteligência genérica em inteligências incorporadas. Modelos de ação em larga escala ou modelos de linguagem visual de inteligências abrem novas possibilidades para sistemas corporificados genéricos, como planejamento, solução de problemas e aprendizado em ambientes complexos. A IA incorporada inteligente dá novos passos no meta-universo e aponta o caminho para as primeiras versões da IA de uso geral.

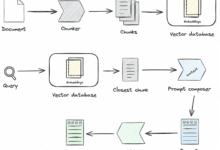

![IA de agente: explorando o mundo da interação multimodal [Fei-Fei Li - Clássico de leitura obrigatória]-1 IA de agente: explorando o mundo da interação multimodal [Fei-Fei Li - Clássico de leitura obrigatória]-1](https://www.aisharenet.com/wp-content/uploads/2025/01/2dd99ca44577ecf.png)

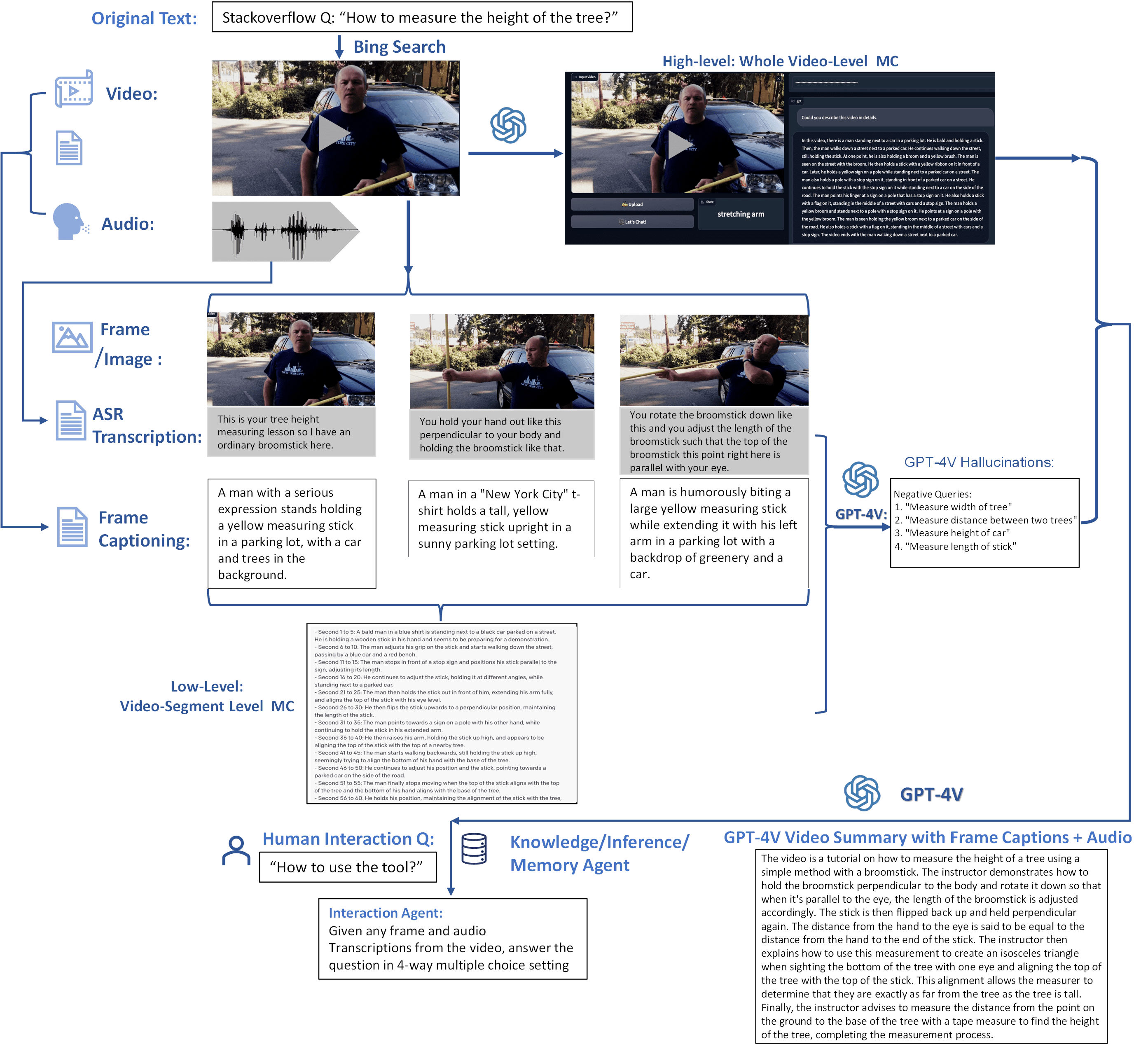

Fig. 2: IA de corpo inteligente multimodal para geração incorporada 2D/3D e interações de edição em toda a realidade.

2.1 Inteligência artificial infinita

As inteligências de inteligência artificial têm a capacidade de interpretar, prever e responder com base em seu treinamento e nos dados de entrada. Embora esses recursos sejam avançados e estejam melhorando, é importante reconhecer suas limitações e o impacto dos dados subjacentes nos quais eles são treinados. Os sistemas de inteligências de IA normalmente têm os seguintes recursos: 1) Modelagem preditiva: as inteligências de IA podem prever resultados prováveis ou sugerir etapas subsequentes com base em dados históricos e tendências. Por exemplo, elas podem prever a continuação de um texto, a resposta a uma pergunta, a próxima ação de um robô ou a solução de um cenário.2) Tomada de decisões: em alguns aplicativos, as inteligências de IA podem tomar decisões com base em suas inferências. Normalmente, as inteligências tomam decisões com base no que é mais provável que atinja o objetivo especificado. Para aplicações de IA, como sistemas de recomendação, as inteligências podem decidir quais produtos ou conteúdos recomendar com base em suas inferências sobre as preferências do usuário.3) Lidar com a ambiguidade: as inteligências de IA geralmente podem lidar com entradas ambíguas inferindo a interpretação mais provável com base no contexto e no treinamento. No entanto, sua capacidade de fazer isso é limitada pelo escopo de seus dados de treinamento e algoritmos.4) Melhoria contínua: embora algumas inteligências de IA tenham a capacidade de aprender com novos dados e interações, muitos modelos de linguagem grandes não atualizam continuamente sua base de conhecimento ou representações internas após o treinamento. Suas inferências geralmente se baseiam apenas nos dados disponíveis na última atualização do treinamento.

Na Figura 2, mostramos inteligências interativas aumentadas para integração multimodal e agnóstica entre realidades com mecanismos emergentes. As inteligências de inteligência artificial exigem a coleta de grandes quantidades de dados de treinamento para cada nova tarefa, o que pode ser caro ou impossível para muitos domínios. Neste estudo, desenvolvemos um corpo inteligente infinito que aprende a transferir informações na memória de um modelo básico de uso geral (por exemplo, GPT-X, DALL-E) para novos domínios ou cenários para compreensão, geração e edição interativa de cenários em um mundo físico ou virtual.

Uma aplicação dessas inteligências infinitas na robótica é o RoboGen Wang et al. (2023d). Nesse estudo, os autores apresentam um pipeline para a execução autônoma de sugestões de tarefas, geração de ambiente e ciclos de aprendizagem de habilidades. O RoboGen é um esforço para transferir conhecimento incorporado em modelos de larga escala para a robótica.

2.2 Inteligência artificial para a Intelligentsia com modelos de base grandes

Pesquisas recentes mostraram que os modelos de base em grande escala desempenham um papel crucial na criação de dados que funcionam como referências para determinar as ações de um corpo inteligente dentro das restrições impostas pelo ambiente. Os exemplos incluem o uso de modelos de base para manipulação de robôs Black et al. (2023); Ko et al. (2023) e navegação Shah et al. (2023a); Zhou et al. (2023a). Para ilustrar, Black et al. empregam um modelo de edição de imagens como um planejador de alto nível para gerar imagens de subobjetivos futuros para orientar a estratégia de baixo nível Black et al. (2023). Para a navegação de robôs, Shah et al. propõem um sistema que emprega um modelo de macrolinguagem para reconhecer pontos de referência do texto e um modelo de linguagem visual para associar esses pontos de referência a entradas visuais, aprimorando assim a navegação por meio de comandos de linguagem natural Shah et al. (2023a).

Há também um interesse crescente na geração de movimentos humanos condicionados, adaptados a fatores linguísticos e ambientais. Vários sistemas de IA foram propostos para gerar movimentos e ações personalizados para comandos linguísticos específicos Kim et al. (2023); Zhang et al. (2022); Tevet et al. (2022) e adaptados a uma variedade de cenas em 3D Wang et al. (2022a). Essa pesquisa destaca a crescente capacidade dos modelos generativos de aprimorar a adaptabilidade e a capacidade de resposta das inteligências de IA em uma variedade de cenários.

2.2.1 Alucinações

As inteligências que geram texto são frequentemente propensas a alucinações, ou seja, situações em que o texto gerado não tem sentido ou não corresponde ao conteúdo da fonte fornecida Raunak et al. (2021); Maynez et al. (2020). As ilusões podem ser divididas em duas categorias.ilusão interiorresponder cantandoilusão externa Ji et al. (2023). As ilusões intrínsecas são aquelas que contradizem o material de origem, enquanto as ilusões extrínsecas são os casos em que o texto gerado contém informações adicionais não incluídas inicialmente no material de origem.

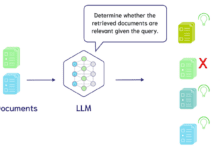

Alguns caminhos promissores para reduzir a taxa de ilusões na geração de linguagem incluem o uso de recuperação para aprimorar a geração Lewis et al. (2020); Shuster et al. (2021) ou outras abordagens que apoiam a saída de linguagem natural por meio da recuperação de conhecimento externo Dziri et al. (2021); Peng et al. (2023). Normalmente, essas abordagens visam aprimorar a geração de linguagem recuperando outro material de origem e fornecendo mecanismos para verificar se há contradições entre a resposta gerada e o material de origem.

No contexto dos sistemas corporais inteligentes multimodais, também foi demonstrado que os modelos de linguagem visual produzem alucinações Zhou et al. (2023b). Uma causa comum de alucinações na geração de linguagem com base visual é uma dependência excessiva da coocorrência de objetos e pistas visuais nos dados de treinamento Rohrbach et al. (2018). As inteligências de IA que dependem exclusivamente de modelos de linguagem visual ou de macrolinguagem pré-treinados e usam um ajuste fino limitado específico do contexto podem ser particularmente propensas a alucinações porque dependem da base de conhecimento interna do modelo pré-treinado para gerar ações e podem não entender com precisão a dinâmica do estado mundial em que são implantadas.

2.2.2 Preconceito e inclusão

As inteligências de IA baseadas em grandes modelos de linguagem (LLMs) ou grandes modelos multimodais (LMMs) são tendenciosas devido a vários fatores inerentes ao seu processo de design e treinamento. Ao projetar essas inteligências de IA, devemos estar atentos à inclusão e às necessidades de todos os usuários finais e partes interessadas. No contexto das inteligências de IA, anão exclusividade refere-se às medidas e aos princípios adotados para garantir que as respostas e as interações da intelligentsia sejam inclusivas, respeitosas e sensíveis a uma ampla gama de usuários de diversas origens. A seguir, apresentaremos os principais aspectos da parcialidade e da inclusão dos corpos inteligentes.

- Dados de treinamentoO modelo subjacente é treinado em uma grande quantidade de dados textuais coletados da Internet, incluindo livros, artigos, sites e outras fontes textuais. Esses dados geralmente refletem preconceitos existentes na sociedade humana, que o modelo pode aprender e reproduzir inadvertidamente. Isso inclui estereótipos, preconceitos e visões tendenciosas relacionadas a raça, gênero, etnia, religião e outros atributos pessoais. Em particular, ao treinar com dados da Internet e, muitas vezes, usar apenas texto em inglês para treinamento, os modelos aprendem implicitamente as normas culturais das sociedades ocidentais, educadas, industrializadas, ricas e democráticas (WEIRD) Henrich et al. ( 2010 ), que têm uma presença desproporcional na Internet. No entanto, é importante reconhecer que os conjuntos de dados criados por seres humanos não podem ser totalmente isentos de preconceitos, pois geralmente refletem preconceitos sociais e também os dos indivíduos que originalmente geraram e/ou compilaram os dados.

- Viés histórico e culturalModelos de IA são treinados em grandes conjuntos de dados de diversos conteúdos. Dessa forma, os dados de treinamento geralmente incluem textos históricos ou materiais de diferentes culturas. Em particular, os dados de treinamento de fontes históricas podem conter linguagem ofensiva ou depreciativa que representa as normas culturais, as atitudes e os preconceitos de uma determinada sociedade. Isso pode resultar em modelos que perpetuam estereótipos desatualizados ou que não conseguem entender totalmente as mudanças e nuances culturais contemporâneas.

- Restrições linguísticas e contextuaisModelos de linguagem: os modelos de linguagem podem ter dificuldade para entender e representar com precisão as nuances da linguagem, como ironia, humor ou alusões culturais. Isso pode levar a mal-entendidos ou respostas tendenciosas em alguns casos. Além disso, muitos aspectos da linguagem falada não são capturados por dados somente de texto, o que leva a uma possível desconexão entre como os humanos entendem a linguagem e como os modelos a entendem.

- Políticas e diretrizesInteligências de IA: as inteligências de IA operam sob políticas e diretrizes rigorosas para garantir a justiça e a inclusão. Por exemplo, ao gerar imagens, há regras para diversificar a representação de personagens e evitar estereótipos associados a raça, gênero e outros atributos.

- generalização excessivaModelos de treinamento: Esses modelos tendem a gerar respostas com base em padrões observados nos dados de treinamento. Isso pode levar à generalização excessiva e os modelos podem gerar respostas que parecem estereotipar determinados grupos ou fazer suposições amplas.

- Monitoramento e atualização contínuosO sistema de IA é continuamente monitorado e atualizado para tratar de quaisquer questões emergentes de parcialidade ou inclusão. O feedback dos usuários e a pesquisa contínua em ética de IA desempenham um papel fundamental nesse processo.

- Ampliação da visão dominanteComo os dados de treinamento geralmente contêm mais conteúdo da cultura ou do grupo dominante, o modelo pode ser mais tendencioso em relação a essas visões e, portanto, pode subestimar ou distorcer as visões dos grupos minoritários.

- Design ético e inclusivoAs ferramentas de IA devem ser projetadas com considerações éticas e inclusão como princípios fundamentais. Isso inclui respeitar as diferenças culturais, promover a diversidade e garantir que a IA não perpetue estereótipos prejudiciais.

- Guia do usuárioOs usuários também são instruídos sobre como interagir com a IA de forma a promover a inclusão e o respeito. Isso inclui evitar solicitações que possam levar a resultados tendenciosos ou inadequados. Além disso, pode ajudar a mitigar situações em que o modelo aprende material prejudicial a partir das interações do usuário.

Apesar dessas medidas, os preconceitos nas inteligências de IA persistem. Os esforços contínuos de pesquisa e desenvolvimento do AI for Intelligentsia estão concentrados em reduzir ainda mais esses vieses e aumentar a inclusão e a justiça dos sistemas AI for Intelligentsia. Esforços de redução de preconceitos:

- Dados de treinamento diversificados e inclusivosEsforços estão sendo feitos para incluir fontes mais diversificadas e inclusivas nos dados de treinamento.

- Detecção e correção de distorçõesPesquisa em andamento: A pesquisa em andamento se concentra na detecção e correção de distorções nas respostas do modelo.

- Diretrizes e políticas éticasOs modelos geralmente estão vinculados a diretrizes e políticas éticas criadas para atenuar preconceitos e garantir interações respeitosas e inclusivas.

- Representação diversificadaInteligência de IA: garantir que o conteúdo gerado ou as respostas fornecidas pelas inteligências de IA representem uma ampla gama de experiências, culturas, etnias e identidades humanas. Isso é particularmente relevante em cenários como a geração de imagens ou a construção de narrativas.

- Mitigação de viesesTrabalho ativo para reduzir a parcialidade nas respostas de IA. Isso inclui preconceitos relacionados a raça, gênero, idade, deficiência, orientação sexual e outras características pessoais. O objetivo é fornecer uma resposta justa e equilibrada, e não perpetuar estereótipos ou preconceitos.

- Sensibilidade culturalOs projetos da AI são culturalmente sensíveis, reconhecendo e respeitando a diversidade de normas, práticas e valores culturais. Isso inclui compreender e responder adequadamente às referências e nuances culturais.

- acessibilidadeInteligência de IA: Garanta que as inteligências de IA sejam acessíveis a usuários com diferentes habilidades, incluindo aqueles com deficiências. Isso pode envolver a incorporação de recursos que facilitem a interação de pessoas com deficiências visuais, auditivas, motoras ou cognitivas.

- Inclusão baseada no idiomaSuporte a vários idiomas e dialetos para uma base de usuários global e sensibilidade às nuances e variações internas do idioma Liu et al. ( 2023b ).

- Interação ética e respeitosaInteligência: A inteligência é programada para interagir de forma ética e respeitosa com todos os usuários, evitando respostas que possam ser consideradas ofensivas, prejudiciais ou desrespeitosas.

- Feedback e adaptação do usuárioIncorporar o feedback do usuário para melhorar continuamente a inclusão e a eficácia das inteligências de IA. Isso inclui aprender com as interações para entender melhor e atender a uma base de usuários diversificada.

- Conformidade com as diretrizes inclusivasAderir a diretrizes e padrões estabelecidos para a inclusão de inteligências de IA, que normalmente são definidos por grupos do setor, comitês de ética ou órgãos reguladores.

Apesar desses esforços, é importante estar ciente da possibilidade de vieses nas respostas e pensar criticamente sobre como interpretá-las. Os aprimoramentos contínuos na tecnologia de inteligências de IA e nas práticas éticas visam a reduzir esses vieses ao longo do tempo. Corpos inteligentes Um dos objetivos gerais da inclusão da IA é criar um corpo inteligente que seja respeitoso e acessível a todos os usuários, independentemente de sua formação ou identidade.

2.2.3 Privacidade e uso dos dados

Uma consideração ética fundamental para as inteligências de IA envolve a compreensão de como esses sistemas processam, armazenam e, potencialmente, recuperam os dados do usuário. Discutiremos os principais aspectos a seguir:

Coleta, uso e finalidade dos dados.

Ao usar os dados do usuário para melhorar o desempenho do modelo, os desenvolvedores de modelos têm acesso aos dados coletados pelas inteligências de IA na produção e na interação com os usuários. Alguns sistemas permitem que os usuários visualizem seus dados por meio de sua conta de usuário ou enviando uma solicitação a um provedor de serviços. É importante reconhecer quais dados as inteligências de IA estão coletando durante essas interações. Isso pode incluir entrada de texto, padrões de uso do usuário, preferências pessoais e, às vezes, informações pessoais mais confidenciais. Os usuários também devem entender como os dados coletados de suas interações são usados. Se, por algum motivo, a IA mantiver informações incorretas sobre um determinado indivíduo ou grupo, deve haver um mecanismo para que o usuário ajude a corrigir o erro assim que ele for reconhecido. Isso é importante para a precisão e o respeito a todos os usuários e grupos. Os usos comuns para recuperar e analisar os dados do usuário incluem melhorar a interação do usuário, personalizar as respostas e otimizar os sistemas. É importante que os desenvolvedores garantam que os dados não sejam usados para fins que os usuários não tenham consentido (por exemplo, marketing não solicitado).

Armazenamento e segurança.

Os desenvolvedores devem estar cientes de onde os dados de interação do usuário são armazenados e das medidas de segurança em vigor para protegê-los contra acesso ou divulgação não autorizados. Isso inclui criptografia, servidores seguros e protocolos de proteção de dados. É importante determinar se e sob quais condições os dados de corpos inteligentes são compartilhados com terceiros. Isso deve ser transparente e geralmente requer o consentimento do usuário.

Exclusão e retenção de dados.

Também é importante que os usuários entendam por quanto tempo os dados do usuário são armazenados e como eles podem solicitar a exclusão de seus dados. Muitas leis de proteção de dados dão aos usuários o direito de serem esquecidos, o que significa que eles podem solicitar a exclusão de seus dados.AI Intelligentsia deve cumprir as leis de proteção de dados, como o GDPR da UE ou a CCPA da Califórnia. Essas leis regem as práticas de processamento de dados e os direitos dos usuários sobre seus dados pessoais.

Política de privacidade e portabilidade de dados.

Além disso, os desenvolvedores devem criar uma política de privacidade para que as inteligências de IA documentem e expliquem aos usuários como seus dados serão tratados. Isso deve detalhar a coleta de dados, o uso, o armazenamento e os direitos do usuário. Os desenvolvedores devem garantir que obtenham o consentimento do usuário para a coleta de dados, especialmente para informações confidenciais. Em geral, os usuários podem optar por não participar ou restringir os dados que fornecem. Em algumas jurisdições, os usuários podem até ter o direito de solicitar uma cópia de seus dados em um formato que possa ser transferido para outro provedor de serviços.

Anonimização.

Para dados usados em análises mais amplas ou treinamento de IA, o ideal é que sejam anônimos para proteger as identidades individuais. Os desenvolvedores devem entender como suas inteligências de IA recuperam e usam dados históricos do usuário durante as interações. Isso pode ser feito para personalização ou para melhorar a relevância de uma resposta.

Em resumo, a compreensão da privacidade de dados para inteligências de IA inclui a compreensão de como os dados do usuário são coletados, usados, armazenados e protegidos, além de garantir que os usuários estejam cientes de seus direitos em relação ao acesso, correção e exclusão de seus dados. Compreender os mecanismos de recuperação de dados dos usuários e das inteligências de IA também é fundamental para uma compreensão completa da privacidade dos dados.

2.2.4 Interpretabilidade e descritividade

Aprendizado por imitação → desacoplamento

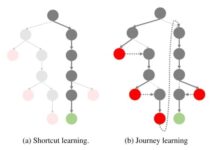

Normalmente, as inteligências são treinadas usando loops de feedback contínuos no aprendizado por reforço (RL) ou aprendizado por imitação (IL), começando com uma estratégia inicializada aleatoriamente. Entretanto, essa abordagem enfrenta gargalos na obtenção de recompensas iniciais em ambientes desconhecidos, especialmente quando as recompensas são esparsas ou só estão disponíveis no final de interações de etapas longas. Portanto, uma solução superior é usar inteligências de memória infinita treinadas por meio da aprendizagem por imitação, que pode aprender estratégias com dados de especialistas, o que leva a uma melhor exploração e utilização de espaços ambientais não vistos, bem como de infraestruturas emergentes, conforme mostrado na Figura 3. Com recursos especializados para ajudar as inteligências a explorar melhor os espaços ambientais invisíveis. A IA de corpos inteligentes pode aprender estratégias e processos de novos paradigmas diretamente de dados especializados.

O aprendizado por imitação tradicional permite que as inteligências aprendam estratégias imitando o comportamento de um demonstrador especializado. No entanto, aprender estratégias de especialistas diretamente pode nem sempre ser a melhor abordagem, pois o corpo inteligente pode não ser bem generalizado para situações inéditas. Para resolver esse problema, propomos aprender um corpo inteligente com dicas contextuais ou funções de recompensa implícitas que capturam os principais aspectos do comportamento do especialista, conforme mostrado na Figura 3. Isso equipa as inteligências de memória infinita com dados comportamentais do mundo físico aprendidos com demonstrações de especialistas para a execução de tarefas. Isso ajuda a superar as desvantagens do aprendizado por imitação existente, como a necessidade de grandes quantidades de dados de especialistas e a possibilidade de erro em tarefas complexas. A ideia principal por trás do Intelligent Body AI tem dois componentes: 1) o Infinite Intelligent Body, que coleta demonstrações de especialistas do mundo físico como pares estado-ação, e 2) o ambiente virtual do Imitation Intelligent Body Generator. O Imitation Intelligent Body gera ações que imitam o comportamento do especialista, enquanto o Intelligent Body aprende um mapeamento de política de estados para ações reduzindo a função de perda da diferença entre as ações do especialista e as ações geradas pela política de aprendizado.

Desacoplamento → Generalização

Em vez de depender de funções de recompensa específicas da tarefa, o corpo inteligente aprende com demonstrações de especialistas que fornecem um conjunto diversificado de pares estado-ação que abrangem vários aspectos da tarefa. Em seguida, o corpo inteligente aprende estratégias para mapear estados para ações, imitando o comportamento do especialista. A dissociação na aprendizagem por imitação refere-se à separação do processo de aprendizagem da função de recompensa específica da tarefa, permitindo assim que as estratégias sejam generalizadas em diferentes tarefas sem depender explicitamente da função de recompensa específica da tarefa. Por meio da dissociação, uma pessoa inteligente pode aprender com demonstrações de especialistas e aprender uma estratégia que pode ser adaptada a várias situações. A dissociação permite a aprendizagem por transferência, na qual uma estratégia aprendida em um domínio pode ser adaptada a outros domínios com um ajuste fino mínimo. Ao aprender uma estratégia generalizada que não está vinculada a uma função de recompensa específica, um corpo inteligente pode usar o conhecimento que adquiriu em uma tarefa para ter um bom desempenho em outras tarefas relacionadas. Como o corpo inteligente não depende de uma função de recompensa específica, ele pode se adaptar às mudanças na função de recompensa ou no ambiente sem precisar de muito retreinamento. Isso torna as estratégias aprendidas mais robustas e generalizáveis em diferentes ambientes. Nesse contexto, a dissociação refere-se à separação de duas tarefas no processo de aprendizagem: aprender a função de recompensa e aprender a política ideal.

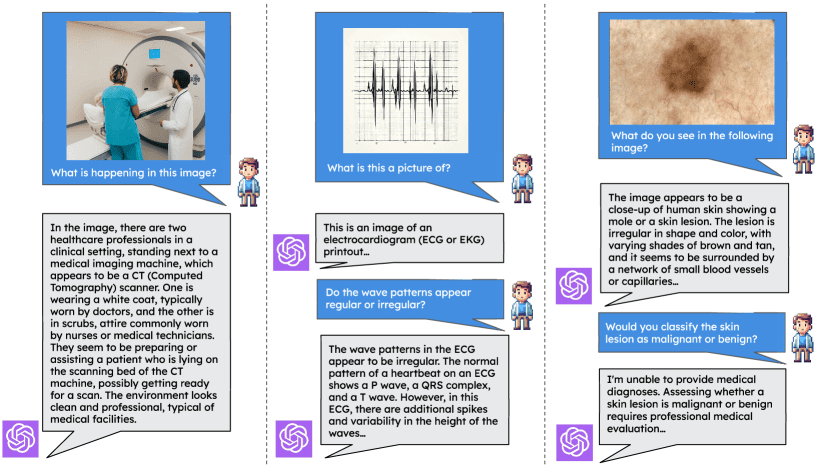

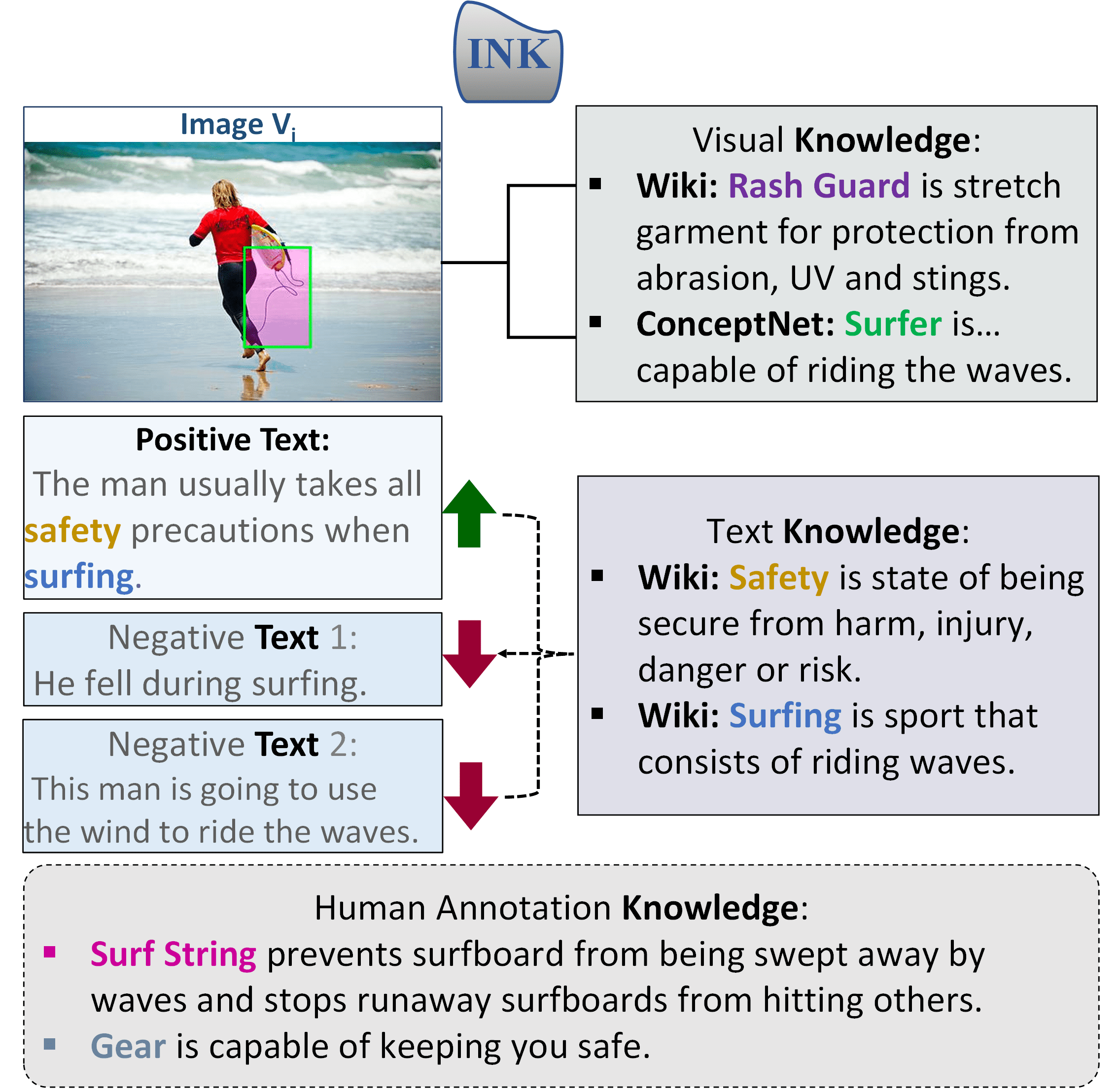

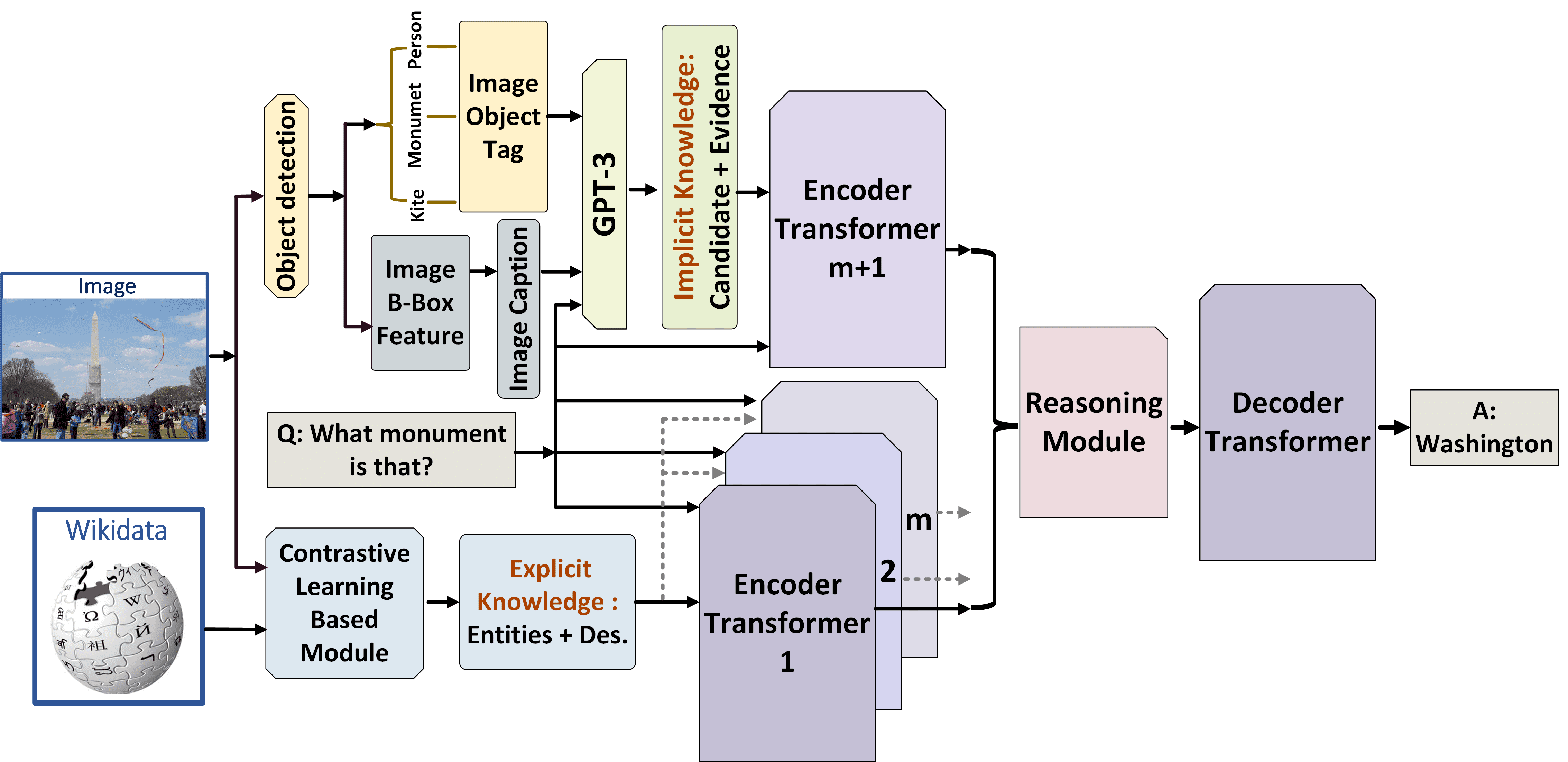

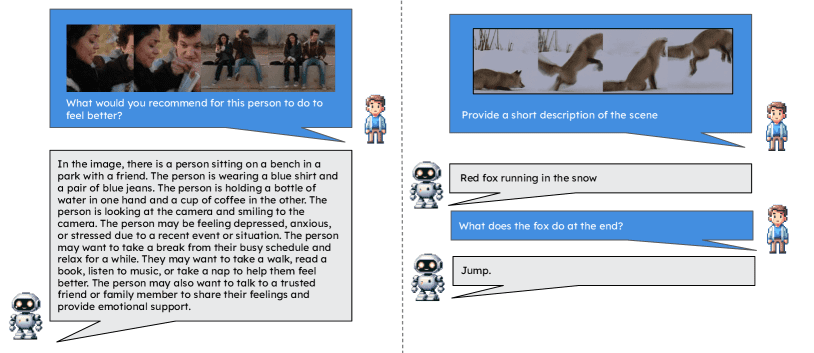

Figura 3: Exemplo de um mecanismo de interação emergente que usa inteligências para identificar textos relacionados a imagens a partir de textos candidatos. A tarefa envolve a integração de informações do mundo externo usando inteligências de IA multimodais da rede e amostras de interação de conhecimento rotuladas manualmente.

Generalização → comportamento emergente

A generalização explica como as propriedades ou os comportamentos emergentes podem surgir de componentes ou regras mais simples. A ideia principal é identificar os elementos ou regras básicas que controlam o comportamento do sistema, como neurônios individuais ou algoritmos básicos. Assim, observando como esses componentes ou regras simples interagem uns com os outros. As interações desses componentes muitas vezes levam ao surgimento de comportamentos complexos que não podem ser previstos apenas pela análise dos componentes individuais. A generalização em diferentes níveis de complexidade permite que o sistema aprenda princípios genéricos que se aplicam a esses níveis, levando a propriedades emergentes. Isso permite que o sistema se adapte a novas situações, demonstrando o surgimento de comportamentos mais complexos a partir de regras mais simples. Além disso, a capacidade de generalizar em diferentes níveis de complexidade facilita a transferência de conhecimento de um domínio para outro, o que ajuda a fazer surgir comportamentos complexos em novos ambientes à medida que o sistema se adapta.

2.2.5 Aprimoramento do raciocínio

Os recursos de raciocínio das inteligências de IA estão em sua capacidade de interpretar, prever e responder com base em dados de treinamento e de entrada. Embora esses recursos sejam avançados e estejam melhorando, é importante reconhecer suas limitações e o impacto dos dados subjacentes nos quais eles são treinados. Em particular, no contexto dos Modelos de Linguagem Ampla (LLMs), isso se refere à sua capacidade de tirar conclusões, fazer previsões e gerar respostas com base nos dados em que são treinados e nas entradas que recebem. O aumento do raciocínio em inteligências de IA refere-se ao uso de ferramentas, técnicas ou dados adicionais para aumentar os recursos de raciocínio natural de uma IA a fim de melhorar seu desempenho, precisão e utilidade. Isso é particularmente importante em cenários complexos de tomada de decisão ou ao lidar com conteúdo especializado ou com nuances. A seguir, listaremos fontes particularmente importantes de aprimoramento do raciocínio:

Riqueza de dados.

A incorporação de fontes de dados adicionais (geralmente externas) para fornecer mais contexto ou histórico pode ajudar as inteligências de IA a fazer inferências mais informadas, especialmente em áreas em que seus dados de treinamento podem ser limitados. Por exemplo, as inteligências de IA podem inferir o significado do contexto de um diálogo ou texto. Elas analisam as informações fornecidas e as utilizam para entender a intenção e os detalhes relevantes da consulta de um usuário. Esses modelos são bons em reconhecer padrões nos dados. Eles usam essa capacidade para inferir informações sobre a linguagem, o comportamento do usuário ou outros fenômenos relevantes com base nos padrões aprendidos durante o treinamento.

Aprimoramento algorítmico.

Aprimorar os algoritmos subjacentes da IA para melhorar o raciocínio. Isso pode envolver o uso de modelos de aprendizado de máquina mais avançados, a integração de diferentes tipos de IA (por exemplo, a combinação de processamento de linguagem natural (NLP) com reconhecimento de imagem) ou a atualização de algoritmos para lidar melhor com tarefas complexas. O raciocínio na modelagem de linguagem envolve a compreensão e a geração de linguagem humana. Isso inclui entender o tom, a intenção e as nuances de diferentes estruturas de linguagem.

Human in the Loop (HITL).

O envolvimento de humanos para aumentar o raciocínio da IA pode ser particularmente útil em áreas em que o julgamento humano é fundamental (por exemplo, considerações éticas, tarefas criativas ou cenários ambíguos). Os seres humanos podem fornecer orientação, corrigir erros ou oferecer percepções que a inteligência não pode inferir por conta própria.

Integração de feedback em tempo real.

Usar o feedback em tempo real do usuário ou do ambiente para aumentar o raciocínio é outra abordagem promissora para melhorar o desempenho durante o raciocínio. Por exemplo, uma IA pode ajustar suas recomendações com base nas respostas do usuário em tempo real ou nas mudanças de condições em um sistema dinâmico. Como alternativa, se a IA realizar uma ação que viole determinadas regras em um ambiente simulado, o feedback poderá ser fornecido dinamicamente à IA para ajudá-la a se corrigir.

Transferência de conhecimento interdisciplinar.

O uso de conhecimentos ou modelos de um domínio para aprimorar o raciocínio em outro é particularmente útil ao gerar resultados em disciplinas especializadas. Por exemplo, as técnicas desenvolvidas para a tradução de idiomas podem ser aplicadas à geração de códigos, ou as percepções de diagnósticos médicos podem aprimorar a manutenção preditiva de máquinas.

Personalização para casos de uso específicos.

A adaptação dos recursos de raciocínio de uma IA para um aplicativo ou setor específico pode envolver o treinamento da IA em conjuntos de dados especializados ou o ajuste fino de seu modelo para melhor atender a uma tarefa específica, como análise jurídica, diagnóstico médico ou previsão financeira. Como a linguagem ou as informações específicas de um domínio podem contrastar com a linguagem de outros domínios, o ajuste fino das inteligências no conhecimento específico do domínio pode ser benéfico.

Considerações éticas e de preconceito.

É importante garantir que o processo de aprimoramento não introduza novos vieses ou questões éticas. Isso envolve a consideração cuidadosa do impacto sobre a justiça e a transparência das fontes de dados adicionais ou de novos algoritmos de aprimoramento do raciocínio. Às vezes, as inteligências de IA precisam responder a considerações éticas ao raciocinar, especialmente sobre tópicos delicados. Isso inclui evitar estereótipos prejudiciais, respeitar a privacidade e garantir a justiça.

Aprendizado e adaptação contínuos.

Atualize e refine regularmente os recursos de IA para acompanhar os novos desenvolvimentos, as mudanças nos cenários de dados e a evolução das necessidades dos usuários.

Em resumo, o aumento do raciocínio em inteligências de IA envolve métodos para aumentar seus recursos de raciocínio natural com dados adicionais, algoritmos aprimorados, entrada humana e outras técnicas. Dependendo do caso de uso, esses aprimoramentos geralmente são essenciais para lidar com tarefas complexas e garantir a precisão do resultado das inteligências.

2.2.6 Regulamento

Recentemente, houve avanços significativos na IA de corpos inteligentes e sua integração com sistemas incorporados abriu novas possibilidades de interação com corpos inteligentes por meio de experiências mais imersivas, dinâmicas e envolventes. Para acelerar esse processo e aliviar o trabalho pesado envolvido no desenvolvimento da IA de corpos inteligentes, propomos o desenvolvimento de um pipeline de interação com corpos inteligentes habilitado para IA de última geração. Desenvolver um sistema de colaboração homem-máquina que permita que humanos e máquinas se comuniquem e interajam de forma significativa. O sistema poderia aproveitar os recursos de conversação e a ampla gama de ações de um Modelo de Linguagem Grande (LLM) ou Modelo de Linguagem Visual (VLM) para conversar com jogadores humanos e identificar as necessidades humanas. Em seguida, ele executará as ações apropriadas para auxiliar o jogador humano conforme necessário.

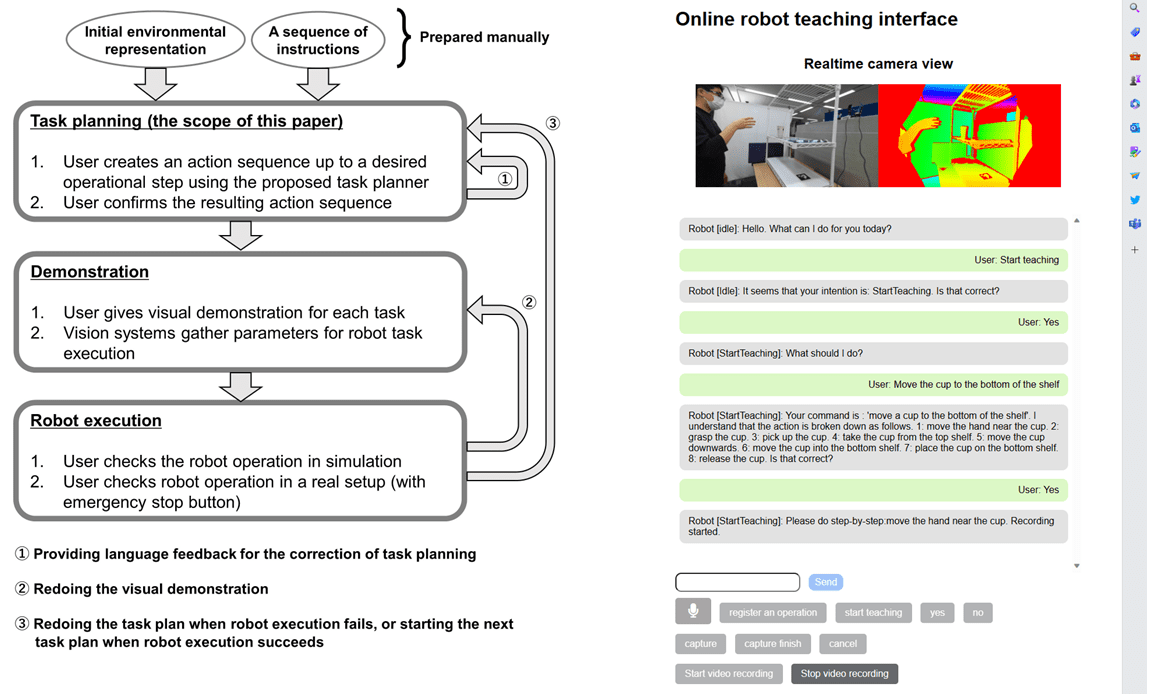

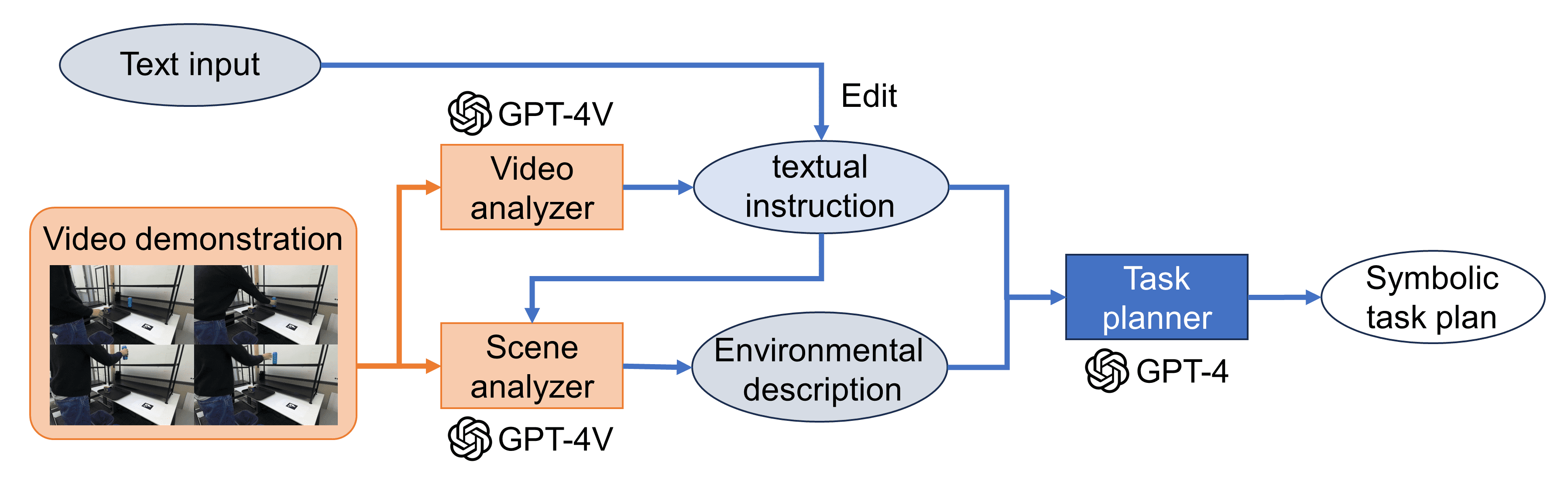

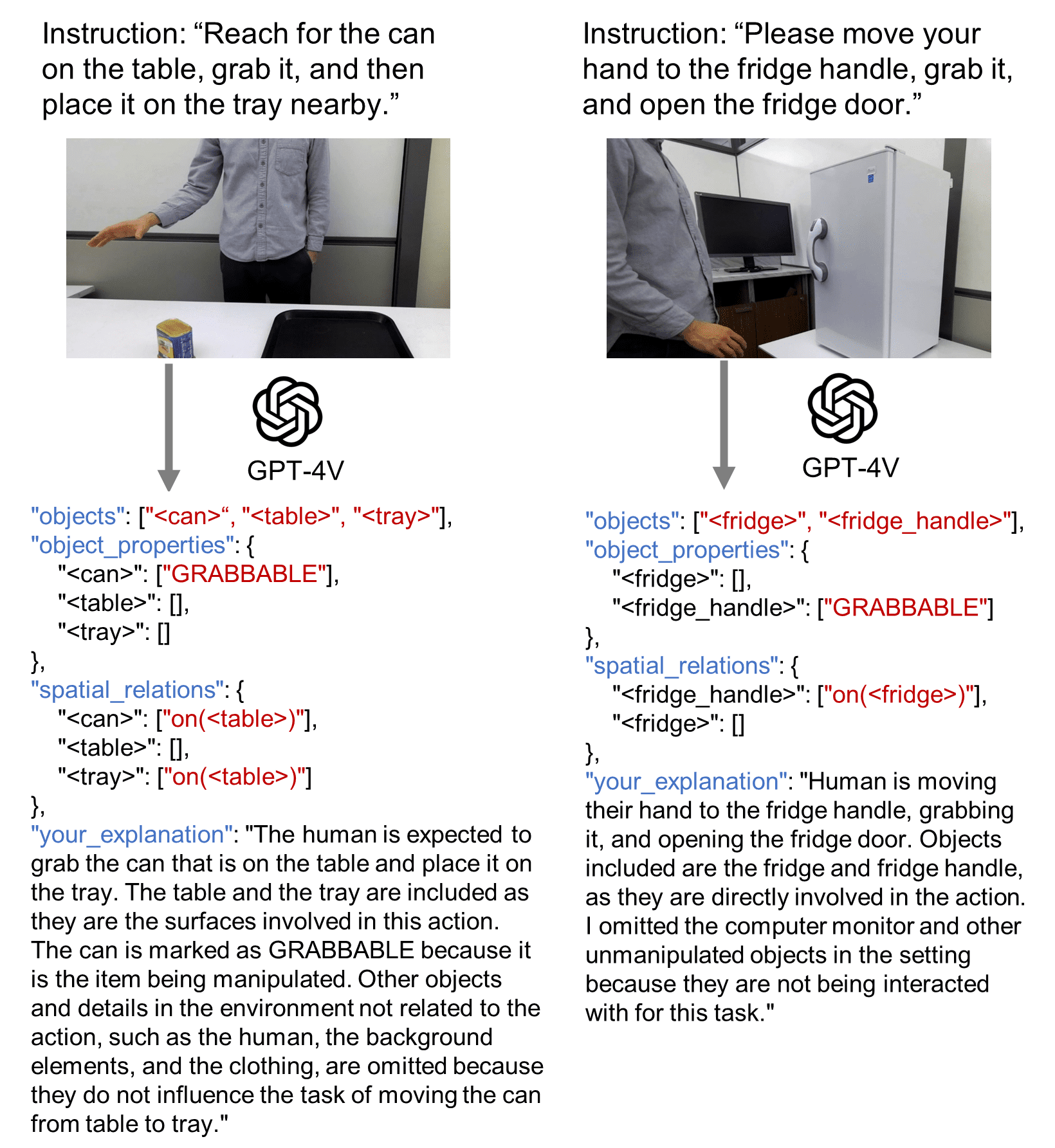

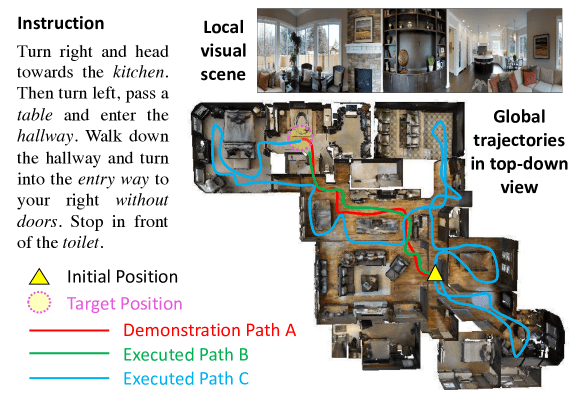

Ao usar modelos de linguagem ampla (LLMs)/modelos de linguagem visual (VLMs) para sistemas colaborativos entre humanos e robôs, é importante observar que esses modelos operam como caixas pretas e produzem resultados imprevisíveis. Essa incerteza pode se tornar crítica em ambientes físicos (por exemplo, na operação de um robô real). Uma maneira de enfrentar esse desafio é limitar o foco do Modelo de Linguagem Ampla (LLM)/Modelo de Linguagem Visual (VLM) por meio da engenharia de dicas. Por exemplo, ao executar o planejamento de tarefas robóticas com base em instruções, foi relatado que o fornecimento de informações ambientais em dicas produz resultados mais estáveis do que confiar apenas no texto, Gramopadhye e Szafir (2022). Esse relatório é apoiado pela teoria da estrutura de IA de Minsky Minsky (1975), que sugere que o espaço do problema a ser resolvido por um Modelo de Linguagem Ampla (LLM)/Modelo de Linguagem Visual (VLM) é definido por um determinado prompt. Outra abordagem é projetar prompts de modo que o Large Language Model (LLM)/Visual Language Model (VLM) contenha texto explicativo para permitir que o usuário entenda o que o modelo está focalizando ou reconhecendo. Além disso, a implementação de um nível mais alto que permita a validação e a modificação pré-execução orientada por humanos pode facilitar a operação de sistemas que funcionam sob essa orientação (Figura 4).

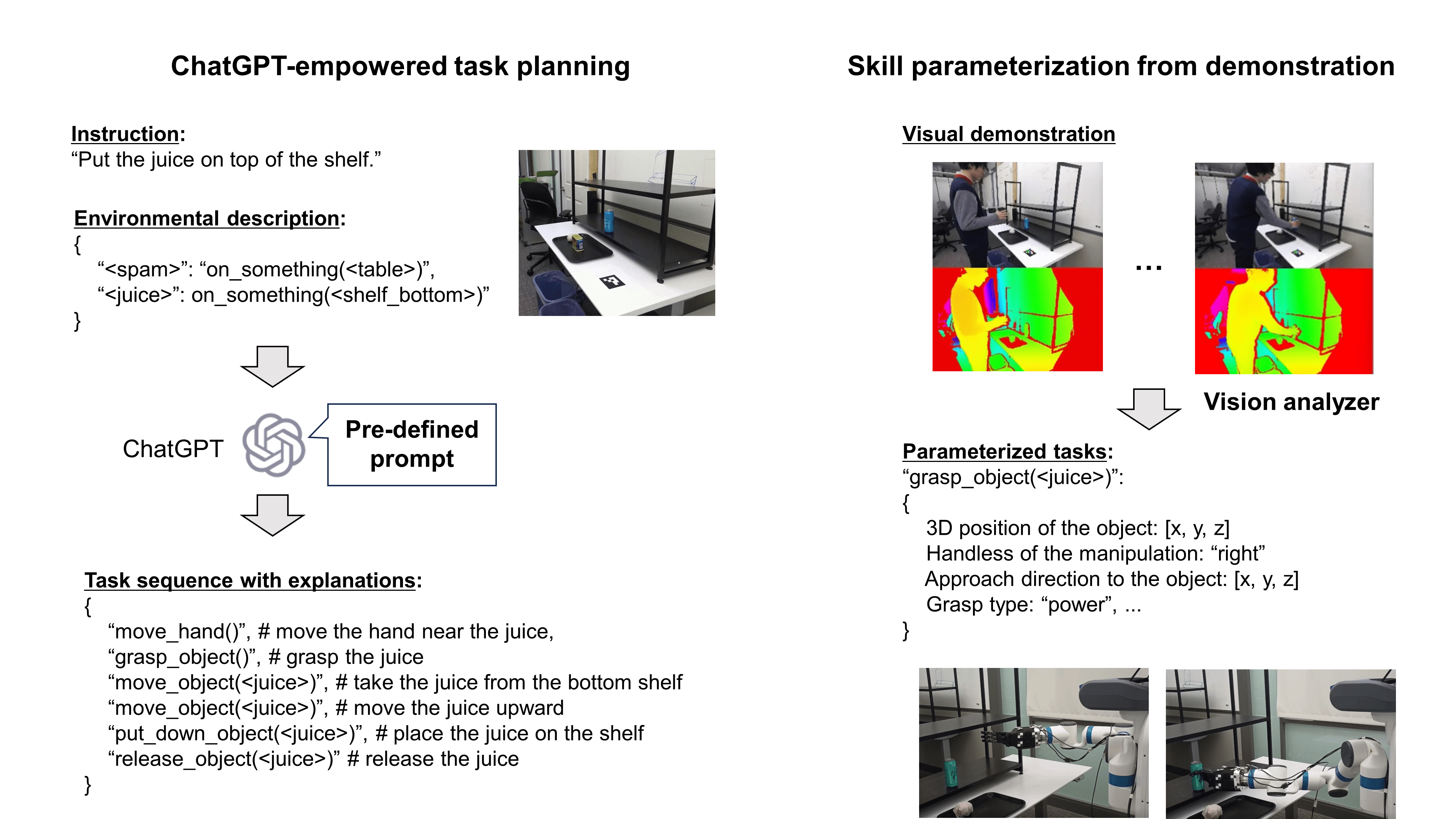

Figura 4: Sistema de ensino de robótica desenvolvido em Wake et al. (2023c). (Esquerda) Fluxo de trabalho do sistema. O processo consiste em três etapas: planejamento de tarefas, que ChatGPT Planejamento de tarefas do robô com base em comandos e informações ambientais; Demonstração, em que o usuário demonstra visualmente as sequências de ação. Todas as etapas são revisadas pelo usuário e, se alguma etapa falhar ou apresentar defeitos, as etapas anteriores podem ser revisadas conforme necessário. (à direita) Um aplicativo da Web que permite o upload de dados de demonstração e a interação entre o usuário e o ChatGPT.

2.3 Intelligentsia AI para recursos emergentes

Apesar da crescente adoção de sistemas de IA de inteligências interativas, a maioria das abordagens propostas ainda enfrenta desafios em termos de desempenho de generalização em ambientes ou cenários não vistos. As práticas atuais de modelagem exigem que os desenvolvedores preparem grandes conjuntos de dados para cada domínio a fim de ajustar/pré-treinar os modelos; no entanto, esse processo é caro ou até mesmo impossível se o domínio for novo. Para resolver esse problema, criamos inteligências interativas que utilizam a memória de conhecimento de modelos básicos genéricos (ChatGPT, Dall-E, GPT-4 etc.) para novos cenários, especialmente para gerar espaços colaborativos entre humanos e inteligências. Identificamos um mecanismo emergente - que chamamos de realidade mista com interações de conhecimento e raciocínio - que facilita a colaboração com humanos para resolver tarefas desafiadoras em ambientes complexos do mundo real e a capacidade de explorar ambientes invisíveis para se adaptar à realidade virtual. Para esse mecanismo, as inteligências aprendem i) microrespostas em todas as modalidades: coletando conhecimento individual relevante para cada tarefa de interação a partir de fontes de rede explícitas (por exemplo, para entender cenários inéditos) e inferindo-o implicitamente a partir da saída de um modelo pré-treinado; e ii) macrocomportamentos de maneira independente da realidade: refinando as dimensões e os padrões de interação nos domínios linguístico e multimodal e raciocinando sobre o papel das representações, sobre determinadas variáveis de objetivo, sobre a realidade mista e sobre a diversidade de influência das informações colaborativas no Modelo de Linguagem Grande (LLM). Investigamos a tarefa de sinergias de interação orientadas pelo conhecimento para a geração de cenários em colaboração com vários modelos OpenAI e mostramos como o sistema Interactive Intelligentsia pode aprimorar ainda mais os resultados promissores dos modelos de base em larga escala em nossa configuração. Ele integra e aprimora a profundidade da generalização, a conscientização e a interpretabilidade de sistemas complexos de IA adaptativa.

3 Paradigma de IA do corpo inteligente

Nesta seção, discutiremos um novo paradigma e uma nova estrutura para o treinamento de IA para inteligências. Esperamos atingir vários objetivos com a estrutura proposta:

- -

Usando os modelos de pré-treinamento e as estratégias de pré-treinamento existentes, nossas inteligências são orientadas de forma eficaz para entender modalidades importantes, como entradas textuais ou visuais. - -

Apoiar a capacidade adequada de planejamento de missão de longo prazo. - -

Introdução de uma estrutura mnemônica que permite que o aprendizado seja codificado e recuperado posteriormente. - -

Permite o uso de feedback ambiental para treinar efetivamente as inteligências para que aprendam quais ações devem ser tomadas.

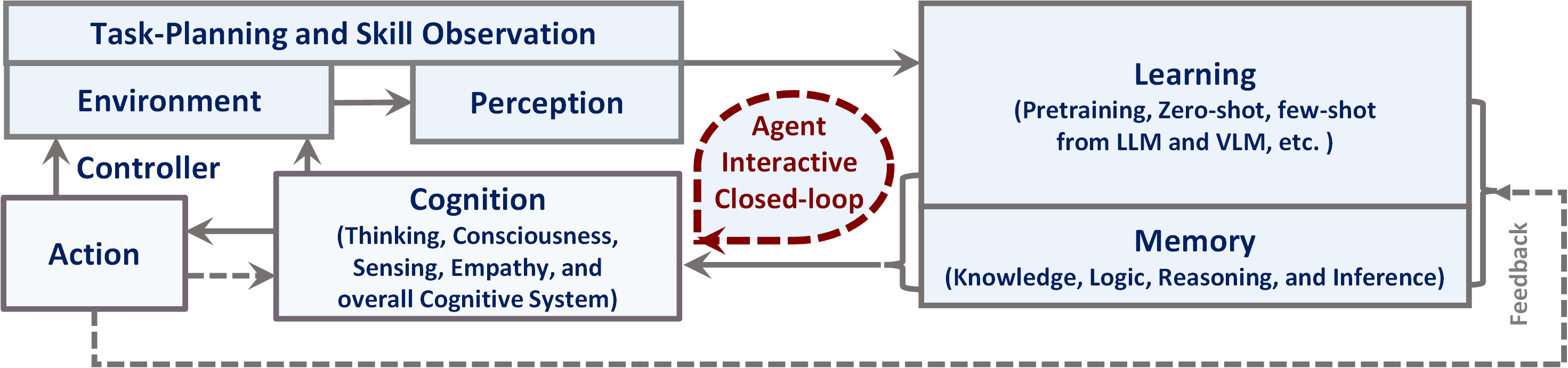

Mostramos um diagrama de alto nível de novas inteligências na Figura 5, delineando os submódulos importantes desse sistema.

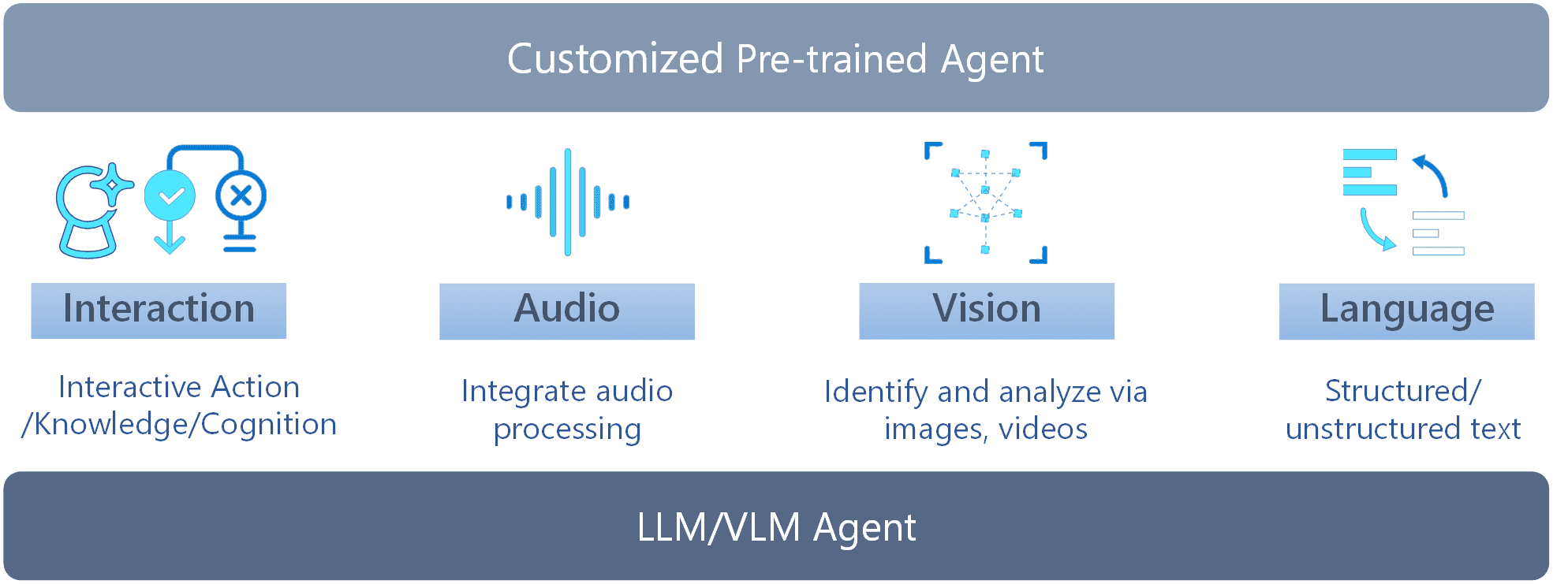

Fig. 5: Nosso novo paradigma de corpo inteligente proposto para inteligências multimodais de propósito geral. Conforme mostrado, há cinco módulos principais: 1) ambiente e percepção, incluindo planejamento de tarefas e observação de habilidades; 2) aprendizado do corpo inteligente; 3) memória; 4) ação do corpo inteligente; e 5) cognição.

3.1 Modelos de linguagem grandes e modelos de linguagem visual

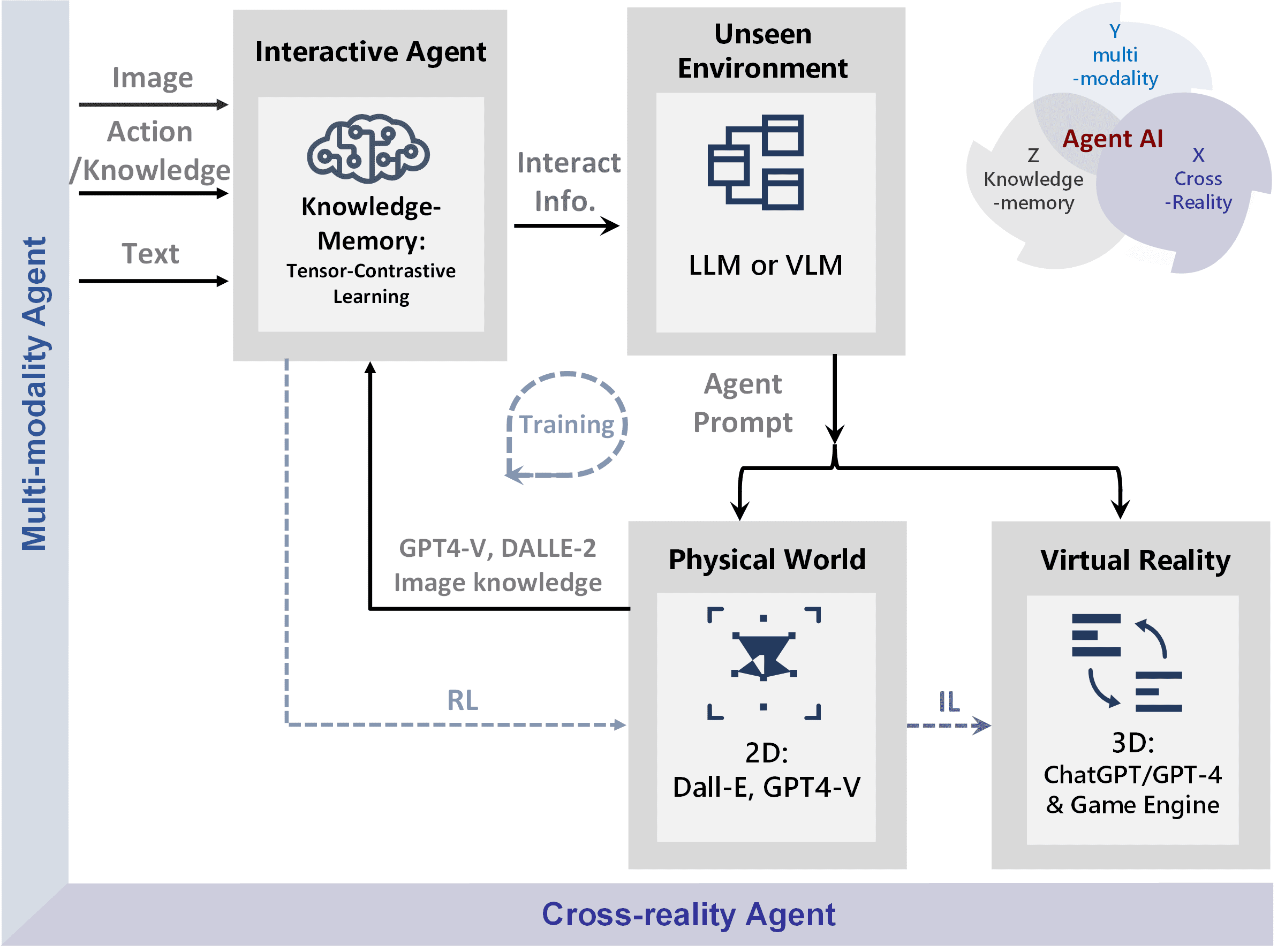

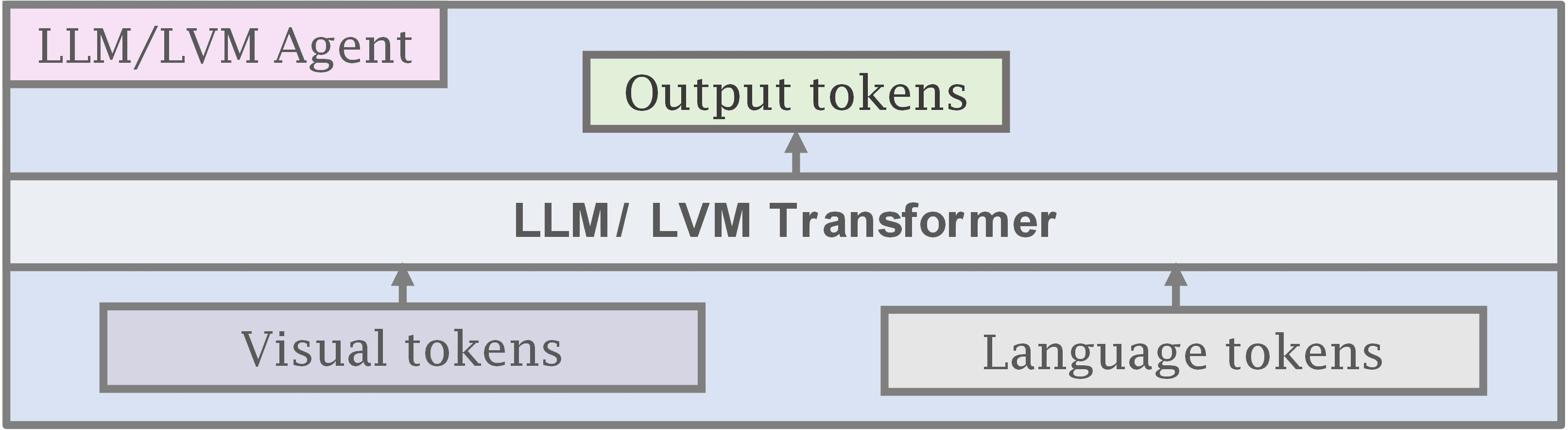

Podemos usar um Modelo de Linguagem Grande (LLM) ou um Modelo de Linguagem Visual (VLM) para inicializar os componentes de um corpo inteligente, conforme mostrado na Figura 5. Em particular, foi demonstrado que os modelos de linguagem grande têm um bom desempenho no planejamento de tarefas Gong et al. (2023a), contêm uma grande quantidade de conhecimento do mundo Yu et al. (2023b) e apresentam um raciocínio lógico impressionante Creswell et al. (2022). Além disso, modelos de linguagem visual como o CLIP Radford et al. (2021) fornecem um codificador visual genérico alinhado à linguagem, além de oferecer recursos de reconhecimento visual de amostra zero. Por exemplo, os modelos multimodais de código aberto de última geração, como o LLaVA Liu et al. (2023c) e o InstructBLIP Dai et al. (2023), dependem do modelo CLIP congelado como codificador visual.

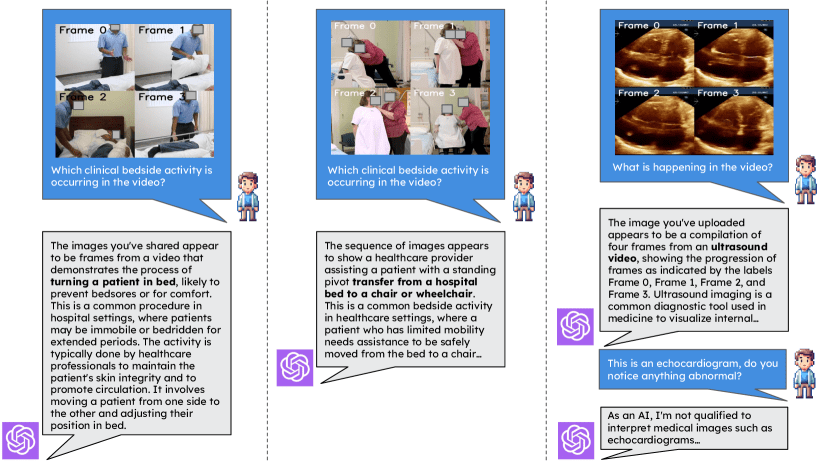

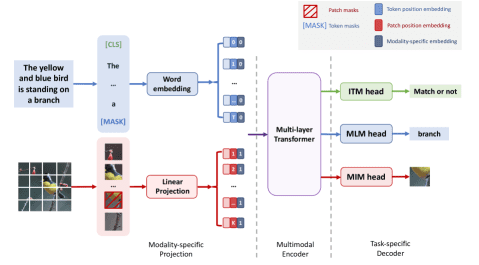

Figura 6: Mostramos o paradigma atual para a criação de inteligências de IA multimodais combinando grandes modelos de linguagem (LLMs) com grandes modelos visuais (LVMs). Em geral, esses modelos recebem informações visuais ou linguísticas e usam modelos visuais e linguísticos pré-treinados e congelados para aprender a conectar e interligar sub-redes menores de modalidades. Os exemplos incluem Flamingo Alayrac et al. (2022), BLIP-2 Li et al. (2023c), InstructBLIP Dai et al. (2023) e LLaVA Liu et al.

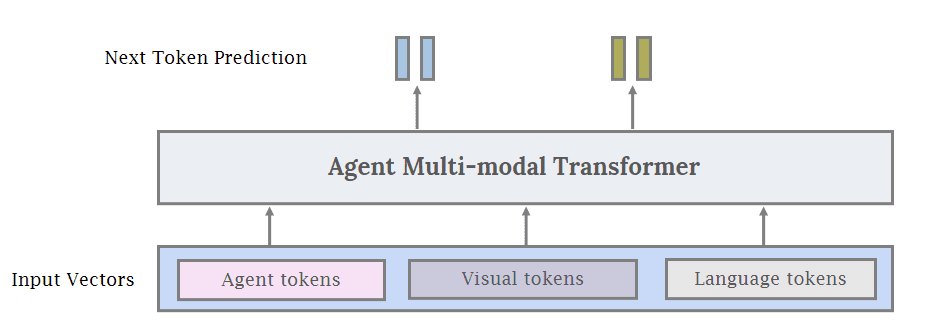

3.2 Definição de transformador de corpo inteligente

Além de usar modelos de macrolinguagem congelados e modelos de linguagem visual como inteligências de IA, também é possível usar uma única inteligência, o modelo Transformer, que combina modelos de linguagem visual e de linguagem visual. Token e o token linguístico como entradas, semelhante a Gato Reed et al. (2022). Além do visual e do linguístico, adicionamos um terceiro tipo genérico de entrada, que denotamos comocorpo inteligente Token: conceitualmente, um Token de corpo inteligente é usado para reservar um subespaço específico para comportamentos de corpo inteligente no espaço de entrada e saída de um modelo. Para robôs ou jogos, isso pode ser representado como o espaço de ação de entrada do controlador. O Token de Corpo Inteligente também pode ser usado ao treinar um corpo inteligente para usar uma ferramenta específica, como um modelo de geração ou edição de imagens, ou para outras chamadas de API, conforme mostrado na Figura 7, onde podemos combinar o Token de Corpo Inteligente com o Token Visual e Linguístico para gerar uma interface unificada para treinamento de IA de corpo inteligente multimodal. O uso do Intelligent Body Transformer tem várias vantagens em relação ao uso de um modelo de linguagem grande e proprietário como um corpo inteligente. Primeiro, o modelo pode ser facilmente personalizado para tarefas muito específicas de corpos inteligentes que podem ser difíceis de representar em linguagem natural (por exemplo, entradas do controlador ou outras ações específicas). Assim, as inteligências podem aprender com as interações ambientais e os dados específicos do domínio para melhorar o desempenho. Em segundo lugar, ao acessar as probabilidades do Token de um corpo inteligente, pode ser mais fácil entender por que um modelo toma ou não toma uma determinada ação. Terceiro, determinados domínios (por exemplo, saúde e direito) têm requisitos rigorosos de privacidade de dados. Por fim, um Intelligent Body Transformer relativamente pequeno pode ser muito mais barato do que um modelo de linguagem proprietário maior.

Figura 7: Modelo de transformador multimodal unificado para a inteligência. Em vez de conectar submódulos congelados e usar modelos básicos existentes como blocos de construção, propomos um paradigma de treinamento unificado de ponta a ponta para sistemas corporais inteligentes. Ainda podemos inicializar submódulos usando o grande modelo de linguagem e o grande modelo de visão na Figura 6, mas também podemos usar Tokens SmartBody, que são tokens especializados usados para treinar modelos para executar comportamentos SmartBody em domínios específicos (por exemplo, robótica). Para obter mais detalhes sobre Tokens SmartBody, consulte a Seção 3.2.

3.3 Criação de um transformador

Conforme mostrado na Figura 5 acima, podemos usar o novo Paradigma do Corpo Inteligente com Corpos Inteligentes guiados por Modelos de Linguagem Grande e Modelos de Linguagem Visual, e usar os dados gerados pelo modelo de base grande para treinar o modelo de Transformação do Corpo Inteligente para aprender a realizar objetivos específicos. No processo, os modelos de corpos inteligentes são treinados para serem adaptados especificamente para tarefas e domínios específicos. Essa abordagem permite que você aproveite os recursos e o conhecimento aprendidos com modelos de base pré-existentes. A seguir, apresentamos uma visão geral simplificada do processo em duas etapas:

Definir metas dentro do domínio.

Para treinar um Intelligent Body Transformer, o objetivo e o espaço de ação do Intelligent Body em cada ambiente específico precisam ser explicitamente definidos. Além disso, quaisquer regras ou procedimentos automatizados que possam ser usados para reconhecer a conclusão bem-sucedida de uma tarefa podem aumentar significativamente a quantidade de dados disponíveis para treinamento. Caso contrário, serão necessários dados gerados pelo modelo básico ou dados anotados manualmente para treinar o modelo. Depois que os dados forem coletados e o desempenho das inteligências puder ser avaliado, o processo de aprimoramento contínuo poderá ser iniciado.

Melhoria contínua.

O monitoramento contínuo do desempenho do modelo e a coleta de feedback são etapas fundamentais do processo. O feedback deve ser usado para aperfeiçoamentos e atualizações adicionais. Também é fundamental garantir que o modelo não perpetue resultados tendenciosos ou antiéticos. Isso requer o exame minucioso dos dados de treinamento, a verificação regular da parcialidade do resultado e, se necessário, o treinamento do modelo para identificar e evitar a parcialidade. Quando o modelo atingir um desempenho satisfatório, ele poderá ser implantado no aplicativo pretendido. O monitoramento contínuo continua sendo essencial para garantir que o modelo tenha o desempenho esperado e para facilitar os ajustes necessários. Consulte a Seção 8 para obter mais detalhes sobre esse processo, fontes de dados de treinamento e mais detalhes sobre o aprendizado contínuo de IA para inteligências.

4 Aprendizado de IA do corpo inteligente

4.1 Estratégias e mecanismos

As estratégias para IA interativa em diferentes domínios estendem o paradigma do uso de inteligências treinadas que buscam ativamente coletar feedback do usuário, informações sobre ações, conhecimento útil para geração e interação para invocar grandes modelos de base. Às vezes, não há necessidade de treinar novamente o modelo de linguagem grande/modelo de linguagem visual, e melhoramos o desempenho das inteligências fornecendo a elas dicas contextuais aprimoradas no momento do teste. Por outro lado, isso sempre envolve a modelagem de interações de conhecimento/raciocínio/senso comum/raciocínio por meio de uma combinação de sistemas ternários - um sistema executa a recuperação de conhecimento a partir de consultas de vários modelos, o segundo executa a geração de interação a partir de inteligências relevantes e o último treina um novo treinamento ou pré-treinamento autossupervisionado rico em informações de forma aprimorada, incluindo aprendizado por reforço ou aprendizado por imitação.

4.1.1 Reforço da aprendizagem (RL)

Há um longo histórico de uso da aprendizagem por reforço (RL) para treinar inteligências interativas que exibem comportamento inteligente. O aprendizado por reforço é um método para aprender a relação ideal entre estados e ações com base nas recompensas (ou punições) recebidas por suas ações. O aprendizado por reforço é uma estrutura altamente escalonável que tem sido aplicada a uma ampla gama de aplicações, incluindo a robótica; no entanto, ele normalmente enfrenta vários problemas de liderança, e os modelos de linguagem grande/modelos de linguagem visual mostraram seu potencial para atenuar ou superar algumas dessas dificuldades:

- Projeto de recompensaA eficiência do aprendizado de estratégia depende muito do design da função de recompensa. O projeto de uma função de recompensa requer não apenas a compreensão do algoritmo de aprendizagem por reforço, mas também um conhecimento profundo da natureza da tarefa e, portanto, geralmente requer o projeto da função com base na experiência de especialistas. Vários estudos exploraram o uso de modelos de linguagem grandes/modelos de linguagem visual para projetar funções de recompensa Yu et al. (2023a); Katara et al. (2023); Ma et al.

- Coleta de dados e eficiência Devido à sua natureza exploratória, o aprendizado de estratégia baseado no aprendizado por reforço requer grandes quantidades de dados Padalkar et al. (2023). A necessidade de grandes quantidades de dados torna-se particularmente evidente quando a estratégia envolve o gerenciamento de sequências longas ou a integração de operações complexas. Isso ocorre porque esses cenários exigem uma tomada de decisão com mais nuances e aprendizado em uma variedade maior de situações. Em estudos recentes, foram feitos esforços para aprimorar a geração de dados para apoiar o aprendizado de estratégias Kumar et al. (2023); Du et al. Além disso, em alguns estudos, esses modelos foram integrados a funções de recompensa para melhorar o aprendizado de estratégias Sontakke et al. (2023). Paralelamente a esses desenvolvimentos, outro estudo se concentrou em obter eficiência de parâmetros no processo de aprendizagem usando modelos de linguagem visual Tang et al. (2023); Li et al. (2023d) e um modelo de linguagem grande Shi et al. (2023).

- passo longitudinal Com relação à eficiência dos dados, o aprendizado por reforço torna-se mais desafiador à medida que o comprimento das sequências de ações aumenta. Isso se deve à relação pouco clara entre ações e recompensas (conhecida como problema de alocação de crédito), bem como ao aumento do número de estados a serem explorados, o que exige uma quantidade significativa de tempo e dados. Uma abordagem típica para tarefas longas e complexas é decompô-las em uma série de submetas e aplicar estratégias pré-treinadas para resolver cada submeta (por exemplo, Takamatsu et al. (2022)). Essa ideia pertence à estrutura de planejamento de tarefas e movimentos (TAMP) de Garrett et al. (2021). O planejamento de tarefas e movimentos consiste em dois componentes principais: planejamento de tarefas, que envolve a identificação de sequências de operações de alto nível, e planejamento de movimentos, que envolve encontrar trajetórias fisicamente consistentes e sem colisões para atingir os objetivos do plano de tarefas. Os modelos de linguagem de grande porte são adequados para o planejamento de tarefas e movimentos, e pesquisas recentes geralmente adotam a abordagem de que o planejamento de tarefas de alto nível é realizado usando modelos de linguagem de grande porte, enquanto o controle de baixo nível é abordado por estratégias baseadas em aprendizagem por reforço Xu et al. (2023); Sun et al. (2023a); Li et al. (2023b); Parakh et al. Os recursos avançados dos modelos de linguagem de grande porte permitem que eles decomponham eficientemente instruções abstratas em submetas Wake et al. (2023c), contribuindo assim para melhorar a compreensão da linguagem em sistemas robóticos.

4.1.2 Aprendizagem por imitação (IL)

Enquanto a aprendizagem por reforço visa a treinar estratégias baseadas na exploração de comportamentos e na maximização das recompensas da interação com o ambiente, a aprendizagem por imitação (IL) visa a usar dados de especialistas para imitar os comportamentos de inteligências ou especialistas experientes. Por exemplo, uma das principais estruturas para a aprendizagem baseada em imitação na robótica é a clonagem comportamental (BC). A clonagem comportamental é um método de treinamento de um robô para imitar as ações de um especialista por meio de cópia direta. Nessa abordagem, as ações de um especialista na execução de uma tarefa específica são registradas e o robô é treinado para replicar essas ações em situações semelhantes. Abordagens recentes baseadas em clonagem comportamental geralmente combinam técnicas do modelo de linguagem grande/modelo de linguagem visual, resultando em modelos mais avançados de ponta a ponta. Por exemplo, Brohan et al. apresentam o RT-1 Brohan et al. (2022) e o RT-2 Brohan et al. (2023), modelos baseados em Transformer que recebem uma série de imagens e linguagem como entrada e sequências de saída de ações de base e braço. Esses modelos apresentam alto desempenho de generalização por terem sido treinados em uma grande quantidade de dados de treinamento.

4.1.3 RGB tradicional

Aprender o comportamento inteligente do corpo usando a entrada de imagens tem sido de interesse há muitos anos Mnih et al. (2015). O desafio inerente ao uso de entrada RGB é a catástrofe da dimensionalidade. Para resolver esse problema, os pesquisadores usaram mais dados Jang et al. (2022); Ha et al. (2023) ou introduziram um viés indutivo no design do modelo para melhorar a eficiência da amostra. Em particular, os autores integram estruturas 3D na arquitetura do modelo usado para manipulação Zeng et al. (2021); Shridhar et al. (2023); Goyal et al. (2023); James e Davison (2022). Para a navegação de robôs, os autores Chaplot et al. (2020a, b) utilizam mapas como representação. Os mapas podem ser aprendidos por redes neurais que agregam todas as entradas RGB anteriores, bem como por métodos de reconstrução 3D, como campos de radiação neural Rosinol et al. (2022).

Para obter mais dados, os pesquisadores usaram simuladores gráficos para sintetizar dados sintéticos Mu et al. (2021); Gong et al. (2023b) e tentaram fechar a lacuna sim2real Tobin et al. (2017); Sadeghi e Levine (2016); Peng et al. (2018). Recentemente, foram feitos esforços conjuntos para curar conjuntos de dados em grande escala com o objetivo de resolver o problema da escassez de dados Padalkar et al. (2023); Brohan et al. Por outro lado, as técnicas de aprimoramento de dados também foram amplamente investigadas a fim de aumentar a complexidade da amostra Zeng et al. (2021); Rao et al. (2020); Haarnoja et al. (2023); Lifshitz et al.

4.1.4 Aprendizado do contexto

A aprendizagem contextual demonstrou ser um método eficaz para resolver tarefas de processamento de linguagem natural usando grandes modelos de linguagem como o GPT-3 Brown et al. (2020); Min et al. (2022). Ao fornecer exemplos de tarefas no contexto dos prompts do modelo de linguagem grande, pode-se ver que os prompts com menos amostras são uma maneira eficaz de contextualizar a saída do modelo em uma variedade de tarefas no processamento de linguagem natural. Fatores como a variedade de exemplos e a qualidade dos exemplos apresentados no contexto podem melhorar a qualidade da saída do modelo An et al. (2023); Dong et al. (2022). No contexto de modelos de base multimodal, quando apenas um pequeno número de exemplos é fornecido, modelos como Flamingo e BLIP-2 Alayrac et al. (2022); Li et al. (2023c) demonstraram ser eficazes em uma ampla variedade de tarefas de compreensão visual. A aprendizagem contextual de inteligências no ambiente pode ser aprimorada ainda mais com a integração de feedback específico do contexto quando determinadas ações são realizadas Gong et al. (2023a).

4.1.5 Otimização em sistemas corporais inteligentes

A otimização de sistemas de corpos inteligentes pode ser dividida em aspectos espaciais e temporais. A otimização espacial considera como os corpos inteligentes operam no espaço físico para realizar tarefas. Isso inclui a coordenação entre robôs, a alocação de recursos e a manutenção de um espaço organizado.

Para otimizar efetivamente os sistemas de IA de corpos inteligentes, especialmente aqueles em que um grande número de inteligências opera em paralelo, os trabalhos anteriores se concentraram no uso do aprendizado por reforço de alto volume Shacklett et al. (2023). Como os conjuntos de dados de interação de corpos multiinteligentes específicos de tarefas são raros, o aprendizado por reforço de autojogo permite que as equipes de corpos inteligentes melhorem com o tempo. No entanto, isso também pode levar a inteligências muito frágeis que só podem funcionar em jogos automáticos e não com seres humanos ou outras inteligências independentes, porque elas se ajustam demais ao paradigma de treinamento de jogos automáticos. Para resolver esse problema, podemos descobrir um conjunto de convenções diferentes, Cui et al. (2023); Sarkar et al. (2023) e treinar uma inteligência que entenda as várias convenções. O modelo básico pode ajudar ainda mais a estabelecer convenções com humanos ou outras inteligências independentes, permitindo assim uma coordenação suave com novas inteligências.

Por outro lado, a otimização temporal concentra-se em como as inteligências executam as tarefas ao longo do tempo. Isso inclui a programação de tarefas, o sequenciamento e a eficiência da linha do tempo. Por exemplo, a otimização da trajetória de um braço robótico é um exemplo de otimização eficiente do movimento entre tarefas sucessivas Zhou et al. (2023c). No nível de programação de tarefas, algoritmos como LLM-DP Dagan et al. (2023) e ReAct Abordagens como a de Yao et al. (2023a) tratam do planejamento eficaz de tarefas por meio da integração interativa de fatores ambientais.

4.2 Sistemas de agentes (níveis de amostragem zero e poucos)

4.2.1 Módulo do agente

Nossa exploração inicial do paradigma do agente envolveu o desenvolvimento de "módulos" de IA de agente para agentes multimodais interativos usando o Modelo de Linguagem Grande (LLM) ou o Modelo de Linguagem Visual (VLM). Nossos módulos iniciais de agente contribuem para o treinamento ou a aprendizagem contextual e têm um design minimalista destinado a demonstrar a capacidade de um agente de programar e coordenar com eficiência. Também exploramos técnicas iniciais de memória baseadas em dicas que ajudam a melhorar o planejamento e informam futuros métodos de ação no campo. Para ilustrar isso, nossa infraestrutura "MindAgent" consiste em cinco módulos principais: 1) Consciência do ambiente com planejamento de tarefas, 2) Aprendizagem do agente, 3) Memória, 4) Previsão de ações genéricas do agente e 5) Cognição, conforme mostrado na Figura 5.

4.2.2 Infraestrutura do agente