Tabela de classificação do agente: Tabela de classificação da avaliação de desempenho do agente de IA

Introdução geral

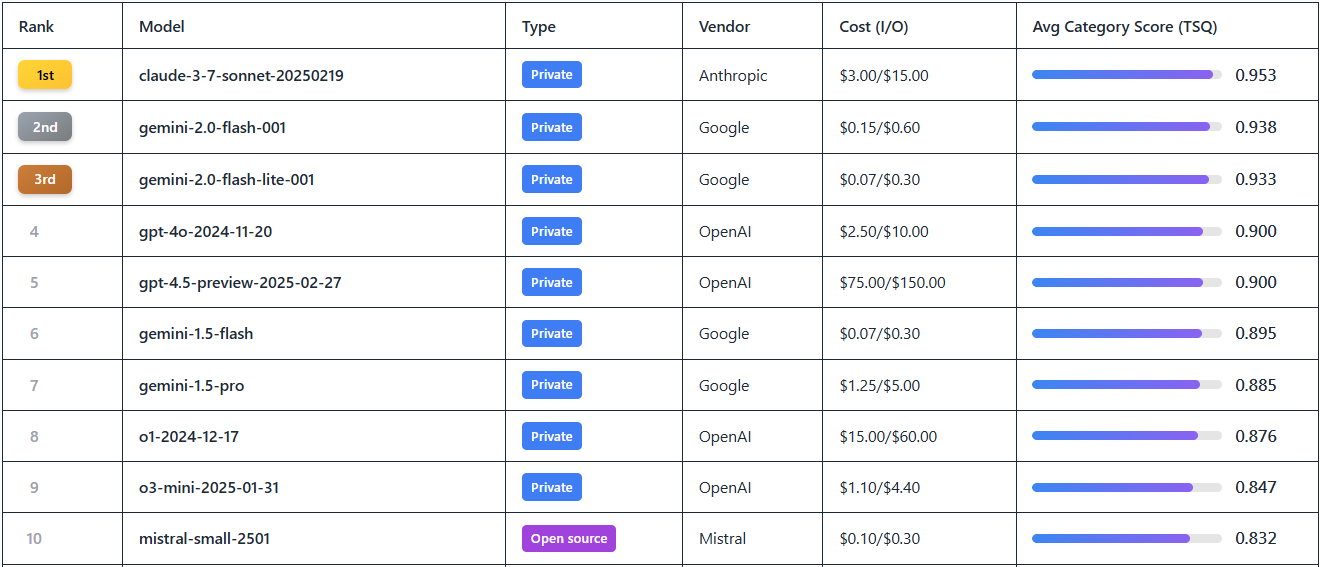

O Agent Leaderboard é uma ferramenta on-line voltada para a avaliação de desempenho de agentes de IA lançada pela Galileo AI na plataforma Hugging Face. Ela testa 17 dos principais modelos de linguagem grande (LLMs), abrangendo cenários que vão de simples chamadas de API a interações complexas com várias ferramentas, combinando vários conjuntos de dados confiáveis (por exemplo, BFCL, τ-bench, xLAM e ToolACE). O site tem como objetivo responder à pergunta "Qual é o desempenho dos agentes de IA em cenários comerciais reais?" e ajudar os desenvolvedores e as empresas a escolher o modelo certo para suas necessidades. A tabela de classificação é atualizada mensalmente e permite a visualização de classificações de modelos, pontuações, custos e outras informações para equipes que precisam criar um sistema eficiente de agentes de IA. Os usuários podem comparar visualmente o desempenho de modelos de código aberto e privados aqui. Exibir relatórios de análise:Hugging Face lança classificações corporais de inteligência de agentes: quem é o líder em chamadas de ferramentas?

Lista de funções

- Classificação do desempenho do modeloExibe as classificações dos 17 principais LLMs, como Gemini-2.0 Flash, GPT-4o, etc., com base nas pontuações de Qualidade de Seleção de Ferramentas (TSQ).

- Dados de avaliação multidimensionalFornece resultados de testes entre domínios, abrangendo mais de 390 cenários, como matemática, varejo, aviação, interações de API e muito mais.

- Custo vs. eficiência:: Demonstrar por milhão para cada modelo token Custo (por exemplo, Gemini-2.0 Flash $0.15 vs. GPT-4o $2.5) para análise de preço/desempenho.

- Ferramentas de filtragem e visualizaçãoSuporte para filtragem de modelos por fornecedor, status de código aberto/privado, pontuação, etc., para localizar rapidamente as informações necessárias.

- Acesso de código aberto a conjuntos de dados:: Fornecer links para download de conjuntos de dados de teste para que os desenvolvedores possam estudá-los e validá-los.

- Mecanismo de atualização dinâmicaAtualização mensal da tabela de classificação para sincronizar os últimos lançamentos de modelos e dados de desempenho.

Usando a Ajuda

Como acessar e usar

O Agent Leaderboard é uma ferramenta on-line que não requer instalação e permite que os usuários simplesmente abram um navegador, visitem o https://huggingface.co/spaces/galileo-ai/agent-leaderboard Pronto para usar. Assim que a página é carregada, você é recebido com uma tabela de classificação intuitiva que permite navegar por todos os dados disponíveis publicamente sem se registrar ou fazer login. Para um envolvimento mais aprofundado (como baixar conjuntos de dados ou fazer sugestões), você pode se inscrever em uma conta do Hugging Face.

fluxo de trabalho

- Navegue pelos gráficos

- Quando você abre a página, a primeira página exibe os 17 principais modelos de LLM atuais por padrão.

- As colunas da tabela incluem Classificação, Modelo, Fornecedor, Pontuação, Custo e Tipo (código-fonte aberto/privado). Score", "Cost" e "Type (Open Source/Private)".

- Exemplo: O Gemini-2.0 Flash nº 1 do ranking com uma pontuação de 0,9+ e um custo de $0,15/milhão de tokens.

- Modelos de triagem e comparação

- Clique nas caixas de filtro na parte superior da tabela para selecionar "Vendor" (por exemplo, Google, OpenAI), "Type" (Open Source ou Private) ou "Score Range".

- Por exemplo, ao digitar "OpenAI", a página filtrará modelos como GPT-4o, o1 e assim por diante, para que seja fácil comparar seu desempenho.

- Para ver a relação custo-benefício, classifique pela coluna "Custo" para encontrar a opção mais barata.

- Visualizar dados detalhados da avaliação

- Clicar em qualquer nome de modelo (por exemplo, Gemini-1.5-Pro) exibirá um relatório de desempenho específico.

- O relatório inclui o desempenho do modelo em diferentes conjuntos de dados, por exemplo, a pontuação do cenário de varejo no τ-bench, a pontuação de interação da API no ToolACE, etc.

- Os dados são apresentados em forma de gráfico para visualizar os pontos fortes e fracos do modelo em tarefas com várias ferramentas ou cenários de contexto longo.

- Download de conjuntos de dados de código aberto

- Na parte inferior da página, há um link "Dataset" (Conjunto de dados), clique nele para ir para

https://huggingface.co/datasets/galileo-ai/agent-leaderboard. - Os usuários podem fazer download de conjuntos de dados de teste completos (por exemplo, bancos de questões de matemática para BFCL, dados de domínio cruzado para xLAM) para análise local ou desenvolvimento secundário.

- Para fazer o download, você precisa entrar na sua conta do Hugging Face. Se não tiver uma conta, você pode se inscrever clicando em "Sign Up" (Inscreva-se) no canto superior direito da página.

- Na parte inferior da página, há um link "Dataset" (Conjunto de dados), clique nele para ir para

- Obter atualizações

- A tabela de classificação promete ser atualizada mensalmente, e siga o blog oficial da Galileo AI (link no final da página) para ser notificado sobre as últimas adições de modelos.

- Por exemplo, solicitações recentes de usuários na comunidade para participar Claude 3.7 Soneto e Grok 3, respostas oficiais serão adicionadas assim que a API estiver disponível.

Funções em destaque

- Interpretação dos escores de qualidade de seleção de ferramentas (TSQ)

- O TSQ é a métrica de avaliação principal do Agent Leaderboard que mede a precisão do modelo no uso da ferramenta.

- Exemplo de operação: selecione GPT-4o e veja sua pontuação TSQ de 0,9, com itens de linha mostrando que ele tem um bom desempenho em tarefas colaborativas com várias ferramentas, mas é um pouco mais fraco em cenários de contexto longo.

- Recomendação de uso: Se o seu projeto envolver fluxos de trabalho complexos, escolha um modelo com um TSQ superior a 0,85.

- Análise dos resultados de testes de vários domínios

- Clique em "Evaluation Details" para ver o desempenho do modelo em 14 testes de benchmark.

- Exemplo: o Gemini-2.0 Flash obteve 0,92 em BFCL (matemática e educação) e 0,89 em ToolACE (interação com API).

- Cenário de uso: as equipes que precisam lidar com dados de aviação podem consultar os resultados do τ-bench para selecionar modelos especializados nessa área.

- Tomada de decisões com otimização de custos

- Veja o preço de entrada/saída por milhão de tokens na coluna "Custo" da tabela.

- Exemplo: Filtro "Custo < $1" e o resultado mostra Mistral-small-2501 ($0,5/milhão de tokens), que é adequado para projetos com orçamento limitado.

- Dica: Equilibre o desempenho e as despesas combinando a pontuação e o custo.

advertência

- Tempo de atualização de dados: Os dados atuais são de fevereiro de 2025, e é recomendável visitá-los regularmente para obter as classificações mais atualizadas.

- Feedback da comunidadeSe você precisar de um novo modelo (por exemplo, Grok 3), deixe uma mensagem na página do Hugging Face e a resposta oficial será baseada na disponibilidade da API.

- Requisitos técnicosA página da Web tem poucos requisitos de rede, mas é necessária uma conexão estável para fazer o download do conjunto de dados, e recomenda-se a operação em desktop.

Com essas etapas, os usuários podem começar a usar rapidamente o Agent Leaderboard, uma ferramenta que oferece suporte prático, quer estejam procurando modelos de alto desempenho ou pesquisando os detalhes técnicos dos agentes de IA.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...