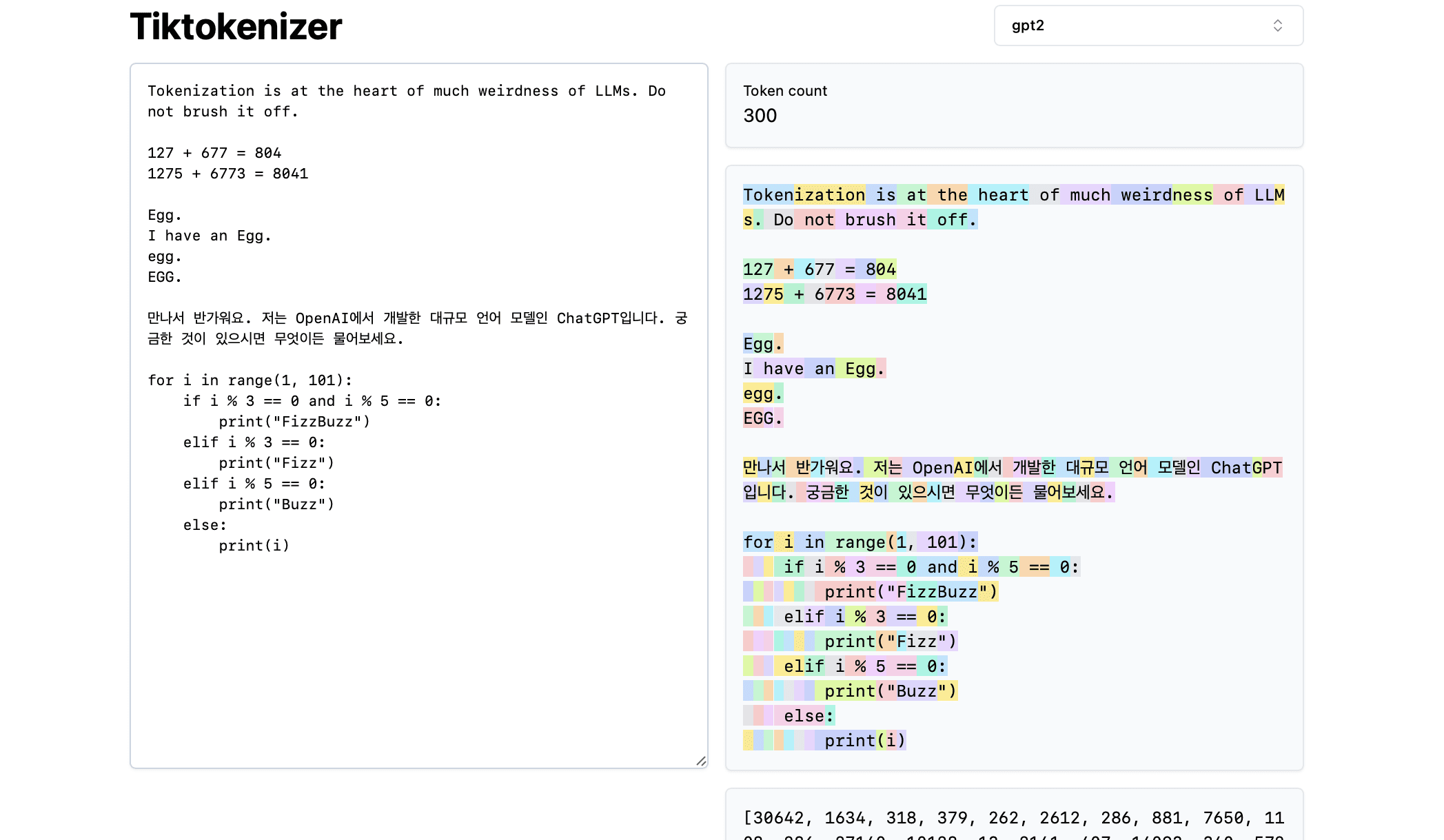

2024 Inventário RAG, estratégia de aplicativo RAG 100+

Olhando para 2024, os grandes modelos estão mudando a cada dia, e centenas de corpos inteligentes estão competindo. Como uma parte importante dos aplicativos de IA, o RAG também é um "grupo de heróis e vassalos". No início do ano, o ModularRAG continua a esquentar, o GraphRAG brilha, no meio do ano, as ferramentas de código aberto estão em pleno andamento, os gráficos de conhecimento criam novas oportunidades e, no final do ano, a compreensão de gráficos e o RAG multimodal iniciam uma nova jornada, então é quase como "você está cantando e eu estou aparecendo no palco", e técnicas estranhas estão surgindo, e a lista continua!

Selecionei sistemas e documentos típicos do RAG para 2024 (com notas de IA, fontes e informações resumidas), e incluí uma visão geral do RAG e material de benchmarking de teste no final do documento, e espero implementar este documento, que tem 16.000 palavras, para ajudá-lo a passar rapidamente pelo RAG.

O texto completo de 72 artigos, mês a mês, como um esboço, fortemente chamado de "estilo RAG 72", para oferecer a você.

Observações:

Todo o conteúdo deste artigo foi hospedado no repositório de código aberto Awesome-RAG. Fique à vontade para enviar PRs para verificar se há lacunas.

Endereço do GitHub: https://github.com/awesome-rag/awesome-rag

(01) GraphReader [Especialista em gráficos]

Especialistas em gráficosÉ como um tutor que é bom em fazer mapas mentais, transformando um texto longo em uma rede de conhecimento clara, de modo que a IA possa encontrar facilmente os pontos-chave necessários para a resposta, como se estivesse explorando um mapa, superando efetivamente o problema de "se perder" ao lidar com textos longos.

- Hora: 01.20

- Tese: GraphReader: Construção de um agente baseado em gráficos para aprimorar as capacidades de contexto longo de modelos de linguagem grandes

O GraphReader é um sistema de inteligências baseado em gráficos projetado para processar textos longos, construindo-os em um gráfico e usando inteligências para explorar esse gráfico de forma autônoma. Ao receber um problema, o corpo inteligente primeiro executa uma análise passo a passo e desenvolve um plano razoável. Em seguida, ele chama um conjunto de funções predefinidas para ler o conteúdo dos nós e seus vizinhos, facilitando uma exploração grosseira a fina do gráfico. Durante todo o processo de exploração, o corpo inteligente registra continuamente novas percepções e reflete sobre a situação atual para otimizar o processo até que tenha reunido informações suficientes para gerar uma resposta.

(02) MM-RAG [Multifacetado]

pessoa versátilVisão e audição: É como um sistema polivalente que pode ser proficiente em visão, audição e linguagem ao mesmo tempo, não apenas compreendendo diferentes formas de informação, mas também alternando e correlacionando entre elas livremente. Por meio da compreensão abrangente de várias informações, ele pode fornecer serviços mais inteligentes e naturais em vários campos, como recomendação, assistente e mídia.

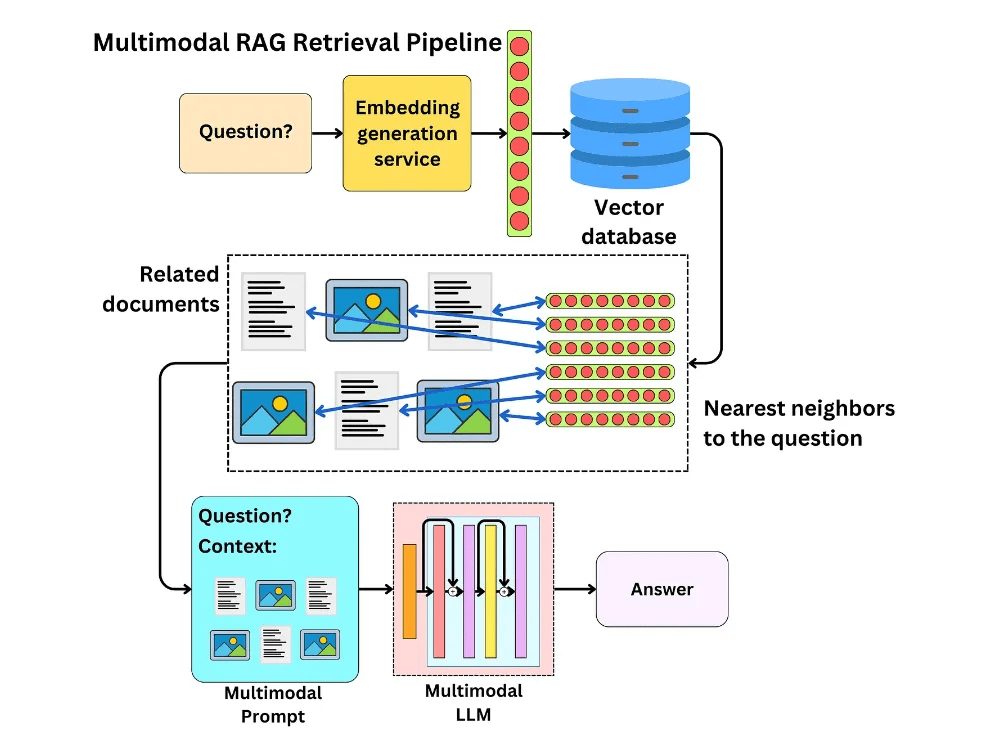

São apresentados os desenvolvimentos no aprendizado de máquina multimodal, incluindo aprendizado comparativo, pesquisa modal arbitrária implementada por incorporação multimodal, geração aumentada de recuperação multimodal (MM-RAG) e como usar bancos de dados vetoriais para criar sistemas de produção multimodal. As tendências futuras da IA multimodal também são exploradas, destacando suas aplicações promissoras em áreas como sistemas de recomendação, assistentes virtuais, mídia e comércio eletrônico.

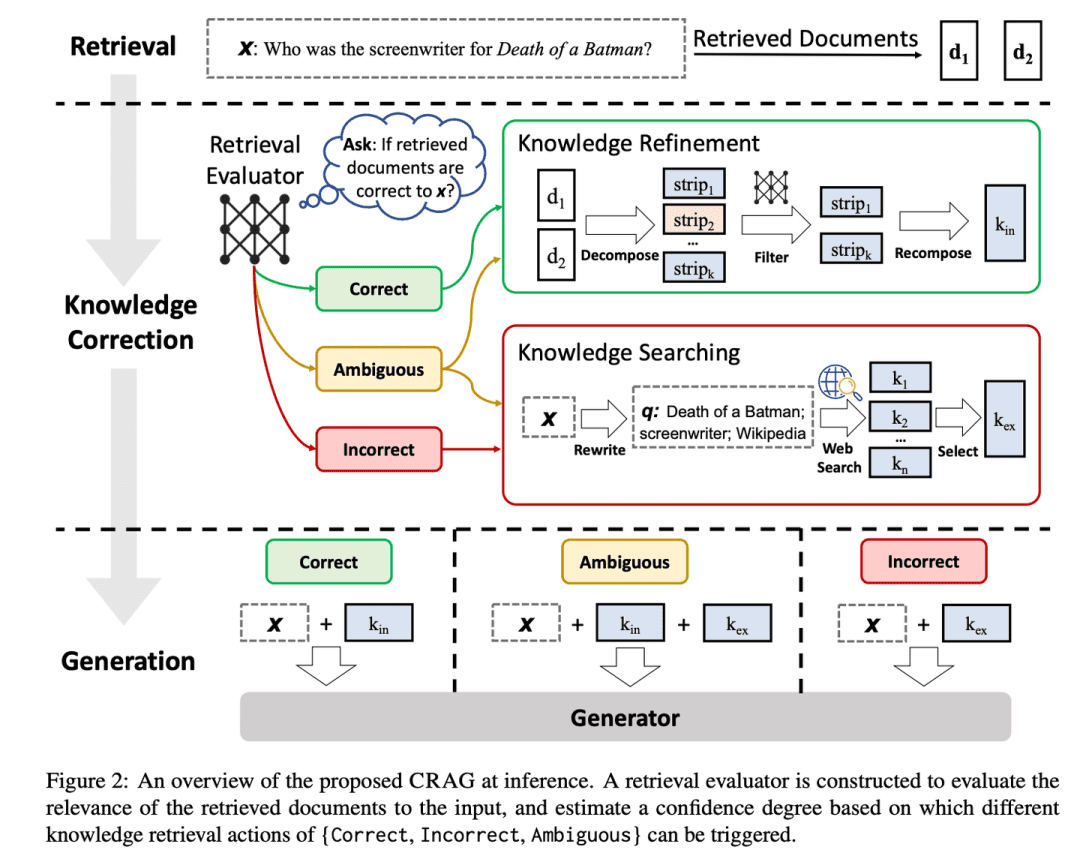

(03) CRAG [autocorreção]

autocorreçãoComo um editor experiente, ele examina as informações preliminares de maneira simples e rápida, depois amplia as informações pesquisando na Web e, por fim, garante que o conteúdo final apresentado seja preciso e confiável, desmontando-o e reorganizando-o. É como colocar um sistema de controle de qualidade no RAG para tornar o conteúdo que ele produz mais confiável.

- Hora: 01.29

- Tese: Corretiva Recuperação Geração aumentada

- Projeto: https://github.com/HuskyInSalt/CRAG

O CRAG aprimora a qualidade dos documentos recuperados projetando um avaliador de recuperação leve e introduzindo a pesquisa na Web em larga escala, além de refinar as informações recuperadas por meio de algoritmos de decomposição e reorganização para aumentar a precisão e a confiabilidade do texto gerado. O CRAG é um complemento útil e um aprimoramento da técnica RAG existente, que aumenta a robustez do texto gerado por meio da autocorreção dos resultados da recuperação.

(04) RAPTOR [generalização hierárquica]

resumo hierárquicoComo um bibliotecário bem organizado, o conteúdo do documento é organizado em uma estrutura de árvore de baixo para cima, permitindo que a recuperação de informações se mova de forma flexível entre diferentes níveis, tanto em termos de uma visão geral quanto de detalhes aprofundados.

- Hora: 01.31

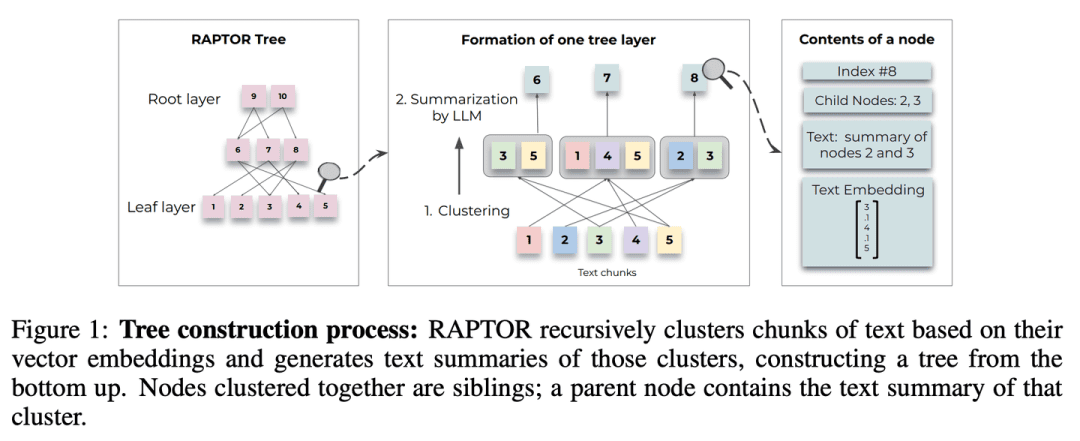

- Tese: RAPTOR: Recursive Abstractive Processing for Tree-Organised Retrieval

- Projeto: https://github.com/parthsarthi03/raptor

O RAPTOR (Recursive Abstractive Processing for Tree-Organised Retrieval) apresenta um novo método de incorporação recursiva, agrupamento e resumo de blocos de texto para criar árvores com diferentes níveis de resumo de baixo para cima. No momento da inferência, o modelo RAPTOR faz a recuperação a partir dessa árvore, integrando informações de documentos longos com diferentes níveis de abstração.

(05) T-RAG [conselheiro particular]

conselheiro particularComo um consultor interno familiarizado com as estruturas organizacionais, ele é hábil em organizar informações usando uma estrutura em árvore para fornecer serviços localizados de forma eficiente e econômica, protegendo a privacidade.

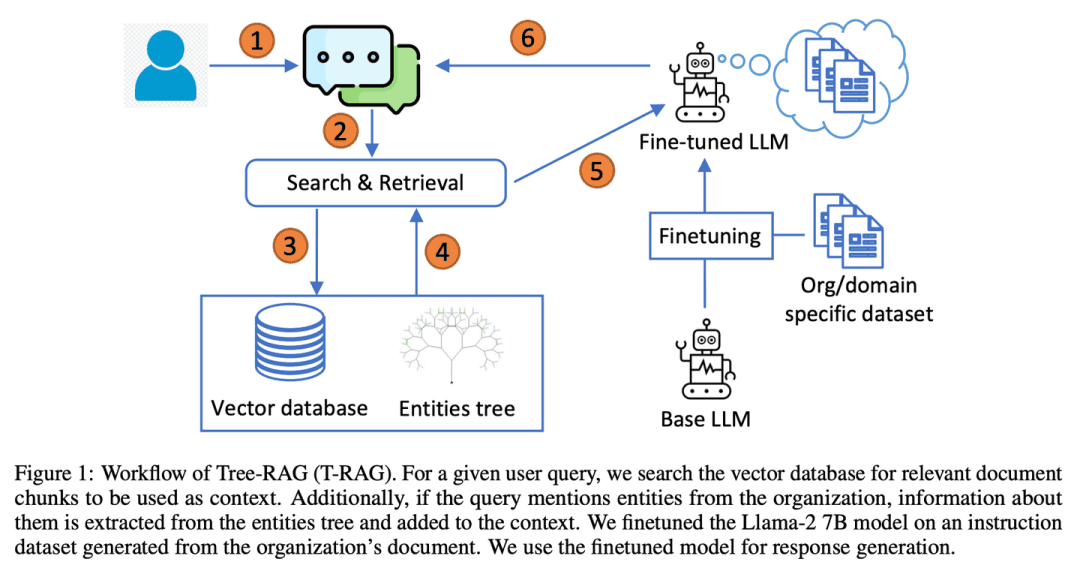

- Tese: T-RAG: Lições das trincheiras do LLM

O T-RAG (Tree Retrieval Augmentation Generation) combina o RAG com LLMs de código aberto ajustados, usando estruturas de árvore para representar hierarquias de entidades em contextos de aumento de organizações, aproveitando modelos de código aberto hospedados localmente para tratar de questões de privacidade de dados e, ao mesmo tempo, abordar a latência de inferência, os custos de uso de tokens e os problemas de disponibilidade regional e geográfica.

(06) RAT [Pensador]

pensadorComo um tutor reflexivo, em vez de chegar a uma conclusão de uma só vez, você começa com as ideias iniciais e, em seguida, usa as informações relevantes recuperadas para revisar e refinar continuamente cada etapa do processo de raciocínio para tornar a cadeia de pensamento mais rígida e confiável.

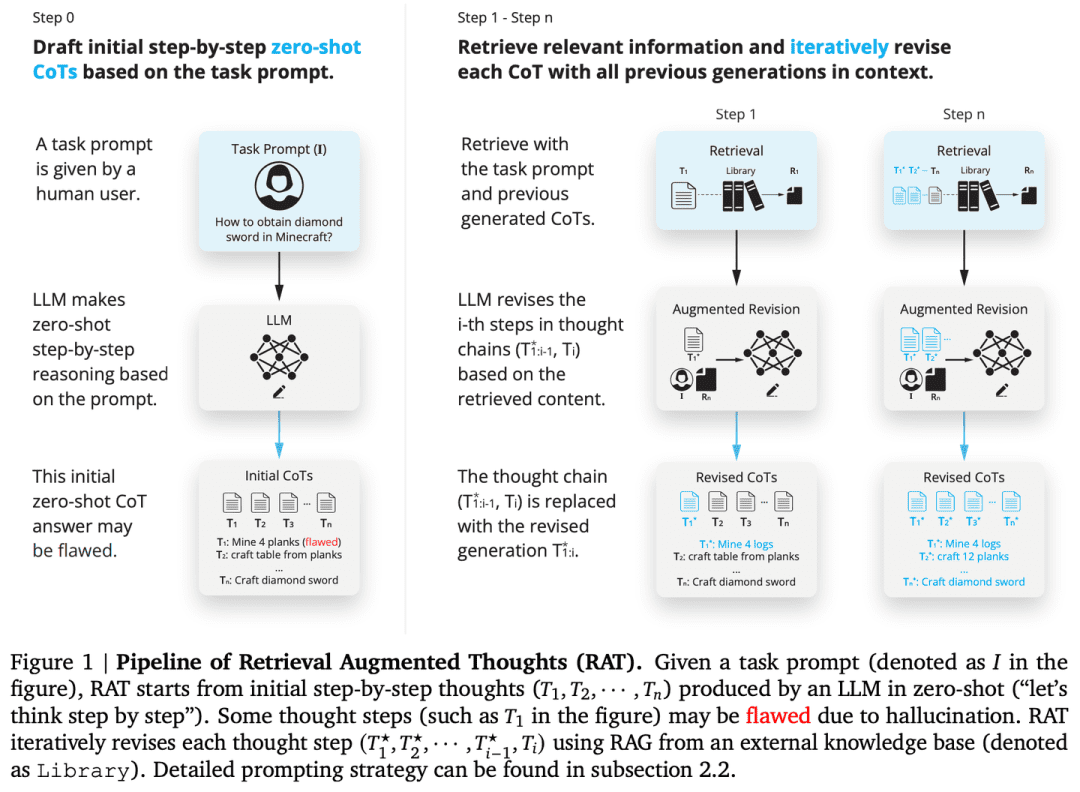

- Tese: RAT: Retrieval Augmented Thoughts (Pensamentos Aumentados de Recuperação) Solicite Raciocínio sensível ao contexto na geração de longo prazo

- Projeto: https://github.com/CraftJarvis/RAT

RAT (Retrieval Augmented Thinking) Depois de gerar uma cadeia inicial de pensamentos (CoT) de amostra zero, cada etapa de pensamento é revisada individualmente usando informações recuperadas relacionadas à consulta da tarefa, etapas de pensamento atuais e passadas, e o RAT melhora significativamente o desempenho em uma ampla variedade de tarefas de geração de longo prazo.

(07) RAFT [Mestre do Livro Aberto]

mestre em abrir livrosComo um bom candidato, você não apenas encontrará as referências corretas, mas também citará os principais elementos com precisão e explicará o processo de raciocínio com clareza para que a resposta seja baseada em evidências e sensata.

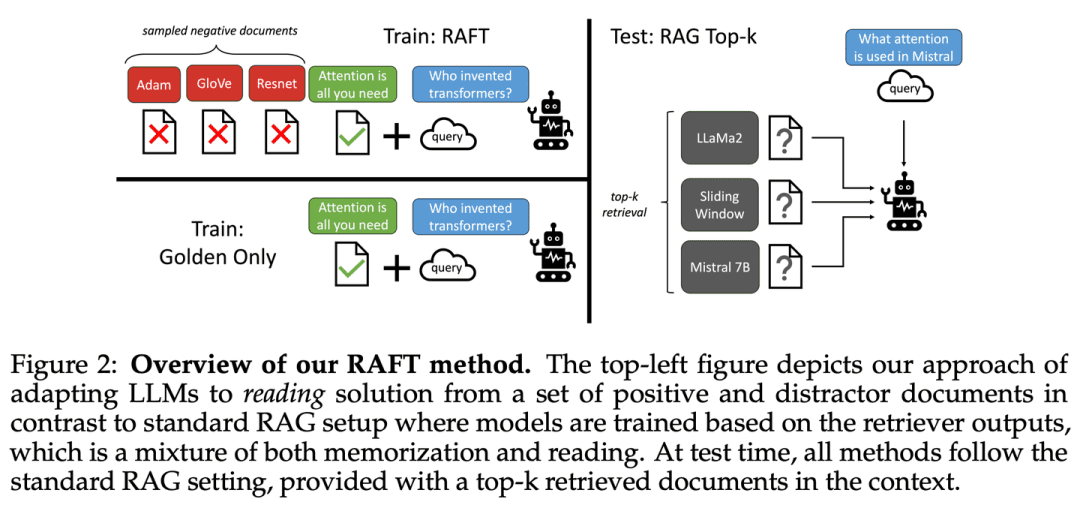

- Tese: RAFT: Adaptação do modelo de linguagem a um domínio específico RAG

O RAFT tem como objetivo aprimorar a capacidade de um modelo de responder a perguntas em um ambiente de "livro aberto" específico de um domínio, treinando o modelo para ignorar documentos irrelevantes e responder a perguntas citando literalmente as sequências corretas dos documentos relevantes, o que, em combinação com respostas de encadeamento de pensamento, melhora significativamente a capacidade de raciocínio do modelo.

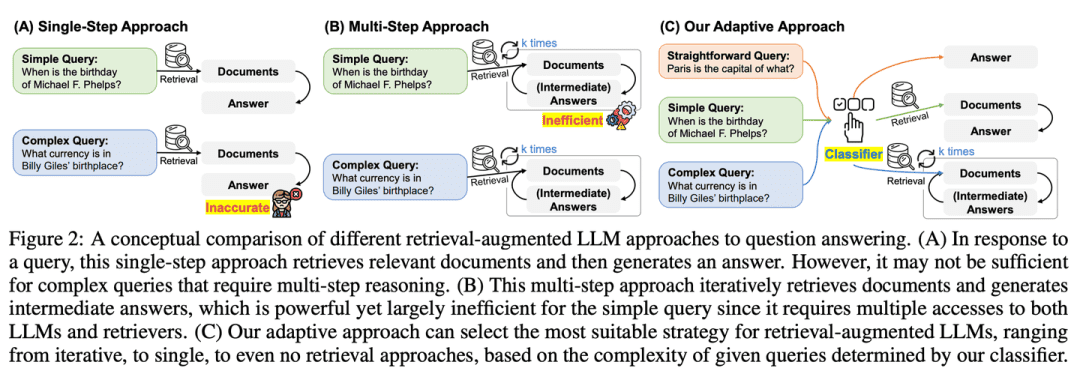

(08) Adaptive-RAG [Alcançando a pessoa certa para o trabalho certo]

(expressão idiomática) ensinar de acordo com a capacidade do alunoQuando confrontado com perguntas de diferentes dificuldades, ele escolherá de forma inteligente a resposta mais adequada. As perguntas simples serão respondidas diretamente, enquanto as perguntas complexas serão respondidas com mais informações ou raciocínio passo a passo, exatamente como um professor experiente que sabe como ajustar o método de ensino de acordo com os problemas específicos dos alunos.

- Tese: Adaptive-RAG: Aprendendo a adaptar modelos de linguagem grandes e aumentados para recuperação por meio da complexidade da pergunta

- Projeto: https://github.com/starsuzi/Adaptive-RAG

O Adaptive-RAG seleciona dinamicamente a estratégia de aprimoramento de recuperação mais adequada para o LLM com base na complexidade da consulta, selecionando dinamicamente a estratégia mais adequada para o LLM, da mais simples à mais complexa. Esse processo de seleção é implementado por meio de um pequeno classificador de modelo de linguagem que prevê a complexidade da consulta e coleta automaticamente rótulos para otimizar o processo de seleção. Essa abordagem fornece uma estratégia equilibrada que se adapta perfeitamente entre LLMs iterativos e aprimorados por recuperação de etapa única, bem como métodos sem recuperação para uma variedade de complexidades de consulta.

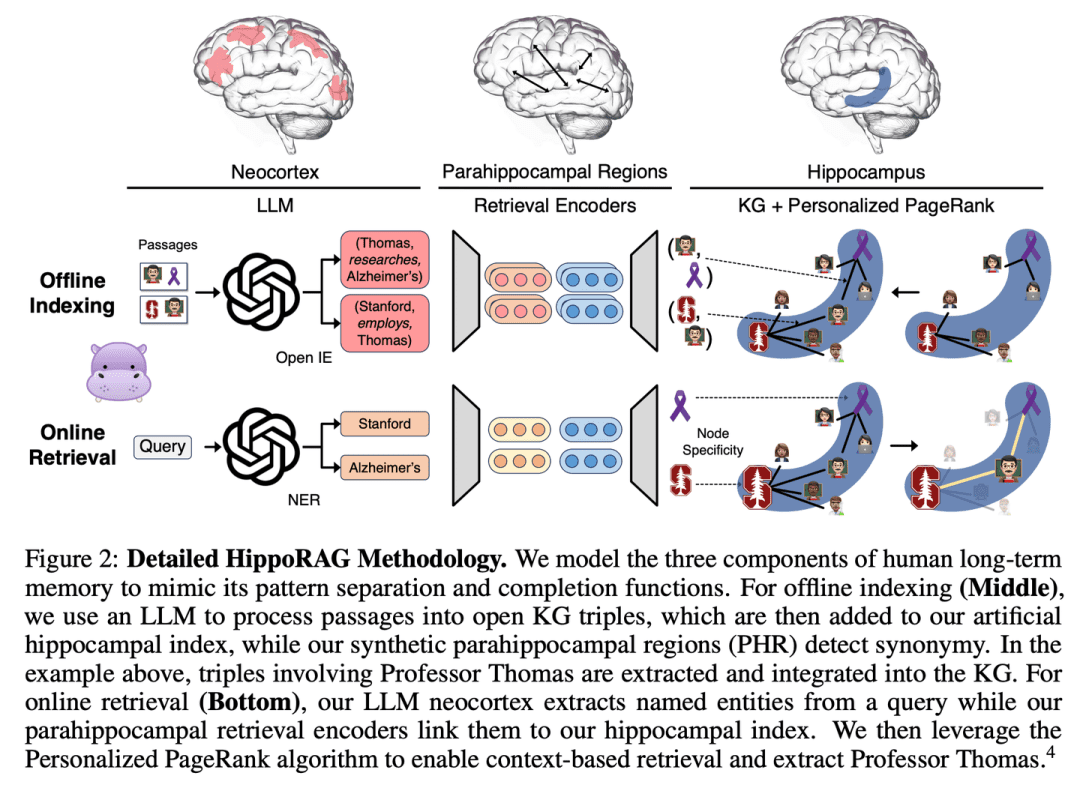

(09) HippoRAG [hipocampo]

hipocampoComo o corpo equino da mente humana, o conhecimento antigo e o novo são habilmente entrelaçados em uma teia. Não se trata apenas de acumular informações, mas de permitir que cada novo conhecimento encontre seu lugar mais apropriado.

- Tese: HippoRAG: Memória de longo prazo inspirada neurobiologicamente para modelos de linguagem grandes

- Projeto: https://github.com/OSU-NLP-Group/HippoRAG

O HippoRAG é uma nova estrutura de recuperação inspirada na teoria de indexação do hipocampo da memória humana de longo prazo, com o objetivo de permitir uma integração de conhecimento mais profunda e eficiente de novas experiências. O HippoRAG orquestra sinergicamente LLMs, gráficos de conhecimento e algoritmos PageRank personalizados para imitar as diferentes funções do neocórtex e do hipocampo na memória humana.

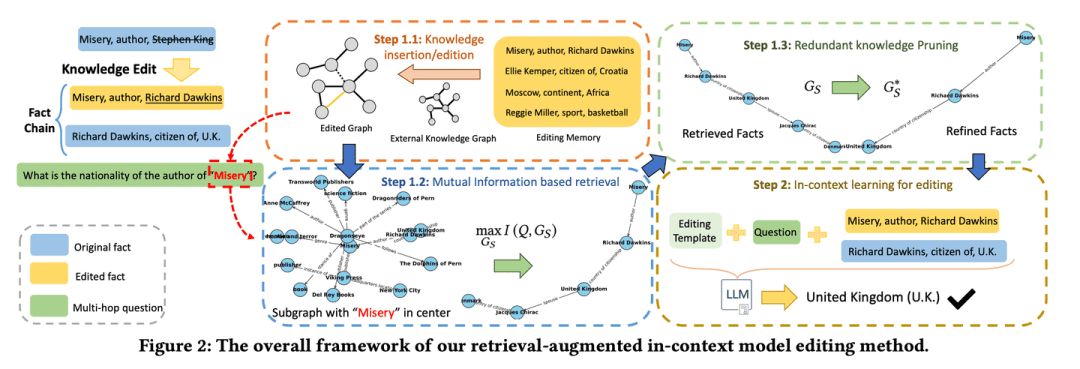

(10) RAE [edição inteligente]

editor inteligente (software)Como um editor de notícias cuidadoso, ele não apenas se aprofundará nos fatos relevantes, mas também descobrirá as principais informações que podem ser facilmente ignoradas pelo raciocínio em cadeia e, ao mesmo tempo, saberá como cortar o conteúdo redundante para garantir que as informações finais apresentadas sejam precisas e concisas, evitando o problema de "falar muito, mas não ser confiável".

- Tese: Edição de conhecimento aprimorada por recuperação em modelos de linguagem para resposta a perguntas em várias etapas

- Projeto: https://github.com/sycny/RAE

O RAE (Multi-hop Q&A Retrieval Enhanced Model Editing Framework) primeiro recupera fatos editados e, em seguida, otimiza o modelo de linguagem por meio da aprendizagem contextual. A abordagem de recuperação baseada na maximização de informações mútuas aproveita o poder de raciocínio do grande modelo de linguagem para identificar fatos encadeados que podem ser perdidos por pesquisas tradicionais baseadas em similaridade. Além disso, a estrutura inclui uma estratégia de poda para eliminar informações redundantes dos fatos recuperados, o que melhora a precisão da edição e atenua o problema da ilusão.

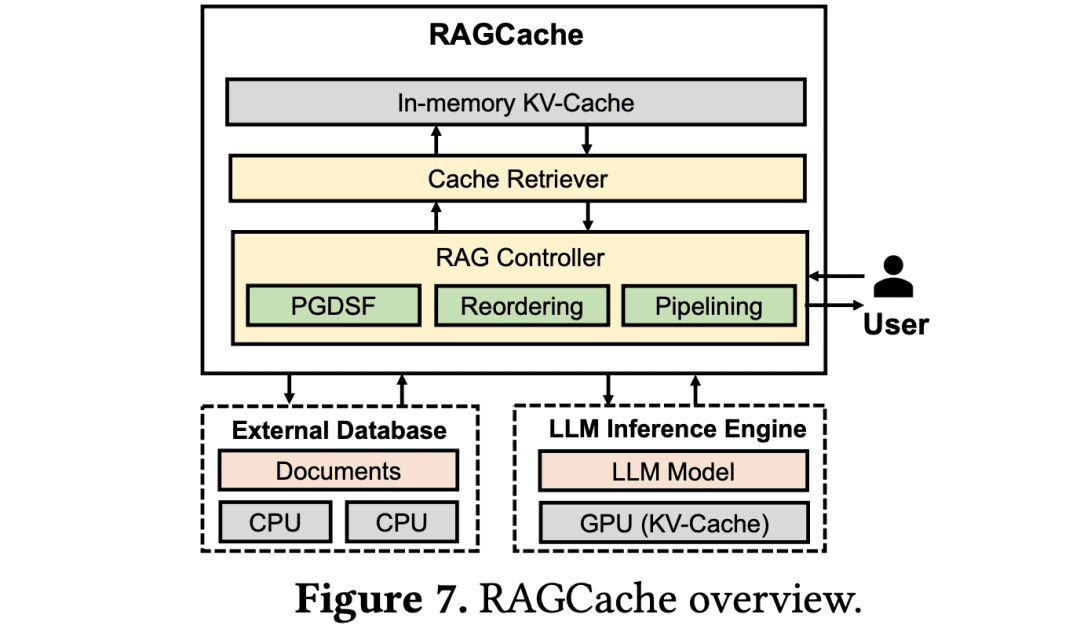

(11) RAGCache [Armazenista]

funcionário do almoxarifadoComo em um grande centro de logística, coloque o conhecimento usado com frequência nas prateleiras que são mais fáceis de pegar. Saiba como colocar os pacotes usados com frequência na porta e os usados com pouca frequência nas caixas traseiras para maximizar a eficiência da coleta.

- Tese: RAGCache: Cache de Conhecimento Eficiente para Geração Aumentada por Recuperação

O RAGCache é um novo sistema de cache dinâmico de vários níveis adaptado ao RAG que organiza os estados intermediários do conhecimento recuperado em uma árvore de conhecimento e os armazena em cache nas hierarquias de memória da GPU e do host. O RAGCache propõe uma estratégia de substituição que leva em conta os recursos de raciocínio LLM e os padrões de recuperação do RAG. Ele também sobrepõe dinamicamente as etapas de recuperação e raciocínio para minimizar a latência de ponta a ponta.

(12) GraphRAG [Resumo da comunidade]

Resumos da comunidadePrimeiro, a rede de moradores do bairro é classificada e, em seguida, cada círculo do bairro recebe um perfil. Quando alguém pergunta por direções, cada círculo da vizinhança fornece pistas que são finalmente integradas na resposta mais completa.

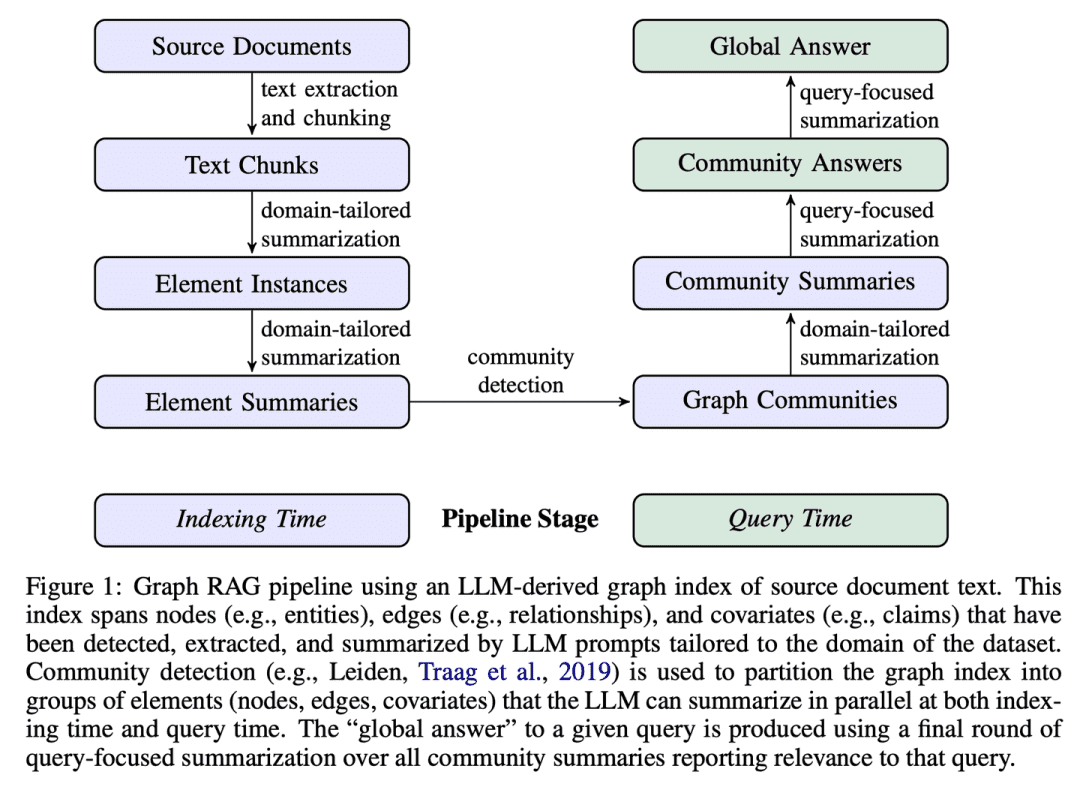

- Tese: Do local ao global: uma abordagem Graph RAG para a sumarização focada em consultas

- Projeto: https://github.com/microsoft/graphrag

O GraphRAG constrói índices de texto baseados em gráficos em dois estágios: primeiro, um gráfico de conhecimento da entidade é derivado dos documentos de origem e, em seguida, os resumos da comunidade são pré-gerados para todos os grupos de entidades intimamente relacionadas. Considerando um problema, cada resumo de comunidade é usado para gerar uma resposta parcial e, em seguida, todas as respostas parciais são resumidas novamente na resposta final ao usuário.

(13) R4 [Mestre Coreógrafo]

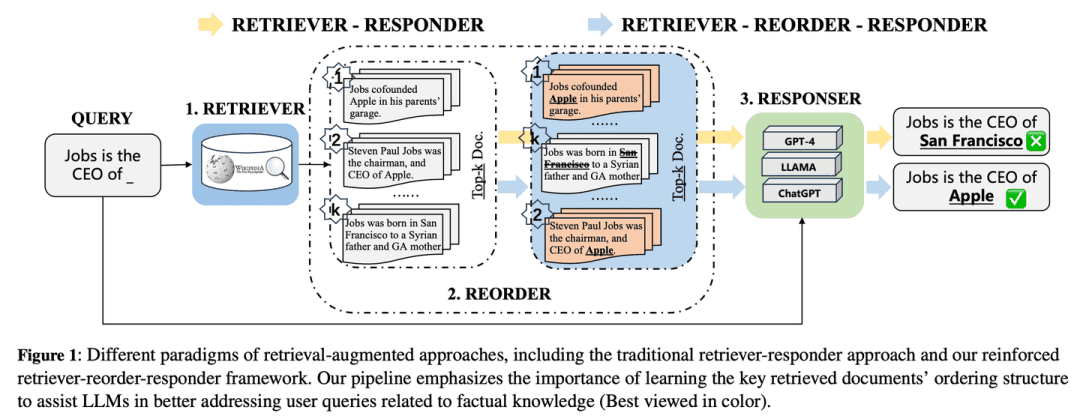

mestre arranjadorComo um tipógrafo mestre, a qualidade do resultado é aprimorada pela otimização da ordem e da apresentação do material, tornando o conteúdo mais organizado e focado sem precisar alterar o modelo principal.

- Tese: R4: Reinforced Retriever-Reorder-Responder for Retrieval-Augmented Large Language Models

O R4 (Reinforced Retriever-Reorder-Responder) é usado para aprender a ordenação de documentos para um modelo de linguagem grande e aprimorado para recuperação, aprimorando ainda mais os recursos de geração do modelo de linguagem grande, enquanto um grande número de seus parâmetros permanece congelado. O processo de aprendizado de reordenação é dividido em duas etapas com base na qualidade das respostas geradas: ajuste da ordem dos documentos e aprimoramento da representação dos documentos. Especificamente, o ajuste da ordem dos documentos tem como objetivo organizar a ordenação dos documentos recuperados em posições de início, meio e fim com base no aprendizado de atenção ao gráfico para maximizar a recompensa de reforço pela qualidade da resposta. O aprimoramento da representação de documentos refina ainda mais as representações de documentos recuperados de respostas de baixa qualidade por meio da aprendizagem adversária de gradiente em nível de documento.

(14) IM-RAG [falando comigo mesmo]

falar consigo mesmoQuando se deparam com um problema, eles calculam em sua mente "quais informações preciso verificar" e "essas informações são suficientes" e refinam a resposta por meio de um diálogo interno contínuo. Essa capacidade de "monólogo" é semelhante à de um especialista humano, que é capaz de pensar profundamente e resolver problemas complexos passo a passo.

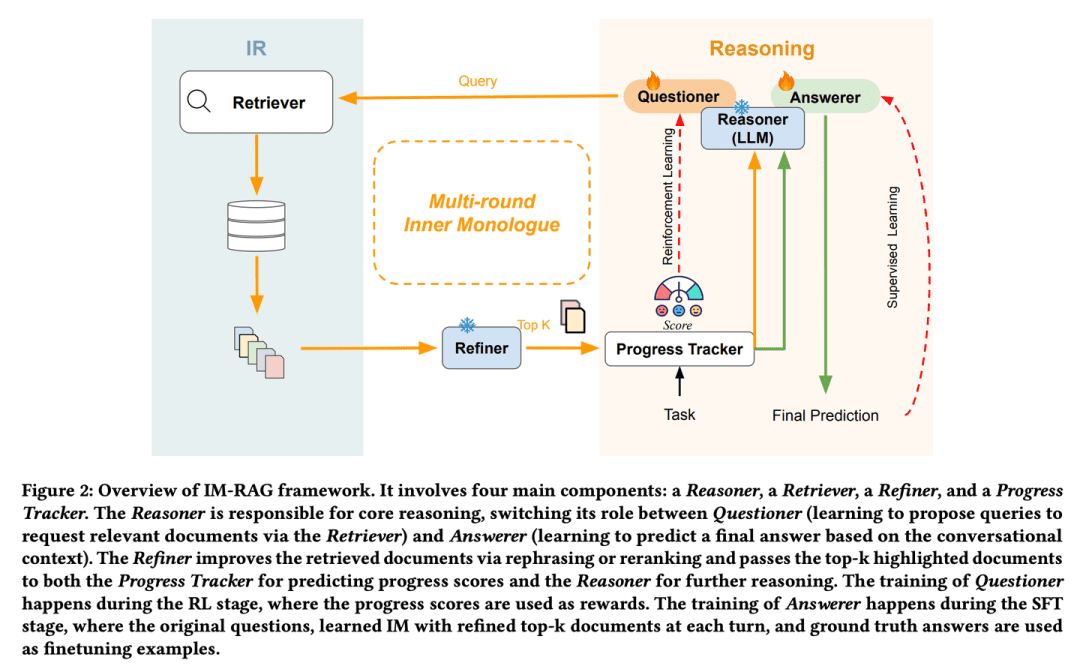

- Tese: IM-RAG: Geração aumentada de recuperação em várias rodadas por meio do aprendizado de monólogos internos

O IM-RAG oferece suporte a várias rodadas de geração de aprimoramento de recuperação por meio do aprendizado de monólogos internos para conectar sistemas de RI com LLMs. A abordagem integra o sistema de recuperação de informações com grandes modelos de linguagem para dar suporte a várias rodadas de geração de aprimoramento de recuperação por meio do aprendizado de monólogos internos. Durante o monólogo interno, o modelo de linguagem grande atua como o modelo de raciocínio central, que pode fazer uma consulta por meio do recuperador para coletar mais informações ou fornecer uma resposta final com base no contexto do diálogo. Também introduzimos um otimizador que melhora a saída do recuperador, preenchendo efetivamente a lacuna entre o raciocinador e os módulos de recuperação de informações com recursos variados e facilitando a comunicação em várias rodadas. Todo o processo de monólogo interno é otimizado por meio da aprendizagem por reforço (RL), em que um rastreador de progresso também é introduzido para fornecer recompensas de etapas intermediárias, e as previsões de resposta são otimizadas individualmente por meio do ajuste fino supervisionado (SFT).

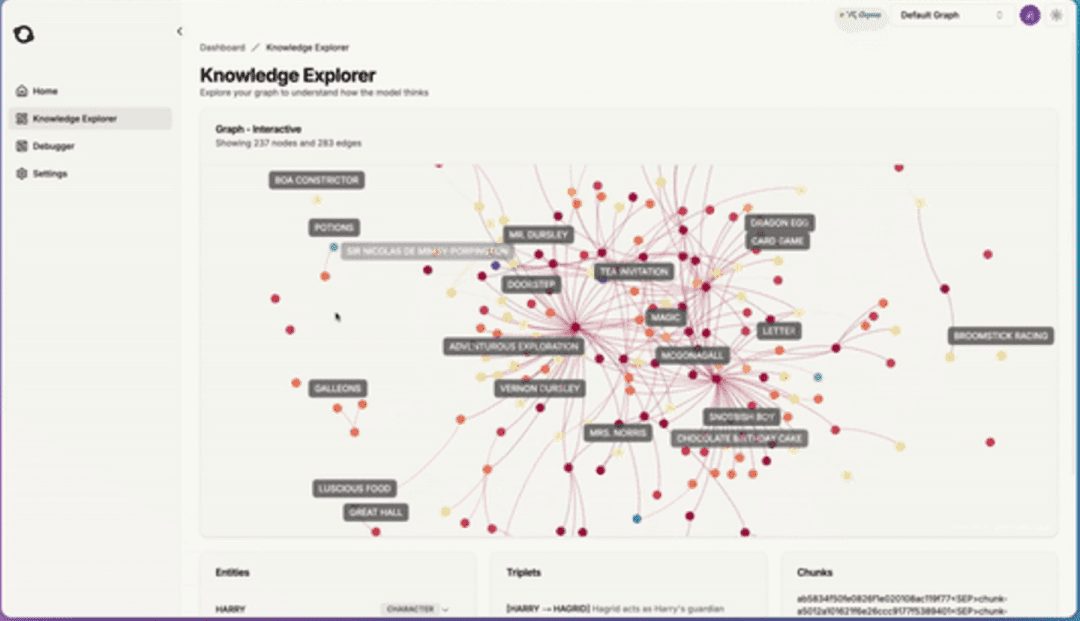

(15) AntGroup-GraphRAG [Centenas de especialistas]

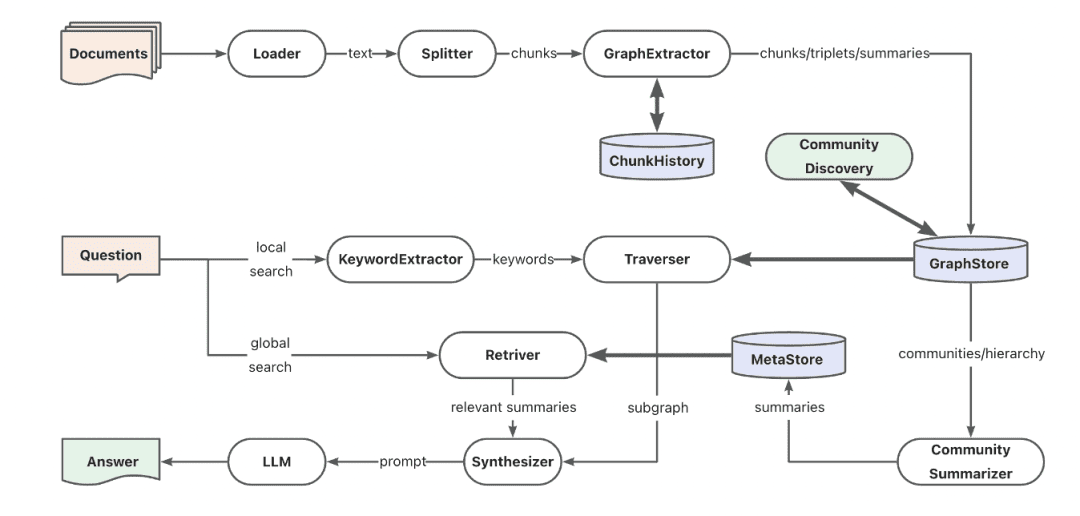

cem escolas de pensamentoA empresa reúne o que há de melhor no setor, especializando-se em uma variedade de maneiras de localizar informações rapidamente, fornecendo pesquisas precisas e compreendendo consultas em linguagem natural, tornando as pesquisas de conhecimento complexas econômicas e eficientes.

- Projeto: https://github.com/eosphoros-ai/DB-GPT

A equipe da Ant TuGraph criou a estrutura GraphRAG de código aberto com base no DB-GPT, que é compatível com uma variedade de pedestais de indexação de base de conhecimento, como vetor, gráfico, texto completo etc., e oferece suporte à extração de conhecimento de baixo custo, mapeamento de estrutura de documentos, abstração de comunidade de gráficos e recuperação híbrida para resolver problemas de QFS Q&A. Também oferece suporte a diversos recursos de recuperação, como palavras-chave, vetores e linguagem natural.

(16) Kotaemon [LEGO]

Lego (brinquedos)Q&A: Um conjunto pronto de blocos de construção de Q&A que pode ser usado diretamente ou livremente desmontado e modificado. Os usuários podem usá-los como quiserem, e os desenvolvedores podem alterá-los como quiserem.

- Projeto: https://github.com/Cinnamon/kotaemon

Uma interface de usuário RAG de código aberto, limpa e personalizável, para criar e personalizar seu próprio sistema de perguntas e respostas sobre documentos. As necessidades do usuário final e do desenvolvedor são levadas em consideração.

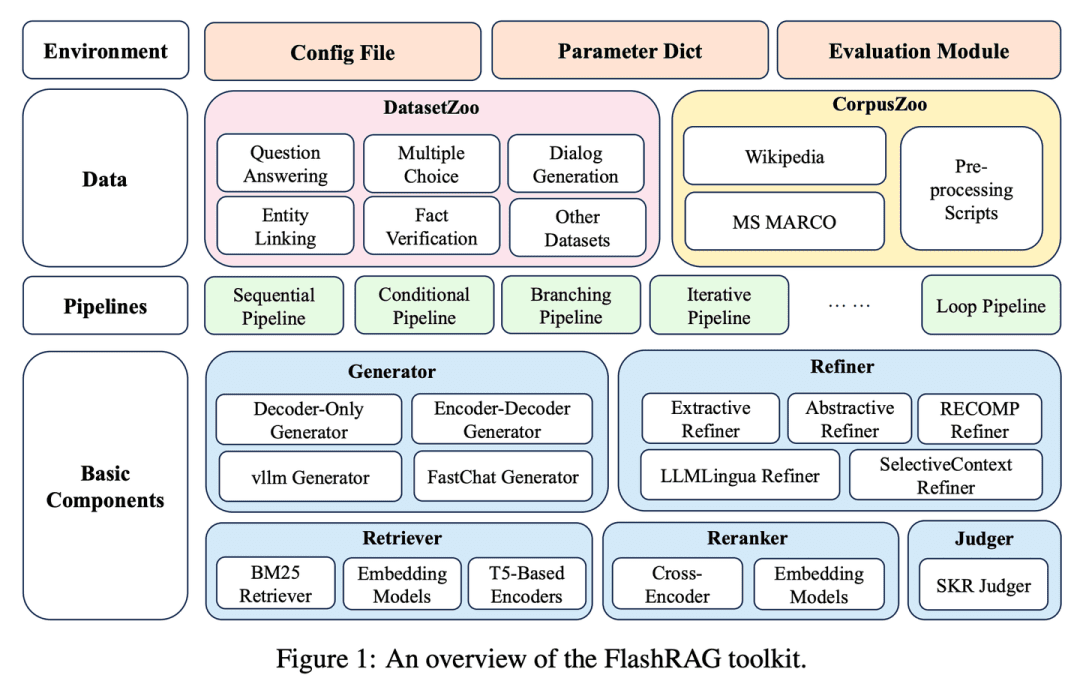

(17) FlashRAG [baú do tesouro]

baú do tesouroEmpacotamento dos vários artefatos do RAG em um kit de ferramentas que permite que os pesquisadores criem seus próprios modelos de recuperação à medida que avançam, como se estivessem escolhendo blocos de construção.

- Tese: FlashRAG: um kit de ferramentas modular para pesquisa de geração aumentada de recuperação eficiente

- Projeto: https://github.com/RUC-NLPIR/FlashRAG

O FlashRAG é um kit de ferramentas de código aberto eficiente e modular projetado para ajudar os pesquisadores a reproduzir os métodos RAG existentes e desenvolver seus próprios algoritmos RAG em uma estrutura unificada. Nosso kit de ferramentas implementa 12 métodos RAG de última geração e coleta e reúne 32 conjuntos de dados de referência.

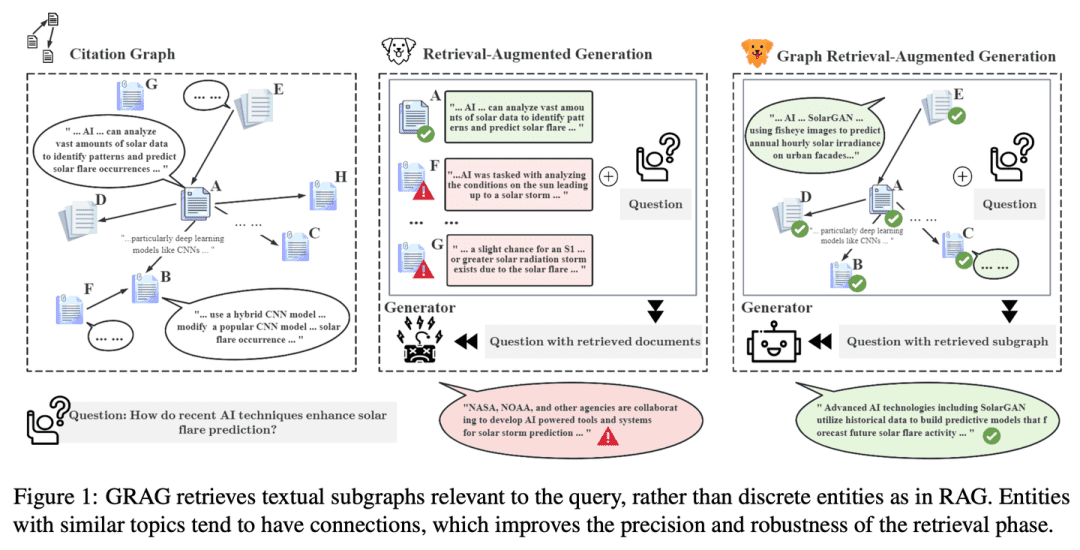

(18) GRAG [Detetive]

fazer trabalho de detetiveNão se contenta com pistas superficiais, aprofundando-se na rede de conexões entre os textos, rastreando a verdade por trás de cada informação como um crime para tornar a resposta mais precisa.

- Tese: GRAG: Geração Aumentada de Recuperação de Grafos

- Projeto: https://github.com/HuieL/GRAG

Os modelos RAG tradicionais ignoram as conexões entre os textos e as informações topológicas do banco de dados ao lidar com dados complexos estruturados em gráficos, o que leva a gargalos no desempenho. O GRAG melhora significativamente o desempenho e reduz as ilusões do processo de recuperação e geração ao enfatizar a importância das estruturas de subgráficos.

(19) Camel-GraphRAG [esquerda e direita]

dar um tapa com uma mão e depois com a outra, em rápida sucessãoUm olho escaneia o texto com o Mistral para extrair inteligência e o outro tece uma rede de relacionamentos com o Neo4j. Ao pesquisar, os olhos esquerdo e direito trabalham juntos para encontrar semelhanças e rastrear o mapa de trilhas, tornando a pesquisa mais abrangente e precisa.

- Projeto: https://github.com/camel-ai/camel

O Camel-GraphRAG se baseia no modelo Mistral para oferecer suporte à extração de conhecimento de determinado conteúdo e à construção de estruturas de conhecimento e, em seguida, armazenar essas informações em um banco de dados de gráficos Neo4j. Uma abordagem híbrida que combina a recuperação de vetores com a recuperação de gráficos de conhecimento é então usada para consultar e explorar o conhecimento armazenado.

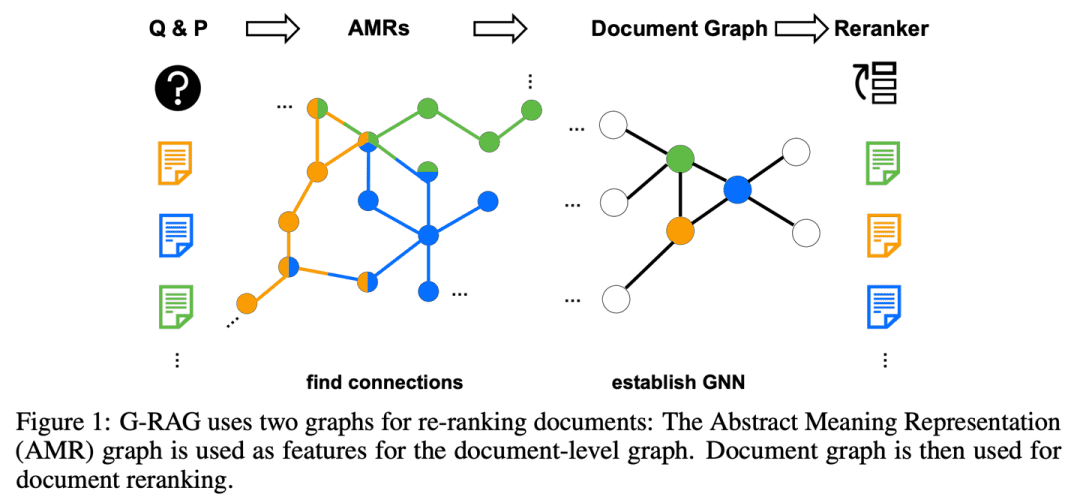

(20) G-RAG [Stringer]

lit. aldrava de portas (expressão idiomática); fig. uma cura milagrosa para os problemas das pessoasEm vez de buscar informações sozinho, você cria uma rede de relacionamentos para cada ponto de conhecimento. Como uma socialite, você não apenas sabe em que cada um de seus amigos é bom, mas também sabe quem é amigo de quem, de modo que possa seguir a trilha diretamente quando estiver procurando respostas.

- Artigo: Não se esqueça de se conectar! Aprimorando o RAG com o Reranking baseado em gráficos

O RAG ainda tem desafios para lidar com a relação entre os documentos e o contexto da pergunta, e o modelo pode não ser capaz de utilizar efetivamente os documentos quando sua relevância para a pergunta não é óbvia ou quando eles contêm apenas informações parciais. Além disso, como inferir razoavelmente as conexões entre os documentos também é uma questão importante. O G-RAG implementa um rearranjador baseado em rede neural gráfica (GNN) entre o recuperador de RAG e o leitor. O método combina as informações de conexão entre os documentos e as informações semânticas (por meio de um gráfico de representação semântica abstrata) para fornecer um classificador baseado em contexto para o RAG.

(21) LLM-Graph-Builder [Mover]

um carregadorDescrição: dar ao texto caótico um lar compreensível. Não simplesmente carregue-o, mas como uma pessoa obsessivo-compulsiva, rotulando cada ponto de conhecimento, desenhando linhas de relacionamento e, finalmente, construindo um edifício de conhecimento bem ordenado no banco de dados do Neo4j.

- Projeto: https://github.com/neo4j-labs/llm-graph-builder

Gerador de extração de gráfico de conhecimento baseado em LLM de código aberto do Neo4j que pode converter dados não estruturados em um gráfico de conhecimento no Neo4j. Usando modelos grandes para extrair nós, relacionamentos e seus atributos de dados não estruturados.

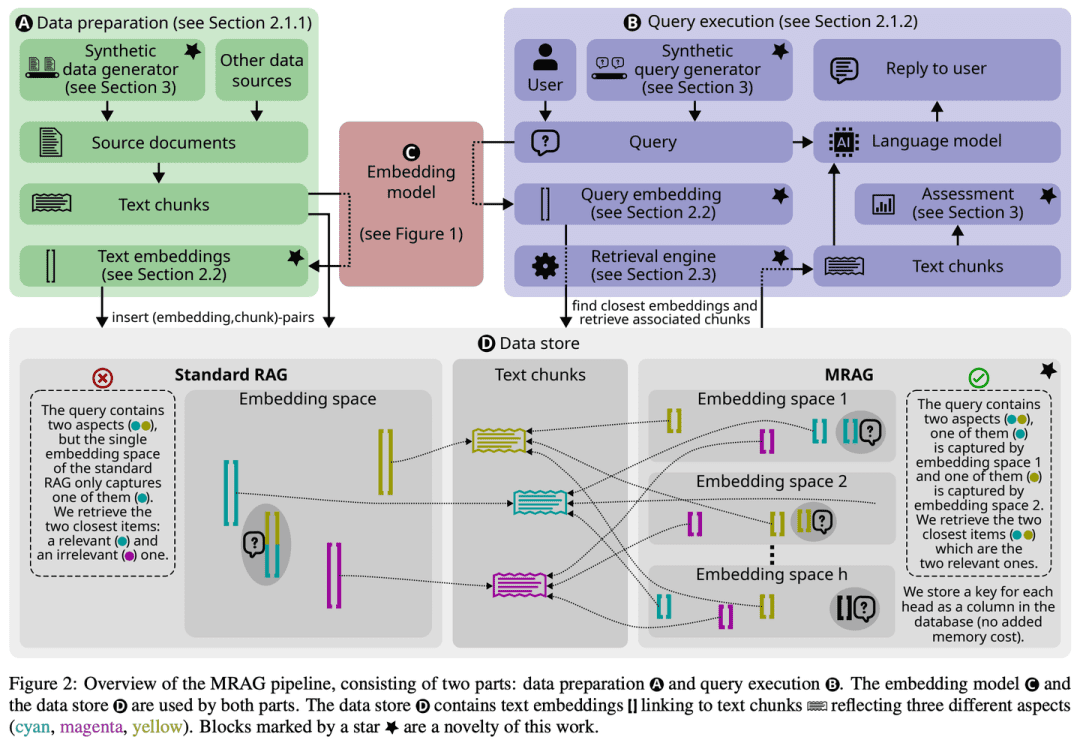

(22) MRAG [Polvo]

polvoEm vez de criar apenas uma cabeça para resolver o problema, ela cria vários tentáculos, como um polvo, sendo que cada tentáculo é responsável por agarrar um ângulo. Simplificando, essa é a versão de IA da "multitarefa".

- Tese: RAG de várias cabeças: solução de problemas de vários aspectos com LLMs

- Projeto: https://github.com/spcl/MRAG

As soluções RAG existentes não se concentram em consultas que podem exigir acesso a vários documentos com conteúdo significativamente diferente. Essas consultas surgem com frequência, mas são desafiadoras porque as incorporações desses documentos podem estar muito distantes no espaço de incorporação, dificultando a recuperação de todos eles. Este artigo apresenta o Multihead RAG (MRAG), um novo esquema que visa a preencher essa lacuna com uma ideia simples, mas poderosa: usar o Transformador A ativação de uma camada de atenção com várias cabeças, em vez de uma camada de decodificador, serve como uma chave para capturar documentos multifacetados. A motivação principal é que diferentes cabeças de atenção podem aprender a capturar diferentes aspectos dos dados. A utilização das ativações correspondentes produz embeddings que representam itens de dados e vários aspectos da consulta, melhorando assim a precisão da recuperação de consultas complexas.

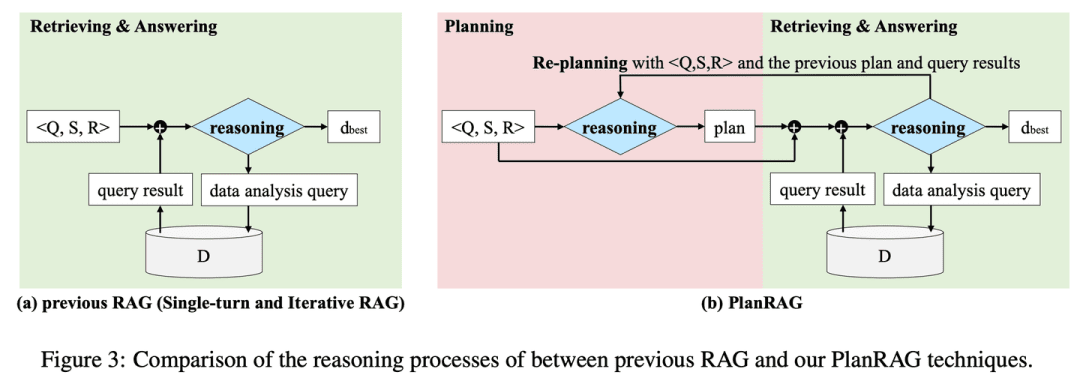

(23) PlanRAG [estrategista]

um estrategistaPlano de batalha: Um plano de batalha completo é desenvolvido, depois a situação é analisada de acordo com as regras e os dados e, por fim, são tomadas as melhores decisões táticas.

- Tese: PlanRAG: uma geração aumentada de planejamento e recuperação para modelos de linguagem grandes e generativos como tomadores de decisão

- Projeto: https://github.com/myeon9h/PlanRAG

O PlanRAG investiga como usar modelos de linguagem em larga escala para resolver soluções para problemas complexos de decisão de análise de dados, definindo a tarefa de QA de decisão, ou seja, determinar a melhor decisão com base no problema de decisão Q, nas regras de negócios R e no banco de dados D. O PlanRAG primeiro gera um plano de decisão e, em seguida, o recuperador gera consultas para análise de dados.

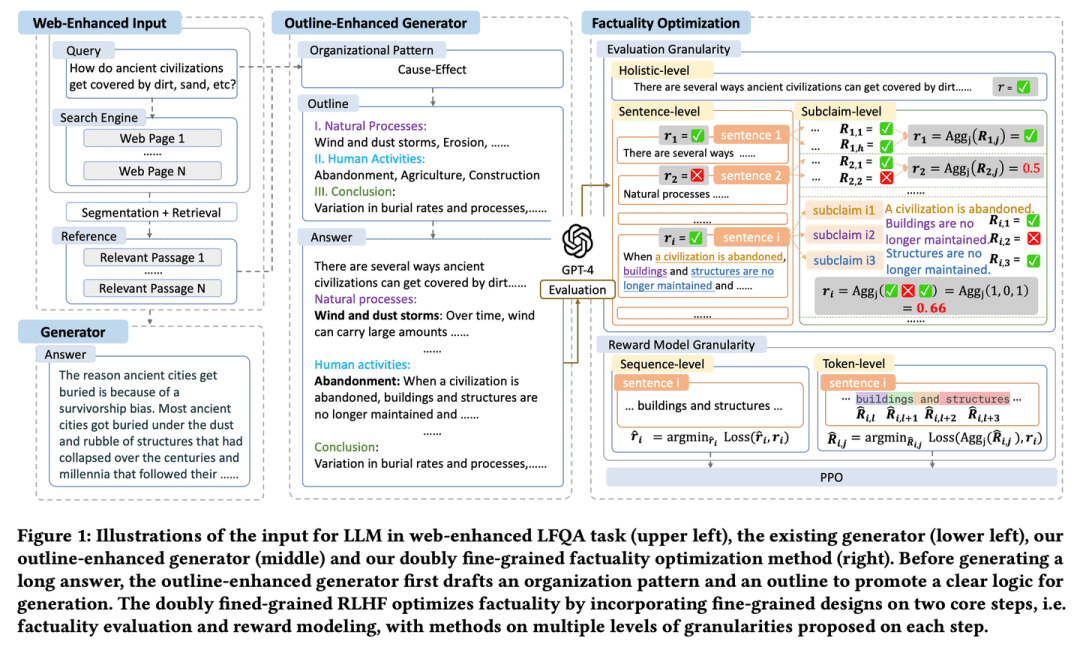

(24) FoRAG [escritor]

escritorA redação é escrita em um esboço que a estrutura e, em seguida, é expandida e refinada parágrafo por parágrafo. Há também um "editor" que ajuda a aperfeiçoar cada detalhe e a garantir a qualidade do trabalho por meio de uma cuidadosa verificação de fatos e sugestões de alterações.

- Tese: FoRAG: Geração Aumentada de Recuperação Otimizada por Fato para Resposta a Perguntas Longas na Web

O FoRAG propõe um novo gerador de aprimoramento de esboço, em que o gerador usa modelos de esboço para elaborar esboços de respostas com base na consulta e no contexto do usuário no primeiro estágio e amplia cada ponto de vista com base no esboço gerado no segundo estágio para construir a resposta final. Também é proposta uma abordagem de otimização facciosa baseada em uma estrutura de RLHF de granulação fina dupla bem projetada, que fornece sinais de recompensa mais densos ao introduzir um design de granulação fina nas duas etapas principais de avaliação facciosa e modelagem de recompensa.

(25) Multi-Meta-RAG [meta-screener]

meta-filtroComo um gerente de dados experiente, ele usa vários mecanismos de filtragem para identificar o conteúdo mais relevante em uma grande quantidade de informações. Ele não olha apenas para a superfície, mas analisa as "tags de identidade" (metadados) dos documentos para garantir que cada informação encontrada esteja realmente relacionada ao tópico.

- Tese: Multi-Meta-RAG: aprimoramento do RAG para consultas de múltiplos saltos usando filtragem de banco de dados com metadados extraídos do LLM

- Projeto: https://github.com/mxpoliakov/multi-meta-rag

O Multi-Meta-RAG usa filtragem de banco de dados e metadados extraídos do LLM para melhorar a seleção do RAG de documentos relevantes de várias fontes que são relevantes para o problema.

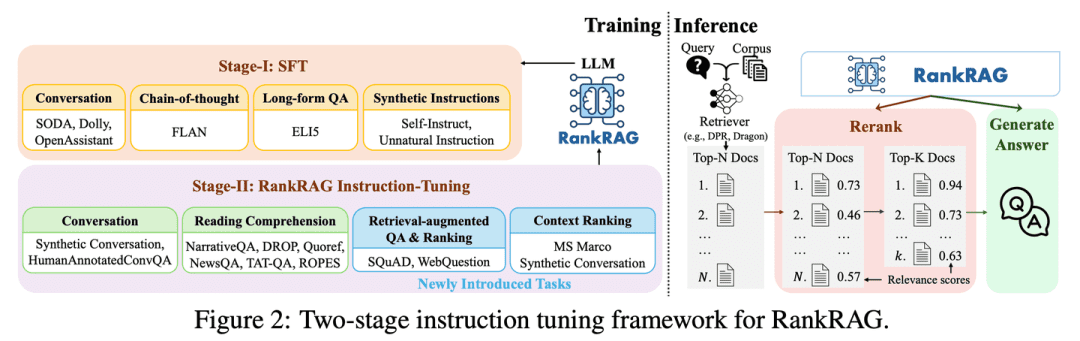

(26) RankRAG [All Rounder]

versátilCom um pouco de treinamento, você pode ser tanto um "juiz" quanto um "competidor". Como um atleta talentoso, com um pouco de treinamento você pode superar os profissionais em várias disciplinas e dominar todas as suas habilidades.

- Tese: RankRAG: unificando a classificação do contexto com a geração aumentada por recuperação em LLMs

O RankRAG faz o ajuste fino de um único LLM com instruções para realizar a classificação contextual e a geração de respostas. Ao adicionar um pequeno volume de dados de classificação aos dados de treinamento, o LLM ajustado por instruções funciona surpreendentemente bem e até supera os modelos de classificação de especialistas existentes, incluindo o mesmo LLM ajustado especificamente em um grande volume de dados de classificação. Esse design não apenas simplifica a complexidade de vários modelos nos sistemas RAG tradicionais, mas também aprimora o julgamento de relevância contextual e a eficiência da utilização de informações por meio do compartilhamento de parâmetros do modelo.

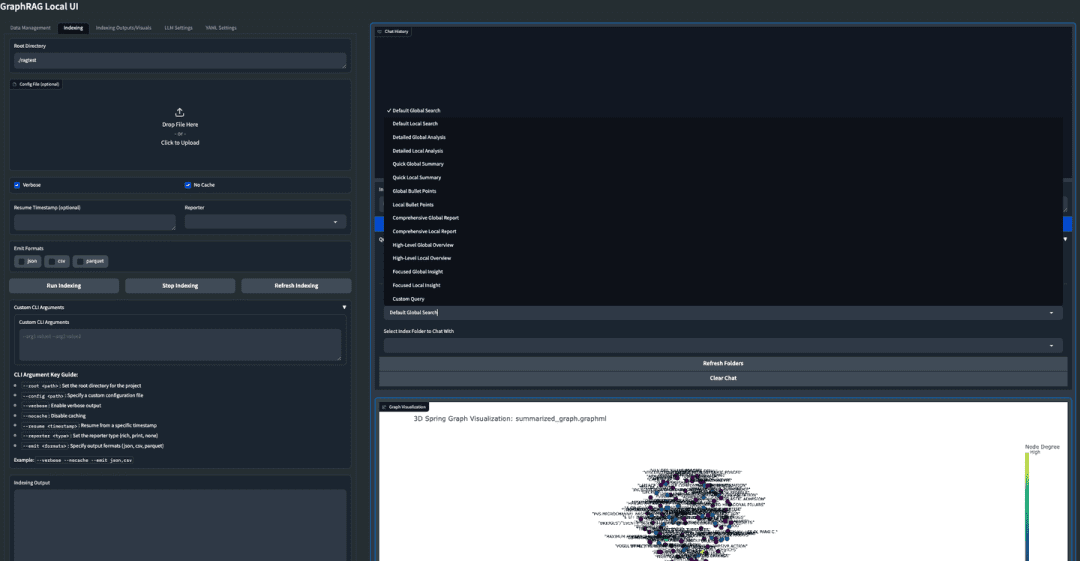

(27) GraphRAG-Local-UI [Modificador]

sintonizadorConversão de um carro esportivo em um carro prático para estradas locais, com um painel de instrumentos amigável para facilitar a condução por todos.

- Projeto: https://github.com/severian42/GraphRAG-Local-UI

O GraphRAG-Local-UI é uma versão adaptada ao modelo local do GraphRAG baseado na Microsoft com um rico ecossistema de interfaces de usuário interativas.

(28) ThinkRAG [pequena secretária]

secretário júniorCondensar um enorme corpo de conhecimento em uma versão de bolso, como uma pequena secretária em movimento, pronta para ajudá-lo a encontrar respostas sem um dispositivo grande.

- Projeto: https://github.com/wzdavid/ThinkRAG

O sistema ThinkRAG Big Model Retrieval Enhanced Generation System pode ser facilmente implantado em laptops para permitir a interrogação inteligente de bases de conhecimento locais.

(29) Nano-GraphRAG [carga leve]

lit. fazer uma mala leve e ir para a batalha (expressão idiomática); fig. viajar com facilidadeComo um atleta que está levando pouca bagagem, o equipamento pesado foi simplificado, mas as competências essenciais foram mantidas.

- Projeto: https://github.com/gusye1234/nano-graphrag

O Nano-GraphRAG é um GraphRAG menor, mais rápido e mais conciso, mantendo a funcionalidade principal.

(30) RAGFlow-GraphRAG [Navegador]

navegador (em um avião ou barco)O que é um mapa: cortar atalhos no labirinto de perguntas e respostas, primeiro desenhando um mapa para marcar todos os pontos de conhecimento, mesclando placas de sinalização duplicadas e, especificamente, reduzindo o mapa para que as pessoas que pedem instruções não tomem o caminho mais longo.

- Projeto: https://github.com/infiniflow/ragflow

O RAGFlow baseia-se na implementação do GraphRAG para introduzir a construção de gráficos de conhecimento como uma opção opcional na fase de pré-processamento de documentos para atender a cenários de QFS Q&A e introduz aprimoramentos como a redução de peso de entidades e a otimização de tokens.

(31) Medical-Graph-RAG [Médico Digital]

médico digitalComo um consultor médico experiente, o conhecimento médico complexo é organizado de forma clara com diagramas, e as sugestões de diagnóstico não são feitas do nada, mas são justificadas, de modo que tanto o médico quanto o paciente possam ver a lógica por trás de cada diagnóstico.

- Tese: Medical Graph RAG: Rumo a um modelo seguro de linguagem médica ampla por meio da geração aumentada de recuperação de gráficos

- Projeto: https://github.com/SuperMedIntel/Medical-Graph-RAG

O MedGraphRAG é uma estrutura projetada para enfrentar os desafios da aplicação do LLM na medicina. Ele usa uma abordagem baseada em gráficos para melhorar a precisão do diagnóstico, a transparência e a integração em fluxos de trabalho clínicos. O sistema melhora a precisão do diagnóstico ao gerar respostas apoiadas por fontes confiáveis, abordando a dificuldade de manter o contexto em grandes volumes de dados médicos.

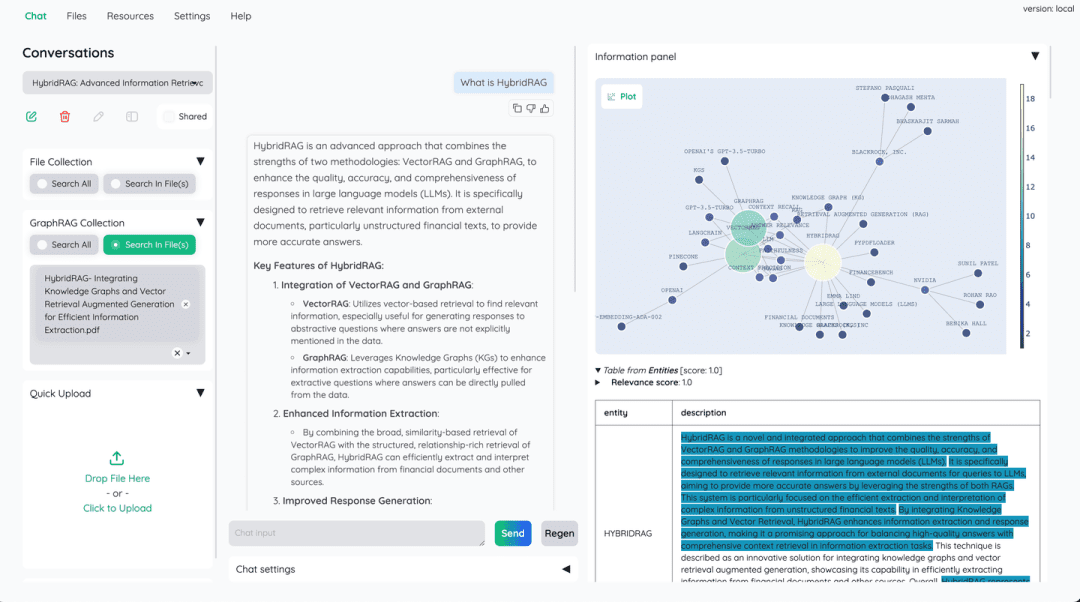

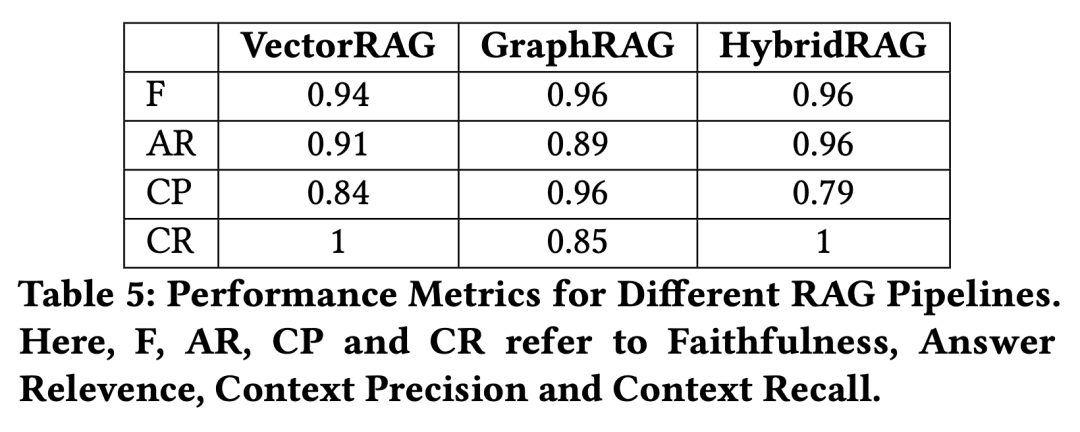

(32) HybridRAG [Fórmulas combinadas de medicina chinesa]

Prescrição de medicina chinesaAssim como na medicina chinesa, um único medicamento não é tão eficaz quanto uma combinação de vários medicamentos. Os bancos de dados vetoriais são responsáveis pela recuperação rápida, e os gráficos de conhecimento suplementam a lógica relacional, complementando os pontos fortes de cada um.

- Tese: HybridRAG: Integrando Gráficos de Conhecimento e Geração Aumentada de Recuperação de Vetores para Extração Eficiente de Informações

Uma nova abordagem baseada em uma combinação de técnicas de Knowledge Graph RAG (GraphRAG) e técnicas de VectorRAG, denominada HybridRAG, para aprimorar os sistemas de perguntas e respostas para extrair informações de documentos financeiros, demonstrou gerar respostas precisas e contextualmente relevantes. Nas fases de recuperação e geração, o HybridRAG para recuperação de contexto de bancos de dados vetoriais e gráficos de conhecimento supera o VectorRAG e o GraphRAG tradicionais em termos de precisão de recuperação e geração de respostas.

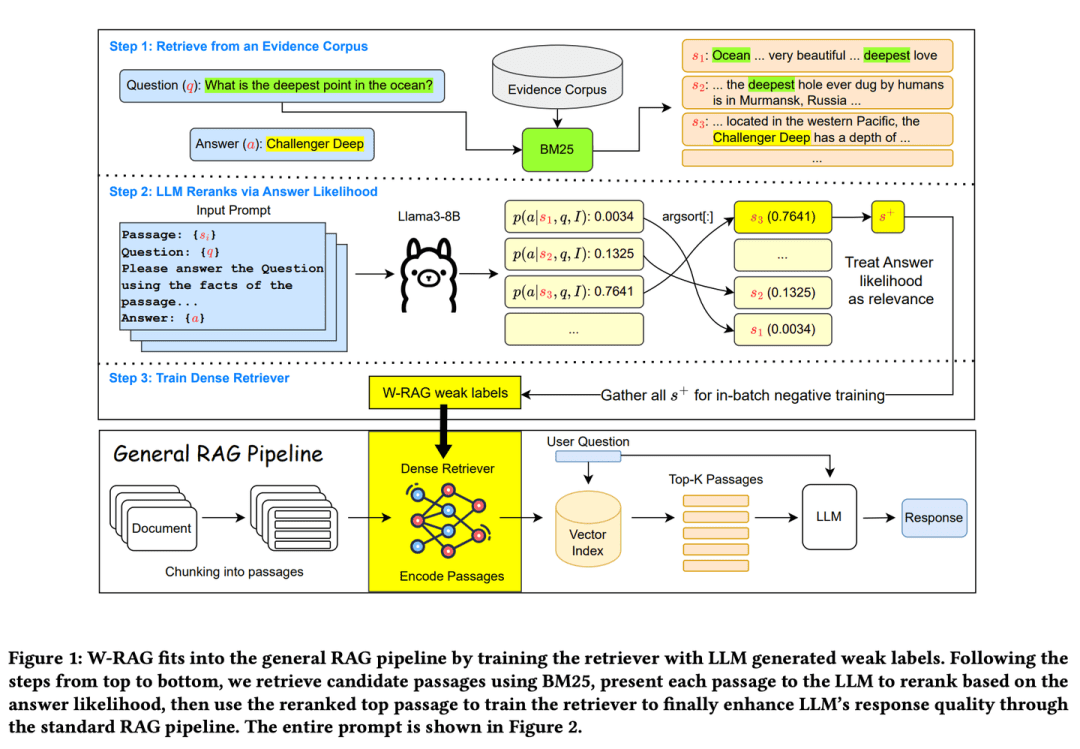

(33) W-RAG [Pesquisa evolutiva]

Pesquisa de evoluçãoComo um bom mecanismo de pesquisa que evolui automaticamente, ele aprende o que é uma boa resposta pontuando parágrafos de artigos em um grande modelo, melhorando gradualmente sua capacidade de encontrar informações importantes.

- Tese: W-RAG: recuperação densa fracamente supervisionada em RAG para resposta a perguntas de domínio aberto

- Projeto: https://github.com/jmnian/weak_label_for_rag

As técnicas de recuperação densa com supervisão fraca em questionários de domínio aberto exploram os recursos de classificação de modelos de linguagem grandes para criar dados com rótulos fracos para treinar recuperadores densos. Ao avaliar a probabilidade de que o modelo de linguagem grande gere a resposta correta com base na pergunta e em cada parágrafo, a probabilidade de passar no teste é de 1,5 ponto. BM25 As K principais passagens recuperadas são classificadas novamente. As passagens mais bem classificadas são então usadas como exemplos de treinamento positivo para recuperação intensiva.

(34) RAGChecker [inspetor de qualidade]

inspetor de qualidadeA resposta não é simplesmente certa ou errada, mas será examinada em profundidade durante todo o processo, desde a busca de informações até a geração da resposta final, como um examinador rigoroso, fornecendo um relatório detalhado de marcação, mas também apontando onde são necessárias melhorias específicas.

- Tese: RAGChecker: uma estrutura refinada para diagnosticar a geração aumentada de recuperação

- Projeto: https://github.com/amazon-science/RAGChecker

A ferramenta de diagnóstico do RAGChecker fornece relatórios de diagnóstico detalhados, abrangentes e confiáveis sobre o sistema RAG e fornece orientações práticas para melhorar ainda mais o desempenho. Ela não apenas avalia o desempenho geral do sistema, mas também fornece uma análise aprofundada do desempenho dos dois módulos principais, recuperação e geração.

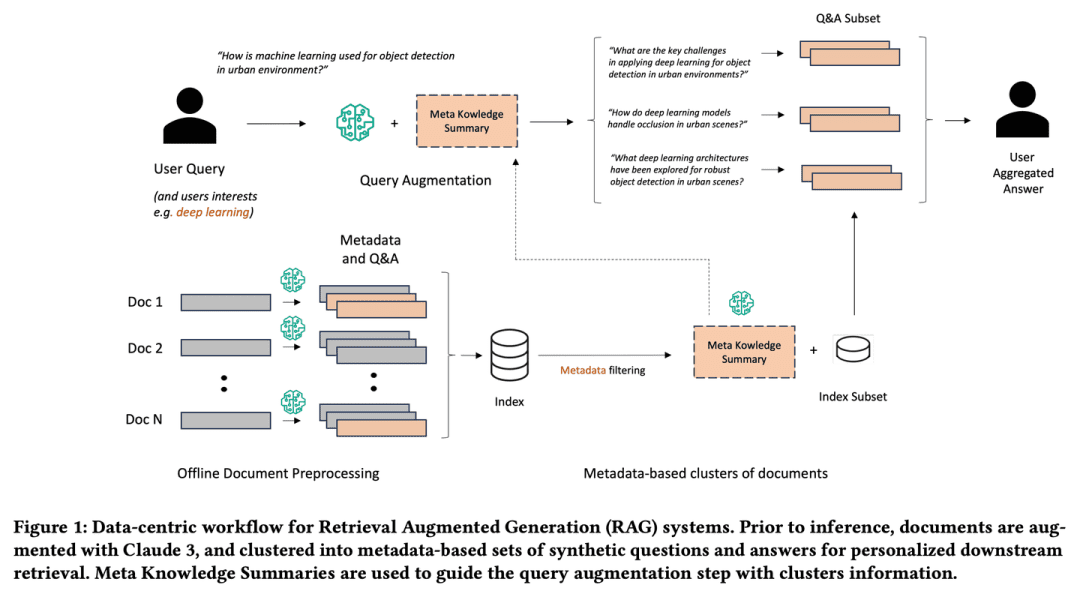

(35) Meta-Conhecimento-RAG [Acadêmico]

acadêmicoComo um pesquisador sênior da área acadêmica, ele não apenas coleta informações, mas também pensa ativamente sobre o problema, anota e resume cada documento e até mesmo prevê possíveis problemas com antecedência. Ele conectará pontos de conhecimento relacionados para formar uma rede de conhecimento, de modo que a consulta se torne mais profunda e abrangente, assim como um acadêmico está ajudando você a ter uma visão geral da pesquisa.

- Tese: Metaconhecimento para recuperação de modelos de linguagem grandes e aumentados

O Meta-Knowledge-RAG (Resumo MK) apresenta um novo fluxo de trabalho RAG centrado em dados que transforma o sistema tradicional de "recuperação e leitura" em uma estrutura mais avançada de "preparação, reescrita e recuperação e leitura " mais avançada para obter uma compreensão de nível de especialista de domínio superior da base de conhecimento. Nossa abordagem se baseia na geração de metadados e perguntas e respostas sintéticas para cada documento, bem como na introdução de um novo conceito de resumo de metaconhecimento para agrupamento de documentos com base em metadados. As inovações propostas permitem o aprimoramento personalizado da consulta do usuário e a recuperação profunda de informações em bases de conhecimento.

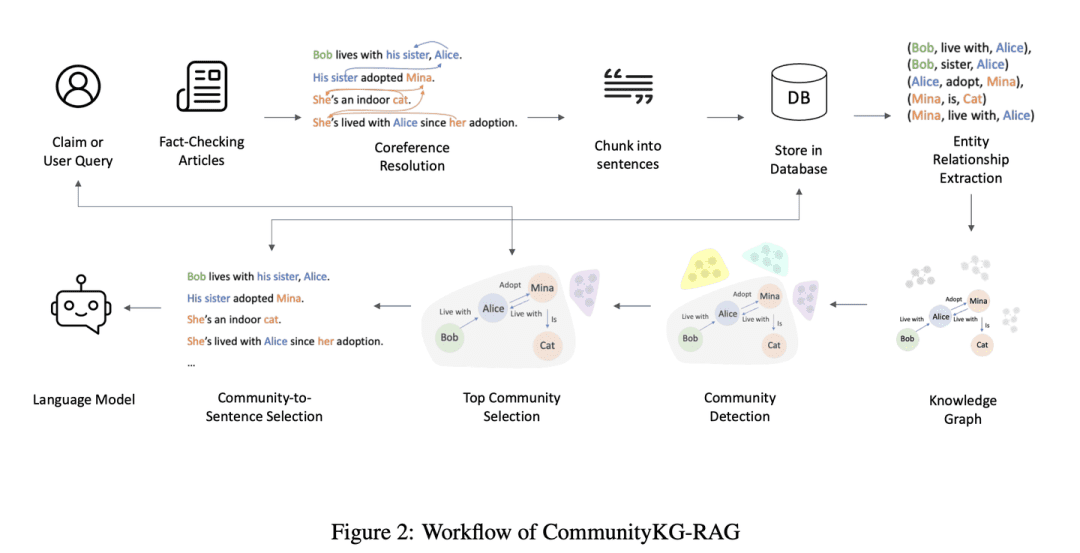

(36) CommunityKG-RAG [Exploração da comunidade]

Exploração da comunidadeComo um mago familiarizado com a rede de relacionamentos da comunidade, ele é hábil em explorar associações entre o conhecimento e as características do grupo para encontrar informações relevantes com precisão e verificar sua confiabilidade sem um estudo especial.

- Tese: CommunityKG-RAG: Aproveitamento de estruturas comunitárias em gráficos de conhecimento para recuperação avançada - Geração aumentada em verificação de fatos verificação de fatos

O CommunityKG-RAG é uma nova estrutura de amostra zero que combina estruturas de comunidade no Knowledge Graph com um sistema RAG para aprimorar o processo de verificação de fatos. O CommunityKG-RAG é capaz de se adaptar a novos domínios e consultas sem treinamento adicional e explora a natureza multihop das estruturas de comunidade no Knowledge Graph para melhorar significativamente a precisão e a relevância da recuperação de informações. relevância.

(37) TC-RAG [Mago da Memória]

artista mnemônico: Coloque um cérebro com uma função de limpeza automática no LLM. Da mesma forma que resolvemos problemas, escreveremos as etapas importantes no papel de rascunho e as riscaremos quando terminarmos. Não é um aprendizado mecânico, ele se lembra do que deve ser lembrado e esvazia o que deve ser esquecido com o tempo, como um valentão da escola que consegue limpar seu quarto.

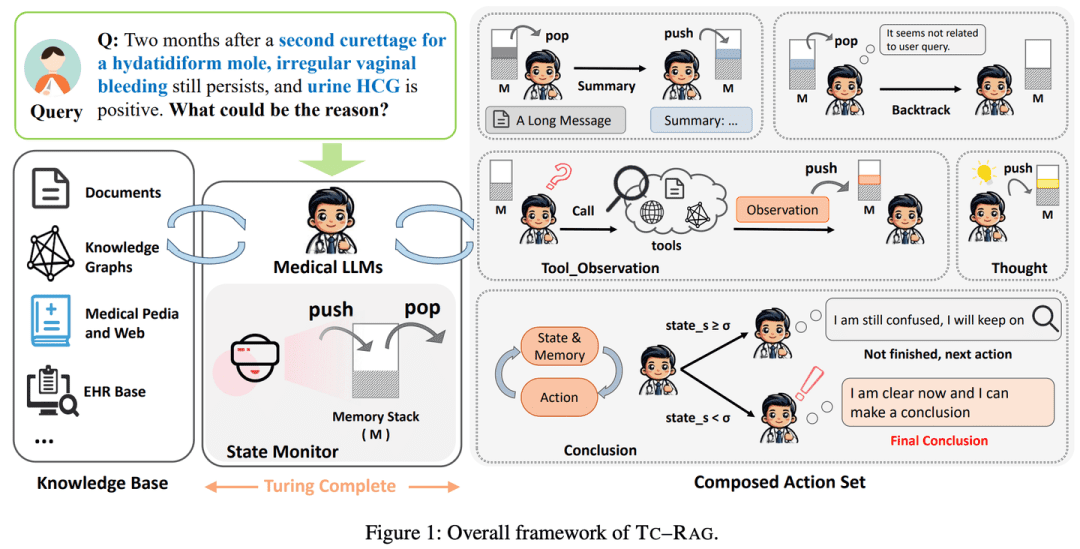

- Tese: TC-RAG: Estudo de caso de Turing-Complete RAG em sistemas médicos de LLM

- Projeto: https://github.com/Artessay/TC-RAG

Com a introdução de um sistema Turing-completo para gerenciar variáveis de estado, obtém-se uma recuperação de conhecimento mais eficiente e precisa. Ao utilizar um sistema de pilha de memória com recursos adaptativos de recuperação, raciocínio e planejamento, o TC-RAG não só garante a interrupção controlada do processo de recuperação, mas também reduz o acúmulo de conhecimento errôneo por meio de operações Push e Pop.

(38) RAGLAB [Arena]

arenaPermitir que os algoritmos concorram e se comparem de forma justa sob as mesmas regras, como um processo de teste padronizado em um laboratório de ciências, garante que cada novo método seja avaliado de forma objetiva e transparente.

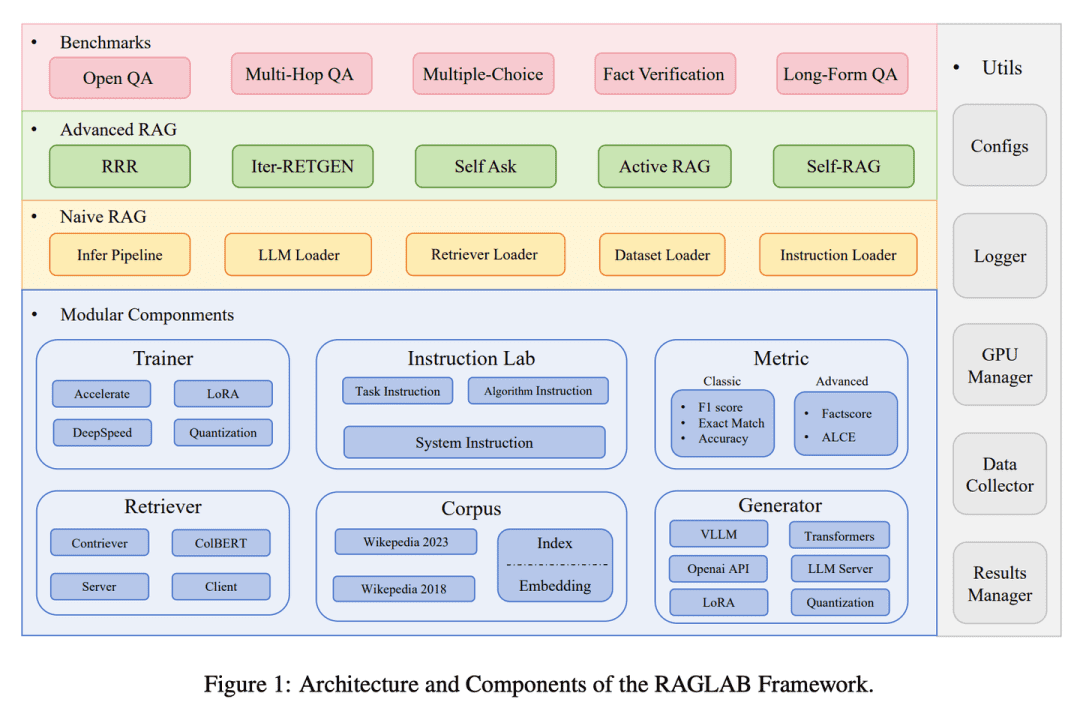

- Tese: RAGLAB: uma estrutura unificada modular e orientada para pesquisa para geração aumentada de recuperação

- Projeto: https://github.com/fate-ubw/RAGLab

Há uma crescente falta de comparações abrangentes e justas entre os novos algoritmos RAG, e a abstração de alto nível das ferramentas de código aberto leva a uma falta de transparência e limita a capacidade de desenvolver novos algoritmos e métricas de avaliação. O RAGLAB é uma biblioteca modular, orientada para a pesquisa e de código aberto que reproduz os 6 algoritmos e cria um ecossistema de pesquisa abrangente. Com o RAGLAB, comparamos os 6 algoritmos de forma justa em 10 benchmarks, ajudando os pesquisadores a avaliar e inovar algoritmos de forma eficiente.

(39) MemoRAG.

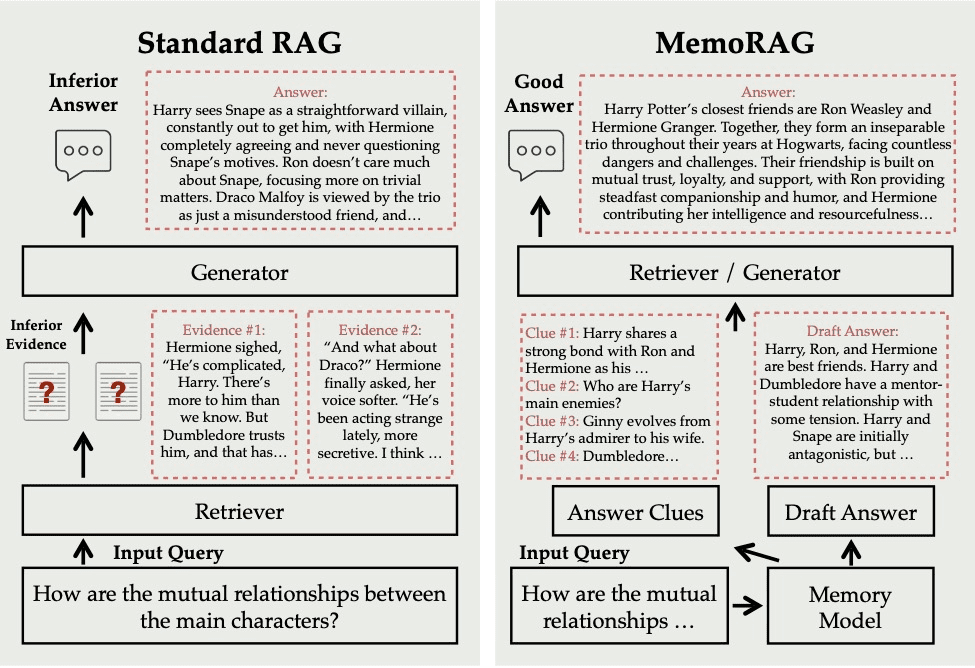

ter uma memória altamente retentivaEle não apenas procura informações sob demanda, mas tem toda a base de conhecimento profundamente compreendida e memorizada. Quando você faz uma pergunta, ele extrai rapidamente as memórias relevantes desse "supercérebro" e dá uma resposta precisa e perspicaz, exatamente como um especialista experiente.

- Projeto: https://github.com/qhjqhj00/MemoRAG

O MemoRAG é uma estrutura inovadora do Retrieval Augmented Generation (RAG) criada com base em um modelo eficiente de memória ultralonga. Diferentemente dos RAGs padrão, que lidam principalmente com consultas com necessidades explícitas de informações, o MemoRAG utiliza seu modelo de memória para obter uma compreensão global de todo o banco de dados. Ao recuperar da memória as dicas específicas da consulta, o MemoRAG aprimora a recuperação de evidências, resultando em uma geração de respostas mais precisa e rica em contexto.

(40) OP-RAG [gerenciamento de atenção]

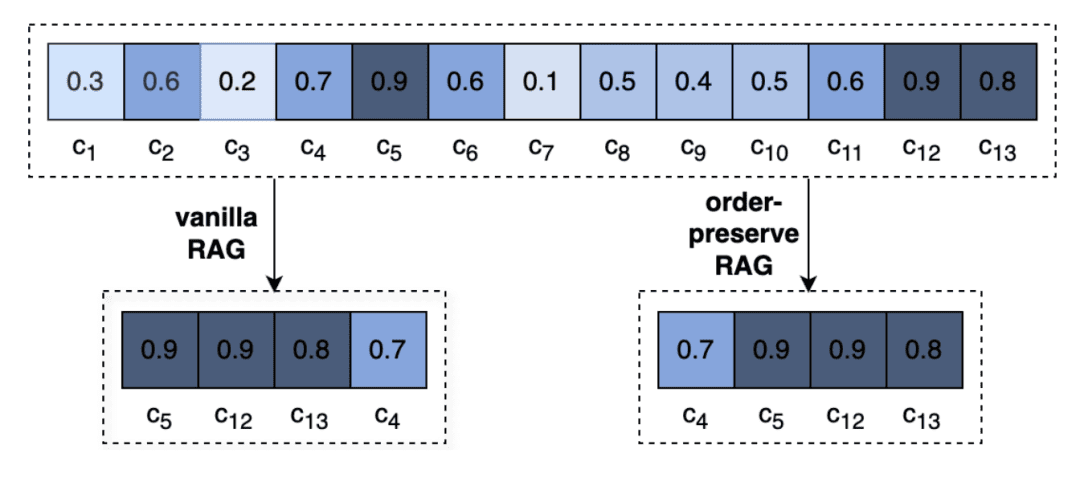

Gerenciamento da atençãoÉ como ler um livro particularmente grosso, você não consegue se lembrar de todos os detalhes, mas as pessoas que sabem como marcar os capítulos principais são os mestres. Não se trata de ler sem rumo, mas como um leitor sênior, enquanto lê e anota os pontos principais, quando necessário, vá diretamente para a página marcada.

- Tese: Em defesa do RAG na era dos modelos de linguagem de contexto longo

Contextos extremamente longos em LLMs levam à redução da atenção às informações relevantes e à possível degradação da qualidade da resposta. Revisitando o RAG na geração de respostas em contextos longos, propomos um mecanismo de geração aprimorado de recuperação com preservação da ordem, o OP-RAG, que melhora significativamente o desempenho do RAG em aplicações de perguntas e respostas em contextos longos.

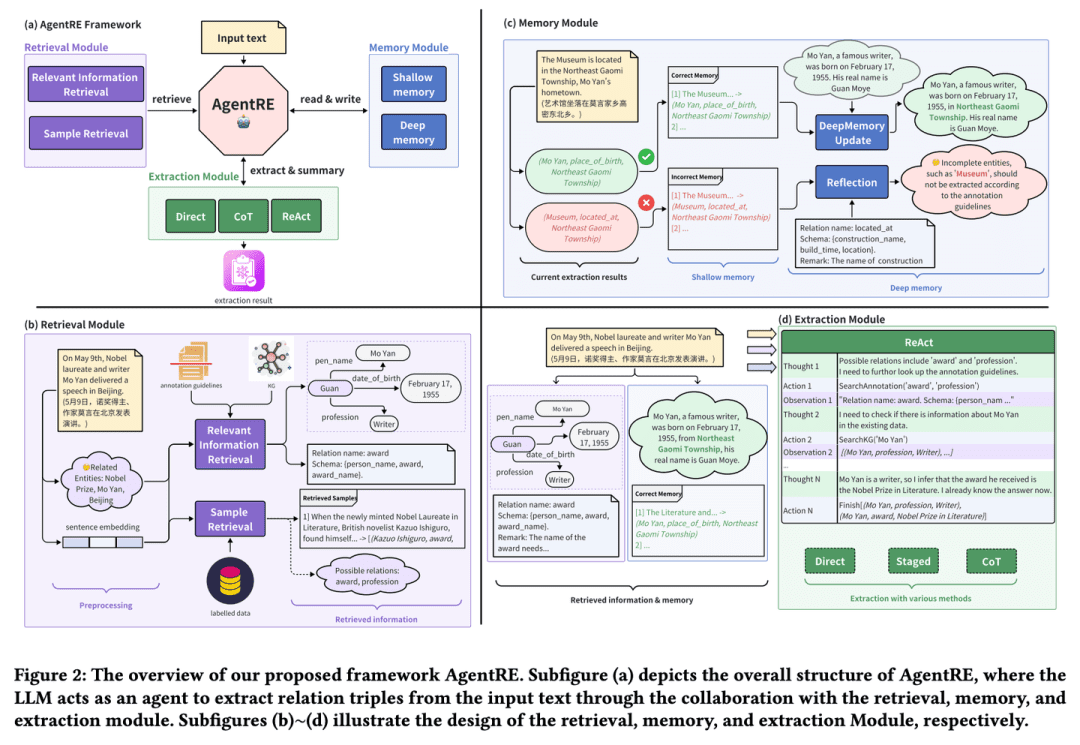

(41) AgentRE [Extração Inteligente]

Extração inteligenteComo um sociólogo que é bom em observar relacionamentos, ele não apenas se lembra das principais informações, mas também toma a iniciativa de verificá-las e pensar sobre elas em profundidade, de modo a entender com precisão a complexa rede de relacionamentos. Mesmo diante de relacionamentos complexos, eles são capazes de analisá-los de várias perspectivas para dar sentido a eles e evitar interpretá-los.

- Tese: AgentRE: uma estrutura baseada em agentes para navegar em cenários de informações complexas na extração de relações

- Projeto: https://github.com/Lightblues/AgentRE

Ao integrar os recursos de memória, recuperação e reflexão de modelos de linguagem em larga escala, o AgentRE enfrenta com eficácia os desafios de diversos tipos de relacionamento na extração de relacionamentos em cenas complexas e relacionamentos ambíguos entre entidades em uma única frase. O AgentRE consiste em três módulos principais que permitem que os agentes adquiram e processem informações de forma eficiente e melhorem significativamente o desempenho do RE.

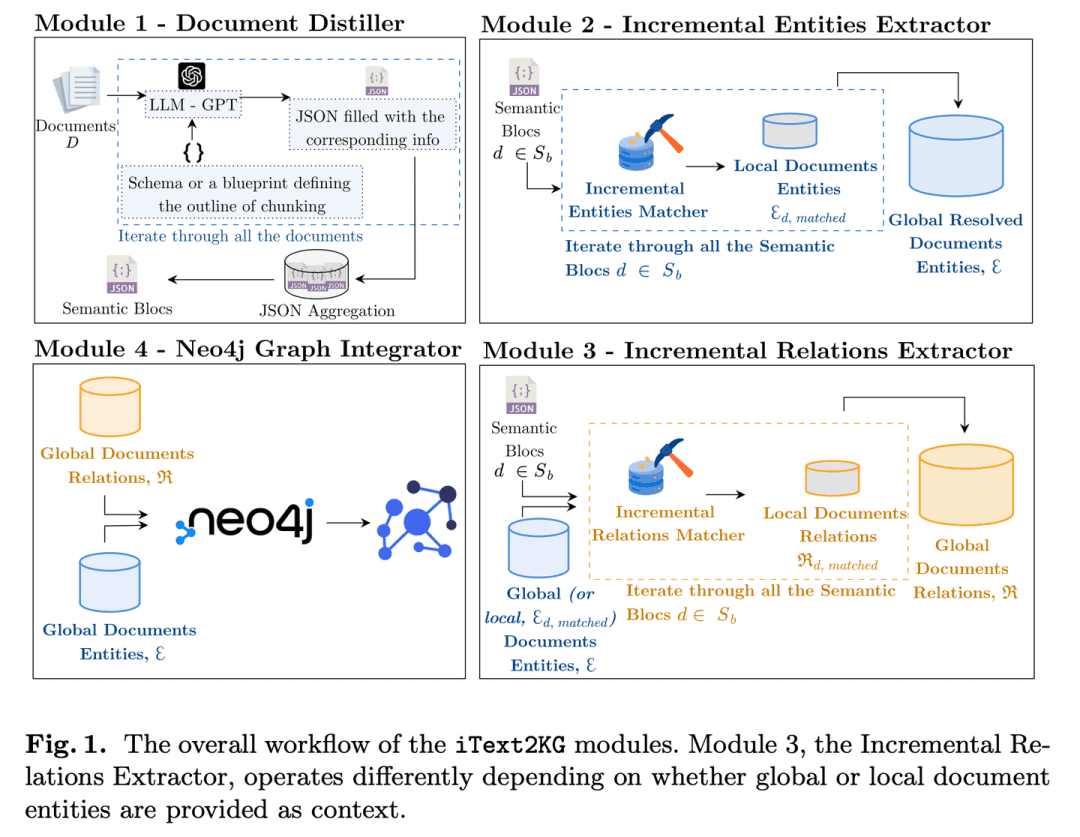

(42) iText2KG [Arquiteto]

arquitetosComo um engenheiro organizado, ele transforma gradualmente documentos fragmentados em uma rede de conhecimento sistemática, refinando, extraindo e integrando informações em etapas, e não exige a preparação prévia de desenhos arquitetônicos detalhados, podendo ser expandido e aprimorado com flexibilidade conforme necessário.

- Tese: iText2KG: Construção de gráficos de conhecimento incremental usando modelos de linguagem grandes

- Projeto: https://github.com/AuvaLab/itext2kg

O iText2KG (Incremental Knowledge Graph Construction) utiliza modelos de linguagem grandes (LLMs) para criar gráficos de conhecimento a partir de documentos brutos e permite a construção incremental de gráficos de conhecimento por meio de quatro módulos (refinador de documentos, extrator de entidades incremental, extrator de relações incremental e integrador de gráficos) sem a necessidade de definição prévia de ontologias ou de treinamento supervisionado extensivo.

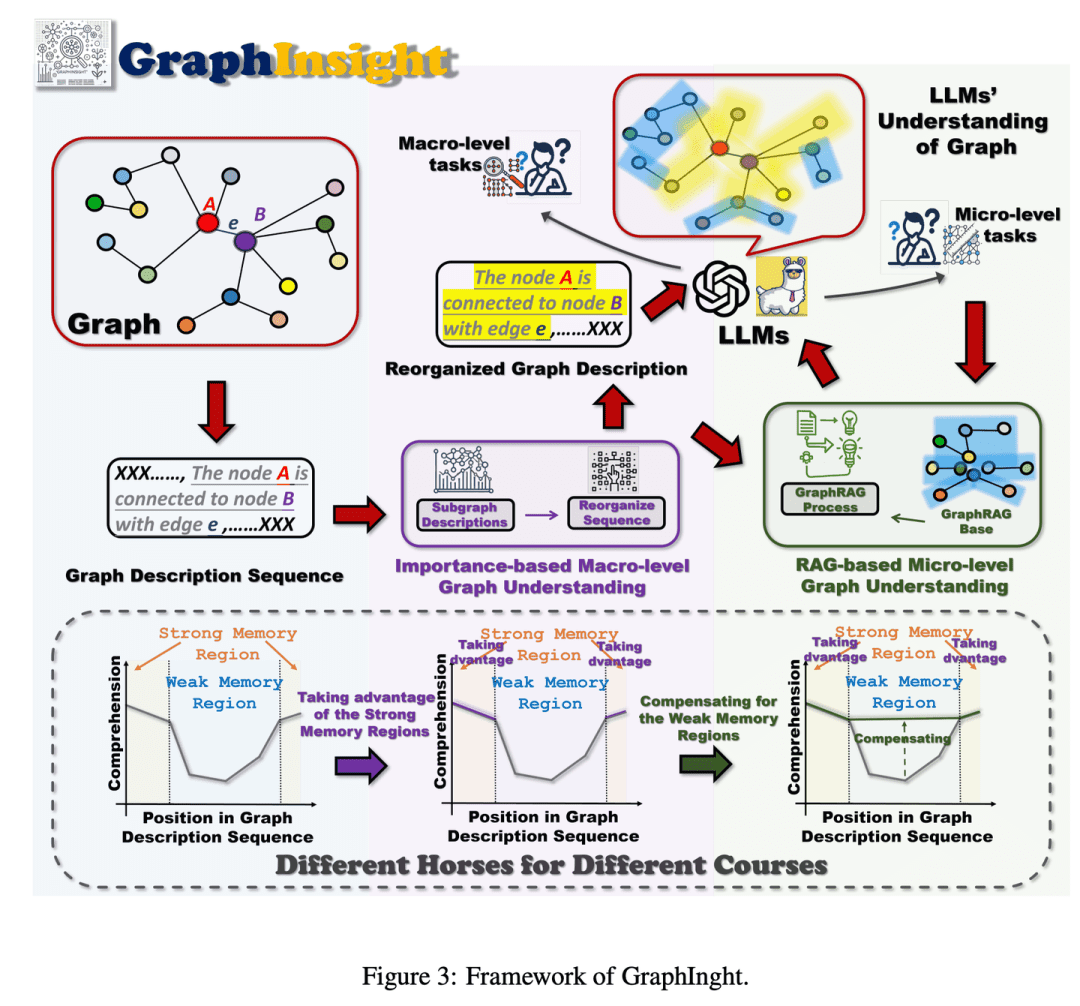

(43) GraphInsight [interpretação gráfica]

interpretação do atlasComo um especialista em análise de infográficos, sabendo colocar informações importantes nos locais mais proeminentes, consultando referências para acrescentar detalhes quando necessário e raciocinando passo a passo em gráficos complexos para que a IA tenha uma visão geral sem perder os detalhes.

- Tese: GraphInsight: revelando percepções em grandes modelos de linguagem para a compreensão da estrutura de gráficos

O GraphInsight se baseia em duas estratégias principais: 1) colocar as principais informações de gráficos em locais onde os LLMs têm um bom desempenho de memória e 2) introduzir bases de conhecimento externas leves para regiões com baixo desempenho de memória, com base na ideia de Retrieval Augmented Generation (RAG). Além disso, o GraphInsight explora a integração dessas duas estratégias no processo do agente LLM para tarefas de gráficos compostos que exigem raciocínio em várias etapas.

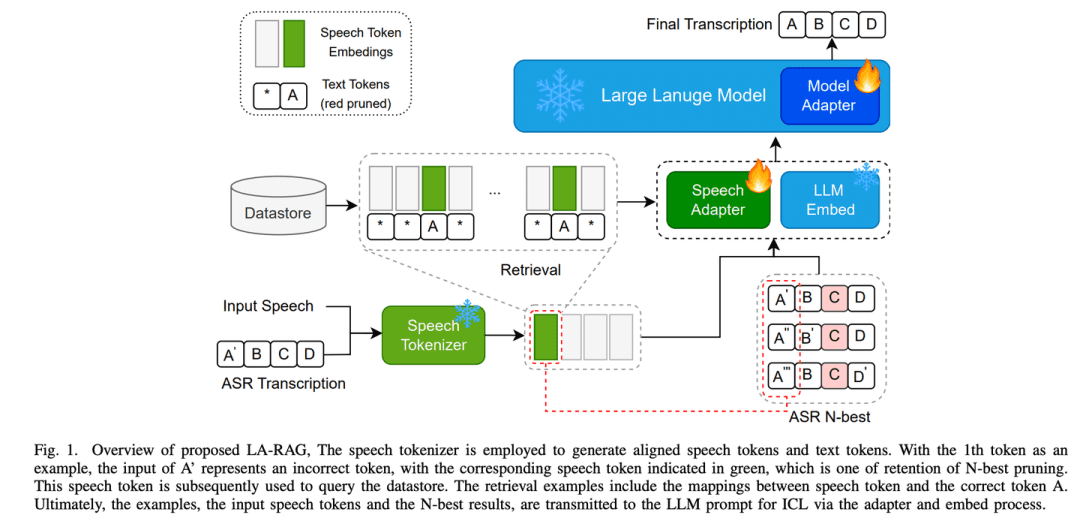

(44) LA-RAG [Dialeto Pass]

livro de dialetosComo um linguista que conhece bem os dialetos de diferentes lugares, a IA pode identificar com precisão não apenas o mandarim padrão, mas também entender os sotaques com características locais por meio de uma análise meticulosa da fala e da compreensão contextual, permitindo que a IA se comunique com pessoas de diferentes regiões sem nenhuma barreira.

- Tese: LA-RAG: aprimorando a precisão da ASR baseada em LLM com geração aumentada por recuperação

LA-RAG, um novo paradigma de Geração Aumentada de Recuperação (RAG) para ASR baseado em LLM. O LA-RAG utiliza armazenamento de dados de fala em nível de token refinado e mecanismos de recuperação de fala para melhorar a precisão da ASR por meio da funcionalidade de Aprendizagem Contextual LLM (ICL).

(45) SFR-RAG [busca refinada]

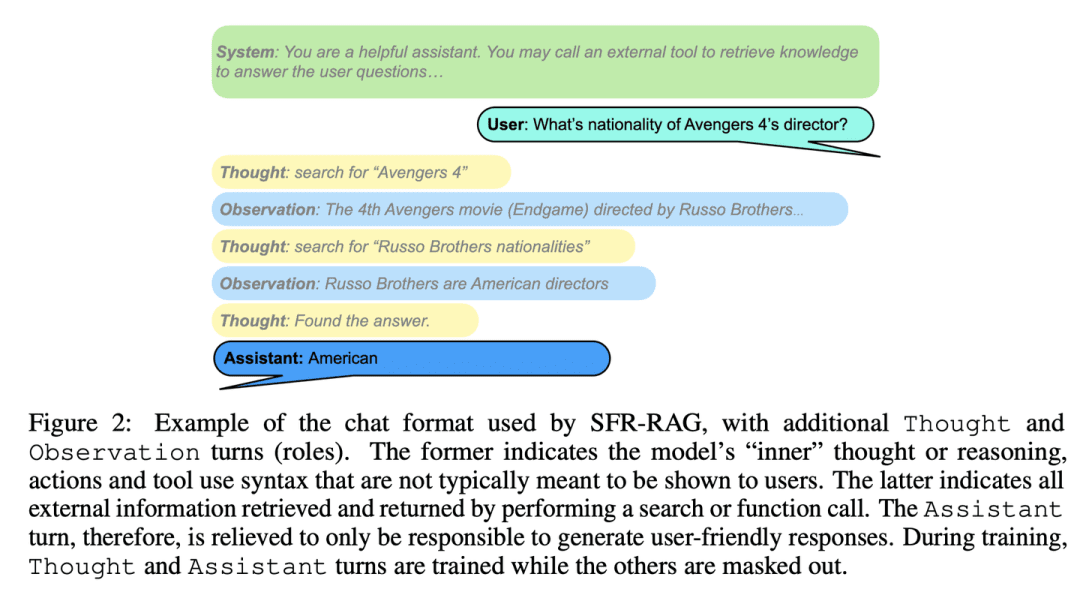

Pesquisa simplificadaComo um consultor de referência refinado, pequeno em tamanho, mas preciso em sua função, ele entende as necessidades e sabe como buscar ajuda externa, garantindo que as respostas sejam precisas e eficientes.

- Tese: SFR-RAG: rumo a LLMs contextualmente fiéis

O SFR-RAG é um modelo de linguagem pequeno, ajustado com instruções que se concentram na geração baseada em contexto e na minimização de ilusões. Ao se concentrar na redução do número de argumentos e, ao mesmo tempo, manter o alto desempenho, o modelo SFR-RAG inclui a funcionalidade de chamada de função que permite interagir dinamicamente com ferramentas externas para recuperar informações contextuais de alta qualidade.

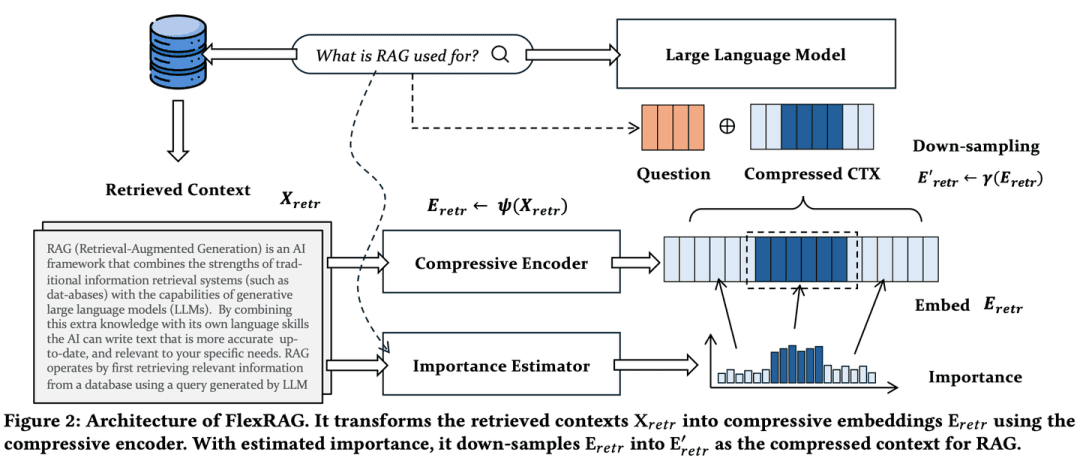

(46) FlexRAG [Especialista em compressão]

Especialista em compressãoCondensar um discurso longo em um resumo conciso, e a taxa de compactação pode ser ajustada de forma flexível de acordo com as necessidades, de modo que as principais informações não sejam perdidas e os custos de armazenamento e processamento possam ser economizados. É como refinar um livro grosso em uma nota de leitura concisa.

- Tese: Lighter And Better: Towards Flexible Context Adaptation For Retrieval Augmented Generation

O contexto recuperado pelo FlexRAG é compactado em embeddings compactos antes de ser codificado pelos LLMs. Ao mesmo tempo, esses embeddings compactados são otimizados para melhorar o desempenho dos RAGs downstream. Um recurso importante do FlexRAG é sua flexibilidade para suportar com eficiência diferentes taxas de compactação e reter seletivamente contextos importantes. Graças a esses projetos técnicos, o FlexRAG alcança uma qualidade de geração superior e reduz significativamente os custos operacionais. Experimentos abrangentes em vários conjuntos de dados de perguntas e respostas validam nossa abordagem como uma solução econômica e flexível para sistemas RAG.

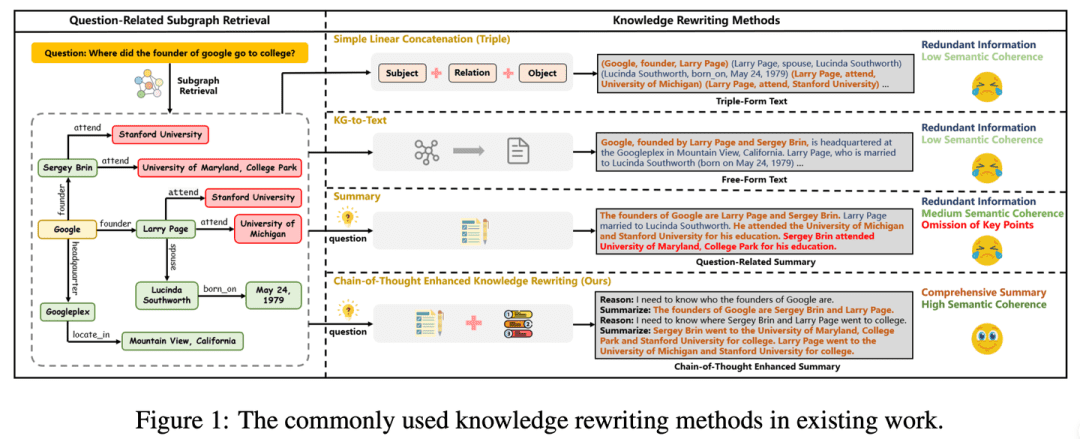

(47) CoTKR [tradução do atlas]

tradução do atlasComo um professor paciente, ele entende o contexto do conhecimento e o explica passo a passo, não apenas repetindo-o, mas transmitindo-o em profundidade. Ao mesmo tempo, ao coletar feedback dos alunos, você pode aprimorar sua própria maneira de explicar, de modo que o conhecimento possa ser transmitido de forma mais clara e eficaz.

- Tese: CoTKR: Reescrita de conhecimento aprimorada por cadeia de pensamento para resposta a perguntas de gráficos de conhecimento complexos

- Projeto: https://github.com/wuyike2000/CoTKR

A abordagem CoTKR (Chain-of-Thought Enhanced Knowledge Rewriting) alterna entre a geração de caminhos de inferência e o conhecimento correspondente, superando assim a limitação da reescrita de conhecimento em uma única etapa. Além disso, para superar a diferença de preferências entre o reescritor de conhecimento e o modelo de controle de qualidade, propomos uma estratégia de treinamento que alinha as preferências do feedback de perguntas e respostas para otimizar ainda mais o reescritor de conhecimento, explorando o feedback do modelo de controle de qualidade.

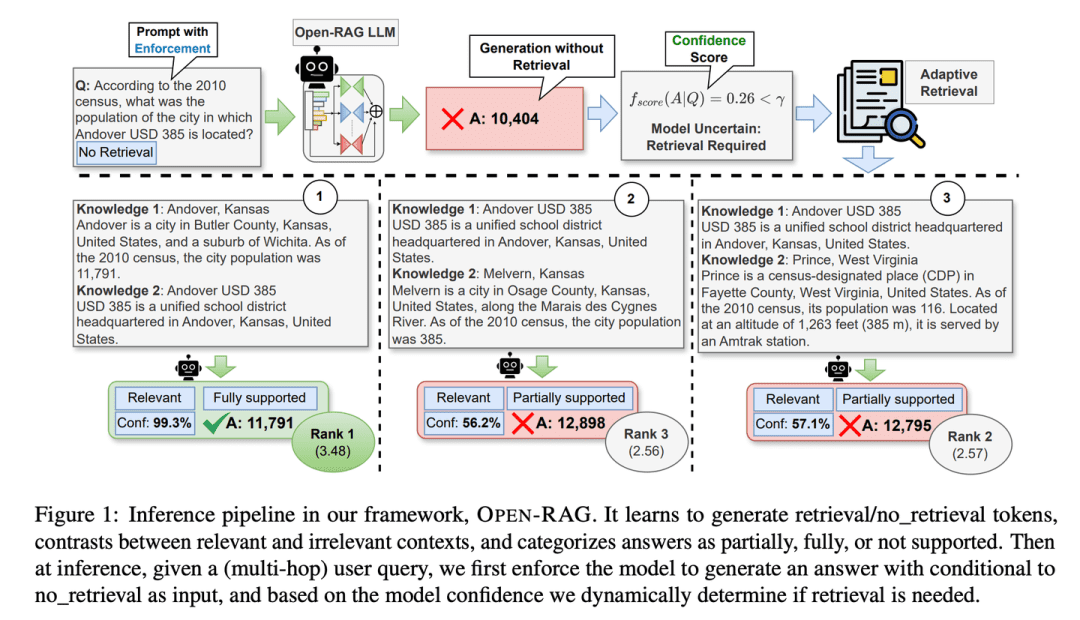

(48) Open-RAG [Think Tank]

repositórioO que é um modelo de linguagem: dividir enormes modelos de linguagem em grupos de especialistas que possam pensar de forma independente e trabalhar em conjunto, além de serem particularmente bons em distinguir entre informações verdadeiras e falsas, sabendo se devem ou não procurar informações em momentos críticos, como um think tank experiente.

- Tese: Open-RAG: Raciocínio aprimorado de recuperação aumentada com modelos de linguagem grandes e de código aberto

- Projeto: https://github.com/ShayekhBinIslam/openrag

O Open-RAG aprimora o raciocínio no RAG por meio de modelos de linguagem grandes e de código aberto, convertendo modelos de linguagem grandes e arbitrariamente densos em modelos esparsos de Mistura de Especialistas (MoE) eficientes em termos de parâmetros, capazes de lidar com tarefas de raciocínio complexas, incluindo consultas de salto único e de vários saltos.

(49) TableRAG [Especialista em Excel]

Especialista em ExcelInformações sobre a tabela: Vá além da simples visualização de dados tabulares e saiba como entender e recuperar dados nas dimensões de cabeçalho e de célula, usando com a mesma proficiência uma tabela dinâmica para localizar e extrair rapidamente as principais informações de que você precisa.

- Artigo: TableRAG: Compreensão de tabelas de milhões de palavras com modelos de linguagem

O TableRAG projetou uma estrutura de geração aprimorada de recuperação especificamente para a compreensão de tabelas, combinando a recuperação de esquemas e células por meio da expansão de consultas para identificar os principais dados antes de fornecer informações ao modelo de linguagem, permitindo uma codificação de dados mais eficiente e uma recuperação precisa, diminuindo drasticamente o comprimento das dicas e reduzindo a perda de informações.

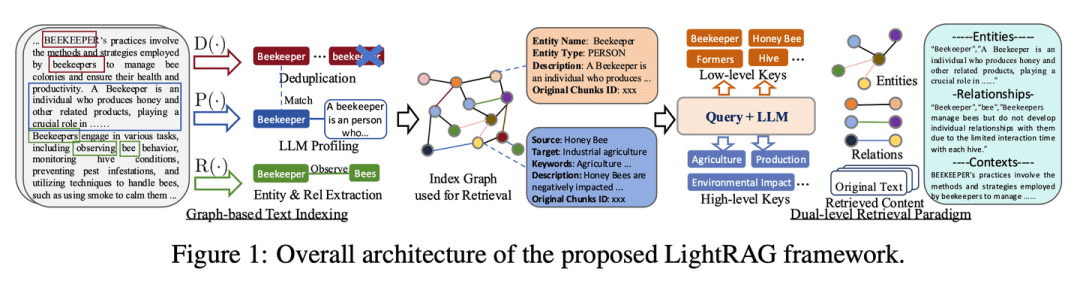

(50) LightRAG [Homem-Aranha]

homem-aranhaNavegação ágil pela teia do conhecimento, capturando os filamentos entre os pontos, mas também usando a teia para seguir os fios. Como um bibliotecário clarividente, você não apenas sabe onde está cada livro, mas também sabe quais livros devem ser lidos juntos.

- Tese: LightRAG: geração simples e rápida de recuperação aumentada

- Projeto: https://github.com/HKUDS/LightRAG

A estrutura integra estruturas gráficas ao processo de indexação e recuperação de texto. Essa estrutura inovadora emprega um sistema de recuperação de duas camadas que aprimora a recuperação abrangente de informações a partir da descoberta de conhecimento de baixo e alto nível. Além disso, a combinação de estruturas gráficas com representações vetoriais facilita a recuperação eficiente de entidades relevantes e seus relacionamentos, melhorando significativamente os tempos de resposta e mantendo a relevância contextual. Esse recurso é aprimorado ainda mais por um algoritmo de atualização incremental que garante a integração oportuna de novos dados, permitindo que o sistema permaneça eficaz e responsivo em um ambiente de dados que muda rapidamente.

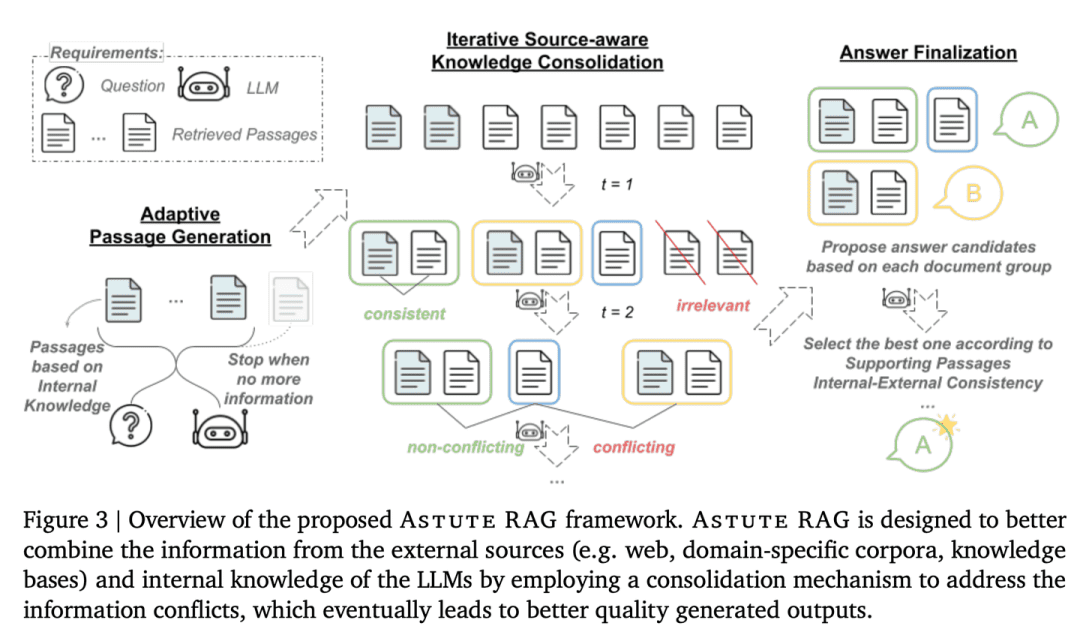

(51) AstuteRAG [Juiz Sábio]

Juiz sensatoConhecimento acumulado: permanecer atento às informações externas, não confiar nos resultados das pesquisas, fazer bom uso do próprio conhecimento acumulado, verificar a autenticidade das informações e pesar as evidências de várias partes para chegar a uma conclusão, assim como um juiz sênior.

- Tese: Astute RAG: Superando o aumento imperfeito da recuperação e os conflitos de conhecimento para modelos de idiomas grandes

A robustez e a confiabilidade do sistema são aprimoradas por meio da extração adaptativa de informações do conhecimento interno dos LLMs, combinando-as com resultados de pesquisa externos e finalizando a resposta com base na confiabilidade das informações.

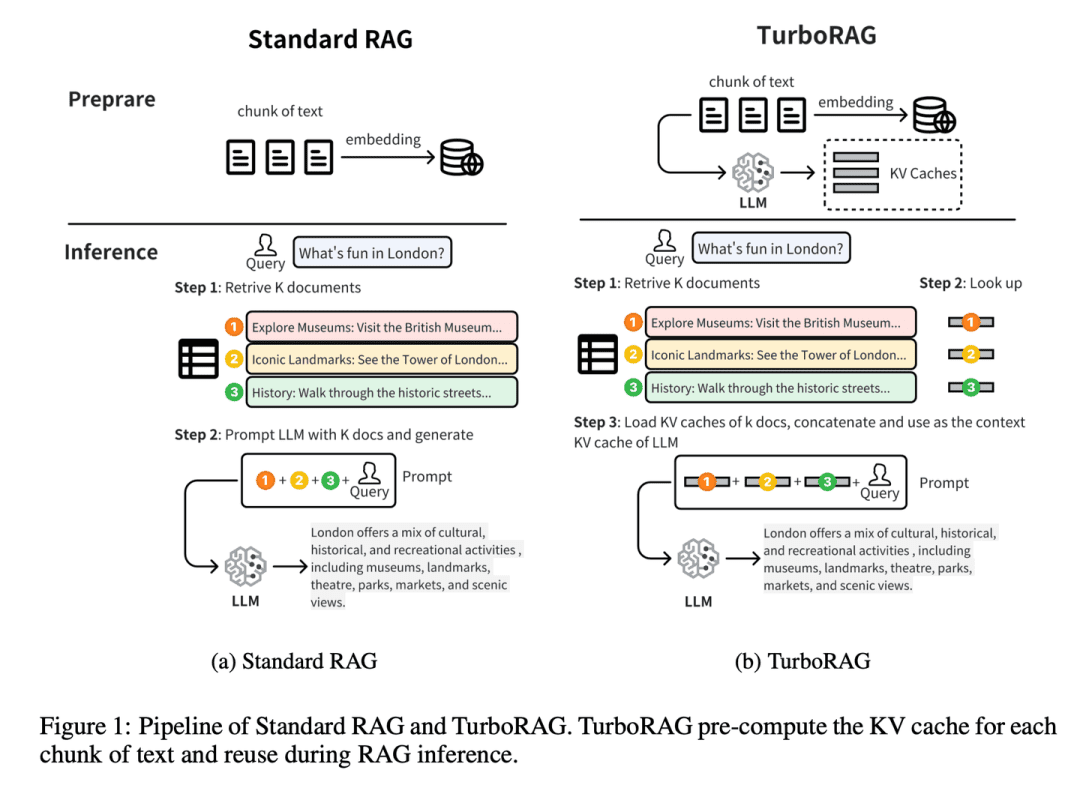

(52) TurboRAG [mestre de taquigrafia]

mestre estenógrafoFaça sua lição de casa com antecedência e anote todas as respostas em um caderno pequeno. Como um valentão de escola que faz um raid antes do exame, não coloque o fecho clínico, mas as perguntas comuns com antecedência no livro errado. Quando precisar usá-lo diretamente, economize todas as vezes que tiver que deduzir uma vez no local.

- Tese: TurboRAG: aceleração da geração aumentada de recuperação com caches KV pré-computados para texto fragmentado

- Projeto: https://github.com/MooreThreads/TurboRAG

O TurboRAG otimiza o paradigma de raciocínio do sistema RAG pré-computando e armazenando os caches KV de documentos off-line. Diferentemente das abordagens tradicionais, o TurboRAG não calcula mais esses caches KV em cada inferência, mas recupera caches pré-computados para uma pré-população eficiente, eliminando a necessidade de computação on-line repetitiva. Essa abordagem reduz significativamente a sobrecarga computacional e acelera o tempo de resposta, mantendo a precisão.

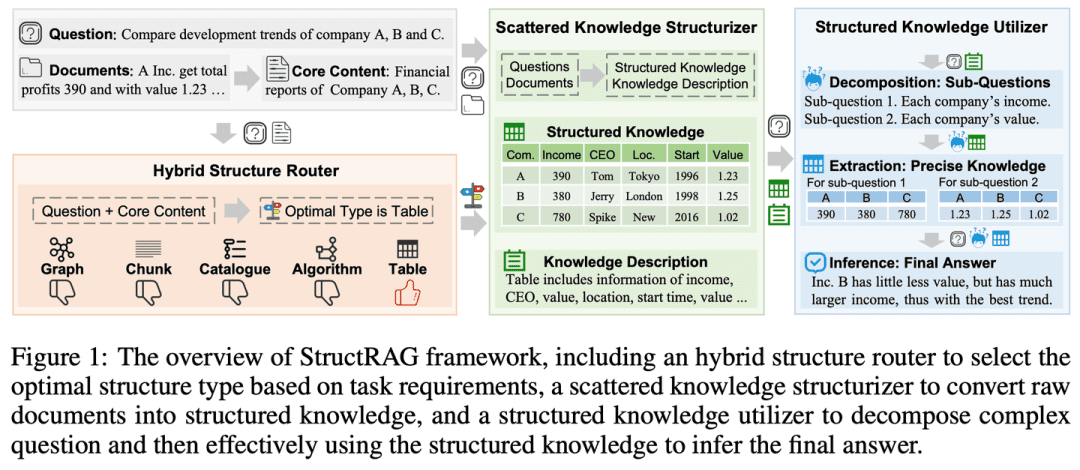

(53) StructRAG [Organizador]

organizadorOrganize a confusão de informações em categorias, como um guarda-roupa organizado. Como um professor imitando a mente humana, em vez de memorização mecânica, desenhe primeiro um mapa mental.

- Tese: StructRAG: Impulsionando o raciocínio intensivo de conhecimento de LLMs por meio da estruturação de informações híbridas em tempo de inferência

- Projeto: https://github.com/Li-Z-Q/StructRAG

Inspirada na teoria cognitiva de que os seres humanos convertem informações brutas em conhecimento estruturado ao lidar com o raciocínio com uso intensivo de conhecimento, a estrutura apresenta um mecanismo híbrido de estruturação de informações que constrói e utiliza o conhecimento estruturado no formato mais adequado, de acordo com os requisitos específicos da tarefa em questão. Ao imitar processos de pensamento semelhantes aos humanos, ele melhora o desempenho do LLM em tarefas de raciocínio com uso intensivo de conhecimento.

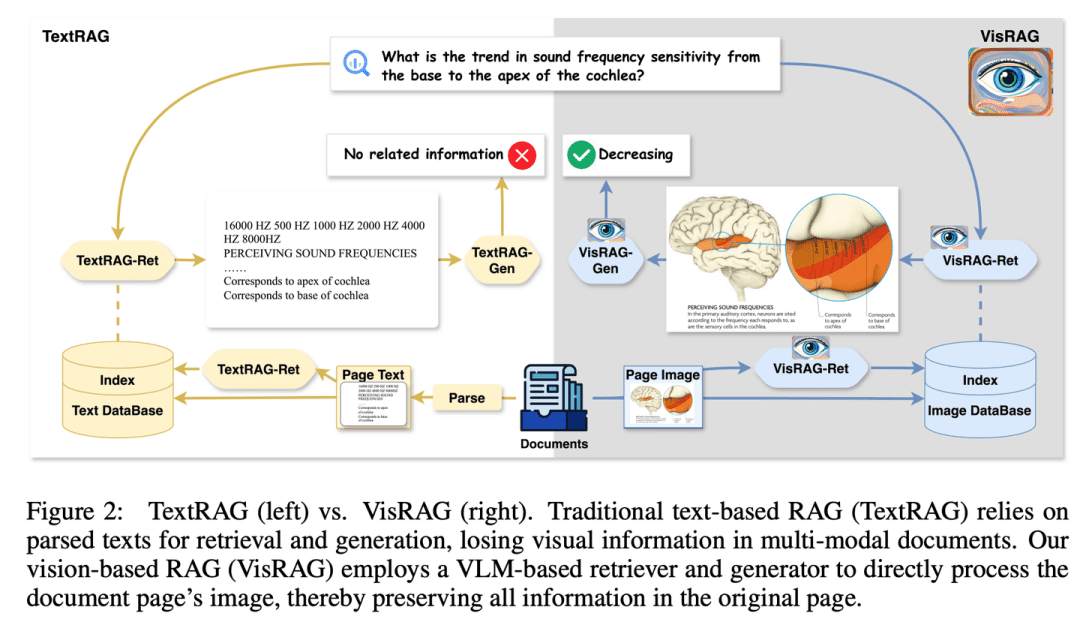

(54) VisRAG [olhos de fogo]

olhos perspicazesFinalmente, percebi que as palavras são apenas uma forma especial de expressão de imagens. Como um leitor que abriu os olhos, ele não insiste mais em analisar palavra por palavra, mas "vê" diretamente a imagem inteira. Em vez de usar o OCR, usei uma câmera e aprendi a essência de que "uma imagem vale mais que mil palavras".

- Tese: VisRAG: geração aumentada de recuperação baseada em visão em documentos multimodais

- Projeto: https://github.com/openbmb/visrag

A geração é aprimorada com a construção de um processo RAG baseado no Modelo Visual-Linguístico (VLM) que incorpora e recupera documentos diretamente como imagens. Em comparação com o RAG de texto tradicional, o VisRAG evita a perda de informações durante a análise e preserva as informações do documento original de forma mais abrangente. Os experimentos mostram que o VisRAG supera o RAG tradicional nas fases de recuperação e geração, com uma melhoria de desempenho de ponta a ponta de 25 a 391 TP3 T. O VisRAG não só faz uso eficaz dos dados de treinamento, mas também demonstra fortes recursos de generalização, o que o torna a opção ideal para o RAG de documentos multimodais.

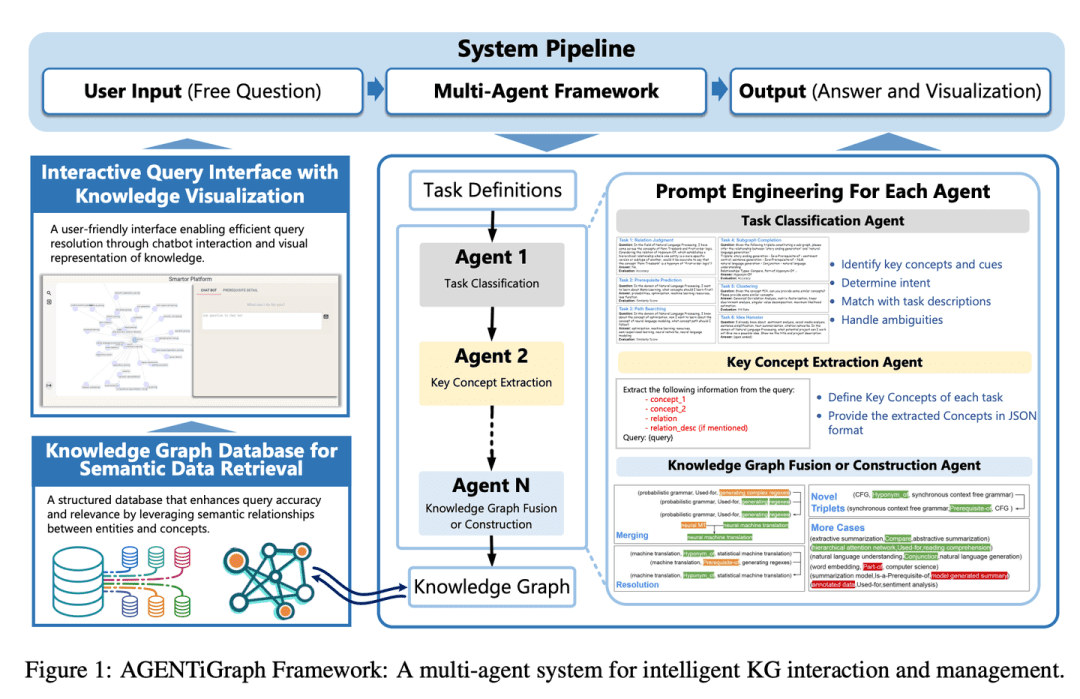

(55) AGENTiGraph [Gerente de conhecimento]

gerente de conhecimentoComo um bibliotecário conversacional, ele o ajuda a organizar e apresentar seu conhecimento por meio da comunicação diária, com uma equipe de assistentes prontos para responder a perguntas e atualizar informações, tornando o gerenciamento do conhecimento fácil e natural.

- Tese: AGENTiGraph: uma plataforma de gráfico de conhecimento interativo para chatbots baseados em LLM que utilizam dados privados

O AGENTiGraph é uma plataforma para o gerenciamento do conhecimento por meio da interação com a linguagem natural. O AGENTiGraph emprega uma arquitetura de inteligência múltipla para interpretar dinamicamente a intenção do usuário, gerenciar tarefas e integrar novos conhecimentos, garantindo que ele possa se adaptar às necessidades do usuário e aos contextos de dados em constante mudança.

(56) RuleRAG [Regra a seguir]

seguir a bússola e seguir o esquadro (expressão idiomática); seguir as regras inflexivelmenteEnsinar a IA a fazer coisas com regras é como trazer uma nova pessoa a bordo e dar a ela um manual do funcionário primeiro. Em vez de aprender sem objetivo, é como um professor rigoroso que primeiro explica as regras e os exemplos e depois deixa os alunos fazerem isso sozinhos. Além disso, essas regras se tornam memória muscular e, da próxima vez que você encontrar problemas semelhantes, saberá naturalmente como lidar com eles.

- Tese: RuleRAG: geração complementada por recuperação guiada por regras com modelos de linguagem para resposta a perguntas

- Projeto: https://github.com/chenzhongwu20/RuleRAG_ICL_FT

O RuleRAG propõe uma abordagem de geração aprimorada de recuperação orientada por regras com base em um modelo de linguagem, que introduz explicitamente regras simbólicas como exemplos de aprendizado contextual (RuleRAG - ICL) para orientar um recuperador a recuperar documentos logicamente relevantes na direção das regras e orientar uniformemente um gerador a produzir respostas informadas orientadas pelo mesmo conjunto de regras. Além disso, a combinação de consultas e regras pode ser usada como dados de ajuste fino supervisionados para atualizar os recuperadores e geradores (RuleRAG - FT) para obter melhor aderência às instruções baseadas em regras, o que, por sua vez, recupera resultados mais favoráveis e gera respostas mais aceitáveis.

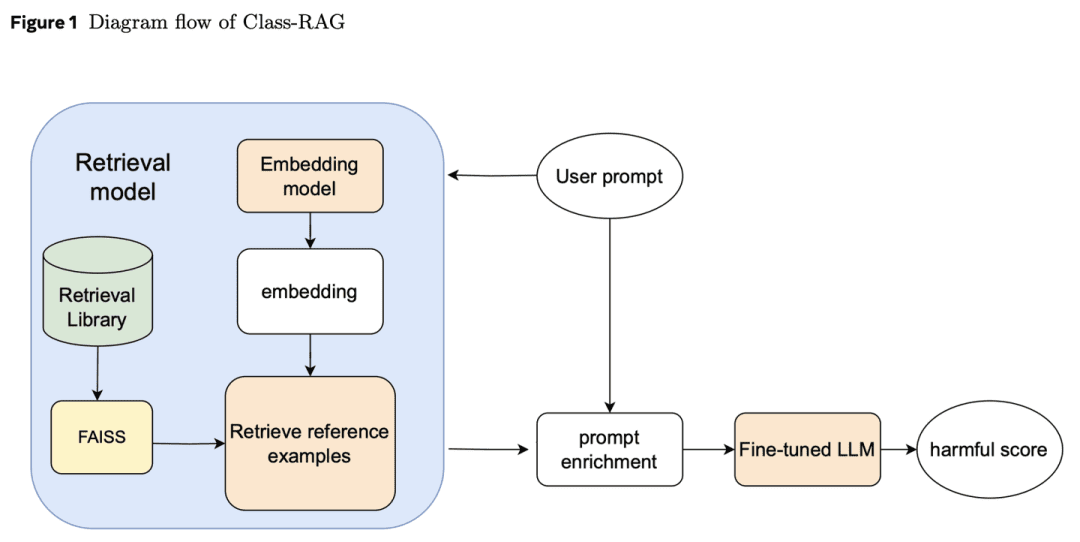

(57) Classe-RAG [Juízes]

juizEm vez de se basear em disposições rígidas para decidir casos, a sentença é examinada por meio de uma biblioteca de jurisprudência em constante expansão. Como um juiz experiente, ele tem em mãos um códice de folhas soltas e lê os casos mais recentes a qualquer momento, de modo que o julgamento tenha temperatura e escala.

- Tese: Class-RAG: Moderação de conteúdo com geração aumentada de recuperação

Os classificadores de verificação de conteúdo são essenciais para a segurança da IA generativa. No entanto, as nuances entre conteúdo seguro e inseguro geralmente são difíceis de distinguir. À medida que as tecnologias se tornam amplamente disponíveis, fica cada vez mais difícil e caro ajustar continuamente os modelos para lidar com os riscos. Para isso, propomos a abordagem Class-RAG, que alcança a mitigação imediata de riscos ao atualizar dinamicamente a base de recuperação. O Class-RAG é mais flexível e transparente do que os modelos tradicionais de ajuste fino e apresenta melhor desempenho em termos de classificação e resistência a ataques. Também é demonstrado que a expansão da base de pesquisa pode melhorar efetivamente o desempenho da auditoria a baixo custo.

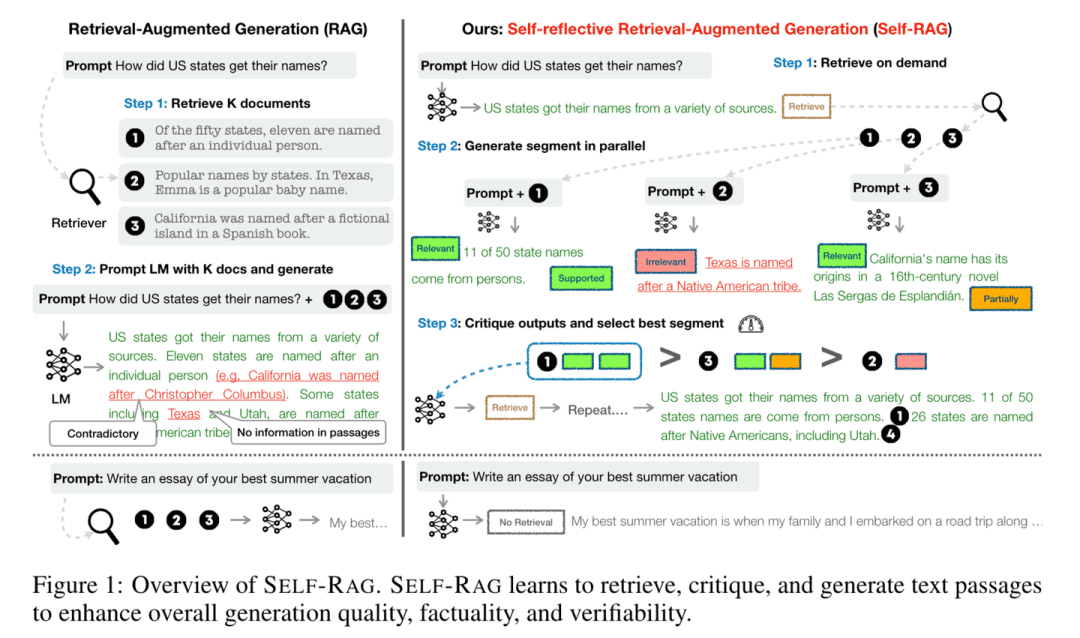

(58) Self-RAG [Refletor]

pensadorQuando respondem a perguntas, eles não apenas consultam informações, mas também pensam e verificam se suas respostas são precisas e completas. Ao "pensar enquanto fala", como um acadêmico prudente, ele ou ela garante que cada ponto de vista seja apoiado por evidências sólidas.

- Tese: Self-RAG: Aprendendo a recuperar, gerar e criticar por meio da autorreflexão

- Projeto: https://github.com/AkariAsai/self-rag

O Self-RAG melhora a qualidade e a precisão dos modelos de linguagem por meio da recuperação e da autorreflexão. A estrutura treina um único modelo de linguagem arbitrário que pode recuperar passagens sob demanda de forma adaptativa e usar marcadores especiais chamados marcadores reflexivos para gerar e refletir sobre as passagens recuperadas e seu próprio conteúdo gerado. A geração de marcadores reflexivos torna o modelo de linguagem controlável na fase de raciocínio, permitindo que ele adapte seu comportamento aos diferentes requisitos da tarefa.

(59) SimRAG [autodidata]

um gênio que se fez sozinhoQuando se deparar com uma área de especialização, faça suas próprias perguntas antes de respondê-las e aprimore sua reserva de conhecimento profissional por meio da prática constante, assim como os alunos se familiarizam com seu conhecimento profissional fazendo exercícios repetidamente.

- Tese: SimRAG: Geração de Recuperação-Aumentada Auto-aperfeiçoada para Adaptar Grandes Modelos de Linguagem a Domínios Especializados

O SimRAG é um método de autotreinamento que equipa os LLMs com os recursos conjuntos de perguntas e respostas e geração de perguntas para atender a domínios específicos. Boas perguntas só podem ser feitas se o conhecimento for realmente compreendido. Esses dois recursos se complementam para ajudar o modelo a entender melhor o conhecimento especializado. Primeiro, o LLM é ajustado em termos de seguimento de instruções, perguntas e respostas e busca de dados relevantes. Em seguida, ele solicita que o mesmo LLM gere uma variedade de perguntas relevantes para o domínio a partir de um corpus não rotulado, com estratégias de filtragem adicionais para reter exemplos sintéticos de alta qualidade. Ao utilizar esses exemplos sintéticos, o LLM pode melhorar seu desempenho em tarefas RAG específicas do domínio.

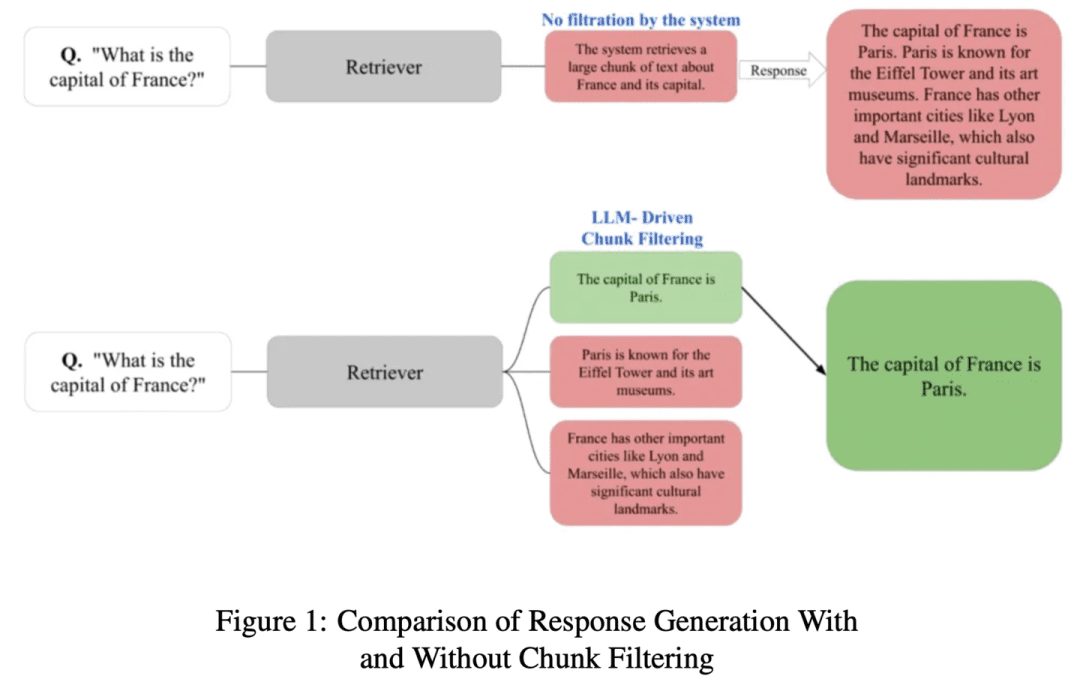

(60) ChunkRAG [trechos do mestre]

pessoa que tira trechos de um livroO que fazer: dividir artigos longos em parágrafos menores e, em seguida, selecionar as partes mais relevantes com um olhar profissional, sem perder o foco ou se distrair com conteúdo irrelevante.

- Tese: ChunkRAG: Novo método de filtragem LLM-Chunk para sistemas RAG

O ChunkRAG propõe uma abordagem de filtragem de pedaços orientada por LLM para aprimorar a estrutura dos sistemas RAG, avaliando e filtrando as informações recuperadas em nível de pedaços, em que os "pedaços" representam partes menores e coerentes de um documento. Nossa abordagem emprega a fragmentação semântica para dividir o documento em partes coerentes e usa a pontuação de relevância com base em um grande modelo de linguagem para avaliar se cada parte corresponde à consulta do usuário. Ao filtrar os pedaços menos relevantes antes da fase de geração, reduzimos significativamente as ilusões e melhoramos a precisão dos fatos.

(61) FastGraphRAG [Radar]

radar (palavra emprestada)Como o Page Rank do Google, dê aos pontos de conhecimento uma lista quente. É como um líder de opinião em uma rede social: quanto mais pessoas o seguirem, mais fácil será ser visto. Em vez de procurar sem rumo, é como um batedor com radar, procurando onde quer que o sinal seja forte.

- Projeto: https://github.com/circlemind-ai/fast-graphrag

O FastGraphRAG oferece uma estrutura Fast Graph Retrieval Augmented Generation (FastGraphRAG) eficiente, interpretável e altamente precisa. Ele aplica o algoritmo PageRank ao processo de passagem do gráfico de conhecimento para localizar rapidamente os nós de conhecimento mais relevantes. Ao calcular a pontuação de importância de um nó, o PageRank permite que o GraphRAG filtre e classifique as informações no gráfico de conhecimento de forma mais inteligente. Isso é como equipar o GraphRAG com um "Radar de importância", que pode localizar rapidamente as principais informações em uma grande quantidade de dados.

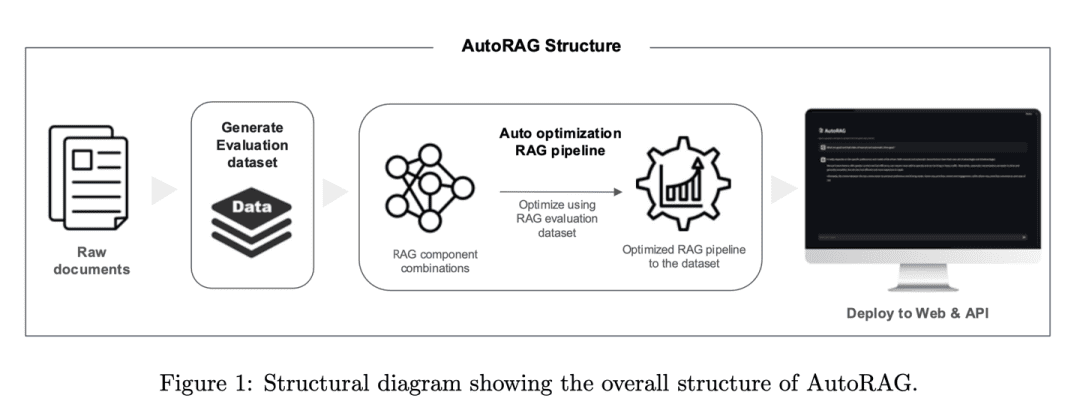

(62) AutoRAG [Tuner]

sintonizadorO RAG é um afinador experiente que encontra o melhor som não por adivinhação, mas por testes científicos. Ele experimenta automaticamente várias combinações de RAGs, assim como um afinador testa diferentes equipamentos de áudio para encontrar a "solução de reprodução" mais harmoniosa.

- Tese: AutoRAG: Estrutura automatizada para otimização do Pipeline de Geração Aumentada de Recuperação

- Projeto: https://github.com/Marker-Inc-Korea/AutoRAG_ARAGOG_Paper

A estrutura do AutoRAG identifica automaticamente os módulos RAG adequados para um determinado conjunto de dados e explora e aproxima a combinação ideal de módulos RAG para esse conjunto de dados. Ao avaliar sistematicamente diferentes configurações de RAG para otimizar a escolha das técnicas, a estrutura é semelhante à prática do AutoML no aprendizado de máquina tradicional, em que são realizados experimentos extensos para otimizar a escolha das técnicas de RAG e melhorar a eficiência e a escalabilidade do sistema RAG.

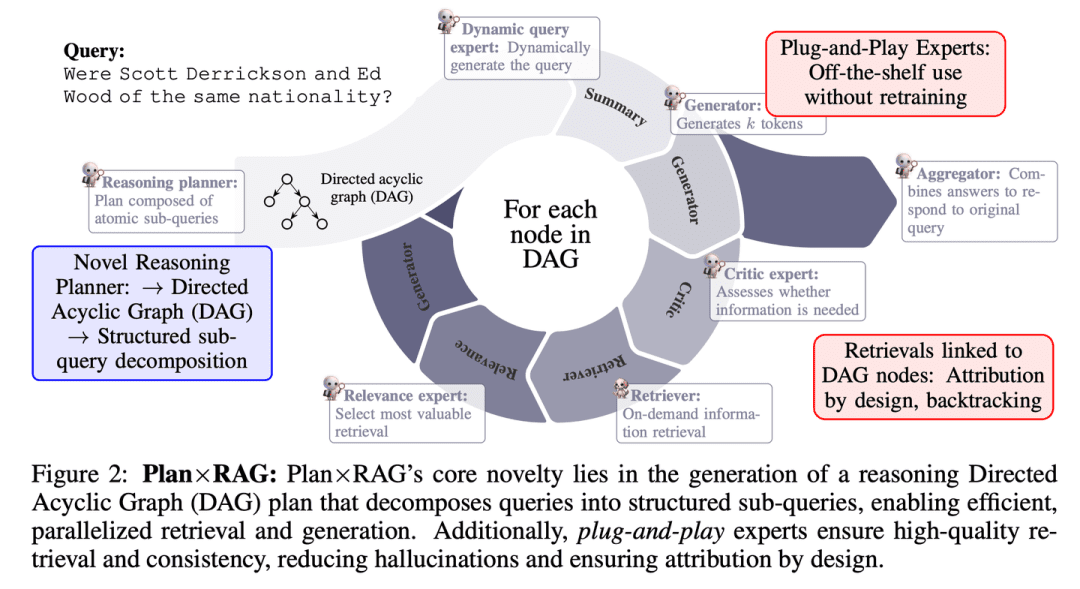

(63) Plano x RAG [Gerente de Projeto]

gerente de projetosPlanejamento antes da ação, dividindo tarefas grandes em tarefas menores e organizando vários "especialistas" para trabalharem em paralelo. Cada especialista é responsável por sua própria área, e o gerente de projeto é responsável por resumir os resultados no final. Essa abordagem não é apenas mais rápida e precisa, mas também fornece um relato claro da origem de cada conclusão.

- Tese: Plan × RAG: Geração Aumentada de Recuperação Orientada por Planejamento

O Plan×RAG é uma nova estrutura que amplia o paradigma de "recuperação - raciocínio" das estruturas RAG existentes para um paradigma de "plano - recuperação". O Plan×RAG formula planos de raciocínio como gráficos acíclicos direcionados (DAGs), que decompõem as consultas em O Plan×RAG formula o plano de raciocínio como um gráfico acíclico direcionado (DAG) e decompõe a consulta em subconsultas atômicas inter-relacionadas. A geração de respostas segue a estrutura DAG, o que aumenta significativamente a eficiência por meio da recuperação e geração paralelas. Embora as soluções RAG de última geração exijam ampla geração de dados e ajuste fino dos modelos de linguagem (LMs), o Plan×RAG incorpora LMs congelados como especialistas plug-and-play para gerar respostas de alta qualidade.

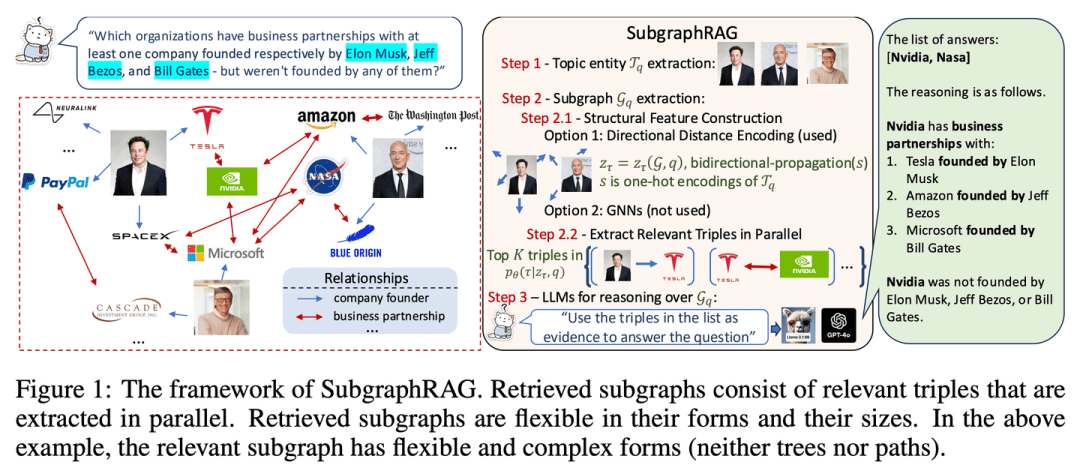

(64) SubgraphRAG [localizador]

posicionadorEm vez de procurar uma agulha em um palheiro, um pequeno mapa de conhecimento é desenhado com precisão para que a IA possa encontrar respostas rapidamente.

- Tese: Simple is Effective: The Roles of Graphs and Large Language Models in Knowledge-Graph-Based Retrieval-Augmented Generation (O simples é eficaz: os papéis dos gráficos e dos modelos de linguagem grandes na geração aumentada de recuperação baseada em gráficos de conhecimento)

- Projeto: https://github.com/Graph-COM/SubgraphRAG

O SubgraphRAG amplia a estrutura RAG baseada em KG, recuperando subgrafos e utilizando LLM para inferência e previsão de respostas. Um perceptron leve de múltiplas camadas é combinado com um mecanismo de pontuação ternário paralelo para recuperação eficiente e flexível de subgrafos, enquanto codifica a distância da estrutura direcionada para melhorar a eficácia da recuperação. O tamanho dos subgrafos recuperados pode ser ajustado de forma flexível para atender aos requisitos da consulta e à capacidade do LLM posterior. Esse projeto atinge um equilíbrio entre a complexidade do modelo e a capacidade de inferência, permitindo um processo de recuperação escalável e versátil.

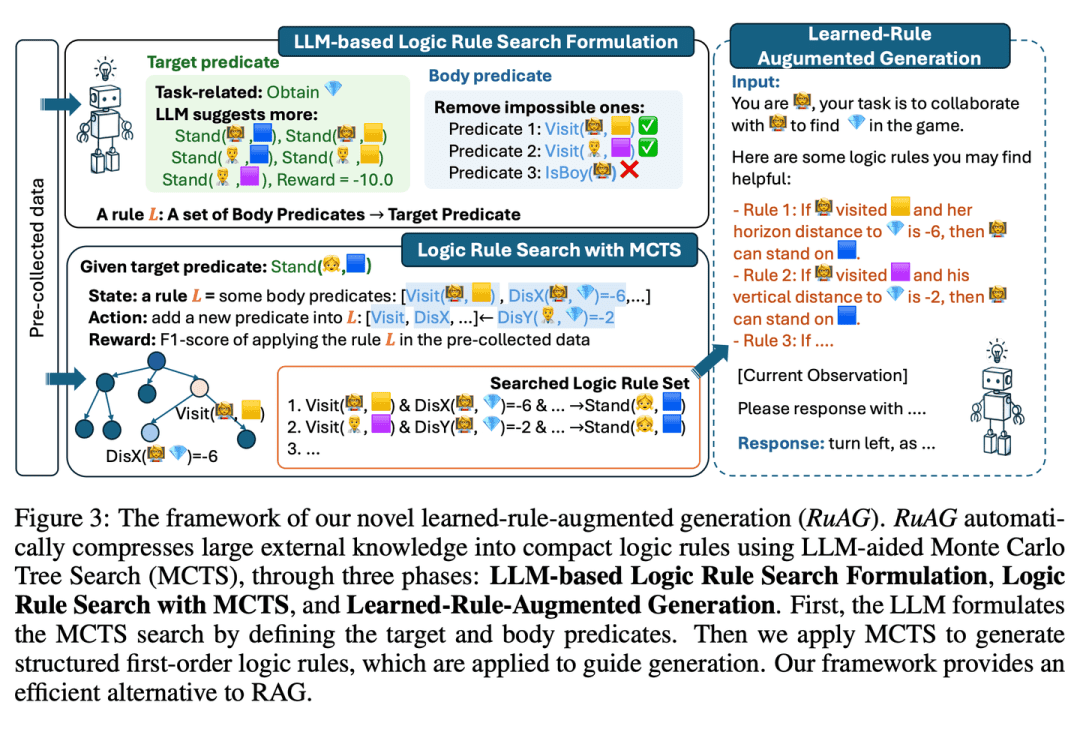

(65) RuRAG [Alquimista]

alquimistaComo um alquimista, ele pode destilar grandes quantidades de dados em regras lógicas claras e expressá-las em linguagem simples, tornando a IA mais inteligente em aplicações práticas.

- Tese: RuAG: Geração de modelos linguísticos grandes com base em regras aprendidas

tem como objetivo aprimorar os recursos de raciocínio dos modelos de linguagem em larga escala (LLMs), destilando automaticamente grandes quantidades de dados off-line em regras lógicas de primeira ordem interpretáveis e injetando-as nos LLMs. A estrutura usa o Monte Carlo Tree Search (MCTS) para descobrir regras lógicas e transformá-las em linguagem natural, permitindo a injeção de conhecimento e a integração perfeita para tarefas posteriores ao LLM. O artigo avalia a eficácia da estrutura em tarefas industriais públicas e privadas, demonstrando seu potencial para aprimorar os recursos de LLM em diversas tarefas.

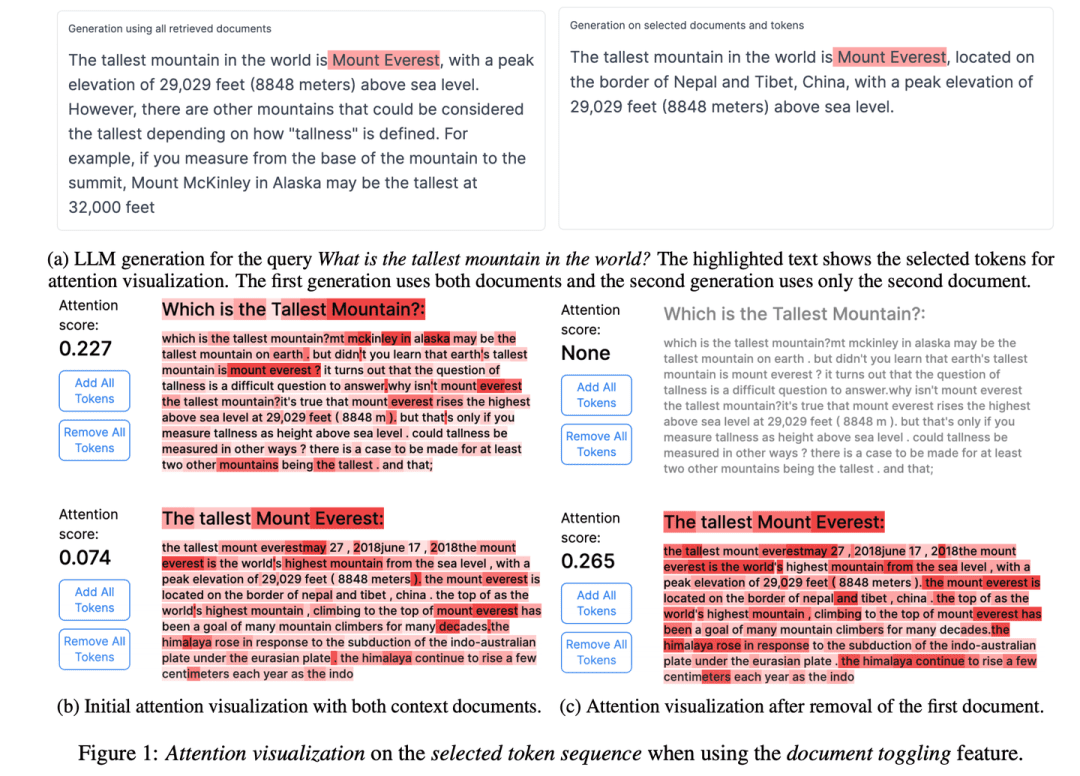

(66) RAGViz [olho transparente]

visão de túnelFaça com que o sistema RAG seja transparente, veja qual frase o modelo está lendo, como um médico olhando para um raio X, e veja o que está errado em um piscar de olhos.

- Tese: RAGViz: Diagnóstico e Visualização da Geração Aumentada de Recuperação

- Projeto: https://github.com/cxcscmu/RAGViz

O RAGViz fornece visualizações de documentos recuperados e atenção ao modelo para ajudar os usuários a entender a interação entre a marcação gerada e os documentos recuperados, e pode ser usado para diagnosticar e visualizar sistemas RAG.

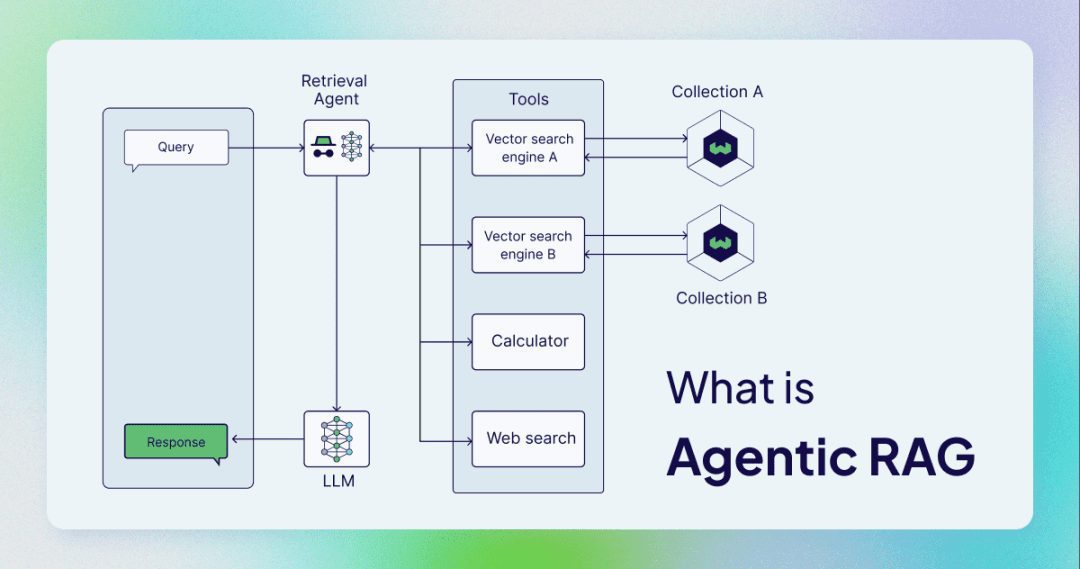

(67) AgenticRAG [Assistente Inteligente]

assistente inteligenteAssistente: Não se trata mais de uma simples questão de procurar e copiar, mas de um assistente que pode atuar como um secretário confidencial. Como um administrador competente, ele não apenas sabe como procurar informações, mas também sabe quando fazer uma ligação telefônica, quando realizar uma reunião e quando pedir instruções.

O AgenticRAG descreve um RAG com base na implementação de inteligências de IA. Especificamente, ele incorpora inteligências de IA ao processo do RAG para coordenar seus componentes e executar ações adicionais além da simples recuperação e geração de informações para superar as limitações dos processos corporais não inteligentes.

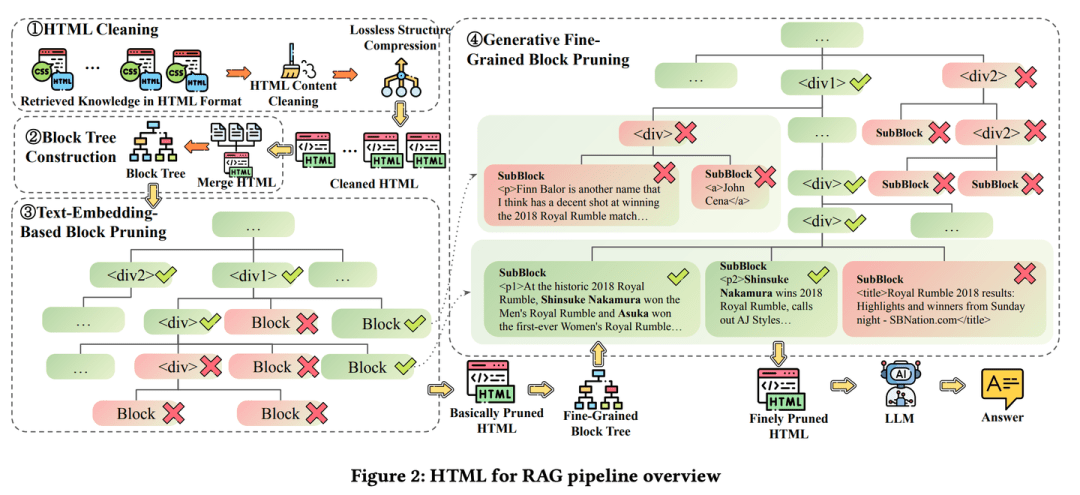

(68) HtmlRAG [Tipógrafo]

tipógrafoO conhecimento não é mantido como um relato contínuo, mas como um layout de revista, com negrito onde o negrito é necessário e rótulo vermelho onde o vermelho é necessário. É como um editor exigente que acha que o conteúdo não é suficiente, mas também o layout, de modo que os pontos principais possam ser vistos em um relance.

- Tese: HtmlRAG: HTML é melhor do que texto simples para modelar o conhecimento recuperado em sistemas RAG

- Projeto: https://github.com/plageon/HtmlRAG

O HtmlRAG usa HTML em vez de texto simples como formato para recuperar conhecimento no RAG; o HTML é melhor do que o texto simples ao modelar o conhecimento de documentos externos e a maioria dos LLMs tem um sólido conhecimento de HTML. O HtmlRAG propõe estratégias de limpeza, compactação e poda de HTML para encurtar o HTML e minimizar a perda de informações.

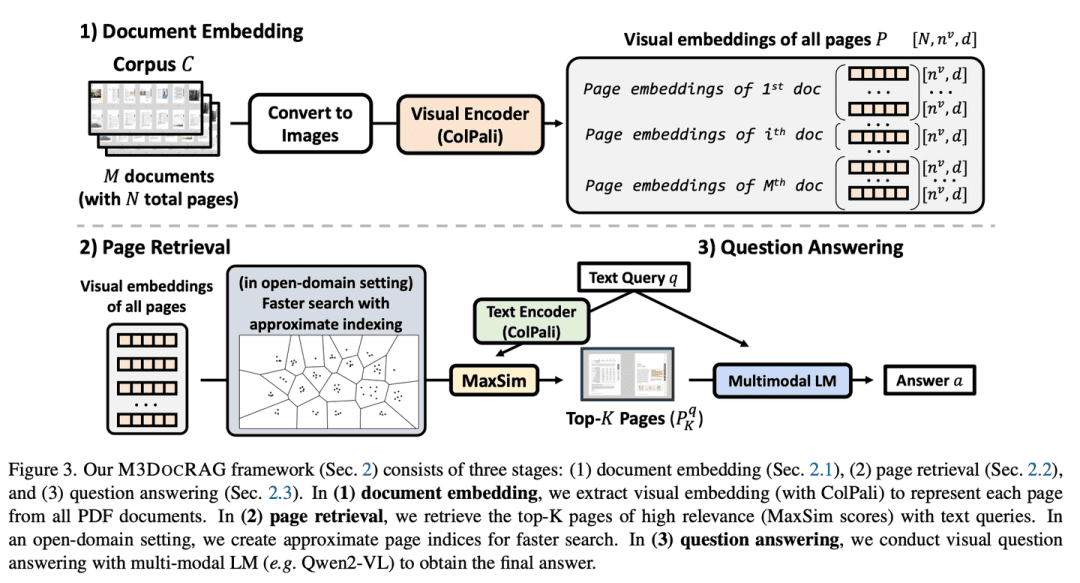

(69) M3DocRAG [Sensualista]

pessoa sensorialEles não apenas podem ler livros, mas também podem ler imagens e ouvir vozes. Como um concorrente versátil em um programa de variedades, ele pode ler imagens, entender palavras, pular quando precisa pular, concentrar-se nos detalhes quando precisa se concentrar e não pode ser derrotado por todos os tipos de desafios.

- Tese: M3DocRAG: Multi-modal Retrieval is What You Need for Multi-page Multi-document Understanding (Recuperação multimodal é o que você precisa para entender várias páginas e vários documentos)

O M3DocRAG é uma nova estrutura de RAG multimodal que se adapta de forma flexível a uma variedade de contextos de documentos (domínios fechados e abertos), saltos de perguntas (únicos e múltiplos) e modos de evidência (texto, tabelas, gráficos etc.). informações visuais.

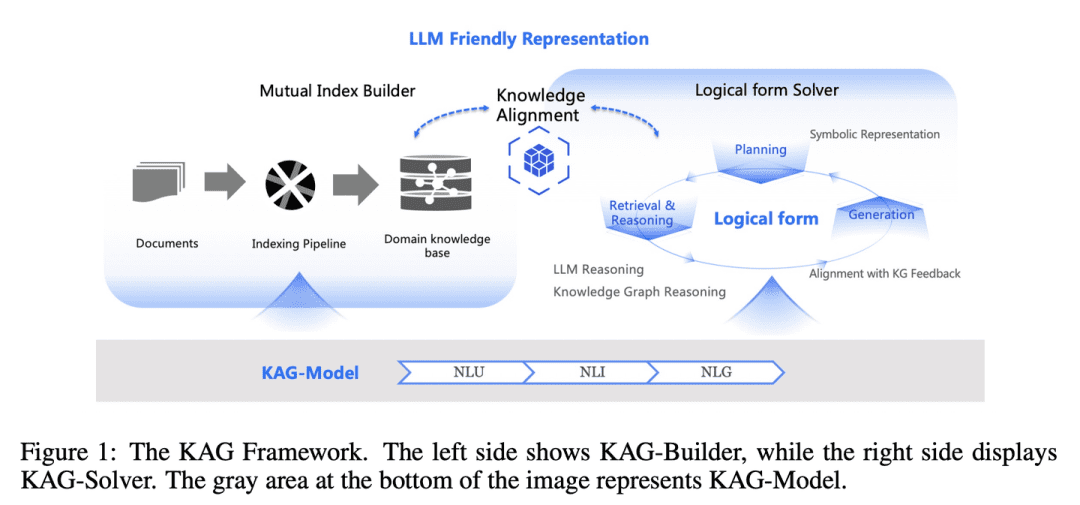

(70) KAG [Mestrado em Lógica]

mestre lógicoO que é: Não é apenas uma questão de encontrar respostas semelhantes pelo sentimento, mas também a relação de causa e efeito entre o conhecimento. Como um professor de matemática rigoroso, você precisa não apenas saber qual é a resposta, mas também explicar como essa resposta foi obtida, passo a passo.

- Tese: KAG: Aumento de LLMs em domínios profissionais por meio da geração aumentada de conhecimento

- Projeto: https://github.com/OpenSPG/KAG

A lacuna entre a semelhança dos vetores e a relevância do raciocínio do conhecimento no RAG, bem como a insensibilidade às lógicas do conhecimento (por exemplo, valores numéricos, relações temporais, regras de especialistas etc.), dificultam a eficácia dos serviços especializados. O KAG foi projetado para aproveitar os pontos fortes do Knowledge Graph (KG) e da recuperação de vetores para enfrentar os desafios acima e aprimora bidirecionalmente os modelos de linguagem em larga escala (LLMs) e o Knowledge Graph por meio de cinco aspectos principais para melhorar o desempenho da geração e da inferência: (1) representação do conhecimento amigável ao LLM, (2) indexação cruzada entre o Knowledge Graph e os blocos brutos, (3) mecanismo de inferência híbrida orientada por forma lógica, (4) alinhamento do conhecimento com inferência semântica e (5) aprimoramento da capacidade de modelagem do KAG.

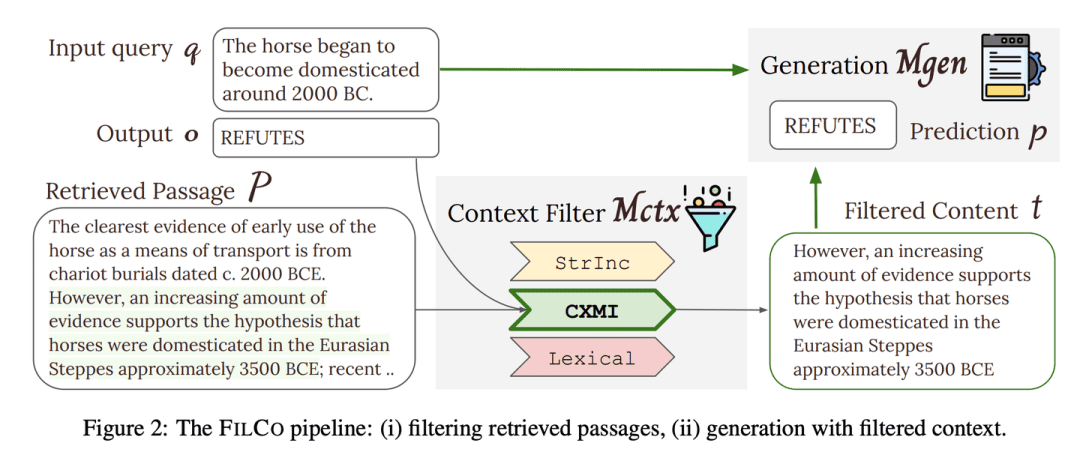

(71) FILCO [Screener]

peneirasEditor: como um editor rigoroso, capaz de identificar e reter as informações mais valiosas de grandes quantidades de texto, garantindo que cada parte do conteúdo entregue à IA seja precisa e relevante.

- Tese: Aprendendo a filtrar o contexto para geração aumentada de recuperação

- Projeto: https://github.com/zorazrw/filco

O FILCO aprimora a qualidade do contexto fornecido ao gerador, identificando contextos úteis com base em abordagens léxicas e de teoria da informação e treinando um modelo de filtragem de contexto para filtrar os contextos recuperados.

(72) LazyGraphRAG [atuário]

atuáriosO que é um passo é um passo se você puder economizar e fazer bom uso dos modelos grandes e caros. Como uma dona de casa que sabe como viver, você não compra apenas quando vê uma promoção no supermercado, você compara antes de decidir onde gastar seu dinheiro para obter o melhor valor.

- Projeto: https://github.com/microsoft/graphrag

Uma nova abordagem para a geração aprimorada de gráficos de recuperação aprimorada (RAG). Essa abordagem reduz significativamente os custos de indexação e consulta, mantendo ou superando os concorrentes em termos de qualidade de resposta, o que a torna altamente dimensionável e eficiente em uma ampla gama de casos de uso. Durante a fase de indexação, o LazyGraphRAG usa apenas técnicas leves de PNL para processar o texto, atrasando a invocação do LLM até a consulta real. Essa estratégia "preguiçosa" evita altos custos iniciais de indexação e consegue uma utilização eficiente dos recursos.

| Gráfico tradicionalRAG | LazyGraphRAG | |

| estágio de indexação | - Extração e descrição de entidades e relacionamentos usando LLM - Gerar resumos para cada entidade e relacionamento - Resumir o conteúdo da comunidade usando o LLM - Gerar vetores de incorporação - Geração de arquivos Parquet | - Extração de conceitos e relações de co-ocorrência usando técnicas de PNL - Construção de mapas conceituais - Extração de estruturas comunitárias - O LLM não é usado na fase de indexação |

| Fase de consulta | - Responda às consultas diretamente usando os resumos da comunidade - Falta de refinamento das consultas e de foco nas informações relevantes | - Uso do LLM para refinar consultas e gerar subconsultas - Seleção de segmentos de texto e comunidades com base na relevância - Extração e geração de respostas usando o LLM - Mais focado em conteúdo relevante, respostas mais precisas |

| Chamada de LLM | - Uso intenso tanto na fase de indexação quanto na fase de consulta | - O LLM não é usado na fase de indexação - Chamada do LLM somente na fase de consulta - O LLM é usado de forma mais eficiente |

| eficiência de custos | - Alto custo e indexação demorada - Desempenho da consulta limitado pela qualidade do índice | - O custo de indexação é de apenas 0,1% do GraphRAG tradicional - Alta eficiência de consulta e boa qualidade das respostas |

| armazenamento de dados | - Os arquivos Parquet são gerados a partir de dados indexados, adequados para armazenamento e processamento de dados em grande escala. | - Os dados indexados são armazenados em formatos leves (por exemplo, JSON, CSV), que são mais adequados para desenvolvimento rápido e tamanhos de dados pequenos. |

| Cenários de uso | - Para cenários que não são sensíveis a recursos de computação e tempo - O gráfico de conhecimento completo precisa ser construído com antecedência e armazenado como um arquivo Parquet para posterior importação para o banco de dados para análises complexas | - Para cenários que exigem indexação e resposta rápidas - Ideal para consultas pontuais, análises exploratórias e processamento de dados em fluxo contínuo |

Pesquisa RAG

- Uma pesquisa sobre a geração de textos com reforço de recuperação

- Recuperação de informações multimodais para geração aumentada: uma pesquisa

- Geração aumentada por recuperação para modelos de linguagem grandes: uma pesquisa

- Geração aumentada por recuperação para conteúdo gerado por IA: uma pesquisa

- Uma pesquisa sobre a geração de textos com aprimoramento de recuperação para modelos de idiomas grandes

- RAG e RAU: uma pesquisa sobre o modelo de linguagem aumentada por recuperação no processamento de linguagem natural

- Uma pesquisa sobre LLMs do RAG Meeting: rumo a modelos de linguagem grandes e aprimorados para recuperação

- Avaliação da geração aumentada por recuperação: uma pesquisa

- Geração aumentada por recuperação para processamento de linguagem natural: uma pesquisa

- Geração aumentada de recuperação de gráficos: uma pesquisa

- Uma pesquisa abrangente da geração aumentada por recuperação (RAG): evolução, cenário atual e direções futuras

- Retrieval Augmented Generation (RAG) e além: uma pesquisa abrangente sobre como fazer com que seus LLMs usem dados externos com mais sabedoria

Referência RAG

- Avaliação comparativa de grandes modelos de linguagem na geração aumentada de recuperação

- RECALL: uma referência para a robustez dos LLMs em relação ao conhecimento contrafactual externo

- ARES: uma estrutura de avaliação automatizada para sistemas de geração aumentada por recuperação

- RAGASAvaliação automatizada da geração aumentada de recuperação

- CRUD-RAG: um benchmark chinês abrangente para a geração de modelos linguísticos grandes com reforço de recuperação

- FeB4RAG: avaliação da pesquisa federada no contexto da geração aumentada de recuperação

- CodeRAG-Bench: a recuperação pode aumentar a geração de códigos?

- Long2RAG: avaliação da geração aumentada de recuperação de contexto longo e formulário longo com recuperação de pontos-chave

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...