はじめに

MMAudioはオープンソースのプロジェクトであり、マルチモーダルな共同訓練によって高品質の同期音声を生成することを目的としている。香港中文大学のHo Kei Chengらによって開発されたこのプロジェクトの主な機能は、ビデオやテキスト入力に基づいて同期されたオーディオを生成することである。MMAudioの革新的なコアは、幅広いオーディオ-ビデオおよびオーディオ-テキストデータセットで学習できるマルチモーダル共同学習アプローチにある。さらに、同期モジュールは、生成された音声をビデオフレームに合わせることができる。このプロジェクトはまだ構築中ですが、単一ケースの推論機能はすでに動作しており、トレーニングコードが追加される予定です。openartサイトでは、関連するワークフローを検索できます。

機能一覧

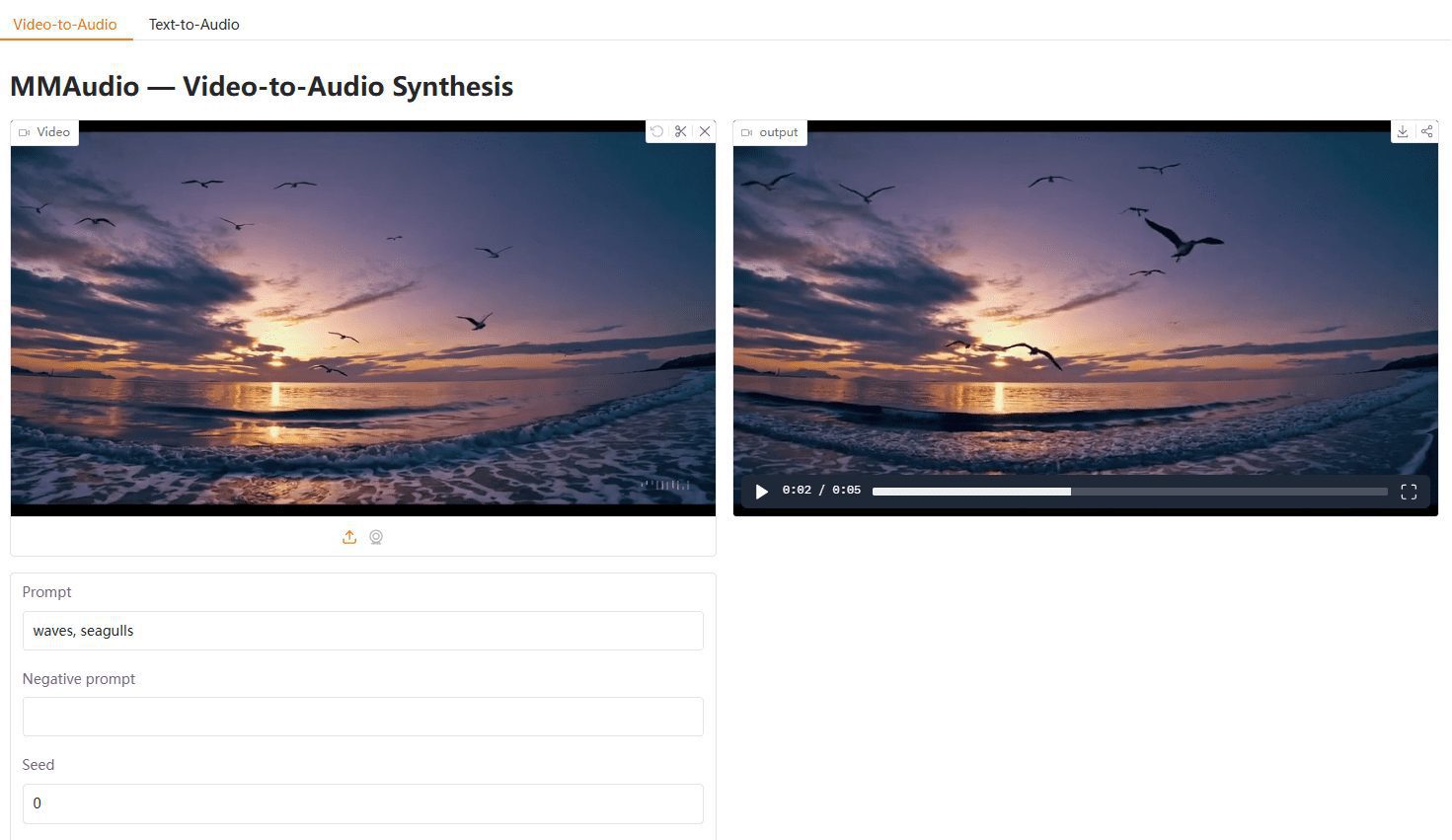

- ビデオからオーディオへ入力映像に同期した音声を生成します。

- テキスト音声生成入力テキストに基づいて音声を生成します。

- マルチモーダル合同トレーニングオーディオ-ビデオおよびオーディオ-テキストデータセットに対する共同学習。

- 同期モジュール生成された音声をビデオフレームに合わせる。

- オープンソースユーザーによる二次開発を容易にするため、完全なオープンソースコードが提供されます。

- 事前学習モデル様々な訓練済みモデルが用意されており、ユーザーが直接使用することができます。

- デモスクリプトユーザーがすぐに使い始められるよう、さまざまなデモスクリプトを用意。

ヘルプの使用

設置プロセス

- 環境準備miniforge環境を推奨します。Python 3.9+とPyTorch 2.5.1+、および対応するtorchvision/torchaudioがインストールされていることを確認してください。

- 依存関係のインストール以下のコマンドを実行して、必要な依存関係をインストールしてください:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 --upgrade

- クローン倉庫以下のコマンドを使用して MMAudio リポジトリをクローンします:

git clone https://github.com/hkchengrex/MMAudio.git

- MMAudioのインストールMMAudioディレクトリに移動し、installコマンドを実行します:

cd MMAudio

pip install -e .

使用方法

- デモ・スクリプトの実行: MMAudioは、以下のコマンドでデフォルトのlarge_44kモデルを実行できるいくつかのデモスクリプトを提供しています:

python demo.py

- ビデオまたはテキストの入力必要に応じてビデオファイルやテキストを入力すると、MMAudioが対応する同期オーディオを生成します。

- 結果を見る生成された音声は、入力されたビデオフレームと同期され、ユーザーが直接見て使用することができます。

詳細な機能操作の流れ

- ビデオからオーディオへ入力としてビデオファイルを使用し、デモスクリプトを実行すると、MMAudioは自動的にビデオに同期したオーディオを生成します。

- テキスト音声生成テキストを入力とし、対応するスクリプトを実行すると、MMAudioが対応するオーディオを生成します。

- マルチモーダル合同トレーニング提供された学習コードをもとに、ユーザが独自のデータセットに対してマルチモーダル協調学習を行うことで、モデル生成を強化することができます。

- 同期モジュールこのモジュールは、生成されたオーディオとビデオフレームを自動的に整列させ、オーディオとビデオの同期を保証します。

ほら

- 環境要件現在のところ、Ubuntuシステムでのみテストされています。

- 依存バージョン互換性の問題を避けるために、インストールされた依存関係のバージョンがプロジェクトの要件と一致していることを確認してください。

- 事前学習モデルデモスクリプトを実行すると、事前にトレーニングされたモデルが自動的にダウンロードされます。

以上の手順で、ユーザーはMMAudioを素早くインストールして使用し、高品質の同期オーディオを生成することができます。詳細な使用法ヘルプとデモスクリプトは、ユーザーがツールをより良く理解し、操作するのに役立ちます。