はじめに

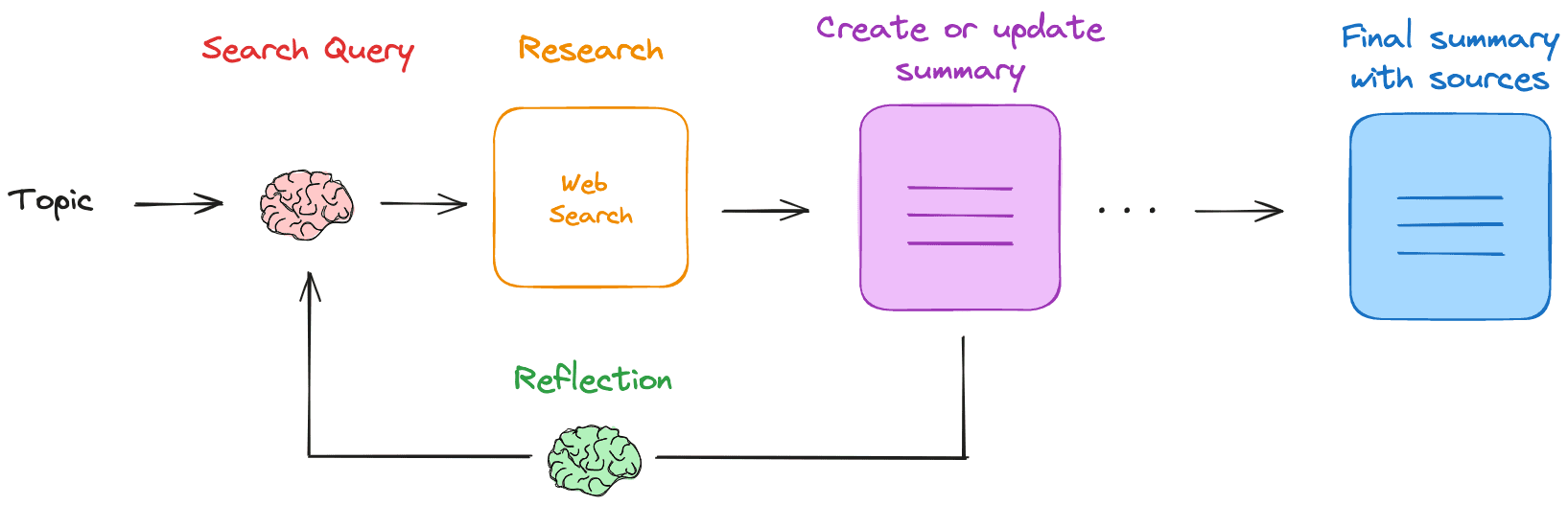

Research Rabbit は LLM (Large Language Model) ベースのウェブリサーチおよび要約アシスタントです。ユーザーがリサーチトピックを提供すると、Research Rabbitは検索クエリを生成し、関連するウェブ結果を取得し、それらの結果を要約します。このプロセスを繰り返し、知識のギャップを埋め、最終的にすべてのソースを含むMarkdown要約を生成する。このツールは完全にローカルで動作するため、データのプライバシーとセキュリティが確保されている。

機能一覧

- 検索クエリの生成ユーザーが提供したトピックに基づいて検索クエリを生成します。

- ウェブ検索: 設定された検索エンジン(Tavilyなど)を使って関連リソースを探す。

- 要約結果ローカルLLMを使ってウェブ検索結果を要約。

- リフレクティブ・サマリー知識のギャップを特定し、新しい検索クエリを生成する。

- 反復更新検索と要約を繰り返し、リサーチを徐々に洗練させていく。

- ローカルオペレーションデータのプライバシーを確保するため、すべての操作はローカルで行われます。

- マークダウンの概要すべてのソースを含む最終的なMarkdown要約を生成する。

ヘルプの使用

設置プロセス

- 地元のLLMを引く必要なローカルLLMをOllamaから引き出す。

オラマ プルllama3.2. - TavilyのAPIキーを取得するTavilyの登録とAPIキーの取得、環境変数の設定

TAVILY_API_KEY= をエクスポートします。. - クローン倉庫走る

git clone https://github.com/langchain-ai/research-rabbit.gitクローン倉庫 - 依存関係のインストールプロジェクト・ディレクトリに移動して

uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 ランググラフ デヴ依存関係をインストールします。 - スタートアップ・アシスタントLangGraphサーバーを起動し

http://127.0.0.1:2024APIドキュメントとWeb UIを見る。

使用プロセス

- LLMの設定LangGraph Studio Web UIで使用するローカルLLMの名前を設定します(デフォルト)。

ラマ3.2). - 研究の深さの設定反復学習の深さを設定する(デフォルトは3)。

- 研究テーマを入力する設定] タブで研究トピックを入力し、研究アシスタントを開始します。

- プロセスを見るアシスタントは検索クエリを生成し、ウェブ検索を実行し、LLMを使って結果を要約し、そのプロセスを繰り返す。

- 要約の入手リサーチが完了すると、アシスタントはすべてのソースを含むMarkdownの要約を作成し、ユーザーはそれを閲覧・編集することができます。

主な機能

- 検索クエリの生成研究テーマを入力すると、アシスタントが自動的に検索クエリを生成します。

- ウェブ検索: アシスタントは設定された検索エンジンを使って関連するリソースを探します。

- 要約結果アシスタントはローカルのLLMを使って検索結果をまとめ、予備レポートを作成する。

- リフレクティブ・サマリーアシスタントは、要約の知識のギャップを特定し、調査を継続するための新しい検索クエリを生成する。

- 反復更新アシスタントは検索と要約を繰り返し、徐々にリサーチを洗練させていく。

- マークダウン要約の生成リサーチが完了すると、アシスタントはすべてのソースを含む最終的なMarkdownサマリーを生成し、ユーザーはそれを閲覧・編集することができる。