はじめに

響は、Kyutai Labsによって開発された高忠実度のリアルタイム音声翻訳モデルです。従来のオフライン翻訳機とは異なり、Hibikiはターゲット言語の自然な音声翻訳を生成し、ユーザーの発話に合わせてリアルタイムにテキスト翻訳を提供します。Hibikiは、教師あり学習によって原文と訳文の位置合わせを行い、合成データ生成技術によって限られた実世界データで高品質な翻訳を実現します。

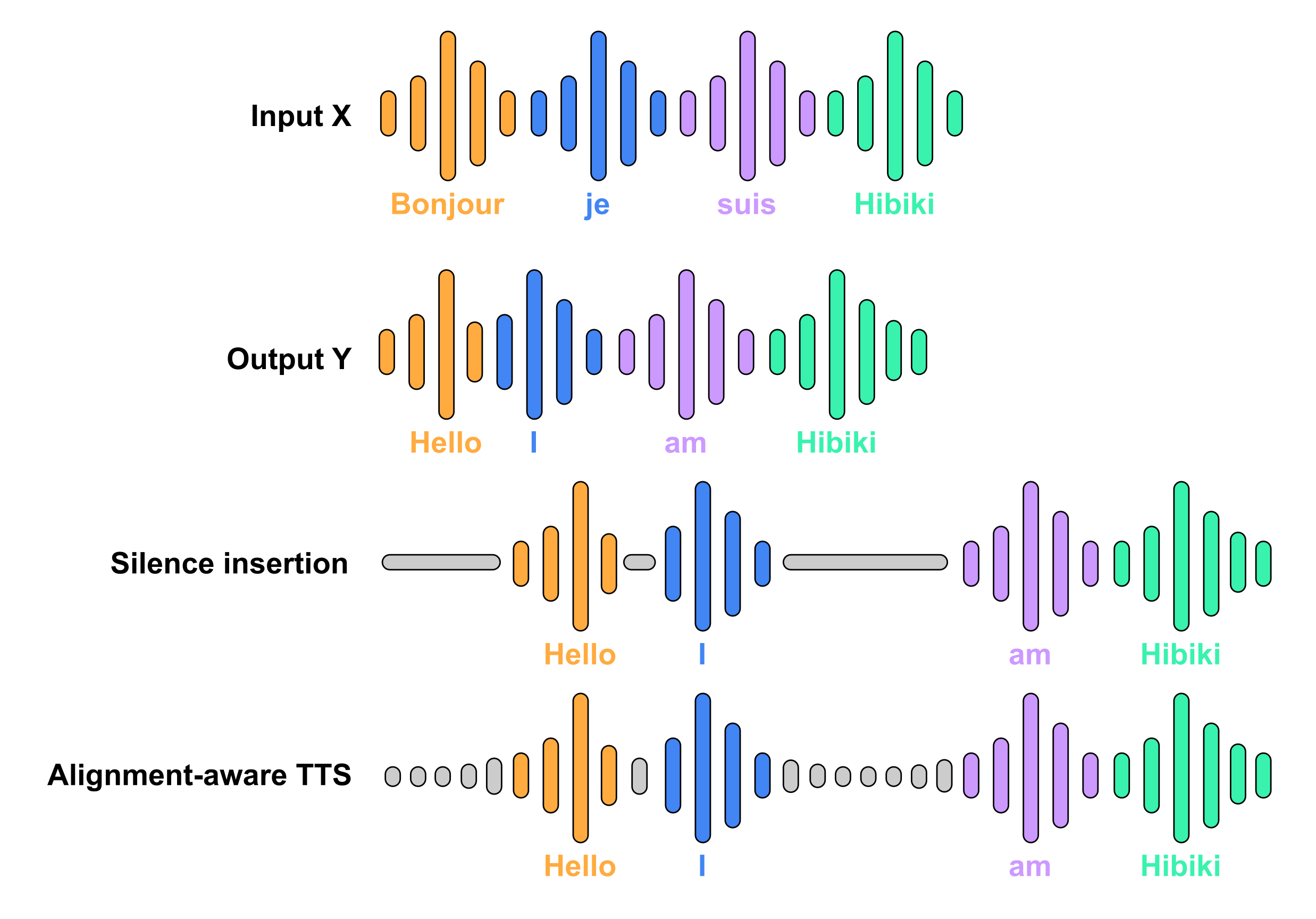

Hibikiは、同一話者による原文と訳文の整合を教師付き学習で行う。そのようなデータが十分でないため、我々は合成データの生成に頼っている。原文と訳文の単語レベルの照合は、市販の機械翻訳システムMADLADを使用し、文脈アライメントの弱い教師ありアプローチで行われる。導出されたアライメントルール(単語は、ソース言語から予測できる場合にのみターゲット言語に出現する)は、音声制御されたアライメントを意識したTTSを使用して、サイレンスを挿入するか、ターゲット音声を合成することによって適用される。

機能一覧

- リアルタイム音声翻訳ユーザーが話している間、リアルタイムでターゲット言語の自然な音声翻訳を生成します。

- テキスト翻訳音声と同期したテキスト翻訳を提供します。

- マルチストリームアーキテクチャ入力音声ストリームを処理すると同時にターゲット音声を生成し、一貫性のある正確な翻訳を実現します。

- ハイフィデリティ教師あり訓練と合成データ生成技術により、高品質の翻訳を保証します。

- おんせいてんいオプションの音声転送機能により、より自然な翻訳音声が得られます。

ヘルプの使用

設置プロセス

パイトーチ

- 取り付け

モシパッケージ:pip install -U moshi - サンプルファイルのダウンロード

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 翻訳を実行する:

python -m moshi.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-pytorch-bf16- オプションのパラメータ

--CFG-COEFデフォルト値は1です。値が大きいほど、生成される音声は元の音声に近くなり、推奨値は3です。

- オプションのパラメータ

MLX

- 取り付け

moshi_mlxパッケージ(少なくともバージョン0.2.1が必要):pip install -U moshi_mlx - サンプルファイルのダウンロード

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 翻訳を実行する:

python -m moshi_mlx.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-mlx-bf16- オプションのパラメータ

--CFG-COEFデフォルト値は1です。値が大きいほど、生成される音声は元の音声に近くなり、推奨値は3です。

- オプションのパラメータ

MLX-スウィフト

kyutai-labs/moshi-swiftこのリポジトリにはiPhoneで動作するMLX-Swiftの実装が含まれており、iPhone 16 Proでテストされています。このコードはまだ実験段階であることに注意してください。

さび

- 入る

響RSカタログCD響-RS - サンプルファイルのダウンロード

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 翻訳を実行する:

cargo run --features metal -r -- gen sample_fr_hibiki_crepes.mp3 out_en.wav- 利用する

--クーダ機能NVIDIA GPU上で実行するか、または--メタルの特徴Macで動作。

- 利用する

モデリング

フランス語から英語への翻訳のために2つのモデルをリリースしました:

- 響 2BPyTorchとMLXの16RVQストリーム用。

- 響 1BPyTorchとMLX用で、8つのRVQストリームを持ち、デバイス側の推論に最適。

モデル一覧:

- PyTorch(bf16)の響2B:

響-2b-ピトーチ-BF16 - PyTorch(bf16)の響1B:

響-1b-ピトーチ-BF16 - MLX(bf16)の響2B:

響-2B-MLX-BF16 - MLX(bf16)の響1B:

響-1B-MLX-BF16

すべてのモデルはCC-BY 4.0ライセンスで公開されています。

使用プロセス

- プライミングモデルインストールプロセスに従ってモデルを起動します。

- 音声入力マイクを通してソース言語の音声を入力します。

- リアルタイム翻訳Hibikiはリアルタイムでターゲット言語の音声翻訳を生成し、同時にテキスト翻訳を表示します。

- セッティングの調整より自然な翻訳をするために、必要に応じて音声転送などの設定を調整します。

主な機能

- リアルタイム音声翻訳起動後、マイクに直接音声を入力すると、響が自動的に翻訳します。

- テキスト翻訳響は音声翻訳と同時にテキスト翻訳を生成し、インターフェースに表示する。

- おんせいてんい翻訳された音声をより自然な発音に近づけるために、設定で音声転送機能を有効にします。

詳しい操作手順

- プライミングモデルすべての依存関係が正しくインストールされていることを確認するために、インストールプロセスに従ってモデルを起動してください。

- 音声入力マイクから原語の音声を入力すると、響が自動的に翻訳を開始します。

- 翻訳結果を見るリアルタイムに生成されたターゲット言語の音声翻訳とテキスト翻訳をインターフェイス上で見ることができます。

- セッティングの調整音声転送などの機能は、最適な翻訳を行うために必要に応じて設定で調整してください。