はじめに

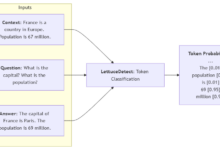

Vision Parseは、最先端の視覚言語モデリング(Vision Language Models)技術を巧みに組み合わせ、PDFドキュメントを高品質なMarkdown形式のコンテンツにインテリジェントに変換する画期的なドキュメント処理ツールです。このツールは、OpenAI、LLama、Google Geminiなどの様々なトップ視覚言語モデルをサポートし、正確にドキュメント内のテキストとテーブルを抽出し、元のドキュメントの階層構造、スタイル、インデントを維持することができます。Vision Parseは、複数ページのPDF処理をサポートしているだけでなく、ローカルモデルの展開オプションを提供するので、ユーザーは、ドキュメントのセキュリティを確保するために、同じ時間にすることができますオフライン処理も可能です。そのシンプルなAPI設計により、開発者はわずか数行のコードで複雑な文書変換タスクを実現し、文書処理の効率と精度を大幅に向上させることができます。

機能一覧

- インテリジェントなコンテンツ抽出: 高度な視覚言語モデルを使用して、テキストと表のコンテンツを正確に認識し、抽出します。

- 書式の完全性:文書の完全な階層構造、スタイル、インデントの書式を維持する。

- マルチモデルのサポート:OpenAI、LLama、Gemini、その他の視覚言語モデルプロバイダと互換性があります。

- PDFマルチページ処理:マルチページのPDFドキュメントをサポートし、処理のためにbase64エンコードされた画像に変換されます。

- ローカルモデルのデプロイメント: Ollamaはドキュメントのセキュリティとオフラインでの使用のためにローカルモデルのデプロイメントをサポートしています。

- カスタム設定:DPI、カラースペースなどのカスタムPDF処理パラメータをサポートします。

- 柔軟なAPI:シンプルで直感的なPython APIインターフェースを提供

ヘルプの使用

1.インストールの準備

基本的な条件

- Python 3.9以上

- ローカルモデルを使用するには、Ollamaをインストールする必要がある。

- OpenAIまたはGoogle Geminiを使用するには、適切なAPIキーが必要です。

インストールの手順

- pipを使ってベースパッケージをインストールする:

pip install vision-parse

- 必要に応じて追加の依存関係をインストールする:

- OpenAIのサポート:

pip install 'vision-parse[openai]' - ジェミニのサポート

pip install 'vision-parse[ジェミニ]'

2.基本的な使い方

サンプルコード:

from vision_parse import VisionParser

# パーサーを初期化する

parser = VisionParser(

model_name="llama3.2-vision:11b", # use local model

temperature=0.4、

top_p=0.3、

extraction_complexity=False # より詳細な抽出結果を得るにはTrueに設定します。

)

# PDFファイルを変換

pdf_path = "your_document.pdf"

markdown_pages = parser.convert_pdf(pdf_path)

# 変換結果を処理

for i, page_content in enumerate(markdown_pages):

print(f"\n--- Page {i+1} ---n{page_content}")

3.高度な設定

PDFのページ構成:

from vision_parse import VisionParser, PDFPageConfig

#はPDF処理設定を構成する

page_config = PDFPageConfig()

page_config = PDFPageConfig(

color_space="RGB", include_annotations=True

include_annotations=True、 preserve_transparency=フリー

preserve_transparency=False

)

# カスタム設定を使用してパーサーを初期化する

parser = VisionParser(

model_name="llama3.2-vision:11b"、

temperature=0.7、

top_p=0.4、

page_config=page_config

)

4.サポートモデル

Vision Parseは、主流の視覚言語モデルを幅広くサポートしています:

- OpenAIモデル:gpt-4o、gpt-4o-mini

- Google Geminiモデル:gemini-1.5-flash、gemini-2.0-flash-exp、gemini-1.5-pro

- メタ・ラマとラバ(オラマを経て):llava:13b、llava:34b、llama3.2-vision:11b、llama3.2-vision:70b

5.使用テクニック

- 適切なモデルの選択:ニーズに応じてローカルモデルかクラウドベースのサービスを選択する

- パラメータの調整:出力の創造性と精度は、温度とtop_pのパラメータによって調整される。

- 抽出の複雑さ:複雑な文書の場合は、extract_complexity=Trueを設定することをお勧めします。

- ローカルへの展開:機密文書では、ローカルへのモデル展開にOllamaを使用することを推奨しています。

- PDFの設定:DPIとカラースペースと他のパラメータを調整するドキュメントの特性に応じて