はじめに

Marco-o1は、アリババ国際デジタル商務グループ(AIDC-AI)によって開発された、複雑な現実世界の問題を解決するためのオープンな推論モデルです。Marco-o1は数学、物理学、プログラミングのような標準的な答えを持つ分野に焦点を当てるだけでなく、明確な基準がなく、報酬を定量化することが困難な領域への一般化にも努めています。このプロジェクトの目標は、多言語アプリケーションのための大規模推論モデルの可能性を探求し、継続的な最適化と改善を通じて、モデルの推論力と応用範囲を強化することである。

機能一覧

- 思考の連鎖の微調整(CoT)オープンソースのCoTデータセットと自己研究による合成データを組み合わせ、フルパラメーターでベースモデルを微調整することにより、モデルの推論能力を向上させる。

- モンテカルロ木探索(MCTS)モデル出力の信頼度を用いて探索を導き、解空間を拡張し、推論経路を最適化する。

- 推論行動戦略革新的な推論アクションストラテジーとリフレクティブメカニズムを実装し、異なる粒度レベルでアクションを探索し、複雑な問題を解決するモデルの能力を向上させる。

- 多言語翻訳業務大規模推論モデルを機械翻訳タスクに初めて適用し、多言語および翻訳ドメインにおける推論時間のスケーリング則を探求。

- 報酬モデルのトレーニング成果報酬モデリング(ORM)とプロセス報酬モデリング(PRM)の開発により、より正確な報酬シグナルを提供し、ツリー検索結果のランダム性を低減。

- 集中学習トレーニング強化学習技術によってモデルの意思決定プロセスを最適化し、問題解決能力をさらに高める。

ヘルプの使用

設置プロセス

- GitHubページを見るに移動する。Marco-o1 GitHubページ.

- クローン倉庫コマンドを使用します。

git clone https://github.com/AIDC-AI/Marco-o1.gitリポジトリをローカルにクローンする。 - 依存関係のインストールプロジェクト・ディレクトリに移動して

pip install -r requirements.txt必要な依存関係をインストールします。

使用ガイドライン

- 積載モデルPython環境では、以下のコードを使ってモデルをロードする:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "AIDC-AI/Marco-o1" model = AutoModelForCausalLM.from_pretrained(model_name) tokeniser = AutoTokenizer.from_pretrained(model_name) - 推論の例モデルを使った推論、簡単な例を挙げよう:

パイソン

input_text = "イチゴの'r'はいくつ?"

inputs = tokeniser(input_text, return_tensors="pt")

出力 = model.generate(**入力)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

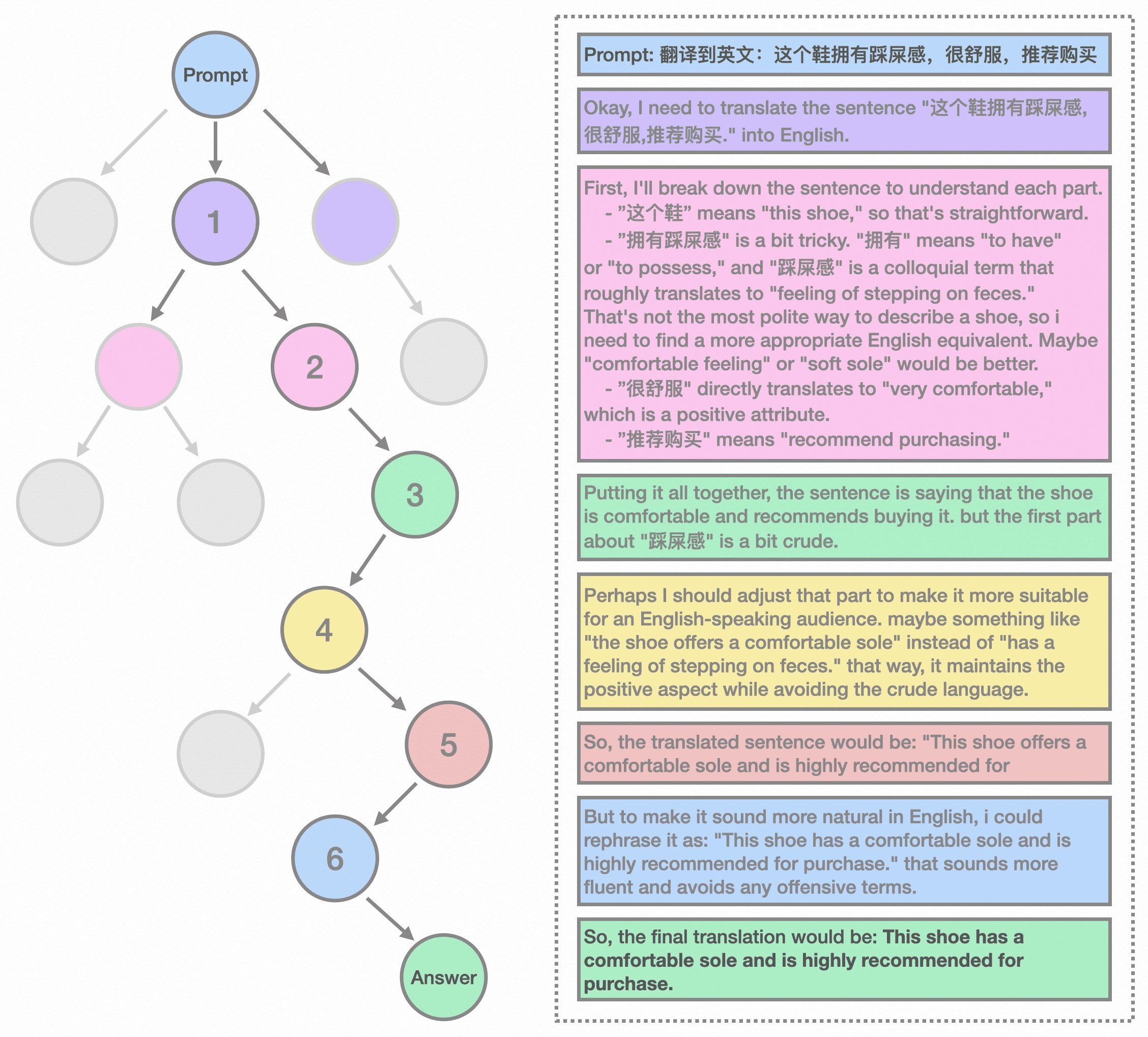

- 多言語翻訳Marco-o1は、多言語翻訳タスクで優れたパフォーマンスを発揮します:

パイソン

input_text = "この靴はクソを踏んでいるような感覚がある"

inputs = tokeniser(input_text, return_tensors="pt")

出力 = model.generate(**入力)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

詳細な機能操作の流れ

- 思考の連鎖の微調整(CoT)::

- データ準備オープンソースのCoTデータセットと自己研究の合成データを収集し、照合する。

- モデリングの微調整上記のデータを使って、フルパラメーターでベースモデルを微調整し、推論を改善する。

- モンテカルロ木探索(MCTS)::

- 結節表現MCTSフレームワークでは、各ノードは問題解決プロセスにおける推論状態を表します。

- モーション出力ノードの可能なアクションはLLMによって生成され、推論連鎖の潜在的なステップを表す。

- ロールバックとボーナス計算ロールバックフェーズでは、LLMは推論プロセスを終了状態まで継続する。

- ブートストラップ検索より信頼性の高い推論チェーンへ探索を誘導するために、報酬スコアを使って有望なパスを評価・選択する。

- 推論行動戦略::

- アクションの粒度検索効率と精度を向上させるために、MCTSフレームワークの中で異なる粒度でアクションを探索する。

- 反射メカニズムモデルに自己反省を促すことで、複雑な問題を解決する能力が大幅に向上する。

- 多言語翻訳業務::

- ミッション申請大規模推論モデルを機械翻訳タスクに適用し、多言語および翻訳ドメインにおける推論時間のスケーリング則を探索する。

- 翻訳例俗語の翻訳に優れた性能を発揮します。

- 報酬モデルのトレーニング::

- 成果報酬モデリング(ORM)より正確な報酬シグナルを提供し、ツリー検索結果のランダム性を低減するためにモデルを訓練する。

- プロセス報酬モデリング(PRM)プロセス報酬モデリングによるモデルの推論パスのさらなる最適化。

- 集中学習トレーニング::

- 意思決定の最適化強化学習技術により、モデルの意思決定プロセスを最適化し、問題解決能力を向上させる。