オリジナル高密度X検索:どのような粒度で検索すべきか?について

注:この方法は、OPENAIシリーズ、Claudeシリーズ、Mixtral、Yi、qwenなど、少数のモデルに適しています。

抄録

オープンドメインの自然言語処理(NLP)タスクにおいて、密な検索は関連する文脈や世界の知識を獲得するための重要な手法となっている。推論時にコーパスを検索するために学習された密検索を使用する場合、しばしば見落とされがちな設計上の選択は、検索単位、すなわちコーパスがインデックスされる粒度、例えば文書、段落、文である。我々は、検索単位の選択が、検索性能だけでなく、下流のタスクの性能にも大きく影響することを発見した。段落や文章を用いる従来のアプローチとは対照的に、我々は集中的な検索のために新しい検索単位である命題を導入する。命題はテキスト中の原子表現として定義され、その各々はユニークな事実をカプセル化し、簡潔で自己完結的な自然言語フォーマットで提示される。異なる検索粒度を経験的に比較する。その結果、命題に基づく検索は、従来の段落ベースや文ベースのアプローチを、高密度検索において大幅に上回ることが示された。さらに、命題による検索は、検索されたテキストが質問に関連する情報をよりコンパクトに含み、長い入力トークンの必要性を減らし、無関係な情報の包含を最小限に抑えるため、下流の質問応答(QA)タスクの性能を向上させる。

1 はじめに

密な検索は、知識集約的なタスクのために外部の情報源にアクセスするために使用される技術のクラスである。学習された密集検索を使ってコーパスから検索を行う前に、重要な設計上の決定を行わなければならないのは、検索単位、つまり、推論において検索されたコーパスをセグメント化し、インデックスを付ける粒度である。実際には、検索単位、例えば文書、段落や文の固定長のチャンクなどの選択は、通常、密検索モデルがどのようにインスタンス化されたか、または訓練されたかに基づいて事前に決定される。

本論文では、密検索推論において軽視されてきた研究課題、すなわち、どのような検索粒度で検索コーパスをセグメント化し、インデックスを付けるべきかについて探求する。我々は、推論時に適切な検索粒度を選択することが、検索と下流タスクの両方において、密検索器の性能を向上させるための単純だが効果的な戦略であることを発見した。

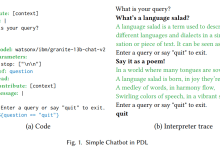

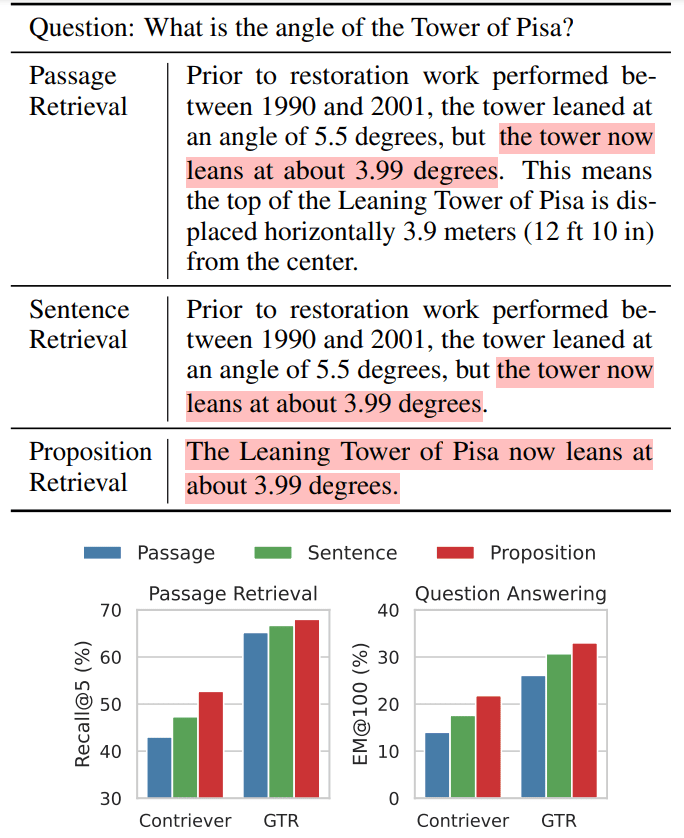

私たちの直観を、オープン・ドメインの質問と回答(QA)の例で説明する(表1)。

表1 図1:インテンシブ検索を使用した場合のウィキペディア・テキストの3つの検索粒度の例

上:ウィキペディアのテキストは、密な検索方法を使用した場合、3つの異なる検索ユニットに分割できることを示す。

下:段落検索タスクと下流のオープンドメインの質疑応答(QA)タスクの両方で、命題(propositions)を介した検索が最高の検索性能をもたらすことが観察された。例えば、Contriever (Izacard et al., 2022)やGTR (Ni et al., 2022)が基幹検索器として用いられた。ハイライトされたセクションは、質問に対する回答を含むセクションを示す。

この例では、同じモデルが3つの異なる粒度のテキストを検索している。理論的には、より粗い粒度を表す段落は、質問に関連する情報をより多く提供することができる。しかし、段落には、リトリーバーや下流タスクの言語モデルの注意をそらす可能性のある付加的な詳細が含まれていることが多い(例えば、表1の例では、回復期間や水平方向の変位)。一方、文レベルの索引付けは、よりきめ細かいアプローチを提供するが、この問題に完全には対処できない。なぜなら、文は依然として複雑で複合的である可能性があり、通常は自己完結しておらず、クエリと文書の関連性を判断するのに必要な文脈情報が欠けているからである。

従来の検索単位(段落や文など)のこうした欠点に対処するため、集中検索のための新しい検索単位として、命題の使用を提案する。命題はテキスト中の原子表現として定義され、その各々はユニークな事実をカプセル化し、簡潔で自己完結的な自然言語フォーマットで提示される。表1に命題の例を示す。この命題は、ピサの斜塔の現在の傾斜角度に関する情報を自己完結的な方法で記述し、質問に対して正確に答えるものである。より詳細な定義と説明はセクションIIで述べる。

次に、5つの異なるオープンドメインのQAデータセットで実験を行い、ウィキペディアを段落、文、提案する命題で索引付けした場合の6つのデュアルエンコーダ検索器の性能を経験的に比較した。段落、文、命題で索引付けされた場合の6つのデュアルエンコーダ検索器の性能。我々の評価は二重構造になっており、検索性能と下流のQAタスクへの影響の両方を検証している。注目すべきは、セクションVで述べるように、命題に基づく検索は、汎化という点で、文や段落に基づくアプローチを凌駕していることである。このことは、命題が、密な検索者が適切な文脈を維持しながら正確な情報にアクセスすることを可能にする、コンパクトで内容の豊富な文脈として機能することを示唆している。さらに、セクションVIで詳述するように、命題ベースの検索を使用した場合、下流のQAパフォーマンスにおいて明らかな優位性が観察される。言語モデルの入力トークンの長さが一般的に限られていることを考えると、命題は本質的に質問に関連する情報の密度が高い。

本稿の主な貢献は以下の通りである:

- 我々は、検索コーパスの索引付けを行う際に、検索単位として命題を使用し、集中的な検索性能を向上させることを提案する。

- FACTOIDWIKIを紹介する。FACTOIDWIKIは、英語版ウィキペディアの各ページを、100語の段落、文、命題という複数の粒度に分割したものである。

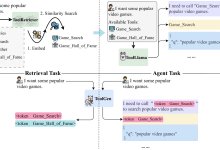

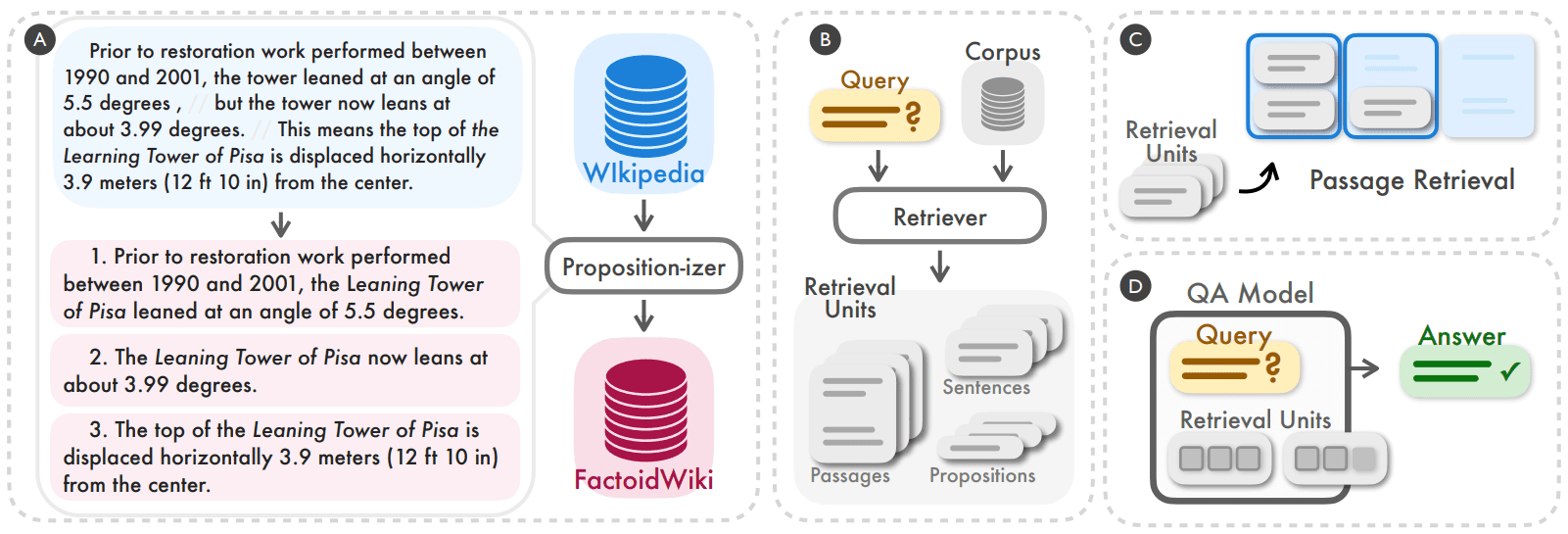

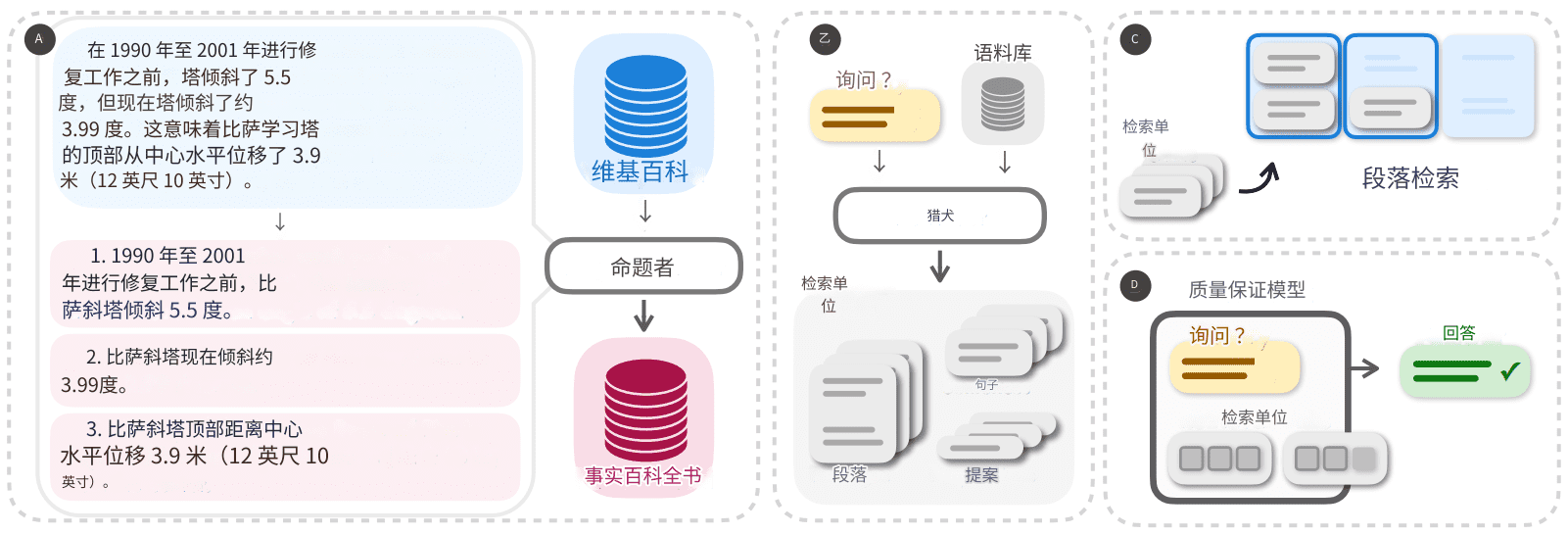

図2:我々は、検索コーパスを命題レベルで分割し、インデックスを付けることが、推論時に密な検索器の汎化性能を向上させる簡単で効果的な戦略になることを発見した(A, B)。100語の段落、文、または命題レベルで作業した場合の、検索と下流のオープンドメインの質疑応答(QA)タスクにおける密検索器の性能を実証的に比較する(C、D)。

2 検索単位としての命題

本研究の目的は、検索コーパスの粒度が高密度検索モデルの性能にどのような影響を与えるかを実証的に理解することである。100語の段落や文といった一般的に用いられる検索単位に加えて、我々は検索単位の代替選択として命題の使用を提案する。ここで、命題とはテキスト中の意味の原子表現を表し、以下の3つの原則によって定義される。

- 各命題はテキスト中の意味の一意な断片に対応し、すべての命題の組み合わせがテキスト全体の意味論を表す。

- 命題は最小限のものでなければならない。

- 命題は文脈化され、自己完結しているべきである。命題は、その意味を説明するために必要な文脈をすべて含むべきである(例:共参照)。

検索単位としての命題の使用は、命題レベルでテキストの意味論を表現し、評価することに成功した一連の最近の研究に触発された。図2の左側の例で、命題の概念と、段落を命題の集合に分割する方法を示す。この段落には3つの命題が含まれており、それぞれがピサの斜塔に関する固有の事実(修復前の角度、現在の角度、水平方向の変位)に対応している。各命題には、その命題の意味を原文とは無関係に解釈できるように、文章中の必要な文脈が含まれている。例えば、最初の命題にある塔への言及は、その正式名称である「ピサの斜塔」として解析される。我々は、各命題が文脈化された原子的事実を正確に記述することを期待しており、そのため、命題は情報検索問題の検索単位として適していると直感している。

3 FACTOIDWIKI:ウィキペディアの命題レベルの索引付けと検索

ウィキペディアの検索単位として、100語の段落、文章、命題の利用を実証的に比較した。ウィキペディアは知識集約的なNLPタスクでよく使われる検索ソースである。異なる粒度での公平な比較を可能にするために、Bohnetら(2022)が使用した2021-10-13の英語Wikipediaダンプを処理した。各文書のテキストを3つの異なる粒度に分割した:100語の段落、文、命題。においても同じ粒度を使用した。付録Aには、段落および文レベルのセグメンテーション・コーパスの詳細情報が含まれている。

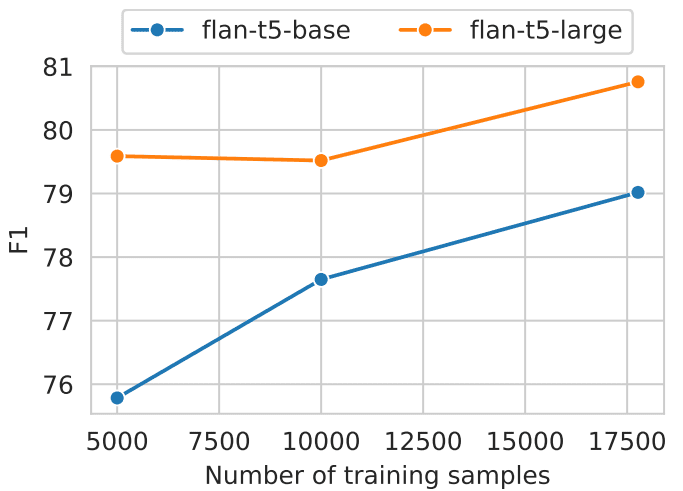

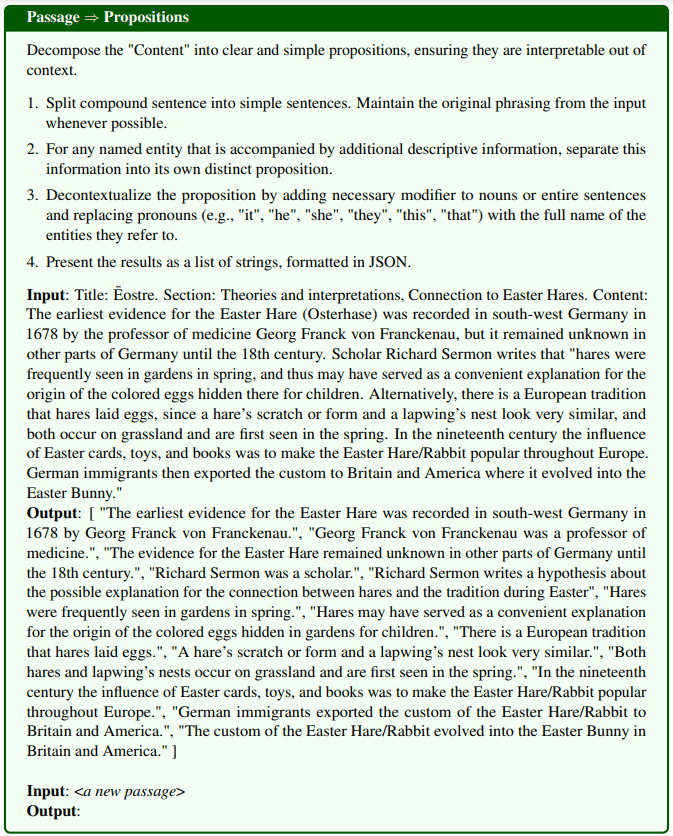

言い換えられた一節は命題である:ウィキペディアのページを命題に分割するために、我々はプロポジサイザーと呼ぶテキスト生成モデルを微調整した。プロポジサイザーは段落を入力とし、段落内の命題のリストを生成する。Chenら(2023b)のアプローチに従い、2段階の蒸留プロセスを用いてプロポジサイザーを訓練する。まず、命題の定義と1つの実演例を含む命令キューGPT-4を使用する。図8にプロンプトの詳細を示す。我々は42kのパッセージのセットから始め、GPT-4を使ってパッセージと命題のペアのシードセットを生成する。次に、このシードセットを使ってFlanT5-largeモデルを微調整する。

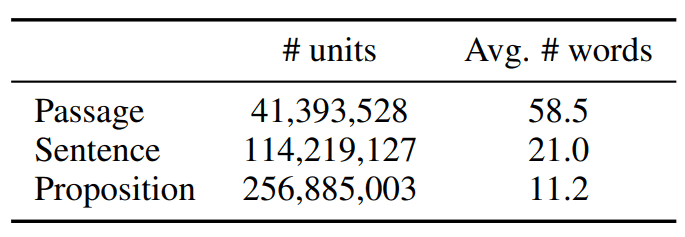

FACTOIDWIKIの統計値を表1に示す。

表1:2021年10月13日の英語版ウィキペディアのデータ・ダンプにおけるテキスト・ユニットの統計データ

4 実験セットアップ

検索単位の3つの選択の影響を評価するために、FACTOIDWIKI上の5つの異なるオープンドメインのQAデータセットで実験を行った。各データセットについて、異なる粒度で索引付けされたWikipediaを用いた場合の段落検索と下流のQAパフォーマンスを評価した。

4.1 オープン・ドメインQAデータセット

我々は、検索ソースとしてウィキペディアを使用する5つの異なるオープンドメインのQAデータセットで評価を行う:Natural Questions (NQ) (Kwiatkowski et al., 2019)、TriviaQA (TQA) (Joshi et al., 2017)、Web Questions (WebQ) (Berant et al., 2013)、SQuAD (Rajpurkar et al., 2016)、Entity Questions (EQ) (Sciavolino et al., 2021)である。

4.2 密な探索モデル

以下の6つの教師ありまたは教師なし密検索モデルの性能を比較する。ここで、教師ありモデルとは、学習期間中に

手動でラベル付けされたクエリとパラグラフのペアは教師ありモデルとなり、その逆は教師なしモデルとなる。

- シムセ はBERTベースのエンコーダであり、Wikipediaからランダムに選択されたラベルのない文章で学習される。

- コントリビューター Contrieverは、ラベル付けされていないウィキペディアとウェブクローリングデータの文書ペアから構築されたコントラストペアを比較することによって学習される。

- DPR は、5 つのオープンドメインの QA データセットで微調整された 2 エンコーダの BERT ベースモデルであり、評価に使用した 4 つのデータセット(NQ、TQA、WebQ、および SQuAD)を含みます。

- ANCE DPRと同じ設定を使用し、ハードネガティブベースの学習法である近似最近傍否定コントラスト推定法(ACE)でモデルを学習した。

- TAS-B は、教師モデルからクロスアテンション訓練によって抽出され、MS MARCO上で微調整された2エンコーダBERTベースモデルである。

- GTR はT5ベースのエンコーダで、ラベルのないオンラインフォーラムのQAデータ対で事前に訓練され、MS MARCOとNatural Questionで微調整されている。

4.3 段落検索の評価

段落、文、命題レベルでコーパスに索引を付けた場合、段落レベルでの検索の性能を評価する。文や命題レベルの検索では、Leeら(2021b)が導入したセットアップに従う。段落のスコアは、クエリと段落内の全ての文や命題の間の最大類似度スコアに基づいている。実際には、まず少し多めのテキストユニットを取得し、各ユニットをソースの段落にマッピングし、上位k個のユニークな段落を返します。この評価指標は、最初に検索されたk個のパラグラフで正解を見つけた質問のパーセンテージとして定義されます。

4.4 ダウンストリームQAアセスメント

異なる検索ユニットを使用することによる、下流のオープンドメインのQAタスクへの影響を理解するために、retrieve-then-read設定における検索モデルの使用を評価する。retrieve-then-read設定では、検索モデルはまず与えられたクエリに対してk個のテキストユニットを検索する。これらのk個の検索されたテキストユニットは、最終的な答えに到達するために、クエリと共にリーダモデルの入力として使用される。通常、kの選択は、最大入力長制約またはリーダーモデルの計算予算によって制限される。

つまり、段落、文、または命題レベルの検索から最初のl単語のみがリーダーモデルに入力される。我々は、予測された答えが真の答えと完全に一致する(EM)質問のパーセンテージを評価する。我々の評価では、リーダーモデルとしてT5-large size UnifiedQA-v2を使用する。

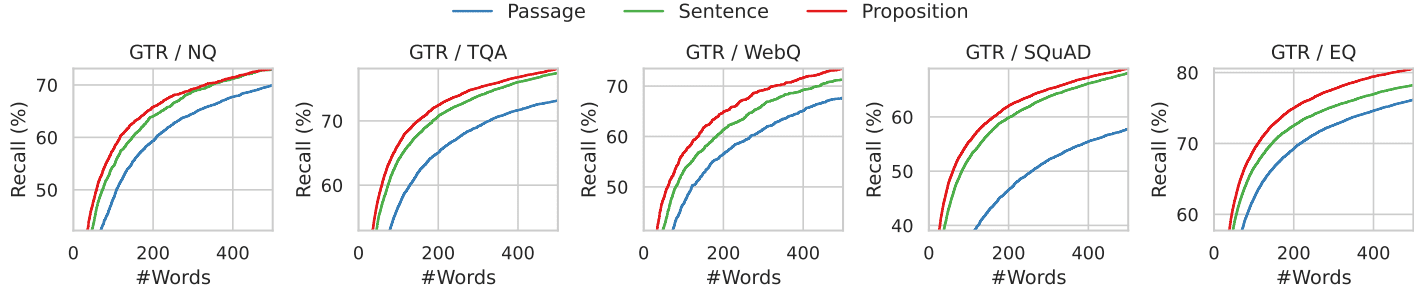

5 結果:段落検索

本節では、検索タスクの性能を報告し、議論する。その結果、どのモデルも命題レベルのデータで訓練されていないが、コーパスが命題レベルで索引付けされている場合、全ての検索モデルが段落ベースや文ベースの検索と同等かそれ以上の性能を示すことがわかった。

5.1 段落検索のパフォーマンス

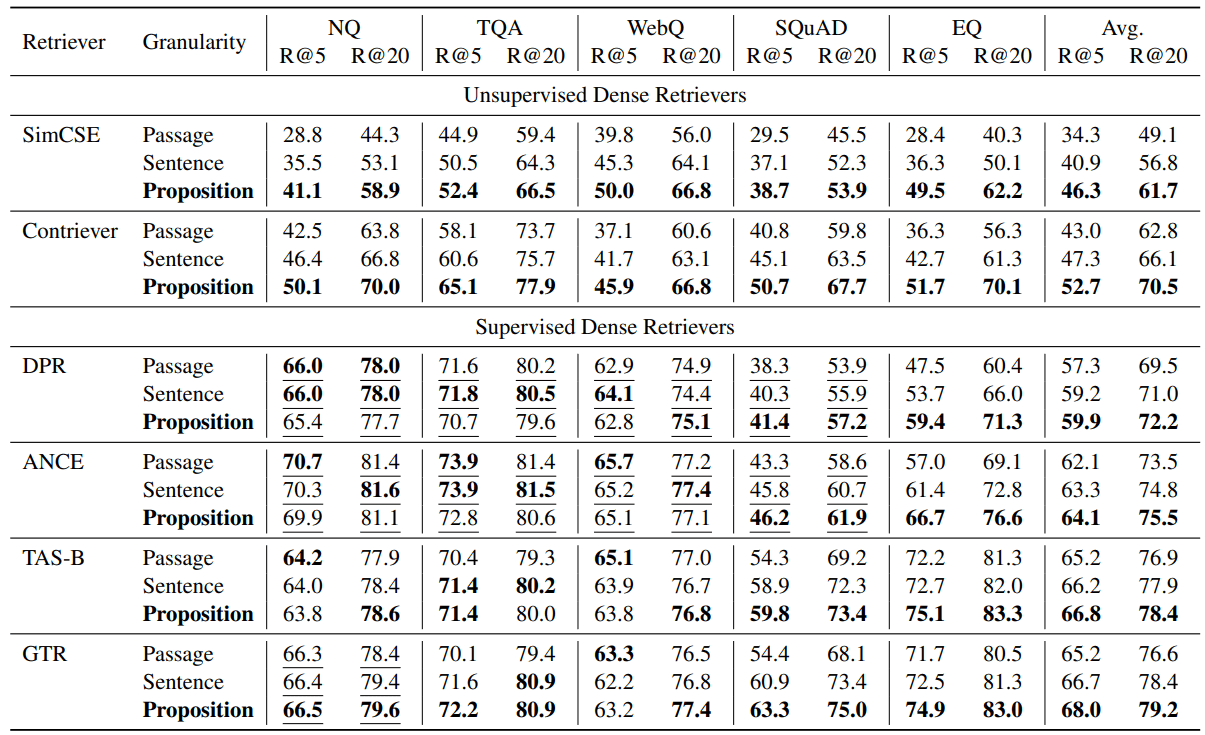

評価結果を表2に示す。ほとんどのタスクにおいて、教師なし検索と教師あり検索の両方で、命題ベースの検索が文ベースや段落ベースの検索を上回ることがわかる。

テストされた全ての集約的検索において、命題ベースの検索は、5つのデータセットにおいて、一貫して文ベースと段落ベースの検索を平均的に上回った。教師なし検索、つまりSimCSEとContrieverでは、5つのデータセットで平均+12.0と+9.3のRecall@5の改善が見られた(相対的な改善は35.01 TP3Tと22.51 TP3T)。

教師あり検索の場合、命題レベル検索は依然として平均的な優位性を示すが、その改善幅は小さい。これは、これらの検索がクエリとパラグラフのペアで学習されているためであると考えられる。例えば、NQ、TQA、WebQ、SQuADで学習されたDPRとANCEでは、SQuADを除く3つのデータセットにおいて、命題ベース検索と文ベース検索は段落ベース検索よりも若干劣っている。表2に示すように、NQ、TQA、WebQでは、3つの検索粒度における全ての教師あり検索の性能は同等である。

しかし、レトリーバーモデルがトレーニング中に見たことのないデータセットでは、命題ベースの検索が明らかに有利であることが観察された。例えば、SQuADやEntityQuestionsでは、命題ベースの検索が他の2つの粒度を大きく上回ることが確認された。DPRやEntityQuestionsのような比較的弱い検索では、17-25%のRecall@5が相対的に向上している。さらに、SQuADにおける命題ベース検索のRecall@5は、TAS-BとGTRで最も向上し、10-16%の相対的な向上が見られる。

表2:5つの異なるオープンドメインのQ&Aデータセットにおいて、事前学習済みのdense retrieverが3つの異なる検索コーパスの粒度で動作した場合の段落検索性能(recall @k = 5, 20)。下線は、対象データセットの学習セグメンテーションがdense retrieverの学習データに含まれていることを示す。

5.2 命題に基づく検索⇒より優れたクロスタスク汎化

その結果、命題ベースの検索の利点は、クロスタスクの汎化において最も顕著であることがわかった。SQuADとEntityQuestionsにおいて、命題に基づく検索はクロスタスク汎化においてより多くの性能向上をもたらすことが確認された。

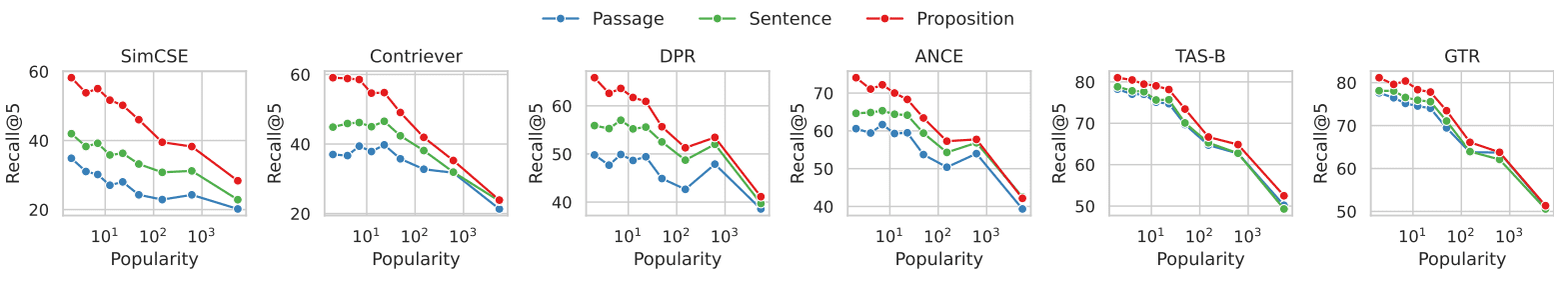

改善の原因をよりよく理解するために、EntityQuestionsについて追加分析を行った。EntityQuestionsは、ロングテールのエンティティ属性をターゲットとする質問を特徴としているため、検索パフォーマンスが、質問におけるターゲットエンティティの人気度、つまり、エンティティがWikipediaに出現する頻度によってどのような影響を受けるかを、3つの異なる粒度レベルで調査しました。各エンティティの人気度を以下の方法で推定する。エンティティの表面形式が与えられた場合、BM25を使用してWikipediaから最初の1000の関連する文章を検索する。その最初の1000段落にエンティティが出現する回数を、そのエンティティの人気の推定値として使用する。EntityQuestionの20,000のテストクエリのうち、約251 TP3Tの対象エンティティの人気度が3以下である。

図3は、段落検索の性能と各問題における対象エンティティの人気度との関係を示している。6つの密な検索器すべてにおいて、あまり一般的でない実体を対象とした問題では、命題ベースの検索が段落ベースの検索よりも有利であることが観察される。エンティティの人気が高くなるにつれて、性能差は減少する。この結果から、命題ベース検索の性能向上は、主にロングテール情報を対象とするクエリに起因することが示唆される。このことは、命題に基づく検索が、密な検索エンジンのタスク横断的な汎化性能を向上させるという我々の観察と一致する。

図3:EntityQuestionsデータセットにおける各質問のターゲットエンティティの人気度に対する文書検索リコール

EntityQuestionsデータセットでは、各質問の人気度(つまり、値が小さいほどそのエンティティは一般的でないことを示し、その逆も同様)は、BM25によって検索された最初の1,000パッセージにおけるエンティティの出現頻度によって推定された。

あまり一般的でないエンティティを含むクエリでは、エンティティによる検索と比較して、命題による検索がより優れていることがわかる。

6 結果:オープンフィールドQA

このセクションでは、検索粒度の選択が下流のオープンドメインQAタスクにどのような影響を与えるかを調べる。我々は、retrieve-then-readセットアップにおいて、命題ベースの検索が下流のQA性能に強い影響を与えることを示す。検索ユニットとして命題を使用した場合、平均EM@l指標におけるQA性能は、検索機全体でより高くなることが確認された。

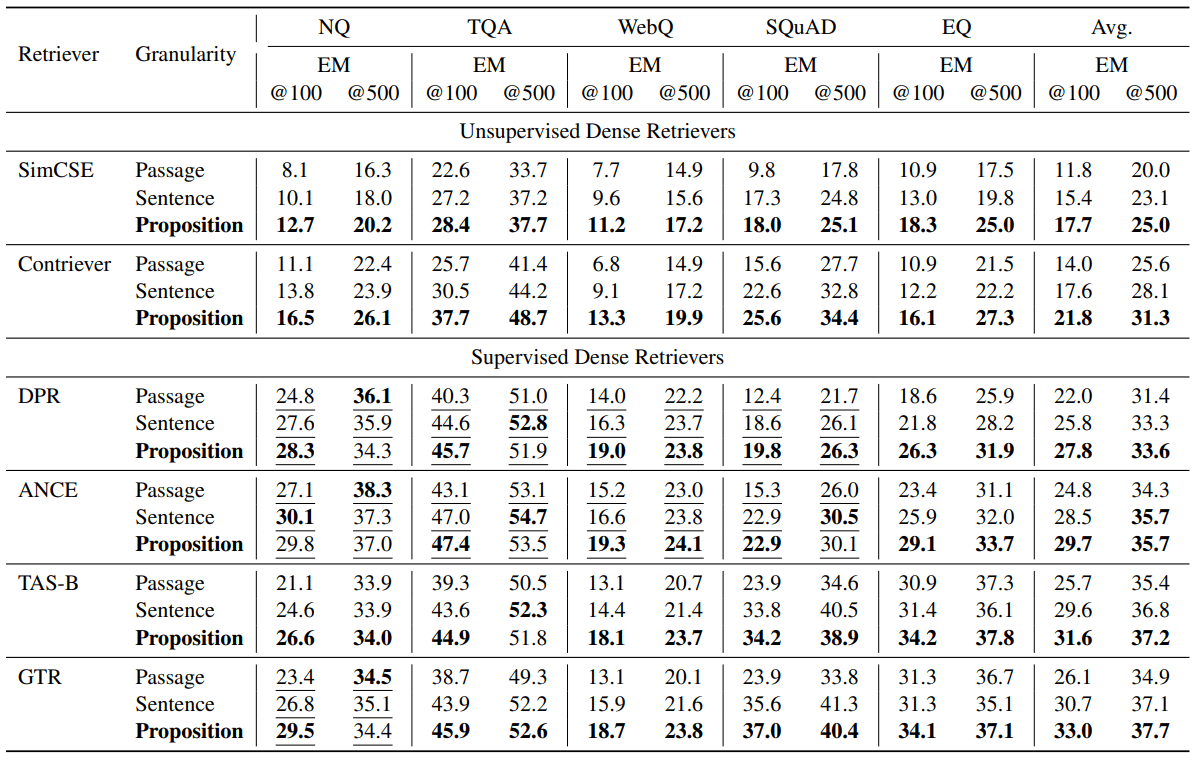

6.1 QAパフォーマンス

表3に評価結果を示す。検索ユニットとして命題を使用した場合、平均EM@l指標においてより高いQA性能が観察された。教師なし検索SimCSEとContrieverは、EM@100スコアをそれぞれ+5.9と+7.8向上させた(50%と55%の相対的向上)。教師あり検索DPR、ANCE、TAS-B、GTRは、EM@100でそれぞれ+5.8、+4.9、+5.9、+6.9の改善を示した(26%、19%、22%、26%の相対改善)。段落検索評価と同様に、特に検索対象のデータセットで訓練されていない場合、下流のQA性能の点で命題ベースの検索がより有益であることがわかった。他のケースでは、命題ベースの検索はまだ有利であるが、平均マージンは小さい。

表3: リーダークイズモデルに渡される検索語数がl = 100または500に制限された、検索後の読み取り設定におけるオープンドメインのクイズのパフォーマンス(EM = 完全一致)。接続された上位の検索テキストユニットからの最初のl単語が、リーダーモデルへの入力として渡された。下線は、ターゲットデータセットの訓練セグメンテーションが、高密度のレトリーバーの訓練データに含まれていることを示す。ほとんどの場合、より小さな検索ユニットを使用することで、Q&Aのパフォーマンスが向上することがわかる。

6.2 命題⇒質問に関連する情報の密度が高い

直感的に言えば、検索ユニットとして文章や段落よりも命題の方が優れている点は、検索された命題はクエリに関連する情報の密度が高いことである。より細かい検索ユニットを使用することで、クエリに対する正しい答えは、密度の高い検索者の検索語の上位に表示される可能性が高くなる。

この現象を図4に示す分析で説明する。ここでは、検索された最初のl語における正解の位置を調べる。具体的には、3つの異なる粒度で索引付けされたウィキペディアを使用した場合、GTRリトリーバによって検索された最初のl語における金色の答えの想起率を計算する。

その結果を図4と図7に示す。lは0から500の範囲で、5つのデータセットすべてをカバーしている。検索語の予算が一定である場合、最初の100~200語の範囲では、命題検索は文検索や段落検索よりも成功率が高い。単語数がさらに増えると、質問に関連するすべての情報が検索されたテキストに含まれるため、3段階の粒度の回収率は収束する。

図4: GTR検索において、検索されたテキストを最初のk語に限定した場合のゴールドスタンダード回答の回収率。よりきめ細かい検索は、すべての単語数範囲においてより高い回収率を示す。

6.3 エラー・ケーススタディ

各検索粒度におけるエラーの原因を理解するために、4つの典型的なエラー例を表4に示し、議論する。各例では、3つの粒度でGTR検索によって検索された問題と、それに対応するトップ1テキストユニットが示されている。

チャネルレベルの検索では、エンティティやその参照の曖昧さが、密な検索者に課題を与える。例えば、例Q1では、質問は「スーパーボウル50」を尋ねているが、検索された記事と文章は「スーパーボウル5」を指している。例Q2では、段落検索は正しい「原子番号」を参照するセクションを特定できない。代わりに、最初に検索された記事は、質問とは異なる無関係な文脈で「原子番号」に言及している。文単位の検索も、例Q1のように、段落単位の検索と同様の問題を持つ可能性があり、文検索のもう一つの課題は、文脈の欠如である。例Q3では、検索された記事中の正しい文が "it "を使って心嚢を指しているため、文に基づく検索は失敗する。

命題に基づく検索は、各検索ユニットが命題に必要な文脈を持つ事実を1つだけ含むようにすることで、上記の問題を解決する。しかし、命題ベースの検索は、長距離のテキスト分析を含むマルチホップ推論の課題に直面する。例Q4では、検索された文章はそれぞれ俳優の名前と役柄を記述している。どの命題も質問と答えの両方を含んでいない。

表4:各検索粒度で検索された最初のランク付けされたテキスト・ユニットが正しい答えを提供できなかったケースを示す例。下線を引いたテキストが正解である。灰色のテキストは命題の文脈であるが、これは説明のためだけに使用され、リトリーバと下流のQ&Aモデルには提供されない。

7 関連作品

高密度検索に関する最近の研究では、一般的にデュアルエンコーダアーキテクチャが用いられている。デュアルエンコーダでは、各クエリと文書は低次元の特徴ベクトルとして別々にエンコードされ、それらの間の相関は、埋め込まれたベクトル間のノンパラメトリック類似度関数によって測定される。類似度関数の表現力には限界があるため、デュアルエンコーダーモデルは通常、特に学習データが乏しい場合、新しいタスクに対する汎化能力が低い。このため、これまでの研究では、密検索器のタスク横断的な汎化性能を向上させるために、データ増強、連続的な事前学習、タスクを考慮した学習、ハイブリッドスパース密検索、ハイブリッド戦略検索などの手法が用いられてきた。

我々の研究は、ColBERT、DensePhrase(Lee et al., 2021a,b)、ME-BERT、MVRなどのマルチベクトル検索の反響に動機づけられた部分があり、検索モデルは、モデルの表現性を高め、検索の粒度を向上させるために、検索候補ユニットを複数のベクトルにエンコードすることを学習する。我々の研究は、密な検索モデルやそのパラメータを更新しない設定に焦点を当てている。検索コーパスをより細かな命題に分割することが、推論中のデュアルエンコーダ密な検索器の汎化能力を向上させる、簡単で直交的な戦略となり得ることを示す。

命題をテキスト表現単位として使用するというアイデアは、自動ダイジェスト評価におけるピラミッドアプローチ(Nenkova and Passonneau, 2004)まで遡ることができる。テキストから命題を抽出することは、自然言語処理における長年の課題であり、初期の定式化では、命題の構造化表現(例えば、オープン情報抽出、意味役割ラベリング)に焦点が当てられていた。最近の研究では、少ないヒントで大規模な言語モデルを使用したり、小規模なモデルを微調整することで、自然言語形式で命題を抽出することに成功している。

検索-読解、またはより広義には検索-強化された生成は、最近オープンドメインのQ&Aで人気のあるパラダイムとなっている。初期の研究では、下流の読者に最大100の検索された文章を提供していたが、最近の大規模な言語モデルを使用する場合、コンテキストウィンドウの長さに制限があり、長いコンテキストを扱うことができないため、許容されるコンテキストの量が大幅に減少する(最初の10個など)。最近の取り組みでは、検索された文書をフィルタリングしたり圧縮したりすることで、読者のコンテキストの質を向上させることが試みられている。我々の研究は、新しい検索単位である命題を利用することで、この問題に効果的に対処している。この命題は、コンテキスト長を短くするだけでなく、より高い情報密度を提供する。

8 結論

本論文では、コーパスに索引を付けるための検索単位として命題を使用することで、推論時の高密度検索の性能を向上させることを提案する。5つのオープンドメインのQAデータセットを用いて、6つの異なる集約的検索器を用いた実験を通して、検索語のバジェットを固定した場合、段落検索精度および下流のQA性能の両方において、命題に基づく検索が段落または文に基づく検索を上回ることを見出す。FACTOIDWIKIを紹介する。FACTOIDWIKIは、英語版ウィキペディアのダンプをインデックス化したもので、600万ページのテキストが2億5千万の命題に分割されている。FACTOIDWIKIと本稿で得られた知見が、今後の情報検索の研究を促進することを期待している。

制限

検索コーパスの粒度に関する我々の現在の研究には以下の限界がある。(1)検索コーパス - ほとんどのオープンドメインのQAデータセットが検索コーパスとしてWikipediaを使用しているため、我々の研究は検索コーパスとしてWikipediaのみに焦点を当てている。(2)評価した高密度検索エンジンの種類 - 本論文の現在のバージョンでは、6つの一般的な高密度検索エンジンのみを評価している。将来のバージョンでは、より広範な密なリトリーバの結果を含め、議論する予定である。(3) 言語 - 我々の現在の研究は、英語版ウィキペディアに限定している。他の言語については今後の研究に譲る。

A コーパスの検索処理

この研究で使用された英語版ウィキペディアのダンプは、Bohnetらによって2022年に発表されたもので、図表やリストを除去し、段落形式で整理するためにフィルターがかけられているため、使用することにした。ダンプの日付は2021年10月13日まで遡る。この研究のために、ウィキペディアを3つの検索単位、すなわち100語の段落ブロック、文章、命題に分割した。段落を100語の段落ブロックに分割するために貪欲な方法を使用した。各段落ブロックに完全な文が含まれるように、文末のみを分割した。段落を処理しながら、文を1つずつ追加していく。次の文を入れると段落ブロックが100ワードを超えてしまう場合は、その文から新しい段落ブロックを始めます。しかし、最終的な段落ブロックが50ワード未満の場合は、小さすぎる断片を避けるために、前の段落ブロックと統合する。さらに、広く使われているPython SpaCyのen_core_web_lgモデルを用いて、各段落を文に分割します。さらに、Propositionizerモデルは各段落を命題に分解する。合計で、我々は600万ページを4,139万段落、1,142万文、2億5,700万命題に分解した。平均して、段落は6.3個の命題を含み、文は2.3個の命題を含む。

B トレーニング提案者

図8に示すように、GPT-4を使って、与えられたパッセージからプロンプトによって命題のリストを生成した。フィルタリング後、合計42,857組がFlan-T5-Largeモデルの微調整に使われた。このモデルをPropositionizerと名付けた。バッチサイズ64、学習率1e-4、重み減衰1e-4のAdamWオプティマイザを使用し、3サイクル学習した。異なるモデルによって生成された命題の性能を比較するために、開発セットと評価指標を設定した。開発セットには、訓練セットと同じ方法でGPT-4によって収集された1000組の追加サンプルが含まれる。予測された命題の質を、2つの命題セットのF1スコアによって評価する。BertScoreの2組のマーカーのF1スコアにヒントを得て、2組の命題のF1スコアを設計する。P = {p1, ... , pn}とする。pn}はラベル付けされた命題の集合、ˆP = {ˆp1, ... , ˆpm}はラベル付けされた命題の集合を表す。ˆpm}は予測命題の集合を表す。sim(pi,ˆpj)を用いて2つの命題間の類似性を表現する。理論的には、どのようなテキスト類似度メトリックも使用できる。我々は、命題間の意味的差異を反映する指標を求めるため、sim関数としてBertScoreを用いることにした。と定義する:

Recall = 1 / |P| ∑(max(sim(pi, ˆpj) for ˆP) Precision = 1 / |ˆP| ∑(max(sim(pi, ˆpj) for pi in P) F1 = 2 * Precision * Recall / (Precision + Recall)リコール)

以下は、F1スコアのグラフによる説明である:想起は、生成された集合の命題に似ているラベル付けされた集合の命題のパーセンテージを表し、精度は、ラベル付けされた集合の命題に似ている生成された集合の命題のパーセンテージを表し、F1は、想起と精度の調整平均である。F1は、2つの集合が同一の場合は1であり、2つの命題が意味的に異なる場合は0である。

我々は、異なるデータ量(図5に示す)を用いて訓練された基本モデルと大型Flan-T5モデルの比較分析を行った。その結果、より大きなモデルと大量の学習データを組み合わせた方が、より良い結果をもたらすことがわかった。命題アナライザーは0.822のF1値を達成した。生成された命題を手動で見直した結果、満足できるものであることがわかった。

図5:サイズと学習データ数の異なるモデルに対する命題レベル分解のパフォーマンス。

Cオフライン・インデックス

pyseriniパッケージとfaissパッケージを使用して、検索されたユニットを埋め込みとしてエンコードした。バッチサイズ64で100万ユニットにグループ化された複数のGPUを使用して、各テキストユニットをエンコードした。エンベッディングの前処理を行った後、内積を用いた厳密探索(faiss.IndexFlatIP)を用いて全ての実験を行った。メモリへの負荷を軽減するため、埋め込みは8つのスライスに分割されている。各スライスは、すべての結果を集約する前に近似最近傍探索を実行する。命題の数はパッセージの数の6倍であるが、効率的なインデックス作成技術を使用することで、ベクトルの総数に対して線形以下の検索時間を達成することができる。さらに、GPUの並列性と分散インデクシングを利用することで、オンライン検索時間が大幅に短縮される。このように、適切な実装により、命題検索を実用的かつ効率的な選択肢とすることができる。

Dレトリーバーモデル

モデルの実装にはtransformersパッケージとsentence-transformersパッケージを使用した。HuggingFaceで公開されている以下のチェックポイントを使用した:SimCSE(princeton-nlp/unsup-simcse-bert-base-uncased)、Contriever(facebook/contriever)、DPR(facebook/dpr-question_encoder-multiset-base)。ctx_encoder-multiset-base、facebook/dpr-question_encoder-multiset-base)、ANCE (castorini/ance-dpr-context-multi、castorini/ance-dpr-question-multi,)、Contriever (facebook/contriever)。question-multi,)、TAS-B(sentence-transformers/msmarco-distilbert-base-tas-b)、GTR(sentence-transformers/gtr-t5-base)。

E その他の結果

セクション5.2では、特にエンティティの母数が減少するEQにおいて、文ベースの検索よりも命題ベースの検索の方が優れていることを示す。Sciavolinoら(2021)で用いられているようなエンティティへのハイパーリンク数を用いるのではなく、BM25によって検索された最初の1000パラグラフにおける出現回数を人気の代理として用いる。その結果、パフォーマンス対人気度のグラフの傾向(図6)は、われわれの結果とSciavolinoら(2021)の結果の間にいくつかの違いを示している。例えば、いくつかのエンティティは曖昧である(例えば、1992年、テレビシリーズ)。この場合、実体の表面形の出現数が多い。同時に、あいまいなエンティティに関連する質問は回答が困難であるため、想起率が低くなる。セクション6.2では、文脈の長さの関数として、検索されたテキストの回答の想起について説明する。さらに、図7に示すように、6つの密な検索エンジンの性能傾向を示す。結果は、命題の想起が文や段落の想起よりも一貫して優れていることを示している。この結果から、文や段落に比べ、命題には質問に関連するユニットの密度が高いという結論が導かれる。

図8:GPT-4を使って記事から命題を生成するためのヒント。

コンテンツ」を明確でシンプルな命題に分解し、解釈できるようにする。

文脈の

1.複文を単文に分割する。 入力された元の言い回しを維持する。

可能な限り。

2.追加的な説明情報を伴う名前付きエンティティについては、この情報を分離する。

情報を独自の明確な提案にする。

3.名詞や文全体に必要な修飾語を加えて、命題を脱文脈化する。

代名詞(例えば、"it"、"he"、"she"、"they"、"this"、"that")を、以下のようにフルネームで置き換える。

を指す。

4.JSONでフォーマットされた文字列のリストとして結果を提示する。インプット。 タイトル:エオストレ セクション:理論と解釈、イースター・ヘアーとの関連 内容:¯.

イースター・ウサギ(Osterhase)の最古の証拠は、ドイツ南西部で次のように記録されている。

1678年、医学教授ゲオルク・フランク・フォン・フランケナウによって発見された。

学者であるリチャード・サーモンは、「野ウサギは、18世紀までドイツの他の地域に生息していた」と書いている。

春になると庭でよく見かけるので、その説明のために使われたのだろう。

あるいは、ヨーロッパには「黒い卵」という伝統がある。

というのも、ノウサギのひっかき傷や巣の形とヒヨドリの巣の形はよく似ているからである。

どちらも草原に生息し、春に初めて見られる。

イースター・カード、玩具、書籍は、イースターのウサギをヨーロッパ中に広めた。

その後、ドイツからの移民がこの習慣をイギリスやアメリカに輸出し、この習慣が発展した。

イースター・バニー"

出力。 [イースター・ヘアーに関する最古の証拠は、ドイツ南西部で記録されている。

1678年、ゲオルク・フランク・フォン・フランケナウ著。

イースター・ヘアーの証拠は、ドイツの他の地域では知られていなかった。

リチャード・サーモンは18世紀まで学者だった」、「リチャード・サーモンは仮説を書いている。

イースターの風習とウサギの関係を説明する可能性について」。

ウサギは春になると庭でよく見かけた」、「ウサギは便利な動物だったのかもしれない」。

子供たちのために庭に隠された色とりどりの卵の由来についての説明。

ノウサギが卵を産むというヨーロッパの伝統」、「ノウサギのひっかき傷や形と、ヒヨドリの巣はとてもよく似ている。

似ている"、"ノウサギもヒヨドリの巣も草原に発生し、春に初めて見られる"、"ノウサギもヒヨドリの巣も草原に発生し、春に初めて見られる"。

19世紀には、イースターカードや玩具、書籍の影響で、イースターは「復活祭」と呼ばれるようになった。

ヨーロッパ全土に広まったウサギとウサギ」、「ドイツからの移民は、ウサギを飼う習慣を輸出した。

イースター・ウサギの習慣は、イギリスとアメリカへと発展した。

英米のイースター・バニー"]]。

インプット。 <a new passage>

出力。

コンテンツ」を明確でシンプルなアイデアに分解し、元の文脈から取り出しても意味が通じるようにする。

1.複文を単文に分解し、可能であれば元の定型文を残す。

2.付加的な記述情報を持つ特定のエンティティの場合、この情報は個別のアサーションに分離される。

3.名詞や文全体に必要な修飾語を付けたり、代名詞(例:"it"、"he"、"she"、"they"、"this"、"that")を、それらが指す実体の正式名称に置き換えたりすることで、文脈から外れた主張をすること。

4.結果を文字列のリストとして提示し、JSON形式を使用する。インプット:タイトル:Eostre.の章:イースター・バニーとの関連性を持つ説と説明。内容:イースター・バニー(Osterhase)の最も古い証拠は、1678年にゲオルク・フランク・フォン・フランケナウがドイツ南西部で記録したものだが、18世紀までドイツの他の地域では知られていなかった。学者のリヒャルト・サーモンは、「ウサギは春になると庭でよく見かけたので、子供たちが庭で見つけた色とりどりの卵の由来を説明するのに都合よく使われたのかもしれない」と書いている。さらにヨーロッパでは、ノウサギが卵を産むという言い伝えがある。その理由は、ノウサギの擦り傷や形がコムギの巣によく似ていること、ノウサギは草原に生息し、春に初めて発見されるからである。19世紀には、イースター・カードやおもちゃ、本の影響で、イースター・バニーがヨーロッパ中に広まった。その後、この風習はドイツ系移民によってイギリスやアメリカに広まり、現在のようなイースター・バニーへと発展した。"

出力:[イースター・バニーに関する最古の証拠は、1678年にドイツ南西部のゲオルク・フランク・フォン・フランケナウによって発見された。ゲオルク・フランク・フォン・フランケナウは医学の教授だった。"ドイツの他の地域の人々がこのイースターうさぎに関連する証拠を知るようになったのは、18世紀になってからである。" , "リチャード・サーモンは、イースターうさぎに関連するこの証拠を知った。"リヒャルト・サーモンは学者であった。""リヒャルト・サーモンは、イースターとウサギの伝統的な結びつきについて、考えられる説明についての仮説を提示した。" , "ウサギは、春になると庭でよく見かける。" , "ウサギは、単純な動物なのかもしれない。", "子供たちが庭で色とりどりの卵を見つける理由を、ウサギは簡単に説明してくれるかもしれない。" , "イースターにはウサギが登場するという伝統的な考え方がある。"ヨーロッパでは、ウサギが卵を産むという伝統的な見方がある""ノウサギの刮目や形はコムギの巣と極めてよく似ている。" "どちらも草原に生息し、春に初めて発見される。"19世紀、イースターカード、おもちゃ、本の流行により、イースターバニーはヨーロッパで広く知られるようになった" , "ドイツ移民がイースターバニーを持ち込んだ。ドイツからの移民がイースターバニーの習慣をイギリスとアメリカに持ち込んだ。"イギリスとアメリカでは、イースターバニーの風習は次第に現在のイースターバニーへと発展していった。" ]

インプット: <新しい段落

出力: