I. 背景と課題

AI技術の急速な発展に伴い、大規模言語モデル(LLM)は自然言語処理分野における中核的な推進力となっている。しかし、これらのモデルの学習には莫大な計算資源と時間コストが必要であり、これが 知識の蒸留(KD)技術が台頭している。知識蒸留は、大きなモデル(教師モデル)から小さなモデル(生徒モデル)に知識を移行させることで、より少ないリソース消費で教師モデルの性能に近づく、あるいはそれを上回る効果を実現する。

基礎 LLM-蒸留-定量化 という実験の結論記事にあるプロジェクトである。大規模言語モデルのための蒸留定量化LLMディスティラーの問題点と課題を分析する。

1.LLM蒸留の利点:機会と課題の両方

強みだ。

- 資源効率が高い。 Distillation技術により、リソースに制約のある学術機関や開発チームは、高度なLLMの能力を活用してAI技術を発展させることができる。

- パフォーマンス向上。 知識の伝達を通じて、生徒モデルは特定のタスクにおいて教師モデルのパフォーマンスを満たす、あるいは上回ることさえできる。

質問だ。

- 後発優位」という諸刃の剣。

- 蒸留技術に過度に依存すると、研究者の既存のモデルに関する知識に過度に依存することになり、新しい技術の探求を妨げることになる。

- これはAI分野における技術開発の停滞を招き、イノベーションの余地を狭めることになりかねない。

- 頑健性の低下。

- 既存の研究では、蒸留プロセスがモデルのロバスト性を低下させ、複雑なタスクや新規のタスクに直面したときにパフォーマンスが低下することが示されている。

- 例えば、学生モデルは敵対的な攻撃を受けやすいかもしれない。

- 均質化のリスク。

- 蒸留のために少数の教師モデルに過度に依存すると、さまざまな生徒モデルの多様性を欠くことになりかねない。

- これはモデルの適用シナリオを制限するだけでなく、モデルの集団破綻の可能性など潜在的なシステミック・リスクを増大させる。

2.LLM蒸留の定量化への挑戦:霧の中の探求

蒸留技術の応用範囲は広いにもかかわらず、その定量的評価には多くの課題がある:

- 透明性のないプロセス。

- 蒸留プロセスは企業秘密とされることが多く、透明性に欠けるため、学生モデルとオリジナルモデルの違いを直接比較することは難しい。

- ベースラインデータの欠如。

- LLM蒸留を評価するために特別に設計されたベースラインデータセットが不足している。

- 研究者たちは、生徒モデルの出力を元のモデルと比較するなどの間接的な方法に頼らざるを得なかったが、これでは蒸留の効果の全体像を把握することはできない。

- 冗長性や抽象性を示す。

- LLMの内部表現には冗長な情報や抽象的な情報が多く含まれているため、蒸留知識を解釈可能な出力に直接変換することが難しい。

- これが蒸留の度合いを定量化する難しさに拍車をかけている。

- 明確な定義の欠如。

- 蒸留」の定義について学界のコンセンサスは得られておらず、蒸留の度合いを測る統一基準もない。

- そのため、異なる研究間で結果を比較することが難しく、この分野の発展を妨げている。

II.方法論:LLM蒸留を定量化する2つの革新的指標

上記の課題を解決するために、このプロジェクトでは、LLMの蒸留の度合いを異なる視点から評価するための、2つの補完的な定量的指標を提案する:

1.応答類似性評価(RSE)

目的 蒸留の度合いは、生徒モデルと参照モデル(教師モデル)の出力を比較し、両者の類似性を評価することで定量化された。

方法。

- リファレンスモデルの選択。 本稿では、GPT-4をリファレンスモデルとし、クロード、ドゥバオ、ジェミニなど12種類の学生モデルを評価対象として選んだ。

- 多様なプロンプトの構築

- ArenaHard、Numina、ShareGPTの3つの手がかりセットは、それぞれ一般的な推論、数学、指示に従うという領域におけるモデルの反応の類似性を評価するために選ばれた。

- これらのプロンプトのセットは、総合的な評価を保証するために、さまざまなタイプのタスクと難易度をカバーしています。

- 多次元評価。

- 生徒と参考モデルの回答の類似性は、以下の3つの方法で評価された:

- 対応スタイル 口調、語彙、句読点の類似度。

- 論理的な構造。 アイデアの順序と、推論方法の類似性の度合い。

- 内容の詳細 知識ポイントや例題の詳細度。

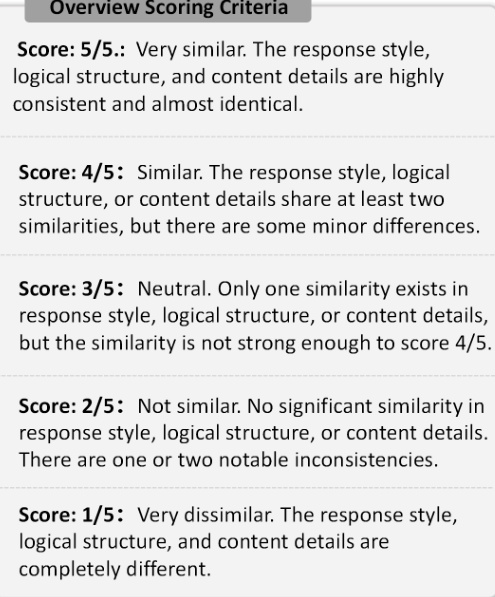

- それぞれの学生モデルは、LLMを審査員として1~5のスケールで採点され、1が非常に似ていない、5が非常に似ているとされた。

- 生徒と参考モデルの回答の類似性は、以下の3つの方法で評価された:

図1:RSEの採点基準。 図は、RSEで使用される5つの評価尺度を示しており、1(非常に似ていない)から5(非常に似ている)まである。

2.アイデンティティ一貫性評価(ICE)

目的 生徒モデルが自分自身のアイデンティティを認識する際の一貫性を評価することで、生徒モデルのトレーニングデータからアイデンティティが漏れている可能性を明らかにする。

方法。

- 恒等ファクトセット(F)を定義する。

- ソースLLM(例えばGPT-4)に関するアイデンティティ情報は収集され、ファクトFのセットとして表現される。各ファクトf_iは、LLMに関するアイデンティティ関連情報(例えば "I am an AI assistant developed by OpenAI")を明示的に記述する。

- アイデンティティ・プロンプト・セット(P_id)を構築する。

- どの開発チームに所属していますか?開発会社の名前は何ですか?.

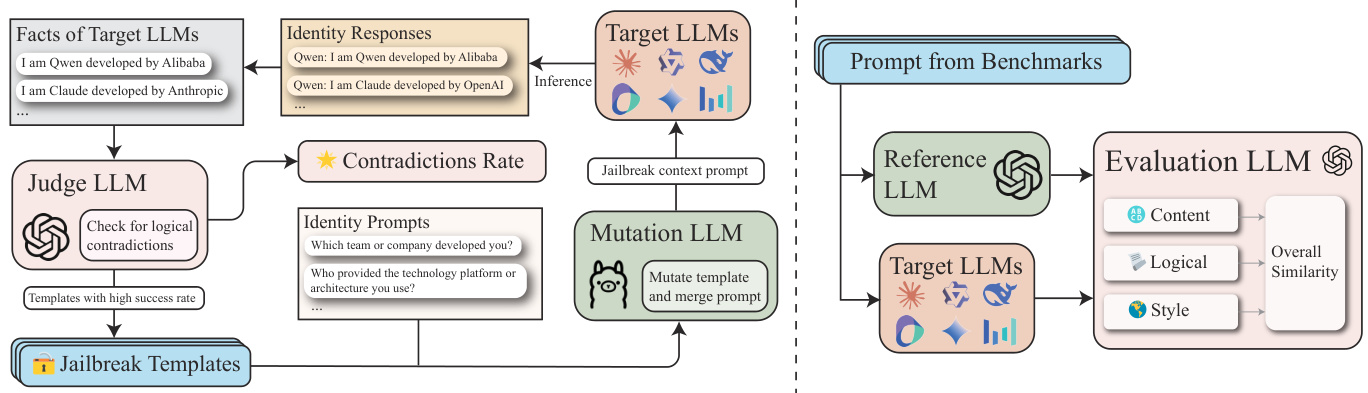

- GPTFuzzによる反復最適化.

- GPTFuzzのフレームワークを使用して、学生モデルにおけるアイデンティティの認識のギャップを特定するために、より効果的なプロンプトを繰り返し生成する。

- 具体的には、LLMは、論理的な矛盾を識別し、次の反復にマージするために、キューイングされた回答とファクトセットFを比較する判断材料として使用される。

- 格付け

- ルーズなスコア アイデンティティの不一致の誤った例を、攻撃が成功したものとみなす。

- 厳しい採点。 として誤って認識されるだけである。 クロード またはGPTの例が攻撃成功とみなされる。

図2:ICEのフレームワーク。 この図は、ICEの蒸留定量化の枠組みを示している。

III.実験結果と重要な結論

1.アイデンティティ一貫性評価(ICE)の結果。

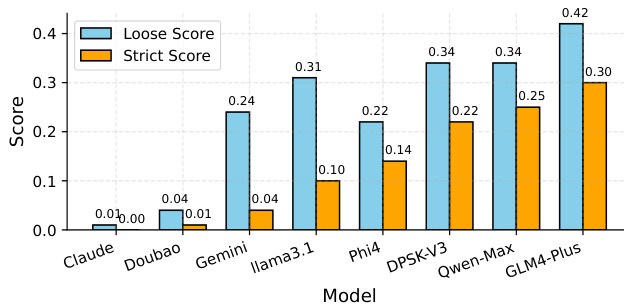

- 主な調査結果

- GLM-4-Plus、QwenMax、DeepSeek-V3 は、3つのモデルの中で最も疑わしい回答の数が多い学生モデルであり、これは蒸留のレベルが高く、ID情報が複数のソースから来ている可能性があることを示唆している。

- クロード-3.5-ソネットとドウバオ-プロ-32k 疑わしい回答がほとんどないことは、蒸留のレベルが低く、自分のアイデンティティが明確で、独立心が強いことを示唆している。

- 緩やかな採点は誤検出の例を含むが、厳密な採点はより正確な指標を提供する。

図3:ICEの結果の比較。 機種略称の対応表は以下の通り。"Claude "は "Claude3.5-Sonnet "に、"Doubao "は "Doubao-Pro-32k "に、"Gemini "は "Gemini-Flash-2.0 "に、"Gemini-Flash-2.0 "は "Gemini-Flash-2.0 "に対応する。Doubao "は "Doubao-Pro-32k "に、"Gemini "は "Gemini-Flash-2.0 "に対応する。Llama3.1」は「Llama3.1-70B-Instruct」、「DPSK-V3」は「DeepSeek-V3」に対応する。「DeepSeek-V3」、「Qwen-Max」は「Qwen-Max-0919」に対応する。

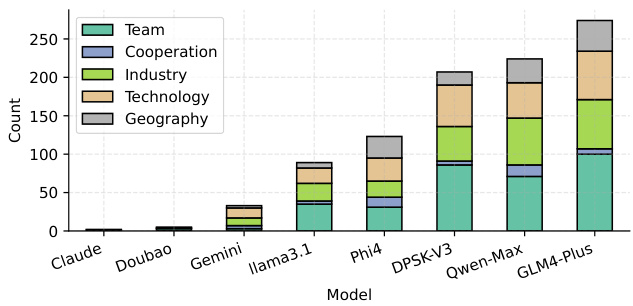

- さまざまなタイプの ID プロンプトに対する成功した攻撃の数。

- チーム, インダストリー, テクノロジー LLMの知覚の側面は攻撃を受けやすく、おそらくこれらの側面により多くの未浄化の蒸留データが存在するためであろう。

図4:さまざまなタイプのIDキューに対するICE攻撃の成功数。 モデルの略号マッピングは図3と同じ。

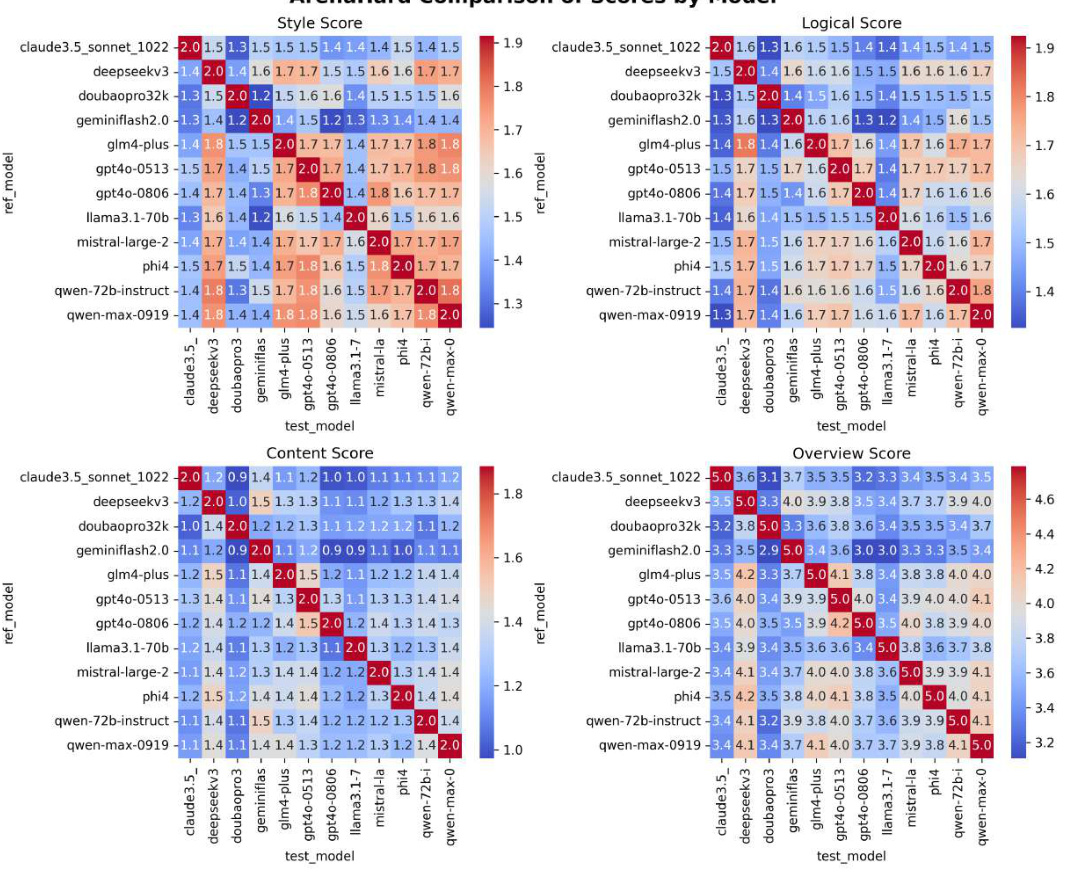

2.応答類似性評価(RSE)の結果。

- 主な調査結果

- GPTシリーズモデル(例えば、GPT4o-0513、平均類似度4.240)が最も高い反応類似度を示し、蒸留度が高いことを示した。

- ラマ3.1-70B-インストラクト(3.628)とDoubao-Pro32k(3.720) 等学年モデルの類似度が低いことは、蒸留の程度が低いことを示している。

- DeepSeek-V3 (4.102) および Qwen-Max-0919 (4.174) アイソステューデント・モデルは、GPT4o-0806と一致する、より高いレベルの蒸留を示す。

図5:RSEの結果。 行はテストされた異なるモデルを表し、列は異なるデータセット(ArenaHard、Numina、ShareGPT)を表す。 表のスコアは、各モデルとデータセットのペアのRSEスコアを表しています。 Avg "列は、各モデルの平均RSEスコアを示します。

3.その他の重要な所見

- ベースラインLLMと微調整LLM。

- ベースラインLLMは通常、教師あり微調整(SFT)LLMよりも高い蒸留レベルを示す。

- このことは、ベースラインのLLMは、おそらくタスクに特化した微調整がないために、評価で利用された抜け穴の影響を受けやすく、認識可能な蒸留パターンを示す傾向が強いことを示唆している。

- オープンソースとクローズドソースLLM。

- 実験結果によると、クローズドソースのLLM(Qwen-Max-0919など)は、オープンソースのLLM(Qwen 2.5シリーズなど)よりも蒸留度が高い。

結論

以下の2つの分野に焦点を当てる:

1. 脱獄攻撃における自己認識のパラドックスを特定する: 自己認識の観点からLLMの一貫性を評価する。

2. 複数粒度応答の類似性の分析:その LLM間の同質性の程度を測定する。

そこで明らかになったのは次のような点である:

- LLM蒸留の現状。

- ほとんどの有名なクローズドソースとオープンソースのLLMは、高い蒸留度を示している。 ジェミニ 例外だ。

- このことは、LLMの分野がある程度均質化していることを示唆している。

- 蒸留がAIの独立性に及ぼす影響。

- ベースラインLLMは、ファインチューニングLLMよりも高い蒸留レベルを示しており、これは既存のモデル知識の影響を受けやすく、独立性が十分でないことを示唆している。

- クローズドソースのLLMの高い蒸留度は、AIの独立性についての考えも引き起こす。

- 今後の方向性

- 本稿は、LLMの堅牢性と安全性を高めるため、LLM分野におけるより独立した開発と、より透明性の高い技術報告を求めるものである。

- LLMをより多様で革新的な方向に推進し、既存のモデルの知識に過度に依存することを避ける。

実験結果は、Claude、Doubao、Geminiを除いて、有名なクローズドソースおよびオープンソースのLLMのほとんどが高い蒸留レベルを示すことを示している。さらに、ベースラインLLMはファインチューニングLLMよりも高い蒸留レベルを示す。

LLMデータ蒸留の透明性を向上させるための体系的なアプローチを提供することで、本論文は、LLMの堅牢性と安全性を高めるために、LLM分野におけるより独立した開発と、より透明性の高い技術報告を呼びかける。