はじめに

このプロジェクトは、Large Language Model(LLM)とインテリジェントなウェブクローリング技術を活用し、ユーザーが自然言語記述によってカスタムAPIを作成できるように設計されたオープンソースプロジェクトです。主な機能には、自動データ構造生成、リアルタイムデータ更新、構造化データ出力、柔軟なデプロイオプションなどがあります。LLM API Engineは、Cloudflare Workers、Vercel Edge Functions、AWS Lambdaなど、複数のプラットフォームへのAPIエンドポイントのデプロイをサポートするモジュラーアーキテクチャを備えています。

機能一覧

- テキストからAPIへの変換シンプルな自然言語記述でAPIを生成。

- データ構造の自動生成OpenAI技術によるデータ構造の自動生成。

- インテリジェント・ウェブ・クローリングFirecrawl技術によるWebページデータのクローリング。

- リアルタイムのデータ更新時間指定クロールとリアルタイムデータ更新をサポート。

- 即時のAPIデプロイメントAPIエンドポイントの迅速なデプロイ。

- 構造化データ出力出力データをJSONスキーマで検証します。

- キャッシュとストレージ・アーキテクチャキャッシュとストレージにRedisを使用。

ヘルプの使用

設置プロセス

- クローン倉庫::

git clone https://github.com/developersdigest/llm-api-engine.git

cd llm-api-engine

- 依存関係のインストール::

npmインストール

- 環境変数ファイルの作成プロジェクトのルート・ディレクトリに作成

環境ファイルに以下の変数を追加する:

OPENAI_API_KEY=your_openai_key

FIRECRAWL_API_KEY=your_firecrawl_key

UPSTASH_REDIS_REST_URL=あなたの_redis_url

UPSTASH_REDIS_REST_TOKEN=あなたの_redis_token

next_public_api_route=http://localhost:3000

- 開発サーバーの実行::

npm run dev

ブラウザを開いてアクセスするhttp://localhost:3000アプリを見る

機能 操作の流れ

- APIエンドポイントの作成::

- アプリケーションのホームページにアクセスし、"Create New API "ボタンをクリックする。

- API名と説明を入力し、データソースのタイプ(例:ウェブクローリング)を選択します。

- 自然言語を使用して、必要なデータ構造とクロールルールを記述する。

- Generate API "ボタンをクリックすると、APIエンドポイントとデータ構造が自動的に生成されます。

- APIの設定と管理::

- API管理画面で、作成したAPIの一覧を表示します。

- APIをクリックすると詳細ページに移動し、API設定の編集、クロールログの表示、APIエンドポイントのテストができます。

- RedisストレージAPIを使用して構成され、いつでも変更や更新が可能です。

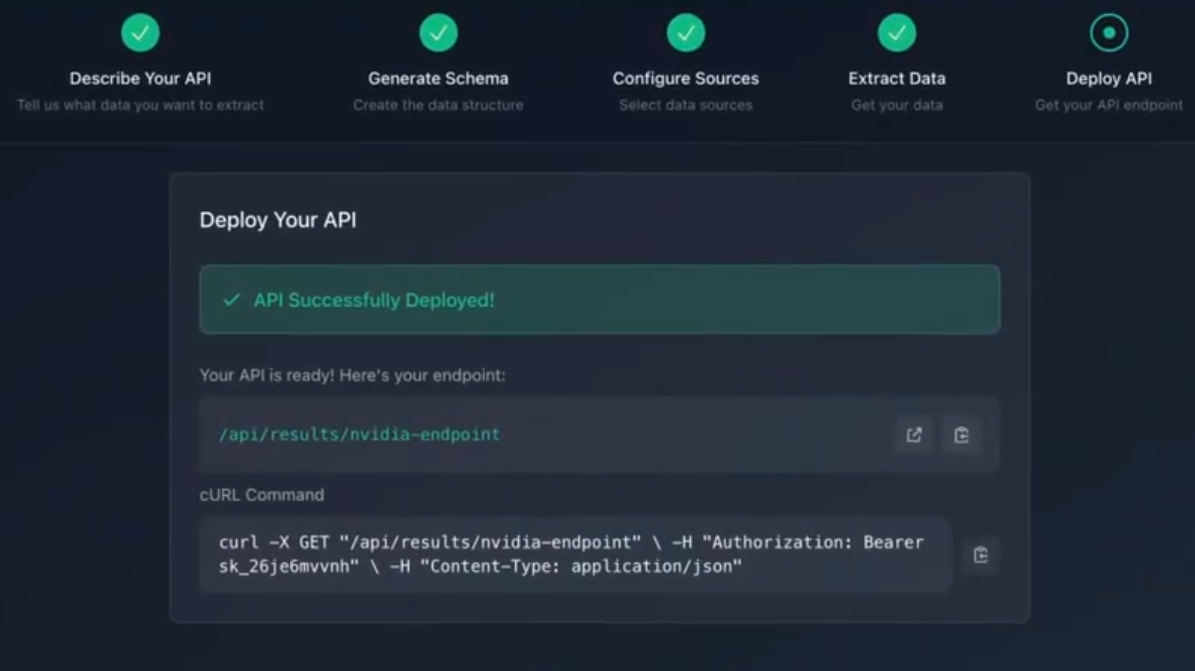

- APIエンドポイントの配置::

- デプロイメント・プラットフォームを選択する(例:Vercel、AWS Lambdaなど)。

- プラットフォーム要件に従ってデプロイパラメータを設定し、[Deploy]ボタンをクリックします。

- デプロイ完了後、「API Management」画面でAPIエンドポイントのURLとステータスを確認できます。

- APIエンドポイントの使用::

- アプリケーションでAPIエンドポイントを呼び出し、構造化データを取得する。

- JSON形式のデータを返すHTTPリクエストによるAPIエンドポイントへのアクセスをサポートします。