はじめに

Reflex LLM Examples は、大規模言語モデル(Large Language Model: LLM)の実際の使用例を示すために、Reflex 開発チームによって作成されたオープンソースプロジェクトです。このプロジェクトでは、Google、Anthropic、OpenAIなどのプロバイダーが提供する大規模言語モデルの実際の使用例を示す、Reflex上で構築されたいくつかのAIアプリケーションがまとめられています。プロジェクトのアプリケーションは、AIエージェント、RAG(Retrieval Augmented Generation)実装などをカバーし、スケーラブルなAIソリューションを構築するためのベストプラクティスを開発者に提供することを目的としています。

機能一覧

- AIエージェント様々なタスクを処理するために、大規模な言語モデルを用いて知的エージェントを構築する方法を示す。

- 検索機能拡張ジェネレーション(RAG)検索と生成を組み合わせて、生成されたコンテンツの精度と関連性を向上させる技術を可能にする。

- マルチモーダルAIエージェントテキスト、画像など複数の入力フォームの処理に対応。

- ニュースエージェントニュースコンテンツの処理と生成に特化したAIアプリケーション。

- PDFインタラクティブPDFからの情報抽出とコンテンツ生成をサポートします。

- GitHub インタラクションGitHubプラットフォームと連動してコードベースの情報を自動処理する方法を紹介します。

ヘルプの使用

設置プロセス

- クローンプロジェクトターミナルで以下のコマンドを実行し、プロジェクトをローカルにクローンする:

git clone https://github.com/reflex-dev/reflex-llm-examples.git

- プロジェクト・ディレクトリに移動する使用

cdコマンドをプロジェクト・ディレクトリに追加する:

CD reflex-llm-examples

- 依存関係のインストールPython環境がインストールされていることを確認し、以下のコマンドを実行してプロジェクトの依存関係をインストールします:

pip install -r requirements.txt

使用ガイドライン

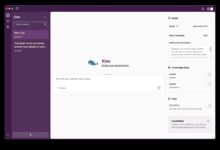

AIエージェント

- ローンチエージェントプロジェクト・ディレクトリで以下のコマンドを実行してAIエージェントを起動します:

python ai_agent.py

- エージェントの設定必要に応じて設定ファイルを修正する。

config.yaml異なるミッション要件に適応するためだ。

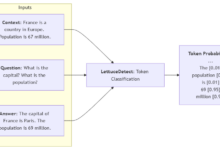

検索機能拡張ジェネレーション(RAG)

- RAGアプリケーションの起動以下のコマンドを実行し、RAGアプリケーションを起動します:

python rag_app.py

- 検索ソースの設定生成されるコンテンツの精度を高めるために、設定ファイルにデータベースやAPIなどの検索ソースを指定する。

マルチモーダルAIエージェント

- マルチモーダル・エージェントの立ち上げ以下のコマンドを実行して、マルチモーダルAIエージェントを起動する:

python multi_modal_ai_agent.py

- マルチモーダルデータの入力APIやインターフェースを通じて、テキストや画像など様々な形式でデータを入力すると、エージェントが自動的に処理し、結果を生成します。

ニュースエージェント

- ローンチ・プレス・エージェント以下のコマンドを実行してニュースエージェントを起動する:

python news_agent.py

- ニュースフィードの設定コンフィギュレーションファイルでニュースフィードを指定すると、エージェントは自動的にニュースコンテンツを取得して処理します。

PDFインタラクティブ

- PDFインタラクティブ・アプリケーションの起動以下のコマンドを実行して、PDF Interactive アプリケーションを起動します:

python chat_with_pdf_locally.py

- PDFファイルのアップロードインターフェースを介してPDFファイルをアップロードすると、アプリケーションは自動的にそこに含まれる情報を抽出して処理します。

GitHub インタラクション

- GitHub インタラクティブ・アプリケーションの起動以下のコマンドを実行して、GitHub対話型アプリケーションを起動します:

python chat_with_github.py

- GitHubリポジトリの設定設定ファイルにGitHubのリポジトリを指定すると、アプリケーションはリポジトリの情報を自動的に処理します。