はじめに

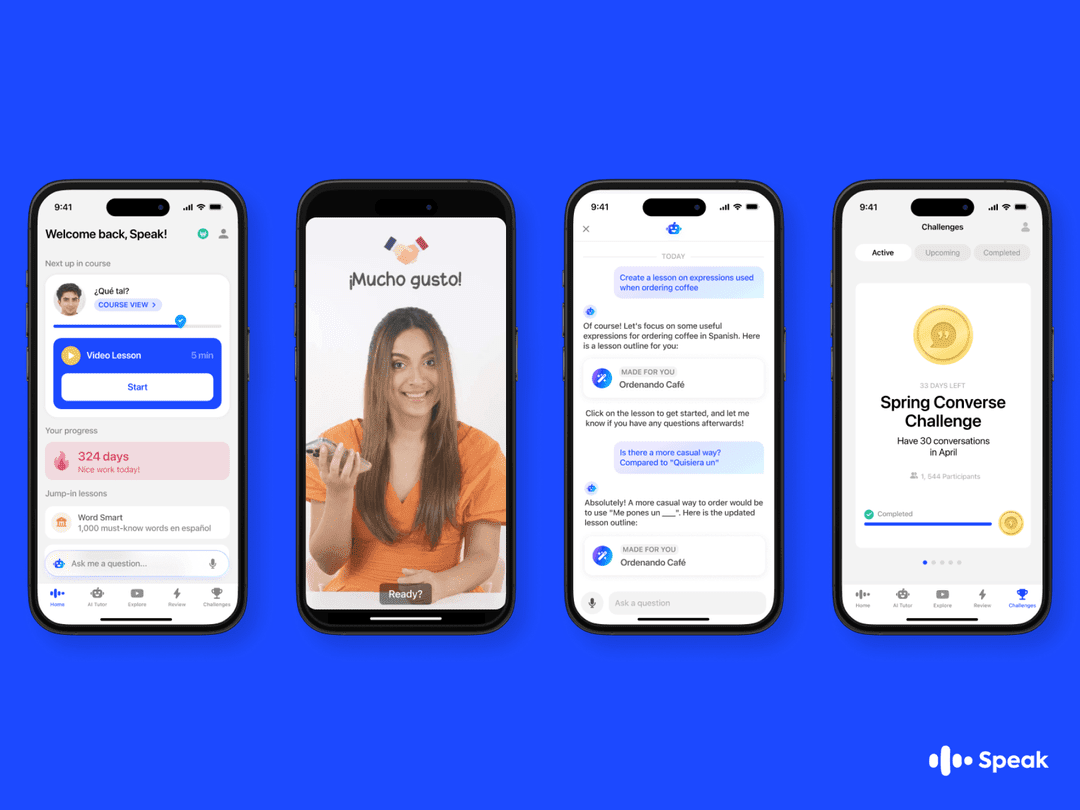

Speakは、AIとの対話を通じて英語のスピーキングスキルを向上させることを目的とした革新的なAI英語学習アプリです。最先端のAI技術を駆使したこのアプリは、パーソナライズされたレッスンとインスタントフィードバックを提供し、ユーザーが短期間で劇的に英語を上達できるようサポートします。Speakは、あらゆるレベルやニーズの学習者向けに、実写ビデオレッスン、フリートーク、AIチューターなど、さまざまな学習モードを提供しています。初心者でも経験豊富な英語学習者でも、Speakを使えば簡単に英会話の練習と上達ができます。

機能一覧

- ライブ・ビデオ・コースライブのビデオレッスンで、正しい英語の使い方や発音を学ぶことができます。

- 自由な対話いつでもどこでもAIと英会話ができ、口頭表現の練習ができます。

- AIメンターAIチューターは即座にフィードバックを提供し、文法や単語の誤りを訂正し、ユーザーがより自然な表現ができるようサポートする。

- パーソナルコース利用者の学習進度やニーズに合わせた、パーソナライズされた学習プラン。

- 状況対話日常生活、旅行、職場などを想定した様々なシナリオで、実践的な英語対話の練習ができます。

- 多言語サポートグローバルなユーザーの利便性のために、多言語インターフェースをサポートします。

ヘルプの使用

設置プロセス

- ダウンロードアプリAndroid App StoreまたはApple App Storeで "Speak "を検索し、アプリをダウンロードしてください。

- アカウント登録アプリを開き、Eメールやソーシャルメディアのアカウントを使って新規ユーザーを登録します。

- 学習開始登録が完了したら、自分に合ったコースを選んで英語学習の旅を始めましょう。

使用ガイドライン

- ライブ・ビデオ・コース::

- コースの選択:コース一覧から自分のレベルに合ったコースを選びます。

- 従って学ぶ:ビデオレッスンを見て、先生の説明に従って練習する。

- 復習と定着:コース終了後、学んだことを定着させるために繰り返しビデオを見ることができます。

- 自由な対話::

- 対話の開始:「フリー対話」機能をクリックし、対話のトピックまたはシナリオを選択します。

- 対話する:AIと対話し、口頭表現を練習する。

- フィードバックを得る:対話の後、AIがフィードバックを提供し、文法や発音の誤りを指摘し、改善のための提案をします。

- AIメンター::

- 質問する:ダイアログボックスに質問やヘルプを入力すると、AIチューターが即座に回答します。

- 文法訂正:AIメンターがユーザーの文法や単語の誤りを自動的に訂正し、より自然な表現をサポートします。

- 個人に合わせたアドバイス:ユーザーの学習進捗状況に基づいて、AIチューターが個人に合わせた学習アドバイスと練習計画を提供します。

- 状況対話::

- シナリオの選択:日常生活、旅行、職場など、シナリオ・ダイアログのリストから関心のあるシナリオを選択する。

- ロールプレイ:シナリオの指示に基づき、AIとの対話をロールプレイする。

- 実践演習:実際のシナリオを想定した実践的な演習を行い、実践力を高める。

- パーソナルコース::

- ラーニング・アセスメント:初回アセスメント・テストを行い、あなたの英語レベルを確認します。

- カスタマイズされたコース:評価結果に基づいて、システムは適切なコースと学習プランを推薦する。

- 継続的なフォローアップ:学習の進捗状況に応じて、学習効果が最大になるよう、システムが常にコース内容を調整します。

一般的な問題

- アカウントにログインできないパスワードをお忘れの方は、「パスワードをお忘れの方」をクリックしてください。それでも問題が解決しない場合は、カスタマーサポートチーム(support@usespeak.com)までご連絡ください。

- コースの最新情報Speakは定期的にコース内容を更新しており、ユーザーはアプリ内で最新のコースを閲覧することができます。

- マルチデバイス対応SpeakはiOSとAndroidデバイスをサポートしており、ユーザーはデバイス間で学習の進捗状況を同期させることができます。