はじめに

Pieces-OSは、Pieces-OSのGRPCストリームを逆変換し、標準的なOpenAI APIインターフェースに変換することを目的としたオープンソースプロジェクトです。このプロジェクトはNekohyによって開発され、学習とコミュニケーションのためにGPL-3.0でオープンソース化されています。このプロジェクトは様々なモデルの互換性を提供し、Vercelのワンクリックデプロイメントをサポートしています。

逆方向 個 クロード、GPT、ジェミニモデルをサポートするAPIインターフェースの1分無料デプロイメント。提供碁バージョン.

機能一覧

- GRPCフロー反転Pieces-OSのGRPCストリームを標準のOpenAIインターフェイスに変換します。

- マルチモデル対応互換性がある クロード シリーズ、GPTシリーズ、Geminiシリーズ、その他多くのモデル。

- ワンクリック配備サポート Vercelプラットフォームのワンクリック展開これは、ユーザーにとって素早く構築しやすいものだ。

- クラウドモデルの構成クラウドモデルのプロファイルを提供することで、ユーザーは必要に応じてさまざまなモデルを抽出して使用することができます。

- APIリクエスト管理環境変数を設定することで、APIリクエストのプレフィックスパス、キー、リトライなどを管理できる。

ヘルプの使用

設置プロセス

- クローンプロジェクト使用

ギットクローンコマンドでプロジェクトをローカルにクローンする。git clone https://github.com/Nekohy/pieces-os.git - 依存関係のインストールプロジェクト・ディレクトリに移動し

package.jsonで定義されている依存ライブラリ。cd pieces-os npm install - トリガ手順実施

ノードindex.js手続きを開始する。ノードindex.js

使用プロセス

- モデル一覧の取得以下のコマンドで利用可能なモデルのリストを取得します。

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - リクエストを送信次のコマンドを使ってチャットリクエストを送信してください。

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{. 「メッセージ": [ { "role": "user", "content": [ { "content": "Hello! } ], "model": "gpt-4o"、 「stream": true }'

環境変数の設定

- API_PREFIXAPIリクエストのプレフィックスパス。

'/'. - API_KEYデフォルトは空文字列です。

- 最大リトライ回数最大リトライ回数。

3. - RETRY_DELAYリトライ遅延時間をミリ秒単位で指定します。

5000(5秒)。 - 港サービスがリッスンするポート。

8787.

モデル構成

このプロジェクトは、複数のモデルのプロファイルを提供する。 cloud_model.jsonユーザーは必要に応じて様々なモデルを抽出して使用することができる。例えば

- クロード・シリーズ::

claude-3-5-sonnet@20240620そしてclaude-3-haiku@20240307その他 - GPTシリーズ::

gpt-3.5-ターボそしてグプトフォーそしてgpt-4-ターボその他 - ジェミニ・シリーズ::

ジェミニ-1.5-フラッシュそしてジェミニ-1.5-プロその他

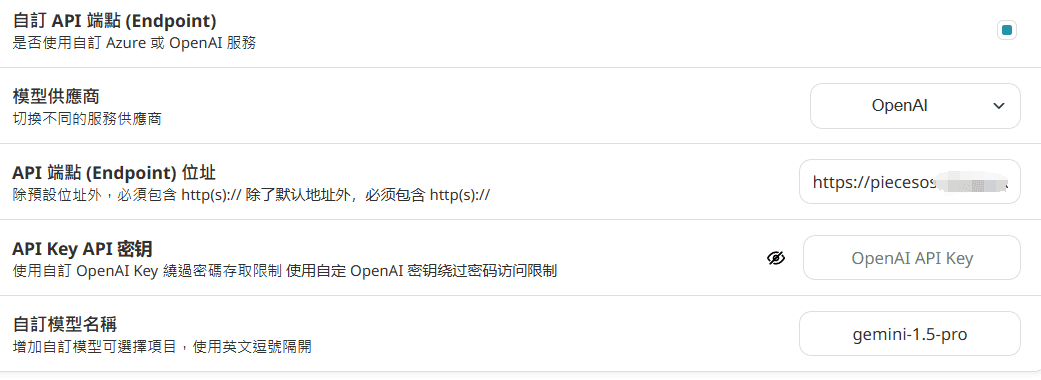

配備後の使い方

nextchatで設定:

ドメイン名を直接入力し、URLの後に追加しないでください。/v1/モデル そして /v1/chat/completions

API_KEYがVercelで設定されていない場合、入力は必要ない。

没入型翻訳での設定: (同時実行の問題があるため、推奨されません)

https://你的域名/v1/chat/completions

apikeyが設定されていない場合は、空欄を埋めてください。