2025年1月30日、マイクロソフトは、ディープシークのR1モデルが、同社のクラウド・コンピューティング・プラットフォームAzureと、開発者向けのGitHubツール全般で利用可能になったと発表した。マイクロソフトはまた、顧客は間もなくDeepSeekのR1モデルを自社の コパイロット + R1モデルをPC上でローカルに実行する。

先に述べたように、コパイロットはOpenAI以外の大きなモデルも徐々に使用していく:

最近、マイクロソフトのニュースが多くなっている。GitHubのコパイロットはフリーでオープンだ!しかし、少なくとも画期的な出来事であり、モデルも当初のGPT4oからo1へと拡大された。 クロード 歌で応える ジェミニ その他多くのモデルがある。

これは、マイクロソフトがOpenAIテクノロジーへの依存から脱却しつつあることを意味する。

最近の結果 ディープシーク 世界でより強力な影響力は、人目を引く新機能のシリーズは、オンラインに来るだけでなく、AIの分野で中国と米国の間の生と死の競争を引き起こし、マイクロソフトでは、中国語のためのより良いサポートcopilotを作るために、copilotでdeepseekのR1モデルを使用する準備が整いました。

マイクロソフトのインディアンCEOはまた、DeepSeek R1モデルがマイクロソフトのAIプラットフォームAzure AI FoundryとGitHubを通じて利用可能になり、まもなくCopilot+コンピュータで実行されるようになることを電話会議で強調した。ナデラ氏は、DeepSeekには「いくつかの真のイノベーションがある」と述べ、AIのコストは低下傾向にあるとした。「スケーリングの法則は、事前学習と推論時間の計算で構築されている。ここ数年で、AIのトレーニングと推論の効率が大幅に向上しています。推論側では、通常、ハードウェアの世代あたり価格/性能で2倍以上、モデルの世代あたり価格/性能で10倍以上の改善が見られます。"

それは嬉しいことだ。

copilot for Microsoft 365は、office 365(word、excel、ppt、OneNote、teamsなど)用のネイティブのcopilotプラグインで、wordで他のファイルに基づいてコンテンツを生成したり、excelで数式や計算を生成したり、PPTで他のファイルに基づいてプレゼンテーションを作成したりできます。また、PPTで他のドキュメントからプレゼンテーションを作成したり、OneNoteでノートを整理してさらにノートを生成したり、チームでミーティングを要約したり、他にもいろいろできます。

関連記事1:「蒸留に最適化されたDeepSeek R1モデルをCopilot+ PCでローカルに実行する

AIはエッジへと移行しており、Copilot+ PCがその道をリードしている。Azure AI Foundryがクラウドホスト型のDeepSeek R1(関連記事2)を稼働させるのに伴い、当社はDeepSeek-R1のNPU最適化バージョンをCopilot+ PCに直接提供し、最初の適応をQualcomm Snapdragon Xプラットフォーム向けに行い、その後Intel Core Ultra 200Vなどのプラットフォームをサポートする予定です。DeepSeek-R1-Distill-Qwen-1.5Bの最初のリリースはAI Toolkitで利用可能で、バージョン7Bと14Bがそれに続く。これらの最適化されたモデルにより、開発者はCopilot+ PCのNPUのパワーを最大限に活用して、デバイス上で効率的に動作するAIアプリケーションを構築し、展開することができる。

Copilot+ PCのニューラル・プロセッシング・ユニット(NPU)は、モデル推論のための非常に効率的なエンジンを提供し、オンデマンドで実行されるだけでなく、半継続的に実行されるサービスを可能にする生成AIの新しいパラダイムを切り開きます。これにより、開発者は強力な推論エンジンを備えたプロアクティブな継続的体験を構築することができます。Phi Silicaプロジェクトからの技術の蓄積を通じて、私たちは効率的な推論を実現しました。バッテリ寿命とシステムリソースの消費を最小限に抑えながら、競争力のあるファースト・トークンの応答時間とスループット率を確保します。NPUに最適化されたDeepSeekモデルには、パフォーマンスと効率の最適なバランスを実現するためのモデルモジュラー設計、低ビット幅の定量化技術、NPU上でのTransformerのマッピング戦略など、プロジェクトで採用された多くの主要技術が使用されています。さらに、Windows Copilot Runtime (WCR)を活用し、ONNX QDQフォーマットを介してWindowsエコシステム全体でのスケーリングを可能にしています。

今すぐ体験しよう!

まずは...さっそく始めよう。

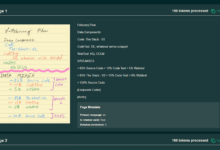

Copilot+のPCでDeepSeekを体験するには、AI Toolkit用のVS Code拡張機能をダウンロードするだけです。 ONNX QDQ形式の最適化されたDeepSeekモデルは、まもなくAI Toolkitのモデルリポジトリで利用できるようになり、Azure AI Foundryから直接取得できるようになります。ダウンロード」ボタンをクリックしてローカルにダウンロードしてください。ダウンロードしたら、Playgroundを開き、"deepseek_r1_1_5 "モデルをロードし、プロンプトで実験を開始します。

Copilot+ PC用に最適化されたONNXモデルに加えて、"ディープシークR1「トライ・イン」。 遊び場「ボタンをクリックすると、Azure Foundryのクラウドでホストされたオリジナルモデルを体験できます。

AI Toolkitは、モデルの実験とデプロイの準備をサポートする、開発者のワークフローの重要な部分です。このPlaygroundを使用すると、ローカル展開のためにAzure AI FoundryでDeepSeekモデルを簡単にテストできます。

チップレベルの最適化

蒸留に最適化されたQwen 1.5Bモデルには、トーケナイザー、エンベッディングレイヤー、コンテキスト処理モデル、トークン反復モデル、言語モデルヘッダー、デトケナイザーモジュールが含まれる。

埋め込み層と言語モデルヘッダには4ビットのチャンク量子化を使用し、これらのメモリ集約的な処理をCPUで実行する。主なNPU最適化リソースを、コンテキスト処理とトークン反復を含む計算集約的なTransformerモジュールに集中させ、int4チャンネルごとの量子化を使用し、重みには選択的な混合精度処理を実装し、活性化値にはint16精度を使用する。

DeepSeek がリリースした Qwen 1.5B には int4 バージョンがありますが、動的な入力形状と動作が存在するため、NPU に直接適応することはできません。さらに、我々はONNX QDQフォーマットは、Windowsエコシステムにおける様々なタイプのNPUのスケーリングをサポートします。CPUとNPU間の演算子レイアウトを最適化し、消費電力と速度の最適なバランスを実現します。

低メモリフットプリントと高速推論(Phi Silicaスキームと同様)という2つの目標を達成するために、我々は2つの重要な改良を行った。1つ目は、スライディングウィンドウ設計を採用し、ハードウェアスタックがダイナミックテンソルをサポートしていない場合でも、超高速ファーストトーケン応答時間とロングコンテキストのサポートを可能にした。QuaRotは、ハダマード回転により重みと活性化値の異常値を除去し、モデルを定量化しやすくする。GPTQのような既存の手法と比較して、QuaRotは、特にチャンネルごとの定量化のような低粒度シナリオにおいて、定量化精度を大幅に向上させる。低ビット幅量子化とスライディングウィンドウ設計などのハードウェア最適化の組み合わせにより、コンパクトなメモリフットプリントで大規模モデルの動作特性を実現することができます。これらの最適化の結果、このモデルは、短いキュー(64トークン未満)シナリオにおいて、最初のトークン応答時間130ミリ秒、スループットレート16トークン/秒を達成した。

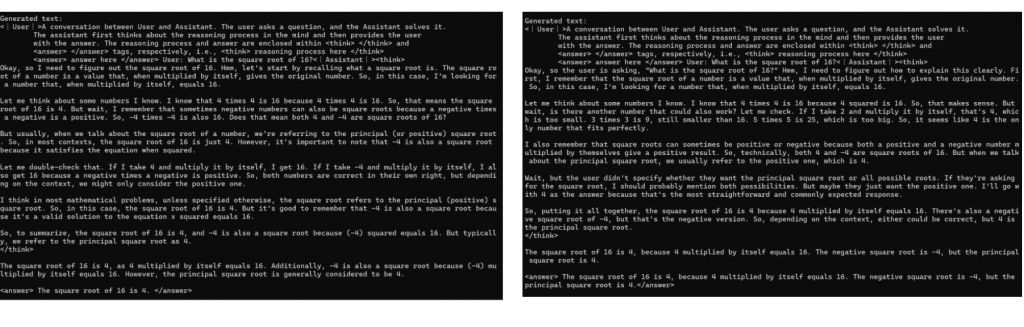

以下の例で、元のモデルのレスポンスと定量的なモデルのレスポンスの微妙な違いを示します。これは、高いパフォーマンスを維持しながらエネルギー効率の最適化を実現するものです:

図1:定性的な比較。オリジナルモデル(左)とNPU最適化モデル(右)が同じキューに反応した例。最適化モデルはオリジナルモデルの推論パターンを維持し、同じ結論に到達しており、オリジナルモデルの推論力をそのまま保持していることがわかる。

NPUに最適化されたDeepSeek R1モデルの優れたスピードとエネルギー効率性能により、ユーザーはこれらの画期的なモデルをローカルで完全に自律的に操作できるようになる。

関連記事2:「DeepSeek R1がAzure AI FoundryとGitHubで利用可能になった

DeepSeek R1がリリース Azure AIファウンドリ とGitHubのモデルカタログに掲載され、最先端、オープンソース、業界固有、タスク指向のAIモデルを網羅する1,800を超えるモデルの多様なポートフォリオに加わりました。Azure AI Foundryの一部として、DeepSeek R1は、SLA、セキュリティ、および責任あるAIの約束を満たしながら、組織が高度なAI技術をシームレスに統合することを可能にする、信頼性が高く、スケーラブルで、エンタープライズ対応のプラットフォームを通じてアクセスできます。マイクロソフトの信頼性と革新性に裏打ちされたものです。

Azure AI Foundry開発者のためのAI推論の高速化

AIの推論は驚くべき速さで人気を集めており、開発者や企業が最先端のインテリジェンスを適用する方法を変えています。DeepSeekが説明するように、R1は、より多くのユーザーが最小限のインフラ投資で最先端のAI機能にアクセスできるようにする、強力で費用対効果の高いモデルを提供します。

Azure AI FoundryでDeepSeek R1やその他のモデルを使用する主な利点は、開発者が実験、反復、およびAIをワークフローに統合できるスピードです。組み込みのモデル評価ツールにより、開発者は出力をすばやく比較し、性能ベンチマークを評価し、AI駆動型アプリケーションを拡張することができます。ほんの数カ月前には想像もできなかったこの迅速なアクセスは、Azure AI Foundryのビジョンの中核をなすものです:最高のAIモデルを1つの場所に集め、イノベーションを加速し、世界中の組織の新たな可能性を解き放つことです。

信頼できるAIを使った開発

deepSeek R1は、モデルの動作の自動評価や潜在的なリスクを軽減するための包括的なセキュリティレビューを含む、厳格な「レッドチームテスト」とセキュリティ評価に合格しています。組み込みのコンテンツフィルタリングはデフォルトで有効になっており、Azure AI Content Securityを通じて柔軟なオプトアウトオプションを利用できる。さらに、セキュリティ評価システムは、顧客がデプロイ前にアプリケーションを効率的にテストするのに役立つ。これらの保護措置により、Azure AI Foundryは、AIソリューションをデプロイするためのセキュアでコンプライアンスに準拠した責任ある環境を組織に提供することができます。

モデルカタログでのDeepSeekの使用方法

- Azureのサブスクリプションをお持ちでない場合は、以下のことが可能です。Azureアカウントの登録

- モデルカタログでDeepSeek R1を検索

- Azure AI Foundryのモデルカタログでモデルカードを開く。

- Deploy "をクリックして推論APIとキーを取得し、テストベッドにアクセスする。

- 1分以内にAPIとキーを表示するデプロイメントページに移動し、テストベッドでプロンプトの入力を試すことができます。

- APIとキーは、さまざまなクライアントで使用できる。

今すぐ始める

DeepSeek R1は、Azure AI Foundryモデルカタログのサーバーレスエンドポイントからアクセスできるようになりました。今すぐAzure AI Foundryにアクセス を選択し、DeepSeekモデルを選択します。

GitHub で、より多くのリソースを検索し、DeepSeek R1 をアプリケーションにシームレスに統合するためのステップバイステップのガイドを入手してください。読む GitHubモデル ブログ記事

近日中に、DeepSeek R1のライトモデルを使用して、Copilot+ PC上でローカルに実行できるようになります。続きを読む ウィンドウズ開発者 ブログ記事

Azure AI Foundryのモデルカタログの拡充を続ける中で、開発者や企業がDeepSeek R1をどのように使用して現実世界の課題に対処し、変革的な体験を生み出すかを目の当たりにできることを楽しみにしています。私たちは、あらゆる規模の組織がイノベーションと成功を推進するための最先端のツールにアクセスできるよう、AIモデルの最も包括的なポートフォリオを提供することをお約束します。