ディープシーク、統合マルチモーダル理解と生成モデルをリリース:JanusFlowからJanus-Proへ

ヤヌスフロー速読

ディープシーク チームはまた新しいモデルをリリースし、28日未明に革新的なマルチモーダルフレームワークであるJanus-Proを発表した。このモデルは、マルチモーダル理解と生成タスクを同時に処理できる統一モデルである。DeepSeek-LLM-1.5b-base/DeepSeek-LLM-7b-baseをベースに構築されたこのモデルは、384 x 384の画像入力をサポートし、画像生成には専用のトークナイザーを使用する。最も重要な特徴は、視覚的なエンコードを別々のチャンネルに分割することです。 変流器 処理のためのアーキテクチャ。

この革新的な設計は、視覚エンコーダにおける従来のモデルの相反する役割の問題を解決するだけでなく、システム全体をより柔軟にします。実際、Janus-Proはこれまでの統一モデルを凌駕し、タスクによってはタスクベースの専用モデルに匹敵する。GenEvalとDPG-Benchベンチマークでは、OpenAIのDALL-E 3とStable Diffusionを上回った。

に始まるヤヌス・モデル・シリーズ。 ヤヌスフローを目指している。マルチモーダル理解と生成のための統一されたフレームワーク自己回帰言語モデル(LLM)と整流フロー生成モデルの組み合わせが核となる。中核となるアイデアは、自己回帰言語モデル(LLM)と整流フロー生成モデルを組み合わせることであり、単一のモデル内で優れた視覚的理解と高品質な画像生成能力の両方を達成することを目指している。ヤヌス・プロ Janusの上級バージョンとして、Janusモデルの性能は、学習戦略、データサイズ、モデル次元の包括的な最適化によってさらに改善され、いくつかのベンチマークテストで大きな進歩を達成している。本論文では、JanusFlowからJanus-ProへのJanusモデルの進化を、その機能性、パラメータ特性、および主要な改良点に焦点を当てて体系的にレビューする。

1.JanusFlow:統一アーキテクチャの礎石

ペーパーアドレス:: https://arxiv.org/pdf/2411.07975

ヤヌスフロー 核となる革新性はミニマリスト・ユニファイド・アーキテクチャーLLMの構造に複雑な変更を加えることなく、修正されたフロー生成モデルを自己回帰LLMフレームワークにシームレスに統合する。このアーキテクチャの主な特徴は以下の通りである:

- ストリーミング画像の生成を修正: JanusFlowは画像生成に修正されたフローモデルを利用し、ガウスノイズから開始し、画像の潜在空間表現を更新するために速度ベクトルを反復的に予測し、最終的にデコーダを通して高品質な画像を生成する。このアプローチは、LLMが条件生成器としてのみ機能し、直接生成機能を持たない従来の手法の限界を回避する。

- 分離型ビジュアルエンコーダー: 統一モデルのパフォーマンスを最適化するために、JanusFlowはデカップリング・エンコーダー戦略では、理解タスクと生成タスクをそれぞれ別の視覚コーダーで処理する:

- エンコーダー(fenc)を理解する: 事前に訓練された シグリップ・ラージ・パッチ/16 このモデルは、マルチモーダルな理解を高めるために、画像の意味的特徴を抽出する役割を担っている。

- エンコーダー(genc)とデコーダー(gdec)を生成する: スクラッチトレーニング ConvNeXt 生成品質を最適化する画像生成タスク専用のモジュール。

- 表現整列メカニズム: 統一トレーニングの過程で、JanusFlowは以下を導入する。文字揃え生成モジュールと理解モジュールの中間表現を整列させるメカニズムにより、生成プロセスにおける意味的一貫性と一貫性が強化される。

- 3段階のトレーニング戦略: JanusFlowは、きめ細かい3段階のトレーニングプログラムを設計した:

- ステージ1:ランダム初期化 コンポーネントの適応 - 線形層、ジェネレーター・エンコーダーとデコーダーは、後続のトレーニングの初期化段階として、事前にトレーニングされたLLMとSigLIPエンコーダーで動作するようにトレーニングされる。

- 第2段階:事前トレーニングの調和 - 視覚エンコーダーを除くモデル全体を訓練し、マルチモーダル理解、画像生成、プレーンテキストデータを融合させ、モデルの統一能力を最初に確立する。

- ステージ3:モニタリングの微調整 - コマンドの微調整データは、ユーザーコマンドに対する応答を改善するためにモデルをさらに訓練するために使用され、この段階でSigLIPエンコーダのパラメータの凍結を解除する。

パラメータ特性:

- ファウンデーションLLM: 1.3Bのパラメータを持つ軽量LLMアーキテクチャ。

- ビジュアル・エンコーダ: SigLIP-Large-Patch/16(理解)、ConvNeXt(エンコーダーとデコーダーの生成)。

- 画像の解像度: 384×384ピクセル。

パフォーマンス JanusFlowは、テキストから画像への生成とマルチモーダル理解タスクの両方で大きな性能を達成し、多くの専門家モデルを凌駕し、その統一アーキテクチャの有効性を証明している。

2.ヤヌス・プロ:データ、モデル、戦略の完全アップグレード

ペーパーアドレス:: https://github.com/deepseek-ai/Janus/blob/main/janus_pro_tech_report.pdf

ヤヌス・プロ Janusの改良版として、JanusFlowは主に3つの分野でアップグレードされた:

- 最適化されたトレーニング戦略: Janus-ProはJanusFlowの3段階のトレーニング戦略を微調整し、トレーニング効率とパフォーマンスのボトルネックに対処することを目的としている:

- ステージ1:拡張ImageNetデータセットのトレーニング - ImageNetデータセットの学習ステップ数を増やすことで、モデルはピクセルの依存関係をより完全に学習し、画像生成の基礎能力を向上させることができる。

- 第2段階:テキストから画像へのデータ・トレーニングに重点を置く - ステージ2の学習では、ImageNetのデータを削除し、通常のテキストから画像へのデータセットを直接使用することで、より効率的に、高密度なテキスト記述に基づいて高品質な画像を生成する学習を行うことができる。

- ステージ3:データのスケーリング - 教師付き微調整フェーズでは、視覚生成能力を確保しつつ、マルチモーダル理解性能をさらに向上させるために、マルチモーダル理解データ、プレーンテキストデータ、テキスト対画像データの比率を微調整した(7:3:10から5:1:4へ)。

- 拡張トレーニングデータ: Janus-Proは、学習データのサイズと多様性を劇的に拡張し、モデルの汎化能力と生成品質を向上させます:

- データのマルチモーダルな理解: ステージ2の事前学習段階では、約9,000万の新しいサンプルが追加され、より幅広い画像キャプションデータ(例:YFCC)や表、グラフ、文書理解データ(例:Docmatix)がカバーされた。第3段階の微調整では、さらなるサンプルが導入される。 ディープシーク-VL2 データセットだけでなく、MEME理解、中国語対話データなど、モデルの対話能力とマルチタスク能力を大幅に向上させる。

- 視覚的に生成されたデータ: 生成画像の美的品質と安定性を向上させるため、Janus-Proは約7,200万件の高品質な合成美的データを導入し、実データと合成データの比率を1:1に調整しています。実験によると、合成データの追加によりモデルの収束が加速し、生成画像の美的品質と安定性が大幅に向上しています。

- 拡張モデルサイズ: Janus-Proは、JanusFlowの1.5Bパラメトリック・モデルを継承しているだけでなく、さらに拡張され、次のような機能を備えています。 7Bパラメータそして 1.5Bと7BのJanus-Proシリーズ。実験結果は、より大規模なLLMがモデルの性能を大幅に改善し、収束速度を加速できることを示している。実験結果は、より大規模なLLMがモデルの性能を大幅に改善し、収束速度を加速できることを示しており、Janusモデルアーキテクチャのスケーラビリティを検証している。

パラメータ特性:

- モデル寸法: サイズは1.5Bと7Bがある。

- 建築: JanusFlowの非連結ビジュアルコーダーアーキテクチャに従う。

- トレーニングデータ: マルチモーダル理解とビジュアル生成のためのトレーニングデータを大幅に拡張・最適化。

- 画像の解像度: 実験に使われた画像解像度は384×384ピクセルのままだった。

パフォーマンス Janus-Proは、すべてのベンチマークで大幅な性能向上を達成し、データ、モデル、ストラテジーのアップグレードの有効性を実証しました。特に、マルチモーダル理解ベンチマークMMBenchとテキストから画像への生成ベンチマークGenEvalとDPG-Benchでは、JanusFlowや他の先進的な統一モデルや特殊モデルを上回りました。

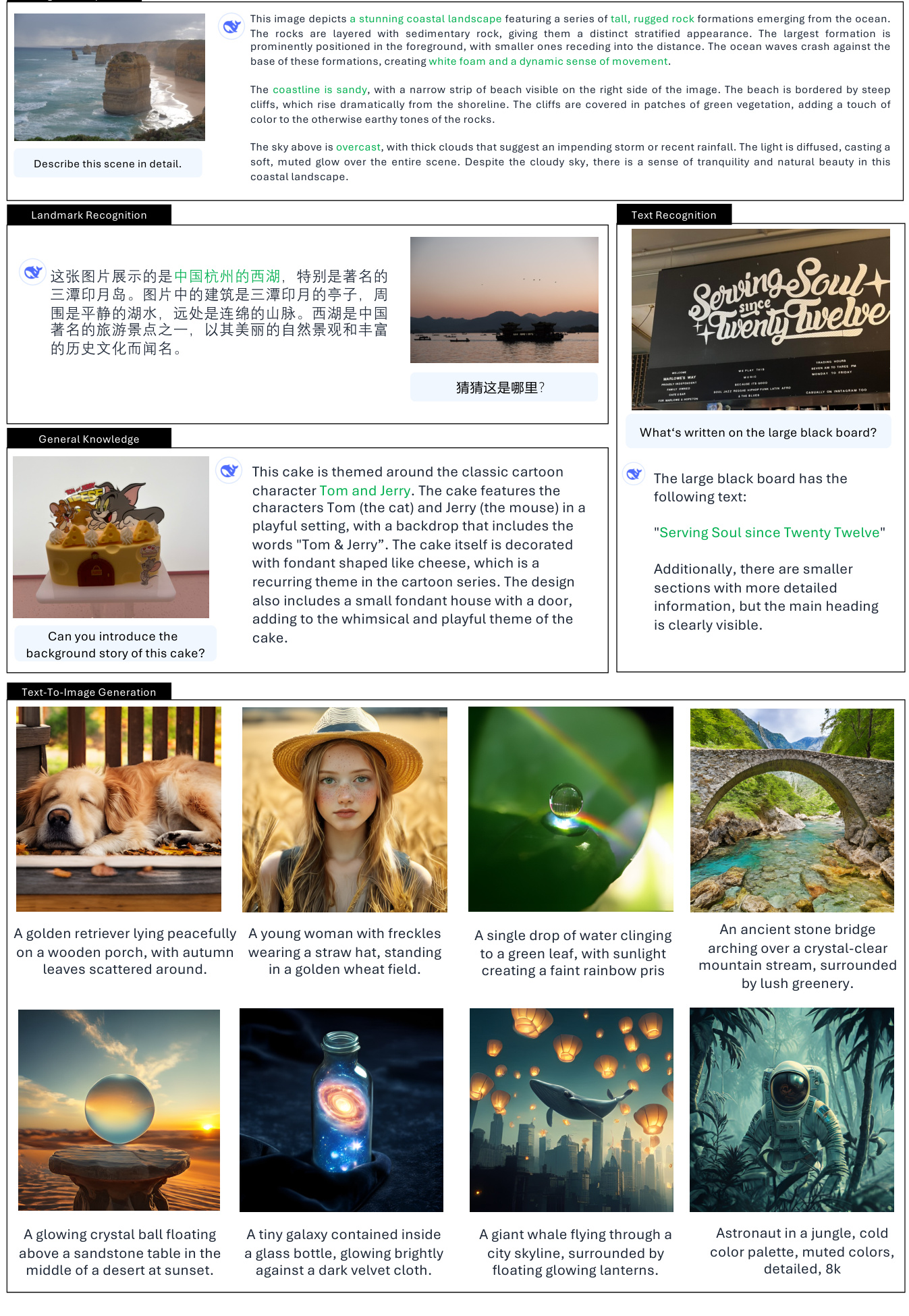

3.ヤヌスの実際の使用シナリオ

視覚的理解機能:

- 画像の説明/キャプション

- 詳細なシーン説明:シーン要素、オブジェクト、環境雰囲気など、画像コンテンツに基づいて詳細なテキスト説明を生成することができます(例:西湖の3つのプール、海辺の風景などの説明)。(例:西湖の三つの池、海辺の風景などの説明)

- グラフの説明:棒グラフのデータ表現や傾向分析など、グラフやチャート上の情報を理解し説明できる。(例:「子供の好きな果物」棒グラフの解釈)

- 物体認識/分類。

- 画像に写っている物体の種類を識別する:画像に写っている物体のカテゴリーを識別し、挙げることができる。(例:写真に写っている果物の種類を特定する。)

- オブジェクトのカウント。

- 画像内のオブジェクトの数を正確に数える:画像内の特定のオブジェクトの数を正確に数える能力。(例:画像内のペンギンの数を数える)

- ランドマーク認定

- 画像に写っている有名なランドマークを特定する:画像に写っているランドマークや場所を特定できる。(例:西湖の3つの池を特定する)

- テキスト認識/OCR。

- 画像内のテキストを認識する:画像内のテキストを認識し、テキスト情報を抽出することができる。(例:黒板に書かれた「Serving Soul since Twenty Twelve」を認識する。)

- ビジュアル質問応答。

- 画像の内容から質問に答える:画像の内容を理解し、ユーザーの質問に対して適切な答えを返すことができる。(例:画像に対して「この写真に写っている果物は何ですか?」と質問する)

- 視覚的推論/知識の統合。

- イメージの背後にある意味や連想を理解する。(例:モナリザの犬の絵のユーモアを説明する、アニメをテーマにしたケーキの背景を理解する)。

- コード生成(プロット用Python)。

- ユーザーコマンドに基づいたコードの生成:チャート作成に対するユーザーの要求を理解し、それに応じてPythonコードを生成する。(例:棒グラフを描くためのPythonコードを生成する)

テキストから画像への変換機能:

- テキストガイド付き画像生成。

- テキスト説明に基づいて画像を生成:ユーザーが入力したテキストプロンプトに基づいて、意味的に関連する画像を生成することができます。

- 創造的なイメージの生成:抽象的で想像力豊かなテキストプロンプトを理解し、創造的で芸術的なイメージを生成する能力。(例:空飛ぶクジラ、宇宙星雲コーギーなど)

- スタイル画像生成:テキストプロンプトのスタイル説明に基づいて、特定の芸術的スタイルの画像を生成します。(例:ルネッサンス様式の教会、中国水墨画風の山村など)。

- 画像上の簡単なテキスト生成:簡単なテキスト要素を持つ画像を生成する機能。(例:黒板に「こんにちは」と書く)

実用的な応用シナリオの例:

- インテリジェントアシスタント:ユーザーがアップロードした画像を理解し、Q&A、説明、分析などを行うマルチモーダルインテリジェントアシスタントとして機能する。

- コンテンツ制作:ソーシャルメディアグラフィックや記事イラストなど、コンテンツ制作者が高品質な画像素材を素早く作成できるようサポート。

- 教育用途:画像認識の教育、図の解釈の教育などに使用され、生徒の視覚情報の理解を助ける。

- 情報検索:画像検索とテキスト理解・生成機能を組み合わせることで、より豊かな検索結果を提供します。

- 芸術的創造:創造的なツールとして、アーティストがイメージを創造し、新しい視覚表現を探求することを支援する。

注意すべきパラメータの特性と制限:

- 画像解像度の限界:現在のモデルのトレーニングとテストは、主に384x384解像度の画像に基づいているため、より高い解像度を必要とするシナリオでは限界があるかもしれない。

- 細部の精緻さ:画像は意味的に豊かであるが、ビジョン・トークナイザーの解像度と再構成ロスのため、細部の精緻さにはまだ改善の余地があるかもしれない。

4.総括と展望

JanusFlowからJanus-Proに至るJanusモデルファミリーは、統一されたマルチモーダル理解と生成の分野における継続的なブレークスルーの可能性を示しています。JanusFlowは統一されたアーキテクチャーの基礎を築き、Janus-Proはトレーニング戦略の最適化、データのスケールアップ、モデルサイズのアップグレードを通じて、パフォーマンスの飛躍的な向上を達成しました。Janus-Proの成功は次のことを実証している。統一モデルのパフォーマンスを向上させる鍵は、データドリブンとモデル拡張にあるヤヌスモデルファミリーの進化は、マルチモーダルモデルの進歩を推し進めるだけでなく、より多機能でインテリジェントなAIシステムを構築するための強固な基盤を築く。

論文全文 "Janus-Pro: データとモデルの拡張が可能にする、統一されたマルチモーダル理解と生成モデル

著者陳小康、呉志宇、劉星超、潘志正、劉文、謝振達、余興凱、阮崇

プロジェクトページhttps://github.com/deepseek-ai/Janus

抄録

本論文では、従来のJanusモデルの改良版であるJanus-Proを紹介する。具体的には、Janus-Proは、(1)最適化された学習戦略、(2)拡張された学習データ、(3)より大きなモデルサイズへのスケーリングを統合している。これらの改良により、Janus-Proは、テキスト生成画像の安定性を向上させながら、テキスト生成画像のマルチモーダル理解とコマンド追従能力を大幅に向上させた。この研究が、この分野のさらなる探求を刺激することを期待している。コードとモデルは公開されている。

1.はじめに

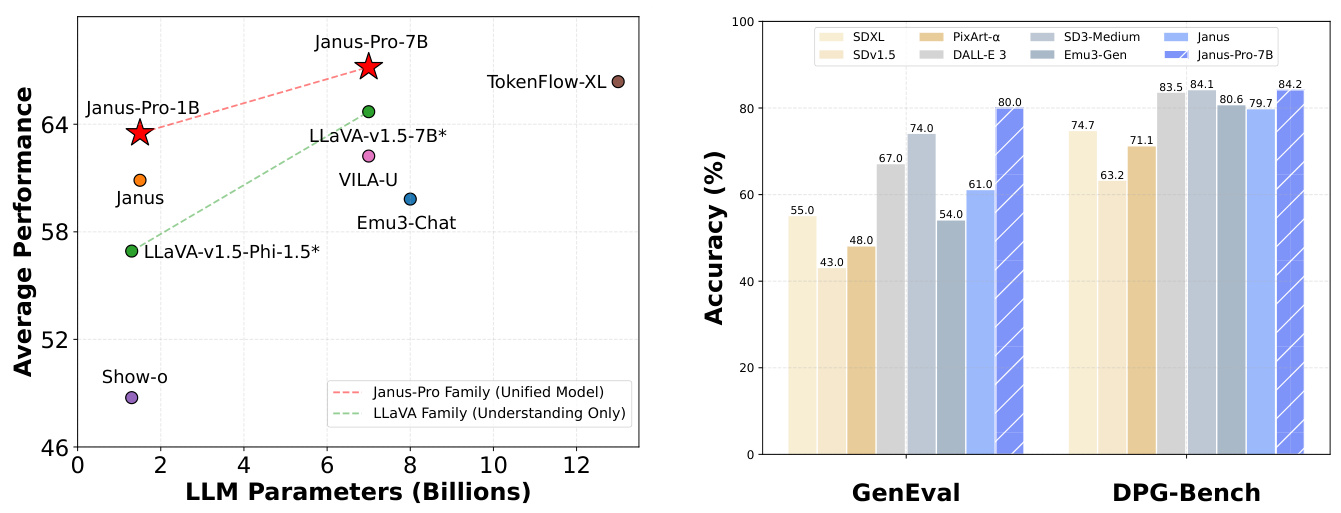

(a) 4つのマルチモーダル理解ベンチマークの平均成績。(b) ベンチマークに続くテキストから画像を生成する指導のパフォーマンス。

図1 Janus-Proのマルチモーダル理解とビジュアル生成の結果。マルチモーダル理解については、POPE、MME-Perception、GQA、MMMUの精度を平均した。MME-Perceptionのスコアは、[0, 100]の範囲になるように20で割った。ビジュアル生成については、GenEvalとDPG-Benchのコマンド追従ベンチマークの性能を評価した。全体として、Janus-Proは、いくつかのタスクに特化したモデルだけでなく、これまでの最先端の統一的なマルチモーダルモデルを凌駕した。最も良い結果が得られたのは、画面上での表示であった。

1.オレンジ色のミカンのシンプルな写真 2.表面が緑色で、白いチョークで正確にはっきりと「Hello」と書かれた清潔な黒板 3.繁栄を象徴するヒマワリのクローズアップ。茎と葉は緑色で、花びらは満開。

図2 Janus-Proとその前身であるJanusのテキスト生成画像の比較。 Janus-Proは、短いプロンプトに対してより一貫した出力を提供し、より高いビジュアル品質、より豊かなディテール、およびシンプルなテキストを生成する能力を備えています。画像の解像度は384x384で、スクリーンで見るのが最適です。

最近、マルチモーダル理解と生成モデルの統合に大きな進展があった [30、40、45、46、48、50、54、55]。これらのアプローチは、モデルの冗長性を減らしながら、視覚的生成タスクにおける命令の順守を強化することが示されている。これらのアプローチのほとんどは、マルチモーダル理解タスクと生成タスクの両方の入力を処理するために、同じ視覚コーダーを使用しています。その結果、2つのタスクで必要とされる表現が異なるため、マルチモーダル理解のパフォーマンスが低下する。この問題に対処するために、Janus [46]は、マルチモーダル理解タスクと生成タスクの間の競合を緩和し、両方のタスクで優れた性能を達成する、分離された視覚的コーディングを提案した。

先駆的なモデルとして、Janusは1Bパラメータスケールで検証された。しかし、学習データの制限とモデル容量が比較的小さいため、短い手がかり画像の生成性能が低い、テキスト生成画像の品質が安定しないなどの欠点がある。Janus-Proファミリーは、1Bと7Bの2つのモデルサイズから構成され、視覚的符号化復号化手法のスケーラビリティを実証している。

Janus-Proを複数のベンチマークで評価した結果、優れたマルチモーダル理解力と、テキストで生成された画像指示の遵守に関する性能の大幅な向上が示された。具体的には、マルチモーダル理解ベンチマークMMBench [29]において、Janus-Pro-7Bは79.2を記録し、Janus [46](69.4)、TokenFlow [34](68.9)、MetaMorph [42](75.2)といったこれまでの最先端の統合マルチモーダルモデルを凌駕した。さらに、Janus-Pro-7Bは、リーダーボードGenEval [14]に従い、text-to-generate-images指令で0.80を記録し、Janus [46] (0.61)、DALL-E 3 (0.67)、Stable Diffusion 3 Medium [11] (0.74)を上回った。

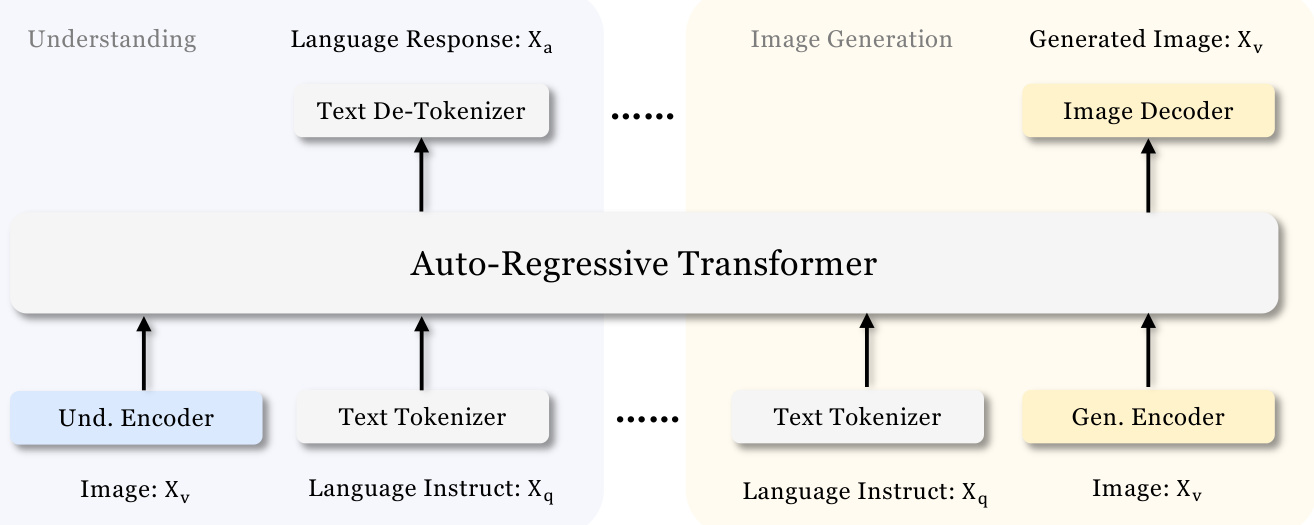

図3 | 邦題 Janus-Proのアーキテクチャ。マルチモーダル理解のための視覚的符号化と視覚的生成を切り離す。「Und.Encoder "と "Gen.Encoder "は、それぞれ "Understanding Encoder "と "Generation Encoder "の略称である。"Und.エンコーダー "と "Gen.エンコーダー "は、それぞれ "Understanding Encoder "と "Generation Encoder "の略です。スクリーンでご覧ください。

2.方法論

2.1.

Janus-Proのアーキテクチャは図3に示されており、Janus [46]と同じである。全体的なアーキテクチャの核となる設計原理は、マルチモーダルな理解と生成のための視覚的コーディングを切り離すことである。生の入力を特徴量に変換するために独立した符号化手法を適用し、それを統一された自己回帰変換器で処理する。マルチモーダル理解のために、SigLIP[53]エンコーダを使い、画像から高次元の意味的特徴を抽出する。これらの特徴は2次元メッシュから1次元シーケンスに広げられ、これらの画像特徴は理解アダプタを使ってLLMの入力空間にマッピングされる。視覚生成タスクでは、[38]のVQタグ設定器を使用して画像を離散IDに変換する。IDシーケンスを1次元に平坦化した後、生成アダプタを使用して各IDに対応するコードブック埋め込みをLLMの入力空間にマッピングする。次に、これらの特徴列を連結してマルチモーダル特徴列を形成し、これをLLMに入力して処理する。LLMに組み込まれた予測ヘッダに加えて、視覚生成タスクにおける画像予測のために、ランダムに初期化された予測ヘッダを使用する。モデル全体は自己回帰の枠組みに従っている。

2.2 最適化されたトレーニング戦略

旧バージョンのJanusでは、3段階のトレーニングプロセスを採用していた。第1段階はアダプタと画像ヘッドのトレーニングに重点を置く。第2段階は均一な事前学習で、内包エンコーダと生成エンコーダを除くすべてのコンポーネントがパラメータを更新する。第3段階は教師付き微調整であり、訓練プロセス中に理解エンコーダのパラメータをさらに解除することで、第2段階を基礎とする。この学習戦略にはいくつかの問題がある。第2フェーズでは、JanusはPixArt [4]に従い、テキストから画像への変換能力の学習を2つのパートに分ける。最初のパートはImageNet [9]のデータを使って訓練され、テキストで生成された画像の手がかりとして画像カテゴリー名を使い、ピクセルの依存関係をモデル化することを目的とした。2番目の部分は、プレーンテキストで生成された画像データを用いて学習された。実装では、第2段階のテキスト生成画像学習ステップの66.67%を第1部分に割り当てた。しかし、さらなる実験により、この戦略は最適ではなく、計算効率の大幅な低下をもたらすことがわかった。

この問題に対処するため、2つの変更が加えられた。

- 第1段階のトレーニング時間が長い我々は、ImageNetデータセットでの完全な学習を可能にする第一段階の学習ステップを追加した。その結果、LLMのパラメータを固定した場合でも、このモデルは画素の依存関係を効果的にモデル化し、カテゴリ名に基づいて賢明な画像を生成できることがわかった。

- フェーズ II 集中トレーニング第2フェーズでは、ImageNetのデータを破棄し、テキストで生成された画像データを直接利用して、密な記述に基づく画像生成モデルの学習を行った。この再設計されたアプローチにより、第2フェーズではテキストで生成された画像データをより効果的に利用できるようになり、学習効率と全体的なパフォーマンスが向上した。

また、教師付き微調整の第3段階では、マルチモーダルデータ、テキストオンリーデータ、テキスト生成画像データの比率を7:3:10から5:1:4に変更し、異なる種類のデータセットのデータ比率を調整した。 テキスト生成画像データの比率をわずかに下げることで、強力な視覚生成能力を維持しながら、マルチモーダル理解性能の向上を達成できることが確認された。

2.3 データ拡張

私たちは、マルチモーダル理解と視覚生成においてJanusが使用するトレーニングデータを拡張します。

- マルチモーダル理解第2段階の事前学習データについては、DeepSeekVL2 [49]を参照し、約9,000万サンプルを追加する。これらには、画像キャプションのデータセット(YFCC [31]など)や、表、グラフ、文書理解のデータセット(Docmatix [20]など)が含まれる。また、第3段階の教師あり微調整データとして、DeepSeek-VL2から、MEME理解、中国語対話データ、対話体験を向上させるためのデータセットを追加した。これらの追加により、モデルの能力が大幅に拡張され、全体的な対話体験を向上させながら、様々なタスクを処理する能力が豊かになりました。

- ビジュアル・プロダクション旧バージョンのJanusで使用されていた実世界のデータは、品質が低く、大きなノイズを含んでいた。Janus-Proでは、統一された事前学習段階で実データと合成データの比率を1:1にするために、約7200万個の合成美的データサンプルを含めた。これらの合成データサンプルのヒントは、[43]などで公開されている。実験によると、合成データで学習すると、モデルの収束が速くなり、より安定したテキスト生成画像出力が得られるだけでなく、美的品質も大幅に向上する。

2.4 モデルの拡張

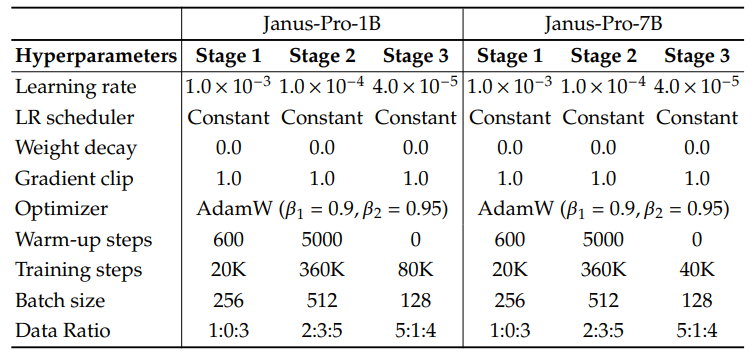

前バージョンのJanusでは、1.5B LLMを用いた視覚符号化デカップリングの有効性を検証した。Janus-Proでは、モデルを7Bに拡張し、1.5Bと7BのLLMのハイパーパラメータの詳細を表1に示す。より大きなLLMを用いると、より小さなモデルに比べて、マルチモーダル理解と視覚生成ロスの収束速度が大幅に向上することが確認された。この発見は、このアプローチのロバストなスケーラビリティをさらに検証するものである。

表1 Janus-Proのアーキテクチャ構成。アーキテクチャのハイパーパラメータを列挙する。

| ヤヌス・プロ-1B | ヤヌス・プロ-7B | |

| 語彙のサイズ | 100K | 100K |

| 埋め込みサイズ | 2048 | 4096 |

| コンテキストウィンドウ | 4096 | 4096 |

| アテンションスパン | 16 | 32 |

| 階 | 24 | 30 |

表2 Janus-Proトレーニングの詳細なハイパーパラメータ。データ比率とは、マルチモーダル理解データ、プレーンテキストデータ、視覚的に生成されたデータの比率を指す。

3.実験

3.1 実施内容

理解タスクで使用する視覚コーダーには、SigLIP-Large-Patch16-384 [53]を選択した。生成エンコーダはサイズ16,384のコードブックを持ち、画像を16回ダウンサンプリングする。各ステージの詳細なハイパーパラメータは表2に示す。すべての画像は384x384ピクセルにリサイズされた。マルチモーダル理解データについては、画像の長辺を384にリサイズし、短辺を背景色(RGB:127, 127, 127)で塗りつぶして384にする。 視覚生成データについては、短辺を384にリサイズし、長辺を384にトリミングする。学習効率を向上させるため、学習過程でシーケンスパッキングを使用する。我々は1回の訓練で、指定された比率に従ってすべてのデータタイプを混合する。我々のJanusは、PyTorch上に構築された軽量で効率的な分散学習フレームワークであるHAI-LLM [15]を用いて学習・評価される。1.5B/7Bのモデルに対して、8つのNvidia A100 (40GB)GPUを搭載した16/32ノードのクラスタで、全学習プロセスに約7/14日を要した。

3.2 セッティングの評価

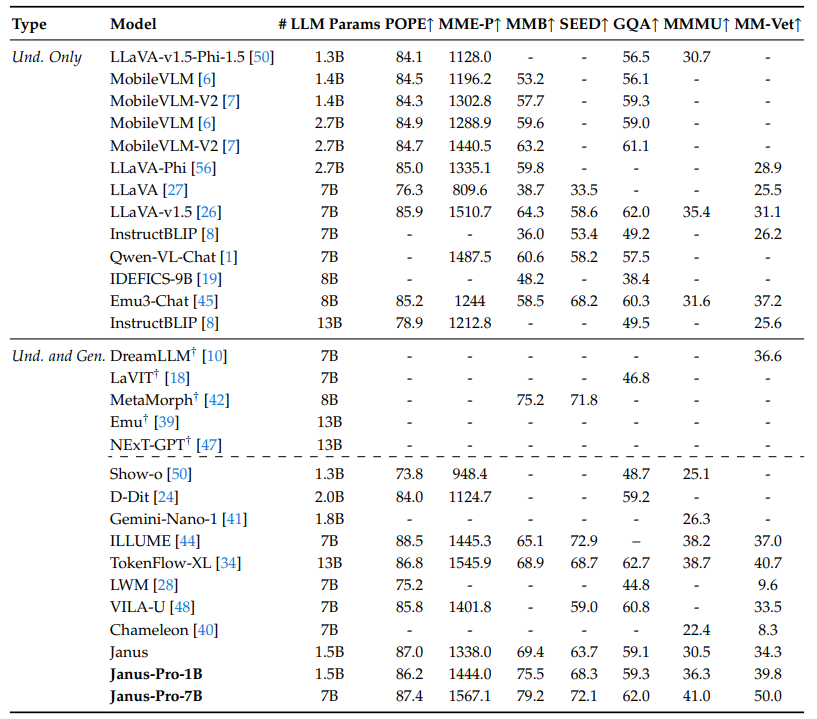

マルチモーダルな理解: マルチモーダル理解を評価するために、GQA [17]、POPE [23]、MME [12]、SEED [21]、MMB [29]、MM-Vet [51]、MMMU [52]など、広く認知されている画像ベースの視覚-言語ベンチマークでモデルを評価した。

表3|「ヴォルフガング」|「ヴォルフガング」|「ヴォルフガング マルチモーダル理解ベンチマークにおける最先端技術との比較。"Und. "は「理解」、"Gen. "は「生成」を表す。 外部で事前に訓練された拡散モデルを使用したモデルには、†が付されている。

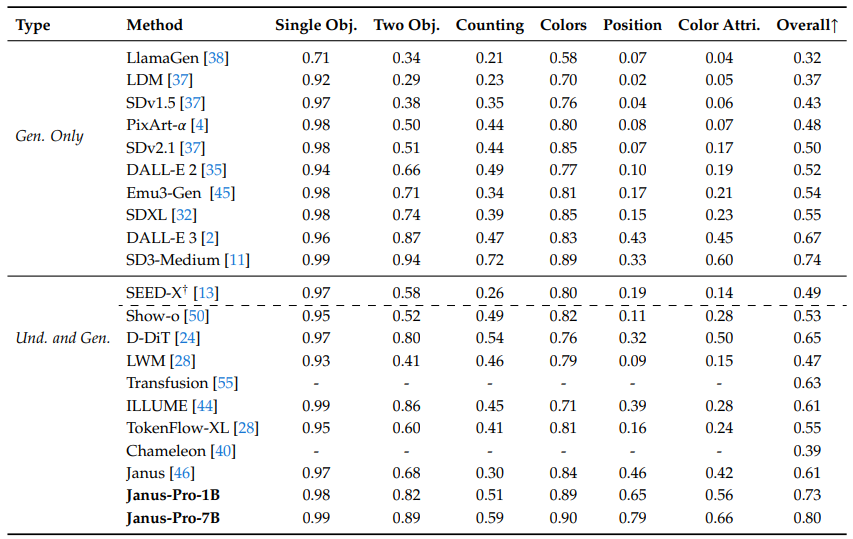

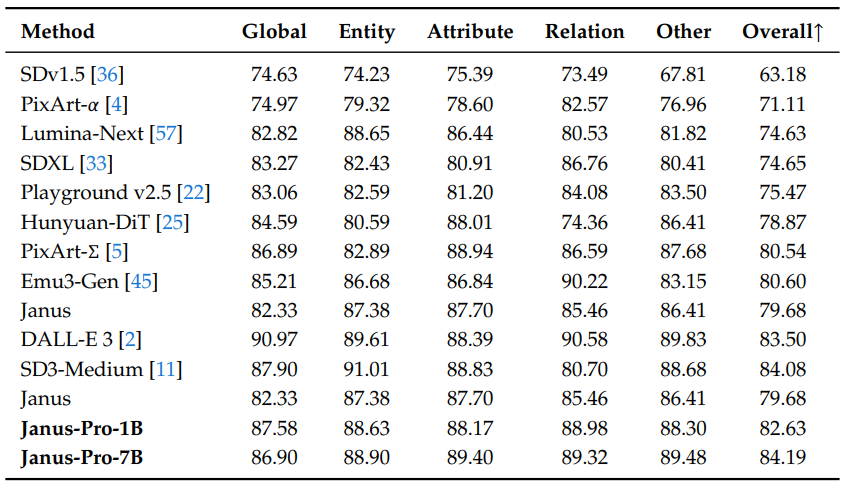

ビジュアル・ジェネレーション: ビジュアル生成能力を評価するために、GenEval[14]とDPG-Bench[16]を使用した。GenEvalは、ビジュアル生成モデルの組み合わせ能力の詳細なインスタンスレベルの分析を通じて、ビジュアル生成モデルの完全な生成能力を反映するように設計された、難易度の高い画像からテキストへの生成ベンチマークである。DPG-Bench(Dense Prompted Graph Benchmark)は、以下を含む包括的なデータセットである。1065個の長くて密なキューを含む包括的なデータセットで、テキストから画像へのモデルの複雑な意味的整列能力を評価するように設計されている。

3.3 最先端技術との比較

マルチモーダル理解パフォーマンス: 表3において、提案アプローチを最新の統一モデルおよび理解専用モデルと比較する。これは、マルチモーダル理解と生成された視覚的コーディングを切り離すことで、これら2つのタスク間の衝突を緩和しているためと考えられる。Janus-Proは、はるかに大きなモデルと比較しても、高い競争力を維持しています。例えば、Janus-Pro-7Bは、GQAを除くすべてのベンチマークでTokenFlow-XL(13B)を上回っています。

表4 GenEvalベンチマークにおけるテキスト画像生成の評価。"Und. "は「理解」、"Gen. "は「生成」を表す。外部で事前に訓練された拡散モデルを使用したモデルには†を付けている。

表5 DPG-Benchでのパフォーマンス。JanusとJanus-Proを除いて、この表にあるすべてのメソッドは、タスク生成に使用されたモデルに固有である。

ビジュアル・ジェネレーションのパフォーマンス: GenEvalとDPG-Benchでの視覚的生成性能を報告する。表4に示すように、我々のJanus-Pro-7BはGenEvalで80%の総合的な精度を得ており、Transfusion[55](63%)、SD3-Medium(74%)、DALL-E 3(67%)など、他の統一的な手法や生成のみをサポートした手法を凌駕している。これは、本手法がより優れた命令追従能力を持つことを示している。表5に示すように、Janus-ProはDPG-Benchで84.19のスコアを達成し、他のすべての手法を上回った。これは、Janus-Proがテキストから画像への生成のための高密度命令に追従するのが得意であることを示している。

3.4 定性的結果

Janus-Proは、異なるコンテクストからの入力を処理する際にも優れた理解力を発揮し、その能力を示している。Janus-Pro-7Bによって生成された画像は、解像度が$384times384$であるにもかかわらず、非常にリアルで細部まで再現されている。想像的で創造的なシナリオに対して、Janus-Pro-7Bはプロンプトの意味情報を正確にとらえ、感覚的で首尾一貫した画像を生成する。

図4 マルチモーダル理解と視覚生成能力の定性的結果。モデルはJanus-Pro-7Bで、視覚的に生成された画像出力は$384times384$の解像度を持つ。

4.結論

本論文では、学習戦略、データ、モデルサイズの点でJanusに改良を加えた。これらの改良により、マルチモーダル理解とテキスト生成画像コマンド追従が大幅に改善された。しかし、Janus-Proにはまだいくつかの制限がある。マルチモーダル理解では、入力解像度が$384times384$に制限され、OCRのような細かいタスクでの性能に影響する。テキストで生成された画像では、解像度が低いため、視覚的タグ付け機能によって生じる再構築ロスと相まって、意味的に豊かではあるが詳細が欠落した画像が生成される。例えば、限られた画像スペースを占める小さな顔領域は、十分な詳細がないように見えることがあります。画像の解像度を上げることで、このような問題を軽減することができる。

書誌

[1] J. Bai, S. Bai, S. Yang, S. Wang, S. Tan, P. Wang, J. Lin, C. Zhou, and J. Zhou. qwen-vl: A cutting-edge large-scale visual language model with versatility. arXiv preprint arXiv:2308.12966, 2023.[2] J. Betker, G. Goh, L. Jing, T. Brooks, J. Wang, L. Li, L. Ouyang, J. Zhuang, J. Lee, Y. Guo, et al. より良いキャプションによる画像生成の改善。Computer Science. https://cdn.openai.com/papers/dall-e-3.pdf, 2(3):8, 2023.

[3] X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu, et al. DeepSeek LLM: Extending open source language models using long-termism.arXiv preprint arXiv:2401.02954, 2024.

[4] J. Chen, J. Yu, C. Ge, L. Yao, E. Xie, Y. Wu, Z. Wang, J. Kwok, P. Luo, H. Lu, et al. PixArtℎ: photo-realistic text generation image synthesis のための高速トレーニング拡散変換器. arXiv preprint arXiv:2310.00426, 2023.

[PixArt-Sigma: weak-to-strong diffusion transformer training for 4K text generation image generation. arXiv preprint arXiv:2403.04692, 2024.

[6] X. Chu, L. Qiao, X. Lin, S. Xu, Y. Yang, Y. Hu, F. Wei, X. Zhang, B. Zhang, X. Wei, et al. Mobilevlm: a fast, reproducible and powerful visual language assistant for mobile devices. arXiv preprint arXiv:2312.16886, 2023.

[7] X. Chu, L. Qiao, X. Zhang, S. Xu, F. Wei, Y. Yang, X. Sun, Y. Hu, X. Lin, B. Zhang, et al. Mobilevlm v2: A faster and more powerful basis for visual language modelling. arXiv preprint arXiv:2402.03766, 2024.

[8] W. Dai, J. Li, D. Li, A. M. H. Tiong, J. Zhao, W. Wang, B. Li, P. Fung, and S. Hoi. Instructblip: towards generalised visual language model with command fine-tuning, 2023.

Imagenet: a large-scale hierarchical image database. [9] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei.2009年IEEE Computer Vision and Pattern Recognition Conference Proceedings, pages 248-255. Institute of Electrical and Electronics Engineers, 2009.

[10] R. Dong, C. Han, Y. Peng, Z. Qi, Z. Ge, J. Yang, L. Zhao, J. Sun, H. Zhou, H. Wei, et al. Dreamllm:マルチモーダルな協調的理解と創造. arXiv preprint arXiv:2309.11499, 2023.

[11] P. Esser, S. Kulal, A. Blattmann, R. Entezari, J. Mller, H. Saini, Y. Levi, D. Lorenz, A. Sauer, F. Boesel, D. Podell, T. Dockhorn, Z. English, K. Lacey.A. Goodwin, Y. Marek, and R. Rombach. Scaling-corrected stream transformer for high-resolution image synthesis, 2024. URL https://arxiv.org/abs/2403.03206.

[12] C. Fu, P. Chen, Y. Shen, Y. Qin, M. Zhang, X. Lin, J. Yang, X. Zheng, K. Li, X. Sun, et al. MME: a comprehensive evaluation benchmark for multimodal large language models. arXiv preprint arXiv:2306.13394, 2023.

[SEED-X: 統一された多粒度理解と生成のマルチモーダルモデル。

[GenEval: an object-oriented framework for evaluating text-generated image alignment.神経情報処理システムの進歩, 36, 2024.

[15] High-flyer. HAI-LLM: An Efficient and Lightweight Large Model Training Tool, 2023. URL https://www.high-flyer.cn/en/blog/hai-llm.

[16] X. Hu, R. Wang, Y. Fang, B. Fu, P. Cheng, and G. Yu. ELLA: Equipping diffusion models for enhanced semantic alignment.arXiv preprint arXiv:2403.05135, 2024.

[17] D. A. Hudson and C. D. Manning. gqa: a new dataset for real-world visual reasoning and combinatorial quizzing.Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 6700-6709, 2019.

[18]Y.Jin、K.Xu、L.Chen、C.Liao、J.Tan、B.Chen、C.Lei、A.Liu、C.Song、X.Lei、et al. arXiv:2309.04669、2023.

[19] H. Laurenon, D. van Strien, S. Bekman, L. Tronchon, L. Saulnier, T. Wang, S. Karamcheti, A. Singh, G. Pistilli, Y. Jernite, and al. IDEFICSの紹介:最先端の視覚言語モデルを再現するためのオープンモデル、2023年。 URL https://huggingface.co/blog/id efics.

[20] H. Laurenon, A. Marafioti, V. Sanh, and L. Tronchon. Building and better understanding visual language models: insights and future directions, 2024.

このような場合、[21] B. Li, R. Wang, G. Wang, Y. Ge, Y. Ge, and Y. Shan. SEED-Bench: benchmarking multimodal LLMs using generative understanding. arXiv preprint arXiv:2307.16125, 2023.

[22] D. Li, A. Kamko, E. Akhgari, A. Sabet, L. Xu, and S. Doshi. 遊び場 v2.5:テキスト生成画像生成の美的品質を高めるための3点インサイト. arXiv preprint arXiv:2402.17245, 2024.

(1)視覚言語モデルにおける物体の錯覚の評価.arXiv preprint arXiv:2305.10355, 2023.

[24] Z. Li, H. Li, Y. Shi, A. B. Farimani, Y. Kluger, L. Yang, and P. Wang. Double diffusion for unified image generation and understanding. arXiv preprint arXiv:2501.00289, 2024.

[25] Z. Li, J. Zhang, Q. Lin, J. Xiong, Y. Long, X. Deng, Y. Zhang, X. Liu, M. Huang, Z. Xiao, et al. Hunyuan-DiT: A powerful multi-resolution diffusion transformer with fine Chinese understanding. arXiv preprint arXiv:2405.08748, 2024.

[26]H.Liu、C.Li、Y.Li、Y.J.Lee.視覚コマンドのための改善された微調整ベースライン。IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 26296-26306, 2024.

[27] H. Liu, C. Li, Q. Wu, and Y. J. Lee. visual command fine-tuning.Advances in Neural Information Processing Systems, 36, 2024.

(注)このような場合、[28] H. Liu, W. Yan, M. Zaharia, and P. Abbeel.リング・アテンションを用いた百万長ビデオと言語の世界モデル。

[29] Y. Liu, H. Duan, Y. Zhang, B. Li, S. Zhang, W. Zhao, Y. Yuan, J. Wang, C. He, Z. Liu, et al. MMBench: あなたのマルチモーダルモデルはオールラウンダーですか? arXiv preprint arXiv:2307.06281, 2023.

[30] Y. Ma, X. Liu, X. Chen, W. Liu, C. Wu, Z. Wu, Z. Pan, Z. Xie, H. Zhang, X. yu, L. Zhao, Y. Wang, J. Liu, and C. Ruan. Janusflow: reconciling autoregressive and corrective flows for unified multimodal understanding and generation, 2024.

[31] mehdidc. yfcc-huggingface. https://huggingface.co/datasets/mehdidc/yfcc15 m, 2024.

[32] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna, and R. Rombach. sdxl: improving potential diffusion models for high resolution image synthesis. arXiv preprint arXiv:2307.01952,.2023.

[33] D. Podell, Z. English, K. Lacey, A. Blattmann, T. Dockhorn, J. Mller, J. Penna, and R. Rombach. sdxl: improving potential diffusion models for high resolution image synthesis.

[34] L. Qu, H. Zhang, Y. Liu, X. Wang, Y. Jiang, Y. Gao, H. Ye, D. K. Du, Z. Yuan, 和 X. Wu. Tokenflow: 统一图像标记器用于多模态理解和生成。arXiv 预印本 arXiv:2412.03069, 2024.

[35]A.Ramesh、P.Dhariwal、A.Nichol、C.Chu、M.Chen. CLIP潜在値を用いた階層的テキスト条件付き画像生成。

[潜在拡散モデルを用いた高解像度画像合成.

[潜在拡散モデルを用いた高解像度画像合成。IEEE/CVF Conference of Computer Vision and Pattern Recognition, pages 10684-10695, 2022.

(1)画像生成のための自己回帰モデル:スケーラブルな画像生成のためのLLama.arXiv preprint arXiv:2406.06525, 2024.

[39] Q. Sun, Q. Yu, Y. Cui, F. Zhang, X. Zhang, Y. Wang, H. Gao, J. Liu, T. Huang, and X. multimodal generative pre-training. arXiv preprint arXiv:2307.05222, 2023.

[40] C. Team. Chameleon: A basic model for early fusion of mixed modes. arXiv preprint arXiv:2405.09818, 2024.

[41] G. Team, R. Anil, S. Borgeaud, Y. Wu, J.-B. Alayrac, J. Yu, R. Soricut, J. Schalkwyk, A. M. Dai, A. Hauth, et al. ジェミニarXivプレプリントarXiv:2312.11805, 2023.

[Metamorph: instruction fine-tuning through multimodal understanding and generation. arXiv preprint arXiv:2412.14164,.2024.

[43] ヴィヴィム 旅の途中 https://huggingface.co/datasets/vivym/midjourney-prompts、2023。 訪問日:[訪問日を挿入、例:2023-10-15]。

このような場合、[44] C. Wang, G. Lu, J. Yang, R. Huang, J. Han, L. Hou, W. Zhang, and H. Xu. Illume: illuminating your LLMs to see, draw, and self-enhance. arXiv preprint arXiv:2412.06673, 2024.

[45] X. Wang, X. Zhang, Z. Luo, Q. Sun, Y. Cui, J. Wang, F. Zhang, Y. Wang, Z. Li, Q. Yu, et al. Emu3:次のタグ予測は必要なものだけである。

[このような、視覚コーディングのデカップリングによる統一的なマルチモーダル理解・生成は、arXiv.preprint arXiv.2410.1384, 2020に掲載されている。 Janus:統一されたマルチモーダル理解と生成のためのデカップリング視覚コーディング. arXiv preprint arXiv:2410.13848, 2024.

[next-gpt:any-to-anyマルチモーダルLLM. arXiv preprint arXiv:2309.05519, 2023.

[48] Y. Wu, Z. Zhang, J. Chen, H. Tang, D. Li, Y. Fang, L. Zhu, E. Xie, H. Yin, L. Yi, et al. VILA-U: 視覚理解と視覚生成を統合するための基礎モデル. arXiv preprint arXiv:2409.04429, 2024.

[49] Z. Wu, X. Chen, Z. Pan, X. Liu, W. Liu, D. Dai, H. Gao, Y. Ma, C. Wu, B. Wang, et al. DeepSeek-VL2:高度なマルチモーダル理解のためのハイブリッドエキスパート視覚言語モデル。

[50] J. Xie, W. Mao, Z. Bai, D. J. Zhang, W. Wang, K. Q. Lin, Y. Gu, Z. Chen, Z. Yang, and M. Z. Shou. show-o: a single converter for unified multimodal understanding and generation. arXiv preprint arXiv:2408.12528,.2024.

[51] W. Yu, Z. Yang, L. Li, J. Wang, K. Lin, Z. Liu, X. Wang, and L. Wang. MM-Vet: evaluating integrative power of large multimodal models. arXiv preprint arXiv:2308.02490, 2023.

[このベンチマークは、専門家によるAGIのための大規模な学際的マルチモーダル理解・推論ベンチマークである。 MMMU: A large-scale multidisciplinary multimodal understanding and inference benchmark for expert AGI. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 9556-9567, 2024.

[53] X. Zhai, B. Mustafa, A. Kolesnikov, and L. Beyer. sigmoid loss for language image pre-training.IEEE/CVF International Conference on Computer Vision, pages 11975-11986, 2023.

(注1)本論文は、(注2)本論文の一部であり、(注3)本論文の一部ではありません。

[55] C. Zhou, L. Yu, A. Babu, K. Tirumala, M. Yasunaga, L. Shamis, J. Kahn, X. Ma, L. Zettlemoyer, and O. Levy. Transfusion: predicting the next labelled and diffused image using multimodal model.arXiv:2408.11039, 2024.

[56] Y. Zhu, M. Zhu, N. Liu, Z. Ou, X. Mou, and J. Tang. lLAVA-Phi: Efficient multimodal assistant with small language models. arXiv preprint arXiv:2401.02330, 2024.[57] L. Zhuo, R. Du, H. Xiao, Y. Li, D. Liu, R. Huang, W. Liu, L. Zhao, F.-Y. Wang, Z. Ma, et al. Lumina-Next:Next-DiTでLumina-T2Xをより強力に、より高速に. arXiv preprint arXiv:2406.18583, 2024.

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません