DeepSeek討論会:コストにおける中国のリーダーシップ、実際のトレーニングコスト、クローズドソースモデルの利益への影響

キーワード:H100価格高騰、補助金推計価格、輸出規制、国土交通省

ディープシークの物語が世界を席巻する

ディープシーク 世界を席巻この1週間、DeepSeekは世界中の誰もが話題にしたがる唯一のトピックとなっている。現在、DeepSeekの1日のトラフィックは、ClaudeやPerplexity、さらにはGeminiよりもはるかに多い。

しかし、この分野に詳しい人にとっては、これは決して "新しい "ニュースではない。我々は数ヶ月前からDeepSeekについて話してきた(すべてのリンクがその例である)。SemiAnalysisは長い間、DeepSeekは非常に優秀であり、米国の一般大衆は気にしていないと主張してきた。世界がようやく注目したとき、それは現実を反映しない熱狂的な誇大宣伝の中で行われた。

この声明は、スケーリング法則が破られ、アルゴリズムの改善が早すぎるという誤解を払拭した先月とは変わっていることを強調したい。

背景:2024年12月11日 スケーリング法 - O1 Proのアーキテクチャ、推論トレーニング・インフラ、Orion、そして クロード 3.5 作品 "失敗"

現在のシナリオは、DeepSeekは非常に効率的であるため、これ以上の計算は必要なく、モデルチェンジのためにすべてのものに巨大な生産能力過剰が発生しているというものである。ジェボンズ・パラドックスも過大に宣伝されているが、ジェボンズの方が現実に近く、これらのモデルは需要を誘発し、H100とH200の価格設定に具体的な影響を与えている。

ディープシークとハイフライヤー

High-Flyerは中国のヘッジファンドで、取引アルゴリズムにAIをいち早く採用した。彼らは金融以外の分野でのAIの可能性と、スケーリングの重要な洞察に早くから気づいていた。その結果、GPUの供給量を増やしてきた。何千ものGPUのクラスタを使ったモデルを実験した後、High Flyerは2021年に10,000個のA100 GPUに投資しました。* これが功を奏した。High-Flyerが改善するにつれて、彼らは2023年5月に、より集中的な方法でさらなるAI機能を追求することを目標に、"DeepSeek "をスピンオフする時期であることに気づいた。 当時、外部の投資家からAIへの関心がほとんどなく、ビジネスモデルの欠如が主な懸念事項であったため、High-Flyerは自己資金で会社を設立した。High-FlyerとDeepSeekは今日、人的・計算的リソースを共有することが多い。

ディープシークは現在、多くのメディアが主張するような「副業」とはかけ離れた、真剣かつ協力的な取り組みへと進化している。彼らのGPUへの投資額は、輸出規制を考慮しても5億ドルを超えると思われる。

出典:SemiAnalysis、Lennart Heim。

GPUの状況

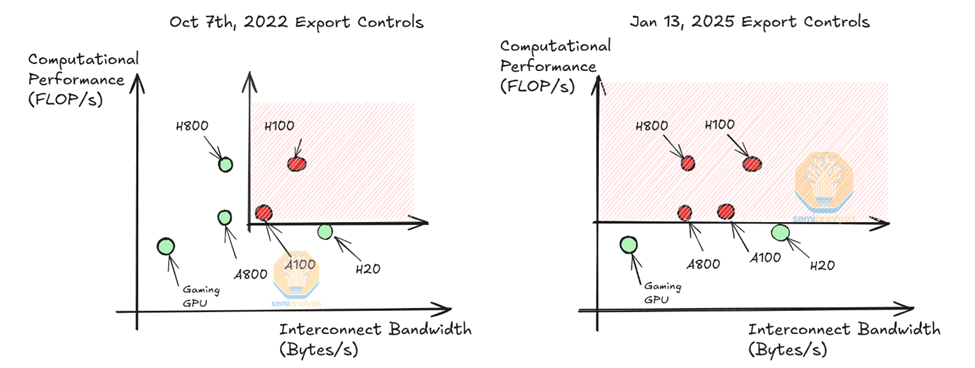

50,000ドルは使えると思う。 ホッパーGPUこれは、一部の人々が主張している5万台のH100とは異なる。Nvidiaは、異なる規制(H800、H20)に準拠するためにH100の異なるモデルを製造しており、現在、H20のみが中国のモデルプロバイダーに提供されている。H800はH100と同じ演算能力を持つが、ネットワーク帯域幅は低い。

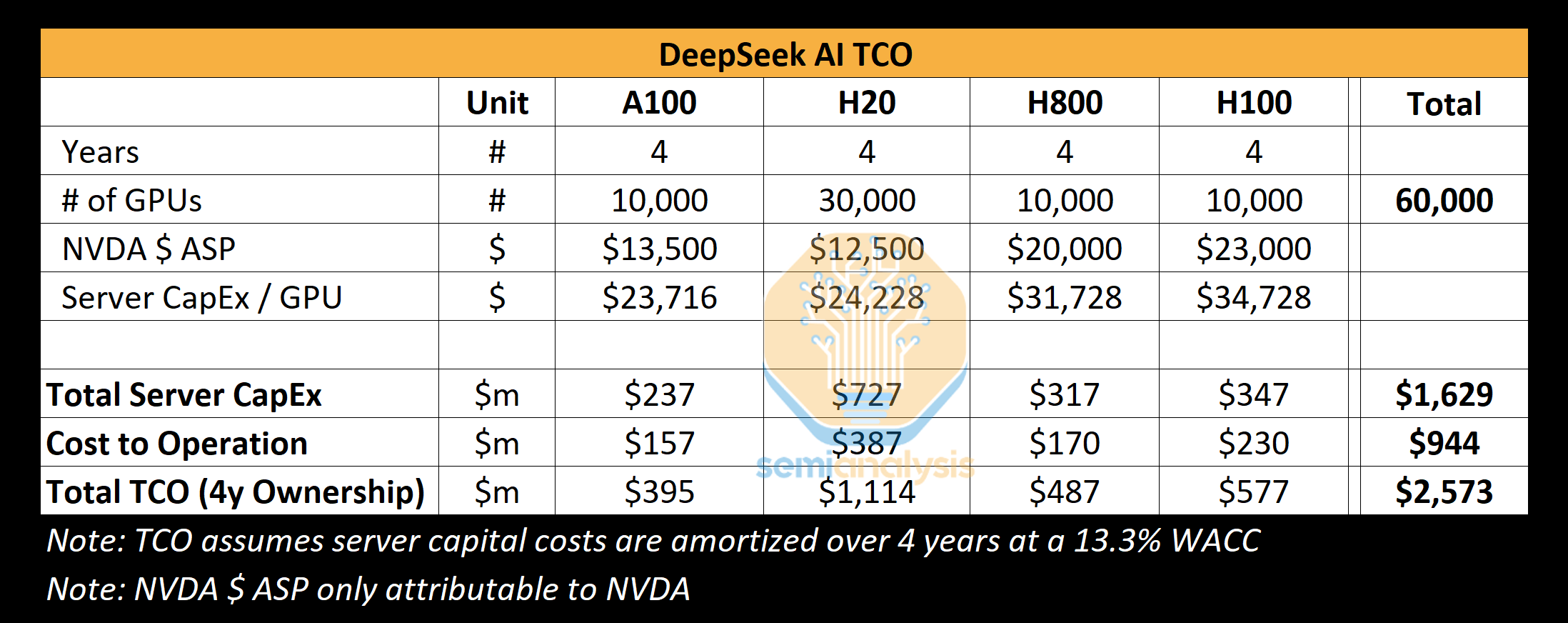

DeepSeekは約1万台のH800と約1万台のH100を使用できると考えている。さらに、彼らはさらにH20を発注しており、Nvidiaは過去9ヶ月間で100万台以上の中国専用GPUを生産した。これらのGPUはHigh-FlyerとDeepSeekで共有され、地理的に多少分散されている。これらのGPUは取引、推論、トレーニングに使用される。これらのGPUは取引、推論、トレーニング、研究に使用されている。より具体的で詳細な分析については、アクセラレーター・モデルをご覧ください。

出典:セミアナリシス

当社の分析によると、DeepSeekのサーバー設備投資総額は約16億ドルで、このようなクラスターの運用に関連するコストは9億4400万ドルにも上る。同様に、すべてのAIラボとハイパースケーラは、リソースのプールが課題であるため、単一のトレーニング実行に提出するよりも、研究やトレーニングを含むさまざまなタスクのために多くのGPUを持っています。

DeepSeekは、資格の有無にかかわらず、能力と好奇心に重点を置いた中国からの人材発掘に特化しており、社員の多くが卒業した北京や浙江などの一流大学で定期的に採用イベントを開催している。募集職種は必ずしも事前定義されておらず、採用担当者には柔軟性が与えられている。求人広告では、1万台以上のGPUを使用制限なしで利用できることを自慢しているほどだ。彼らは非常に競争力が高く、有望な候補者には130万ドルを超える給与を提示すると言われており、競合する中国の大手テック企業やムーンショットなどのAIラボよりもはるかに高い。

ディープシークにはグーグルのような官僚主義がなく、自己資金で運営されているため、アイデアを素早く前進させることができる。しかし、グーグルのように、ディープシークも(大部分は)自社でデータセンターを運営しており、外部の関係者やプロバイダーに依存していない。そのため、より多くの実験スペースが確保され、スタック全体でイノベーションを起こすことができる。

メタのラマやミストラルなどを抑え、現在最高の「オープンウェイト」ラボだと信じている。

ディープシークのコストと性能

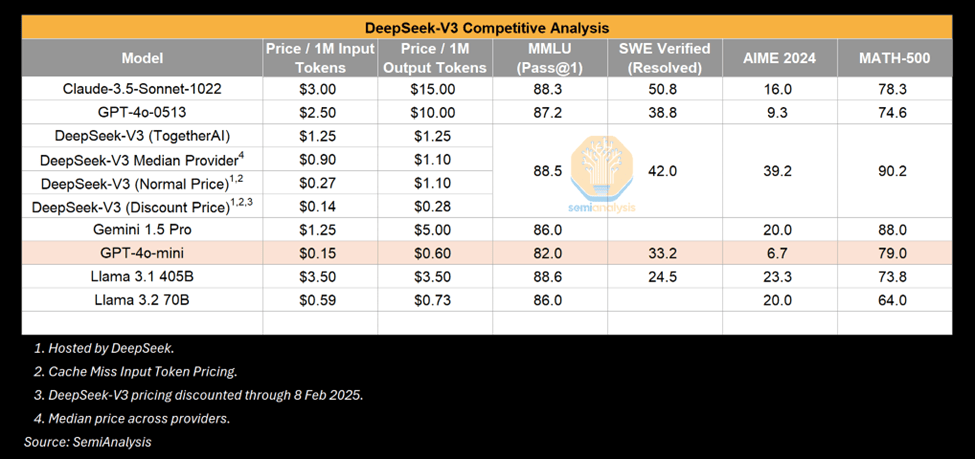

今週、ディープシークの価格と効率は熱狂を呼び、主な見出しはディープシークV3の「600万ドル」というトレーニング費用だった。これは間違っている。これは、製品の部品表の特定の部分を指して、それをコスト全体の原因としているのと似ています。事前トレーニングのコストは、総コストのごく一部です。

トレーニング費用

我々は、事前トレーニングの数字は、モデルに費やされた実際の金額とはかけ離れていると考えている。我々は、同社がその歴史の中でハードウェアに費やした金額は5億ドルをはるかに超えると考えている。新しいアーキテクチャのイノベーションを開発するために、新しいアイデア、新しいアーキテクチャのアイデア、モデル開発中のアブレーションをテストするためにかなりの支出があります。DeepSeekの重要なイノベーションであるマルチヘッド潜在的アテンションは、開発に数ヶ月を要し、チーム全体のマンパワーとGPUの時間を費やしました。

論文にある600万ドルというコストは、事前学習実行のGPUコストのみに起因するもので、モデルの総コストのほんの一部に過ぎない。参考までに、クロード3.5のソネットはトレーニングに数千万ドルかかっており、それだけで済むのであれば、Anthropicはグーグルから数十億ドル、アマゾンから数百億ドルを調達していないだろう。というのも、彼らは実験し、新しいアーキテクチャを考え出し、データを収集し、クリーニングし、従業員に給与を支払うなどしなければならないからだ。

では、なぜディープシークはこれほど大規模なクラスターを持っているのだろうか?輸出規制の遅れが鍵であり、以下の輸出のセクションで説明する。

ギャップを埋める - V3パフォーマンス

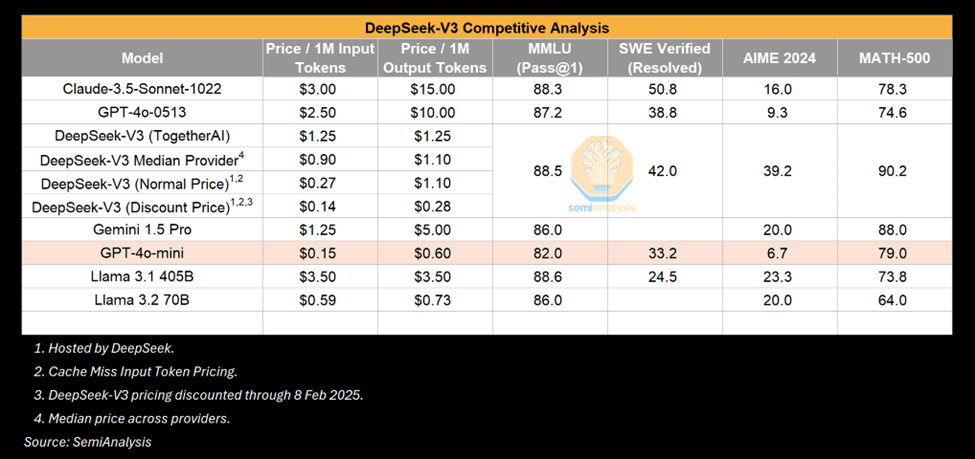

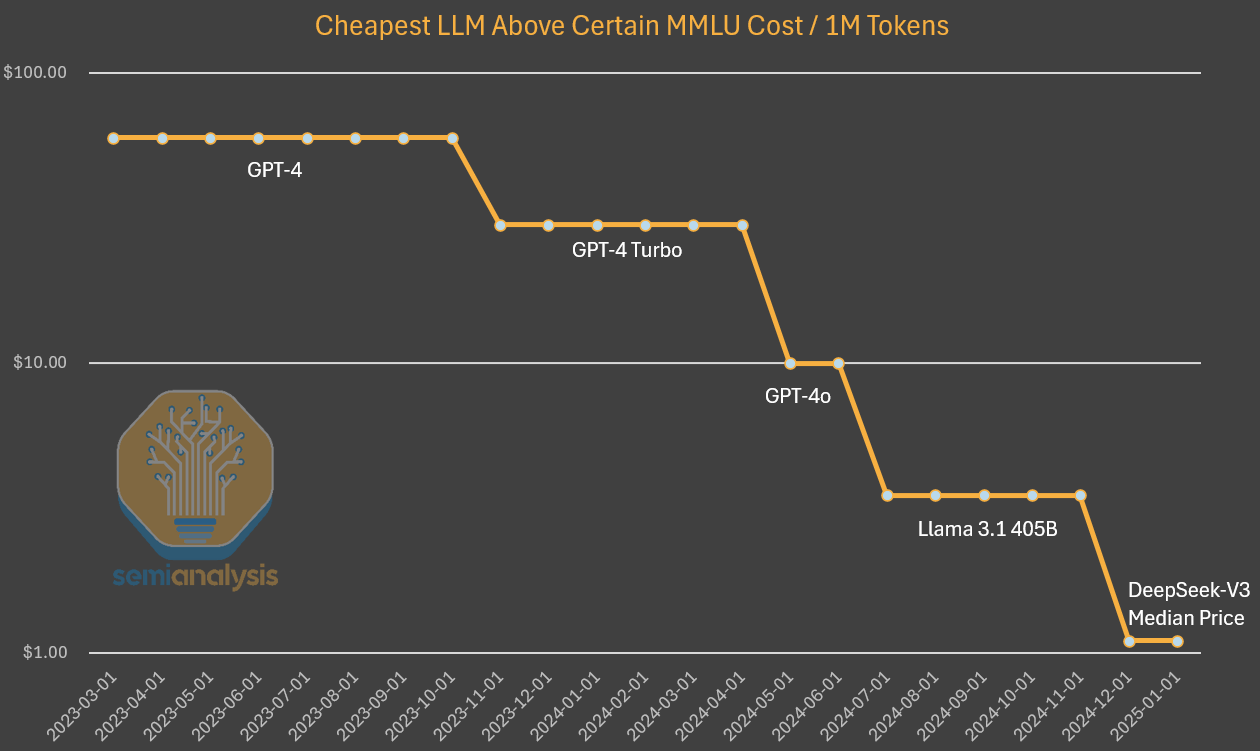

V3は間違いなく印象的なモデルだが、以下の点を強調する価値がある。 印象的なものとは対照的だ。.多くの人がV3とGPT-4oを比較し、V3がいかに4oの性能を上回っているかを強調している。これは事実だが、GPT-4oは4oより性能が上なのだ。 2024年5月release.AIは急速に進化しており、2024年5月はアルゴリズムの改良という点でまた新たな時代となる。さらに、一定の時間が経過すれば、より少ない計算回数で同等以上のパワーが達成されても不思議ではない。推論コストの崩壊は、AI改善の兆しである。

出典:セミアナリシス

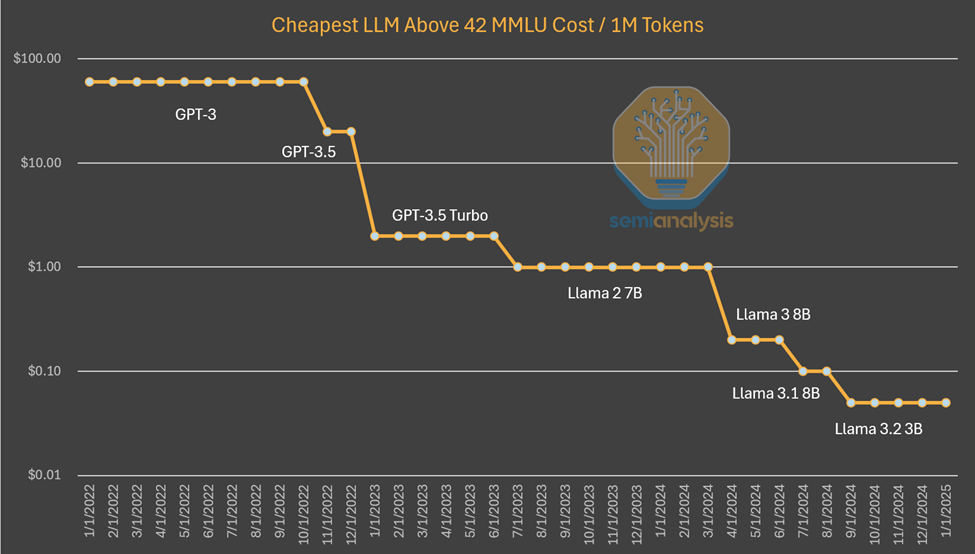

その一例として、ノートパソコンで実行できる小さなモデルは、学習にスーパーコンピューターを、推論に複数のGPUを必要とするGPT-3に匹敵する性能を持つ。言い換えれば、アルゴリズムの改善によって、同じ能力を持つモデルの訓練と推論をより少ない計算回数で行えるようになり、このパターンが何度も繰り返されているのだ。今回、世界が注目したのは、それが 中国 ラボの。しかし、小型モデルが良くなるのは今に始まったことではない。

出典:SemiAnalysis、Artificialanalysis.ai、 アナキン.ai, a16z

私たちがこれまで目撃してきたこのパターンは、AIラボがより多くの絶対的な資金を費やしていることだ。 もっと見る Anthropicのインテリジェンスアルゴリズムの進歩は年間4倍と推定されている。つまり、同じ能力を達成するために必要な計算量は、年を追うごとに4倍ずつ減っていく。AnthropicのCEOであるDarioは、アルゴリズムの進歩はさらに速く、10倍の進歩をもたらすと考えている。GPT-3の品質推論の価格設定の場合、コストは1200分の1になった。

GPT-4のコストを調べてみると、カーブの初期ではあるが、同様のコストの減少が見られる。経時的なコスト差の減少は、上のグラフのように容量を一定に保たなくなったことで説明できる。この場合、アルゴリズムの改善と最適化によって、コストが10倍削減され、キャパシティが10倍増加したことがわかります。

出典:SemiAnalysis、OpenAI、 一緒に.ai

はっきり言って、ディープシークがユニークなのは、そもそもこのレベルのコストと能力を達成したという点である。オープン・ウェイトをリリースしている点でもユニークだが、以前の ミストラル ディープシークはこのレベルのコストを達成したが、年末までにコストがさらに5倍下がっても驚かないでほしい。

R1のパフォーマンスはo1と同等か?

一方、R1は9月に発表されたばかりのo1に匹敵する結果を出すことができた。ディープシークはなぜこれほど早く追いつくことができたのだろうか?

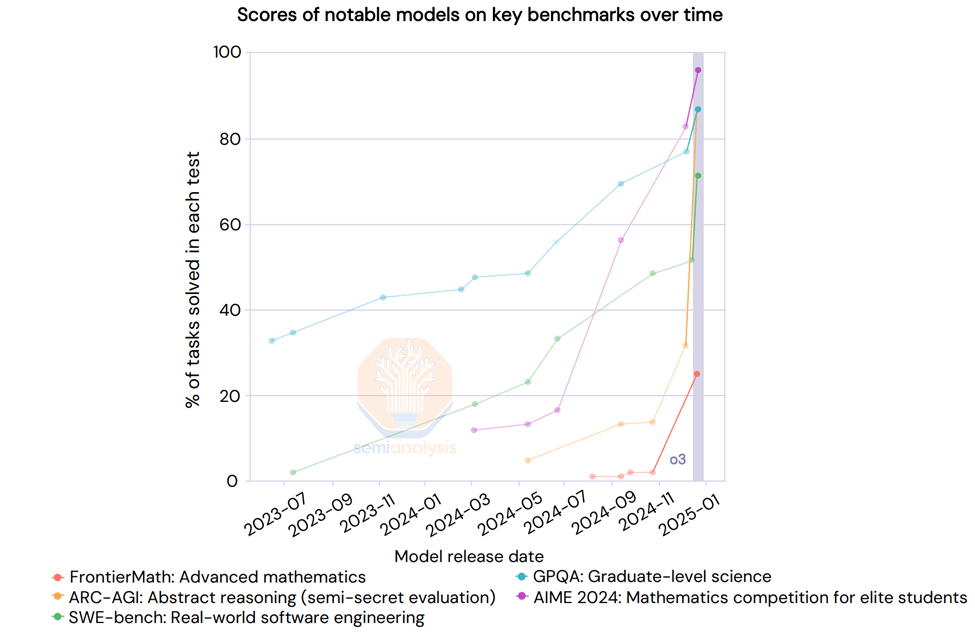

その答えは、推論はより速い反復速度と達成しやすい目標を持つ新しいパラダイムであり、少量の計算で以前のパラダイムと比較して意味のある利益を得ることができるということである。Scaling Lawsのレポートで説明したように、以前のパラダイムは事前学習に依存しており、これはますます高価になり、ロバストな利益を達成するのが難しくなっている。

新しいパラダイムは、合成データ生成と既存モデルのポストトレーニングにおける強化学習を通じて推論能力を可能にすることに重点を置いており、その結果、低価格でより速い利益を得ることができる。シンプルな最適化と相まって参入障壁が低くなっているため、DeepSeek は o1 アプローチを通常よりも高速に再現することができます。参加者がこの新しいパラダイムでよりスケールアップする方法を見出すにつれ、マッチング能力の時間差は拡大すると予想される。

R1論文 記載なし これは偶然ではない。これは偶然ではなく、R1をポストトレーニングするために使用される合成データを生成するために多くの計算が必要なのだ。r1が非常に優れたモデルであることに異論はないし、これほど早く推論の優位性に追いついたことは、客観的に見て素晴らしいことだ。

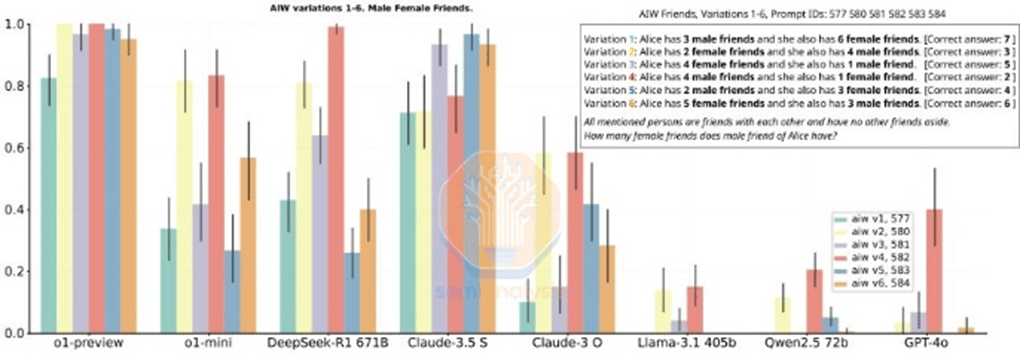

しかし、R1が挙げているベンチマークの中には、次のようなものもある。 紛らわしい.R1がリードしていないベンチマークについて特に言及していないため、R1とo1を比較するのは難しい。R1は推論性能では一致しているが、すべての指標で明確な勝者ではなく、多くの場合o1よりも劣っている。

出典:(さらに)もうひとつの栄枯盛衰の物語。 ディープシークR1

実際、OpenAIは最近、ベンチマークのスケーリングが垂直になっているo3の結果を共有した。「ディープラーニングは壁にぶつかっている」。

出典:AIアクション・サミット

グーグルの推論モデルはR1並み

R1には熱狂的な宣伝の波が押し寄せたが、2.5兆ドル規模の米国企業が1カ月前に、より安価な推論モデルを発表した。 ジェミニ Flash 2.0は、モデルが利用可能であり、APIを介してアクセス可能である。 R1よりはるかに安い。たとえモデルのコンテキストの長さの方が大きくても。

Flash 2.0 Thinkingは、報告されているベンチマークではR1に勝っているが、ベンチマークがすべてを語っているわけではない。とはいえ、グーグルのモデルは堅牢であり、多くの点でR1と競合できると思われるが、誇大広告の対象にはなっていない。これは、グーグルの市場参入戦略の欠如とユーザーエクスペリエンスの低さが原因かもしれないが、R1は中国でも驚きを与えた。

出典:セミアナリシス

はっきり言って、ディープシークの素晴らしさを損なうものではない。ディープシークは、急成長し、十分な資金を持ち、頭が良く、集中力のある新興企業である。 メタ と他の巨人には称賛に値する理由がある。

技術的業績

DeepSeekはコードを解読し、主要ラボがまだ実現していないイノベーションを解き明かした。リリースされたディープシークの改良は、欧米のラボですぐに再現されるものと期待している。

これらの改善点とは?アーキテクチャー上の成果のほとんどは、R1のベースモデルでもあるV3に特化したものだ。これらの革新的な技術について詳しく説明しよう。

トレーニング(トレーニング前後)

DeepSeek V3は、前例のないスケールを持つ複数台のカメラを活用している。 トークン 予測(MTP)は、単一のトークンではなく、次の数トークンを予測するアテンションモ ジュールを追加したものである。これは、より少ない計算量で性能向上を達成するアルゴリズムの革新の一例です。

トレーニングにおけるFP8の精度など、他にも注意点はあるが、米国の主要ラボは以前からFP8のトレーニングを行っている。

MoE モデルが直面する課題の 1 つは、どのトークンがどのサブモデルまたは「エキスパート」に渡 るかを決定する方法です。DeepSeek は、モデルのパフォーマンスに影響を与えることなく、トークンを適切なエキスパートに バランスよくルーティングする「ゲートネットワーク」を実装しています。これは、ルーティングが非常に効率的であり、各トークンがトレーニング中に変更するパラメータは、モデル全体のサイズに対してわずかであることを意味します。これにより、トレーニング効率が向上し、推論コストが低くなる。

ハイブリッド・エキスパート(MoE)による効率向上が投資を減らすかもしれないという懸念にもかかわらず、ダリオは、より強力なAIモデルの経済性は非常に大きいため、節約された分はより大きなモデルの構築にすぐに再投資されると指摘する。これらの企業は、モデルをより多くの計算に拡張し、アルゴリズムによってより効率的にすることに重点を置いている。

R1の場合、強化学習(RL)の恩恵もあり、強力なベースモデル(v3)を持っている。強化学習(RL)には、フォーマッティング(首尾一貫した出力を確実にすること)と有用性・無害性(モデルが有用であることを確実にすること)という2つの主眼がある。推論力は、モデルの微調整中に合成データセット上で出現する。これはスケーリング法則の記事にあるようにこれがo1で起こったことだ。R1の論文には計算についての言及がないことに注意してほしい。これは、どれだけの計算が使われたかを言及すると、彼らの説明から想像されるよりも多くのGPUがあったことを示してしまうからだ。この規模のRLでは、特に合成データを生成するために多くの計算が必要となる。

加えて、DeepSeekが使用しているデータの一部はOpenAIのモデルから来ているようであり、出力からの抽出戦略にも影響があると思われる。これはすでにTOSで違法とされているが、今後を考えると、KYC(Know Your Customer)の一形態として抽出をブロックすることが新たなトレンドになるかもしれない。

抽出といえば、おそらくR1の論文で最も興味深いのは、推論モデルからの出力を使って非推論ミニモデルを微調整し、推論モデルに変換する機能だろう。データセット管理には合計80万サンプルが含まれており、誰でもR1のCoT出力を使って独自のデータセットを作り、その出力を使って推論モデルを作ることができるようになった。今後、推論機能を発揮する小型モデルが増え、小型モデルの性能が向上することが期待される。

マルチレベル・アテンション(MLA)

MLAは、DeepSeekの推論価格の大幅な削減につながった重要なイノベーションです。その理由は、標準的なアテンションと比較して、MLAはクエリごとに必要なKVキャッシュの量を約 93.3%KVキャッシュは 変圧器 ダイアログのコンテキストを表すデータを保存するためのモデルのメモリメカニズム。

スケーリング法則の記事で説明したように、KVキャッシュはダイアログコンテキストが大きくなるにつれて大きくなり、かなりのメモリ制限が生じます。クエリごとに必要なKVキャッシュの量を大幅に削減すれば、クエリごとに必要なハードウェアの量が減り、コストを削減できます。しかし、我々は、DeepSeekが実際にお金を稼ぐことなく市場シェアを獲得するために、推論をコストで提供していると考えている。google Gemini Flash 2 Thinkingの方がまだ安く、Googleがコストで提供する可能性は低い。MLAは2024年5月にリリース予定のDeepSeek V2に搭載されている。また、DeepSeekは、H20の方がメモリ帯域幅と容量が大きいため、H100に比べてH20の方が推論ワークロード効率が高い。ファーウェイとの提携も発表されたが、今のところアセンド・コンピューティングに関する取り組みはほとんどない。

我々が最も興味深いと思うのは、特に利益率への影響と、これがエコシステム全体にとって何を意味するかである。以下では、AI業界全体の将来の価格構造を概観し、ディープシークが価格を補助していると考える理由と、ジェボンズ・パラドックスの初期の兆候が見られる理由を詳しく説明します。また、輸出規制への影響や、ディープシークの優位性が高まるにつれてCCPがどのように反応するかなどについてもコメントしています。

© 著作権表示

記事の著作権 AIシェアリングサークル 無断転載はご遠慮ください。

関連記事

コメントはありません