はじめに

Laminarは、第一原理からのAIエンジニアリングに焦点を当てた、オープンソースのAIエンジニアリング最適化プラットフォームです。LLM(大規模言語モデル)アプリケーションの品質を向上させるために、ユーザーがデータを収集、理解、利用することを支援します。Laminarは、包括的な観測可能性、テキスト分析、評価、キューチェーン管理機能を提供し、複雑なAI製品の構築と最適化をサポートします。データ追跡、オンライン評価、データセット構築など、Laminarはユーザーが効率的なAI開発と展開を実現するための強力なサポートを提供します。

Rust、RabbitMQ、Postgres、Clickhouseなどを含む最新のオープンソース・テクノロジースタックにより、高いパフォーマンスと低いオーバーヘッドを保証します。ユーザはDocker Composeを使って素早くデプロイすることも、ホストされたプラットフォームを使ってフル機能を楽しむこともできます。

デモ:https://www.lmnr.ai/

機能一覧

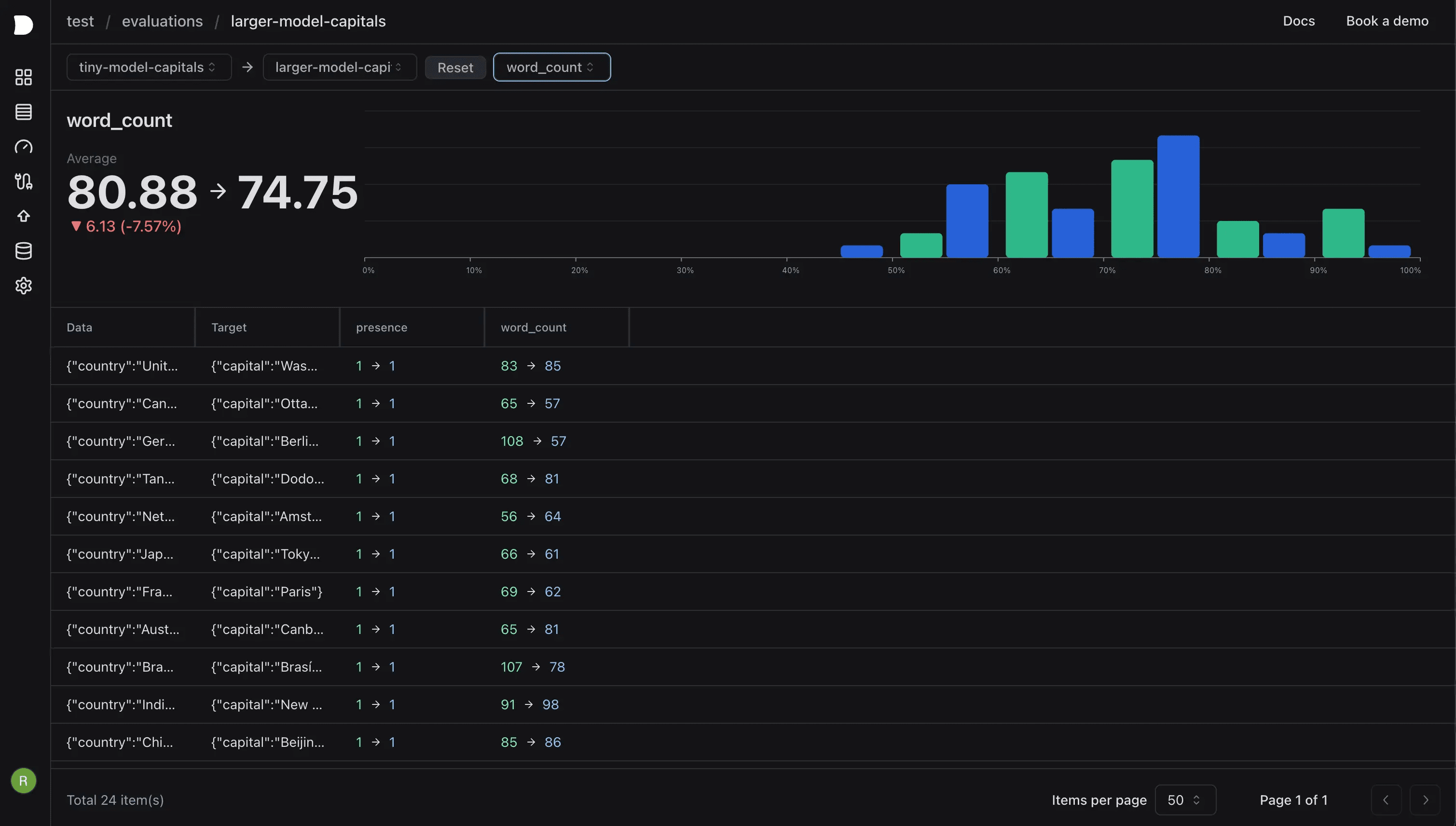

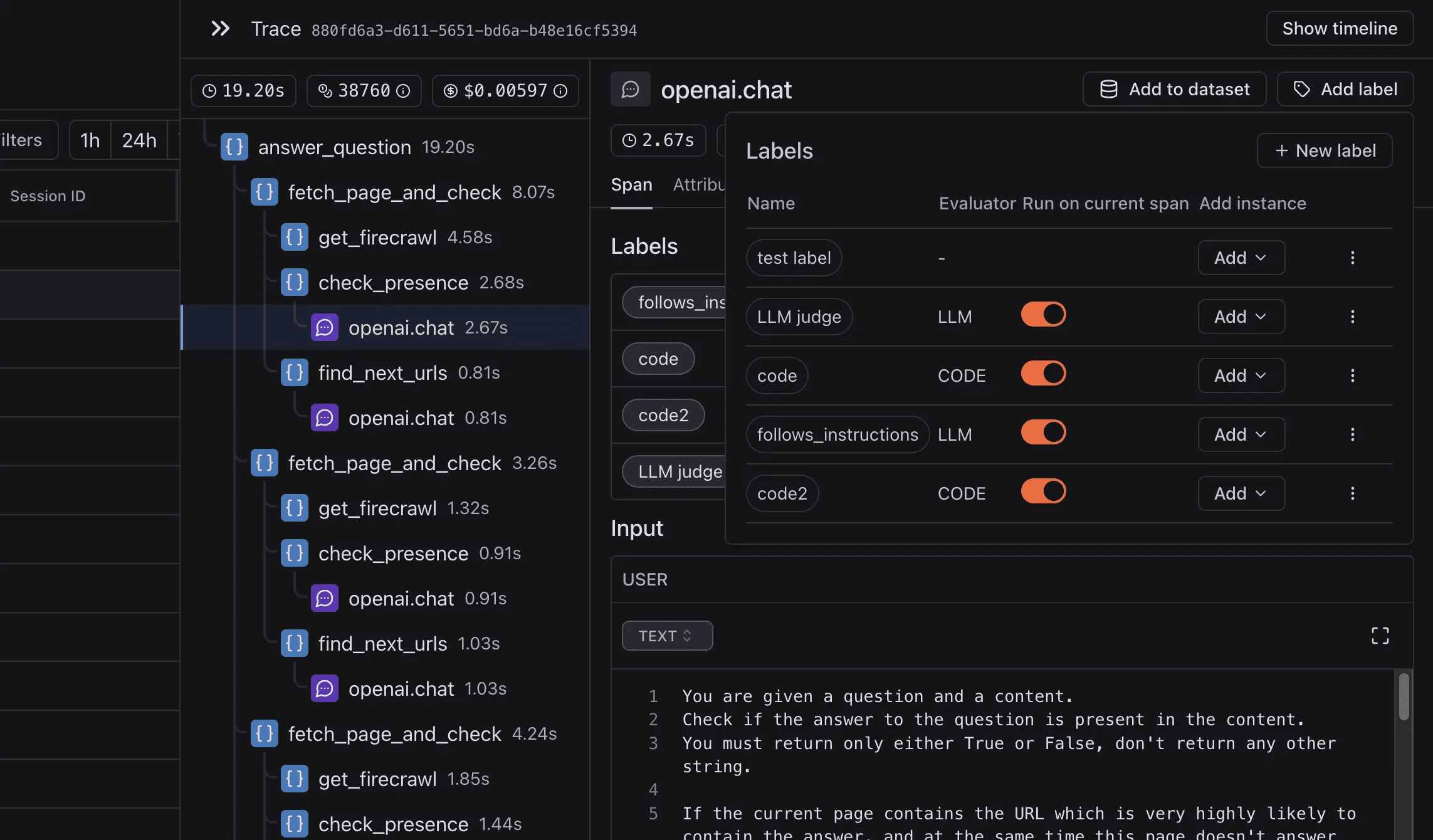

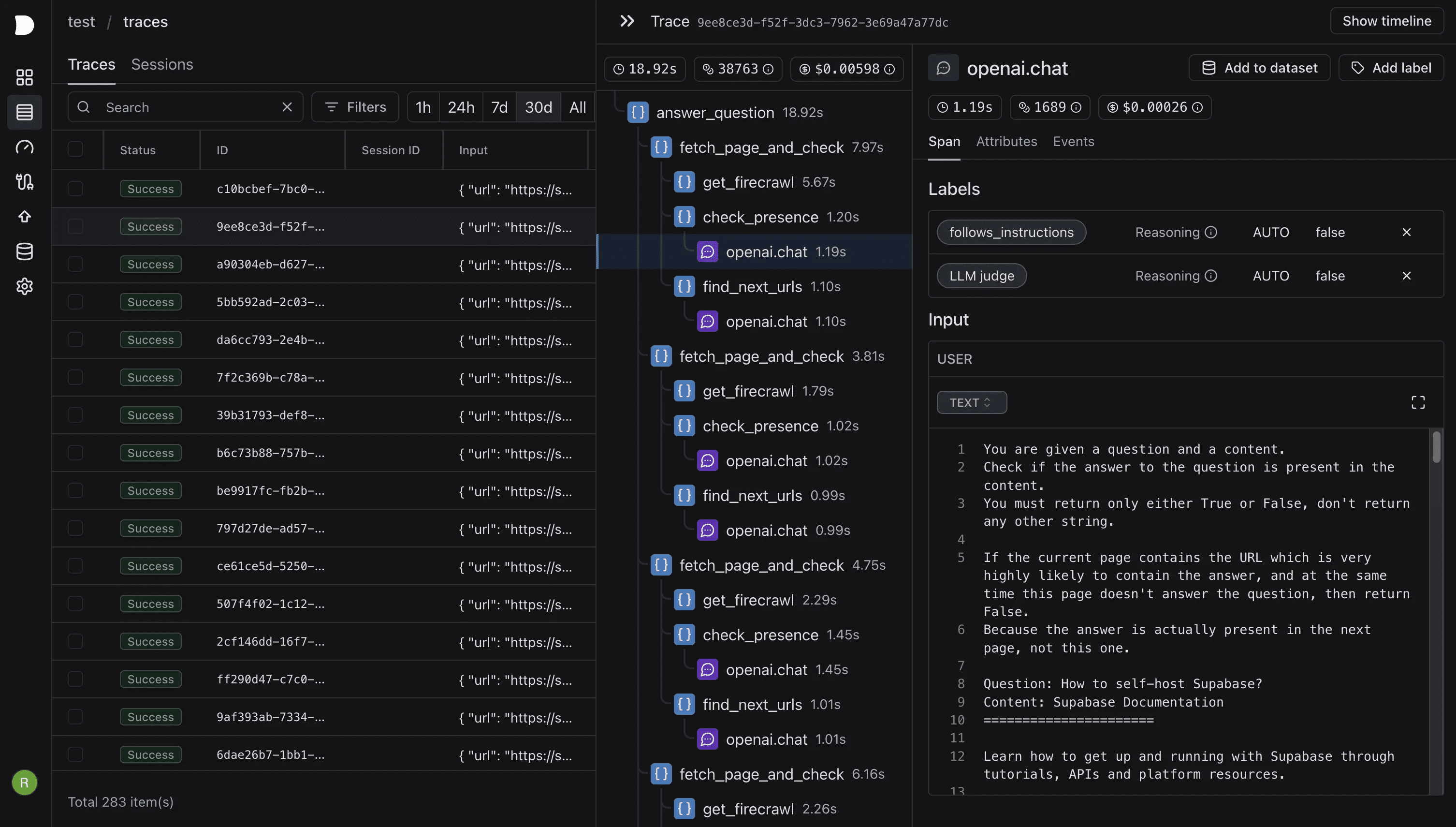

- データトラッキングLLMアプリケーションの実行の各ステップを記録し、より良い評価と微調整のための貴重なデータを収集する。

- オンライン評価: LLMを評価者として設定するか、Pythonスクリプトの評価者を使用して、受信したスパンごとに評価する。

- データセットの構築トラッキングデータからデータセットを構築し、エンジニアリングを評価、微調整、促進する。

- キュー・チェーン・マネジメントエージェントハイブリッドや自己再帰的LLMパイプラインを含む、複雑なキューチェーンの構築とホスティングをサポート。

- オープンソースとセルフホスト完全なオープンソースで、簡単にセルフホスティングでき、いくつかのコマンドを実行するだけですぐに使える。

ヘルプの使用

設置プロセス

- GitHubリポジトリのクローン:

git clone https://github.com/lmnr-ai/lmnr - プロジェクト・カタログにアクセスする:

cd lmnr - Docker Composeを始めました:

docker compose up -d

機能操作ガイド

データトラッキング

- 初期化コードにLaminarをインポートし、プロジェクトのAPIキーを初期化します。

from lmnr import Laminar, observe Laminar.initialize(project_api_key="...") - コメント機能使用

オブザーブトレースが必要な関数に注釈を付ける。オブザーブ() def my_function(): ...

オンライン評価

- 評価者の設定LLMは、審査員として機能するようにセットアップすることもできるし、Pythonスクリプトの評価ツールを使って、受信したスパンを評価し、採点することもできる。

# コード例 evaluateator = LLMJudge() evaluator.evaluate(スパン)

データセットの構築

- データセットの作成追跡データからデータセットを構築し、その後の評価や微調整に役立てる。

dataset = create_dataset_from_traces(traces)

キュー・チェーン・マネジメント

- キューチェーンの構築エージェントミキシングや自己反映型LLMパイプラインを含む複雑なキューチェーンの構築をサポート。

chain = PromptChain() chain.add_prompt(プロンプト)

自ホスト

- セルフステップDockerとDocker Composeがインストールされていることを確認してください。

git clone https://github.com/lmnr-ai/lmnr cd lmnr docker compose up -d