ジェンモ AIは、最先端のオープンソース動画生成モデルの開発に特化した最先端の人工知能研究所である。その主力製品であるMochi 1は、テキストキューから高品質の動画を生成できるオープンソースの動画生成モデルである。Genmoの目標は、動画生成技術を通じて人工知能のイノベーションを推進し、バーチャルな探索と創造に無限の可能性を提供することである。

Modelsは映像生成モデルのオープンソースライブラリで、最新のMochi 1モデルを搭載しています。 Mochi 1は非対称拡散に基づいています。 変圧器 (AsymmDiT)アーキテクチャは、10億個のパラメータを持ち、一般に公開されている動画生成モデルとしては最大規模である。このモデルは、テキストの合図に反応する高品質で滑らかなアクション動画を生成することができる。

Mochi 1 Previewは、忠実な動きと強力なキュー・フォローを備えたオープンな先進映像生成モデルです。私たちの新しいモデルは、クローズドな映像生成システムとオープンな映像生成システムのギャップを大きく埋めるものです。私たちは、このモデルを自由なApache 2.0ライセンスの下でリリースする予定です。

餅1号試写会アドレス

機能一覧

- ビデオ・ジェネレーションテキストプロンプトを入力することで、高品質のビデオコンテンツを生成します。

- オープンソースモデルMochi 1はオープンソースモデルとして提供され、ユーザーによる個別適合や二次開発を可能にしている。

- 忠実なモーションクオリティスムーズなモーションと忠実な物理処理でビデオを生成します。

- 強力なキュー・アライメントテキストプロンプトに基づき、ユーザーのニーズに正確にマッチしたビデオを生成する機能。

- 地域支援生成されたビデオコンテンツをユーザーが共有し、議論できるコミュニティプラットフォームを提供する。

- マルチプラットフォーム対応ウェブやモバイルデバイスを含むマルチプラットフォームでの使用をサポート。

餅1号モデル建築

Mochi 1は、私たちの新しい非対称拡散変換器(AsymmDiT)アーキテクチャに基づいた100億パラメータの拡散モデルで、オープンソースのビデオ生成における重要な進歩を象徴しています。完全にスクラッチからトレーニングされたこのモデルは、これまでに公開されたビデオ生成モデルの中で最大規模です。最も重要なことは、シンプルでハッキング可能なアーキテクチャであるということです。

効率性は、コミュニティが我々のモデルを確実に実行できるようにするために非常に重要です。Mochiに加え、私たちはビデオVAEもオープンソース化しました。これは、8x8のスペースと6倍の時間圧縮を使用して、潜在的なスペースの12チャンネルにビデオを128倍のサイズに圧縮します。

AsymmDiT は、テキスト処理を単純化し、ニューラルネットワークの能力を視覚的推論に集中させることで、ユーザーキューと圧縮ビデオマーカーを効率的に処理します。AsymmDiT は、マルチモーダル自己注意メカニズムを使用して、テキストと視覚マーカーに共同で焦点を当て、Stable Diffusion と同様に、各モダリティに対して個別のMLPレイヤーを学習します3。は、視覚ストリームに対するパラメータがテキストストリームに対するパラメータのほぼ4倍になる。自己注意メカニズムにおいてモダリティを統一するために、我々は非対称QKVと出力投影層を使用する。この非対称設計により、推論に必要なメモリが削減される。

最近の伝播モデルの多くは、ユーザーからのプロンプトを表現するために、事前に訓練された複数の言語モデルを使用する。これに対して、Mochi 1は、単一のT5-XXL言語モデルのみを用いてキューをエンコードする。

Mochi 1は、44,520個のビデオマーカーからなるコンテキストウィンドウを共同推論するために、完全な3次元注意メカニズムを使用する。各マーカーをローカライズするために、学習可能な回転位置埋め込み(RoPE)を3次元に拡張する。ネットワークは空間軸と時間軸の周波数を混合したものをエンドツーエンドで学習する。

Mochiは、SwiGLUフィードフォワードレイヤー、安定性向上のためのクエリーキー正規化、内部活性化を制御するためのメザニン正規化など、言語モデル拡張における最新の改良の恩恵を受けている。

技術論文では、ビデオ生成の進歩を促進するために、より詳細な情報を提供する予定である。

餅1号設置の流れ

- クローン倉庫 ::

ギット クローン https://github.com/genmoai/models

cd モデル

- 依存関係のインストール ::

pip install uv

uv venv .venv

ソース .venv/bin/activate

uv pip install -e .

- モデルウェイトのダウンロード Hugging Faceから、またはマグネットリンクからウェイトファイルをダウンロードし、ローカルフォルダに保存してください。

使用プロセス

- ユーザーインターフェースの起動 ::

python3 -m mochi_preview.gradio_ui --model_dir ""

相互互換性とする。はモデルの重みが置かれているディレクトリです。

- コマンドラインによるビデオ生成 ::

python3 -m mochi_preview.infer --prompt 「桃色を背景に、レモンとミントの小枝で満たされた木製のボウルから、繊細な指の手が鮮やかな黄色のレモンをつまみ上げる。ボウルの横にはベージュの紐付き袋が置かれ、素朴なタッチを添えている。ボウルの底には、半分に切ったレモンが散りばめられている。 均一な照明が鮮やかな色彩を引き立て、爽やかで魅力的な雰囲気を醸し出している。均一な照明が鮮やかな色を引き立て、新鮮で心地よい雰囲気を作り出している。" --seed 1710977262 --cfg_scale 4.5 --model_dir ""

相互互換性とする。はモデルの重みが置かれているディレクトリです。

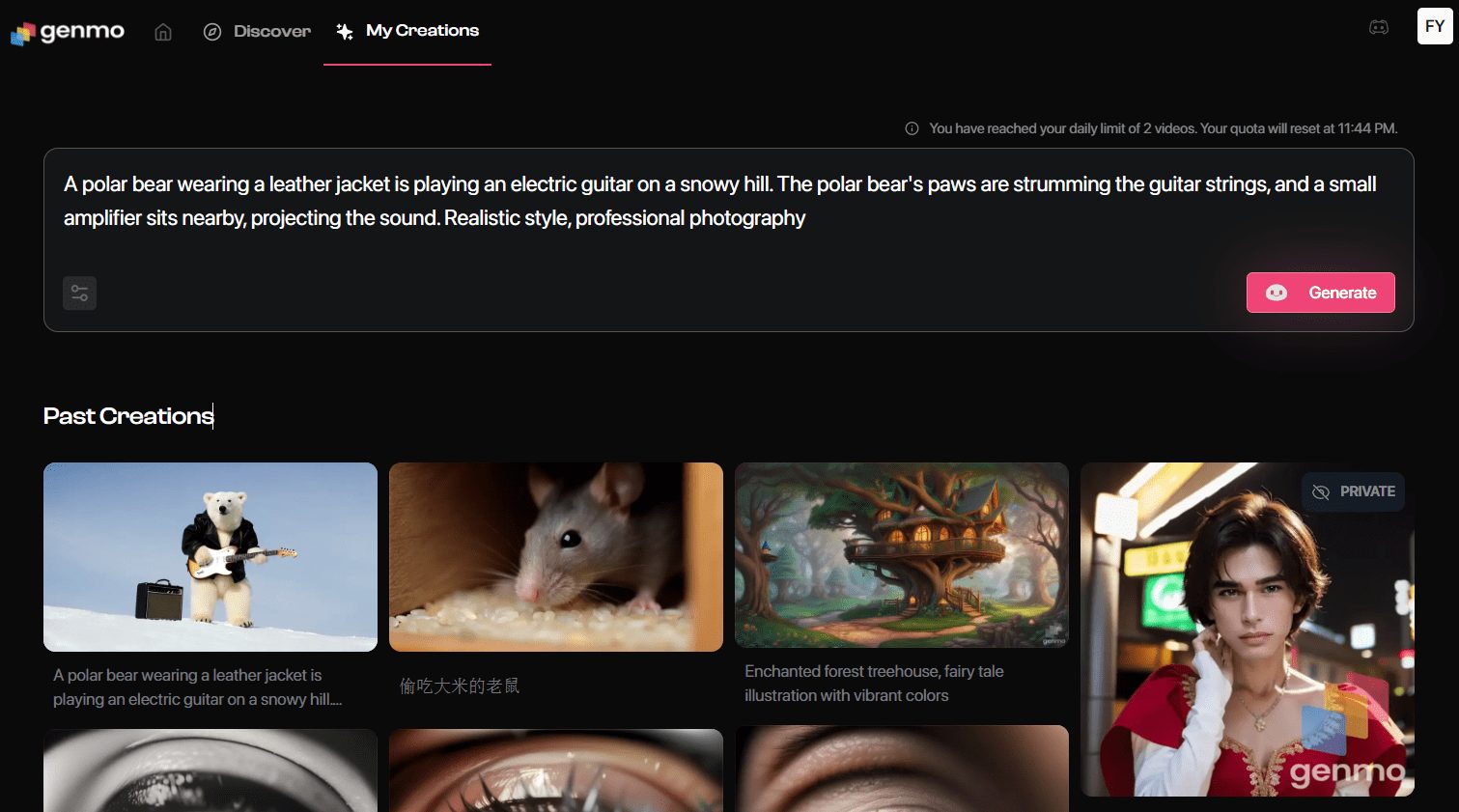

オンラインで餅つき体験

- 世代別ページへログイン後、"Playground "をクリックし、ビデオ生成ページに入ります。

- 入力プロンプトプロンプトボックスに生成したいビデオの説明を入力してください。例:「赤いウールのバイクヘルメットをかぶった30歳の宇宙飛行士の冒険の予告編」。

- セッティングの選択必要に応じてビデオスタイル、解像度、その他の設定を選択します。

- ビデオの作成Generate "ボタンをクリックすると、あなたの指示に従ってビデオが生成されます。

- ダウンロード&シェア生成されたビデオは、プレビューしてローカルにダウンロードすることも、ソーシャルメディアに直接共有することもできます。

高度な機能

- カスタムモデルMochi 1のモデルウェイトをダウンロードし、ローカルでトレーニングやチューニングを行い、パーソナライズすることができます。

- 地域社会との交流: GenmoのDiscordコミュニティに参加して、他のユーザーと経験を交換したり、生成されたビデオを共有しましょう。

- APIインターフェース開発者は、Genmoが提供するAPIインターフェイスを使用して、ビデオ生成機能をアプリケーションに統合することができます。

一般的な問題

- ビデオ生成の失敗入力するプロンプト文は、曖昧で複雑な記述を避け、明確で具体的なものにすること。

- ログインの問題ログインできない場合は、インターネット接続を確認するか、別のブラウザをお試しください。

- モデルダウンロードGenmoのGitHubページで最新のMochi 1モデルのウェイトをダウンロードしてください。