はじめに

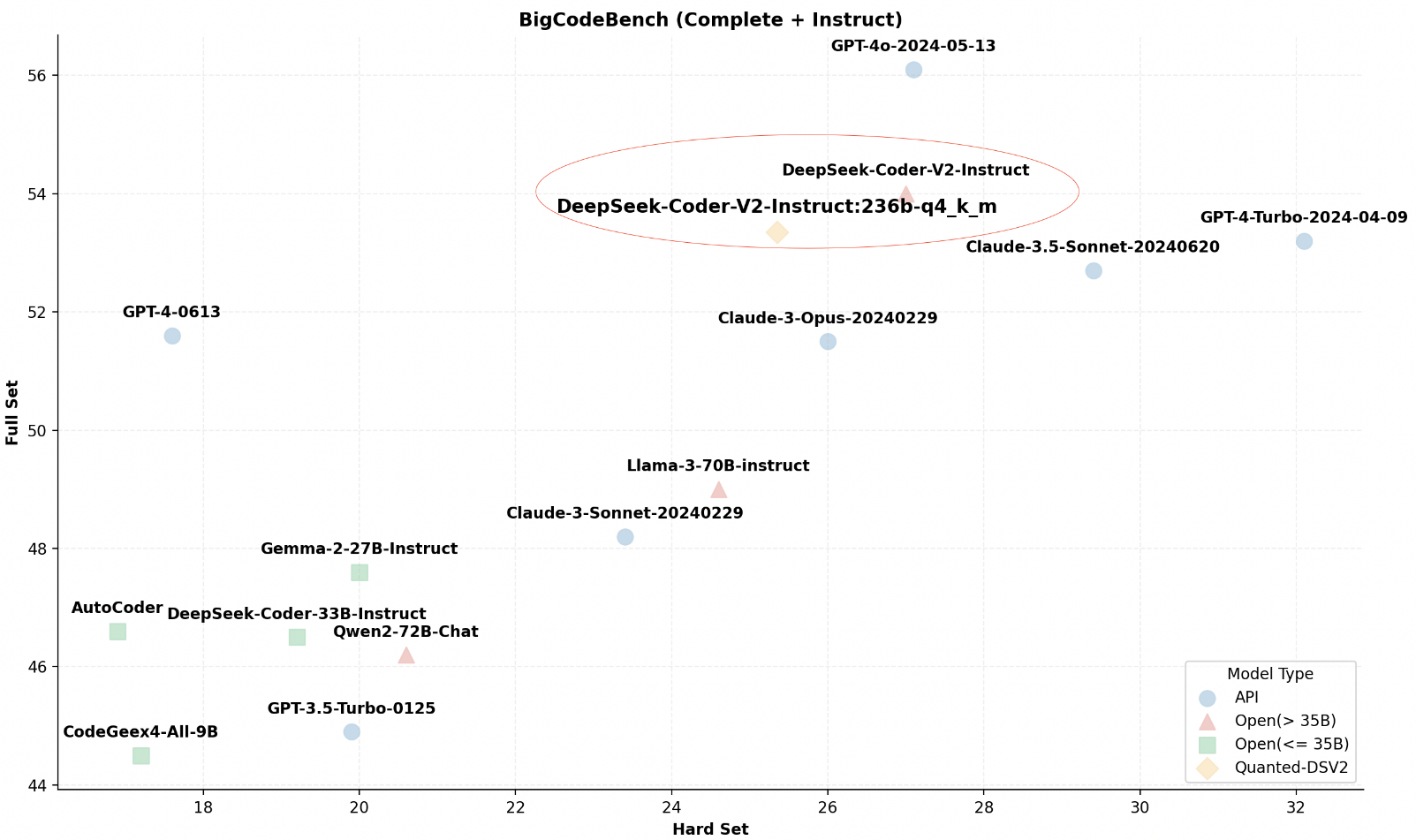

KTransformers:大規模モデル推論のボトルネックを克服するために設計された高性能Pythonフレームワーク。 KTransformersは、単なるモデル実行ツールではなく、極めて優れたパフォーマンス最適化エンジンと柔軟なインターフェース強化プラットフォームのセットです。 KTransformersは、高度なカーネル最適化、強力な並列化戦略(マルチGPU、スパースアテンション)、およびその他のコアテクノロジーを通じて、モデル推論速度を大幅に高速化し、ハードウェアの敷居を下げることで、大規模モデル推論の効率をボトムアップから改善することに専念しています。

単にモデルを実行するだけでなく、KTransformersはあらゆるパフォーマンスの向上とアプリケーションのスケーラビリティを提供します。 既存のプロジェクトをシームレスに移行するためのネイティブなTransformers互換インターフェイスを手に入れるだけでなく、OpenAIに準拠したアプリケーションを簡単に構築することができます。 オーラマ 標準のRESTful APIサービスにより、あらゆる種類のアプリケーションに迅速に統合できます。 また、すぐに使える チャットGPT 面倒な設定をすることなく、モデル効果を素早く体験し、テストできるスタイルのウェブ・インターフェイス。

KTransformersは、より高いパフォーマンスを求めるユーザーのために設計されています。 究極の推論速度を求める開発者、大規模モデル・アプリケーションを効率的に展開する必要のあるエンジニア、あるいは高性能な大規模モデルをローカルで簡単に体験したいユーザーなど、KTransformersは、革新的なアプリケーションを推進する大規模モデルの可能性を最大限に引き出す強力なサポートを提供します。

核となる強み:

- 極限のパフォーマンス: カーネルレベルの最適化と並列戦略がもたらすもの桁違いに速い推論.

- 柔軟なインターフェース: Transformers準拠のインターフェイス、RESTful API、Webインターフェイス。さまざまなアプリケーション・シナリオのニーズに対応.

- 幅広い互換性: 複数のGPU、複数のCPUアーキテクチャ、複数の主流マクロモデルをサポート。幅広いハードウェアとモデリング・オプションに対応.

- 使いやすさはカスタマイズ性と密接な関係にある: 既存すぐに使える利便性こちらも利用可能豊富な設定オプション上級ユーザーの深い最適化ニーズに応える。

機能一覧

- 高性能トランス互換インターフェース トランスフォーマー・ライブラリーとの完全互換インターフェイスを提供します。既存のプロジェクトをゼロコストで移行し、パフォーマンス向上を即座に享受できます!.

- 柔軟で使いやすいRESTful APIサービス OpenAIとOllamaの標準に従う。スケーラブルなAPIサービスを迅速に構築同社の製品は、さまざまなアプリケーションやプラットフォームに簡単に統合できるように設計されている。

- すぐに使えるChatGPTスタイルのウェブ・インターフェイス フレンドリーかつインタラクティブなインターフェイスを提供。コードゼロでモデルのパフォーマンスを素早く体験、テストデモや検証を簡単に行うことができる。

- マルチGPU並列コンピューティングエンジン :: 複数のGPUのパワーを解き放つ推論速度は直線的に向上し、応答時間は劇的に短縮される。

- カーネルレベルの性能最適化 高度なカーネル最適化技術を使用。ボトムアップでハードウェアの可能性を引き出すモデル推論性能の質的飛躍を達成した。

- インテリジェント・スパース・アテンション・フレームワーク ブロック・スパース・アテンション・メカニズムをサポート。メモリフットプリントを大幅に削減で、CPU効率の良いデコードをサポートしている。ハードウェアのボトルネックを打破する.

- 大規模モデルのための広範な生態学的サポート InternLM、DeepSeek-Coderなどに対応。主力大型モデルの数々 (連続拡張中)。最適なモデリングソリューションを柔軟に選択できる.

- 軽量ローカル高性能推論 高価な専用ハードウェアは必要ない。一般的なデスクトップ環境での優れた推論パフォーマンス使用への敷居が低くなる。

ヘルプの使用

取り付け

- クローン倉庫 ::

git clone https://github.com/kvcache-ai/ktransformers.git

cd ktransformers

- 依存関係のインストール ::

pip install -r requirements-local_chat.txt

- Kトランスフォーマーの設置 ::

python setup.py インストール

はじめに

- 積載モデル ::

from ktransformers import KTransformers

model = KTransformers(model_name="your_model_name")

- 推論の例 ::

input_text = "こんにちは、KTransformers!"

出力 = model.infer(input_text)

print(output)

- RESTful APIを使う APIサービスを開始します:

python -m ktransformers.api

リクエストを送信

curl -X POST "http://localhost:8000/infer" -d '{"text": "こんにちは、KTransformers!"}'

高度な機能

- マルチGPUサポート プロジェクトのルート・ディレクトリにある設定ファイルを編集する。

config.yaml推論速度を向上させるために、マルチGPU設定を指定します。 - 注意力不足 プロジェクトのルート・ディレクトリにある設定ファイル

config.yaml特にリソースに制約のある環境において、メモリ使用量を最適化するためのスパース・アテンション設定を追加。 - 局所推論 プロジェクトのルート・ディレクトリにある設定ファイル

config.yaml24GBのVRAMと150GBのDRAMをサポートし、ローカルデスクトップ環境で効率的な推論を行うために、メモリとビデオメモリのパラメータを指定します。

コンフィギュレーション詳細

- 複数のGPUを設定する 設定ファイルの編集

config.yaml::

gpu.

- id: 0 # GPU デバイス・インデックス 0

- id: 1 # GPU デバイス・インデックス 1

- 疎な注意を可能にする 設定ファイルに追加する:

注意

タイプ:疎

- ローカル推論設定 コンフィギュレーションファイルでメモリとビデオメモリのパラメータを指定します:

メモリ

vram: 24GB #メモリ制限(GB)、実際の状況に応じて調整。

ドラマ:150GB #メモリ制限(GB)、実際の状況に応じて調整します。