ColBERT(Contextualised Post-Cultural Interaction based on BERT)は、従来の濃密な埋め込みモデルとは異なる。以下は、ColBERT がどのように機能するかについての簡単な説明である:

- トークン層の埋め込み文書全体またはクエリ全体に対して直接個々のベクトルを作成するのとは異なり、ColBERT は、各クエリに対 して単一のベクトルを作成する。 トークン 埋め込みベクトルを作成する。

- ポストインタラクションクエリとドキュメントの類似度を計算する場合、全体のベクトルを直接比較するのではなく、各クエリトークンを各ドキュメントトークンと比較する。

- MaxSimオペレーション各クエリのトークンについて、ColBERT は文書内の任意のトークンとの最大類似度を見つけ、それを合計して類似度スコアを得る。

注釈: https://github.com/adithya-s-k/AI-Engineering.academy/tree/main/RAG/10_ColBERT_RAG

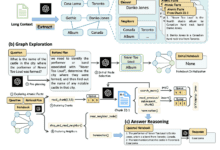

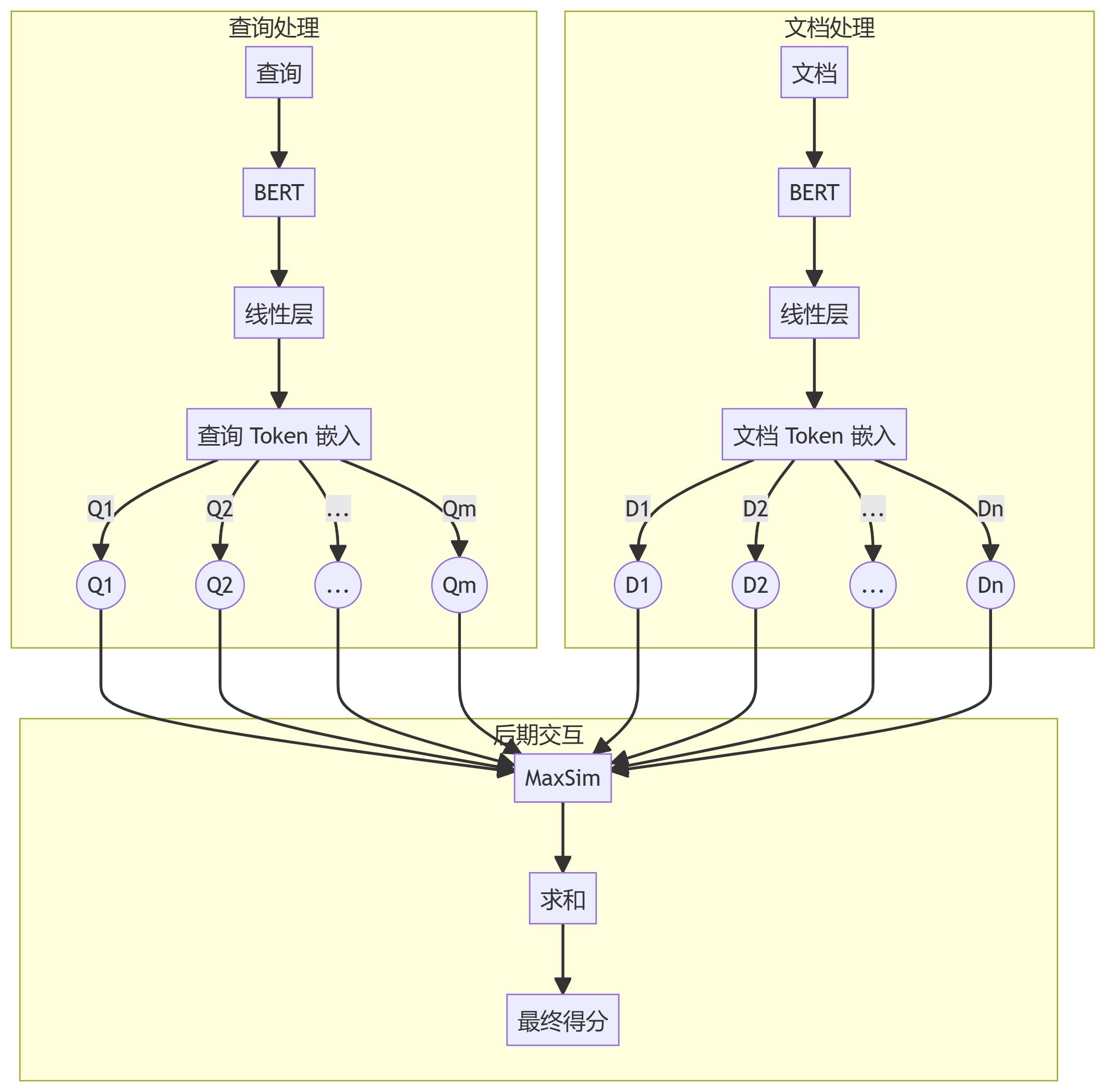

次のステップは、ColBERTがどのように使用されるかを、図解を交えて詳細に示すことである。 ラグ トークン・レベルの処理とポスト・インタラクション・メカニズムを重視したプロセスで働く。

この図は、ColBERTベースのRAGパイプラインの全体的なアーキテクチャを示しており、ColBERT アプローチにおけるトークンレベルの処理とポストインタラクションを強調している。

次に、ColBERT のトークン・レベルの埋め込みとポストインタラクション・メカニズムを強調する、 より詳細な図を作成しよう:

この図はそれを示している:

- 文書とクエリは、BERTと線形レイヤーを通して、トークン・レベルの埋め込みとしてどのように処理されるか。

- ポストインタラクションメカニズムにおいて、各クエリトークンが各ドキュメントトークンとどのように比較されるか。

- MaxSim操作とそれに続く合計ステップにより、最終的な相関スコアを生成する。

これらの図は、RAGパイプライン内でColBERTがどのように動作するかをより正確に示しており、そのトークンレベルアプローチとレイトインタラクションメカニズムを強調している。このアプローチにより、ColBERTは、クエリーとドキュメントからより細かい情報を保持することができ、従来の密な埋め込みモデルと比較して、より細かいマッチと潜在的に優れた検索性能をもたらす。

![エージェントAI:マルチモーダルインタラクションのフロンティアの世界を探る [フェイフェイ・リー - クラシック必読] - チーフAIシェアリングサークル](https://www.aisharenet.com/wp-content/uploads/2025/01/6dbf9ac2da09ee1-220x150.png)