挙げる

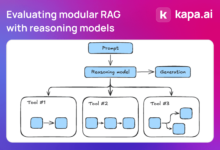

Self-Query RAG (SQRAG)は、取り込み段階でメタデータ抽出を導入し、検索段階でインテリジェントなクエリ解析を行うことで、従来のRAGを強化する先進的な検索拡張生成(RAG)アプローチである。 ラグ プロセス

https://github.com/adithya-s-k/AI-Engineering.academy/tree/main/RAG/07_Self_Query_RAG

機関車

従来のRAGシステムは、意味的類似性と特定のメタデータ制約を含む複雑なクエリを処理するのに苦労することが多い。自己クエリ型RAGは、メタデータを活用し、大規模言語モデル(LLM)を使用してユーザーのクエリをインテリジェントに解析することにより、これらの課題に対処する。

方法論の詳細

ドキュメントの前処理とベクトルストアの作成

- 文書を管理しやすいかたまりに分割する。

- 各チャンクからメタデータ(日付、著者、カテゴリーなど)を抽出する。

- 適切な埋め込みモデルを使って各ナゲットを埋め込む。

- ナゲット、埋め込みベクトル、関連するメタデータをベクトルデータベースにインデックス化する。

自己照会型RAGワークフロー

- ユーザーは自然言語によるクエリを送信する。

- 大規模言語モデル(LLM)を使用してクエリを解析し、ユーザーの意図とクエリ構造を理解する。

- LLM世代:

a) クエリに基づくメタデータのフィルタリング条件。

b) コンテンツ関連検索のためのセマンティック検索クエリ。 - メタデータフィルタを適用して検索を絞り込む。

- フィルタリングされた部分集合に対してセマンティック検索を実行します。

- 検索された文書チャンクは、元のユーザークエリと組み合わされてコンテキストを形成する。

- コンテキストをラージ・ランゲージ・モデル(LLM)に渡し、最終的な答えを生成する。

自己照会型RAGの主な特徴

- メタデータ抽出構造化情報による文書表現の強化

- インテリジェントなクエリ解決LLMを使って、複雑なユーザーのクエリを理解する。

- ハイブリッド検索メタデータフィルタリングとセマンティック検索の組み合わせ。

- フレキシブルなお問い合わせユーザがメタデータの制約を自然言語で暗黙的に指定できるようにする。

この方法の利点

- 検索精度の向上メタデータフィルターは、より関連性の高い文書を絞り込むのに役立ちます。

- 複雑なクエリーの処理コンテンツの類似性とメタデータの制約を含むクエリを解釈し、応答することができます。

- 効率的な検索メタデータのフィルタリングは、セマンティック検索を必要とする文書の数を大幅に減らすことができる。

- 強化されたコンテキストメタデータは、応答生成を向上させる付加的な構造化情報を提供する。

評決を下す

セルフクエリRAGは、メタデータ抽出とインテリジェントなクエリ解析を導入することで、従来のRAGプロセスを強化する。このアプローチは、特に意味的類似性と特定のメタデータ制約を含む複雑なクエリに対して、検索をより正確かつ効率的にする。クエリ理解のために大規模言語モデル(LLM)を活用することで、セルフクエリRAGはAI Q&Aシステムに、より正確で文脈に関連した応答を提供する。