はじめに

Diffbot LLM Reasoning Server は、LLama モデルアーキテクチャに基づいた特別な最適化と改良が施された革新的な大規模言語モデリングシステムです。このプロジェクトの最大の特徴はリアルタイム・ナレッジグラフ(ナレッジグラフ)対検索強化世代(RAG)の技術を組み合わせ、独自のGraphRAGシステムを構築した。Web情報をリアルタイムに抽出・処理するだけでなく、正確な事実の引用と知識検索を行う。このシステムは、Llama 3.1に基づく8Bパラメータモデル(diffbot-small)とLlama 3.3に基づく70Bパラメータモデル(diffbot-small-xl)の2つのバージョンを提供しています。MMLU-Proのような権威あるベンチマークでは、システムは優れた性能を示し、特にリアルタイムデータ処理では、GPT-4やChatGPTを含む主流のモデルを凌駕しています。このプロジェクトは完全にオープンソースであり、ローカル展開とクラウドAPIコールをサポートしているため、開発者は柔軟な使い方ができます。

経験:https://diffy.chat/

機能一覧

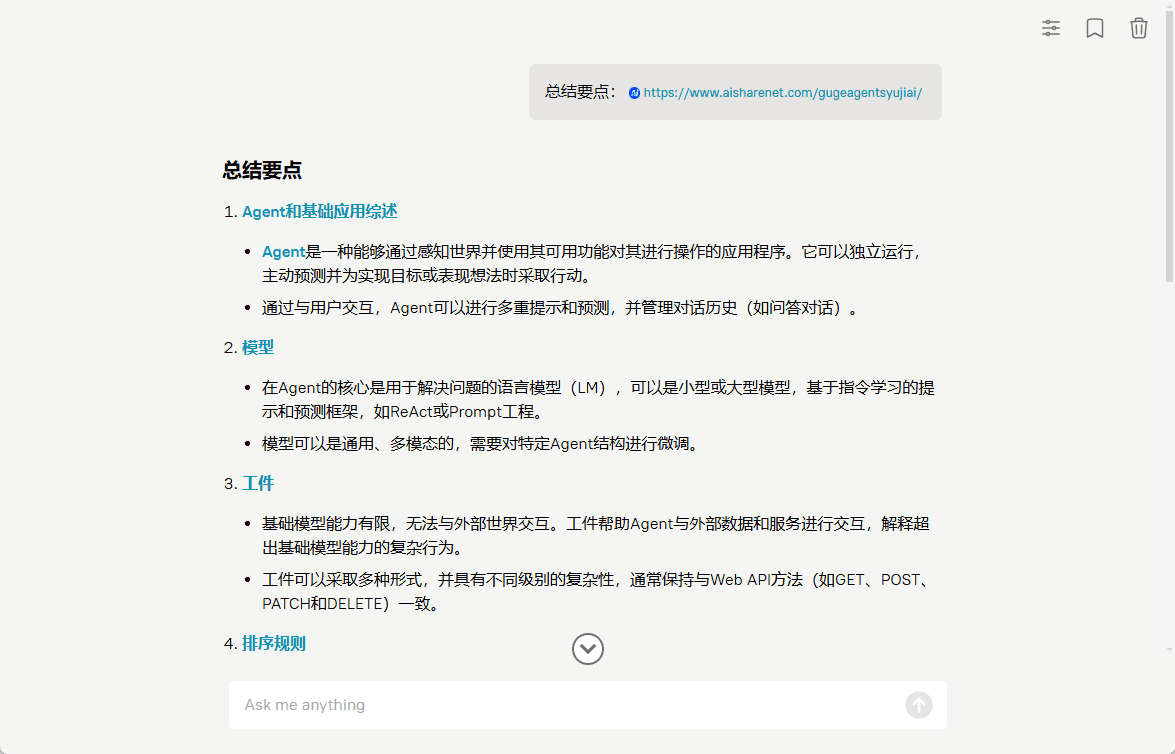

- リアルタイムのウェブページURLコンテンツ抽出と要約

- 知識グラフに基づく正確な事実検索と引用

- Diffbot Knowledge Graph Query Language (DQL) のサポート

- 画像理解力と描写力

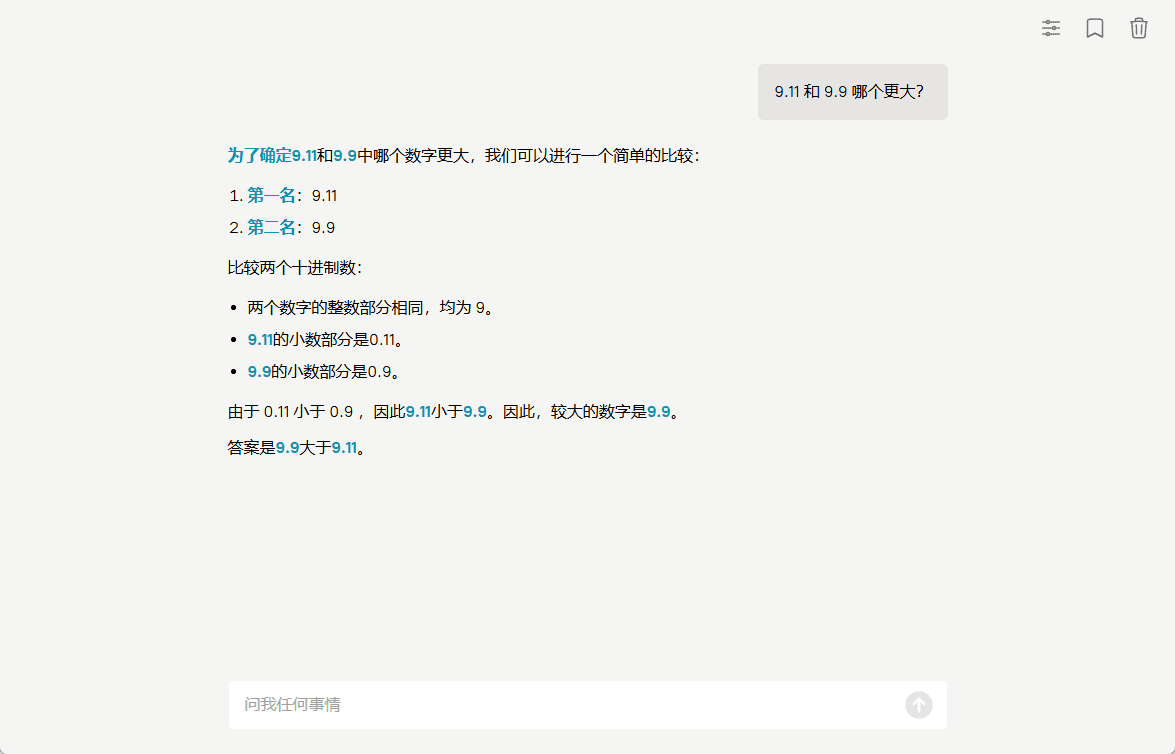

- JavaScriptインタプリタコードの算術関数の統合

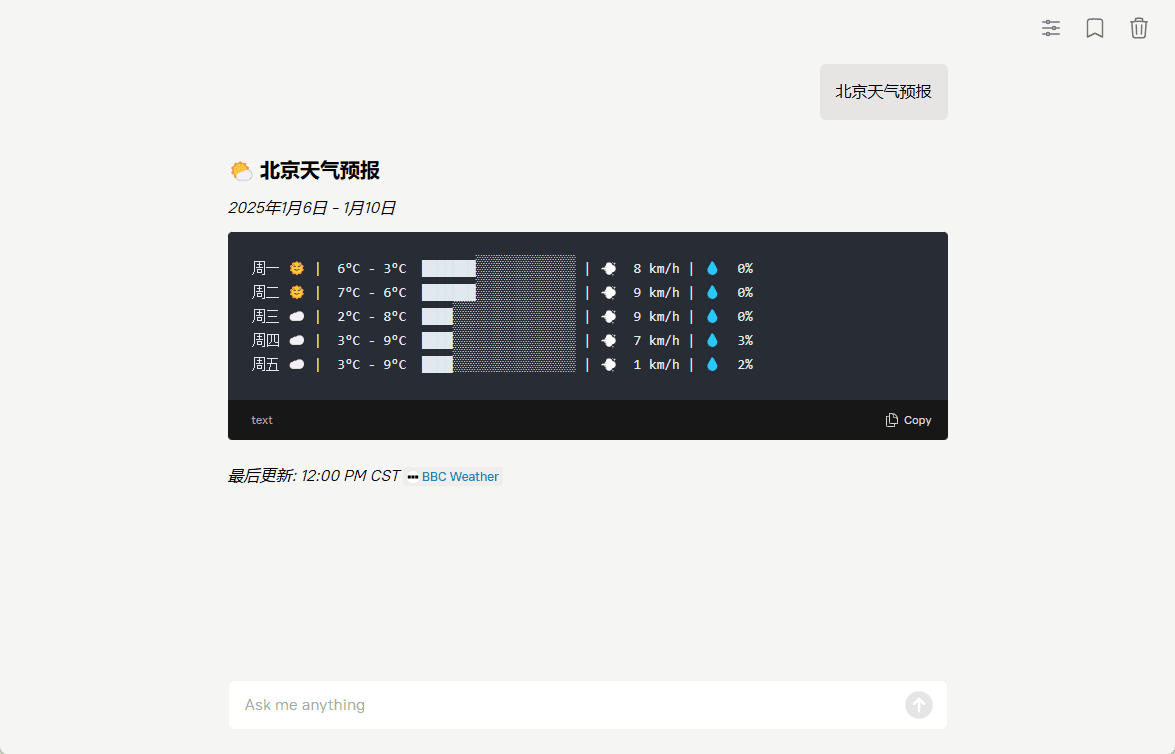

- アスキーアート天気予報

- Dockerコンテナによるデプロイをサポート

- REST API インターフェース・サービスの提供

- カスタムツール・エクステンションのサポート

- 複数のハードウェア構成展開オプションをサポート

ヘルプの使用

1.展開オプション

このシステムには、ローカルデプロイメントとクラウドAPIコールの2つの使用方法がある。

現地での展開プロセス:

- ハードウェア要件を確認:

- diffbot-smallモデル:最低Nvidia A100 40Gグラフィックカードが必要です。

- diffbot-small-xlモデル:最低2枚のNvidia H100 80Gグラフィックカードが必要(FP8フォーマット)

- Dockerのデプロイ手順:

# 1. Dockerイメージをプルする

docker pull docker.io/diffbot/diffbot-llm-inference:latest

# 2. Dockerコンテナを実行する(モデルは自動的にHuggingFaceからダウンロードされる)

docker run --runtime nvidia --gpus all -p 8001:8001 --ipc=host ˶ -e VLLM_OPM

-e VLLM_OPTIONS="--model diffbot/Llama-3.1-Diffbot-Small-2412 --served-model-name diffbot-small --enable-prefix-caching" ୧-͈ᴗ-͈

docker.io/diffbot/diffbot-llm-inference:latest

クラウドAPIの呼び出し:

- アクセス認証情報を取得する:

- https://app.diffbot.com/get-started にアクセスして登録し、無料の開発者トークンを入手してください!

- Pythonコード例:

from openai import OpenAI

クライアント = OpenAI(

base_url = "https://llm.diffbot.com/rag/v1"、

api_key = "あなたのdiffbot_token"

)

# 会話リクエストを作成する

完了 = client.chat.completions.create(

model="diffbot-xl-small"、

model="diffbot-xl-small", temperature=0、

メッセージ=[

{

"role": "user"、

"content": "あなたの質問"

}

]

)

print(完了)

2.コア機能の使用説明

- ウェブページのコンテンツ抽出:

- システムはあらゆるウェブURLをリアルタイムで処理できる

- 重要な情報を自動的に抽出し、サマリーを生成

- 原典引用の完全性の維持

- 知識グラフクエリ:

- ディフボット クエリー言語(DQL)による高精度検索

- 複雑な知識関係クエリをサポート

- リアルタイムで更新されるナレッジベースへのアクセス

- 画像処理能力:

- 画像の理解と説明のサポート

- テキストと組み合わせて、関連する画像分析を生成できる

- コード解釈機能:

- JavaScriptインタプリタ内蔵

- リアルタイムの数学計算をサポート

- 単純なプログラム・ロジックを処理できる

3.カスタムツール・エクステンション

新機能を拡張するには、プロジェクトのadd_tool_to_diffbot_llm_inference.mdドキュメントを参照し、カスタムツールを追加する手順に従ってください。