2024年を振り返ると、大きなモデルは日々変化し、何百もの知的体が競争している。AI応用の重要な一翼を担うRAGもまた「群雄割拠」である。年初はModularRAGが熱を帯び続け、GraphRAGが輝き、中盤はオープンソースツールが本格化し、ナレッジグラフが新たな可能性を生み出し、年末はグラフ理解とマルチモーダルRAGが新たな旅立ちを迎え、まるで「あなたが歌い、私が登場する」ような、奇想天外なテクニックが出てくるなど、枚挙にいとまがない!

2024年の代表的なRAGシステムや論文を選び(AIの注釈、出典、サマリー情報付き)、巻末にRAGの概要とテストベンチマークの資料を掲載し、16,000字に及ぶ本稿を実施することで、RAGを素早く攻略する一助としたい。

RAG七十二ンスタイル」と強く呼ばれる72の記事の全文を、月ごとにアウトラインとして提供する。

備考

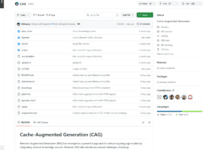

この記事の内容はすべて、オープンソースのリポジトリAwesome-RAGにホストされている。

GitHubアドレス:https://github.com/awesome-rag/awesome-rag

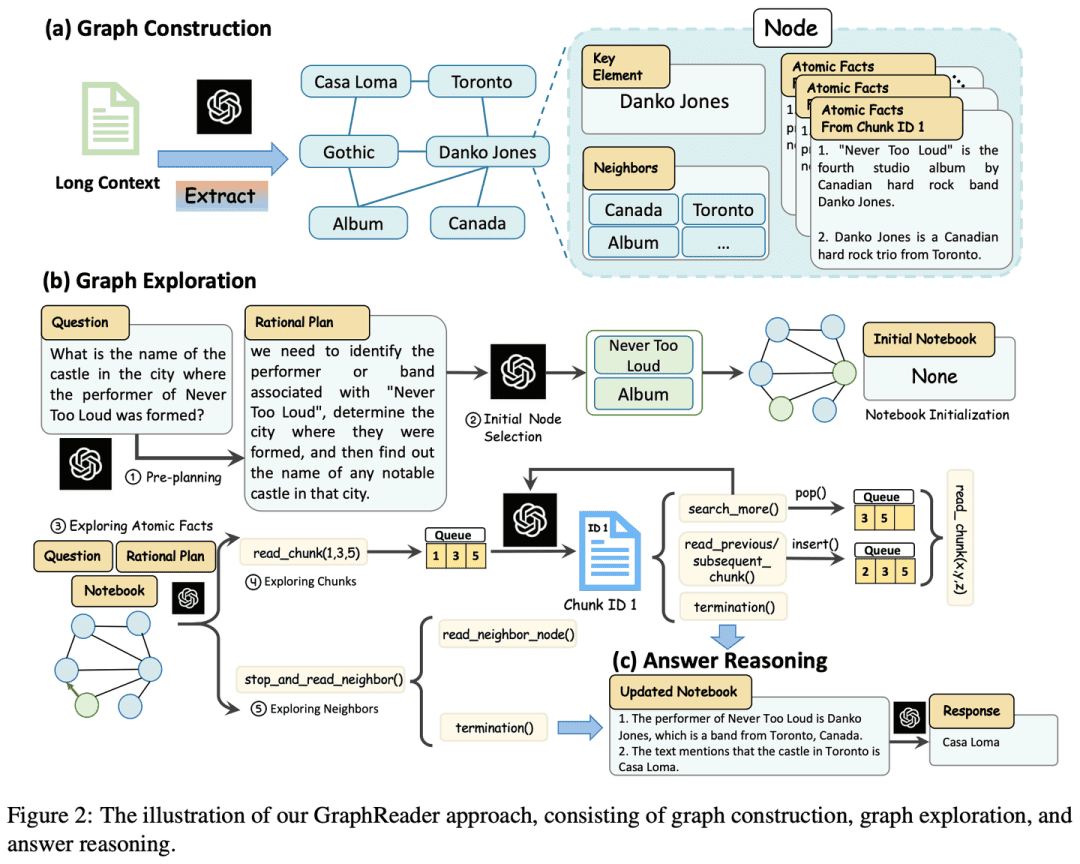

(01) GraphReader [グラフィックエキスパート]

グラフィック・エキスパートマインドマップを作るのが得意な家庭教師のようなもので、長いテキストを明確な知識ネットワークに変換し、AIが地図に沿って探索するように、答えに必要な重要ポイントを簡単に見つけることができるようにし、長いテキストを扱う際の「迷子」の問題を効果的に克服する。

- 時間:01.20

- 論文:GraphReader:大規模言語モデルのロングコンテクスト能力を強化するグラフベース・エージェントの構築

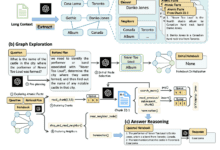

GraphReaderは、長い文章をグラフに構成し、そのグラフを自律的に探索する知性体を用いて処理するように設計された、グラフベースの知性体システムである。問題を受け取ると、知的体はまず段階的な分析を行い、合理的な計画を立てる。次に、あらかじめ定義された関数のセットを呼び出してノードの内容や近傍を読み取り、グラフの粗いものから細かいものまでの探索を容易にする。探索プロセスを通して、知的ボディは継続的に新しい洞察を記録し、答えを生成するのに十分な情報が集まるまで、プロセスを最適化するために現在の状況を反映する。

(02) MM-RAG【多面的

多芸多才視覚、聴覚、言語に同時に精通し、さまざまな情報を理解するだけでなく、それらを自由に切り替え、関連付けることができるオールラウンダーのようなものです。様々な情報を総合的に理解することで、レコメンデーション、アシスタント、メディアなど様々な分野において、よりスマートで自然なサービスを提供することができる。

比較学習、マルチモーダル埋め込みによって実装された任意モード検索、マルチモーダル検索拡張生成(MM-RAG)、マルチモーダル生産システムを構築するためのベクトルデータベースの使用方法など、マルチモーダル機械学習の発展が紹介されている。また、マルチモーダルAIの将来的な動向についても探求し、レコメンダーシステム、バーチャルアシスタント、メディア、電子商取引などの分野への応用が有望であることを強調している。

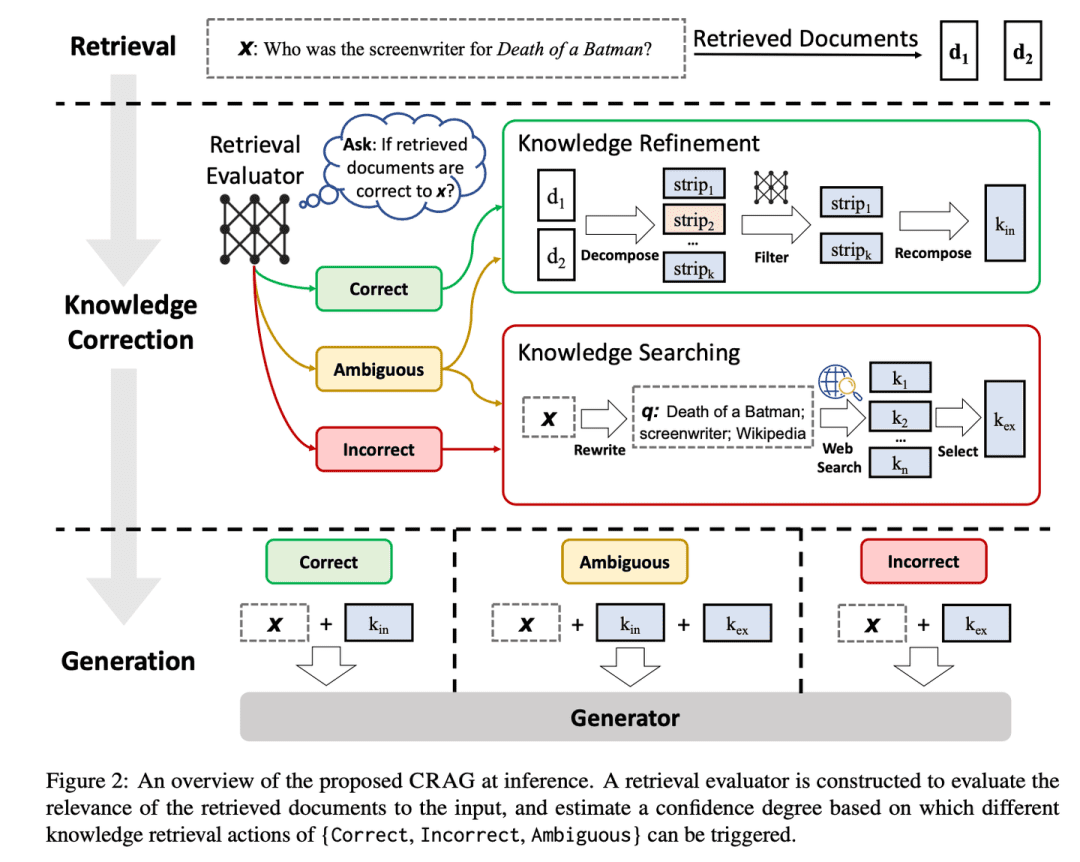

(03) CRAG [自己訂正]

自己修正熟練した編集者のように、シンプルかつ迅速な方法で事前情報を選別し、ウェブを検索して情報を拡大し、最終的に提示されるコンテンツが正確かつ信頼できるものであることを、分解と再編成によって保証します。RAGが作成するコンテンツをより信頼性の高いものにするために、品質管理システムを導入しているようなものだ。

- 時間:01.29

- 論文: 矯正 検索 拡張世代

- プロジェクト:https://github.com/HuskyInSalt/CRAG

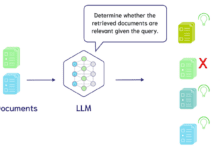

CRAGは、軽量な検索評価器を設計し、大規模なウェブ検索を導入することによって、検索された文書の品質を向上させ、さらに、生成されたテキストの正確性と信頼性を高めるために、分解と再編成アルゴリズムによって検索された情報を洗練する。CRAGは、検索結果を自己修正することによって生成されたテキストの頑健性を高める、既存のRAG技術を補完し、改善するのに有用である。

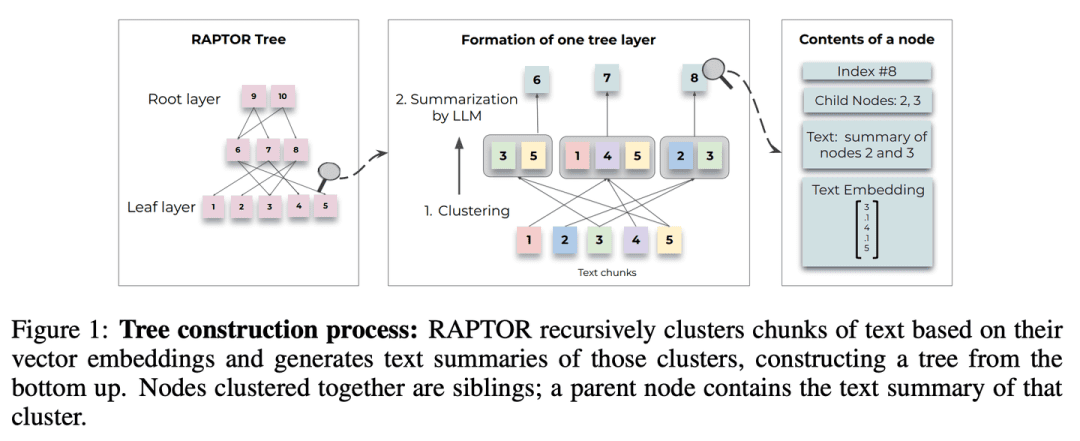

(04) RAPTOR[階層的一般化]

階層的要約よく整理された図書館員のように、文書の内容は下から上にツリー構造で整理されており、情報検索は、全体的な概要と詳細な詳細の両方において、異なるレベル間を柔軟に移動することができる。

- 時間:01.31

- 論文:RAPTOR:木構造検索のための再帰的抽象化処理

- プロジェクト:https://github.com/parthsarthi03/raptor

RAPTOR(Recursive Abstractive Processing for Tree-Organised Retrieval)は、テキストブロックを再帰的に埋め込み、クラスタリングし、要約して、異なる要約レベルを持つツリーをボトムアップで構築する新しい手法を導入している。推論時に、RAPTORモデルはこのツリーから、抽象度の異なる長い文書からの情報を統合して検索する。

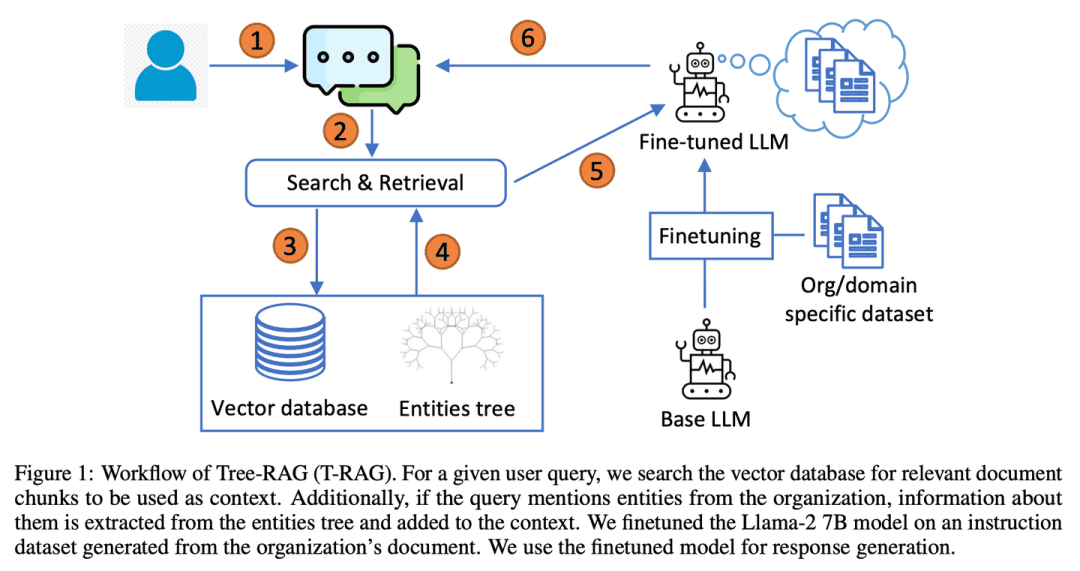

(05) T-RAG[プライベート・カウンセラー]

プライベート・カウンセラー組織構造に精通した社内コンサルタントのように、ツリー構造を使って情報を整理し、プライバシーを保護しながら、地域密着型のサービスを効率的かつコスト効率よく提供することに長けている。

- 論文:T-RAG:LLMの現場からの教訓

T-RAG(Tree Retrieval Augmentation Generation)は、RAGと、組織拡張コンテキスト内のエンティティ階層を表現するためにツリー構造を使用して微調整されたオープンソースのLLMを組み合わせ、ローカルにホストされたオープンソースモデルを活用して、推論の待ち時間、トークン使用コスト、地域的・地理的な可用性の問題に対処しながら、データプライバシーに関する懸念に対処する。

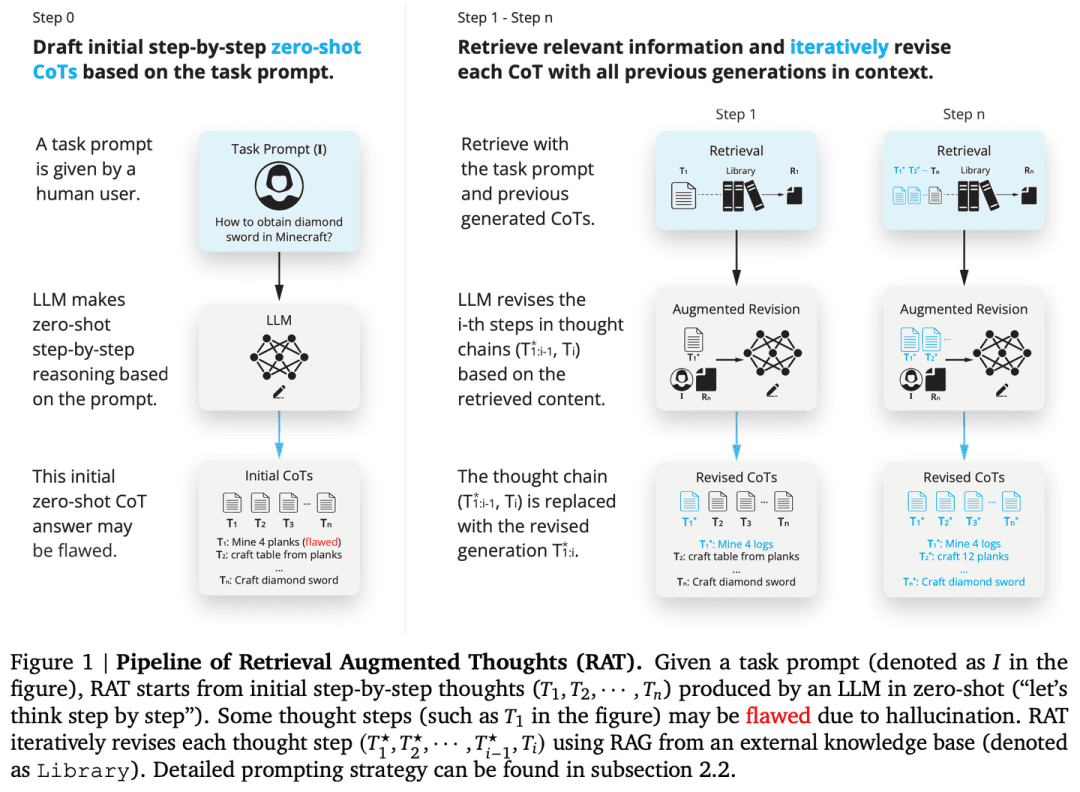

(06) RAT [シンカー]

思想家リフレクティブ・チューターのように、一度に結論を出すのではなく、まず最初のアイデアから始め、そこから得られた関連情報を使って推論プロセスの各ステップを継続的に見直し、洗練させることで、思考の連鎖をより強固で信頼性の高いものにするのです。

- 論文:RAT:検索拡張思考 引き出す ロングホライズン世代における文脈考慮型推論

- プロジェクト:https://github.com/CraftJarvis/RAT

RAT (Retrieval Augmented Thinking) 最初のゼロサンプルの思考の連鎖(CoT)を生成した後、タスククエリ、現在の思考ステップ、過去の思考ステップに関連する検索された情報を使用して、各思考ステップを個別に修正する。RATは、様々な長時間生成タスクのパフォーマンスを大幅に向上させる。

(07) ラフト [オープンブック・マスター]

開帳名人優秀な候補者のように、適切な参考文献を見つけるだけでなく、重要な要素を正確に引用し、理由付けのプロセスを明確に説明することで、根拠に基づいた良識ある答えを導き出すことができる。

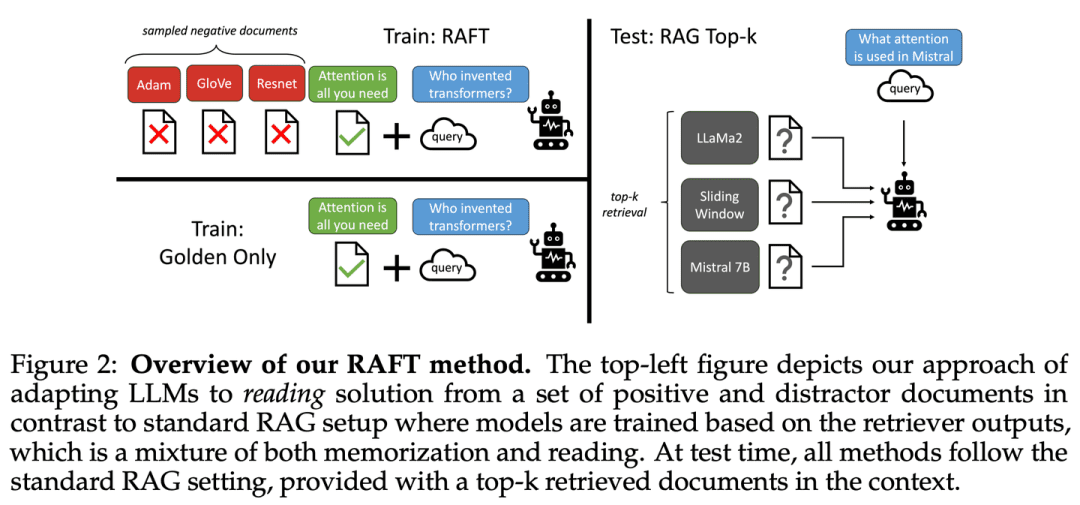

- 論文:RAFT:言語モデルのドメイン固有性への適応 ラグ

RAFTは、関連性のない文書を無視し、関連文書から正しいシーケンスを逐語的に引用して質問に回答するようにモデルを訓練することで、ドメイン固有の「オープンブック」環境におけるモデルの質問回答能力を向上させることを目的としており、思考連鎖回答と組み合わせることで、モデルの推論能力を大幅に向上させる。

(08) Adaptive-RAG【適材適所のリーチング

(生徒の能力に合わせて教える異なる難易度の問題に直面したとき、最も適切な答えを賢く選択します。簡単な質問には直接答え、複雑な質問にはより多くの情報やステップバイステップの推論で答えます。まるで、生徒の具体的な問題に応じて教え方を調整する方法を知っている経験豊富な教師のようです。

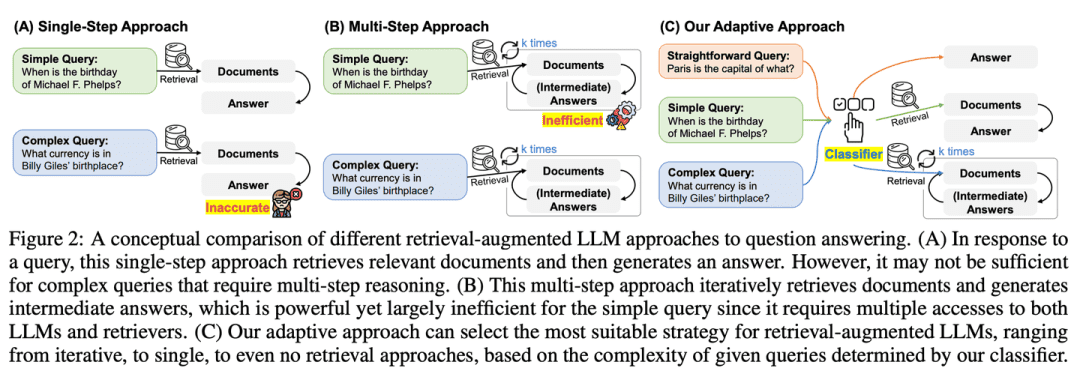

- 論文:Adaptive-RAG:質問の複雑さを通して検索補強大規模言語モデルを適応させる学習

- プロジェクト:https://github.com/starsuzi/Adaptive-RAG

Adaptive-RAGは、クエリの複雑さに基づいて、LLMに最も適した検索強化戦略を動的に選択し、最も単純なものから最も複雑なものまで、LLMに最も適した戦略を動的に選択する。この選択プロセスは、クエリの複雑さを予測し、選択プロセスを最適化するためのラベルを自動的に収集する小さな言語モデル分類器によって実装される。このアプローチは、様々な複雑なクエリに対して、反復的なLLMとシングルステップの検索を強化したLLM、そして検索を行わない手法の間をシームレスに適応するバランスの取れた戦略を提供する。

(09) ヒッポラグ[海馬]

海馬人間の心の馬の体のように、古くて新しい知識は網の目のように巧みに織り込まれている。単に情報を積み重ねるのではなく、それぞれの新しい知識が最適な住処を見つけられるようにするのだ。

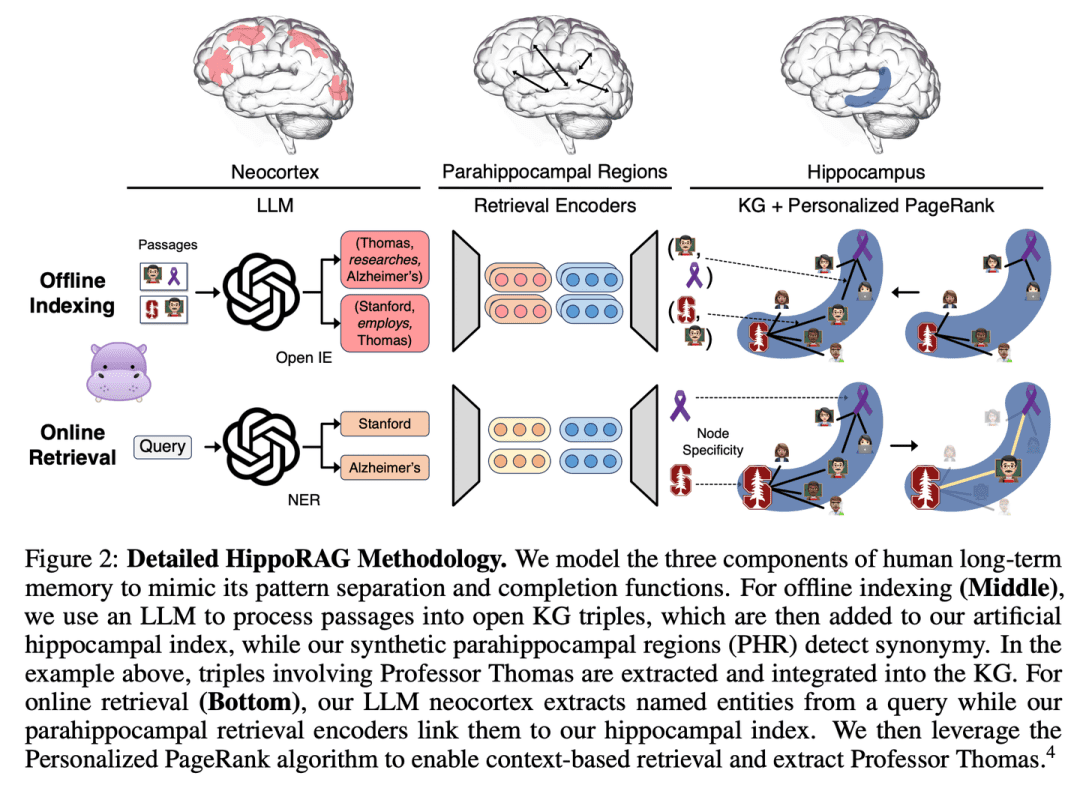

- 論文:HippoRAG:大規模言語モデルのための神経生物学的インスパイアード長期記憶

- プロジェクト:https://github.com/OSU-NLP-Group/HippoRAG

HippoRAGは、人間の長期記憶の海馬インデックス理論に着想を得た新しい検索フレームワークであり、新しい経験をより深く効率的に知識統合できるようにすることを目的としている。HippoRAGは、人間の記憶における大脳新皮質と海馬の異なる役割を模倣するために、LLM、知識グラフ、パーソナライズされたPageRankアルゴリズムを相乗的に編成する。

(10) RAE [インテリジェント編集]

インテリジェントエディタ慎重なニュース編集者のように、関連する事実を深く掘り下げるだけでなく、連鎖的な推論によって見落とされやすい重要な情報を見つけ出し、同時に冗長な内容をカットする方法を心得て、最終的に提示される情報が正確かつ簡潔であることを保証し、「多くを語るが信頼できない」という問題を回避する。

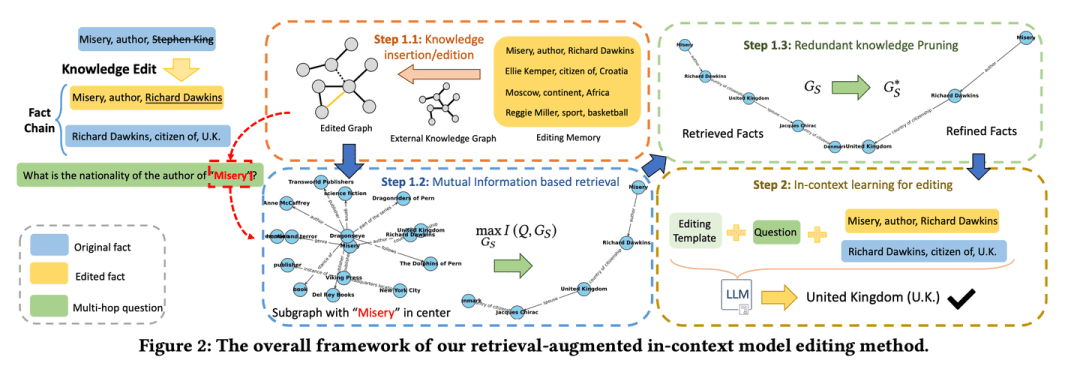

- 論文:マルチホップ質問応答のための言語モデルにおける検索強化知識編集

- プロジェクト:https://github.com/sycny/RAE

RAE (Multi-hop Q&A Retrieval Enhanced Model Editing Framework)は、まず編集された事実を検索し、次に文脈学習を通して言語モデルを最適化する。相互情報最大化に基づく検索アプローチは、従来の類似性ベースの検索では見逃される可能性のある連鎖した事実を特定するために、大規模な言語モデルの推論力を活用する。さらに、このフレームワークには、検索されたファクトから冗長な情報を除去するプルーニング戦略が含まれており、これにより編集精度が向上し、錯覚問題が緩和される。

(11) RAGCache【倉庫番

倉庫係大きな物流センターのように、よく使う知識は取りやすい棚に置く。集荷効率を最大化するために、使用頻度の高い小包は入り口に、使用頻度の低い小包は奥のゴミ箱に入れる方法を知っておく。

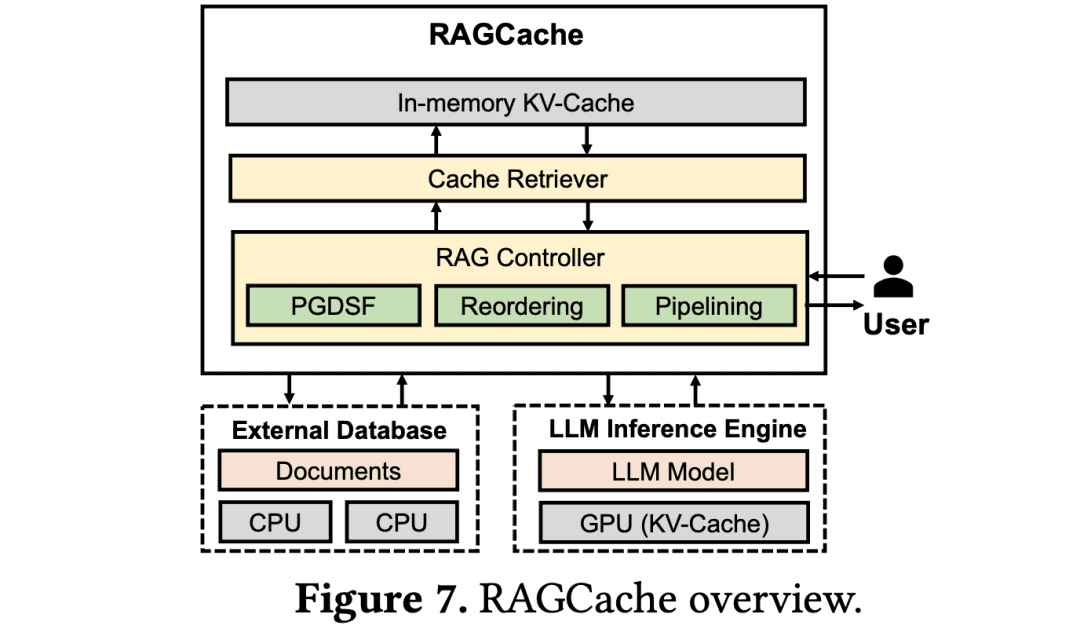

- 論文:RAGCache:検索拡張世代のための効率的知識キャッシュ

RAGCacheは、知識ツリーで検索された知識の中間状態を整理し、GPUとホストメモリの両方の階層にキャッシュする、RAG用に調整された新しいマルチレベルの動的キャッシュシステムである。また、エンドツーエンドのレイテンシを最小化するために、検索と推論のステップを動的にオーバーラップさせる。

(12)グラフグラフ【コミュニティまとめ

コミュニティ概要まず、近隣の住民のネットワークが整理され、それぞれのサークルにプロフィールが与えられる。誰かが道を尋ねると、各近所サークルがヒントを提供し、最終的に最も完全な答えに統合される。

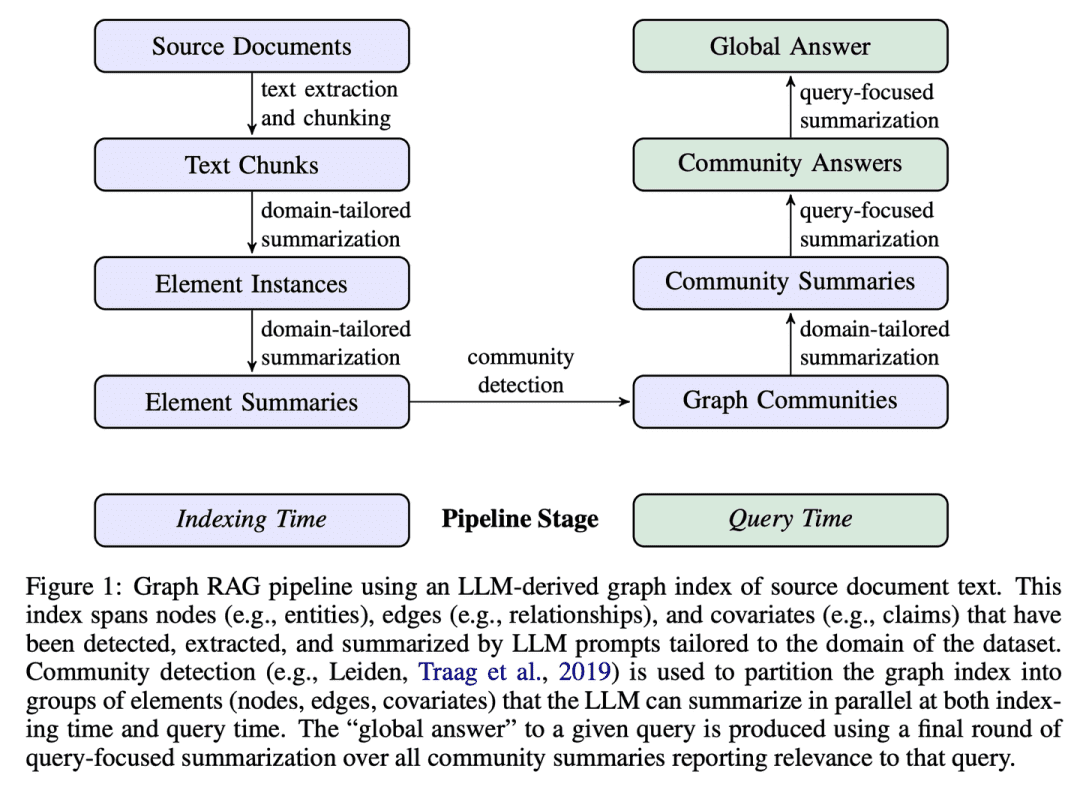

- 論文:ローカルからグローバルへ:クエリに焦点を当てた要約へのグラフRAGアプローチ

- プロジェクト:https://github.com/microsoft/graphrag

GraphRAGは、グラフベースのテキストインデックスを2段階で構築する。まず、ソースドキュメントからエンティティ知識グラフを導き出し、次に、密接に関連するエンティティの全グループについてコミュニティ要約を事前に生成する。問題が与えられた場合、各コミュニティ要約は部分的な応答を生成するために使用され、すべての部分的な応答は、ユーザへの最終的な応答において再度要約される。

(13) R4 [マスター・コレオグラファー]

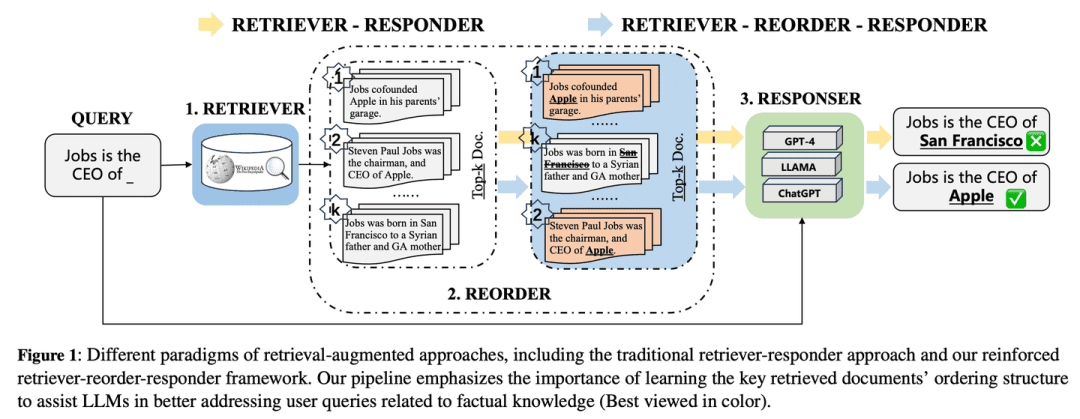

マスター・アレンジャータイポグラファーの巨匠のように、素材の順序や見せ方を最適化することでアウトプットの質を高め、コアモデルを変更することなく、コンテンツをより整理された集中力のあるものにする。

- 論文: R4: 検索補強大規模言語モデルのための強化リトリーバ-リオーダ-レスポンダ

R4 (Reinforced Retriever-Reorder-Responder) は、検索機能を強化した大規模言語モデルの文書順序を学習するために使用され、その結果、大規模言語モデルの多くのパラメータが凍結されたまま、その生成能力がさらに強化される。並び替え学習プロセスは、生成された応答の品質に基づいて、文書順序の調整と文書表現の強化という2つのステップに分けられる。具体的には、文書順序調整は、応答品質に対する強化報酬を最大化するために、グラフ注目学習に基づいて、検索された文書の順序を開始、中間、終了の位置に整理することを目的とする。文書表現強化は、文書レベルの勾配敵対的学習により、検索された質の低い応答の文書表現をさらに洗練する。

(14) IM-RAG[独り言]

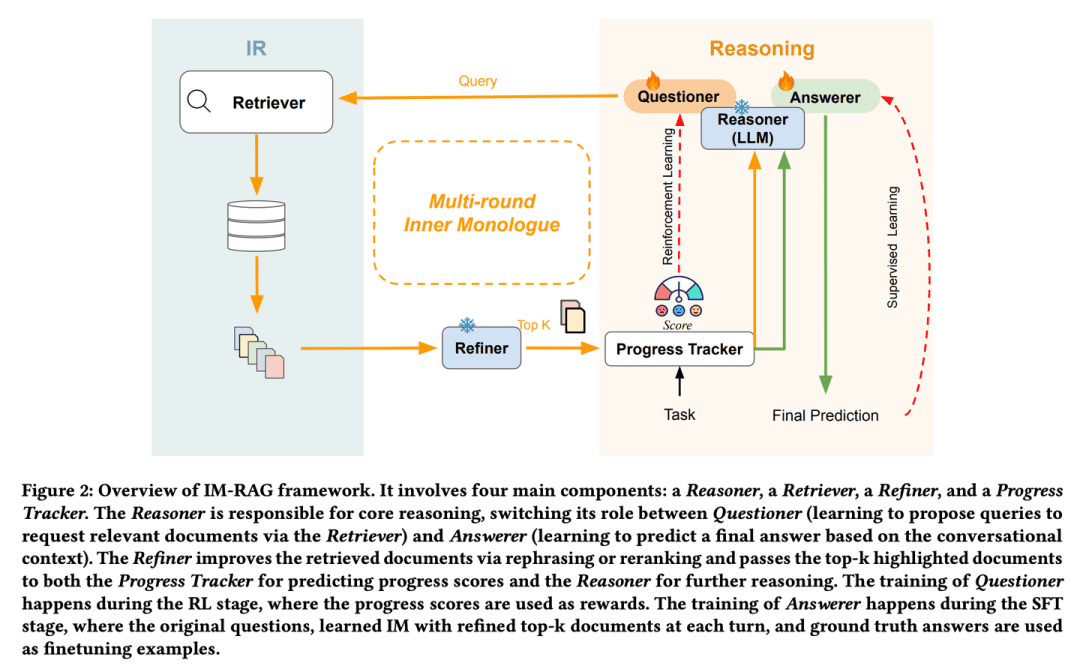

独り言ちるこの「モノローグ」能力は、複雑な問題を一歩一歩深く考え、解決していく人間の専門家のようなものである。

- 論文:IM-RAG:内的モノローグの学習による多ラウンド検索-拡張生成

IM-RAGは、IRシステムとLLMをつなぐInner Monologuesの学習により、複数回の検索拡張生成をサポートする。このアプローチは、インナーモノローグを学習することにより、複数ラウンドの検索拡張生成をサポートするために、情報検索システムを大規模言語モデルと統合する。インナー・モノローグの間、大規模言語モデルはコア推論モデルとして機能し、より多くの情報を収集するためにリトリーバを介してクエリを出すか、対話コンテキストに基づいて最終的な答えを提供することができる。また、リトリーバの出力を改善するオプティマイザを導入することで、様々な能力を持つ推論モデルと情報検索モジュールの間のギャップを効果的に埋め、多ラウンドのコミュニケーションを促進する。内部モノローグプロセス全体は強化学習(RL)により最適化され、中間ステップの報酬を提供する進捗トラッカーも導入され、回答予測はさらに教師付き微調整(SFT)により個別に最適化される。

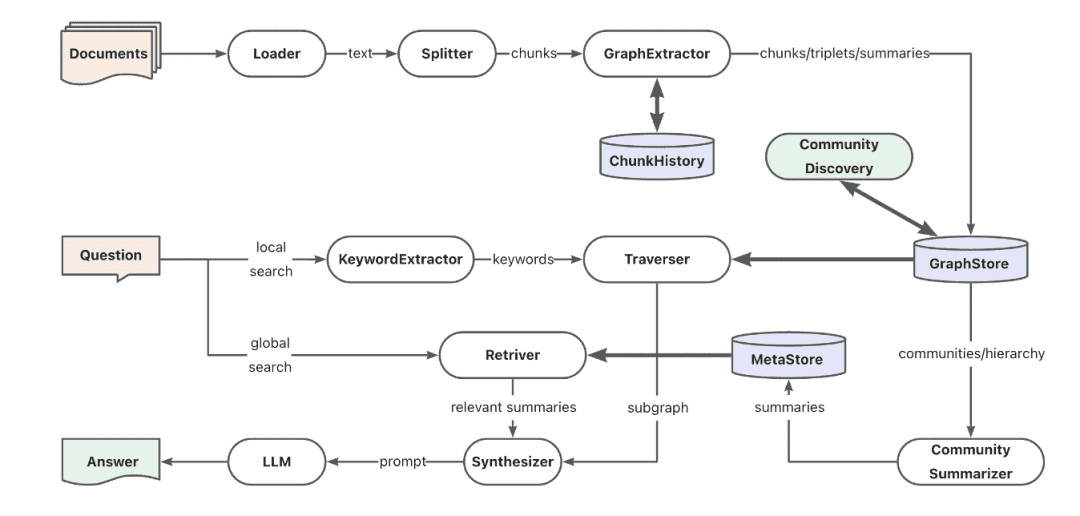

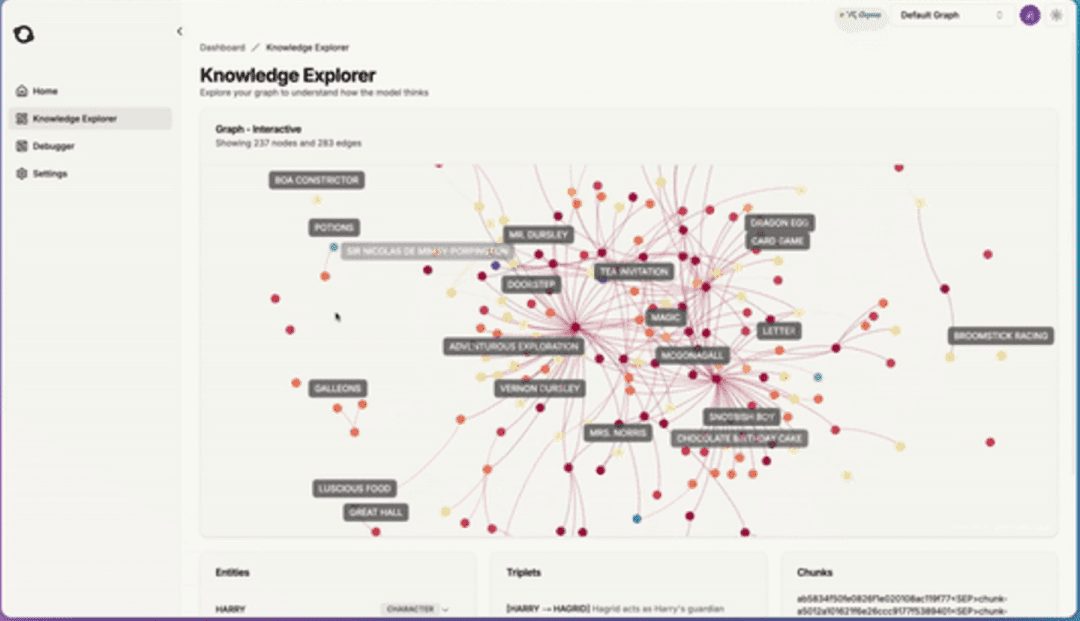

(15) AntGroup-GraphRAG 【数百人の専門家

百家争鳴同社は、情報の迅速な検索、正確な検索の提供、自然言語によるクエリの理解など、さまざまな方法に特化し、複雑な知識検索をコスト効率よく、効率的に行うことができる、業界のベスト・オブ・ベストを結集している。

- プロジェクト:https://github.com/eosphoros-ai/DB-GPT

Ant TuGraphチームはDB-GPTをベースとしたオープンソースのGraphRAGフレームワークを構築し、ベクトル、グラフ、フルテキストなどの様々な知識ベース索引ペデスタルと互換性があり、QFS Q&A問題を解決するためのハイブリッド検索で低コスト知識抽出、文書構造マッピング、グラフコミュニティ抽象化をサポートする。また、キーワード、ベクトル、自然言語などの多様な検索機能をサポートします。

(16) コタエモン [LEGO]

レゴ(おもちゃ)直接使用することも、自由に分解して改造することもできる、既製のQ&Aビルディング・ブロックのセット。ユーザーは好きなように使うことができ、開発者は好きなように変更することができます。

- プロジェクト:https://github.com/Cinnamon/kotaemon

独自のドキュメントQ&Aシステムを構築しカスタマイズするための、クリーンでカスタマイズ可能なオープンソースのRAG UIです。エンドユーザーと開発者の両方のニーズを考慮しています。

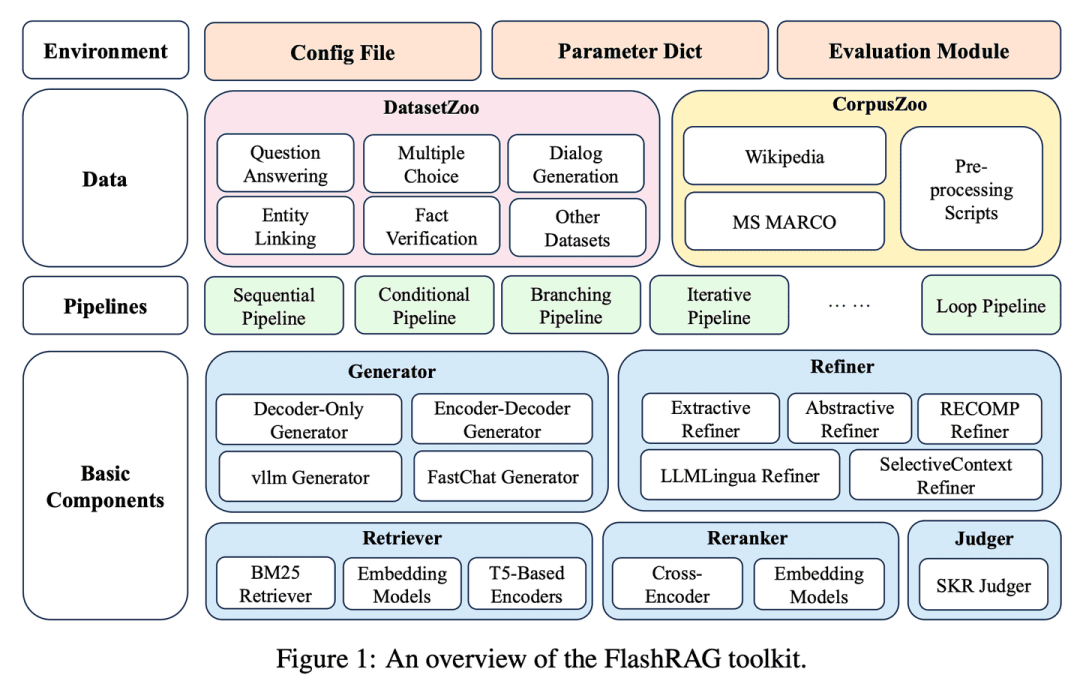

(17) フラッシュラグ[宝箱]

宝箱さまざまなRAGの成果物をツールキットにパッケージ化することで、研究者は積み木を選ぶように、自分の検索モデルを構築することができる。

- 学位論文:FlashRAG:効率的な検索拡張世代研究のためのモジュラーツールキット

- プロジェクト:https://github.com/RUC-NLPIR/FlashRAG

FlashRAGは、研究者が既存のRAG手法を再現し、統一されたフレームワークの中で独自のRAGアルゴリズムを開発できるように設計された、効率的でモジュール式のオープンソースツールキットである。我々のツールキットは、12の最先端のRAG手法を実装し、32のベンチマークデータセットを収集・照合している。

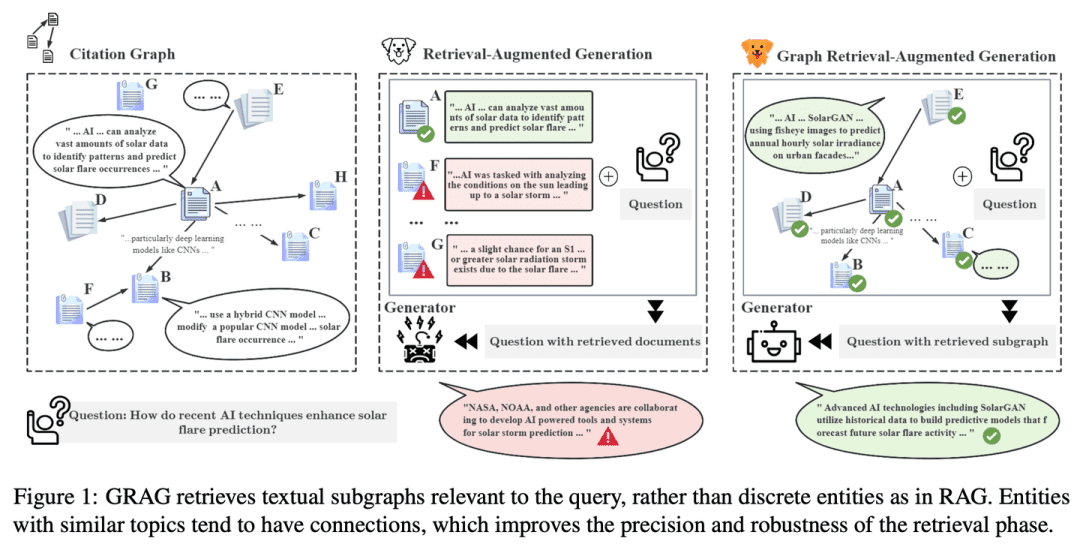

(18) GRAG [刑事]

探偵をする表面的な手がかりに満足することなく、文章間のつながりのネットワークをより深く掘り下げ、犯罪のようにひとつひとつの情報の背後にある真実を追跡し、より正確な答えを導き出す。

- 論文:GRAG:グラフ検索拡張生成

- プロジェクト:https://github.com/HuieL/GRAG

従来のRAGモデルは、複雑なグラフ構造を持つデータを扱う際、テキスト間のつながりやデータベースのトポロジー情報を無視するため、性能のボトルネックとなっていた。GRAGは、部分グラフ構造の重要性を強調することで、性能を大幅に向上させ、検索・生成プロセスの幻想を軽減する。

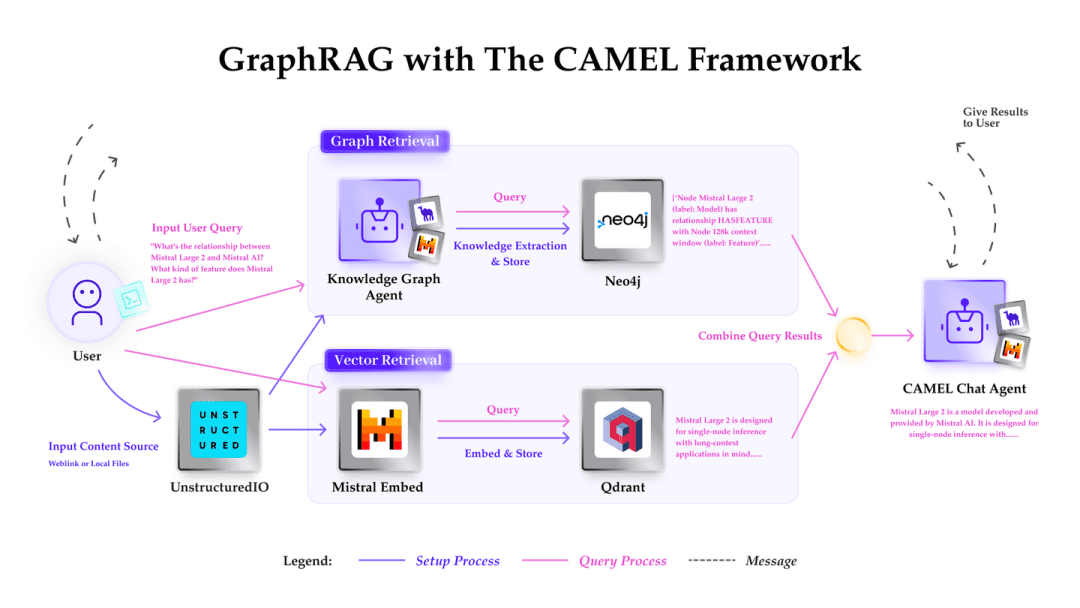

(19) キャメル・グログラフ[左右]

片手で平手打ちし、もう一方の手で平手打ちする。片方の目はMistralでテキストをスキャンしてインテリジェンスを抽出し、もう片方の目はNeo4jで関係の網を編む。検索時には、左目と右目が連携して、類似点を見つけるだけでなく、トレイルマップに沿って追跡し、より包括的で正確な検索を行います。

- プロジェクト:https://github.com/camel-ai/camel

Camel-GraphRAGは、与えられたコンテンツから知識を抽出し、知識構造を構築し、この情報をNeo4jグラフデータベースに格納するためのサポートを提供するMistralモデルに依存している。そして、ベクトル検索と知識グラフ検索を組み合わせたハイブリッドアプローチが、保存された知識の照会と探索に使用される。

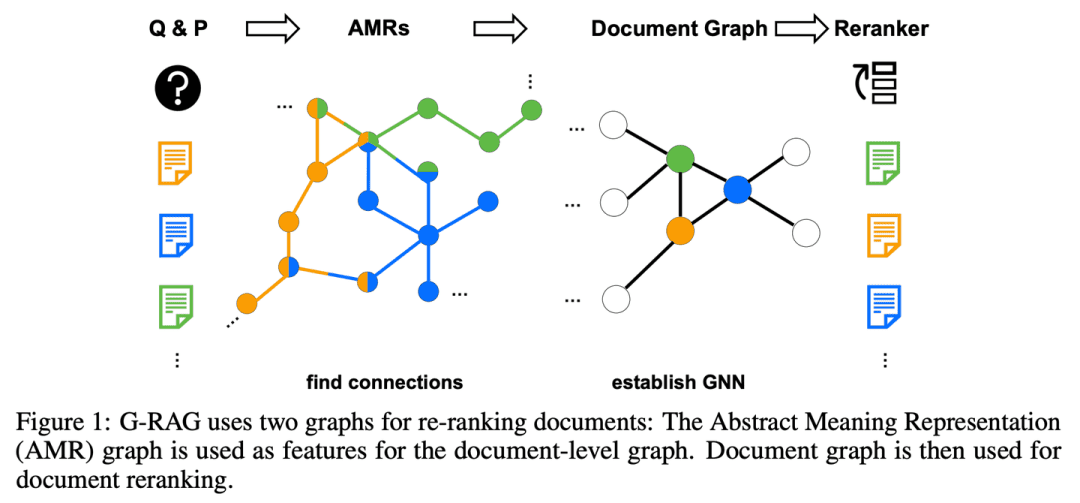

(20) G-RAG【ストリンガー

lit.ドアノッカー(慣用句);fig.人々の問題を解決する奇跡の治療法一人で情報を探すのではなく、知識のポイントごとに人間関係のネットワークを構築する。社交家のように、それぞれの友人が何を得意としているかを知っているだけでなく、誰が誰と友達かも知っているので、答えを探しているときにその足跡を直接たどることができる。

- 論文:接続を忘れるな! グラフベースの再ランキングでRAGを改善する

RAGには、文書と質問の文脈との関係を扱うという課題が残っており、質問との関連性が明らかでない文書や、部分的な情報しか含まれていない文書を効果的に利用できない可能性がある。さらに、文書間のつながりをどのように合理的に推測するかも重要な問題である。G-RAGは、RAG検索者と読者の間に、グラフ・ニューラル・ネットワーク(GNN)をベースとした再配列器を実装している。この方法は、文書間の接続情報と(抽象的な意味表現グラフを介した)意味情報を組み合わせ、RAGにコンテキストベースのランカーを提供する。

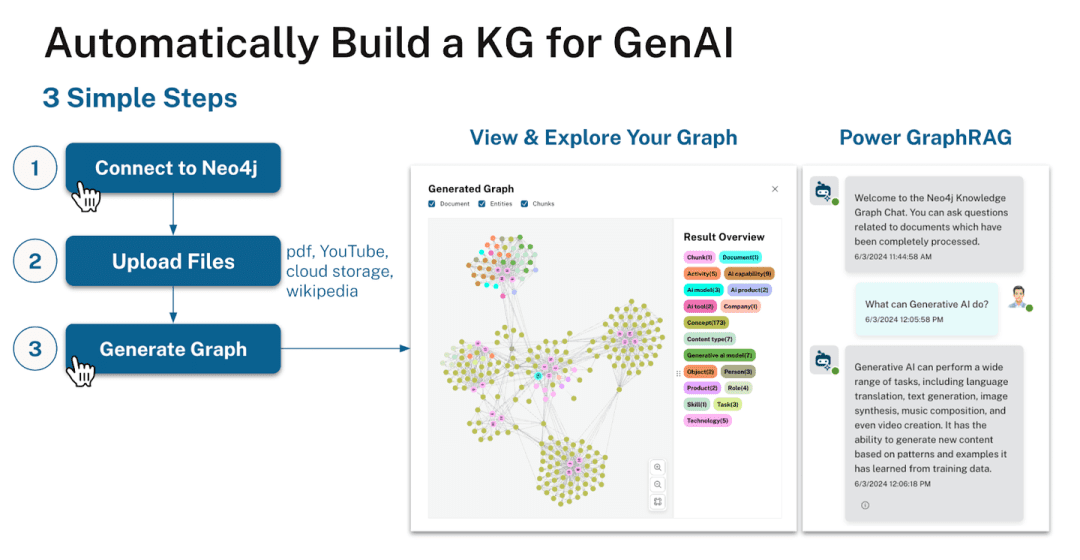

(21) LLM-グラフ・ビルダー[ムーバー]

ポーター混沌としたテキストに理解しやすい家を与える。単に運ぶだけでなく、強迫神経症の人のように、各知識ポイントにラベルを付け、関係線を引き、最終的にNeo4jのデータベースに整然とした知識構築を構築する。

- プロジェクト:https://github.com/neo4j-labs/llm-graph-builder

Neo4jオープンソースLLMベースの知識グラフ抽出ジェネレータは、非構造化データをNeo4jの知識グラフに変換することができます。大規模なモデルを使用して、非構造化データからノード、関係、およびそれらの属性を抽出します。

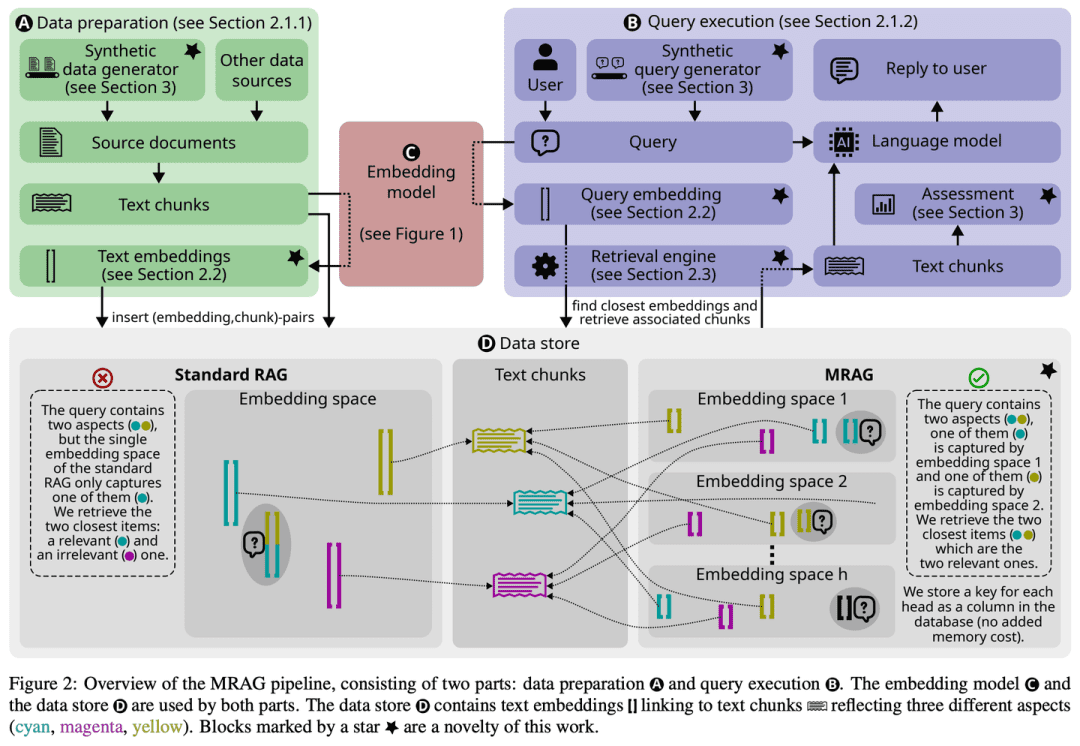

(22) MRAG [オクトパス]

タコ問題を解決するために頭を1つだけ成長させるのではなく、タコのように複数の触手を成長させ、それぞれの触手が角度を把握する役割を担う。簡単に言えば、これはAI版の「マルチタスク」である。

- 論文:マルチヘッドRAG:LLMによるマルチアスペクト問題の解決

- プロジェクト:https://github.com/spcl/MRAG

既存のRAGソリューションは、内容が大きく異なる複数の文書へのアクセスを必要とするクエリに焦点を当てていない。このようなクエリは頻繁に発生するが、これらの文書の埋め込みが埋め込み空間内で離れている可能性があり、それらを全て検索することが困難であるため、困難である。本稿では、このギャップを埋めることを目的とした新しいスキームであるMulti-Reader RAG (MRAG)を紹介する。MRAGは、多面的な文書を取得するための鍵として、デコーダ層ではなく、Transformerのマルチヘッド注意層の活性化を活用するという、シンプルかつ強力なアイデアである。その原動力は、異なる注意ヘッドが異なるデータ側面を捉えることを学習できることである。対応する活性を利用することで、データ項目とクエリの様々な側面を表す埋め込みが生成され、複雑なクエリの検索精度が向上する。

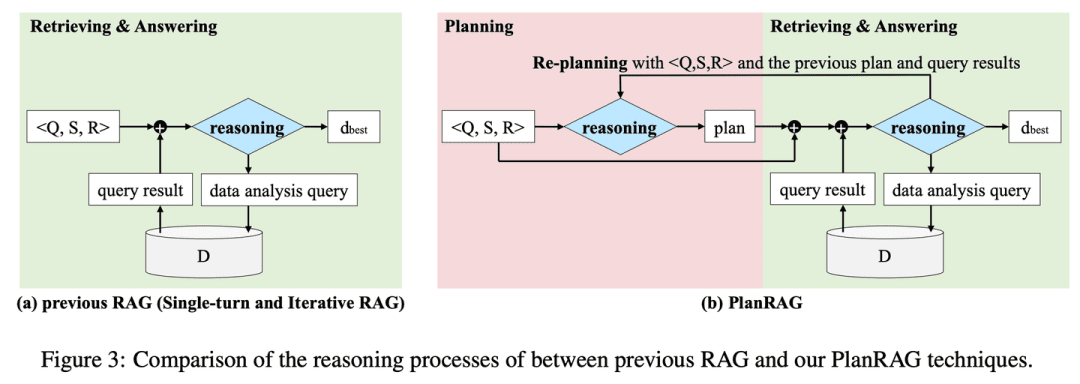

(23) PlanRAG[ストラテジスト]

へいほうか完全なバトルプランが練られ、ルールとデータに基づいて状況が分析され、最終的に最善の戦術的判断が下される。

- 学位論文:PlanRAG:意思決定者としての生成大規模言語モデルのための計画-その後検索-拡張生成

- プロジェクト:https://github.com/myeon9h/PlanRAG

PlanRAGは、デシジョンQAタスク、すなわち、デシジョン問題Q、ビジネスルールR、データベースDに基づいて最適なデシジョンを決定することを定義することにより、複雑なデータ分析デシジョン問題の解決策を解くために大規模言語モデルをどのように使用するかを検討する。

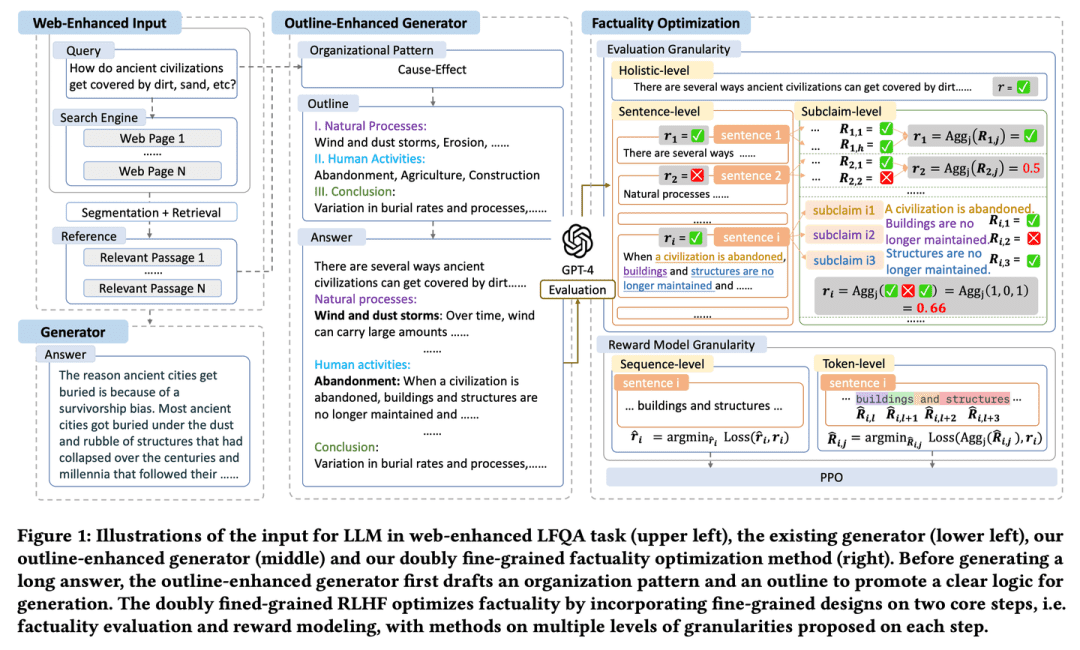

(24) FoRAG【ライター

ライターエッセイは、エッセイの骨組みとなるアウトラインで書かれ、段落ごとに拡大・洗練されていきます。また、細部まで完璧に仕上げ、入念な事実確認や変更点の提案を通じて作品の質を保証する「編集者」もいる。

- 学位論文:FoRAG:Web強化型長文質問応答のための事実に最適化された検索拡張生成

FoRAGは、新しいアウトライン拡張ジェネレータを提案する。このジェネレータは、第一段階でユーザのクエリとコンテキストに基づいてアウトラインテンプレートを使用して回答のアウトラインを作成し、第二段階で生成されたアウトラインに基づいて各視点を拡張し、最終的な回答を構築する。また、二重にきめ細かく設計されたRLHFフレームワークに基づく事実最適化アプローチも提案する。これは、事実評価と報酬モデリングの2つのコアステップにきめ細かい設計を導入することで、より密度の高い報酬信号を提供するものである。

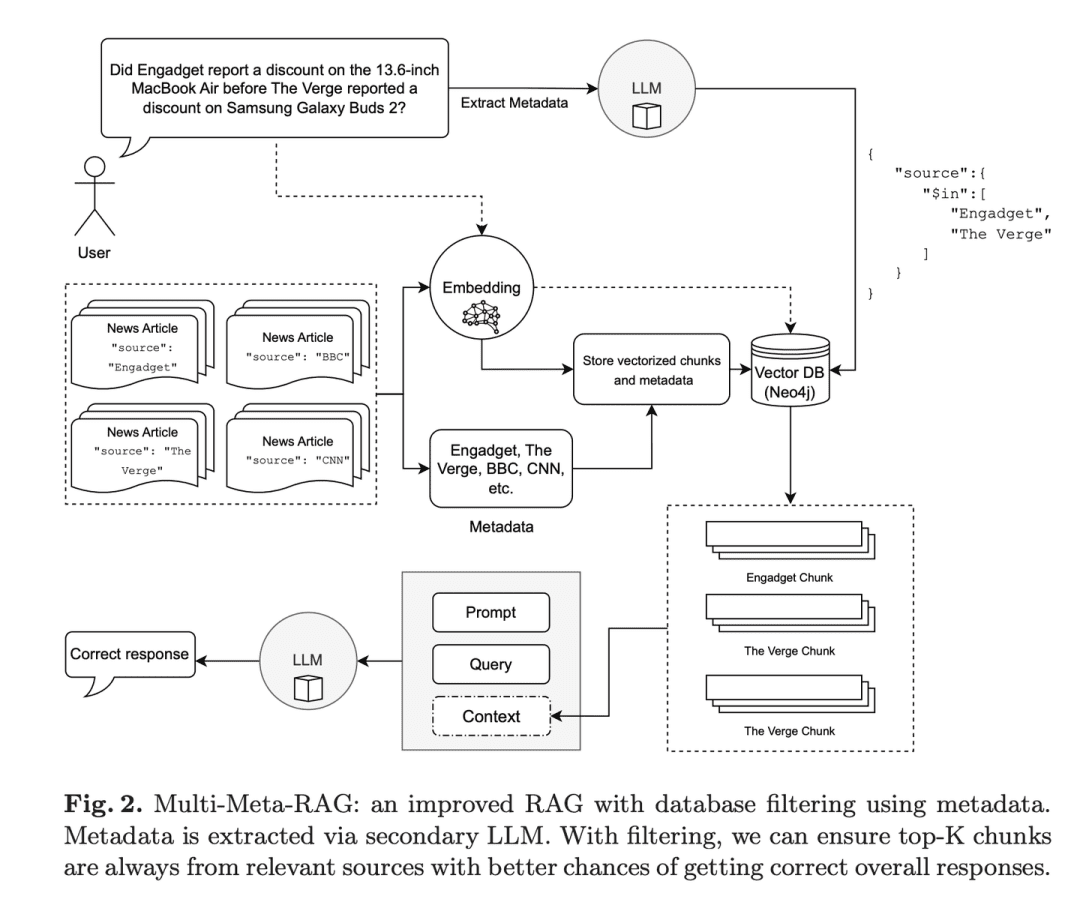

(25) マルチメタRAG[メタスクリーナー]

メタフィルター経験豊富なデータ・マネージャーのように、複数のフィルタリング・メカニズムを使って、膨大な量の情報から最も関連性の高いコンテンツをピンポイントで探し出します。表面だけを見るのではなく、ドキュメントの「IDタグ」(メタデータ)を分析し、見つけた情報のすべてが本当にオントピックであることを確認する。

- 論文:Multi-Meta-RAG:LLM抽出メタデータを用いたデータベースフィルタリングによるマルチホップクエリのRAG改善

- プロジェクト:https://github.com/mxpoliakov/multi-meta-rag

Multi-Meta-RAGは、データベースのフィルタリングとLLMによって抽出されたメタデータを使用して、問題に関連する様々なソースからの関連文書のRAGの選択を改善する。

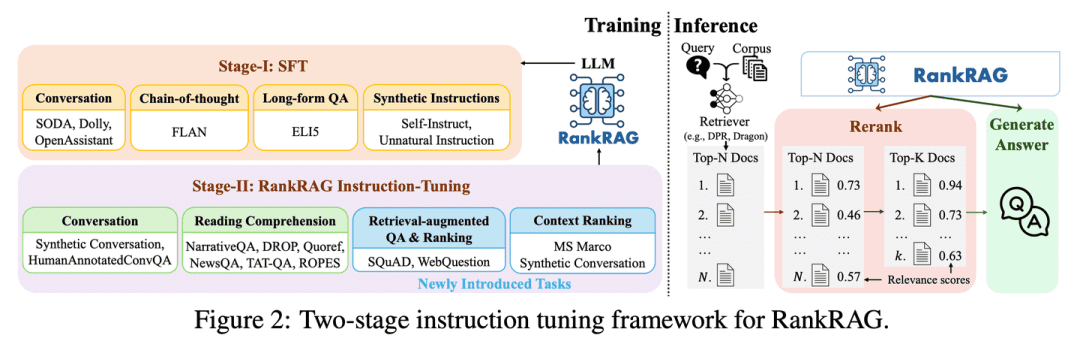

(26) RankRAG [オールラウンダー]

オールラウンダー少しトレーニングすれば、"審判 "にも "競技者 "にもなれる。才能あるアスリートのように、少し指導を受ければ、複数の種目でプロを凌駕し、なおかつすべての技術をマスターすることができる。

- 論文:RankRAG:LLMにおける検索補強型生成とコンテキスト・ランキングの統合

RankRAGは、文脈に沿ったランキングと回答生成の両方を実行する命令を持つ単一のLLMを微調整する。学習データに少量のランキングデータを追加することで、命令によって微調整されたLLMは驚くほどうまく機能し、特に大量のランキングデータで微調整された同じLLMを含む、既存のエキスパートランキングモデルを凌ぐことさえある。この設計は、従来のRAGシステムにおける複数のモデルの複雑さを単純化するだけでなく、モデルパラメータを共有することにより、文脈的関連性判断と情報活用の効率を高める。

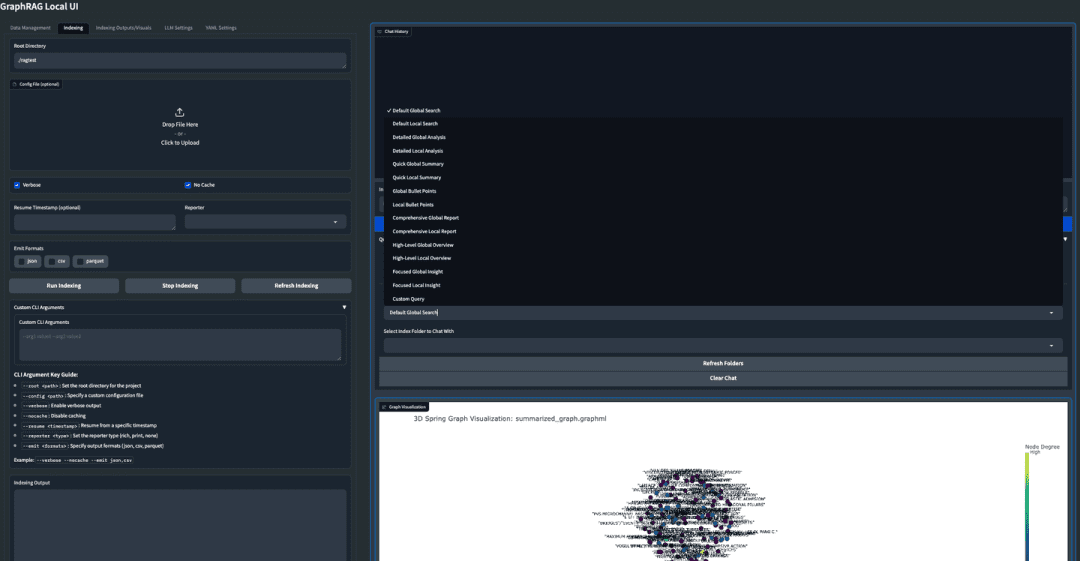

(27) GraphRAG-Local-UI[修飾子]

チューナースポーツカーを、誰もが運転しやすいフレンドリーなダッシュボードを備えた、地元の道路で使える実用的なクルマに変える。

- プロジェクト:https://github.com/severian42/GraphRAG-Local-UI

GraphRAG-Local-UIは、MicrosoftベースのGraphRAGをローカルモデルに適応させたもので、インタラクティブなユーザーインターフェースの豊富なエコシステムを備えている。

(28)シンクラグ【小さな秘書

ジュニア・セクレタリー大きなデバイスがなくても答えを見つけられるように、膨大な知識をポケットサイズに凝縮。

- プロジェクト:https://github.com/wzdavid/ThinkRAG

ThinkRAG Big Model Retrieval Enhanced Generation Systemはノートパソコンに簡単に導入でき、ローカルな知識ベースのインテリジェントなクイズを可能にする。

(29) ナノグラフRAG[軽負荷]

身軽になって戦場に赴く(慣用句)。アスリートが荷造りを軽くするように、煩雑な機材は簡素化されたが、核となる能力は維持されている。

- プロジェクト:https://github.com/gusye1234/nano-graphrag

Nano-GraphRAGは、核となる機能はそのままに、より小さく、より速く、より簡潔なGraphRAGである。

(30) RAGFlow-GraphRAG [ナビゲーター]

こうかいちょう迷路のような質問と答えをショートカットするために、まず地図を描いて知識のポイントをすべてマークし、重複する道しるべを省き、道を尋ねる人が遠回りしないように地図をスリム化する。

- プロジェクト:https://github.com/infiniflow/ragflow

RAGFlowはGraphRAGの実装を利用し、QFSのQ&Aシナリオに対応するために、ドキュメントの前処理段階でオプションとして知識グラフの構築を導入し、エンティティの重み付け除去やトークンの最適化などの改良を導入している。

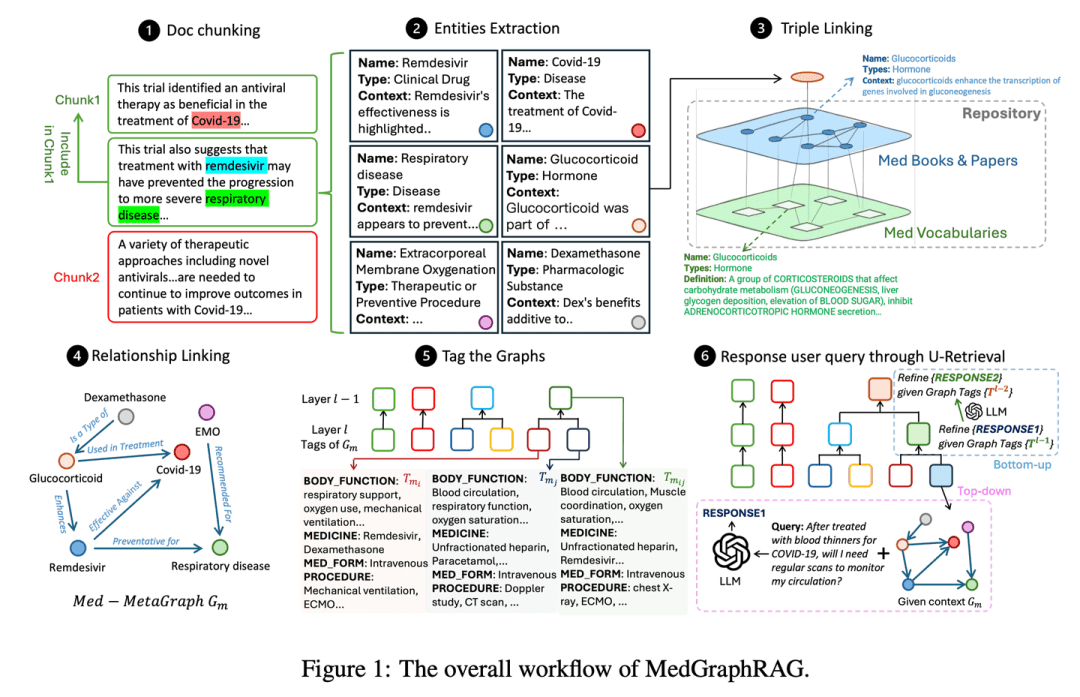

(31) Medical-Graph-RAG【デジタルドクター

デジタルドクター経験豊富な医療コンサルタントのように、複雑な医学知識は図解でわかりやすく整理され、診断の提案もいきなりなされるのではなく、根拠が示されているので、医師も患者もそれぞれの診断の根拠がわかる。

- 論文:医用グラフRAG:グラフ検索による安全な医用大規模言語モデルの構築を目指して

- プロジェクト:https://github.com/SuperMedIntel/Medical-Graph-RAG

MedGraphRAGは、LLMを医学に応用する際の課題に対処するために設計されたフレームワークである。グラフベースのアプローチにより、診断精度の向上、透明性の向上、臨床ワークフローへの統合を実現する。このシステムは、信頼できる情報源に裏付けされた回答を生成することで診断精度を向上させ、大量の医療データにおけるコンテキストの維持の難しさに対処する。

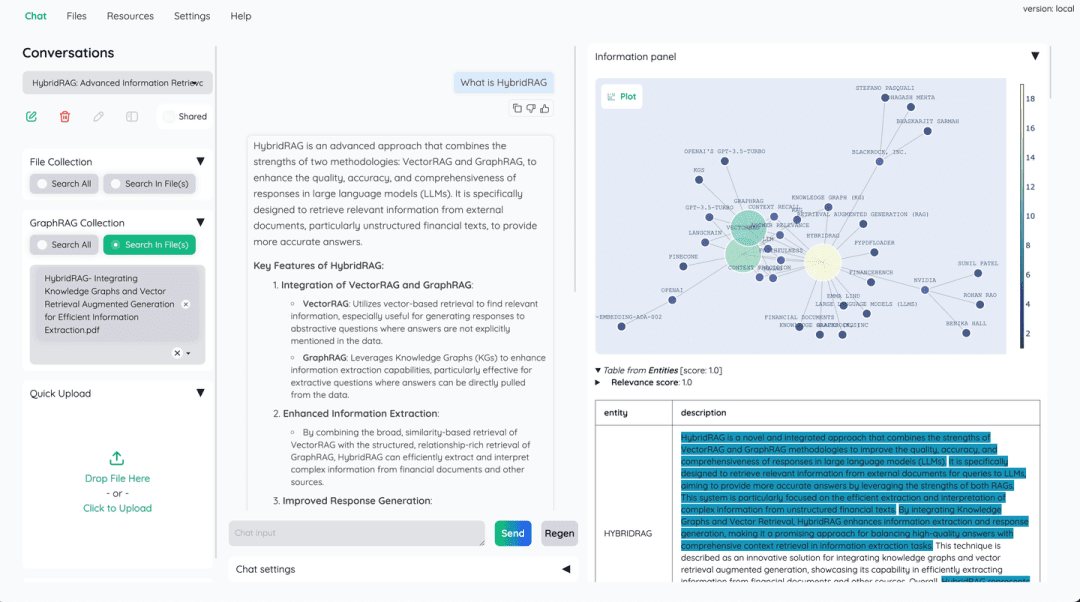

(32) ハイブリッドラグ[漢方配合処方]

漢方処方漢方薬のように、単一の薬は複数の薬の組み合わせほど効果がない。ベクトル・データベースは高速検索を担い、知識グラフはリレーショナル・ロジックを補完し、互いの強みを補い合う。

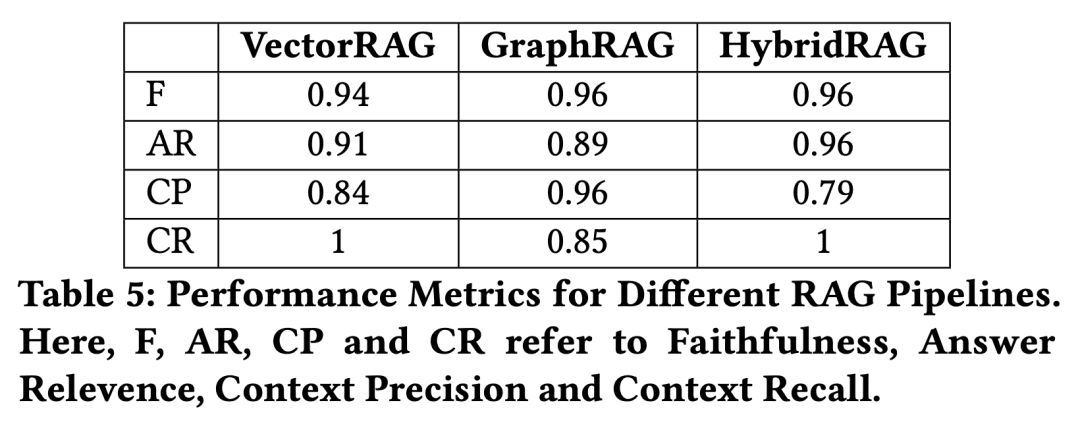

- 論文:HybridRAG:効率的な情報抽出のための知識グラフとベクトル検索拡張生成の統合

知識グラフRAG技術(GraphRAG)とベクターRAG技術の組み合わせに基づく新しいアプローチ(HybridRAGと呼ぶ)は、金融文書から情報を抽出するための質問応答システムを強化するために、正確で文脈に関連した回答を生成することを示す。検索と生成の段階において、ベクトルデータベースと知識グラフから文脈を検索するHybridRAGは、検索精度と回答生成の点で従来のVectorRAGとGraphRAGを上回る。

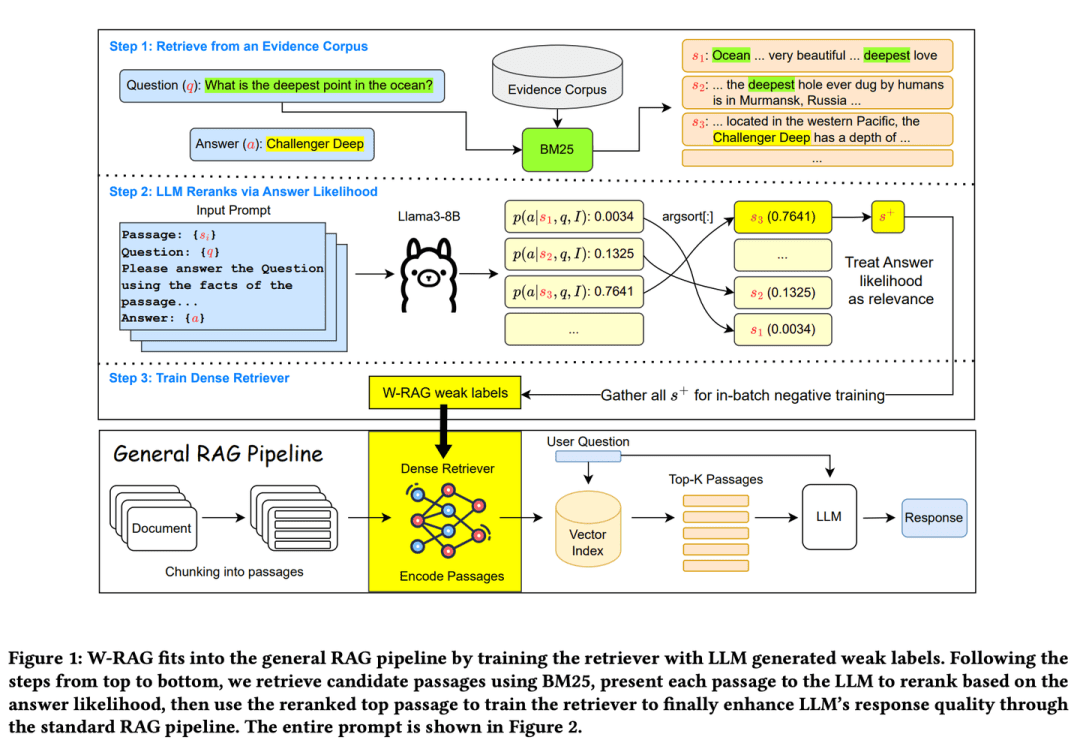

(33) W-RAG【進化的探索

エボリューション・サーチ優れた自己進化型検索エンジンのように、記事の段落を大きなモデルで採点することで、何が良い答えかを学習し、重要な情報を見つける能力を徐々に向上させていく。

- 論文:W-RAG:オープンドメイン質問応答のためのRAGにおける弱教師付き高密度検索

- プロジェクト:https://github.com/jmnian/weak_label_for_rag

オープンドメインのクイズにおける弱教師付き密集検索技術は、密集検索器を学習するための弱ラベルデータを作成するために、大規模言語モデルのランキング機能を利用する。質問と各段落に基づき、大規模言語モデルが正しい答えを生成する確率を評価することで、クイズに合格する確率が高くなります。 BM25 検索された上位K個の文章は再ランク付けされる。上位にランクされた文章は、集中的な検索のための肯定的な学習例として使用される。

(34) RAGChecker[品質検査員]

品質検査員単純な正解・不正解ではなく、厳しい試験官のように情報探索から最終的な答案の作成まで深く検討され、詳細な採点レポートが出され、具体的な改善点が指摘される。

- 論文:RAGChecker:検索補強世代を診断するきめ細かなフレームワーク

- プロジェクト:https://github.com/amazon-science/RAGChecker

RAGCheckerの診断ツールは、RAGシステムに関するきめ細かく、包括的で信頼性の高い診断レポートを提供し、さらなるパフォーマンス向上のための実行可能な方向性を示します。システムの全体的なパフォーマンスを評価するだけでなく、検索と生成という2つのコアモジュールのパフォーマンスを詳細に分析します。

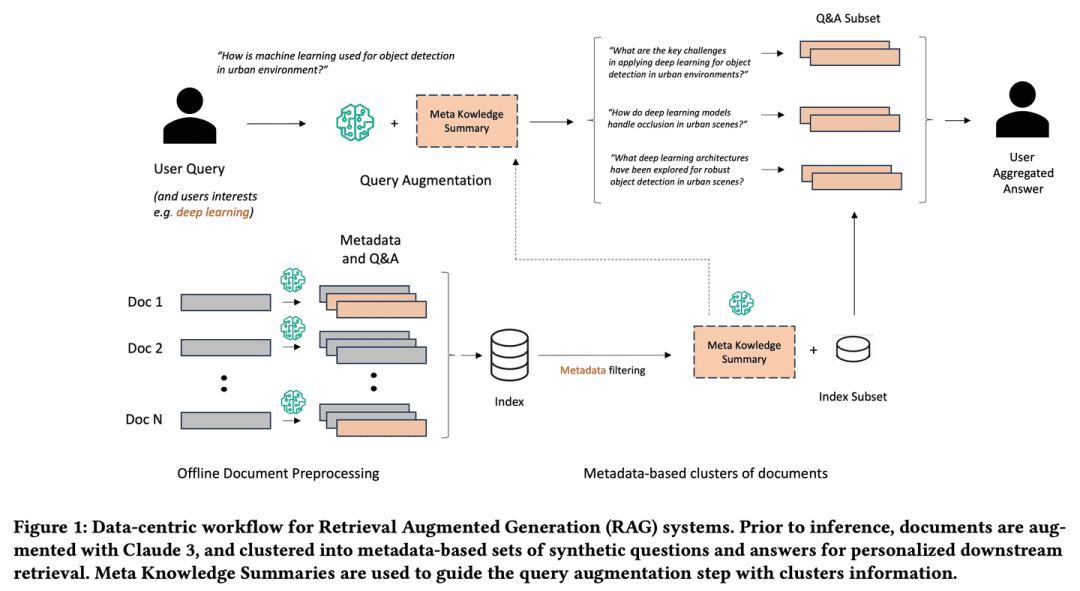

(35)メタ知識-RAG [Scholar]について

アカデミー学術界の上級研究者のように、情報を収集するだけでなく、積極的に問題を考え、各文書に注釈を付け、要約し、さらには起こりうる問題を事前に想定します。関連する知識ポイントをつなげて知識ネットワークを形成し、クエリがより深く、より広くなるように、まるで学者が研究概要を手助けしてくれるように。

- 論文:拡張された大規模言語モデルの検索のためのメタ知識

Meta-Knowledge-RAG(MK要約)は、伝統的な "retrieve-read "システムを、より高度な "prepare-rewrite-retrieve-read "フレームワークに変換する、新しいデータ中心のRAGワークフローを紹介する。「フレームワークへと変換する、新しいデータ中心RAGワークフローを紹介する。我々のアプローチは、メタデータベースの文書クラスタリングのためのメタ知識要約の新しい概念の導入と同様に、各文書のメタデータと合成質問と回答の生成に依存している。提案する技術革新により、パーソナライズされたユーザクエリの拡張と、知識ベース全体にわたる深い情報検索が可能となる。

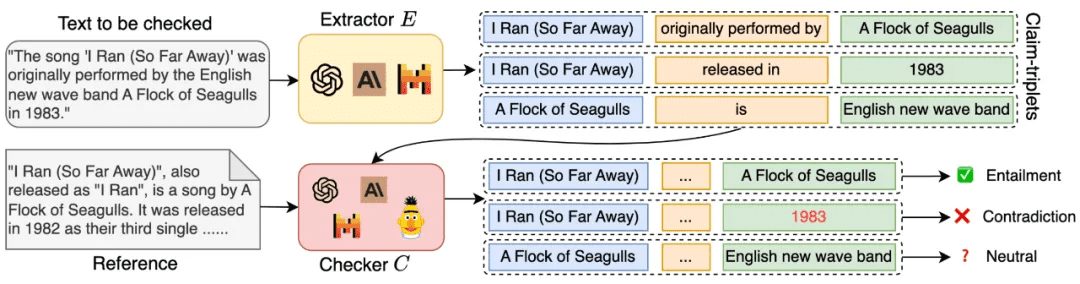

(36)コミュニティKG-RAG【コミュニティ探査

コミュニティ探検地域社会の人間関係のネットワークに精通した魔法使いのように、知識と集団の特性の関連性を利用することに長けており、特別な調査をしなくても、関連する情報を正確に見つけ、その信頼性を検証することができる。

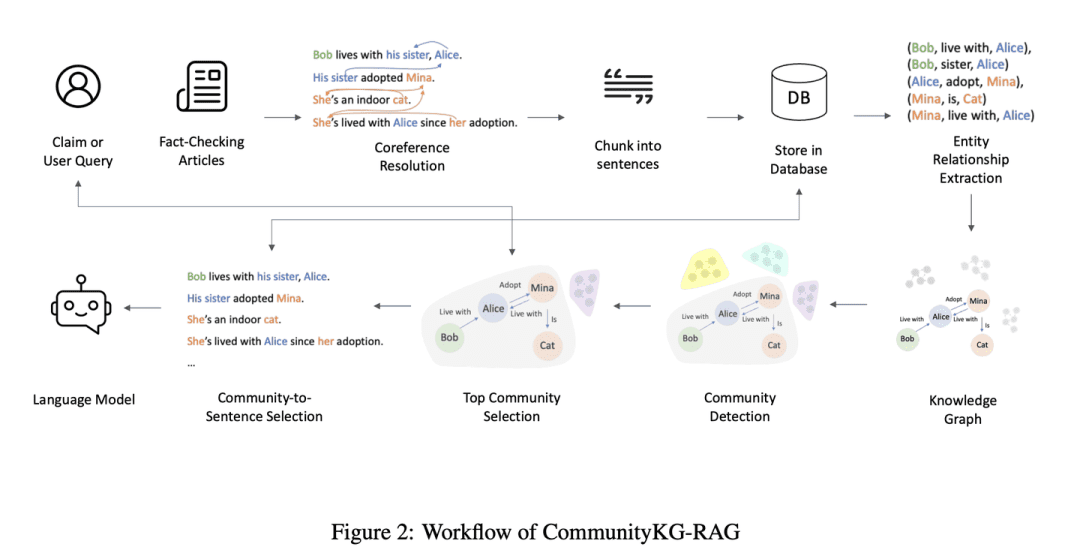

- 論文:CommunityKG-RAG:知識グラフのコミュニティ構造を活用したファクト・チェックにおける高度な検索-拡張生成チェック

CommunityKG-RAGは、ナレッジグラフのコミュニティ構造とRAGシステムを組み合わせ、ファクトチェックプロセスを強化する新しいゼロサンプルフレームワークである。関連性を向上させる。

(37) TC-RAG【メモリーウォーロック

ニモニック・アーティスト: LLMに自動クリーンアップ機能を備えた頭脳を搭載する。問題を解くのと同じように、重要な手順を下書き用紙に書き、終わったら消していく。暗記学習ではなく、学校のいじめっ子が部屋を片付けられるように、覚えるべきことは覚え、忘れるべきことはそのうちに空にする。

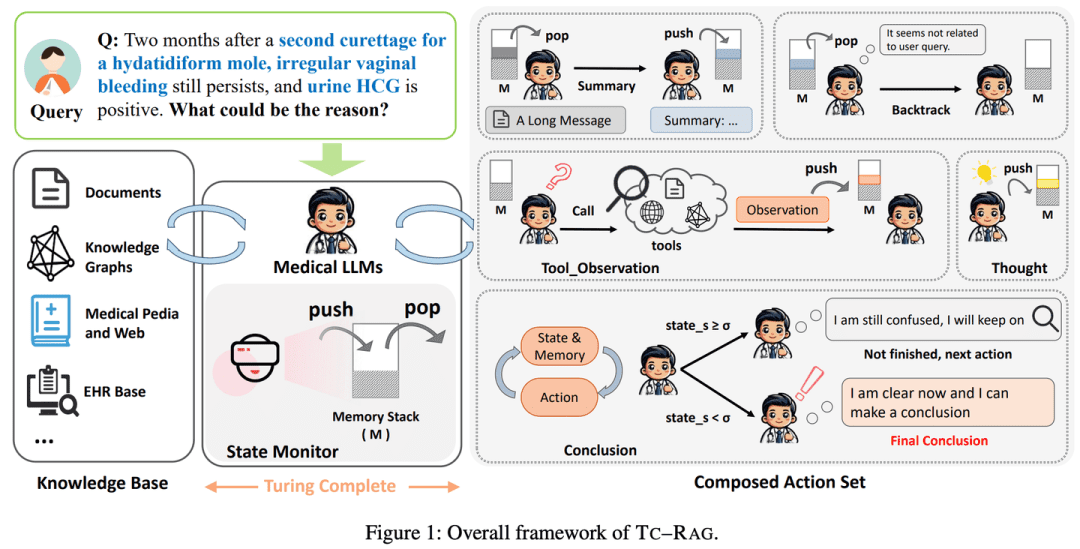

- 論文:TC-RAG:チューリング完全RAGの医療LLMシステムにおける事例研究

- プロジェクト:https://github.com/Artessay/TC-RAG

状態変数を管理するためにチューリング完全システムを導入することで、より効率的で正確な知識検索が達成される。適応的な検索、推論、計画機能を持つメモリスタックシステムを利用することで、TC-RAGは検索プロセスの制御停止を保証するだけでなく、プッシュ・アンド・ポップ操作による誤った知識の蓄積を緩和する。

(38) ラグラボ[アリーナ]

アリーナ科学研究室における標準化されたテストプロセスのように、アルゴリズムが同じルールのもとで公平に競争し、比較できるようにすることで、それぞれの新しい手法が客観的かつ透明性をもって評価されるようになる。

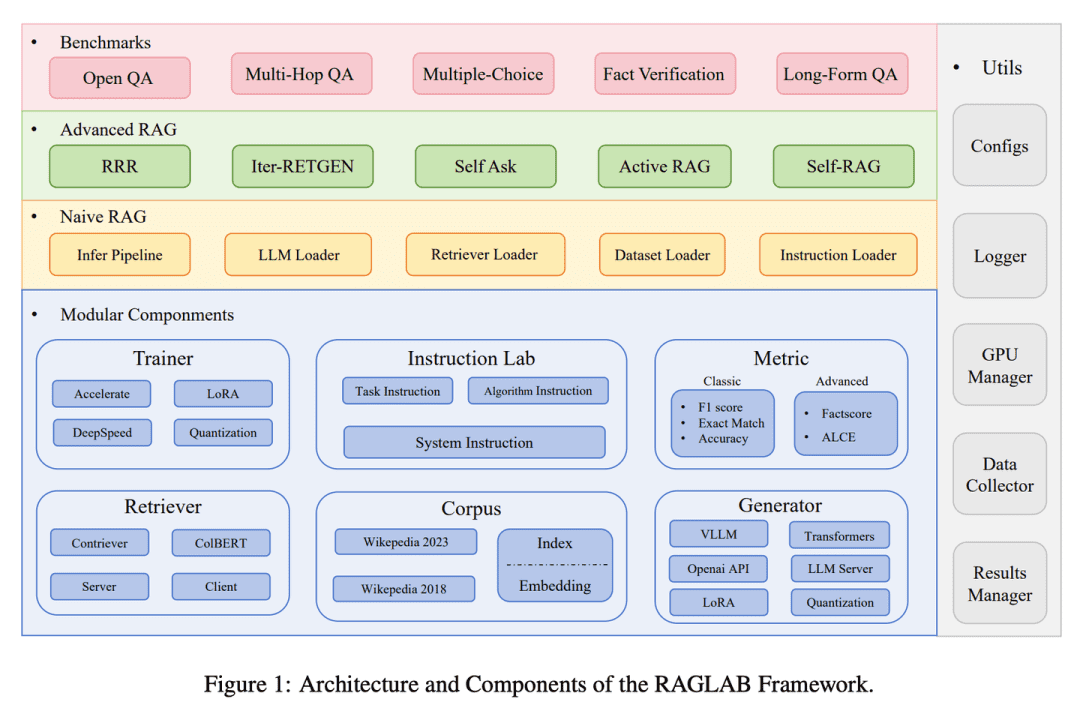

- 論文:RAGLAB:検索支援型生成のためのモジュラー型研究指向統合フレームワーク

- プロジェクト:https://github.com/fate-ubw/RAGLab

RAGLABは、6つのアルゴリズムを再現し、包括的な研究エコシステムを構築する、モジュール式の研究指向のオープンソースライブラリです。RAGLABでは、6つのアルゴリズムを10のベンチマークで公平に比較し、研究者が効率的にアルゴリズムを評価し、革新することを支援します。

(39)メモラグ。

記憶力が高いただ必要に応じて情報を調べるのではなく、知識ベース全体を深く理解し、記憶しているのだ。質問をすると、この「スーパーブレイン」から関連する記憶を素早く引き出し、知識豊富な専門家のように正確で洞察に満ちた答えを返してくれる。

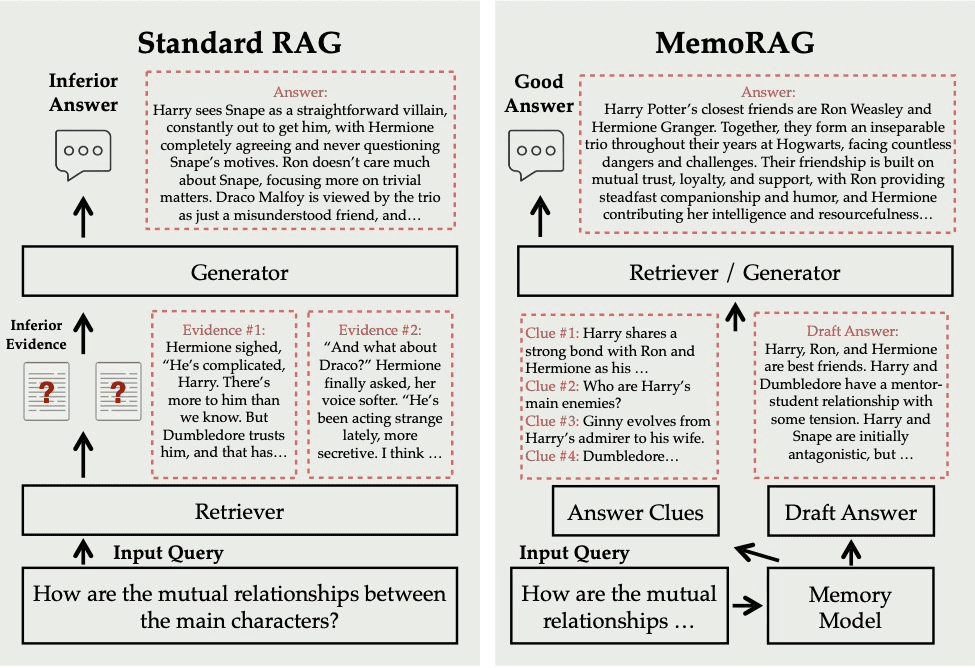

- プロジェクト:https://github.com/qhjqhj00/MemoRAG

MemoRAGは、効率的な超長時間メモリモデルの上に構築された革新的なRAG(Retrieval Augmented Generation)フレームワークである。主に明示的な情報ニーズを持つクエリを扱う標準的なRAGとは異なり、MemoRAGは、データベース全体のグローバルな理解を達成するために記憶モデルを利用する。メモリからクエリ固有の手がかりを呼び出すことで、MemoRAGは証拠検索を強化し、より正確で文脈に富んだ応答生成を実現する。

(40) OP-RAG[アテンション・マネジメント]

アテンション・マネジメント特に分厚い本を読むようなもので、細部まで覚えていることは不可能だが、重要な章に印をつける方法を知っている人こそが達人なのだ。漫然と読むのではなく、上級読者のように、読みながら要点を書き留め、必要なときには印をつけたページを直接めくる。

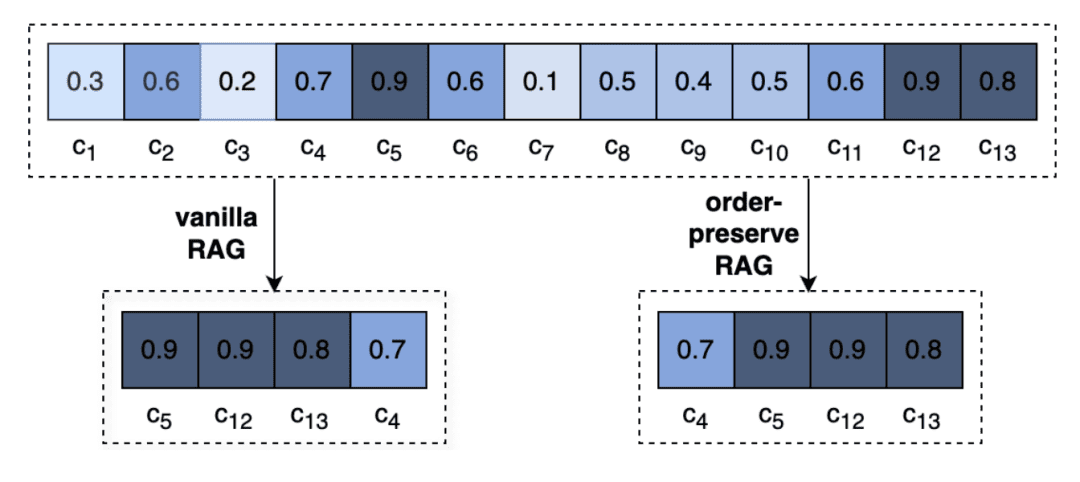

- 論文:ロングコンテクスト言語モデルの時代におけるRAGの擁護

LLMにおける極端に長い文脈は、関連情報への注意を低下させ、回答の質を低下させる可能性がある。我々は、長い文脈の回答生成におけるRAGを再検討し、長い文脈の質問と回答アプリケーションにおけるRAGの性能を大幅に改善する、順序を保持する検索強化生成メカニズム、OP-RAGを提案する。

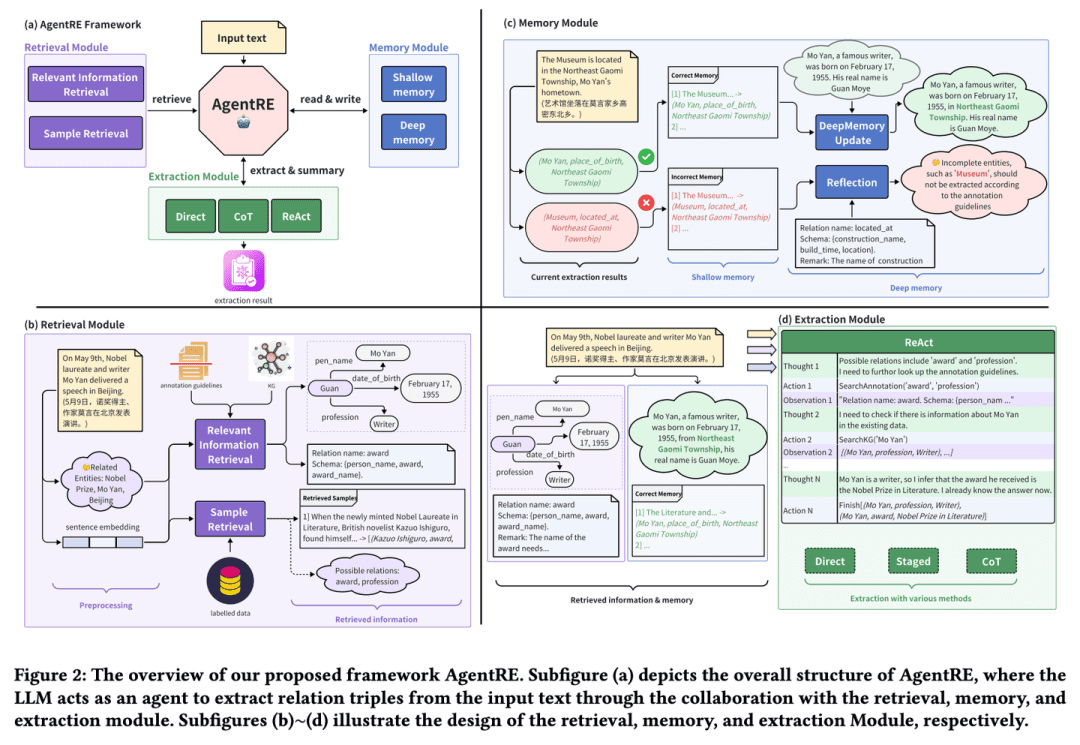

(41) AgentRE [インテリジェント・エクストラクション]

インテリジェント抽出人間関係を観察するのが得意な社会学者のように、重要な情報を記憶しているだけでなく、複雑な人間関係のネットワークを正確に理解するために、率先してそれを調べ、深く考える。複雑な人間関係を前にしても、それを多角的に分析し、意味を理解し、深読みしないようにすることができる。

- 論文:AgentRE:関係抽出における複雑な情報ランドスケープをナビゲートするエージェントベースのフレームワーク

- プロジェクト:https://github.com/Lightblues/AgentRE

大規模言語モデルの記憶、検索、反映機能を統合することで、AgentREは、複雑なシーンの関係抽出における多様な関係タイプや、単一センテンス内のエンティティ間の曖昧な関係といった課題に効果的に対処します。AgentREは、エージェントが効率的に情報を取得・処理し、REのパフォーマンスを大幅に向上させることを可能にする3つの主要モジュールで構成されています。

(42) iText2KG [アーキテクト]

建築家組織化されたエンジニアのように、情報を段階的に絞り込み、抽出し、統合することで、断片的なドキュメントを体系的な知識ネットワークへと徐々に変換していく。

- 論文:iText2KG:大規模言語モデルを用いたインクリメンタル知識グラフの構築

- プロジェクト:https://github.com/AuvaLab/itext2kg

iText2KG (Incremental Knowledge Graph Construction)は、Large Language Models (LLM)を使って生の文書から知識グラフを構築し、4つのモジュール(Document Refiner、Incremental Entity Extractor、Incremental Relationship Extractor、Graph Integrator)を通して、事前のオントロジー定義や大規模な教師付き学習を必要としないインクリメンタルな知識グラフ構築を可能にします。

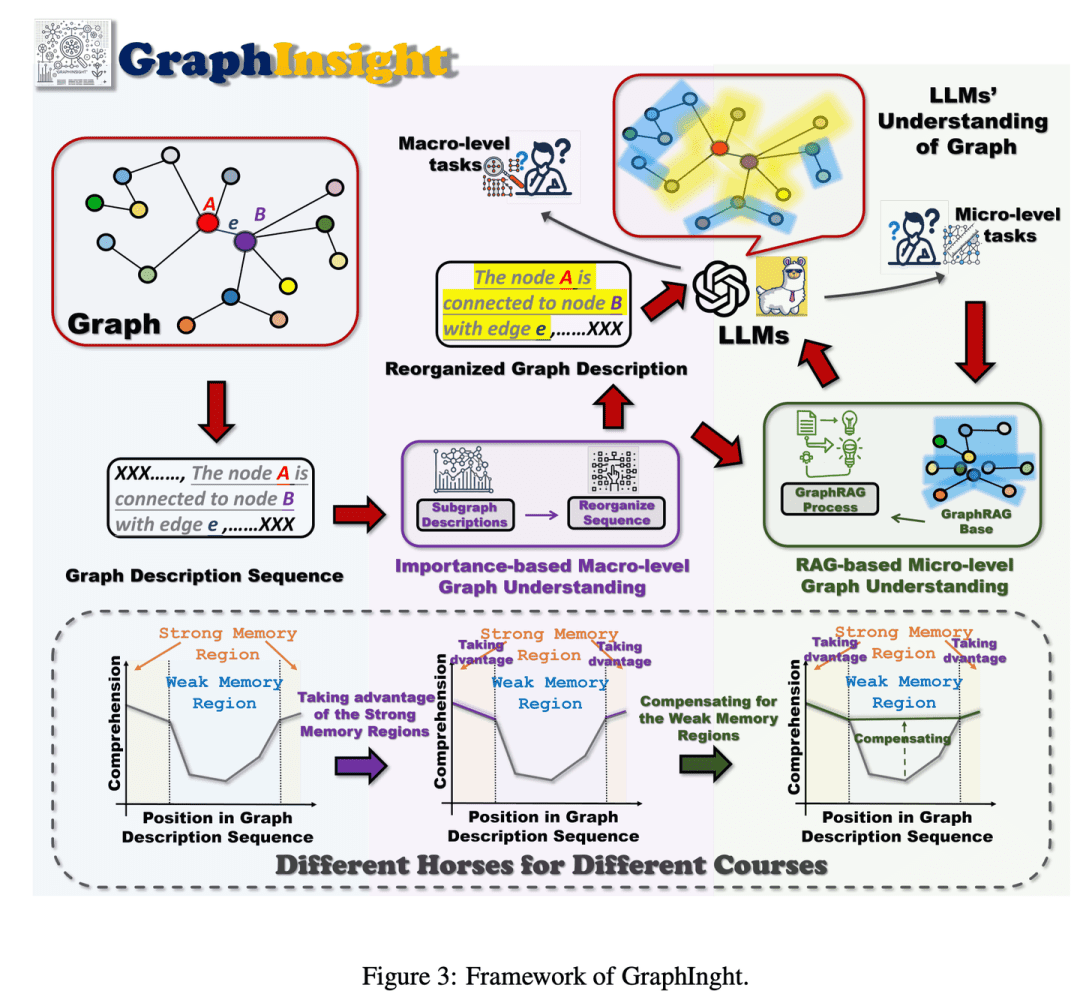

(43) GraphInsight[グラフ解釈]

アトラス解釈インフォグラフィックを分析する専門家のように、重要な情報を最も目立つ場所に配置することを熟知し、必要に応じて参考文献を参照しながら詳細を追加し、複雑なグラフを一歩一歩推論することで、AIが細部を見逃すことなく全体像を把握できるようにする。

- 論文:GraphInsight:グラフ構造理解のための大規模言語モデルにおける洞察の解明

GraphInsightは、LLMのマクロレベルおよびミクロレベルのグラフ情報に対する理解を向上させることを目的とした新しいフレームワークである。GraphInsightは、2つの主要な戦略に基づいている:1)LLMの記憶性能が強い場所に主要なグラフ情報を配置する、2)記憶性能が弱い領域に対して軽量な外部知識ベースを導入する。さらに、GraphInsightは、多段階推論を必要とする複合グラフタスクのために、これら2つの戦略をLLMエージェントプロセスに統合することを探求している。

(44) LA-RAG [方言峠]

方言集このAIは、各地の方言に精通した言語学者のように、標準的な北京語だけでなく、きめ細かな音声分析と文脈理解によって、その土地の特徴を生かしたアクセントも正確に理解することができる。

- 論文:LA-RAG:検索補強型生成によるLLMベースASR精度の向上

LA-RAGは、LLMベースのASRのための新しいRAG(Retrieval Augmented Generation)パラダイムです。LA-RAGは、LLM文脈学習(ICL)機能によってASRの精度を向上させるために、きめ細かいトークンレベルの音声データストレージと音声対音声検索メカニズムを利用します。

(45) SFR-RAG【絞り込み検索

合理化された検索リファレンス・アドバイザーのように、規模は小さいが機能は的確で、ニーズを理解し、外部の助けを求める方法を知っており、回答が正確かつ効率的であることを保証する。

- 論文:SFR-RAG:文脈に忠実なLLMを目指して

SFR-RAGは、文脈に基づく生成と錯覚の最小化に焦点を当てた命令で微調整された小さな言語モデルです。SFR-RAGモデルは、高性能を維持しながら引数の数を減らすことに重点を置くことで、高品質の文脈情報を取得するために外部ツールと動的に相互作用することを可能にする関数呼び出し機能を含んでいます。

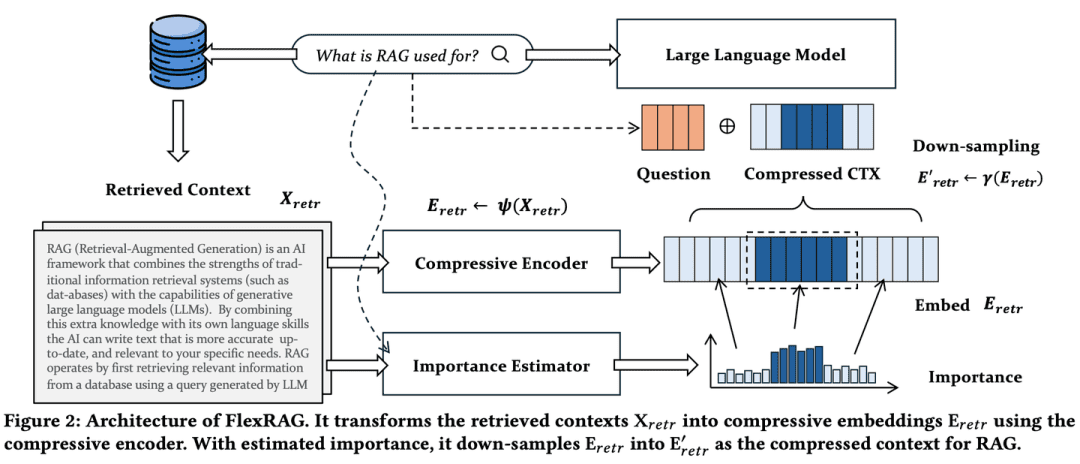

(46) フレックスラグ【コンプレッション・エキスパート

コンプレッション・スペシャリスト長いスピーチを簡潔な要約に凝縮し、圧縮率をニーズに応じて柔軟に調整できるため、重要な情報が失われることがなく、保管や処理のコストを節約できる。分厚い本を簡潔な読書ノートにするようなものだ。

- 論文:より軽く、より良く:検索拡張世代のための柔軟な文脈適応に向けて

FlexRAGによって取得されたコンテキストは、LLMによって符号化される前に、コンパクトな埋め込みに圧縮される。FlexRAGの主な特徴は、異なる圧縮率を効率的にサポートし、重要なコンテキストを選択的に保存できる柔軟性である。これらの技術設計により、FlexRAGは運用コストを大幅に削減しながら、優れた生成品質を実現している。様々なQ&Aデータセットを用いた包括的な実験により、我々のアプローチがRAGシステムのための費用対効果が高く柔軟なソリューションであることが検証された。

(47) CoTKR[アトラス翻訳]

アトラス翻訳忍耐強い教師のように、知識の背景を理解した上で段階的に説明し、単に繰り返すのではなく、深く伝えていく。同時に、生徒からのフィードバックを集めることで、自分自身の説明の仕方を改善し、知識をより明確かつ効果的に伝えることができる。

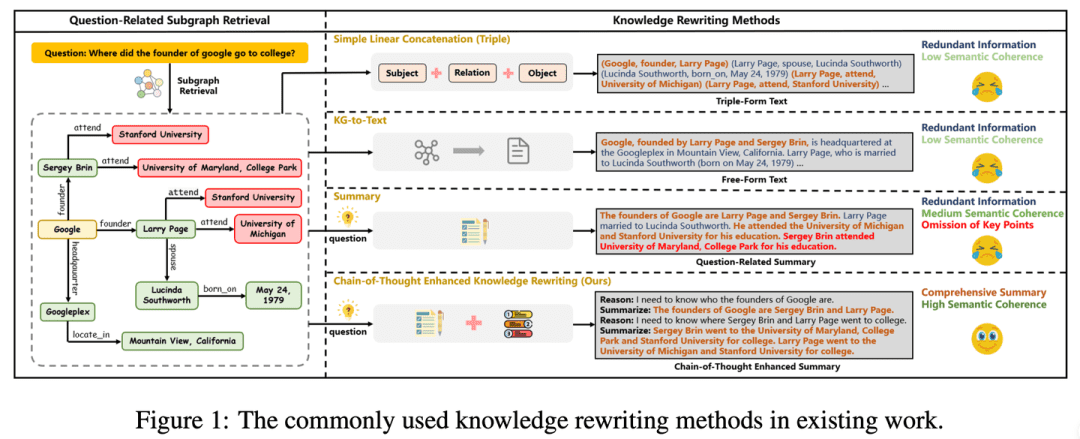

- 論文:CoTKR:複雑な知識グラフ質問応答のための思考連鎖を強化した知識書き換え

- プロジェクト:https://github.com/wuyike2000/CoTKR

CoTKR(Chain-of-Thought Enhanced Knowledge Rewriting)手法は、推論経路の生成と対応する知識の生成を交互に行うことで、シングルステップの知識書き換えの限界を克服する。さらに、知識書き換え器とQAモデルの嗜好の違いを埋めるために、Q&Aフィードバックから嗜好を揃える学習戦略を提案し、QAモデルからのフィードバックを利用して知識書き換え器をさらに最適化する。

(48) 開く RAG【シンクタンク】。

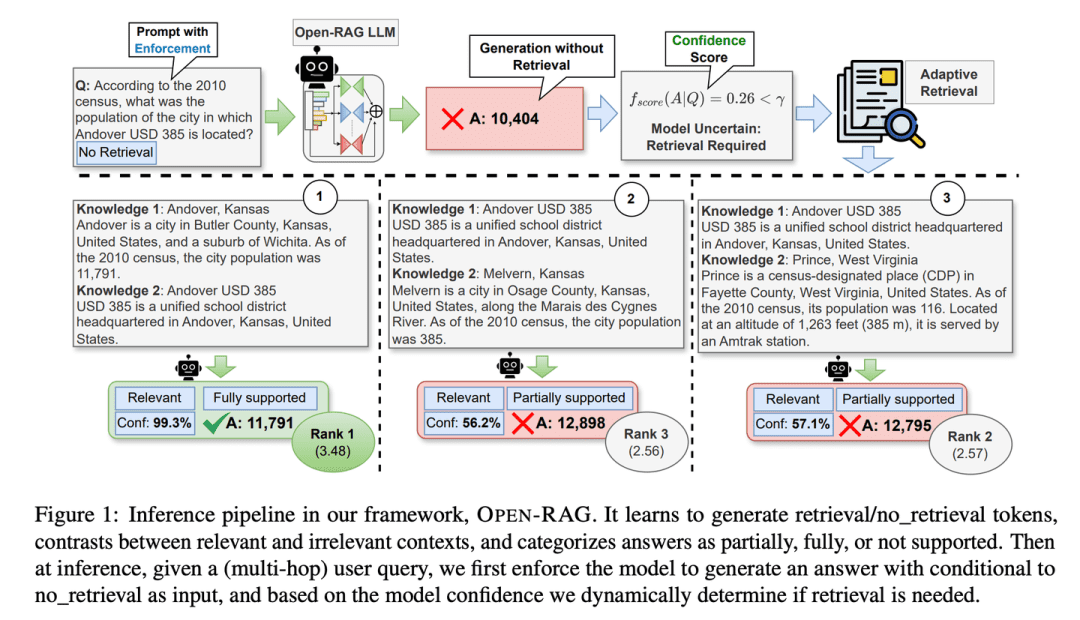

リポジトリ巨大な言語モデルを、単独で考えるだけでなく共同作業もできる専門家集団に分解し、特に熟練したシンクタンクのように、重要な瞬間に情報を調べるか調べないかを見極め、真実と偽りの情報を区別することに長けている。

- 論文:Open-RAG:オープンソースの大規模言語モデルによる検索支援推論の強化

- プロジェクト:https://github.com/ShayekhBinIslam/openrag

OPEN-RAGは、大規模な言語モデルをオープンソース化することで、RAGの推論を改善し、任意に高密度な大規模言語モデルを、シングルホップとマルチホップの両方のクエリを含む複雑な推論タスクを処理できる、パラメータ効率の良いスパースなMoE(Mixed-Mixture-of-Experts)モデルに変換します。

(49) TableRAG[エクセル・エキスパート]

エクセルスペシャリスト単に表形式のデータを見るだけでなく、ヘッダーとセルの両方のディメンションでデータを理解し、取得する方法を知っています。また、ピボットテーブルを使用して、必要な重要な情報をすばやく見つけ、抽出することもできます。

- 論文:TableRAG:言語モデルによる100万トークンのテーブル理解

TableRAGは、テーブル理解に特化した検索機能強化型生成フレームワークを設計しており、クエリ拡張によるスキーマ検索とセル検索を組み合わせることで、言語モデルに情報を提供する前にキーデータをピンポイントで検索し、より効率的なデータエンコーディングと正確な検索を可能にし、ヒントの長さを劇的に短くし、情報損失を低減する。

(50) ライトラグ[スパイダーマン]

スパイダーマン: 知識の網の目を軽快に進み、点と点の間のフィラメントをとらえるだけでなく、網を使って糸をたどる。千里眼を持つ図書館員のように、それぞれの本がどこにあるか知っているだけでなく、どの本を一緒に読むべきかも知っている。

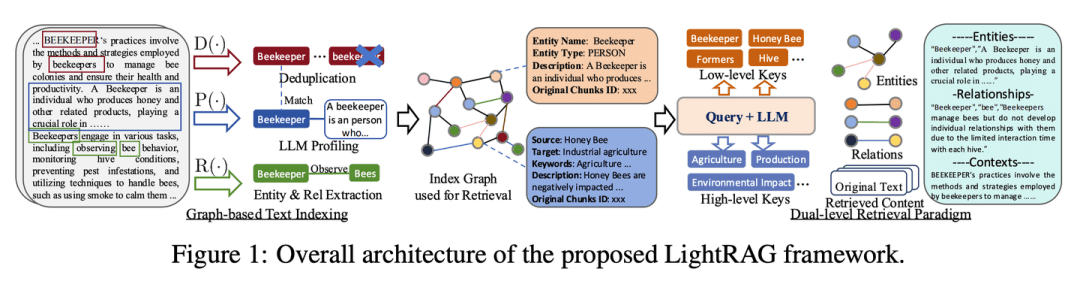

- 論文:LightRAG:シンプルで高速な検索機能拡張型ジェネレーター

- プロジェクト:https://github.com/HKUDS/LightRAG

このフレームワークは、テキストの索引付けと検索プロセスにグラフ構造を統合する。この革新的なフレームワークは、低レベルと高レベルの知識発見の両方から包括的な情報検索を強化する2階層検索システムを採用している。さらに、グラフ構造とベクトル表現を組み合わせることで、関連するエンティティとその関係を効率的に検索し、文脈上の関連性を維持しながら応答時間を大幅に改善する。この機能は、新しいデータのタイムリーな統合を保証するインクリメンタル更新アルゴリズムによってさらに強化され、システムは急速に変化するデータ環境において効果的で応答性の高い状態を維持することができる。

(51) AstuteRAG[ワイズ・ジャッジ]

良識ある判事外部情報を警戒し、検索結果を鵜呑みにせず、自らの蓄積した知識を駆使し、情報の信憑性を選別し、上級裁判官のように多くの関係者の証拠を秤にかけて結論を出すこと。

- 論文:Astute RAG:大規模言語モデルにおける不完全な検索補強と知識の衝突の克服

LLMの内部知識から適応的に情報を抽出し、外部の検索結果と組み合わせ、情報の信頼性に基づいて答えを最終決定することで、システムの頑健性と信頼性を向上させている。

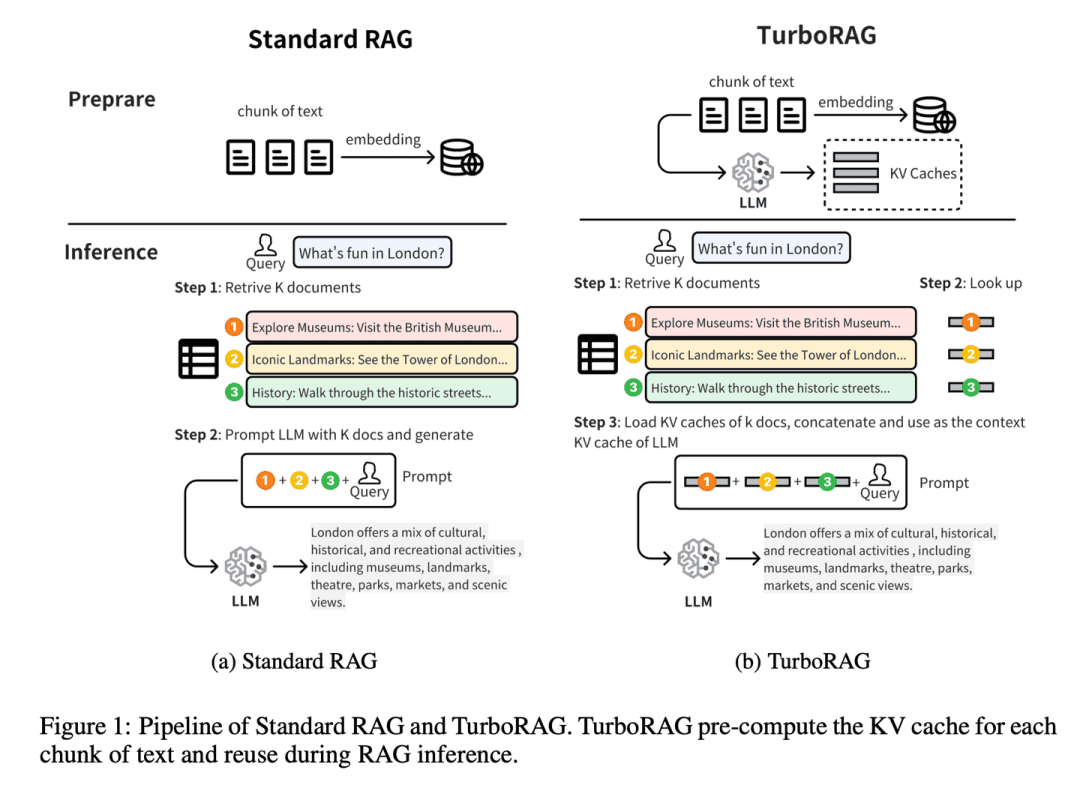

(52) TurboRAG[速記マスター]

マスターステノグラファー事前に宿題をして、小さなノートにすべての答えを書き留めておくこと。試験前の学校のいじめっ子のように、臨床的な留め具ではなく、よくある質問をあらかじめ間違った本に入れておく。あなたが直接使用するために判明する必要があるときは、その場で一度推論しなければならないたびに保存します。

- 論文:TurboRAG:チャンク化されたテキストに対する事前計算KVキャッシュを用いた検索拡張生成の高速化

- プロジェクト:https://github.com/MooreThreads/TurboRAG

TurboRAGは、ドキュメントのKVキャッシュを事前に計算し、オフラインで保存することで、RAGシステムの推論パラダイムを最適化する。従来のアプローチとは異なり、TurboRAGは推論のたびにこれらのKVキャッシュを計算するのではなく、効率的な事前投入のために事前に計算されたキャッシュを取得し、反復的なオンライン計算の必要性を排除する。このアプローチにより、計算オーバーヘッドが大幅に削減され、精度を維持しながら応答時間が短縮される。

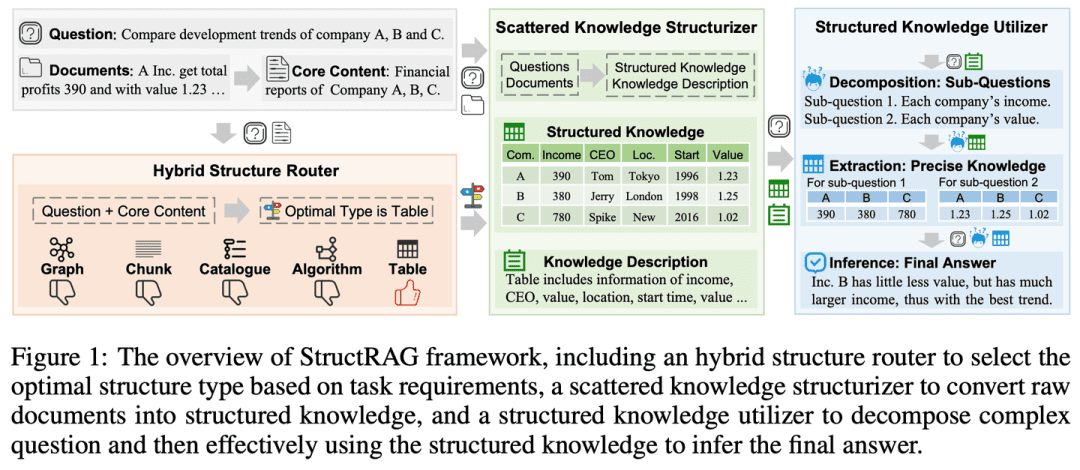

(53) StructRAG [オーガナイザー]

主催者整理されたワードローブのように、雑然とした情報をカテゴリー別に整理する。学校の先生が人間の心理を真似るように、丸暗記の代わりに、まずマインドマップを描こう。

- 論文:StructRAG:推論時間型ハイブリッド情報構造化によるLLMの知識集約的推論の促進

- プロジェクト:https://github.com/Li-Z-Q/StructRAG

人間が知識集約的な推論を行う際に、生の情報を構造化された知識に変換するという認知理論にヒントを得て、このフレームワークは、手元のタスクの特定の要件に従って、最も適切な形式で構造化された知識を構築し、利用するハイブリッド情報構造化メカニズムを導入する。人間のような思考プロセスを模倣することで、知識集約的な推論タスクにおけるLLMの性能を向上させる。

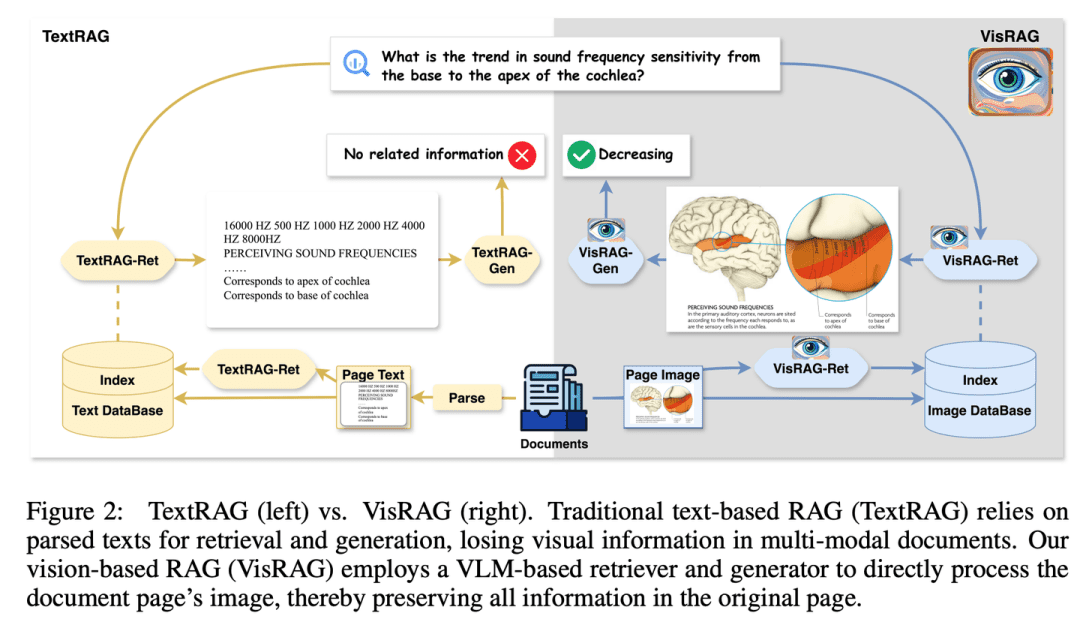

(54) ヴィスラグ[炎の目]

鑑識眼言葉はイメージの特殊な表現形態に過ぎないということにようやく気づいた。目を見開いた読者のように、もはや一語一語を解析することにこだわらず、全体像を直接「見る」のだ。OCRの代わりにカメラを使い、「百聞は一見にしかず」の真髄を学んだ。

- 論文:VisRAG:マルチモダリティ文書における視覚に基づく検索支援生成

- プロジェクト:https://github.com/openbmb/visrag

視覚言語モデル(VLM)に基づくRAGプロセスを構築することで、文書を画像として直接埋め込み、検索することで、生成機能を強化した。従来のテキストRAGと比較して、VisRAGは構文解析中の情報損失を回避し、元の文書の情報をより包括的に保存する。実験によれば、VisRAGは検索と生成の両段階において従来のRAGを凌駕し、25-391 TP3 Tのエンドツーエンドの性能向上を示している。VisRAGは学習データを効果的に利用するだけでなく、強力な汎化能力を示しており、マルチモーダル文書RAGの理想的な選択肢となっている。

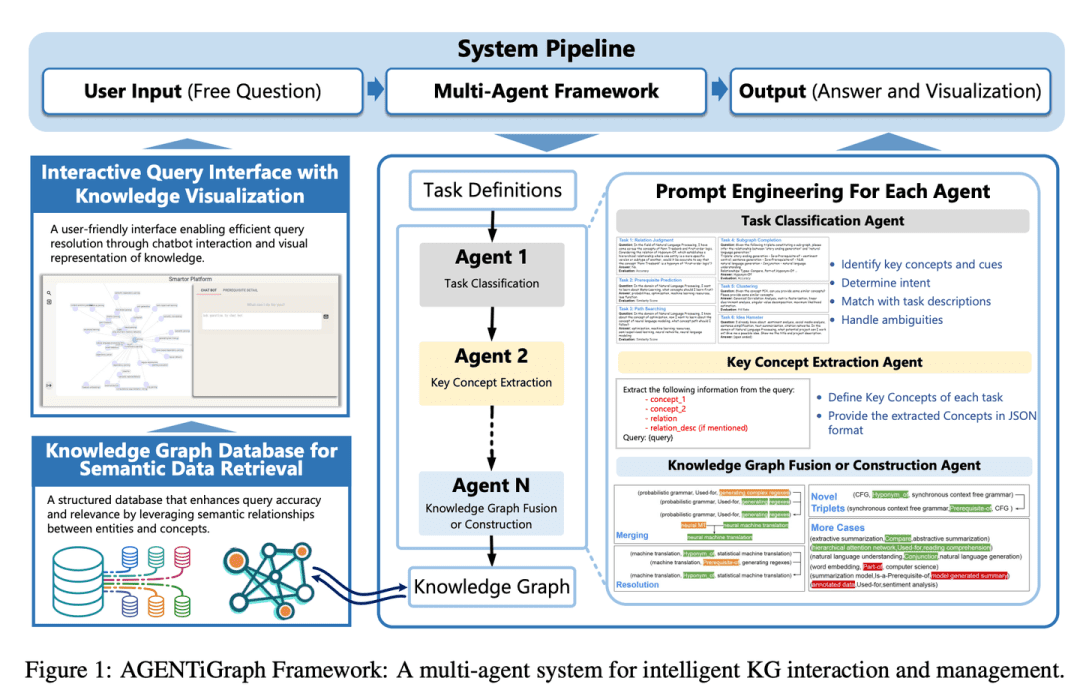

(55) AGENTiGraph [ナレッジ・マネージャー]

ナレッジ・マネージャー会話する図書館員のように、日々のコミュニケーションを通じて知識の整理と提示をサポートし、アシスタント・チームが質問に答えたり情報を更新したりすることで、知識管理を簡単かつ自然に行うことができる。

- 論文:AGENTiGraph:プライベートデータを活用したLLMベースチャットボットのための対話型知識グラフプラットフォーム

AGENTiGraphは、自然言語対話によるナレッジマネジメントのためのプラットフォームです。AGENTiGraphは、マルチ・インテリジェンス・アーキテクチャを採用し、ユーザーの意図を動的に解釈し、タスクを管理し、新しい知識を統合します。

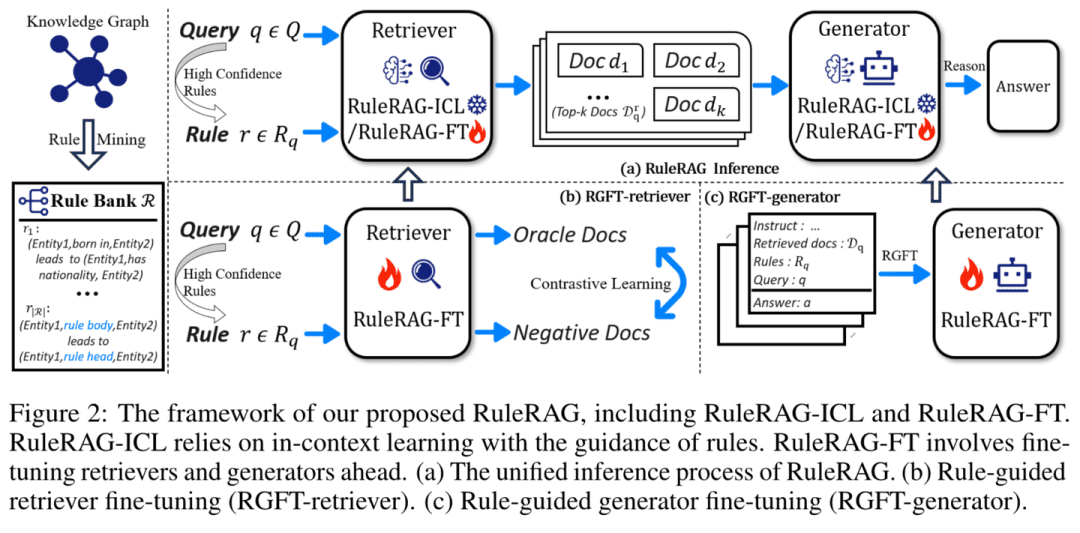

(56) RuleRAG[ルール・フォローイング]

羅針盤に従い、決められた四角を進む(慣用句);融通無碍に規則に従うことルールのあることをAIに教えるのは、新入社員が入社して最初に社員ハンドブックを渡すようなものだ。漫然と学ぶのではなく、厳しい教師が最初にルールと例を説明し、生徒に自分でやらせるようなものだ。さらに、これらのルールは筋肉の記憶となり、次に同じような問題に遭遇したとき、どのように対処すればよいかが自然にわかるようになる。

- 論文: RuleRAG: 質問応答のための言語モデルによるルール誘導検索拡張生成

- プロジェクト:https://github.com/chenzhongwu20/RuleRAG_ICL_FT

RuleRAGは、言語モデルに基づくルール誘導検索強化生成アプローチを提案する。これは、文脈学習の例として記号的ルールを明示的に導入し(RuleRAG - ICL)、ルールの方向に論理的に関連する文書を検索するように検索器を誘導し、同じルールセットに誘導された情報に基づいた回答を生成するように生成器を一律に誘導する。さらに、クエリとルールの組み合わせは、より良いルールベースの指示の順守を達成するために、検索器と生成器を更新するための教師付き微調整データ(RuleRAG - FT)として使用することができ、その結果、より支持的な結果を検索し、より受け入れやすい回答を生成する。

(57)クラスRAG[ジャッジ]

ジャッジ厳格な規定に基づいて事件を判断するのではなく、常に拡大し続ける法律学のライブラリーを通して判決を検討する。経験豊富な裁判官のように、彼はルーズリーフを手に取り、いつでも最新の判例に目を通す。

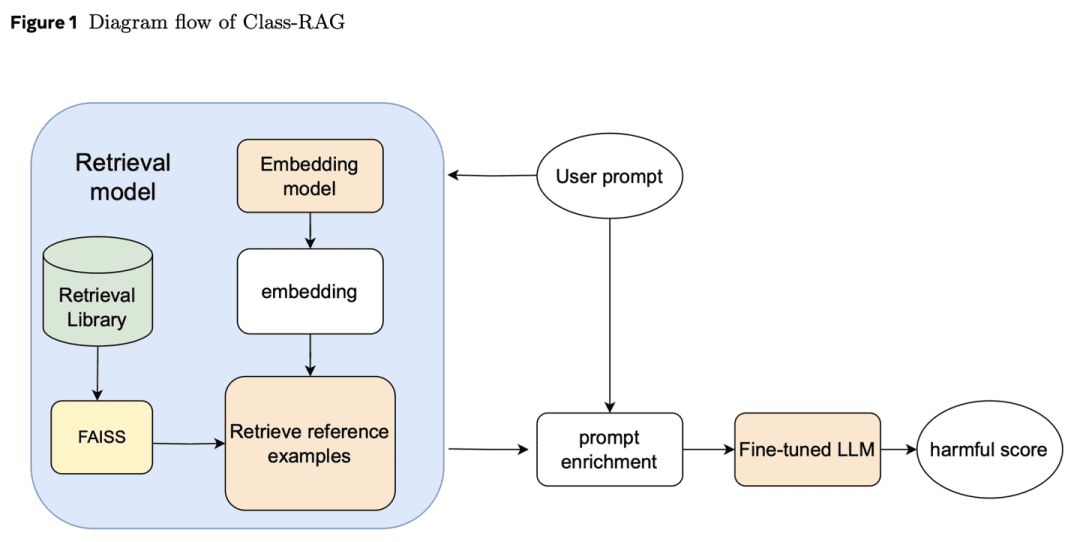

- 論文:Class-RAG:検索補強型生成によるコンテンツ・モデレーション

生成AIのセキュリティにとって、コンテンツの吟味分類器は非常に重要である。しかし、安全なコンテンツと安全でないコンテンツのニュアンスを区別することはしばしば困難である。技術が広く利用されるようになると、リスクに対処するためにモデルを継続的に微調整することはますます難しくなり、コストもかかるようになる。このため、検索ベースを動的に更新することで即座にリスク軽減を実現するClass-RAGアプローチを提案する。Class-RAGは、従来の微調整モデルよりも柔軟で透過的であり、分類と攻撃耐性において優れた性能を発揮する。また、検索ベースを拡張することで、監査性能を低コストで効果的に改善できることも示される。

(58) セルフRAG[リフレクター]

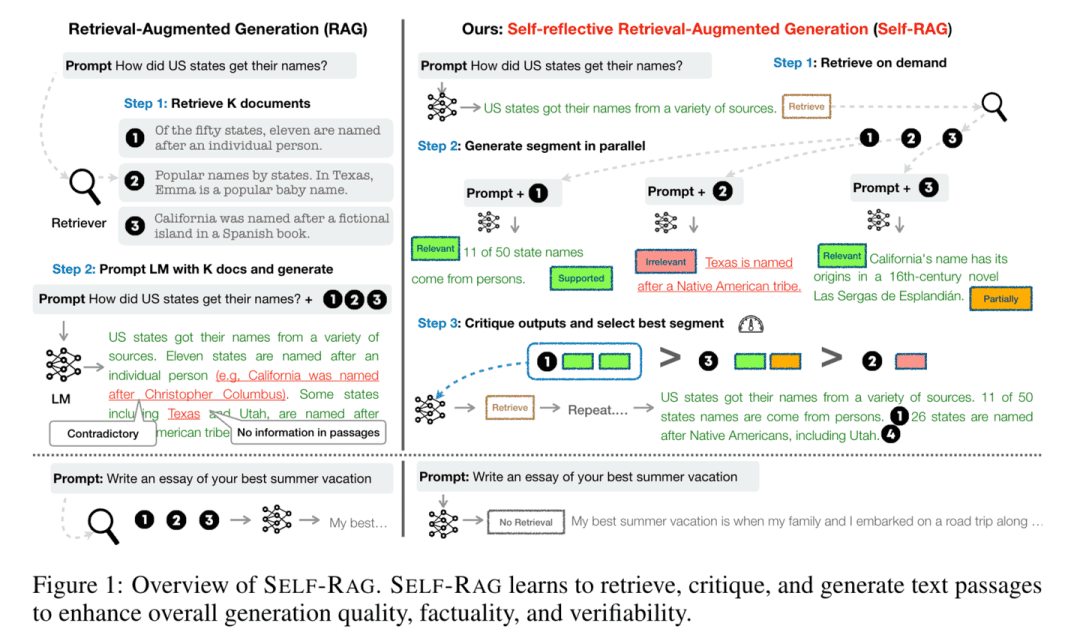

思想家質問に答えるとき、情報を参照するだけでなく、自分の答えが正確で完全なものであるかどうかを考え、チェックする。慎重な学者のように「考えながら話す」ことで、それぞれの見解が確かな証拠によって裏付けられていることを確認する。

- 論文:Self-RAG:自己省察を通して、検索、生成、批評を学ぶ

- プロジェクト:https://github.com/AkariAsai/self-rag

Self-RAGは、検索と自己反省を通じて言語モデルの品質と精度を向上させる。このフレームワークは、要求に応じて適応的にパッセージを検索し、リフレクティブマーカーと呼ばれる特別なマーカーを使用して、検索されたパッセージとそれ自身が生成したコンテンツを生成し、反映することができる単一の任意の言語モデルを学習する。リフレクティブマーカーを生成することで、言語モデルを推論フェーズで制御可能にし、異なるタスク要件にその振る舞いを適応させることを可能にする。

(59) シムラグ[独学]

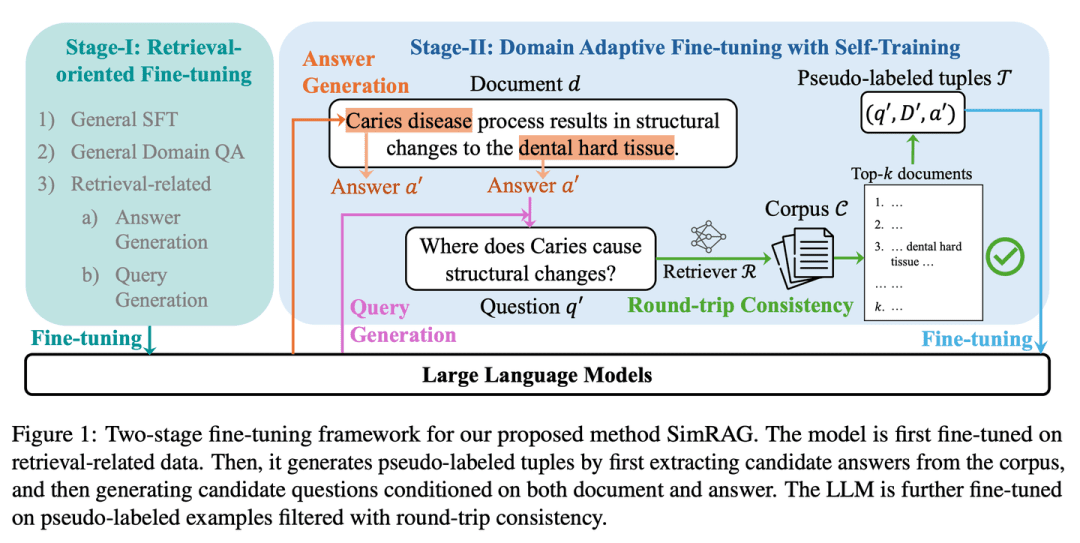

自作の天才専門分野に直面したとき、自分で答えを出す前に自分で質問し、学生が演習を繰り返して専門知識に慣れるのと同じように、絶え間ない練習を通じて専門知識の蓄えを高める。

- 論文:SimRAG:大規模言語モデルを特殊なドメインに適応させるための自己改良型検索拡張世代

SimRAGは、LLMに特定のドメインに適した質問と回答、質問生成の共同能力を身につけさせる自己訓練法である。知識が真に理解されて初めて良い質問ができる。この2つの能力は、モデルが専門知識をよりよく理解するために、互いに補完し合う。LLMはまず、指示に従うこと、Q&A、関連データの検索に関して微調整される。次に同じLLMに、ラベル付けされていないコーパスからドメインに関連する様々な質問を生成するよう促し、さらにフィルタリング戦略を追加して高品質の合成例を保持する。これらの合成例を利用することで、LLMはドメイン固有のRAGタスクのパフォーマンスを向上させることができる。

(60) チャンクラーグ[マスターからの抜粋]

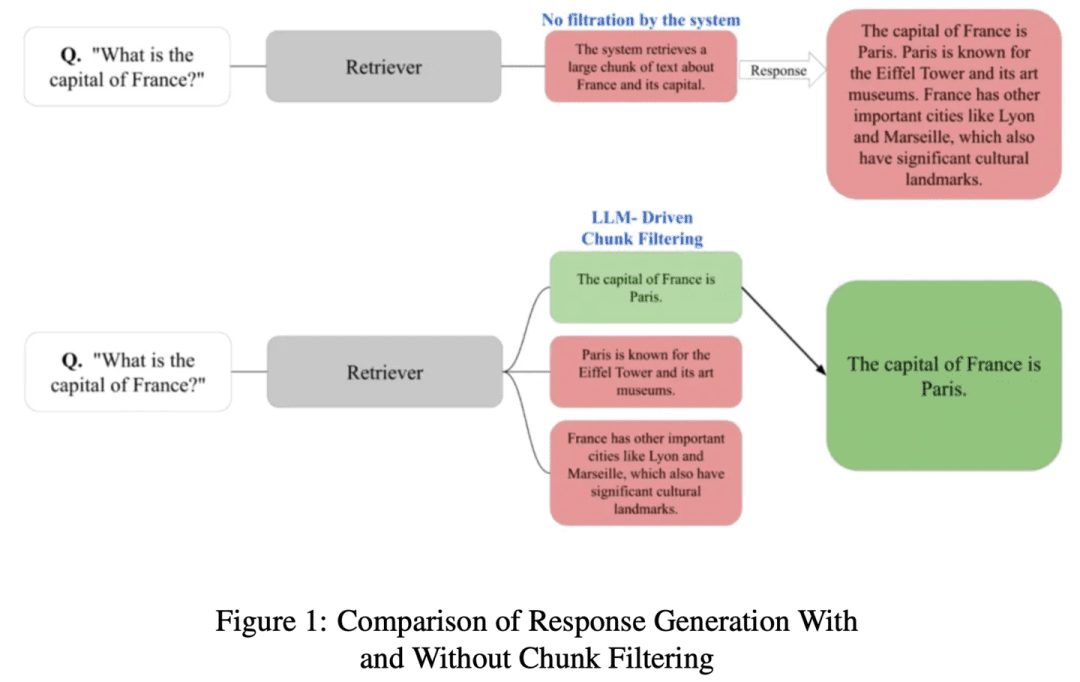

抄者長い記事を小さな段落に分割し、ポイントを外したり、無関係な内容に惑わされることなく、プロの目で最も関連性の高い記事を選び出す。

- 論文:ChunkRAG:RAGシステムのための新しいLLM-チャンクフィルタリング法

ChunkRAGは、検索された情報をチャンクレベルで評価しフィルタリングすることで、RAGシステムのフレームワークを強化するLLM駆動チャンクフィルタリングアプローチを提案する。我々のアプローチは、文書を首尾一貫した部分に分割するためにセマンティック・チャンキングを採用し、各チャンクがユーザのクエリとどの程度マッチするかを評価するために、大規模な言語モデルに基づいた関連性スコアリングを使用する。生成段階の前に関連性の低いチャンクをフィルタリングすることで、錯覚を大幅に減らし、事実精度を向上させる。

(61) FastGraphRAG[レーダー]

レーダーグーグルページランクのように、ナレッジポイントにホットリストを与える。ソーシャルネットワークにおけるオピニオンリーダーのようなもので、多くの人がフォローすればするほど、目に留まりやすくなる。あてもなく探すのではなく、レーダーを持ったスカウトのように、信号が強いところを探すのだ。

- プロジェクト:https://github.com/circlemind-ai/fast-graphrag

FastGraphRAGは、効率的で解釈可能かつ高精度な高速グラフ検索拡張生成(FastGraphRAG)フレームワークを提供する。PageRankアルゴリズムを知識グラフの探索プロセスに適用し、最も関連性の高い知識ノードを素早く見つける。ノードの重要度スコアを計算することで、PageRankはGraphRAGが知識グラフ内の情報をよりインテリジェントにフィルタリングし、ソートすることを可能にする。これはGraphRAGに「重要度レーダー」を装備するようなもので、膨大なデータの中から重要な情報を素早く見つけることができる。

(62) オートラグ[チューナー]

チューナーRAGは経験豊富なチューナーであり、推測ではなく科学的なテストによって最高のサウンドを見つけます。チューナーが様々なオーディオ機器をテストして最も調和のとれた「演奏ソリューション」を見つけるように、RAGも自動的に様々な組み合わせを試します。

- 論文:AutoRAG:検索拡張生成パイプラインの最適化のための自動フレームワーク

- プロジェクト:https://github.com/Marker-Inc-Korea/AutoRAG_ARAGOG_Paper

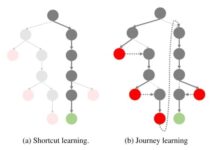

AutoRAGフレームワークは、与えられたデータセットに適したRAGモジュールを自動的に識別し、そのデータセットに最適なRAGモジュールの組み合わせを探索し近似する。手法の選択を最適化するために異なるRAGセットアップを系統的に評価することで、このフレームワークは、RAG手法の選択を最適化し、RAGシステムの効率性とスケーラビリティを改善するために広範な実験が実施される、従来の機械学習におけるAutoMLの実践に似ている。

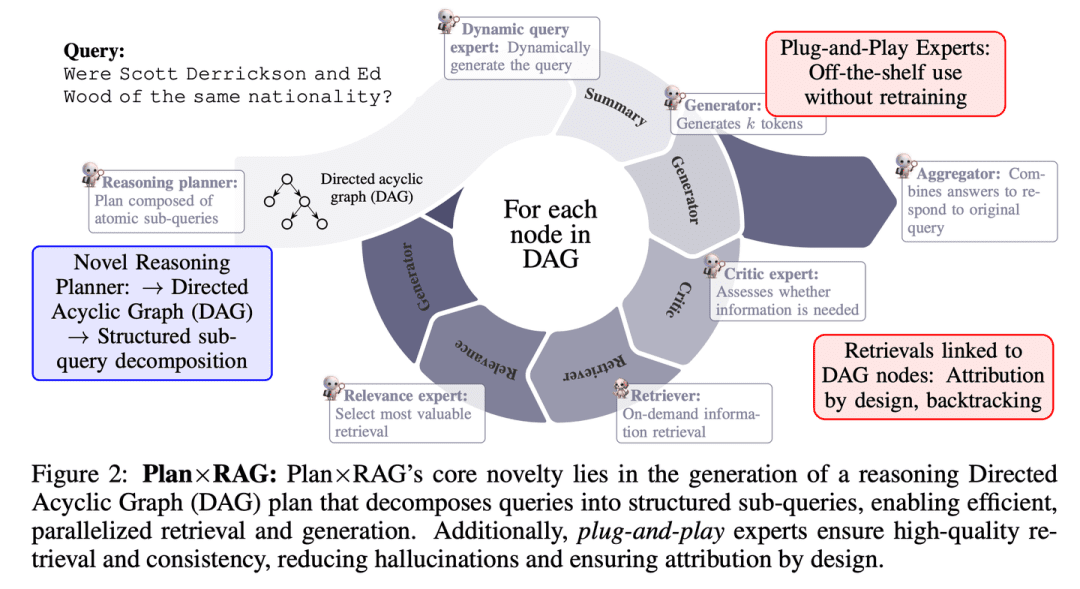

(63)プラン×RAG【プロジェクトマネージャー

プロジェクトマネージャー行動する前に計画を立て、大きなタスクを小さなタスクに分解し、複数の「専門家」が並行して作業できるように手配する。各エキスパートはそれぞれの分野を担当し、プロジェクトマネージャーは最後に結果をまとめる。このアプローチは、より迅速かつ正確であるだけでなく、各結果の出典を明確に説明することができる。

- 論文:プラン×RAG:プランニング誘導型検索拡張世代

Plan×RAGは既存のRAGフレームワークの "検索-推論 "パラダイムを "計画-検索 "パラダイムに拡張する新しいフレームワークである。Plan×RAGは、推論計画を有向非循環グラフ(DAG)として定式化し、クエリを相互に関連するアトミックなサブクエリに分解する。回答生成はDAG構造に従い、検索と生成を並列に行うことで効率を大幅に向上させる。最先端のRAGソリューションが大規模なデータ生成と言語モデル(LM)の微調整を必要とするのに対し、Plan×RAGは凍結されたLMをプラグアンドプレイのエキスパートとして組み込み、高品質な回答を生成する。

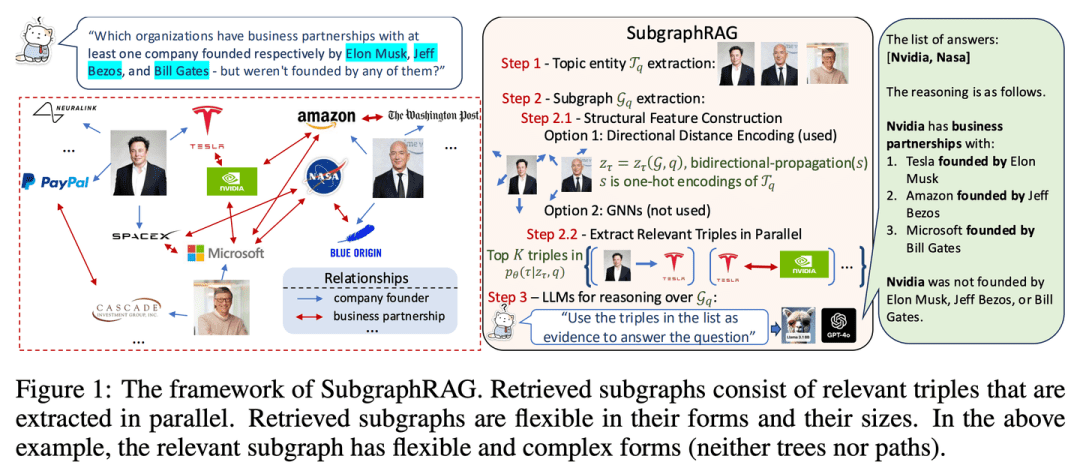

(64) サブグラフRAG [ロケータ]

ポジショナー干し草の山から針を探す代わりに、知識の小さな地図を正確に描くことで、AIは素早く答えを見つけることができる。

- 論文:シンプル・イズ・エフェクティブ:知識グラフに基づく検索-拡張生成におけるグラフと大規模言語モデルの役割

- プロジェクト:https://github.com/Graph-COM/SubgraphRAG

SubgraphRAGは、KGベースのRAGフレームワークを、サブグラフを検索し、推論と解答予測にLLMを利用することで拡張したものである。軽量な多層パーセプトロンは、効率的で柔軟なサブグラフ検索のために、並列3値スコアリング機構と組み合わされる。検索される部分グラフのサイズは、クエリの要求と下流のLLMの能力に合わせて柔軟に調整できる。この設計は、モデルの複雑さと推論能力のバランスをとり、スケーラブルで汎用的な検索プロセスを可能にする。

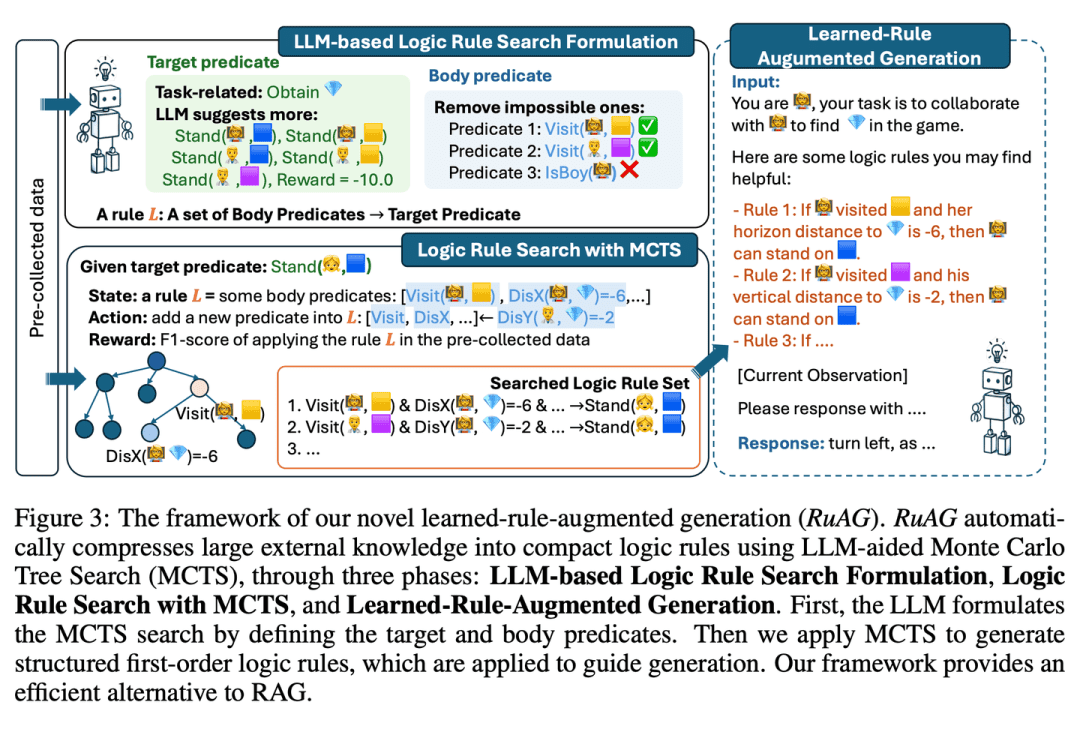

(65) ルラグ[錬金術師]

錬金術師錬金術師のように、大量のデータを明確な論理的ルールに落とし込み、平易な言葉で表現することで、AIをより賢く実用化することができる。

- 学位論文:RuAG:大規模言語モデルのための学習則補強型生成

このフレームワークは、大量のオフラインデータを解釈可能な一次論理ルールに自動的に抽出し、LLMに注入することで、大規模言語モデル(LLM)の推論機能を強化することを目的としている。このフレームワークは、モンテカルロ木探索(MCTS)を用いて論理ルールを発見し、これらのルールを自然言語に変換することで、LLMの下流タスクへの知識注入とシームレスな統合を可能にする。本論文では、公共および民間の産業タスクにおけるフレームワークの有効性を評価し、多様なタスクにおけるLLM能力を強化する可能性を示す。

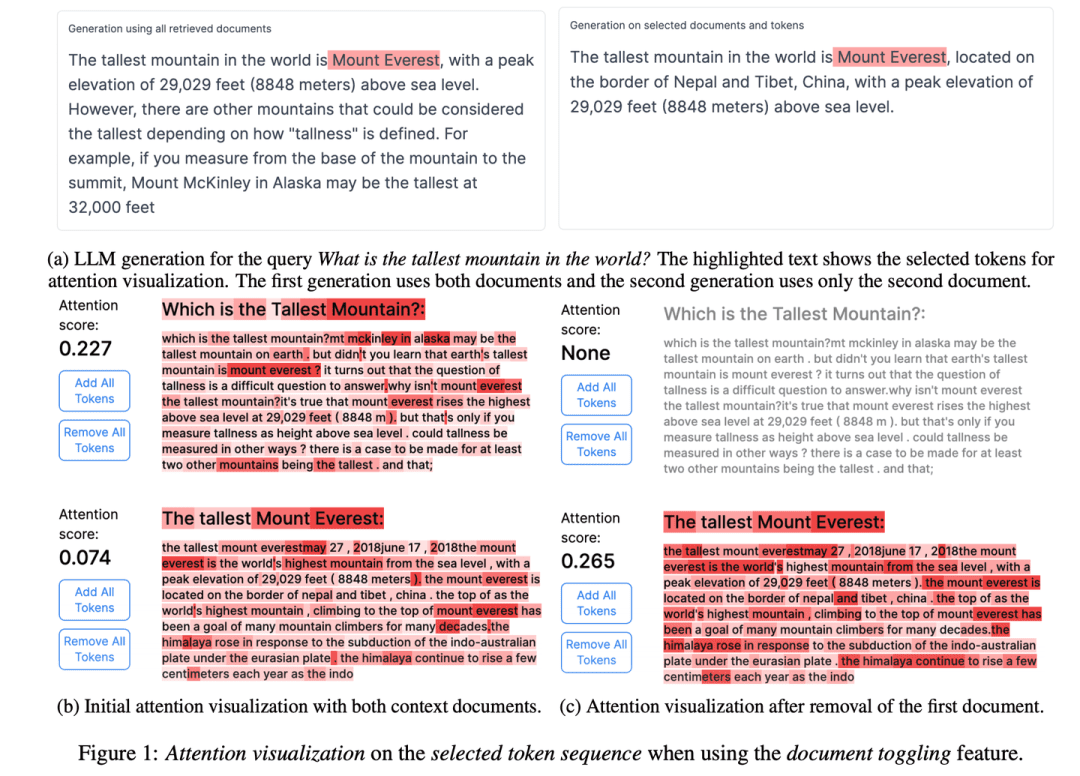

(66) RAGViz[シースルー・アイ]

トンネル・ビジョンRAGシステムを透明化し、医者がレントゲンを見るように、モデルがどの文章を読んでいるかが一目でわかるようにする。

- 論文:RAGViz:検索補強世代の診断と可視化

- プロジェクト:https://github.com/cxcscmu/RAGViz

RAGVizは、生成されたマークアップと検索されたドキュメントの相互作用を理解するために、検索されたドキュメントとモデルの注意を視覚化し、RAGシステムの診断と視覚化に使用することができます。

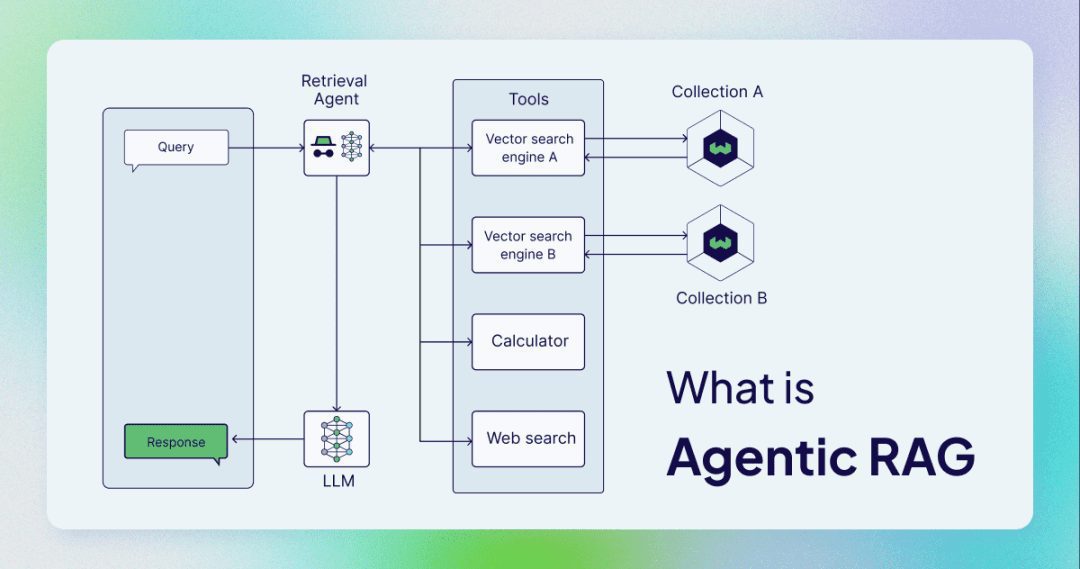

(67) AgenticRAG[インテリジェント・アシスタント]

インテリジェントアシスタントもはや調べてコピーするだけの単純な仕事ではなく、秘密秘書のような役割を果たせるアシスタントが必要なのだ。有能な管理者のように、情報の調べ方だけでなく、電話をかけるタイミング、会議を開くタイミング、指示を仰ぐタイミングも心得ている。

AgenticRAGは、AIインテリジェンスの実装に基づくRAGを説明している。具体的には、AIインテリジェンスをRAGプロセスに組み込み、そのコンポーネントを調整し、単純な情報検索と生成を超える追加アクションを実行することで、非インテリジェントな本体プロセスの限界を克服する。

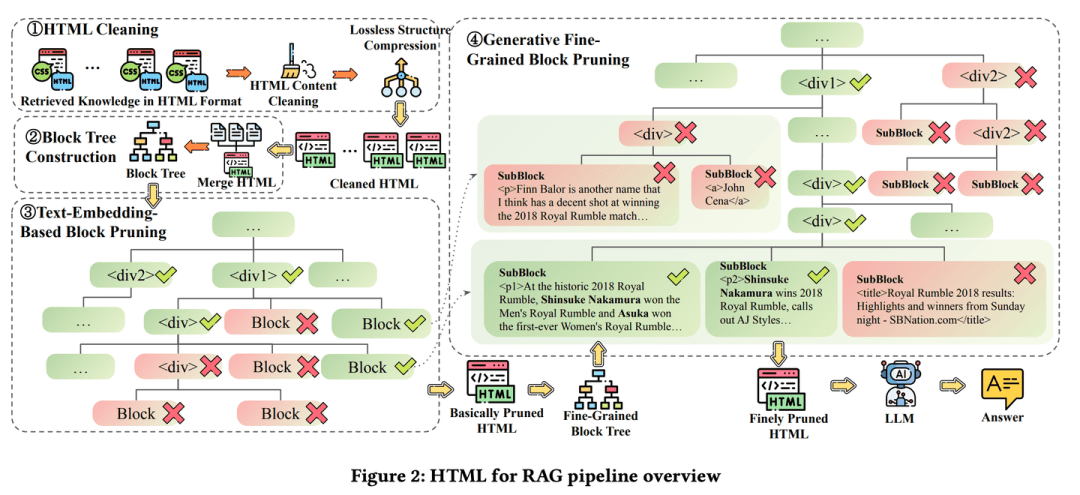

(68) HtmlRAG[タイポグラファー]

タイポグラファー: ナレッジはランニングアカウントとしてではなく、雑誌のレイアウトのように、太字が必要なところは太字にし、赤字が必要なところは赤字にしている。内容だけでは物足りないと感じるうるさい編集者のように、重要なポイントが一目でわかるようにレイアウトも工夫されている。

- 論文:HtmlRAG:RAGシステムにおいて取得された知識をモデル化するために、HTMLはプレーンテキストよりも優れている。

- プロジェクト:https://github.com/plageon/HtmlRAG

HtmlRAGは、RAGで知識を検索するためのフォーマットとして、プレーンテキストではなくHTMLを使用する。HTMLは、外部文書から知識をモデル化する場合にプレーンテキストよりも優れており、ほとんどのLLMはHTMLをよく理解している。HtmlRAGは、情報の損失を最小限に抑えながらHTMLを短縮するために、HTMLのクリーンアップ、圧縮、刈り込み戦略を提案する。

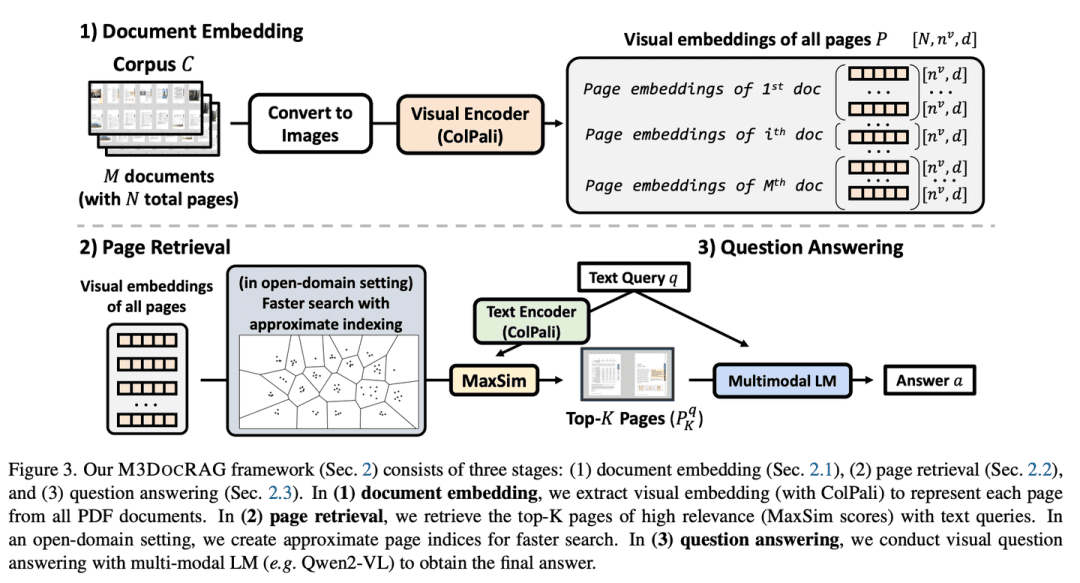

(69) M3DocRAG 【官能主義者

かんかくしゃ字が読めるだけでなく、絵も読めるし、声も聞ける。バラエティ番組の万能選手のように、絵を読み、言葉を理解し、跳ぶべき時には跳び、集中すべき時には細部に集中し、あらゆるチャレンジに負けない。

- 論文:M3DocRAG:多ページ多文書理解に必要なのはマルチモーダル検索である

M3DocRAGは、様々な文書コンテキスト(クローズドドメインとオープンドメイン)、質問ジャンプ(単一と複数)、証拠モード(テキスト、チャート、グラフなど)に柔軟に適応する新しいマルチモーダルRAGフレームワークである。情報

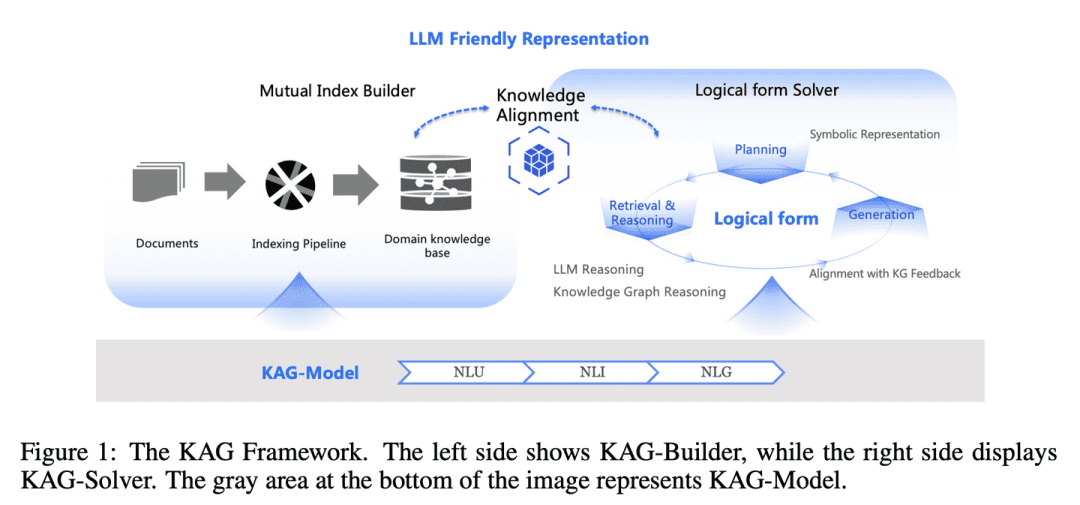

(70) KAG[マスターズ・オブ・ロジック]

ロジックマスター: 単に感覚で似たような答えを見つけるだけでなく、知識同士の因果関係も重要です。厳格な数学教師のように、答えが何であるかを知るだけでなく、その答えがどのように導き出されたかを段階的に説明する必要がある。

- 論文:KAG:知識拡張世代による専門領域のLLMのブースト

- プロジェクト:https://github.com/OpenSPG/KAG

KAGはナレッジグラフ(KG)とベクトル検索の長所を活用して上記の課題に対処するように設計されており、以下の5つの重要な側面を通じて大規模言語モデル(LLM)とナレッジグラフを双方向に強化します。(1)LLMに適した知識表現、(2)知識グラフと生のチャンク間のクロスインデックス、(3)論理形式ガイド付きハイブリッド推論エンジン、(4)意味推論との知識アライメント、(5)KAGのモデリング能力強化。

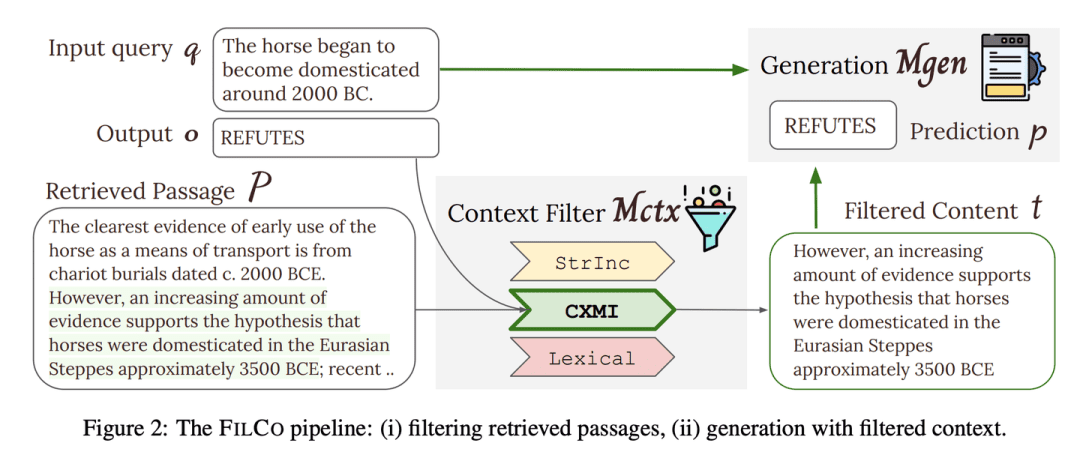

(71) FILCO [スクリーナー]

スクリーナー厳格な編集者のように、大量のテキストから最も価値のある情報を特定し、保持することに長けており、AIに配信されるすべてのコンテンツが正確かつ適切であることを保証する。

- 論文:検索補強型生成のための文脈フィルタリング学習

- プロジェクト:https://github.com/zorazrw/filco

FILCOは、語彙的アプローチと情報理論的アプローチに基づいて有用なコンテキストを識別し、コンテキスト・フィルタリング・モデルを訓練して検索されたコンテキストをフィルタリングすることにより、ジェネレータに提供されるコンテキストの質を向上させる。

(72) LazyGraphRAG[アクチュアリー]

アクチュアリー一歩は一歩、貯めれば貯まる。スーパーのセールを見て買うだけでなく、比較してからどこにお金をかけるのが一番お得なのかを決めるのが、暮らし方を知っている主婦のようです。

- プロジェクト:https://github.com/microsoft/graphrag

グラフを利用した拡張検索(RAG)生成の新しいアプローチ。LazyGraphRAGはLLMの使用を遅延させる。インデックス作成段階では、LazyGraphRAGはテキストを処理するために軽量のNLP技術のみを使用し、実際のクエリまでLLMの起動を遅らせる。この "怠惰な "戦略により、先行する高いインデックス作成コストを回避し、効率的なリソース利用を実現する。

| 従来のグラフ | レイジーグラフ | |

| 索引段階 | - LLMを使用したエンティティと関係の抽出と記述 - 各エンティティとリレーションシップのサマリーを生成 - LLMを使ったコミュニティ・コンテンツの要約 - 埋め込みベクトルを生成する - パーケットファイルの生成 |

- NLP技術を用いた概念と共起関係の抽出 - 概念マップの構築 - コミュニティ構造の抽出 - LLMはインデックス作成段階では使用されない |

| 問い合わせ段階 | - コミュニティ・サマリーを使用してクエリに直接回答 - クエリの絞り込みと関連情報への集中の欠如 |

- LLMを使用してクエリを絞り込み、サブクエリを生成する - 関連性に基づくテキストセグメントとコミュニティの選択 - LLMを使用した回答の抽出と生成 - より関連性の高い内容に焦点を当て、より的確な回答 |

| LLMコール | - インデックス作成段階とクエリー段階の両方で多用される | - LLMはインデックス作成段階では使用されない - クエリーフェーズでのみLLMを呼び出す - LLMはより効率的に使用される |

| コスト効率 | - 高コストと時間のかかるインデックス作成 - インデックス品質によって制限されるクエリ性能 |

- インデックス作成コストは従来のGraphRAGのわずか0.1% - 高い照会効率と質の高い回答 |

| データストレージ | - パーケットファイルは、インデックス化されたデータから生成され、大規模なデータの保存や処理に適している。 | - インデックス化されたデータは軽量フォーマット(JSONやCSVなど)で保存され、迅速な開発や小さなデータサイズに適している。 |

| 使用シナリオ | - コンピューティング・リソースや時間に左右されないシナリオの場合 - ナレッジグラフは事前に作成し、Parquetファイルとして保存しておく必要がある。 |

- 迅速なインデックス作成とレスポンスを必要とするシナリオの場合 - 単発のクエリ、探索的分析、ストリーミング・データ処理に最適 |

RAGサーベイ

- 検索を利用したテキスト生成に関する調査

- 拡張世代のためのマルチモーダル情報の検索:調査

- 大規模言語モデルのための検索支援型生成:サーベイ

- AIが生成したコンテンツの検索拡張生成:調査

- 大規模言語モデルのための検索支援テキスト生成に関するサーベイ

- RAGとRAU:自然言語処理における検索補強言語モデルに関するサーベイ

- RAGミーティングLLMに関する調査:検索補強大規模言語モデルに向けて

- 検索支援型ジェネレーションの評価:調査

- 自然言語処理のための検索支援型生成:サーベイ

- グラフ検索-拡張世代:サーベイ

- 検索補強世代(RAG)の包括的な調査:進化、現在の状況、将来の方向性

- 検索拡張世代(RAG)とその後:LLMに外部データをより賢く利用させる方法に関する包括的な調査

RAGベンチマーク

- 検索支援生成における大規模言語モデルのベンチマーク

- リコール:外部反事実知識に対するLLMの頑健性のベンチマーク

- ARES: 検索支援型生成システムの自動評価フレームワーク

- RAGAS:検索拡張世代の自動評価

- CRUD-RAG:大規模言語モデルの検索支援生成のための包括的な中国語ベンチマーク

- FeB4RAG:検索拡張世代の文脈における統合検索の評価

- CodeRAG-Bench:検索はコード生成を強化できるか?

- Long2RAG:キーポイントリコールによるロングコンテクスト&ロングフォーム検索-拡張生成の評価

![エージェントAI:マルチモーダルインタラクションのフロンティアの世界を探る [フェイフェイ・リー - クラシック必読] - チーフAIシェアリングサークル](https://www.aisharenet.com/wp-content/uploads/2025/01/6dbf9ac2da09ee1-220x150.png)