Quelle est la meilleure version pour exécuter les grands modèles de DeepSeek-R1 avec une carte graphique RTX 4090 ?

Exécution de DeepSeek-R1 avec une carte graphique RTX 4090.Préférence recommandée pour Q4_K_M quantised 671B full-blooded versionsuivi d'une version quantifiée de 14B ou 32B, à condition qu'il s'appuie sur les KTransformers, et s'il est fastidieux d'apprendre la méthode Débarbouillettes Une version quantitative a été introduite, et en voici une autre Ollama Tutoriel d'installation DeepSeek R1 671B Tutoriel de déploiement local : basé sur Ollama et la quantification dynamiqueCela dépend de vos besoins en termes de "puissance extrême" ou de "vitesse". Cela dépend de vos besoins en termes de "puissance extrême" ou de "rapidité".

1️⃣ RTX 4090 La version complète (671B) fonctionne également ?

Oui ! L'équipe de Tsinghua KTransformateurs Laissez une seule carte graphique 4090 exécuter la version complète.

- Mémoire VGA requiseLe Q4_K_M Quantised Edition ne nécessite que 14 Go de mémoire vidéo, et les 24 Go du 4090 sont parfaitement suffisants.

- rythmeLes vitesses de prétraitement allant jusqu'à 286 mots/seconde et les vitesses de génération d'environ 14 mots/seconde sont déjà trop élevées pour être perçues par le commun des mortels.

- ScénarioTâches nécessitant un raisonnement complexe, telles que l'écriture d'un code, les dialogues à plusieurs tours.

2️⃣ Si c'est trop lent ? Essayez une version plus petite

Si vous trouvez que 14 mots/seconde est trop lent, vous pouvez choisir un modèle plus petit :

- 14B version quantifiéeLa mémoire graphique requise est d'environ 6,5 Go, ce qui permet d'accélérer la vitesse d'écriture et de traduction au quotidien.

- 32B version quantifiéeLe logiciel de traitement de texte : nécessite 14,9 Go de mémoire vidéo et prend en charge le traitement de textes longs (par exemple, l'analyse d'articles entiers).

3️⃣ Pourquoi la version à sang plein court-elle à la place ?

Voici une astuce technique :Déchargement quantitatif et informatique.

- quantifiableLa compression du modèle à une taille plus petite, par exemple la quantification sur 4 bits (Q4), réduit l'empreinte mémoire de 70%.

- Calculer le déchargementLe GPU est un outil d'aide à la décision : il permet d'abandonner les tâches de calcul non importantes au profit du CPU et de laisser le GPU faire ce qu'il sait faire le mieux.

4️⃣ Comparaison avec d'autres solutions graphiques

Là encore, utilisez la version complète :

- Cluster graphique H100Il coûte des centaines de milliers de dollars et est plus rapide, mais il n'est pas abordable pour le commun des mortels.

- carte graphique maisonLa compatibilité n'est pas suffisante et il est facile de tomber dans le piège.

rendre un verdictLe 4090 est de loin l'option la plus rentable.

5️⃣ Conseils de déploiement

- dépense ou frais

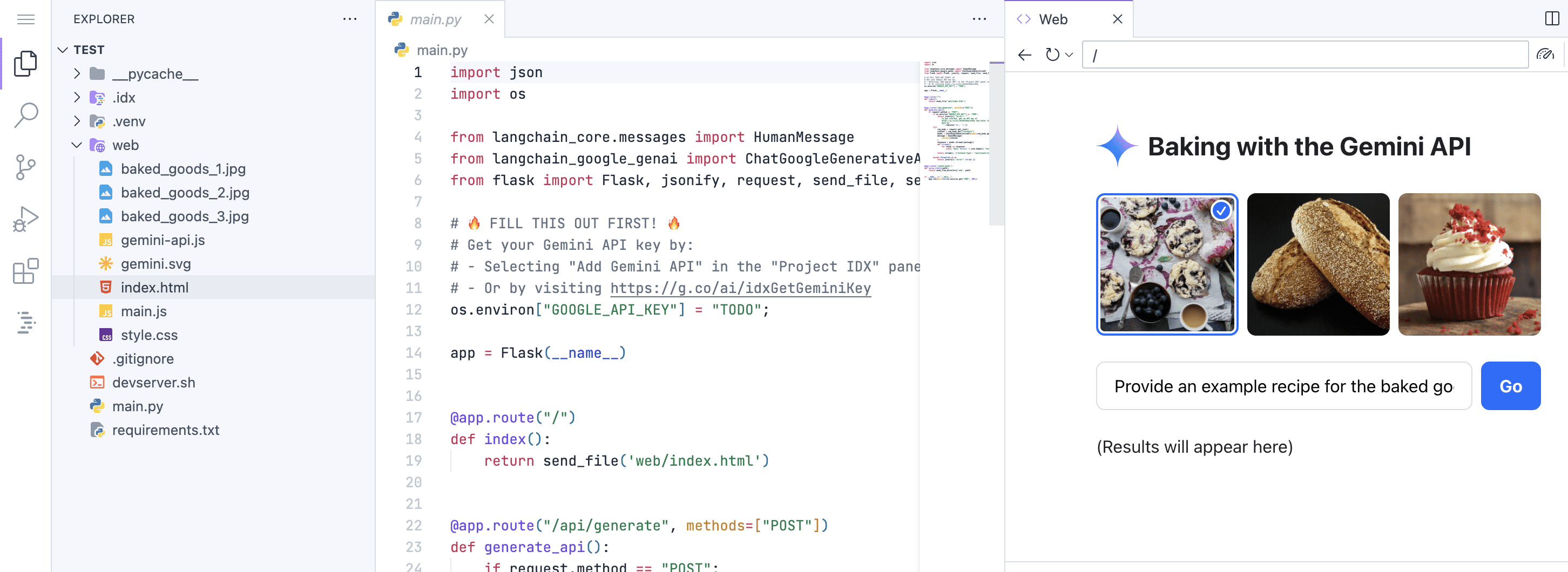

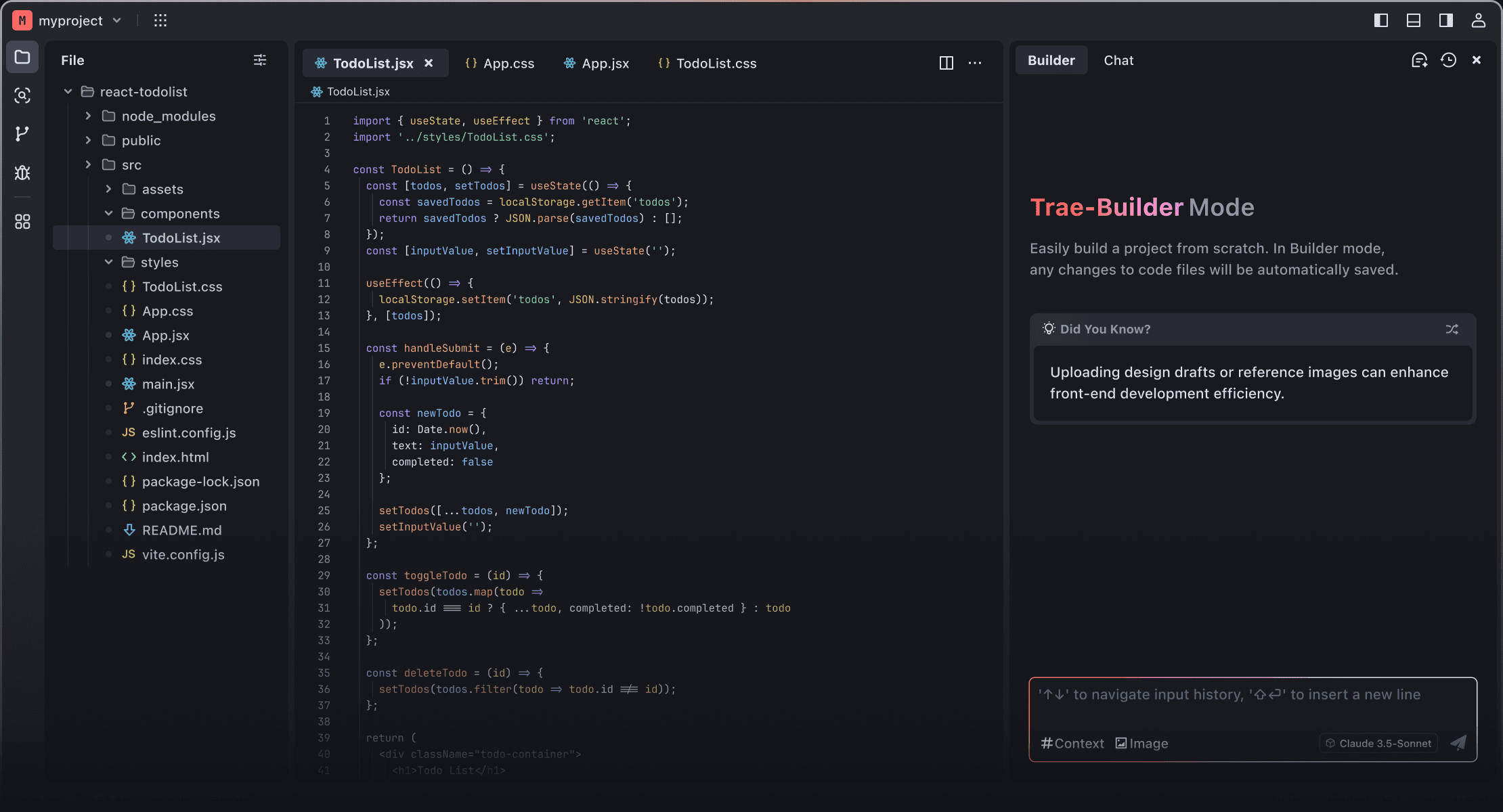

KTransformersLe cadre peut être déployé en un seul clic et est doté de la même interface que ChatGPT. - Si vous manquez de mémoire, vous pouvez essayer le mode "activer seulement 6 experts", qui est un peu plus rapide.

Pour l'IA la plus intelligente, choisissez le 671B quantifié, pour un dialogue fluide, choisissez le 14B/32B, le 4090 a tout pour plaire !

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...