Petit modèle, grande puissance : QwQ-32B avec un paramètre de 1/20 pour lutter contre DeepSeek-R1 au sang chaud

Récemment, des progrès impressionnants ont été réalisés dans le domaine de l'IA, en particulier pour améliorer la capacité de raisonnement des grands modèles de langage (LLM). Parmi eux, l'apprentissage par renforcement (RL) devient une technologie clé pour éliminer le goulot d'étranglement des performances des modèles traditionnels. De nombreuses études ont confirmé que l'apprentissage par renforcement peut améliorer de manière significative la capacité de raisonnement des modèles. Par exemple, le modèle DeepSeek R1 est parvenu à une réflexion approfondie et à un raisonnement complexe en intégrant des données de départ à froid et une formation en plusieurs étapes, atteignant ainsi le niveau le plus élevé à l'époque.

Dans ce contexte, AliCloud a lancé le modèle QwQ-32B, qui a une fois de plus attiré l'attention de l'industrie. Ce modèle, qui compte 32 milliards de paramètres, est comparable, en termes de performances, au modèle QwQ-32B d'AliCloud. Profondeur de l'eau-R1 qui comporte un nombre élevé de 671 milliards de paramètres (37 milliards de paramètres activés). Les performances exceptionnelles de QwQ-32B démontrent clairement l'efficacité de l'apprentissage par renforcement pour améliorer l'intelligence de puissants modèles de base préformés sur la base d'une connaissance massive du monde.

De plus, Aliyun a également intégré des capacités liées aux agents dans le modèle de raisonnement du QwQ-32B, ce qui lui permet non seulement de penser de manière critique, mais aussi d'utiliser des outils et d'ajuster le processus de raisonnement en fonction du retour d'information de l'environnement. Ces avancées technologiques démontrent le potentiel de transformation de la technologie RL et ouvrent la voie à l'intelligence artificielle générale (AGI).

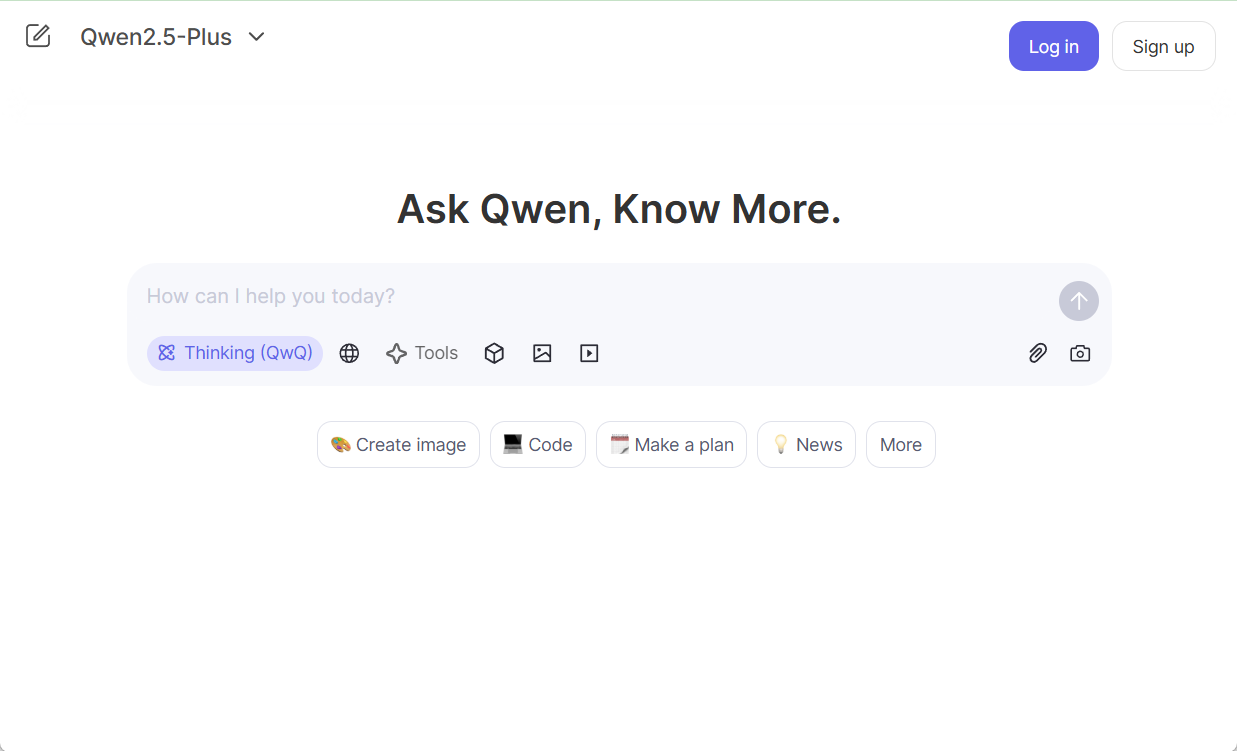

Actuellement, QwQ-32B a été publié sur les plateformes Hugging Face et ModelScope sous le protocole open-source Apache 2.0, et les utilisateurs peuvent y accéder via le site web Chat Qwen Expérience.

Introduction

QwQ est le modèle d'inférence de la famille de modèles "Qwen". Par rapport aux modèles traditionnels de réglage fin des instructions, les modèles QwQ ont des capacités de réflexion et de raisonnement plus fortes, et montrent des gains de performance significatifs dans les tâches en aval, en particulier lors de la résolution de puzzles complexes. qwQ-32B, en tant que modèle d'inférence de taille moyenne, a des performances comparables à celles des modèles d'inférence avancés tels que DeepSeek-R1 et o1-mini. sont comparables à celles de modèles d'inférence avancés tels que DeepSeek-R1 et o1-mini.

Caractéristiques du modèle.

- typologieModèles de langage causal

- phase de formationLes outils d'apprentissage : Pré-entraînement et post-entraînement, y compris le réglage fin supervisé et l'apprentissage par renforcement.

- construireStructure des transformateurs avec codage positionnel RoPE, fonction d'activation SwiGLU, normalisation RMSNorm et biais QKV de l'attention Mécanisme de l'attention biaisé

- échelle des paramètres32,5 milliards de dollars (32,5B)

- Taille des paramètres de la couche non incorporée31 milliards de dollars (31,0 milliards d'euros)

- étage: 64

- Chefs d'attention (GQA)Le nombre d'utilisateurs est de 40 du côté de la requête et de 8 du côté de la clé/valeur.

- Longueur du contexte: Complet 131 072 jetons

prendre notePour une expérience optimale, assurez-vous de vous référer à la page d'accueil du site web de la Commission européenne. Lignes directrices pour l'utilisation Le modèle QwQ est déployé ultérieurement.

Les utilisateurs peuvent utiliser le Démonstration Vivre une expérience, ou passer par le QwenChat Pour accéder au modèle QwQ, pensez à ouvrir Thinking (QwQ).

Pour de plus amples informations, veuillez vous référer à Dépôts GitHub aussi document officiel.

Performance

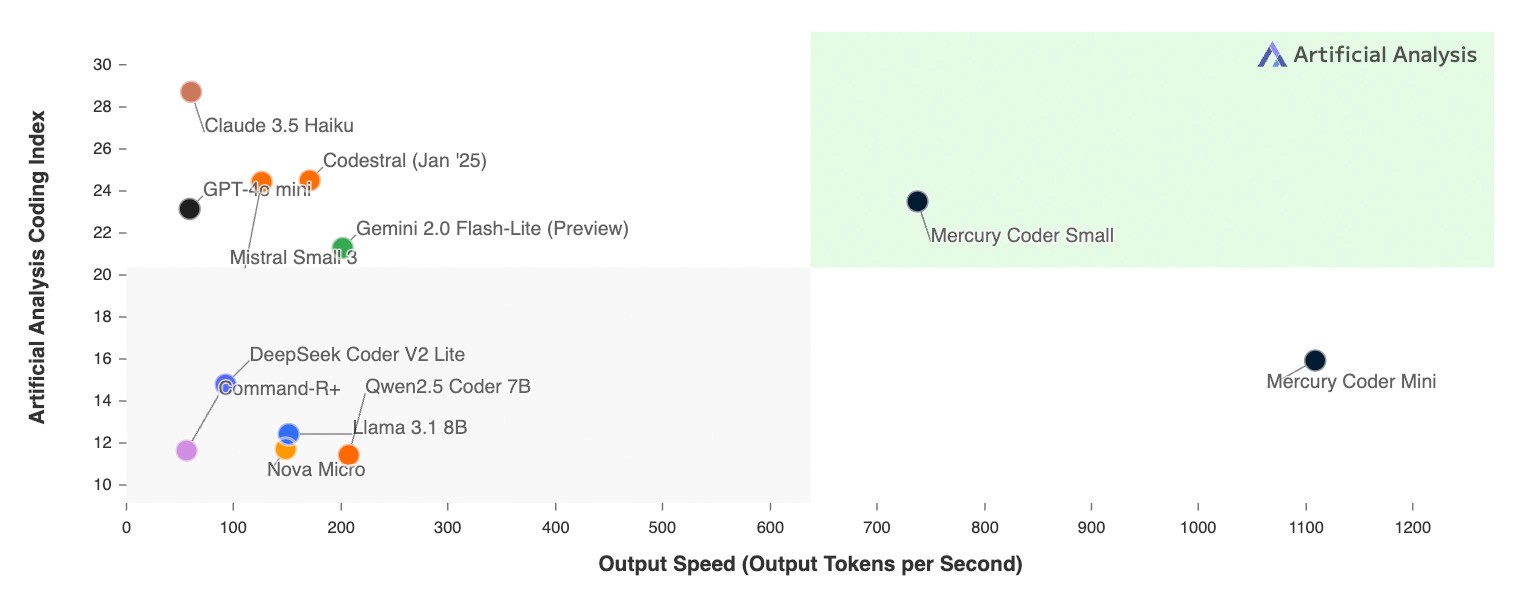

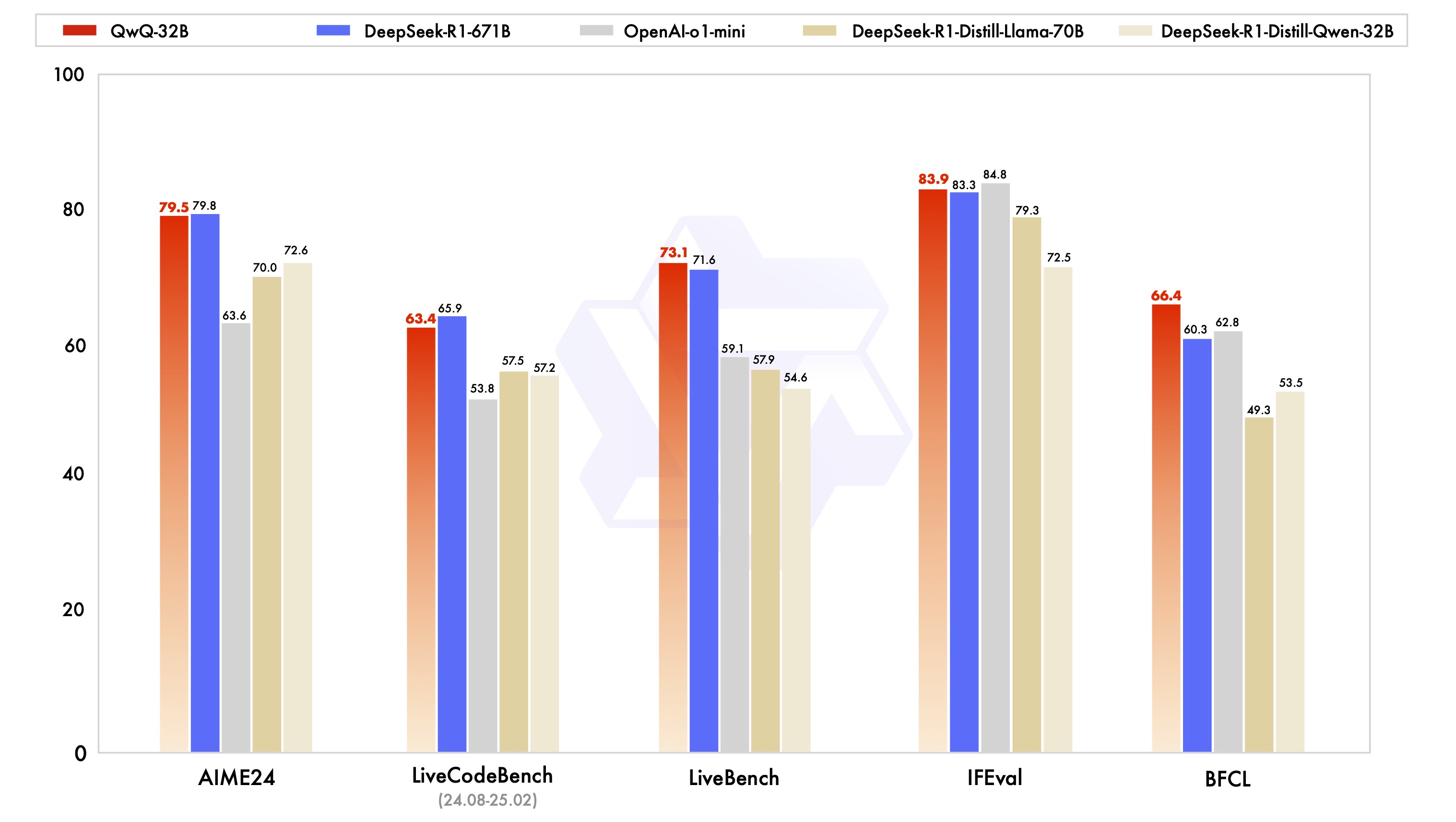

Le modèle QwQ-32B a été évalué dans le cadre d'une série de tests de référence conçus pour fournir un aperçu complet de ses capacités en matière de raisonnement mathématique, d'écriture de code et de résolution de problèmes génériques. Le tableau ci-dessous illustre les performances de QwQ-32B par rapport à d'autres modèles de premier plan, notamment DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini et le DeepSeek-R1 original.

D'après les résultats, QwQ-32B affiche des performances similaires, voire supérieures, à celles des modèles les plus performants dans plusieurs points de référence clés. Il est particulièrement intéressant de noter que QwQ-32B reste compétitif par rapport à DeepSeek-R1, qui a un nombre de paramètres beaucoup plus élevé que QwQ-32B, ce qui prouve une fois de plus le grand potentiel de l'apprentissage par renforcement dans l'amélioration de la performance des modèles.

Apprentissage par renforcement

Les performances exceptionnelles du QwQ-32B sont dues en grande partie à la technologie d'apprentissage par renforcement (RL) qui le sous-tend. En termes simples, l'apprentissage par renforcement est une méthode qui guide un modèle pour qu'il apprenne à prendre des décisions optimales dans un environnement donné grâce à des mécanismes de récompense ou de punition. Contrairement à l'apprentissage supervisé traditionnel, l'apprentissage par renforcement ne s'appuie pas sur de grandes quantités de données étiquetées, mais interagit plutôt avec l'environnement et apprend par essais et erreurs, pour finalement maîtriser les stratégies nécessaires à l'accomplissement de la tâche.

Pendant la formation de QwQ-32B, l'équipe de recherche d'Aliyun a mis en œuvre une méthode d'extension de l'apprentissage par renforcement basée sur la récompense des résultats, en partant d'un point de contrôle à froid. Dans la phase initiale, ils se sont concentrés sur l'extension de l'apprentissage par renforcement pour les mathématiques et les tâches de codage. Au lieu de s'appuyer sur des modèles de récompense traditionnels, l'équipe a utilisé un vérificateur de précision pour les questions de mathématiques afin de s'assurer de l'exactitude des réponses finales, et un serveur d'exécution de code pour évaluer si le code généré a passé avec succès les cas de test prédéfinis.

Au fur et à mesure de la formation, les performances du modèle dans les domaines des mathématiques et du code se sont améliorées de manière constante. Après la première phase, l'équipe de recherche a ajouté une phase de formation RL pour les capacités génériques. Cette phase de formation a utilisé les signaux de récompense du modèle de récompense générique et un certain nombre de validateurs basés sur des règles. Les résultats expérimentaux montrent qu'un petit nombre d'étapes de formation RL peut améliorer efficacement les capacités générales du modèle en termes de respect des instructions, d'alignement des préférences humaines et de performance de l'agent sans entraîner de dégradation significative des performances dans les domaines des mathématiques et du codage.

Voici un article qui explique pourquoi Qwen-2.5-3B a d'excellentes capacités de raisonnement :Comment les grands modèles deviennent-ils plus "intelligents" ? L'université de Stanford révèle la clé de l'amélioration de soi : quatre comportements cognitifs

Guide d'utilisation

Les paramètres suivants sont recommandés pour une performance optimale :

- Forcer les modèles à penser à la production: : Veiller à ce que les modèles soient modélisés à l'aide de

<think>\nafin d'éviter de générer un contenu de réflexion vide, ce qui pourrait réduire la qualité de la sortie. Si vous utilisez la fonctionapply_chat_templateet mettre en placeadd_generation_prompt=TrueCeci est automatiquement mis en œuvre. Notez toutefois que cela peut entraîner l'absence de réponse au début de la chaîne de caractères.<think>L'étiquetage, ce qui est normal. - Paramètres d'échantillonnage:

- utiliser

Temperature=0.6répondre en chantantTopP=0.95Au lieu du décodage gourmand pour éviter les répétitions interminables. - utiliser

TopKEntre 20 et 40 pour filtrer les cas rares Jeton apparaissent, tout en maintenant la diversité de la production générée.

- utiliser

- Formats de sortie standardisésPour les analyses comparatives, il est recommandé d'utiliser l'invite Prompt afin de standardiser les résultats du modèle.

- problème de mathématiques: Dans l'invite, ajoutez "Veuillez raisonner étape par étape et mettre votre réponse finale dans \boxed{}. "(Veuillez raisonner étape par étape et inscrire votre réponse finale dans \boxed{}.

- question à choix multiples: Ajouter la structure JSON suivante à l'invite pour standardiser la réponse : "Veuillez indiquer votre choix dans le champ

answeravec seulement la lettre choisie, par exemple.\"answer\": \"C\". "(Veuillez ajouter ce qui suit auanswerLe champ affiche votre sélection et ne contient que la lettre de la sélection, par exemple, la lettre\"answer\": \"C\").

- Traitement des entrées longuesPour les entrées supérieures à 32 768 tokens, activer YaRN afin d'améliorer la capacité du modèle à capturer efficacement les informations sur les longues séquences.

Pour les cadres pris en charge, les éléments suivants peuvent être ajoutés à l'élément config.json pour activer YaRN :

{

...,

"rope_scaling": {

"factor": 4.0,

"original_max_position_embeddings": 32768,

"type": "yarn"

}

}

Pour le déploiement, il est recommandé d'utiliser vLLM. Si vous n'êtes pas familiarisé avec vLLM, veuillez vous référer à la page d'accueil de vLLM. document officiel pour obtenir l'utilisation. Actuellement, vLLM ne prend en charge que les YARN statiques, ce qui signifie que le facteur d'échelle reste constant lorsque la longueur de l'entrée change.Cela peut affecter les performances du modèle lorsqu'il s'agit de textes plus courts. Il est donc recommandé de n'ajouter des contextes longs que lorsqu'ils doivent être traités rope_scaling Configuration.

Comment utiliser QwQ-32B (Utiliser QwQ-32B)

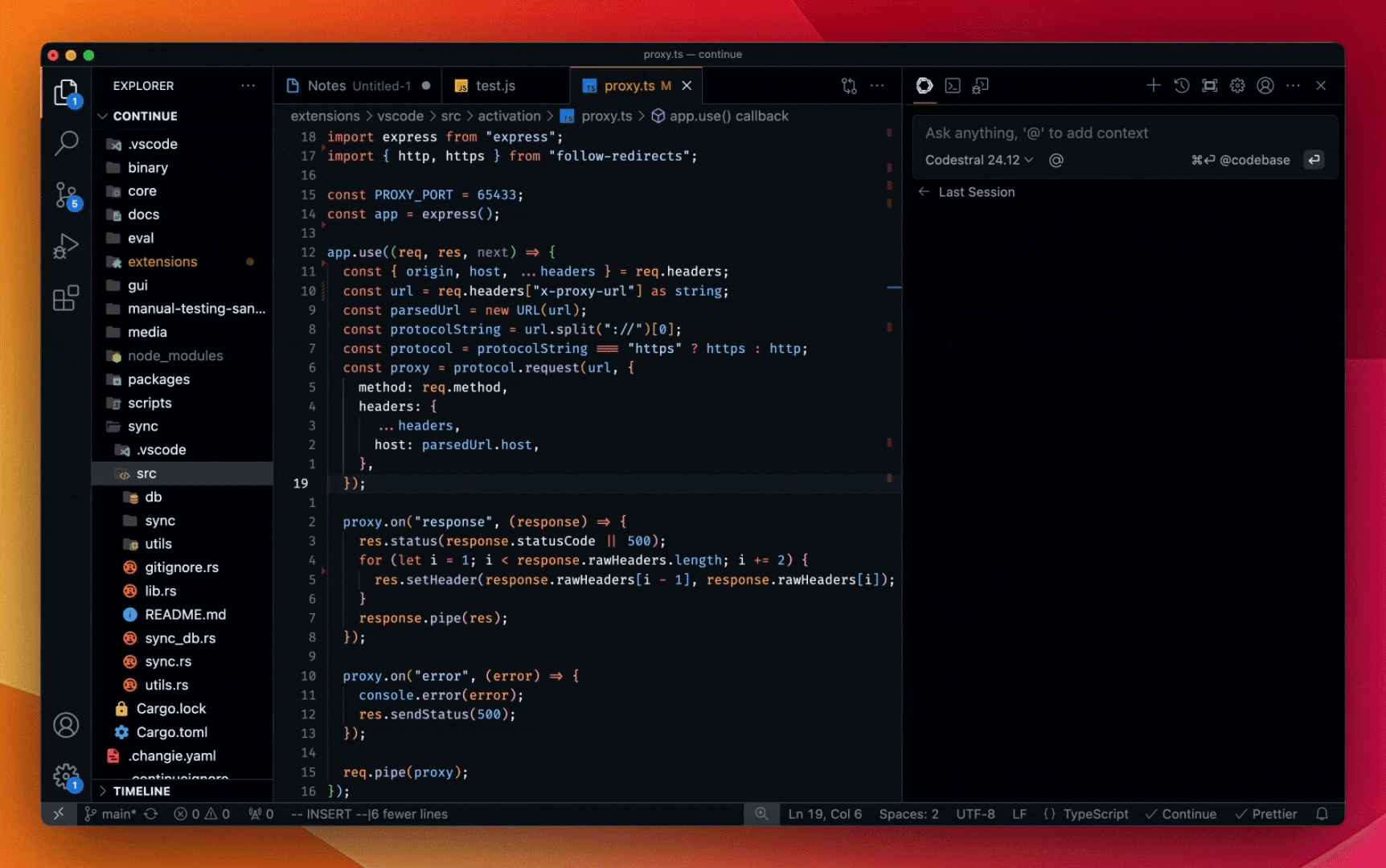

Le bref exemple suivant montre comment utiliser le modèle QwQ-32B via Hugging Face Transformers et AliCloud DashScope API.

via Hugging Face Transformers.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

Via l'API AliCloud DashScope.

from openai import OpenAI

import os

# Initialize OpenAI client

client = OpenAI(

# If the environment variable is not configured, replace with your API Key: api_key="sk-xxx"

# How to get an API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

reasoning_content = ""

content = ""

is_answering = False

completion = client.chat.completions.create(

model="qwq-32b",

messages=[

{"role": "user", "content": "Which is larger, 9.9 or 9.11?"}

],

stream=True,

# Uncomment the following line to return token usage in the last chunk

# stream_options={

# "include_usage": True

# }

)

print("\n" + "=" * 20 + "reasoning content" + "=" * 20 + "\n")

for chunk in completion:

# If chunk.choices is empty, print usage

if not chunk.choices:

print("\nUsage:")

print(chunk.usage)

else:

delta = chunk.choices[0].delta

# Print reasoning content

if hasattr(delta, 'reasoning_content') and delta.reasoning_content is not None:

print(delta.reasoning_content, end='', flush=True)

reasoning_content += delta.reasoning_content

else:

if delta.content != "" and is_answering is False:

print("\n" + "=" * 20 + "content" + "=" * 20 + "\n")

is_answering = True

# Print content

print(delta.content, end='', flush=True)

content += delta.content

Travaux futurs

La sortie de QwQ-32B marque une étape initiale mais critique dans l'extension de l'apprentissage par renforcement (RL) pour améliorer le raisonnement avec la famille de modèles Qwen. Grâce à cette exploration, Aliyun a non seulement constaté l'énorme potentiel des applications étendues de l'apprentissage par renforcement, mais a également reconnu le potentiel inexploité des modèles linguistiques pré-entraînés.

Aliyun est confiant dans le développement de la prochaine génération de modèles "Mille questions". Elle pense qu'en combinant un modèle de base plus robuste avec des techniques d'apprentissage par renforcement alimentées par des ressources de calcul à grande échelle, elle devrait accélérer l'objectif ultime de l'intelligence artificielle générale (AGI). En outre, AliCloud explore activement une fusion plus poussée des agents avec l'apprentissage par renforcement pour permettre des capacités de raisonnement à plus long terme, et s'engage à débloquer une plus grande intelligence grâce à la mise à l'échelle au point d'inférence.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...