Thin-Plate-Spline-Motion-Model : Vidéo de référence de la carte de portrait statique Vidéo de génération de mouvement de portrait

Introduction générale

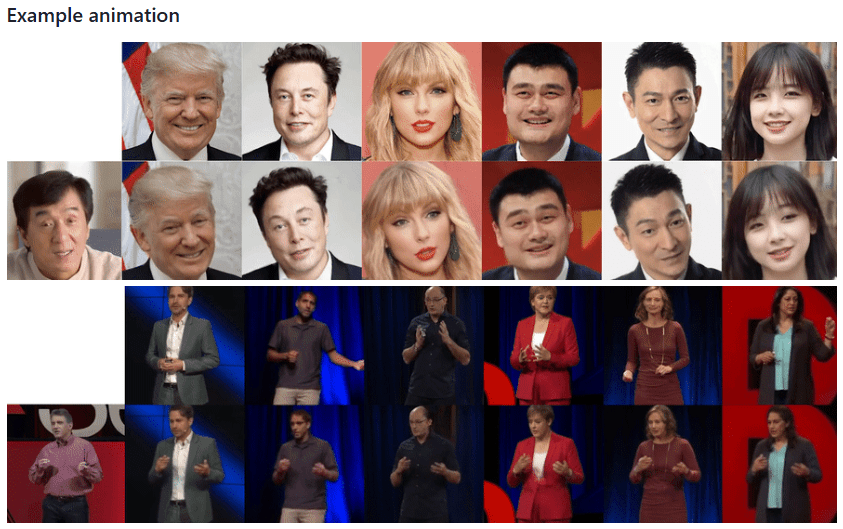

Thin-Plate-Spline-Motion-Model est un projet révolutionnaire de génération d'animations d'images présenté à la CVPR 2022. Le projet est basé sur la théorie de la transformation Spline à plaque mince, qui permet une animation de haute qualité d'images statiques basées sur la vidéo de conduite. Le projet adopte un cadre d'apprentissage non supervisé de bout en bout, qui est particulièrement efficace dans les situations où il existe de grandes différences de pose entre l'image source et la vidéo de conduite. Grâce à l'introduction innovante de l'estimation de mouvement par spline fine et du masquage multirésolution, le modèle est capable de générer des effets d'animation plus naturels et plus fluides. Le projet ne se contente pas d'ouvrir le code d'implémentation complet, mais fournit également un modèle pré-entraîné et une démo en ligne, permettant aux chercheurs et aux développeurs de reproduire et d'appliquer facilement la technique.

Que se passe-t-il si le porte-parole de l'image publique s'en va ? Vous pouvez conserver l'image du porte-parole et demander à quelqu'un d'autre d'enregistrer une vidéo de sorte que l'image du porte-parole imite les actions de la vidéo enregistrée pour générer la vidéo, à l'instar de la technologie d'échange de visages.

Liste des fonctions

- Génération d'animations d'images statiques

- Prise en charge de l'entraînement sur des ensembles de données multiples (VoxCeleb, TaiChi-HD, TED-talks, etc.)

- Modèles pré-entraînés disponibles au téléchargement

- Prise en charge des présentations en ligne basées sur le web (intégration de Hugging Face Spaces)

- Prise en charge de Google Colab en ligne

- Prise en charge de l'entraînement multi-GPU

- Fournir une fonction de formation au réseau AVD (Advanced Video Decoder)

- Fonction d'évaluation de la reconstruction vidéo

- Prise en charge des appels à l'API Python

- Prise en charge de l'environnement Docker

Utiliser l'aide

1. configuration de l'environnement

Le projet nécessite un environnement Python 3.x (Python 3.9 est recommandé), et les étapes d'installation sont les suivantes :

- Clonage de l'entrepôt de projets :

git clone https://github.com/yoyo-nb/Thin-Plate-Spline-Motion-Model.git

cd Thin-Plate-Spline-Motion-Model

- Installer la dépendance :

pip install -r requirements.txt

2. la préparation des données

Le projet prend en charge plusieurs ensembles de données :

- Jeu de données MGif : se référer au projet Monkey-Net pour l'obtenir

- Ensembles de données TaiChiHD et VoxCeleb : traitement selon les directives de prétraitement vidéo

- Jeu de données TED-talks : suivre les lignes directrices du projet MRAA

Téléchargement d'un ensemble de données de prétraitement (VoxCeleb à titre d'exemple) :

# 下载后合并解压

cat vox.tar.* > vox.tar

tar xvf vox.tar

3. formation au modèle

Ordres de formation de base :

CUDA_VISIBLE_DEVICES=0,1 python run.py --config config/dataset_name.yaml --device_ids 0,1

Formation au réseau AVD :

CUDA_VISIBLE_DEVICES=0 python run.py --mode train_avd --checkpoint '{checkpoint_folder}/checkpoint.pth.tar' --config config/dataset_name.yaml

4. évaluation de la reconstruction vidéo

CUDA_VISIBLE_DEVICES=0 python run.py --mode reconstruction --config config/dataset_name.yaml --checkpoint '{checkpoint_folder}/checkpoint.pth.tar'

5. les présentations d'animation graphique

Offre de nombreuses possibilités d'utilisation :

- Jupyter Notebook : Utilisation de demo.ipynb

- Ligne de commande Python :

CUDA_VISIBLE_DEVICES=0 python demo.py --config config/vox-256.yaml --checkpoint checkpoints/vox.pth.tar --source_image ./source.jpg --driving_video ./driving.mp4

- Démonstration en ligne :

- entretiensEspaces de câlinsDémonstration en ligne

- utiliserRépliquerDémonstration web de la plateforme

- faire passer (un projet de loi, une inspection, etc.)Google Colabêtre en mouvement

6. acquisition d'un modèle de pré-entraînement

Plusieurs sources de téléchargement sont fournies :

- Google Drive

- Disque Yandex

- Baidu.com (Code d'extrait : 1234)

7. mises en garde

- Il est recommandé de s'entraîner avec plus de données et des cycles d'entraînement plus longs pour obtenir de meilleurs résultats.

- Veiller à ce que la mémoire du GPU soit suffisante

- Il est recommandé d'utiliser l'ensemble de données prétraitées pour la formation.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...