TangoFlux : Outil de conversion rapide de texte en doublage qui génère 30 secondes d'audio long en 3 secondes !

Introduction générale

TangoFlux est un modèle efficace de génération de texte audio (TTA) développé par DeCLaRe Lab. Le modèle est capable de générer jusqu'à 30 secondes d'audio stéréo à 44,1 kHz en seulement 3,7 secondes. TangoFlux utilise des techniques de correspondance de flux et d'optimisation des préférences classées (CRPO) pour améliorer l'alignement TTA en générant et en optimisant les données de préférence. Le modèle donne de bons résultats dans les tests objectifs et subjectifs, et l'ensemble du code et des modèles est ouvert à la source afin de soutenir d'autres recherches sur la génération de TTA.

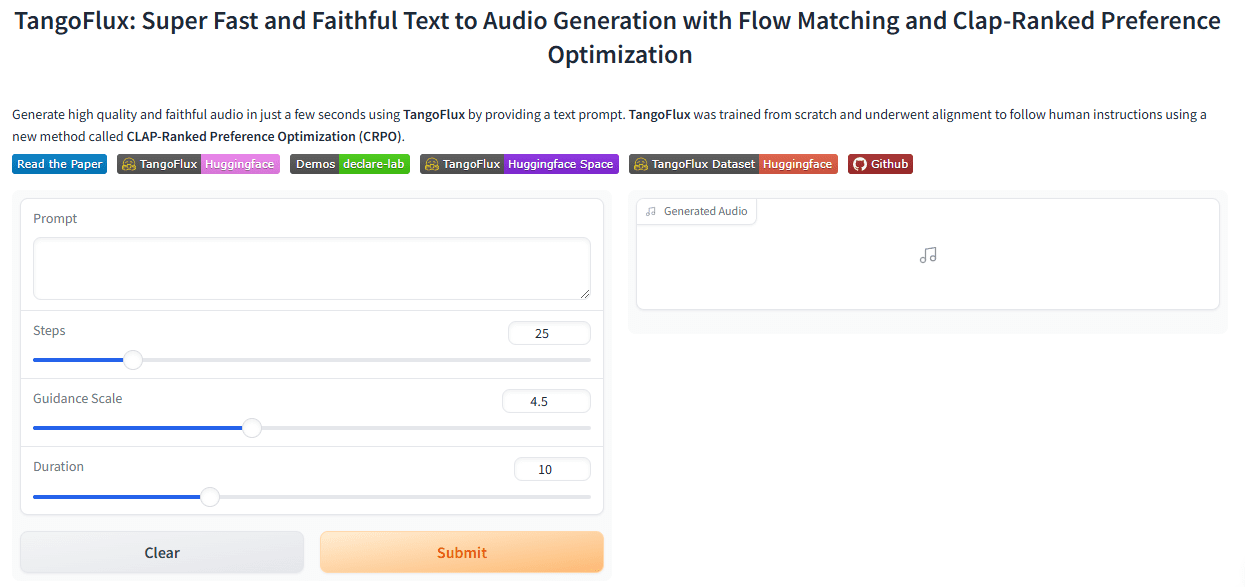

Expérience : https://huggingface.co/spaces/declare-lab/TangoFlux

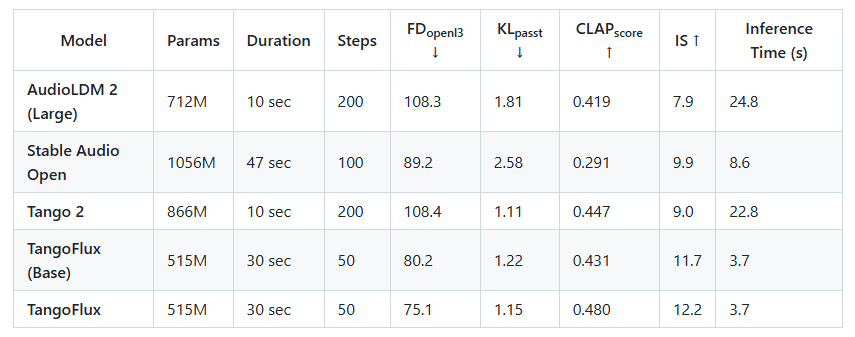

La Singapore University of Technology and Design (SUTD) et NVIDIA ont présenté conjointement TangoFlux, un modèle de génération de texte audio (TTA) très efficace avec environ 115 millions de paramètres qui peut générer de l'audio à 44,1 kHz en seulement 3,7 secondes sur un seul GPU A40. Avec environ 515 millions de paramètres, le modèle est capable de générer jusqu'à 30 secondes d'audio 44,1 kHz en seulement 3,7 secondes sur un seul GPU A40. TangoFlux a non seulement une vitesse de génération ultra-rapide, mais aussi une meilleure qualité audio que les modèles audio open-source tels que Stable Audio.

Comparez TANGoFLux avec d'autres modèles open-source de génération de texte vers audio : non seulement TANGoFLux génère environ deux fois plus vite que les modèles les plus rapides, mais il atteint également une meilleure qualité audio (mesurée par les scores CLAP et FD), le tout avec moins de paramètres entraînables.

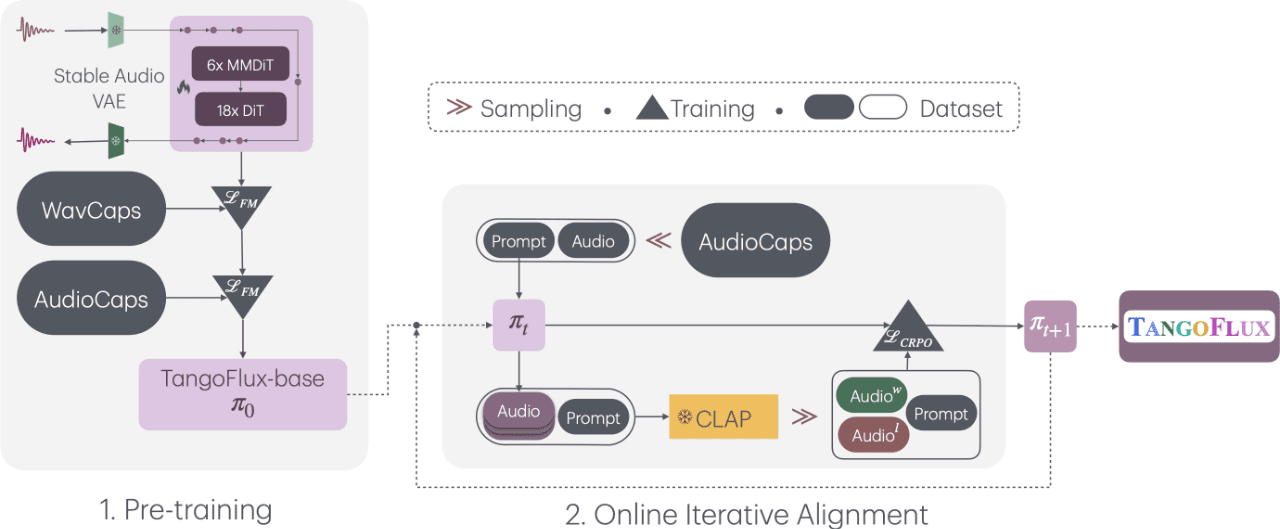

TangoFlux, intitulé "Ultra-Fast and Faithful Text-to-Audio Generation via Stream Matching and Clap-Ranked Preference Optimisation", se compose de blocs FluxTransformer, qui sont des transformateurs de diffusion (DiT) et des transformateurs de diffusion multimodaux (MMDiT) conditionnés par des indices textuels et des enregistrements de durée afin de générer jusqu'à 30 secondes d'audio à 44,1 kHz. Il s'agit du transformateur de diffusion (DiT) et du transformateur de diffusion multimodal (MMDiT), qui sont conditionnés par des indices textuels et des enregistrements de durée afin de générer un son de 44,1 kHz d'une durée maximale de 30 secondes.TangoFlux apprend des trajectoires de flux rectifiées des représentations latentes de l'audio encodé par l'autoencodeur variable (VAE).Le pipeline d'apprentissage de TangoFlux se compose de trois phases : le pré-entraînement, le réglage fin et l'optimisation des préférences à l'aide du CRPO. Plus précisément, le CRPO génère itérativement de nouvelles données synthétiques et construit des paires de préférences en utilisant les pertes DPO pour l'optimisation des préférences en vue de l'appariement des flux.

Liste des fonctions

- Génération rapide d'audioLa technologie de l'enregistrement de la voix : génère jusqu'à 30 secondes de son de haute qualité en 3,7 secondes.

- Technologie de mise en correspondance des fluxGénération audio à l'aide de FluxTransformer et Multimodal Diffusion Transformers.

- Optimisation du CRPOAméliorer la qualité de la génération audio en générant et en optimisant les données de préférence.

- Formation en plusieurs étapesIl se compose de trois phases : le pré-entraînement, le réglage fin et l'optimisation des préférences.

- source ouverteLes modèles et le code sont en libre accès afin de faciliter les recherches ultérieures.

Utiliser l'aide

Processus d'installation

- Configuration de l'environnementPython : Assurez-vous que Python 3.7 et plus est installé, et que les bibliothèques de dépendance nécessaires sont installées.

- entrepôt de clonesExécution dans un terminal

git clone https://github.com/declare-lab/TangoFlux.gitEntrepôt de clonage. - Installation des dépendances: Allez dans le répertoire du projet et exécutez

pip install -r requirements.txtInstaller toutes les dépendances.

Processus d'utilisation

- formation au modèle: :

- Accélérateur de configuration : Exécuter

accelerate configet suivez les instructions pour configurer l'environnement d'exécution. - Configurez le chemin d'accès au fichier d'apprentissage : dans le champ

configs/tangoflux_config.yamlSpécifiez le chemin du fichier d'apprentissage et les hyperparamètres du modèle dans le champ - Exécuter le script de formation : Utilisez la commande suivante pour démarrer la formation :

CUDA_VISIBLE_DEVICES=0,1 accelerate launch --config_file='configs/accelerator_config.yaml' src/train.py --checkpointing_steps="best" --save_every=5 --config='configs/tangoflux_config.yaml'- Formation des DPD : modifiez le fichier de formation pour y inclure les champs "chosen", "reject", "caption" et "duration" et exécutez la commande suivante :

CUDA_VISIBLE_DEVICES=0,1 accelerate launch --config_file='configs/accelerator_config.yaml' src/train_dpo.py --checkpointing_steps="best" --save_every=5 --config='configs/tangoflux_config.yaml' - Accélérateur de configuration : Exécuter

- raisonnement modélisé: :

- Télécharger le modèle : Assurez-vous que vous avez téléchargé le modèle TangoFlux.

- Générer de l'audio : utilisez le code suivant pour générer de l'audio à partir d'une invite textuelle :

import torchaudio from tangoflux import TangoFluxInference from IPython.display import Audio model = TangoFluxInference(name='declare-lab/TangoFlux') audio = model.generate("生成音频的文本提示", duration=10) Audio(audio, rate=44100)

Fonctionnement détaillé

- Génération de texte audioLe modèle génère le son de haute qualité correspondant à l'invite textuelle, à la durée du son généré (de 1 à 30 secondes).

- parti pris pour l'optimisationLa technologie CRPO permet au modèle de générer un son plus conforme aux préférences de l'utilisateur.

- Formation en plusieurs étapesIl se compose de trois phases : le pré-entraînement, le réglage fin et l'optimisation des préférences pour garantir la qualité et la cohérence de l'audio généré par le modèle.

mise en garde

- exigences en matière de matérielIl est recommandé d'utiliser un GPU avec une puissance de calcul plus élevée (par exemple A40) pour des performances optimales.

- Préparation des donnéesLes données de formation doivent être diversifiées et de bonne qualité afin d'améliorer la génération de modèles.

Grâce à ces étapes, les utilisateurs peuvent rapidement commencer à utiliser TangoFlux pour une conversion texte-audio de haute qualité. Des instructions d'installation et d'utilisation détaillées permettent aux utilisateurs de mener à bien le processus d'apprentissage et d'inférence du modèle.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...