Step1X-Edit : un outil open source pour l'édition d'images avec des instructions en langage naturel

Introduction générale

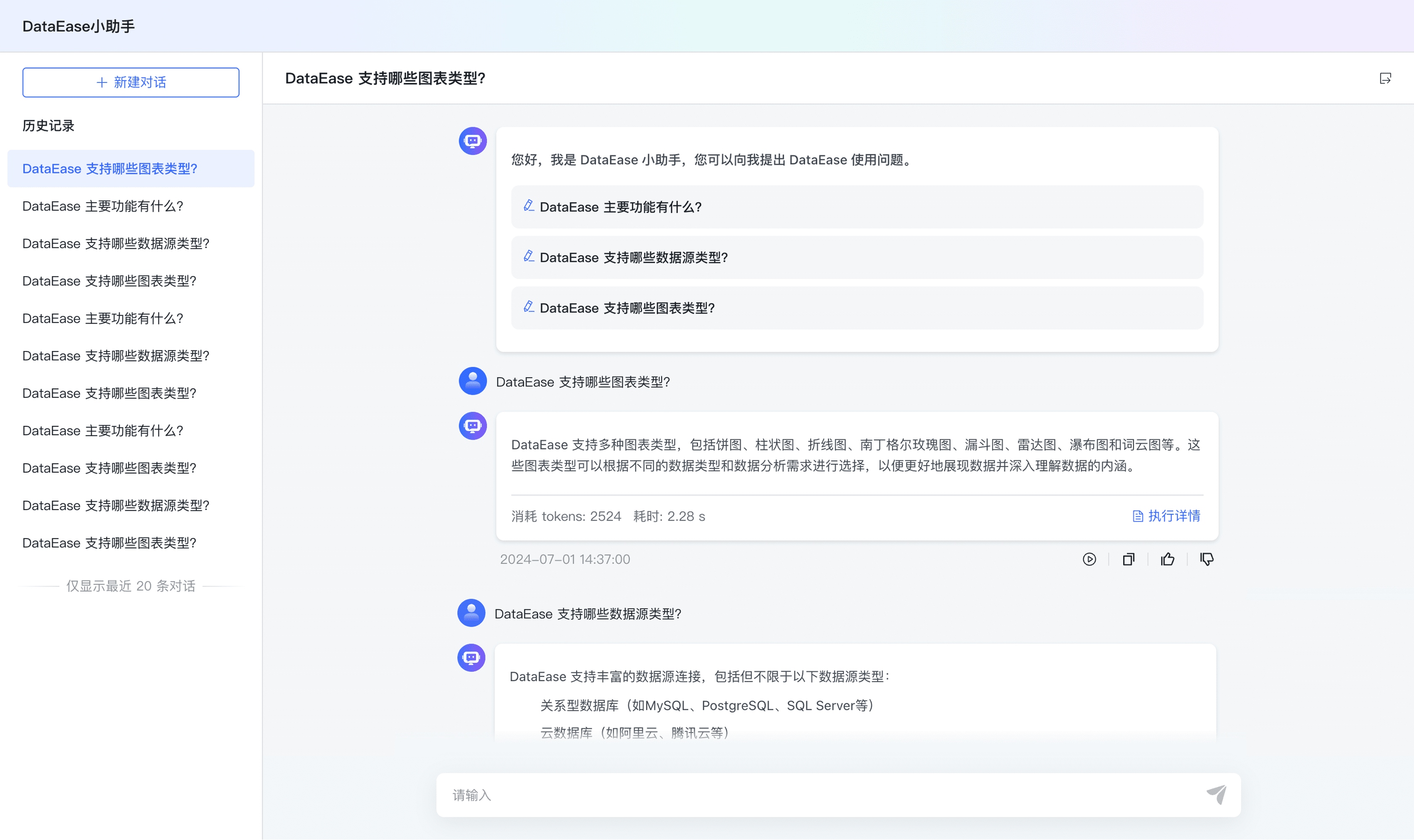

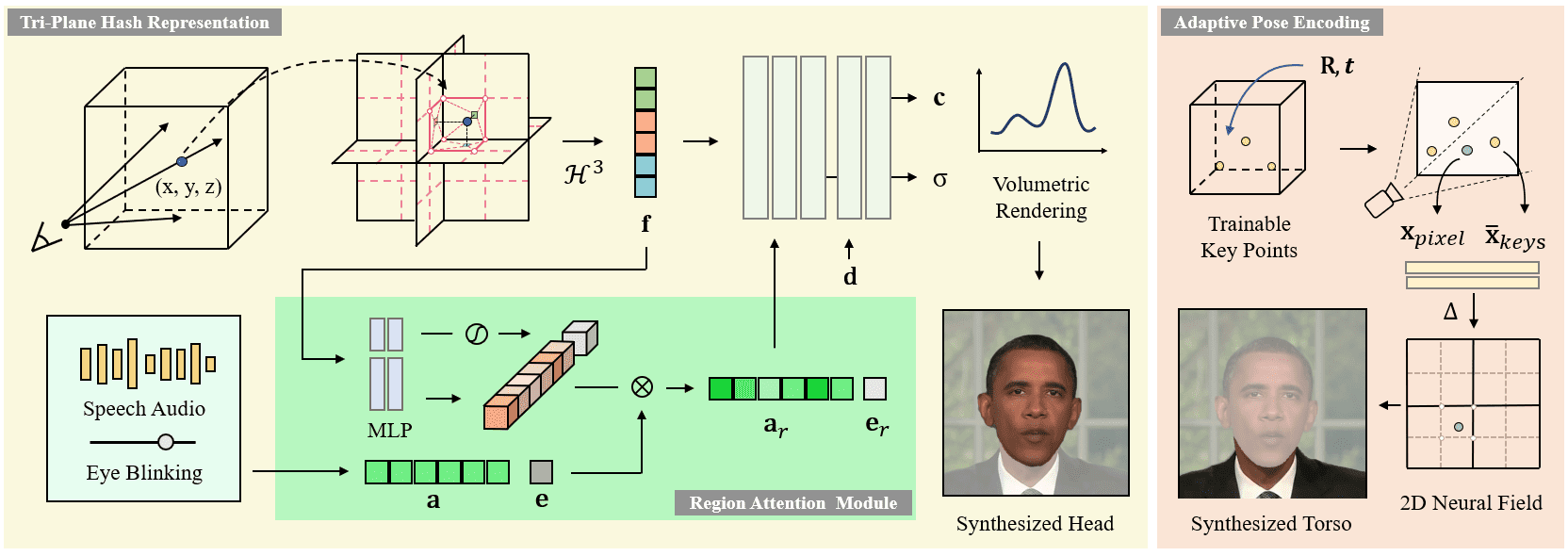

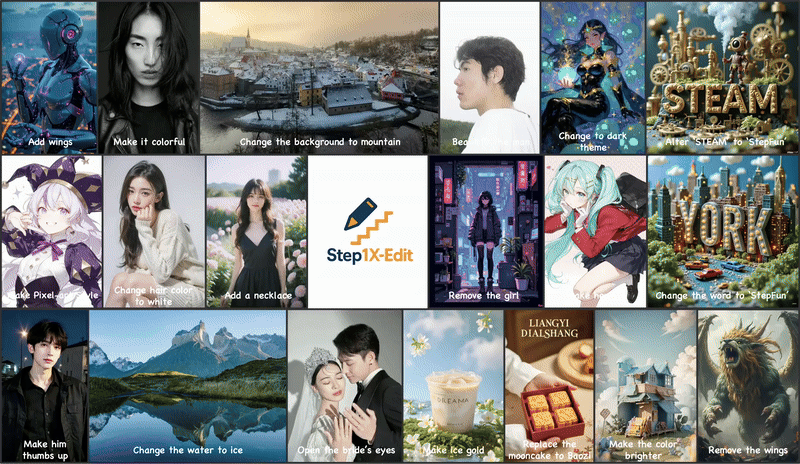

Step1X-Edit est un cadre d'édition d'images open source, développé par l'équipe Stepfun AI et hébergé sur GitHub, qui combine un modèle multimodal à grand langage (Qwen-VL) et un transformateur de diffusion (DiT) pour permettre aux utilisateurs d'éditer une image avec des commandes simples en langage naturel, telles que changer l'arrière-plan, supprimer un objet ou changer de style. Le projet a été publié le 25 avril 2025 et ses performances sont proches de celles de modèles à source fermée tels que GPT-4o et Gémeaux 2 Flash. step1X-Edit fournit les poids des modèles, le code d'inférence et l'analyse comparative GEdit-Bench pour prendre en charge un large éventail de scénarios d'édition. La licence Apache 2.0 permet une utilisation gratuite et un développement commercial, ce qui attire les développeurs, les concepteurs et les chercheurs. Le soutien de la communauté est actif et a permis de lancer ComfyUI Plug-ins et versions quantifiées du FP8 pour optimiser les exigences matérielles.

Actuellement disponible en Étape AI Expérience gratuite. Cependant, les résultats de l'édition d'images sont légèrement différents de ceux obtenus avec GPT-4o et Gemini 2 Flash.

Liste des fonctions

- Prise en charge des commandes en langage naturel pour l'édition d'images, telles que "Changer l'arrière-plan pour une plage" ou "Supprimer les personnes de la photo".

- Analyse des commandes d'images et de textes à l'aide d'un modèle de langage multimodal (Qwen-VL) pour générer des modifications précises.

- Génère des images de haute qualité basées sur le transformateur de diffusion (DiT) qui conserve les détails de l'image originale.

- Fournit un banc d'essai GEdit-Bench pour évaluer les performances d'édition sous les commandes réelles de l'utilisateur.

- Prend en charge les modèles quantitatifs FP8, réduit les exigences matérielles et s'adapte aux GPU à faible mémoire.

- L'intégration avec le plug-in ComfyUI simplifie le flux de travail et améliore l'expérience de l'utilisateur.

- Une démonstration en ligne est disponible, permettant aux utilisateurs d'expérimenter les fonctions d'édition sans installation.

- Poids des modèles et code d'inférence en libre accès pour soutenir le développement secondaire et la recherche.

Utiliser l'aide

Processus d'installation

Pour utiliser Step1X-Edit, vous devez installer l'environnement et télécharger les poids du modèle. Vous trouverez ci-dessous les étapes détaillées, adaptées aux systèmes Linux (Ubuntu 20.04 ou supérieur recommandé) :

- Préparation de l'environnement

Assurez-vous que Python 3.10 ou plus est installé sur votre système, ainsi que la boîte à outils CUDA (12.1 recommandée). Un GPU est recommandé (80 Go de RAM sont préférables, comme le NVIDIA H800), mais les versions quantifiées du FP8 prennent en charge une RAM plus faible (16 Go ou 24 Go).conda create -n step1x python=3.10 conda activate step1x

- entrepôt de clones

Téléchargez le code du projet Step1X-Edit sur GitHub :git clone https://github.com/stepfun-ai/Step1X-Edit.git cd Step1X-Edit - Installation des dépendances

Installez PyTorch (2.3.1 ou 2.5.1 recommandé) et les bibliothèques associées :pip install torch==2.3.1 torchvision --index-url https://download.pytorch.org/whl/cu121 pip install -r requirements.txtInstaller Flash Attention (facultatif, pour un raisonnement accéléré) :

pip install flash-attn --no-build-isolationSi vous rencontrez des problèmes lors de l'installation de Flash Attention, vous pouvez vous référer au script officiel pour générer un fichier wheel pré-compilé adapté à votre système :

python scripts/find_flash_attn_wheel.py - Télécharger le modèle de poids

Téléchargez les poids du modèle et l'autocodeur variable (VAE) à partir de Hugging Face ou de ModelScope :- Étape 1X-Editer le modèle :

step1x-edit-i1258.safetensors(environ 24,9 Go) - VAE :

vae.safetensors(environ 335MB) - Modèle Qwen-VL :

Qwen/Qwen2.5-VL-7B-Instruct

Téléchargements automatisés à l'aide de scripts Python :

from huggingface_hub import snapshot_download import os target_dir = "models/step1x" os.makedirs(target_dir, exist_ok=True) # 下载 Step1X-Edit 模型 snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["step1x-edit-i1258.safetensors"]) # 下载 VAE snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["vae.safetensors"]) # 下载 Qwen-VL qwen_dir = os.path.join(target_dir, "Qwen2.5-VL-7B-Instruct") snapshot_download(repo_id="Qwen/Qwen2.5-VL-7B-Instruct", local_dir=qwen_dir) - Étape 1X-Editer le modèle :

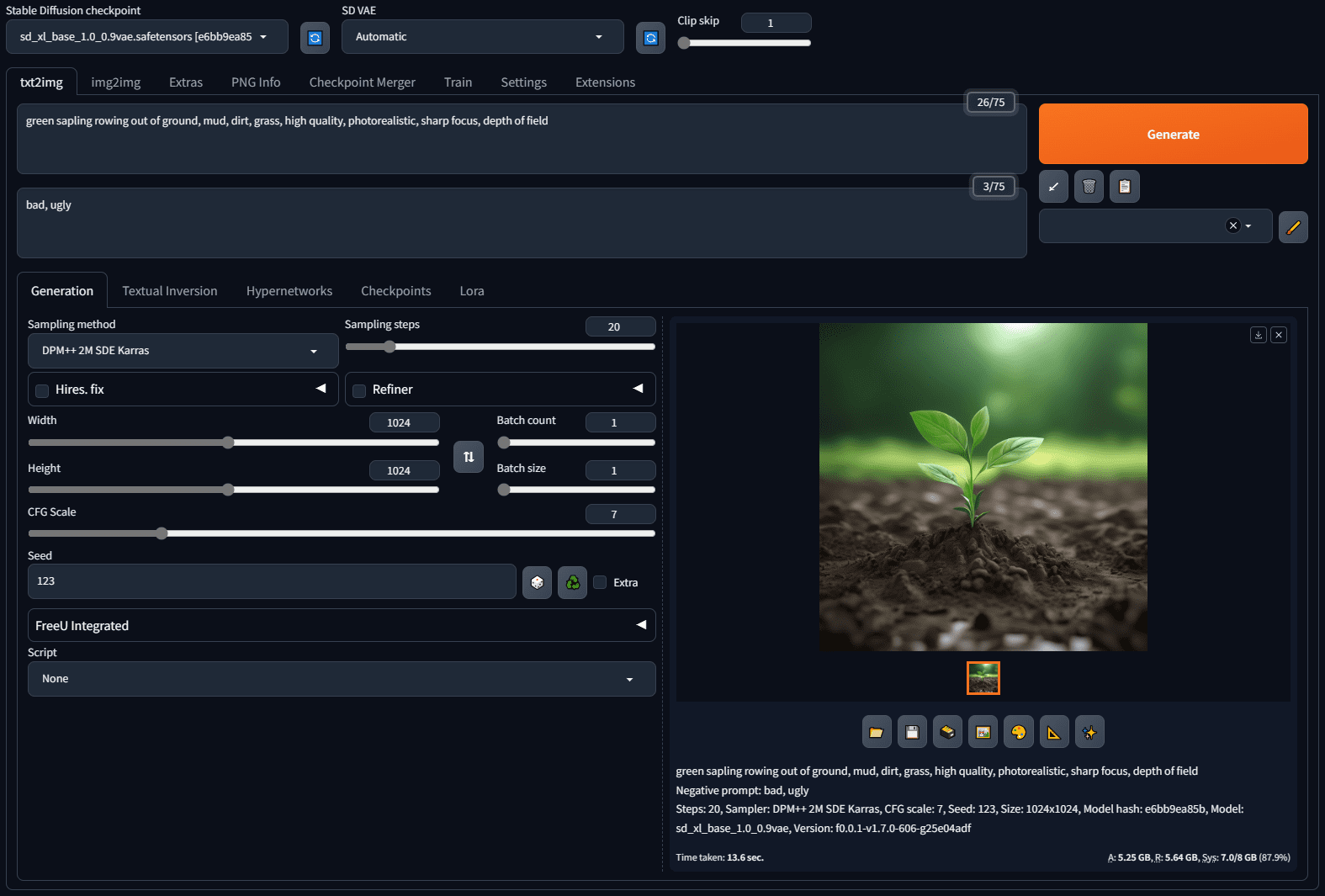

- raisonnement en cours d'exécution

Modifiez l'image à l'aide du script de raisonnement fourni. Par exemple, modifiez une image et changez l'arrière-plan :python scripts/run_inference.py --image_path assets/demo.png --prompt "将背景改为夜空" --output_path output.pngParamètre Description :

--image_path: Saisir le chemin d'accès à l'image.--promptLes commandes d'édition (par exemple, "changer le ciel en coucher de soleil").--output_path: Chemin d'accès à l'image de sortie.--size_levelRésolution (par défaut 512x512, 1024x1024 nécessite plus de mémoire).--seedLes graines aléatoires permettent de contrôler la cohérence de la génération.

Utiliser le plug-in ComfyUI

Step1X-Edit propose un plug-in ComfyUI pour les utilisateurs qui souhaitent s'intégrer dans les flux de travail.

- Clonez le dépôt de plugins ComfyUI :

cd path/to/ComfyUI/custom_nodes git clone https://github.com/quank123wip/ComfyUI-Step1X-Edit.git - Placer les poids du modèle sur le

ComfyUI/models/Step1x-EditCatalogue :step1x-edit-i1258.safetensorsvae.safetensors- Dossier du modèle Qwen-VL :

Qwen2.5-VL-7B-Instruct

- Démarrez ComfyUI et chargez le nœud Step1X-Edit.

- Dans l'interface ComfyUI, téléchargez une image, entrez une commande d'édition (par exemple "Ajouter des ailes") et exécutez le flux de travail pour générer le résultat.

Principales fonctions

- éditeur de langage naturel

L'utilisateur télécharge une image et saisit une commande de texte. Par exemple, pour changer l'arrière-plan d'une photo par une vue de montagne, il faut saisir "change background to mountain view". Le modèle analyse la commande à travers Qwen-VL, extrait la sémantique et génère une nouvelle image en conjonction avec DiT. Il est recommandé que les commandes soient claires et spécifiques, par exemple "Changer le ciel en ciel bleu étoilé" est plus efficace que "Embellir le ciel". - Retrait ou ajout d'objet

Des commandes telles que "Retirer une personne d'une photo" ou "Ajouter un arbre". Le modèle conserve le reste de l'image et modifie précisément la zone spécifiée. Dans les scènes complexes, plusieurs ajustements des commandes peuvent optimiser les résultats. - changement de style

L'édition stylisée est prise en charge, par exemple "convertir l'image en style pixel art" ou "changer en style Miyazaki". Le modèle est diffusé pour produire une image stylisée. - Démonstration en ligne

Visitez l'espace Hugging Face (https://huggingface.co/spaces/stepfun-ai/Step1X-Edit), téléchargez une image, entrez des instructions et faites-en l'expérience directement. Chaque génération est limitée par le temps de GPU et les utilisateurs gratuits ont droit à deux tentatives.

mise en garde

- exigences en matière de matérielLa version quantifiée FP8 peut être réduite à 16 Go de mémoire pour les GPU tels que le 3090 Ti.

- Optimisation des commandesUne édition complexe nécessite des instructions détaillées, telles que "changer l'arrière-plan en montagnes enneigées, garder les personnages de premier plan inchangés".

- Soutien communautaireLe dépôt GitHub a une communauté active, donc consultez les Questions ou les Discussions si vous rencontrez des problèmes.

scénario d'application

- création de contenu

Les concepteurs utilisent Step1X-Edit pour modifier rapidement les arrière-plans ou ajuster les styles des documents publicitaires. Par exemple, changer l'arrière-plan d'une photo de produit pour un thème de vacances afin d'améliorer l'attrait visuel. - Retouche photo personnelle

Les utilisateurs ordinaires peuvent embellir leurs photos, par exemple en supprimant l'arrière-plan ou en transformant une photo de jour en photo de nuit, grâce à des démonstrations en ligne faciles à utiliser et ne nécessitant pas de compétences professionnelles. - Optimisation des produits pour le commerce électronique

Les plateformes de commerce électronique utilisent Step1X-Edit pour générer des images de présentation de produits dans différents scénarios, par exemple en plaçant des vêtements sur un fond de plage ou de ville afin d'économiser sur les coûts de prise de vue. - recherche universitaire

Les chercheurs utilisent l'ensemble de données GEdit-Bench et les poids des modèles pour développer de nouveaux algorithmes d'édition d'images ou comparer les performances des modèles.

QA

- Quelles sont les résolutions prises en charge par Step1X-Edit ?

Prend en charge les résolutions 512x512 et 1024x1024. La résolution 512x512 est plus rapide et nécessite moins de mémoire ; la résolution 1024x1024 est plus détaillée et nécessite plus de mémoire. - Comment puis-je optimiser mes résultats d'édition ?

Utilisez des instructions spécifiques et évitez les descriptions vagues. Essayer plusieurs fois une formulation différente peut améliorer les résultats. Par exemple, "changer le ciel en un coucher de soleil rouge" est plus clair que "changer le ciel". - Prend-il en charge les commandes en chinois ?

Oui, le modèle prend en charge les commandes en chinois avec des résultats comparables à ceux de l'anglais. Il est recommandé de décrire les exigences dans un langage concis. - FP8 Quelle est la différence entre les versions quantifiées ?

La version FP8 nécessite moins de mémoire (16 Go pour fonctionner), mais peut sacrifier légèrement les détails. Elle est idéale pour les utilisateurs disposant de ressources matérielles limitées. - Doit-il être mis en réseau pour fonctionner ?

Aucune connexion internet n'est requise pour l'exécution locale. Les démonstrations en ligne nécessitent un accès à l'espace Hugging Face.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...