Sim Studio : générateur de flux de travail open source pour les agents d'intelligence artificielle

Introduction générale

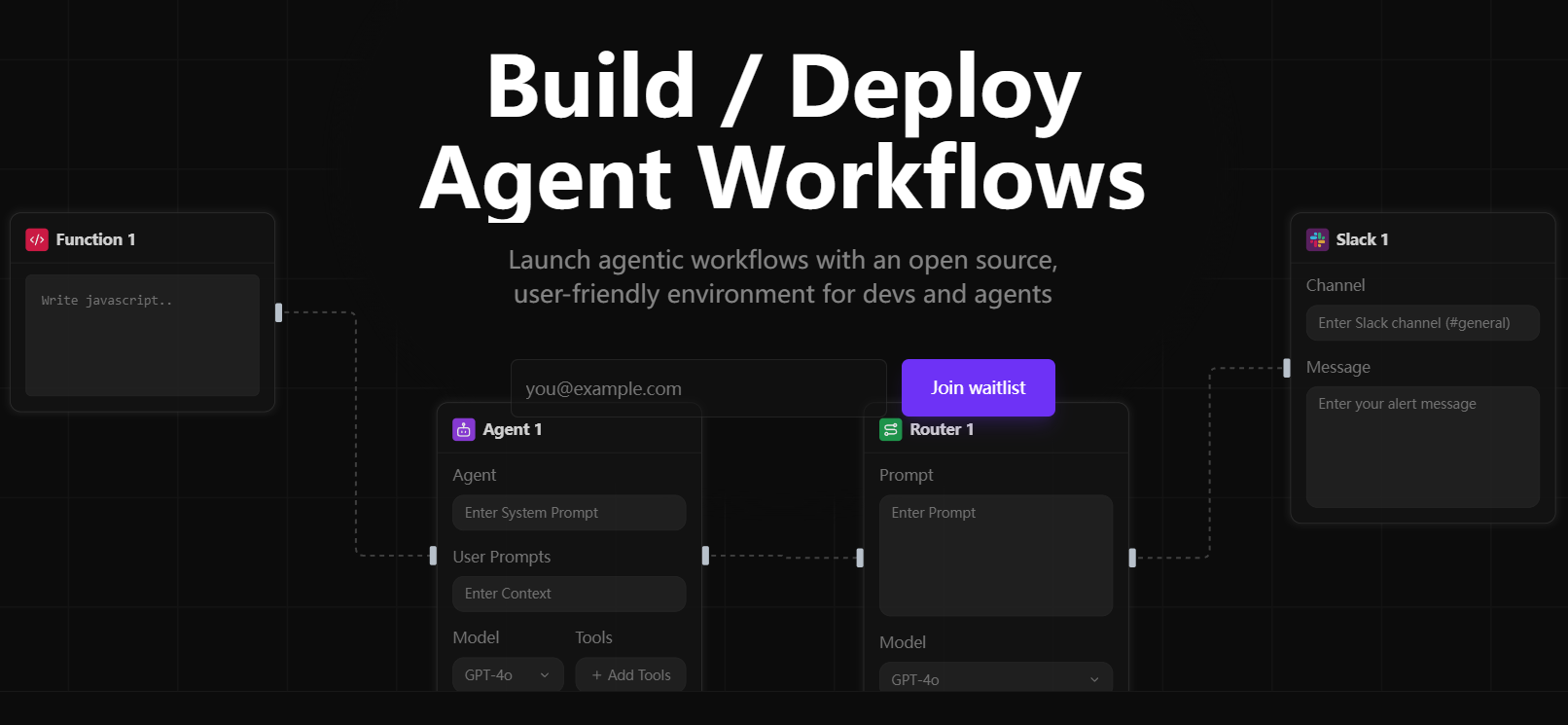

Sim Studio est une plateforme open source de construction de flux de travail d'agents d'intelligence artificielle qui aide les utilisateurs à concevoir, tester et déployer rapidement des flux de travail de modèles de langage à grande échelle (LLM) grâce à une interface visuelle légère et intuitive. Les utilisateurs peuvent créer des applications multi-agents complexes par glisser-déposer sans programmation approfondie. Il prend en charge les modèles locaux et en nuage, et est compatible avec un large éventail d'intégrations d'outils tels que Slack et les bases de données. Une version officielle hébergée dans le cloud (https://simstudio.ai) et des options auto-hébergées sont disponibles pour répondre à différents besoins.

Les frameworks d'agents d'IA fleurissent de nos jours, pourquoi est-ce que je recommande Sim Studio en particulier ? J'ai compilé une liste des caractéristiques de quelques-uns des principaux frameworks d'agents d'IA open source actuellement disponibles :

| Nom du cadre | paradigme de base | Principaux avantages | Scénarios applicables |

|---|---|---|---|

| LangGraph | Flux de travail basé sur des graphiques | Contrôle explicite du DAG, ramification et débogage | Tâches complexes en plusieurs étapes, traitement avancé des erreurs |

| SDK des agents OpenAI | Chaîne d'outils avancée OpenAI | Intégration d'outils tels que la recherche sur le web et la recherche de fichiers | Les équipes qui s'appuient sur l'écosystème OpenAI |

| Smolagents | Boucles d'agents minimales centrées sur le code | Configuration simple, exécution directe du code | Automatisation rapide des tâches sans chorégraphie complexe |

| CrewAI | Collaboration multi-agents (équipages) | Flux de travail parallèle basé sur le rôle avec mémoire partagée | Tâches complexes nécessitant la collaboration de plusieurs experts |

| AutoGen | chat asynchrone multi-agents | Dialogue en temps réel, axé sur les événements | Scénarios nécessitant une interaction "vocale" simultanée et multi-LLM en temps réel |

| Studio Sim | Constructeur visuel de flux de travail | Interface intuitive, déploiement rapide, flexibilité de l'open source | Prototypage rapide et déploiement d'un environnement de production |

Il existe aujourd'hui sur le marché un certain nombre de plates-formes de création d'agents d'intelligence artificielle à code réduit ou sans code, et j'ai dressé une liste de leurs performances par rapport à Sim Studio :

| bâtiment à toit plat | spécificités | Scénarios applicables | prix |

|---|---|---|---|

| Vertex AI Builder | Plateforme d'entreprise sans code avec des API complexes | Automatisation des flux de travail dans les grandes entreprises | couvrir les coûts |

| Faisceau AI | Plate-forme horizontale avec prise en charge de plusieurs agents sur site | Automatisation multidisciplinaire (conformité, service à la clientèle, etc.) | couvrir les coûts |

| Microsoft corporation Copilote Studio | Faible code, 1200+ connecteurs de données | Chatbot interne, Gestion des commandes | couvrir les coûts |

| Lyzr Agent Studio | Modulaire et adapté au prototypage | Finance, automatisation des ressources humaines | couvrir les coûts |

| Studio Sim | Open source, interface visuelle, déploiement flexible | L'ensemble du processus, du prototype à la production | libre et gratuit |

Comme vous pouvez le constater, en tant que projet open source, Sim Studio n'est pas en reste en termes de fonctionnalités et de flexibilité, et il n'y a pas de pression financière pour l'utiliser.

Liste des fonctions

- Éditeur visuel de flux de travail Conception de flux de travail d'agents d'intelligence artificielle avec une interface "glisser-déposer" qui prend en charge la logique conditionnelle et les tâches à plusieurs étapes.

- Prise en charge de plusieurs modèles Les systèmes de gestion du cycle de vie (LLM) : compatibles avec les LLM locaux et en nuage, par exemple par l'intermédiaire du système de gestion du cycle de vie (LLM). Ollama Exécution de modèles locaux.

- intégration des outils Les fonctionnalités de proxy étendues : prise en charge de la connexion à des outils externes tels que Slack, des bases de données et des fonctionnalités de proxy étendues.

- Déploiement de l'API Les API de flux de travail sont générées en un seul clic pour faciliter l'intégration dans d'autres systèmes.

- déploiement local Les services d'hébergement automatique sont pris en charge par Docker ou manuellement pour les scénarios sensibles en matière de confidentialité.

- Extensions modulaires Le système de gestion de l'information : Il améliore la flexibilité en permettant aux utilisateurs de personnaliser les blocs fonctionnels et les outils.

- Journalisation et débogage Les données sont enregistrées de manière détaillée afin d'optimiser le flux de travail et de résoudre les problèmes d'erreurs.

- Soutien aux conteneurs de développement Les conteneurs de développement VS Code simplifient la mise en place d'environnements de développement locaux.

Utiliser l'aide

Le cœur de Sim Studio réside dans ses capacités légères et intuitives de création de flux de travail. Les paragraphes suivants décrivent en détail le processus d'installation, le fonctionnement des principales fonctions et l'utilisation des caractéristiques spéciales afin de permettre aux utilisateurs de démarrer rapidement.

Processus d'installation

Sim Studio propose trois options d'auto-hébergement : Docker (recommandé), les conteneurs de développement et l'installation manuelle. Les options suivantes sont principalement Docker et l'installation manuelle, et le conteneur de développement convient aux développeurs qui sont familiers avec VS Code.

Méthode 1 : Installation de Docker (recommandée)

Docker fournit un environnement d'exécution cohérent qui convient à la plupart des utilisateurs. Docker et Docker Compose doivent être installés au préalable.

- Clonage de la base de code

S'exécute dans le terminal :git clone https://github.com/simstudioai/sim.git cd sim

- Configuration des variables d'environnement

Copiez et modifiez le fichier d'environnement :cp sim/.env.example sim/.env

configuré dans le fichier .env :

- BETTER_AUTH_SECRET : Génère une clé aléatoire pour l'authentification.

- RESEND_API_KEY : utilisé pour la vérification de la boîte aux lettres ; s'il n'est pas défini, le code de vérification sera affiché sur la console.

- Paramètres de la base de données : PostgreSQL est utilisé par défaut, vous devez vous assurer que le service de base de données fonctionne.

- OLLAMA_HOST : la valeur est fixée à http://host.docker.internal:11434 en cas d'utilisation d'un modèle local.

- Démarrage des services

Exécutez la commande suivante :docker compose up -d --build

ou utiliser un script :

./start_simstudio_docker.sh

Une fois le service démarré, visitez le site http://localhost:3000/w/ pour accéder à l'interface du flux de travail.

- Services de gestion

- Voir le journal :

docker compose logs -f simstudio

- Interruption des services :

docker compose down

- Redémarrer le service (après la mise à jour du code) :

docker compose up -d --build

- Voir le journal :

- Utilisation de modèles locaux

Si un LLM local est nécessaire (par exemple LLaMA), retirez le modèle :./sim/scripts/ollama_docker.sh pull <model_name>

Lancer des services qui soutiennent les modèles locaux :

./start_simstudio_docker.sh --local

Ou choisir en fonction du matériel :

# 有 NVIDIA GPU docker compose up --profile local-gpu -d --build # 无 GPU docker compose up --profile local-cpu -d --build

Si vous avez déjà une instance d'Ollama, modifiez docker-compose.yml pour l'ajouter :

extra_hosts: - "host.docker.internal:host-gateway" environment: - OLLAMA_HOST=http://host.docker.internal:11434

Mode 2 : Installation manuelle

Pour les développeurs qui ont besoin d'un environnement personnalisé avec Node.js, npm et PostgreSQL installés.

- Cloner et installer les dépendances

git clone https://github.com/simstudioai/sim.git cd sim/sim npm install

- Environnement de configuration

Copiez et modifiez le fichier d'environnement :cp .env.example .env

Configurer BETTER_AUTH_SECRET, les connexions à la base de données, etc.

- Initialisation de la base de données

Architecture de la base de données Push :npx drizzle-kit push

- Démarrer le serveur de développement

npm run dev

Visitez le site http://localhost:3000.

Approche 3 : Développement de conteneurs

- Installer l'extension Remote - Containers dans VS Code.

- Ouvrez le répertoire du projet et cliquez sur "Reopen in Container".

- Exécutez npm run dev ou sim-start pour démarrer le service.

Principales fonctions

Au cœur de Sim Studio se trouve l'éditeur visuel de flux de travail, décrit ci-dessous :

Création de flux de travail

- Connectez-vous à Sim Studio (http://localhost:3000/w/).

- Cliquez sur "Nouveau flux de travail" pour accéder à l'éditeur.

- Faites glisser le nœud Agent et sélectionnez LLM (Cloud or Local Model).

- Ajoutez un nœud Tools (par exemple Slack ou Database) et configurez les paramètres.

- Utilisez le nœud Logique conditionnelle pour définir la logique de branchement.

- Connecter des nœuds et enregistrer des flux de travail.

Processus de test

- Cliquez sur "Test" et saisissez les données de l'exemple.

- Consulter les résultats et les journaux pour vérifier l'exécution du nœud.

- Ajuster les nœuds ou la logique si nécessaire et refaire le test.

Processus de déploiement

- Cliquez sur Déployer et sélectionnez Générer l'API.

- Obtenir le point de terminaison de l'API (par exemple http://localhost:3000/api/workflow/).

- Tester l'API :

curl -X POST http://localhost:3000/api/workflow/<id> -d '{"input": "示例数据"}'

Processus de débogage

- Vérifiez les entrées et sorties du nœud en consultant le "Journal" dans l'éditeur.

- Utiliser le contrôle de version pour enregistrer des instantanés du flux de travail afin de faciliter le retour en arrière.

Fonction en vedette Fonctionnement

- Soutien au modèle local La configuration de l'agent est terminée : l'exécution d'un modèle local via Ollama est adaptée aux scénarios sensibles en matière de confidentialité. Après la configuration, sélectionnez le modèle au niveau du nœud de l'agent et testez les performances.

- intégration des outils Prenons l'exemple de Slack, saisissons le jeton API dans le nœud de l'outil, définissons la cible du message et testons la fonctionnalité d'envoi du message.

- Conteneurs de développement Développement conteneurisé via VS Code, avec configuration automatique de l'environnement pour une itération rapide.

mise en garde

- Les installations Docker doivent s'assurer que le port 3000 n'est pas occupé.

- Les modèles locaux nécessitent une configuration matérielle élevée (16 Go de RAM recommandés, GPU en option).

- Les environnements de production doivent être configurés avec RESEND_API_KEY et HTTPS.

- Mettre régulièrement le code à jour :

git pull origin main docker compose up -d --build

pile technologique

Sim Studio utilise une pile technologique moderne pour garantir la performance et l'efficacité du développement :

- fig. modèle Next.js (routeur d'applications)

- base de données complète PostgreSQL + Drizzle ORM : PostgreSQL + Drizzle ORM

- accréditation La loi sur l'immigration et la protection des réfugiés : Better Auth

- Interfaces : Shadcn, Tailwind CSS

- Gestion du statut : Zustand

- Éditeur de processus : ReactFlow

- fichier (informatique) : Fumadocs

scénario d'application

- Service client automatisé

Concevoir des flux de travail multi-agents, intégrer une base de données et Slack, automatiser les réponses aux questions des clients et notifier le service client humain, adapté aux plateformes de commerce électronique. - l'analyse des données

Créez des flux de travail pour extraire des données des bases de données, appelez LLM pour générer des rapports, déployez-les sous forme d'API, adaptées à l'analyse financière. - Outils pédagogiques

Création d'agents d'apprentissage interactifs, combinaison de modèles locaux pour répondre aux questions et intégration d'outils de génération de questions de test pour l'enseignement en ligne.

QA

- Sim Studio est-il compatible avec Windows ?

Windows est pris en charge, mais nécessite Docker Desktop ou Node.js. L'approche Docker est recommandée pour garantir un environnement cohérent. - Comment se connecter à une instance Ollama existante ?

Modifier docker-compose.yml, ajouter le mappage host.docker.internal, définir OLLAMA_HOST. - Quel est le matériel nécessaire pour un modèle local ?

16 Go de RAM recommandés, GPU pour de meilleures performances, peut fonctionner lentement sur les appareils bas de gamme. - Comment contribuer au code ?

Se référer à https://github.com/simstudioai/sim/blob/main/.github/CONTRIBUTING.md.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...