Utilisation de l'API DeepSeek-R1 Questions fréquemment posées

API DeepSeek-R1

Le nom du modèle standard est : deepseek-reasoner

DeepSeek-R1 prend en charge les hits de cache

Les résultats de la mise en cache sont généralement utilisés pour les entrées à haute fréquence comportant peu d'exemples, les entrées de documents volumineux comportant plusieurs sorties (moins de 64 jetons (dont le contenu ne sera pas mis en cache)

La partie entrée des messages du système et de l'utilisateur est comptabilisée en tant qu'occurrences du cache.

Les résultats de la mise en cache sont sensibles au temps, généralement de quelques heures à quelques jours.

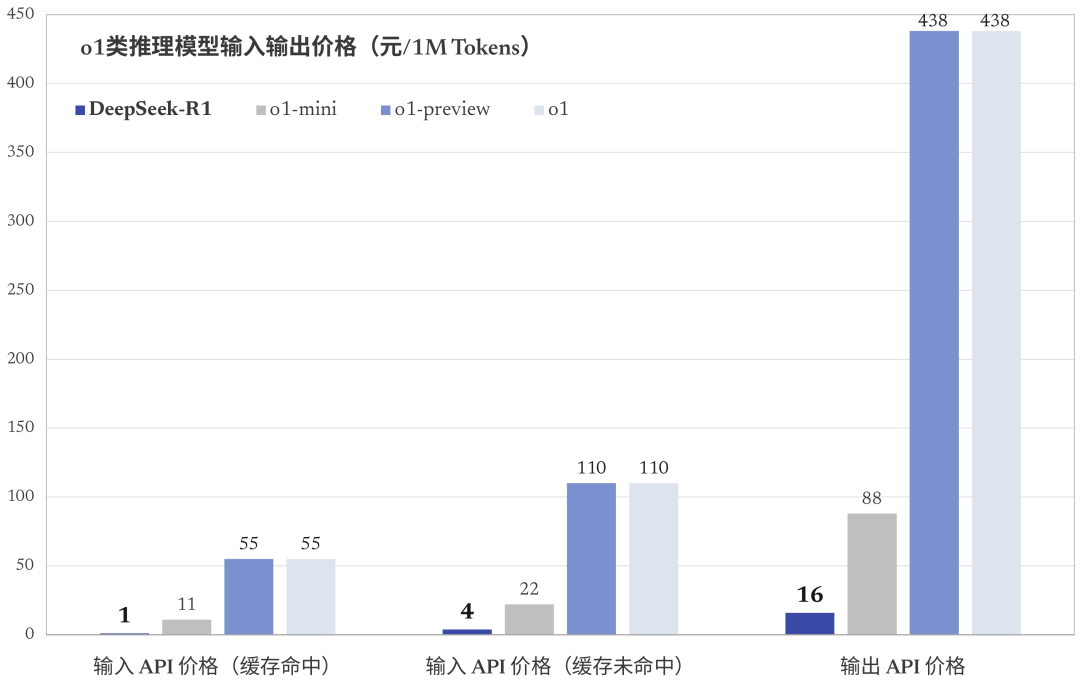

Nombre de jetons touchés par le cache (1$/million de jetons)

DeepSeek-R1 Problèmes de sortie

Profondeur de l'eau-R1 La sortie comprend à la fois la sortie de la chaîne de pensée et la sortie de la réponse, qui comptent toutes deux comme une sortie. jeton La facturation est la même.

L'API prend en charge jusqu'à 64 000 contextes et les chaînes de pensée ne sont pas prises en compte dans la longueur totale.

La sortie de la chaîne de pensée peut être réglée à un maximum (effort de raisonnement) de 32K tokens ; la sortie de la réponse peut être réglée à un maximum (max_tokens) de 8K tokens.

DeepSeek-R1 Épissage contextuel

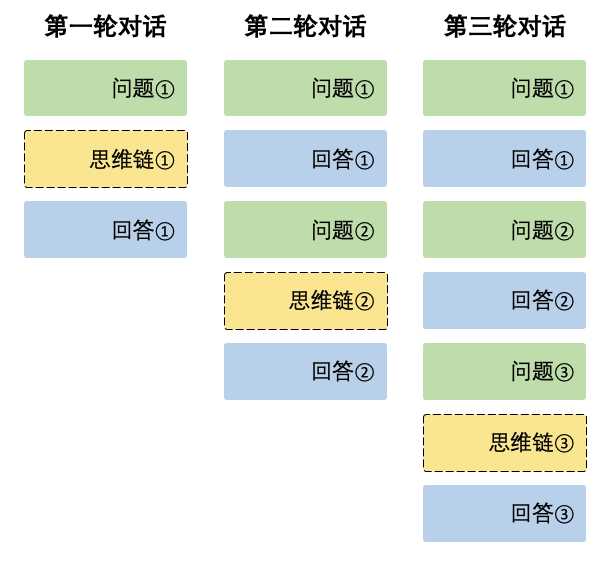

Lors de chaque cycle de dialogue, le modèle produit le contenu de la chaîne de pensée (reasoning_content) et la réponse finale (content). Lors du dialogue suivant, le contenu de la chaîne de pensée issue du dialogue précédent n'est pas intégré au contexte, comme le montre le schéma ci-dessous :

Le contexte conserve toujours la dernière étape de la chaîne de pensée, sinon la réponse sera confuse.

A propos de l'utilisation de l'API tierce DeepSeek-R1

Notez l'incompatibilité avec les formats officiels ! Par exemple, le flux basé sur le silicium.

© déclaration de droits d'auteur

Article copyright Cercle de partage de l'IA Tous, prière de ne pas reproduire sans autorisation.

Articles connexes

Pas de commentaires...